Explorando a deteção de pequenos objetos com Ultralytics YOLO11

Descubra como Ultralytics YOLO11 deteção rápida e precisa de pequenos objetos em aplicações do mundo real, como vigilância e robótica.

Descubra como Ultralytics YOLO11 deteção rápida e precisa de pequenos objetos em aplicações do mundo real, como vigilância e robótica.

Os drones integrados com a Vision AI podem voar a centenas de metros acima do solo e ainda assim detect pessoa que aparece como apenas alguns pixels na sua transmissão de vídeo. Na verdade, esse é um desafio comum em aplicações como robótica, vigilância e deteção remota, onde os sistemas devem identificar objetos muito pequenos dentro de uma imagem.

Mas os modelos tradicionais de deteção de objetos podem ter dificuldade em fazer isso. Objetos pequenos em imagens e vídeos representam informações visuais muito limitadas. Simplificando, quando um modelo os analisa, não há muitos detalhes para aprender ou reconhecer.

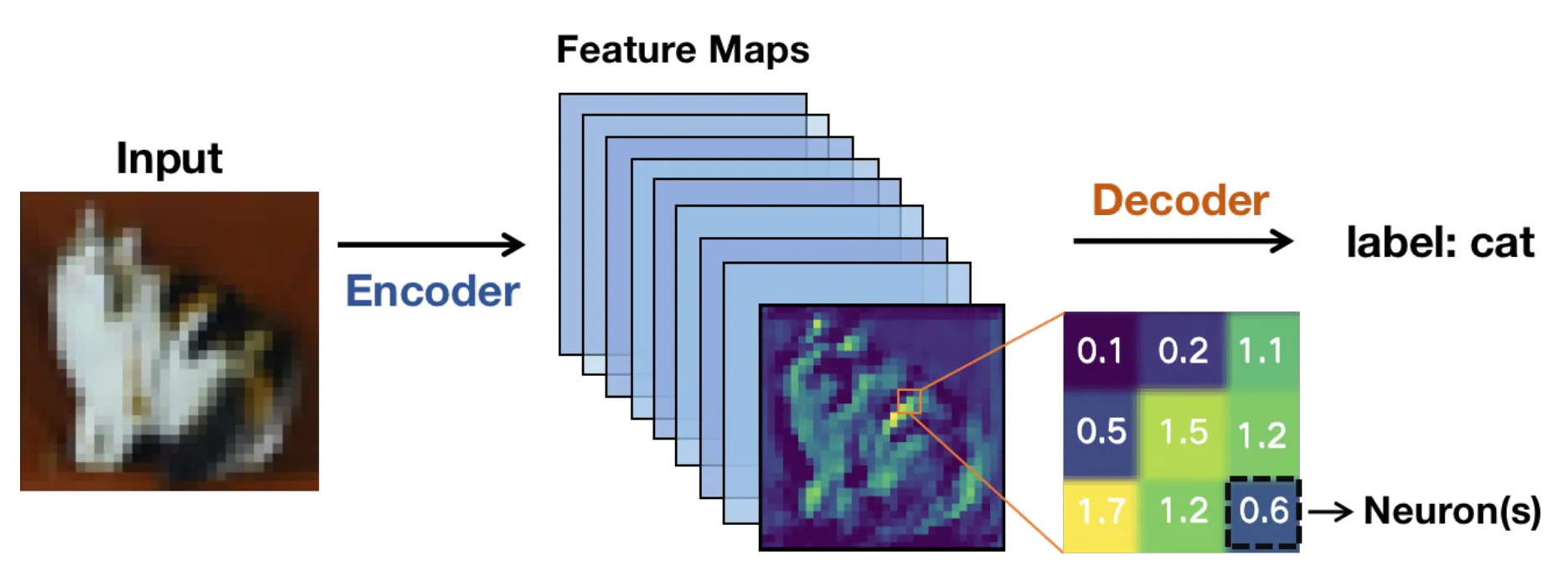

Nos bastidores, esses modelos normalmente dependem de uma arquitetura baseada em rede neural convolucional (CNN). As imagens são passadas por camadas da rede e transformadas em mapas de características ou representações simplificadas que destacam padrões relevantes em vez de pixels brutos.

À medida que a imagem se aprofunda na rede, esses mapas de características tornam-se menores. Isso torna o cálculo mais rápido, mas também significa que os detalhes finos podem desaparecer.

Para objetos minúsculos, esses detalhes são cruciais. Quando esses detalhes desaparecem, um modelo de visão computacional pode ter dificuldade em detectar o objeto, o que pode levar a caixas delimitadoras menos precisas ou inconsistentes.

Os sistemas de visão computacional de ponta a ponta em tempo real tornam isso ainda mais complicado. Imagens de alta resolução ajudam a preservar os detalhes, mas tornam a inferência mais lenta e exigem mais GPU . Resoluções mais baixas funcionam mais rapidamente, mas objetos pequenos tornam-se ainda mais difíceis de detect.

Torna-se um equilíbrio constante entre velocidade, precisão e limites de hardware. Graças aos recentes avanços tecnológicos, modelos de visão computacional como o Ultralytics YOLO11 e o próximo Ultralytics foram projetados para gerenciar esse equilíbrio de forma mais eficaz.

Neste artigo, exploraremos por que a deteção de objetos pequenos é difícil e como YOLO11 facilitar esse processo. Vamos começar!

A deteção de pequenos objetos é uma tarefa da visão computacional, um ramo da IA, que se concentra em identificar e localizar objetos que ocupam uma porção muito pequena de uma imagem. Esses objetos são frequentemente representados na imagem por um número limitado de pixels, que são as menores unidades de uma imagem digital. Isso torna-os mais difíceis de detect alvos maiores e mais nítidos (que geralmente contêm mais pixels).

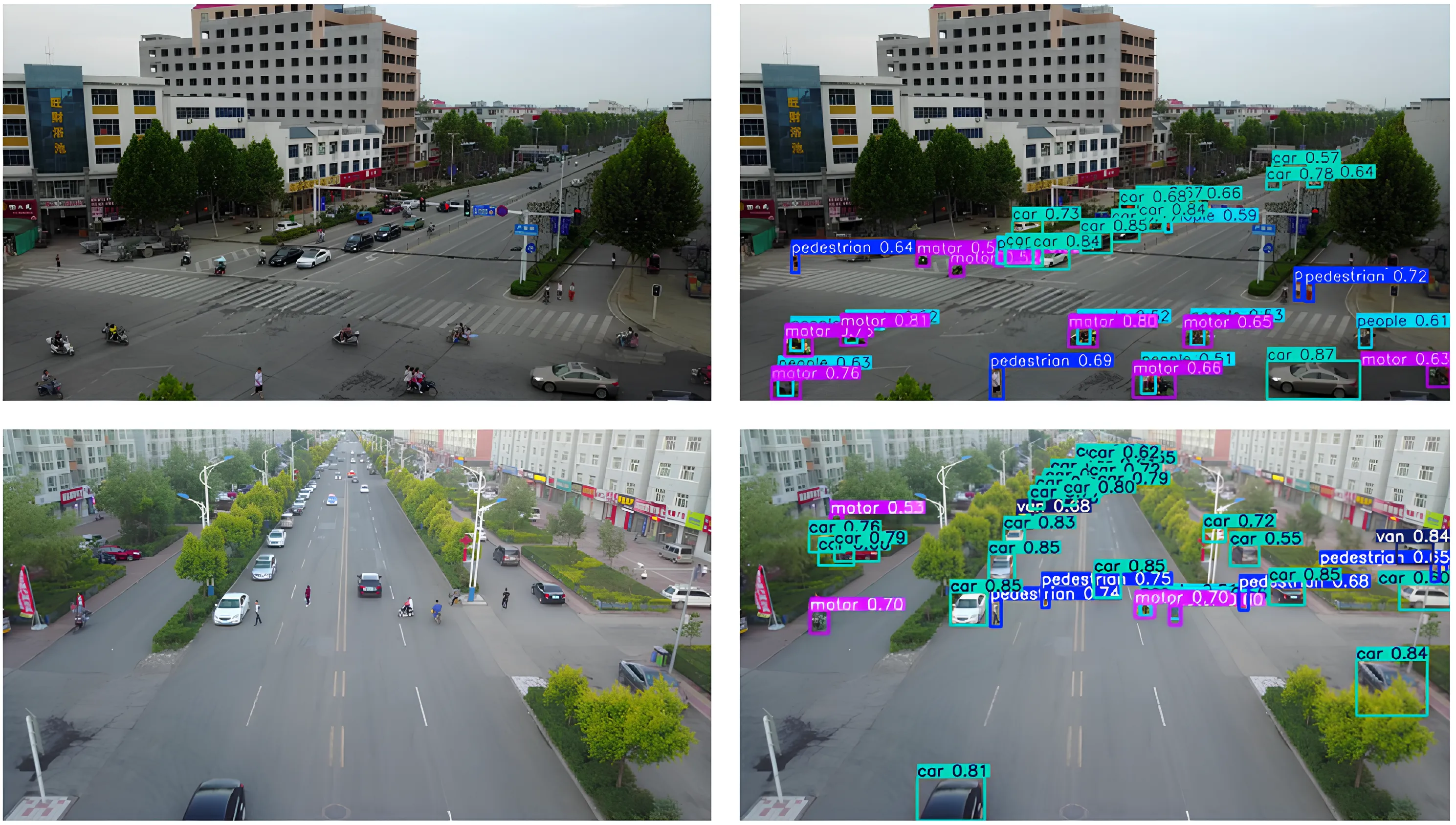

Por exemplo, veículos em imagens aéreas, ferramentas num chão de fábrica ou pessoas capturadas por câmaras de vigilância grande angular podem aparecer como pequenos objetos dentro da imagem. Detetá-los é importante porque muitas vezes contêm informações críticas, e muitas aplicações do mundo real, como a vigilância, dependem dessas deteções para funcionar corretamente.

Quando pequenos objetos são perdidos, o desempenho do sistema e a tomada de decisões podem ser afetados. A monitorização por veículos aéreos não tripulados (UAV) é um bom exemplo, em que perder um pequeno objeto em movimento no solo pode afetar a precisão da navegação ou do rastreamento.

Os sistemas anteriores utilizavam recursos artesanais e métodos tradicionais de visão computacional, que apresentavam dificuldades em cenas movimentadas ou variadas. Mesmo hoje, com modelos de aprendizagem profunda com desempenho muito superior, ainda é difícil detectar alvos pequenos quando eles ocupam apenas uma parte minúscula da imagem.

A seguir, vamos analisar alguns dos desafios comuns que surgem em diferentes cenários reais ao detetar objetos pequenos.

Objetos pequenos contêm muito poucos pixels, o que limita a quantidade de detalhes visuais que um modelo pode aprender durante etapas como a extração de características. Como resultado, padrões como bordas, formas e texturas são mais difíceis de detect, tornando os objetos pequenos mais propensos a se misturarem ao fundo.

À medida que as imagens passam pelas camadas convolucionais de uma rede neural, as informações visuais nos pixels são gradualmente comprimidas em mapas de características. Isso ajuda o modelo a permanecer eficiente, mas também significa que os detalhes finos desaparecem.

Para alvos pequenos, pistas importantes podem desaparecer antes que a rede de detecção tenha a oportunidade de agir. Quando isso acontece, a localização torna-se menos fiável e as caixas delimitadoras podem deslocar-se, sobrepor-se ou perder completamente os objetos-alvo.

Os desafios relacionados ao tamanho também são frequentemente levantados pela oclusão. A oclusão ocorre quando objetos, especialmente os menores, ficam parcialmente ocultos por outros objetos na cena.

Isso reduz a área visível de um alvo, o que limita as informações disponíveis para o detetor de objetos. Mesmo uma pequena oclusão pode confundir as redes de deteção, especialmente quando combinada com entradas de baixa resolução. Um exemplo interessante disso pode ser visto em conjuntos de dados de UAV, como o VisDrone, onde pedestres, bicicletas ou veículos podem estar parcialmente bloqueados por edifícios, árvores ou outros objetos em movimento.

Da mesma forma, a variação de escala introduz outra camada de dificuldade quando o mesmo objeto parece muito pequeno ou relativamente grande, dependendo da distância e da posição da câmara. Apesar desses obstáculos, os algoritmos de deteção devem reconhecer esses pequenos objetos em diferentes escalas sem perder precisão.

O contexto também desempenha um papel importante na deteção. Por exemplo, objetos grandes geralmente aparecem com um ambiente claro que fornece pistas visuais úteis. Por outro lado, alvos pequenos muitas vezes carecem dessa informação contextual, o que dificulta o reconhecimento de padrões.

Métricas de avaliação comuns, como Intersection over Union (IoU), medem o quão bem uma caixa delimitadora prevista se sobrepõe à caixa de referência. Embora IoU bem para objetos maiores, o seu comportamento é bem diferente para objetos pequenos.

Objetos pequenos ocupam apenas alguns pixels, portanto, mesmo uma pequena alteração na caixa prevista pode criar um grande erro proporcional e reduzir drasticamente a IoU . Isso significa que objetos pequenos muitas vezes não atendem ao IoU padrão usado para considerar uma previsão correta, mesmo quando o objeto é visível na imagem.

Como resultado, os erros de localização são mais propensos a serem classificados como falsos positivos ou falsos negativos. Essas limitações levaram os investigadores a repensar como os sistemas de detecção de objetos avaliam e lidam comdetect pequenos edetect .

À medida que os investigadores trabalhavam para melhorar a deteção de pequenos objetos, tornou-se claro que preservar e representar informações visuais em várias escalas é essencial. Essa percepção é refletida em pesquisas recentes do arXiv e em artigos apresentados em eventos como as Conferências Internacionais do IEEE e a Associação Europeia de Visão Computacional (ECCV).

À medida que as imagens avançam na rede neural, pequenos objetos podem perder detalhes ou desaparecer completamente. É por isso que modelos modernos de visão computacional, como YOLO11 grande ênfase a uma melhor extração de características. A seguir, vamos examinar os conceitos básicos por trás dos mapas de características e das redes piramidais de características para compreendê-los melhor.

Quando uma imagem de entrada, como uma imagem de sensoriamento remoto, entra numa rede neural, ela é gradualmente transformada em mapas de características. Essas são representações simplificadas da imagem que destacam padrões visuais como bordas, formas e texturas.

À medida que a rede se aprofunda, esses mapas de características tornam-se menores em tamanho espacial. Essa redução ajuda o modelo a funcionar com eficiência e a concentrar-se em informações de alto nível. No entanto, mapas de características reduzidos e profundos também reduzem os detalhes espaciais.

Enquanto objetos grandes retêm informações visuais suficientes para uma detecção precisa, alvos pequenos podem perder detalhes críticos após apenas algumas camadas de rede. Quando isso acontece, um modelo pode ter dificuldade em reconhecer que um objeto pequeno existe. Essa é uma das principais razões pelas quais objetos pequenos são ignorados em modelos de detecção profunda de objetos.

As redes piramidais de características, frequentemente chamadas de FPN, foram introduzidas para resolver a perda de detalhes espaciais e funcionam como um módulo de suporte que combina informações de várias camadas para que os modelos possam detect objetos detect de forma mais eficaz. Esse processo também é conhecido como agregação e fusão de características.

Camadas superficiais fornecem detalhes espaciais precisos, enquanto camadas mais profundas adicionam contexto semântico, permitindo uma aprendizagem eficaz de características em múltiplas escalas. Ao contrário do upsampling ingênuo, que simplesmente amplia os mapas de características, o FPN preserva informações significativas e melhora a deteção de pequenos objetos.

As abordagens modernas baseiam-se nessa ideia, utilizando fusão de características adaptativas e designs sensíveis ao contexto para melhorar ainda mais a deteção de alvos pequenos. Em outras palavras, o FPN ajuda os modelos a ver tanto o panorama geral quanto os pequenos detalhes ao mesmo tempo. Essa otimização é essencial quando os objetos são pequenos.

Aqui está um vislumbre de como os modelos de deteção de objetos evoluíram e avançaram ao longo do tempo para detect melhor detect de diferentes tamanhos, incluindo os muito pequenos:

Agora que entendemos melhor como funciona a deteção de pequenos objetos, vamos ver algumas aplicações reais em que YOLO11 ser utilizado.

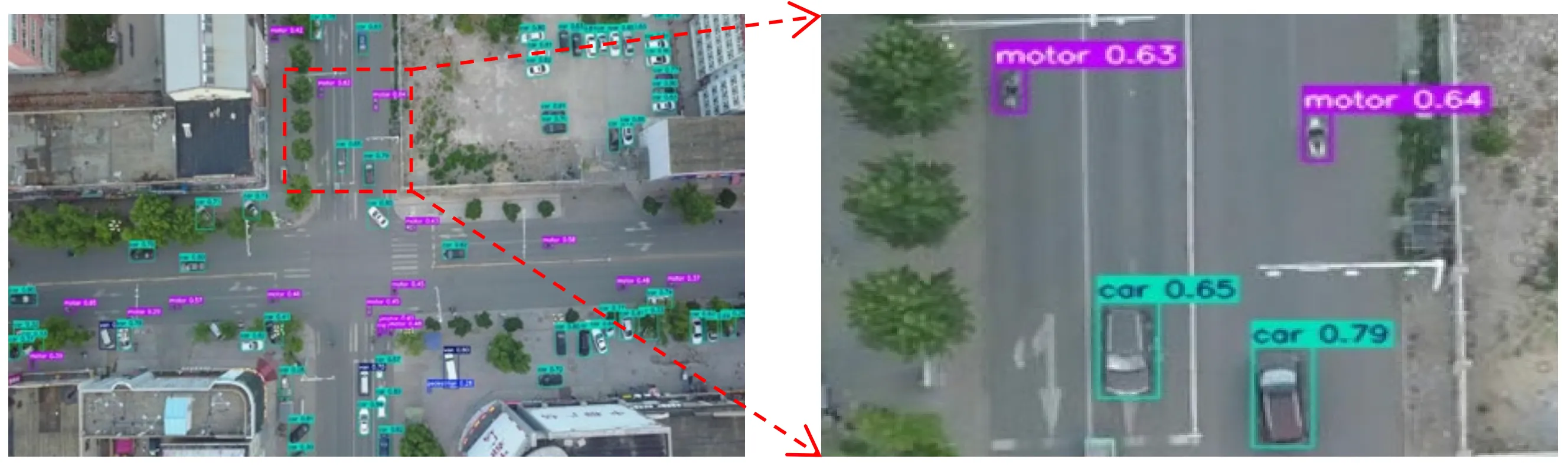

Imagine um drone a sobrevoar uma rua movimentada da cidade. Dessa altura, carros, bicicletas e até mesmo pessoas encolhem-se até se tornarem apenas alguns pixels num ecrã.

Os módulos de imagens aéreas e UAV frequentemente capturam cenas como esta, em que os objetos de interesse são minúsculos e estão rodeados por fundos desorganizados, o que torna difícil a sua detect por modelos de visão computacional.

Nesses tipos de cenários, YOLO11 ser a escolha ideal de modelo. Por exemplo, um drone equipado com um modelo como YOLO11 monitorar o tráfego em tempo real, detetando veículos, ciclistas e peões à medida que se movem pela cena, mesmo quando cada objeto ocupa apenas uma pequena parte da imagem. Isso permite uma tomada de decisão mais rápida e insights mais precisos em aplicações como gestão de tráfego, segurança pública ou planeamento urbano.

Os robôs são frequentemente utilizados em ambientes onde a precisão e o tempo são fundamentais. Em locais como armazéns, fábricas e quintas, um robô pode precisar de reconhecer objetos muito pequenos, como uma peça numa linha de montagem, uma etiqueta numa embalagem ou um pequeno rebento numa planta no campo, e responder rapidamente.

Detectar objetos desse tamanho pode ser complicado, especialmente quando eles aparecem como apenas alguns pixels na imagem da câmara ou estão parcialmente ocultos por outros objetos. Perder esses pequenos detalhes pode retardar a automação ou afetar a capacidade do robô de concluir uma tarefa.

YOLO11 fazer a diferença nessas situações. Sua extração de recursos aprimorada e inferência rápida permitem que os robôs detect objetos em tempo real e ajam imediatamente.

YOLO11 suporta segmentação de instâncias, o que pode ajudar os robôs a compreender os limites dos objetos e a capturar pontos com mais precisão, em vez de apenas localizar caixas delimitadoras gerais. Por exemplo, um braço robótico integrado ao YOLO11 identificar pequenos componentes numa correia transportadora, segment forma exata e recolhê-los antes que saíssem do alcance, ajudando o sistema a permanecer eficiente e confiável.

Com tantos modelos de visão computacional disponíveis atualmente, você pode estar se perguntando o que faz Ultralytics YOLO11 destacar.

Aqui estão algumas razões pelas quais Ultralytics YOLO11 uma ótima opção para aplicações em que pequenos objetos precisam ser detetados:

Além de usar um modelo como o YOLO11, a forma como prepara as suas anotações, o conjunto de dados geral e o procedimento de treino do modelo podem fazer uma diferença significativa no desempenho da deteção.

Aqui está uma breve visão geral do que deve ser focado:

A deteção de objetos pequenos é difícil porque os alvos pequenos perdem detalhes à medida que as imagens passam por um modelo de visão computacional. YOLO11 a forma como esses detalhes são preservados, tornando a deteção de objetos pequenos mais fiável sem sacrificar o desempenho em tempo real. Esse equilíbrio permite YOLO11 suporte à deteção precisa e eficiente em aplicações do mundo real.

Junte-se à nossa crescente comunidade! Explore nosso repositório GitHub para saber mais sobre IA. Descubra inovações como a visão computacional no varejo e a IA na indústria automotiva visitando nossas páginas de soluções. Para começar a construir com visão computacional hoje mesmo, confira nossas opções de licenciamento.