Como na Ultralytics YOLO mais rápidos no seu chip favorito

Como Ultralytics YOLO para velocidade em CPUs, GPUs e dispositivos de ponta. Explicaremos chips, memória e técnicas inteligentes, como quantização, fusão e poda.

Como Ultralytics YOLO para velocidade em CPUs, GPUs e dispositivos de ponta. Explicaremos chips, memória e técnicas inteligentes, como quantização, fusão e poda.

Na Ultralytics, criamos modelos de visão computacional; basicamente, ensinamos os computadores a ver! Pense nesses modelos como receitas matemáticas gigantes. Eles são compostos por operações (que chamamos de camadas) e uma enorme pilha de números que chamamos de pesos.

YOLO nossosYOLO Ultralytics YOLO processam imagens como elas realmente são: matrizes de números! Cada pixel é, na verdade, apenas valores de cor, a quantidade de vermelho, verde e azul (ou seja, RGB) para cada ponto que compõe a imagem. Chamamos essas matrizes numéricas de «tensores» porque soa muito mais legal do que «matrizes multidimensionais», que soa muito mais legal do que «números empilhados sobre números empilhados sobre números».

Quando insere uma imagem no nosso modelo, ela embarca numa viagem épica pela rede. Imagine tensor seu tensor por camadas e camadas, sendo transformado, convoluído e matematicamente distorcido da maneira mais bela possível. Pense nisso como uma festa dançante onde números se misturam e se combinam, extraindo a essência do que faz um gato ser um gato ou um carro ser um carro. Chamamos a este processo de extração de características.

O que sai do outro lado? Mais números! Números significativos. Em tarefas de deteção, eles dizem exatamente onde as coisas estão na sua imagem e o que elas provavelmente são. «Ei, há 95% de probabilidade de que seja um cão nas coordenadas (x, y)!» Chamamos a esse processo mágico de inferência.

Agora, antes que os nossos modelos possam fazer a sua mágica, eles precisam de ir à escola; precisam de ser treinados. A parte do treino é onde as coisas ficam intensas.

Durante o treino, cada vez que apresentamos uma imagem à rede, não estamos apenas a obter uma resposta. Estamos a fazer duas coisas extremamente complexas. Primeiro, calculamos o quão errada a rede estava (chamamos isso de perda, basicamente a distância do alvo). Segundo, e esta é a parte importante, atualizamos cada número (ou peso) na rede com base nessa perda. Pense nisso como ajustar milhares de pequenos botões ao mesmo tempo, onde cada ajuste é calculado para tornar a rede mais precisa a cada vez. Estamos essencialmente a treinar a rede por meio de correções: cada erro ensina o que NÃO fazer, e ajustamos todos esses pesos para que, quando ela vir uma imagem semelhante novamente, ela se aproxime mais da resposta certa. Essencialmente, a rede aprende sendo empurrada na direção certa, erro por erro, até começar a acertar as previsões.

De quantos números estamos a falar? Bem, o nosso pequeno e fofo YOLO11n tem alguns milhões de parâmetros. Mas o YOLO11x? Esse bad boy tem mais de 50 milhões de parâmetros! Mais parâmetros significam mais detalhes que você pode codificar, como a diferença entre desenhar com giz de cera e ter uma paleta completa de tintas.

Durante a inferência, essa contagem de parâmetros torna-se crucial. Executar uma rede de 3 milhões de parâmetros é como correr ao redor do quarteirão. Executar uma rede de 50 milhões de parâmetros? É mais como correr uma maratona enquanto faz malabarismos com tochas em chamas.

Então, o que é exatamente computação? Como é que todo esse processamento de números realmente acontece? Como podemos torná-lo mais rápido? E o que significa "otimizar a computação"?

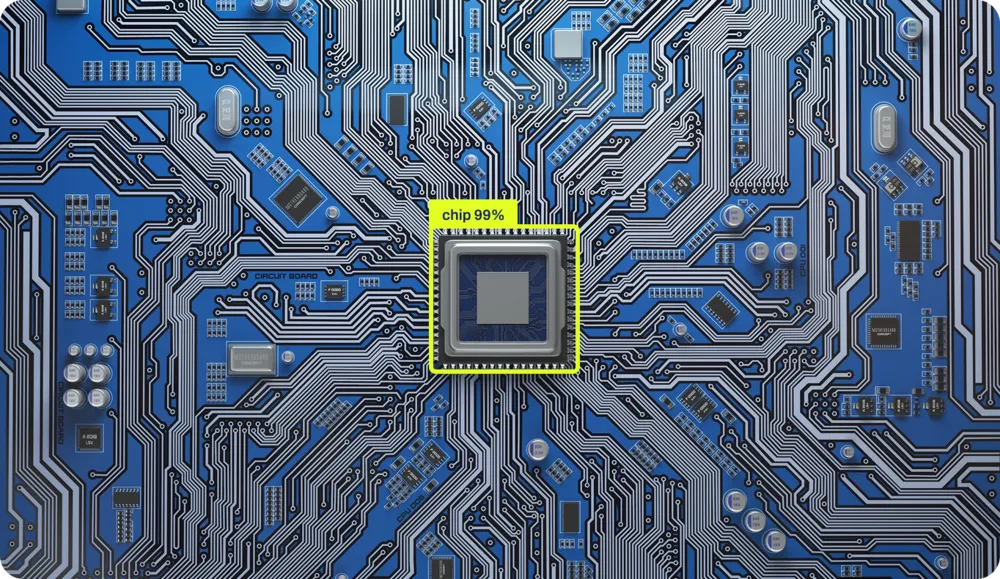

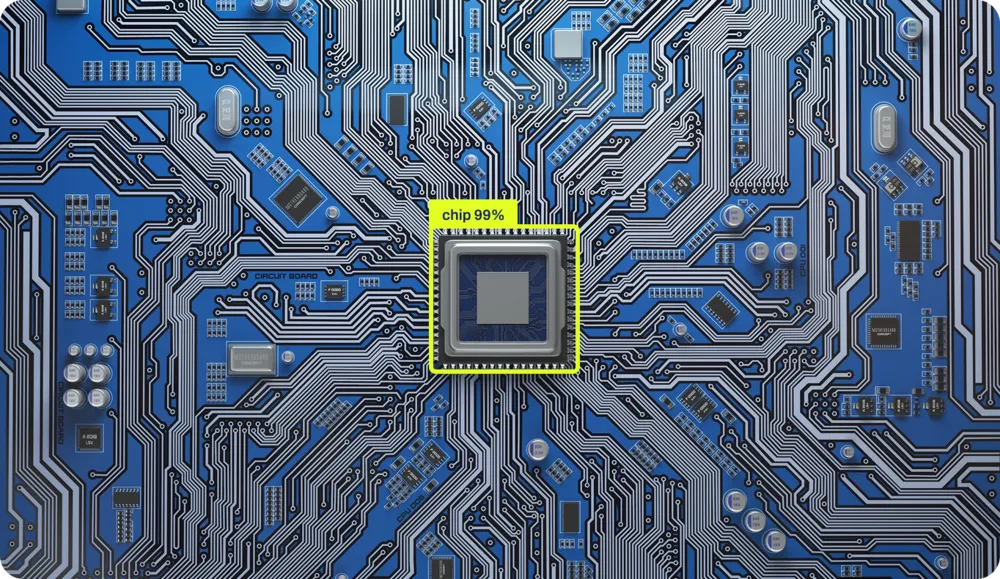

A computação acontece com chips. Esses pequenos quadrados de silício são basicamente os castelos de areia mais organizados do universo. Cada operação que o seu computador realiza, cada adição, cada comparação, cada «se isto, então aquilo» está fisicamente gravado no silício. Existem circuitos físicos reais em áreas específicas do chip dedicados à adição de números e outros para operações lógicas. É como ter uma pequena cidade onde diferentes bairros se especializam em diferentes tipos de matemática.

Isso provavelmente parece bizarro, mesmo para quem é cientista da computação. Isso porque passámos os últimos 40 anos a construir camadas e camadas de abstração, como uma lasanha tecnológica que ficou tão alta que nem conseguimos mais ver a base. Simplificámos tanto as coisas que a maioria dos programadores de hoje não tem ideia de como a computação realmente acontece no silício. Não por culpa deles, mas por design!

Vamos analisar essas camadas. Veja este Python extremamente simples:

x = 1

if x == 1:

y = x + 1Estamos a criar uma variável x, definindo-a como 1, e se x for igual a 1 (spoiler: é), criamos y com o valor de x mais 1. Três linhas. Fácil.

Mas é aqui que fica interessante. Entre essas três linhas inocentes e os elétrons reais que se movem pelo silício, há PELO MENOS quatro camadas massivas de tradução a acontecer (na verdade, há mais, mas a nossa Gestora de Conteúdo Digital diz que a minha contagem de palavras já está a deixá-la ansiosa). Deixe-me guiá-lo por esta viagem alucinante:

Camada 1: Python Bytecode Primeiro, Python o seu código e compila-o para algo chamado bytecode, uma linguagem intermédia que é mais fácil para os computadores digerirem, mas que faria os seus olhos sangrarem se tentasse lê-la.

Camada 2: Bytecode → Código de máquina O Python (como o CPython) pega esse bytecode e o traduz para código de máquina, as instruções reais que o seu processador entende. É aqui que o seu elegante "if x == 1" se torna algo como "CARREGAR registo, COMPARAR registo, SALTAR se sinalizador zero estiver definido".

Camada 3: Código de máquina → Microcódigo Reviravolta! Os processadores modernos nem sequer executam o código de máquina diretamente. Eles dividem-no ainda mais em microcódigo, operações ainda menores que os componentes internos do chip podem processar. A sua instrução única "ADD" pode tornar-se várias microoperações.

Camada 4: Microcódigo → Eletrónica física Finalmente, chegamos ao silício. Essas microoperações acionam sinais elétricos reais que fluem através dos transístores. Bilhões de pequenos interruptores ligam e desligam, os elétrons dançam por caminhos cuidadosamente projetados e, de alguma forma mágica, 1 + 1 torna-se 2.

Cada camada existe para esconder a complexidade insana da camada abaixo dela. É como aquelas bonecas russas, exceto que cada boneca fala uma língua completamente diferente, e a menor delas é literalmente feita de raios presos na areia.

A ironia? Essas três linhas de Python acionam MILHÕES de interruptores de transístores. Mas, graças a essas abstrações, não precisa pensar em nada disso. Basta escrever «y = x + 1» e confiar que, em algum lugar, nas profundezas do silício, a magia acontece.

Cada operação é fisicamente implementada no silício, e ONDE ela ocorre no chip depende inteiramente da topologia do chip. É como o planeamento urbano, mas para elétrons. O somador fica aqui, o multiplicador fica ali, e todos precisam se comunicar entre si de forma eficiente.

Temos centenas de chips diferentes no mercado, cada um projetado para finalidades diferentes. O que muda entre eles? A topologia, como as operações são posicionadas e implementadas no domínio físico. Isso é o que chamamos de arquitetura, e, cara, temos muitas delas:

Cada arquitetura não apenas organiza os seus transístores de maneira diferente, mas também fala uma linguagem diferente. As abstrações que usamos para enviar instruções a essas máquinas são completamente diferentes. É como ter que escrever instruções de viagem para alguém, mas, dependendo do carro dessa pessoa, talvez seja necessário escrever em francês, mandarim ou dança interpretativa.

O combustível dos nossos chips são os eletrões, a eletricidade que flui para o chip, fornecendo a energia para o cálculo. Mas a energia por si só não é suficiente. Para que um chip funcione realmente, para mover dados através da sua topologia complexa, tudo depende de um componente crítico: o relógio. É isso que faz com que os eletrões fluam por caminhos específicos em momentos específicos. Sem ele, você teria apenas silício alimentado sem fazer nada.

Imagine tentar coordenar uma performance gigantesca em que milhares de milhões de componentes precisam de se mover em perfeita sincronia. Sem um ritmo, seria o caos. É exatamente isso que o relógio faz pelo seu processador. É um cristal que vibra a uma velocidade incrivelmente consistente, enviando impulsos elétricos milhares de milhões de vezes por segundo.

Quando ouve «processador de 3,5 GHz», esse GHz (gigahertz) é a velocidade do clock, 3,5 mil milhões de batidas por segundo. Cada batida é chamada de ciclo de clock e é a unidade fundamental de tempo na computação.

NADA acontece entre os ciclos do relógio. O computador inteiro congela, à espera do próximo batimento. É como o jogo mais extremo do universo de luz vermelha, luz verde. Em cada «luz verde» (pulso do relógio):

Algumas operações levam um ciclo (uma simples adição), enquanto outras levam muitos ciclos (uma divisão ou a obtenção de dados da RAM). É uma coreografia precisa, com milhares de milhões de componentes a realizar as suas operações específicas, todos sincronizados com este ritmo implacável.

Você pode fazer um overclock no seu processador fazendo o cristal vibrar mais rápido; tudo acontece mais rápido, mas também gera mais calor, tornando-se menos estável. Se for longe demais, o seu computador irá travar porque os elétrons literalmente não conseguem acompanhar o ritmo.

Antigamente, essas operações eram implementadas com máquinas do tamanho de salas. Mas os componentes que fazem todos esses cálculos são extremamente simples: são apenas interruptores. Interruptores liga/desliga.

Conecte um número suficiente desses interruptores no padrão correto e você terá computação. Toda a revolução digital se resume a um arranjo sofisticado de interruptores.

Essa simplicidade significa que, se tiver interruptores, quaisquer interruptores, pode construir um computador. As pessoas já construíram computadores funcionais com tubos e válvulas de água, dominós, blocos de LEGO, bolinhas de gude e até mesmo com redstone no Minecraft.

Os princípios não mudaram desde a década de 1940. Apenas nos tornámos incrivelmente bons em fabricar interruptores extremamente pequenos. O seu telemóvel tem mais poder computacional do que todos os computadores que enviaram humanos à Lua e cabe no seu bolso porque descobrimos como fabricar interruptores à escala atómica.

Quando estamos a executar redes neurais com milhões de parâmetros, estamos a acionar esses pequenos interruptores bilhões de vezes por segundo, todos perfeitamente sincronizados com aquele batimento cardíaco cristalino. Cada atualização de peso, cada multiplicação de matriz, cada função de ativação, todas marcham ao ritmo do relógio.

Não é de admirar que os modelos de treino façam o seu computador parecer que está a tentar descolar!

Muito bem, então temos estes chips com milhares de milhões de interruptores a dançar ao ritmo de um cristal e queremos executar redes neurais com milhões de parâmetros neles. Deve ser fácil, certo? Basta lançar os números no chip e deixá-lo funcionar!

Executar redes neurais rapidamente é como tentar preparar uma refeição de cinco pratos numa cozinha onde o frigorífico fica a três quarteirões de distância, só tem uma panela e todos os ingredientes pesam 225 kg. A matemática em si não é o maior problema; são todas as outras coisas.

A maioria dos chips foi concebida para executar Microsoft , não redes neurais. CPU sua CPU construída pensando que passaria a vida a executar instruções if, loops e, ocasionalmente, a calcular os seus impostos (o único cálculo que até os supercomputadores consideram emocionalmente desgastante). Ela é otimizada para operações sequenciais: faça isto, depois aquilo, depois outra coisa.

Mas as redes neurais são completamente diferentes. Elas querem fazer TUDO DE UMA VEZ. Durante o treino, você atualiza milhões de pesos com base no quão erradas foram as suas previsões. Durante a inferência (na verdade, usando o modelo treinado), você processa dados através de milhões de cálculos simultaneamente. Imagine que precisa multiplicar um milhão de números por outro milhão de números. CPU sua CPU, abençoada seja, quer fazer isso um de cada vez, como um contabilista muito rápido, mas muito metódico.

É por isso que as GPUs se tornaram a espinha dorsal da computação de IA. As GPUs foram projetadas para videogames, onde é necessário calcular a cor de milhões de pixels simultaneamente. Acontece que calcular as cores dos pixels e fazer cálculos de redes neurais são surpreendentemente semelhantes: ambos envolvem realizar a mesma operação em grandes quantidades de dados em paralelo.

Mas mesmo as GPUs não são perfeitas para redes neurais. É por isso que as empresas estão agora a construir chips de IA especializados (TPUs, NPUs e todos os outros acrónimos que terminam em PU). Esses chips são projetados desde o início com uma única função: tornar as redes neurais mais rápidas. É como contratar um chef que só sabe cozinhar um prato, mas o faz a uma velocidade sobre-humana. Enquanto a CPU para realizar operações matriciais sequencialmente e a GPU as GPU muito bem em paralelo, esses chips especializados comem matrizes ao pequeno-almoço, almoço e jantar.

Na computação moderna de redes neurais, gastamos mais tempo e energia MOVENDO dados do que realmente COMPUTANDO com eles.

Pense no chip do seu computador como um matemático brilhante que trabalha na velocidade da luz, mas todos os seus livros de referência estão armazenados em diferentes prédios pela cidade. Ele pode resolver qualquer equação instantaneamente, mas primeiro precisa obter os números, e essa jornada leva uma eternidade.

O seu chip pode multiplicar dois números num ciclo de relógio (lembre-se, isso é um desses milhares de milhões de batidas por segundo). É extremamente rápido! Mas transferir esses números da memória para o chip? Isso pode levar CENTENAS de ciclos. É como se o seu matemático pudesse resolver um problema num segundo, mas precisasse de cinco minutos para ir até à biblioteca e voltar.

A razão é a distância (e o espaço). A eletricidade move-se rapidamente, mas não infinitamente rápido. Quanto mais longe os dados têm de viajar no chip, mais tempo demoram. Os designers de computadores resolveram este problema criando uma hierarquia de memória, como se tivessem vários locais de armazenamento a diferentes distâncias:

As estruturas exatas variam, o chip do seu telemóvel pode ignorar a cache L3, enquanto uma CPU de servidor CPU ter quantidades enormes dela. O princípio, no entanto, permanece o mesmo: a memória mais próxima é mais rápida, mas menor.

É aqui que as redes neurais começam a sofrer. Imagine queYOLO seuYOLO Ultralytics YOLO tem 50 milhões de parâmetros (ChatGPT bilhões, aliás). São 50 milhões de números que precisam de viajar da memória para as unidades de computação e vice-versa. Mesmo que cada número tenha apenas 4 bytes, são 200 megabytes de dados que precisam de ser movidos pelo seu sistema.

O chip pode processar cada número num único ciclo, mas se forem necessários 100 ciclos para obter esse número da RAM, estará a gastar 99% do seu tempo à espera da entrega. É como ter um carro de Fórmula 1 num engarrafamento. Todo esse poder computacional, parado ali, à espera que os dados cheguem.

Aqui está a ideia crucial: este é O gargalo da computação moderna. É chamado de gargalo de von Neumann. Tornar os chips mais rápidos em matemática é relativamente fácil. Tornar a memória mais rápida está a atingir limites físicos. É por isso que quase TODA a otimização de desempenho em IA acontece ao nível da memória. Quando os engenheiros aceleram as redes neurais, raramente tornam a matemática mais rápida; eles encontram maneiras inteligentes de mover menos dados, armazená-los melhor em cache ou acessá-los de forma mais inteligente.

Os chips de IA modernos não se concentram apenas na velocidade de computação; eles são obcecados pela largura de banda da memória e pelas estratégias de movimentação de dados. Eles pré-buscam dados, reutilizam valores já existentes na cache e organizam cálculos para minimizar as viagens à memória. Os vencedores na corrida pelo hardware de IA não são aqueles com as calculadoras mais rápidas; são aqueles que descobriram como manter essas calculadoras alimentadas com dados. Todo o jogo consiste em otimizar os padrões de acesso à memória.

Sempre que se move um pouco de dados, gasta-se energia. Não é muita, estamos a falar de picojoules, mas quando se movimentam terabytes por segundo, isso soma-se RAPIDAMENTE. Na verdade, mover dados 1 mm através de um chip consome mais energia do que fazer o cálculo propriamente dito!

É por isso que o seu portátil soa como um motor a jato quando treina redes neurais. Não é a matemática que gera calor, mas sim a movimentação de dados. Cada atualização de parâmetro, cada cálculo de gradiente, cada passagem para a frente está literalmente a aquecer o seu quarto.

Os aceleradores de IA modernos são basicamente exercícios de termodinâmica. Quanta computação podemos colocar antes que o chip derreta? Com que rapidez podemos dissipar o calor? É como fazer overclocking, mas o relógio está sempre em 11 e estamos apenas a tentar não provocar um incêndio.

As redes neurais mais rápidas não são necessariamente as mais inteligentes, mas sim aquelas concebidas tendo em mente os chips. Elas:

É como a diferença entre uma receita que diz «use ingredientes da sua mercearia local» e outra que exige que importe especiarias do Tibete, queijo da França e água da Antártida. Ambas podem ter um sabor bom, mas uma é definitivamente mais prática.

E é por isso que tornar as redes neurais rápidas é uma forma de arte. Não basta ter bons conhecimentos de matemática; é preciso entender o hardware, respeitar a hierarquia da memória e dançar perfeitamente com a arquitetura.

Bem-vindo ao mundo onde a ciência da computação se encontra com a física, a engenharia e a magia pura. Onde mover um número custa mais do que computá-lo. Onde o paralelo é rápido, mas a sincronização é a morte. Onde o seu maior inimigo não é a complexidade, mas a distância.

Quando treina um YOLO , obtém uma rede neural que funciona perfeitamente na sua configuração de treino. Mas eis o problema: GPU sua GPU para jogos, o seu iPhone e aquele pequeno chip numa câmara de segurança falam línguas completamente diferentes. Eles têm pontos fortes e pontos fracos diferentes, além de ideias muito diferentes sobre como processar dados.

Pense nisso desta forma: uma GPU milhares de núcleos que podem funcionar simultaneamente – ela foi concebida para processamento paralelo. Enquanto isso, um chip móvel pode ter circuitos especiais concebidos especificamente para operações de IA, mas só consegue lidar com certos tipos de cálculos matemáticos. E aquele dispositivo de ponta na sua câmara da campainha? Ele está a tentar executar IA com um consumo de energia menor do que uma lâmpada LED.

Na Ultralytics, oferecemos suporte a mais de uma dúzia de formatos de exportação diferentes, pois cada um deles é otimizado para um hardware específico. Não se trata de ter muitas opções, mas sim de ter a opção certa para as SUAS necessidades específicas.

No YOLO original, muitas operações ocorrem em sequência. Por exemplo, podemos fazer uma convolução, depois normalizar os resultados e, em seguida, aplicar uma função de ativação. São três etapas separadas, cada uma exigindo suas próprias leituras e gravações de memória.

Mas aqui está a parte inteligente: podemos combinar essas operações em uma única etapa. Quando exportamos YOLO implementação, fundimos essas operações. Em vez de:

Nós fazemos:

Para um YOLO típico que processa uma imagem de 640×640, esse truque simples elimina gigabytes de transferências desnecessárias de memória. Num telemóvel, essa é a diferença entre uma deteção em tempo real suave e um atraso frustrante.

YOLO precisa de números superprecisos para detect com precisão. Durante o treinamento, usamos 32 bits para representar cada peso – é como usar uma calculadora científica para medir os ingredientes de uma sanduíche. Para a implementação real? 8 bits funcionam muito bem.

Isso é chamado de quantização e é uma das nossas técnicas de otimização mais poderosas. Ao usar números menores:

Nem todas as camadas no YOLO igualmente sensíveis a essa redução. As camadas iniciais que detect bordas e formas detect ? Elas são robustas – podemos usar números de 8 bits sem qualquer problema. As camadas finais de detecção que determinam «isso é um gato ou um cão?» precisam de um pouco mais de precisão. Portanto, ajustamos a precisão camada por camada, usando apenas os bits necessários para manter a exatidão e, ao mesmo tempo, maximizar a velocidade.

Descobrimos que, com uma quantização cuidadosa, Ultralytics YOLO 99,5% da sua precisão original, ao mesmo tempo que funciona três vezes mais rápido em telemóveis. Essa é a diferença entre um modelo de pesquisa e algo que pode realmente usar no mundo real.

Existem dezenas de maneiras diferentes de realizar a mesma operação matemática. Uma convolução simples (a operação central no YOLO) pode ser calculada usando algoritmos completamente diferentes, e a melhor escolha depende do seu hardware específico e do tamanho da entrada.

Quando exportamos YOLO, a nossa estrutura de otimização testa diferentes algoritmos e escolhe o mais rápido para o seu caso específico. É como ter várias rotas para o mesmo destino e escolher com base nas condições atuais do trânsito. Numa GPU, podemos usar um algoritmo que processa muitos pixels simultaneamente. Numa CPU, podemos usar um que seja otimizado para processamento sequencial. A matemática é a mesma, mas a estratégia de execução é completamente diferente.

Lembra-se de como falámos sobre a memória ser o verdadeiro gargalo na computação moderna? Isso é especialmente verdadeiro para YOLO. O modelo pode ter 50 milhões de parâmetros e, durante a inferência, cria gigabytes de resultados intermediários. Movimentar todos esses dados costuma ser mais lento do que o próprio cálculo.

Utilizamos vários truques para minimizar a movimentação da memória:

Agendamento inteligente: organizamos as operações para que os dados sejam usados imediatamente enquanto ainda estão na memória cache rápida. Para a rede piramidal de recursos YOLO, isso reduz o tráfego de memória em 40%.

Mosaico: Em vez de processar uma imagem inteira de uma só vez, dividimo-la em mosaicos menores que cabem na cache. Isso significa que o processador pode trabalhar com a memória local rápida, em vez de ficar constantemente a buscar dados da memória principal lenta.

Reutilização do buffer: em vez de criar constantemente nova memória para resultados intermediários, reutilizamos os mesmos buffers de memória. É incrivelmente eficiente – toda a estrutura YOLO pode funcionar com apenas alguns buffers reutilizáveis.

Aqui está um facto surpreendente: YOLO são frequentemente superdimensionados. Podemos remover 30% dos canais em muitas camadas sem praticamente nenhum impacto na precisão. Isso não está apenas a tornar o modelo menor, mas também mais rápido, porque há literalmente menos cálculos a serem realizados.

O processo é elegante: analisamos quais partes da rede contribuem menos para os resultados finais da deteção, removemo-las e, em seguida, ajustamos o modelo para compensar. Um modelo YOLO11m podado pode ser 30% mais rápido, mantendo 99% da sua precisão original. Em dispositivos alimentados por bateria, esse ganho de eficiência pode significar horas extras de operação.

Processadores diferentes são bons em coisas diferentes, e as diferenças de desempenho são impressionantes. O mesmo modelo YOLO11n leva:

Não se trata apenas de diferenças de velocidade em relação às frequências de clock – elas refletem diferenças arquitetónicas fundamentais. As GPUs têm milhares de núcleos que funcionam em paralelo, perfeitos para as convoluções YOLO. As NPUs móveis têm circuitos especializados projetados especificamente para redes neurais. As CPUs são multifuncionais, flexíveis, mas não especializadas.

A chave para a otimização é combinar as operações YOLO com o que cada chip faz de melhor. Uma GPU realizar a mesma operação em muitos dados simultaneamente. Uma NPU móvel pode suportar apenas determinadas operações, mas as executa com incrível eficiência. Uma TPU de ponta funciona TPU com inteiros de 8 bits, mas atinge uma velocidade notável dentro dessa restrição.

Quando exporta um YOLO , algo notável acontece nos bastidores. Não convertemos apenas o formato do ficheiro – na verdade, compilamos o modelo especificamente para o seu hardware de destino. É como a diferença entre Google e um falante nativo. O processo de compilação:

O compilador pode reorganizar as operações para utilizar melhor a cache do seu processador, selecionar instruções especializadas que o seu chip suporta ou até mesmo utilizar a aprendizagem automática para encontrar a melhor estratégia de otimização. Sim, estamos a utilizar IA para otimizar IA – o futuro está aqui!

Esta etapa de compilação pode fazer uma diferença de 10 vezes no desempenho. O mesmo YOLO pode rastejar com código genérico, mas voar com instruções devidamente otimizadas.

Vamos falar sobre o que acontece quando YOLO o mundo real – especificamente, o mundo desafiador dos dispositivos de ponta. Imagine uma câmara de segurança que precisa executar YOLO , para detecção de objetos. Ela enfrenta restrições brutais:

Veja o que a otimização alcança na prática. Uma câmara de segurança executando YOLO11s:

Reduzimos o consumo de energia em 80% e, ao mesmo tempo, melhoramos o desempenho! Essa é a diferença entre um dispositivo que superaquece e gasta a bateria e outro que funciona de forma confiável durante anos.

O segredo está em escolher as compensações certas. Em dispositivos de ponta, frequentemente:

Na Ultralytics, seguimos uma abordagem sistemática para otimização. Primeiro, criamos um perfil do modelo para entender onde o tempo é realmente gasto. Muitas vezes, os gargalos não estão onde você esperaria. Talvez 80% do tempo seja gasto em apenas algumas camadas, ou as transferências de memória estejam dominando o tempo de computação.

Em seguida, aplicamos otimizações iterativamente:

Por exemplo, com a implementação do YOLO11m num telemóvel:

Cada etapa melhora o desempenho, mantendo mais de 99% da precisão original. O resultado? Detecção de objetos em tempo real num dispositivo que cabe no seu bolso.

Os dispositivos modernos estão a tornar-se mais inteligentes na utilização conjunta de vários processadores. O seu telemóvel não tem apenas um processador, mas vários, cada um especializado em tarefas diferentes:

O futuro da YOLO consiste em dividir o modelo de forma inteligente entre esses processadores. Talvez a NPU lide com as principais convoluções, a CPU a lógica de detecção final e a GPU os resultados. Cada processador faz o que faz de melhor, criando um pipeline mais eficiente do que qualquer processador individual poderia alcançar.

Estamos a desenvolver algoritmos de particionamento inteligentes que determinam automaticamente a melhor maneira de dividir YOLO os processadores disponíveis, considerando não apenas as suas capacidades, mas também o custo de transferência de dados entre eles.

Otimizar YOLO não se resume apenas a converter formatos de ficheiros; trata-se de transformar IA de ponta em algo que realmente funcione no mundo real. Através de técnicas como quantização (uso de números menores), poda (remoção de partes desnecessárias), fusão de operações (combinação de etapas) e gestão inteligente de memória, alcançamos melhorias de desempenho de 10 a 100 vezes, mantendo a precisão.

O que é notável? Não existe uma otimização universal «melhor». Um servidor em nuvem com potência ilimitada precisa de otimizações diferentes das de um drone alimentado por bateria. Um telemóvel com um chip de IA dedicado precisa de um tratamento diferente do de um Raspberry Pi. É por isso que Ultralytics tantas opções de exportação – cada uma delas é otimizada para cenários diferentes.

Todas as otimizações que discutimos têm um único objetivo: tornar a visão computacional acessível em qualquer lugar. Esteja você a desenvolver uma campainha inteligente, uma aplicação para drones ou um serviço de nuvem em grande escala, nós fornecemos as ferramentas para que YOLO dentro das suas restrições.

Quando exporta um YOLO com Ultralytics, não está apenas a guardar um ficheiro. Está a aproveitar anos de investigação para tornar as redes neurais práticas. Está a transformar um modelo de IA de última geração em algo que pode ser executado em hardware real, com restrições reais, resolvendo problemas reais.

É isso que fazemos na Ultralytics. Nós preenchemos a lacuna entre a pesquisa em IA e a implementação prática. Fazemos com que a visão computacional funcione em todos os lugares, porque o futuro da IA não se resume apenas a ter os melhores modelos, mas sim a tornar esses modelos úteis no mundo real.