从健身应用程序到病人监控,了解计算机视觉如何解决以下问题:人工智能能否在现实世界中detect 人类的行动?

从健身应用程序到病人监控,了解计算机视觉如何解决以下问题:人工智能能否在现实世界中detect 人类的行动?

日常生活充满了我们很少停下来思考的小动作。在一个房间里走动、坐在桌子旁或向朋友挥手对我们来说可能毫不费力,但用 AI 检测它们要复杂得多。对人类来说很自然的事情,当机器试图理解它时,会变得更加复杂。

这种能力被称为人类活动识别(HAR),它使计算机能够detect 和解释人类行为的模式。一款健身应用程序就是 HAR 的一个很好的应用实例。通过跟踪步数和锻炼程序,它展示了人工智能如何监控日常活动。

看到 HAR 的潜力,许多行业已经开始采用这项技术。事实上,预计到 2033 年,人类动作识别市场将达到 125.6 亿美元以上。

这一进展的很大一部分是由计算机视觉驱动的,计算机视觉是人工智能的一个分支,使机器能够分析视觉数据,例如图像和视频。借助计算机视觉和图像识别,HAR 已从研究概念演变为前沿人工智能应用中一个实用且令人兴奋的组成部分。

在本文中,我们将探讨什么是 HAR、用于识别人类动作的不同方法,以及计算机视觉如何帮助回答这个问题:人工智能能否在现实世界的应用中detect 人类动作?让我们开始吧!

人体行为识别技术通过分析身体动作,使计算机系统能够理解人类的活动或行为。与简单地检测图像中的人不同,HAR可以帮助识别该人在做什么。例如,区分行走和跑步,识别挥手,或者注意到有人摔倒。

HAR 的基础在于运动和姿势的模式。人体的手臂或腿部的姿势略有变化,就可以发出各种动作的信号。通过捕获和解释这些细微的细节,HAR 系统可以从身体运动中获得有意义的见解。

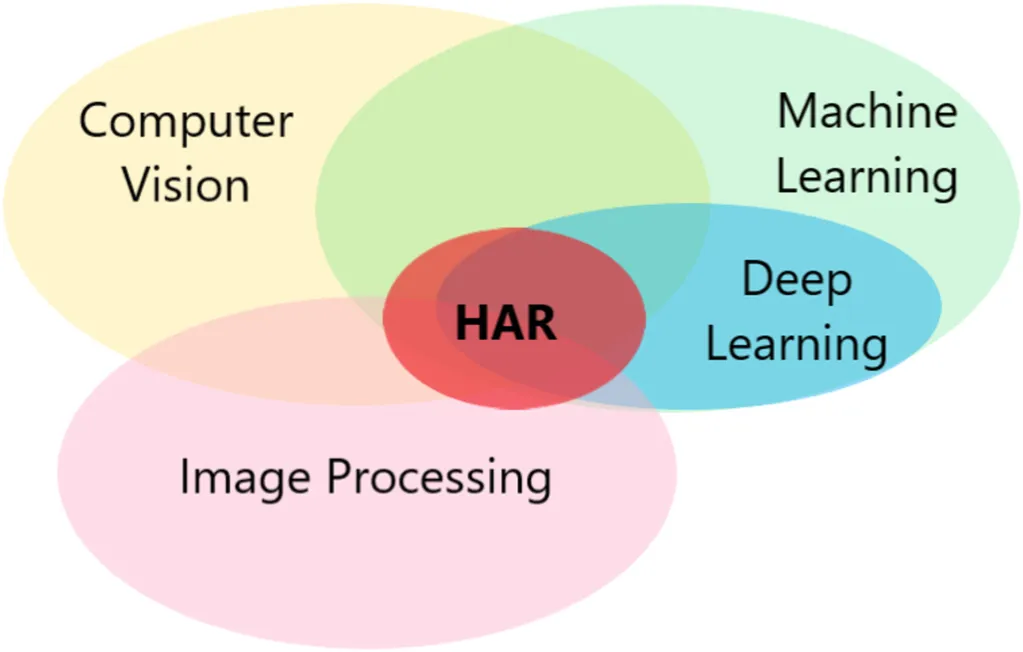

为了实现这一点,人类行为识别结合了多种技术,例如机器学习、深度学习模型、计算机视觉和图像处理,它们协同工作以分析身体动作,并以更高的精度解释人类行为。

早期的 HAR 系统更加有限。 它们只能处理受控环境中的一些简单、重复的动作,并且在现实环境中经常会遇到困难。

如今,得益于人工智能和大量的视频数据,HAR在准确性和鲁棒性方面都取得了显著进展。现代系统能够以更高的准确性识别各种活动,使该技术在医疗保健、安全和交互设备等领域具有实用性。

既然我们已经对什么是人类动作识别有了更深入的了解,那就让我们来看看机器detect 人类动作的不同方法吧。

以下是一些常用方法:

对于任何 HAR 模型或系统,数据集 都是起点。HAR 数据集是示例的集合,例如视频剪辑、图像或传感器数据,这些示例捕获了诸如行走、坐着或挥手等动作。这些示例用于训练 AI 模型以识别人类运动中的模式,然后可以将其应用于现实生活中的应用程序。

训练数据的质量直接影响模型执行的良好程度。干净、一致的数据使系统更容易准确识别操作。

因此,数据集通常在训练前进行预处理。一个常见的步骤是归一化,它以一致的方式缩放值,以减少误差并防止过拟合(模型在训练数据上表现良好,但在新数据上表现不佳)。

为了衡量模型在训练之外的表现,研究人员依赖于评估指标和基准数据集,这些指标和数据集允许进行公平的测试和比较。流行的集合(如 UCF101、HMDB51 和 Kinetics)包括数千个用于人类动作检测的标记视频剪辑。在传感器方面,从智能手机和可穿戴设备收集的数据集提供了有价值的运动信号,使识别模型在不同的环境中更加稳健。

在detect 人类行为的各种方法中,计算机视觉已迅速成为最受欢迎和研究最广泛的方法之一。它的主要优势在于可以直接从图像和视频中提取丰富的细节。通过逐帧查看像素和分析运动模式,它可以实时识别活动,而无需人们佩戴额外的设备。

深度学习,特别是卷积神经网络 (CNN) 的最新进展(CNN 旨在分析图像)使计算机视觉变得更快、更准确、更可靠。

例如,广泛使用的最先进计算机视觉模型,如 Ultralytics YOLO11就是建立在这些进步的基础上的。YOLO11 支持物体检测、实例分割、跨视频帧跟踪人物和估计人物姿势等任务,是人类活动识别的绝佳工具。

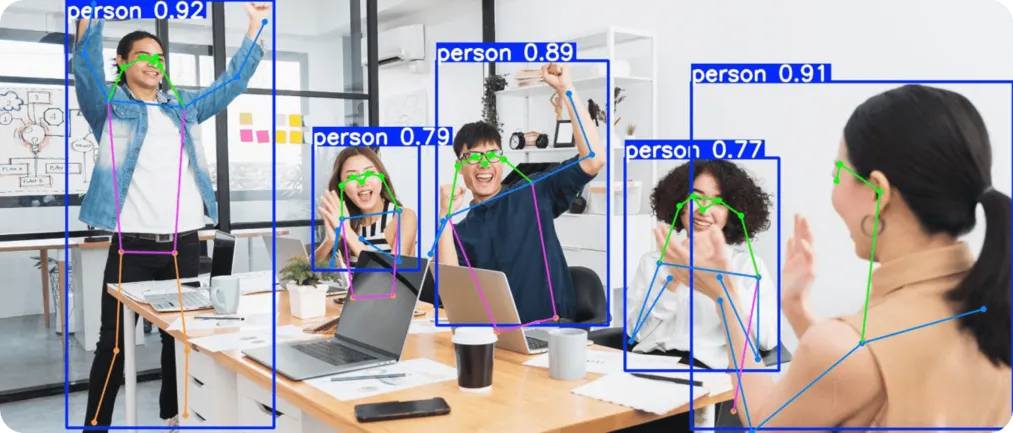

Ultralytics YOLO11 是一款视觉人工智能模型,其设计兼顾速度与精度。它支持核心计算机视觉任务,如物体检测、物体跟踪和姿势估计 。这些功能对于人类活动识别尤其有用。

物体检测可识别和定位场景中的人物,跟踪可跟踪人物在视频帧中的移动以识别动作序列,而姿势估计 可映射人体的关键关节,以区分类似的活动或detect 突然的变化(如跌倒)。

例如,可以利用模型提供的洞察力来区分一个人安静地坐着、然后站起来,最后举起双臂欢呼。这些简单的日常动作乍一看可能很相似,但如果在序列中分析,则具有非常不同的含义。

接下来,让我们仔细了解计算机视觉驱动的人体活动识别技术如何在影响我们日常生活的实际应用中使用。

在医疗保健领域,运动中的微小变化可以为了解一个人的状况提供有用的见解。例如,老年患者的绊倒或康复期间肢体的角度可能会揭示风险或进展。这些迹象通常很容易被传统方法(如检查)所忽略。

YOLO11 可以通过使用姿势估计 和图像分析来帮助实时监控病人。它可用于detect 跌倒、track 恢复练习以及观察步行或伸展等日常活动。由于它是通过视觉分析来工作的,无需传感器或可穿戴设备,因此它提供了一种简单的方法来收集准确的信息,从而为病人护理提供支持。

安防系统依赖于快速检测异常的人类活动,例如有人在禁区内闲逛、奔跑或表现出突然的攻击性。在繁忙的环境中,这些迹象往往会被遗漏,因为保安人员无法手动监视一切。这就是计算机视觉和YOLO11 的用武之地。

YOLO11 支持实时视频监控,可detect 可疑动向并发送即时警报,从而使安防监控变得更加简单。它支持公共场所的人群安全,并加强私人区域的入侵检测。

通过这种方法,保安人员可以与计算机视觉系统协同工作,创建人机交互和伙伴关系,从而能够更快、更及时地响应可疑活动。

以下是使用计算机视觉进行人体活动识别的一些优势:

虽然使用计算机视觉进行 HAR 有很多好处,但也存在一些局限性需要考虑。以下是一些需要记住的因素:

人工智能和计算机视觉使机器能够更准确、实时地识别人类行为。通过分析视频帧和运动模式,这些系统可以识别日常手势和突发变化。随着技术的不断进步,人类活动识别正在走出研究实验室,成为医疗保健、安全和日常应用的实用工具。

访问我们的GitHub 仓库并加入我们的社区,了解更多关于 AI 的信息。查看我们的解决方案页面,了解机器人技术中的 AI和制造业中的计算机视觉。探索我们的许可选项,开始使用视觉 AI。