了解视觉人工智能中图像匹配的工作原理,探索帮助机器detect、比较和理解视觉数据的核心技术。

了解视觉人工智能中图像匹配的工作原理,探索帮助机器detect、比较和理解视觉数据的核心技术。

当你看到同一物体的两张图片时,例如一幅画和一张汽车照片,很容易就能发现它们的共同点。然而,对于机器来说,这就不那么简单了。

计算机视觉是人工智能(AI)的一个分支,可帮助机器解释和理解视觉信息。计算机视觉使系统能够detect 物体、理解场景并从图像或视频中提取模式。

特别是,有些视觉任务超出了分析单一图像的范围。它们需要对图像进行比较,以发现相似之处、差异或track 随时间发生的变化。

视觉人工智能涵盖一系列广泛的技术,其中一项基本能力被称为图像匹配,其重点是识别图像之间的相似性,即使在光线、角度或背景不同的情况下也是如此。这种技术可用于各种应用,包括机器人、增强现实和地理测绘。

在本文中,我们将探讨什么是图像匹配、图像匹配的核心技术以及图像匹配在现实世界中的一些应用。让我们开始吧!

图像匹配可以让计算机系统了解两张图像是否包含相似的内容。人类可以通过注意形状、颜色和图案直观地做到这一点。

而计算机则依赖于数字数据。它们通过研究每个像素(数字图像的最小单位)来分析图像。

每幅图像都是以像素网格的形式存储的,每个像素通常都有红、绿、蓝(RGB)值。当图像旋转、调整大小、从不同角度观看或在不同光线条件下拍摄时,这些值都会发生变化。由于这些变化,逐个像素比较图像通常并不可靠。

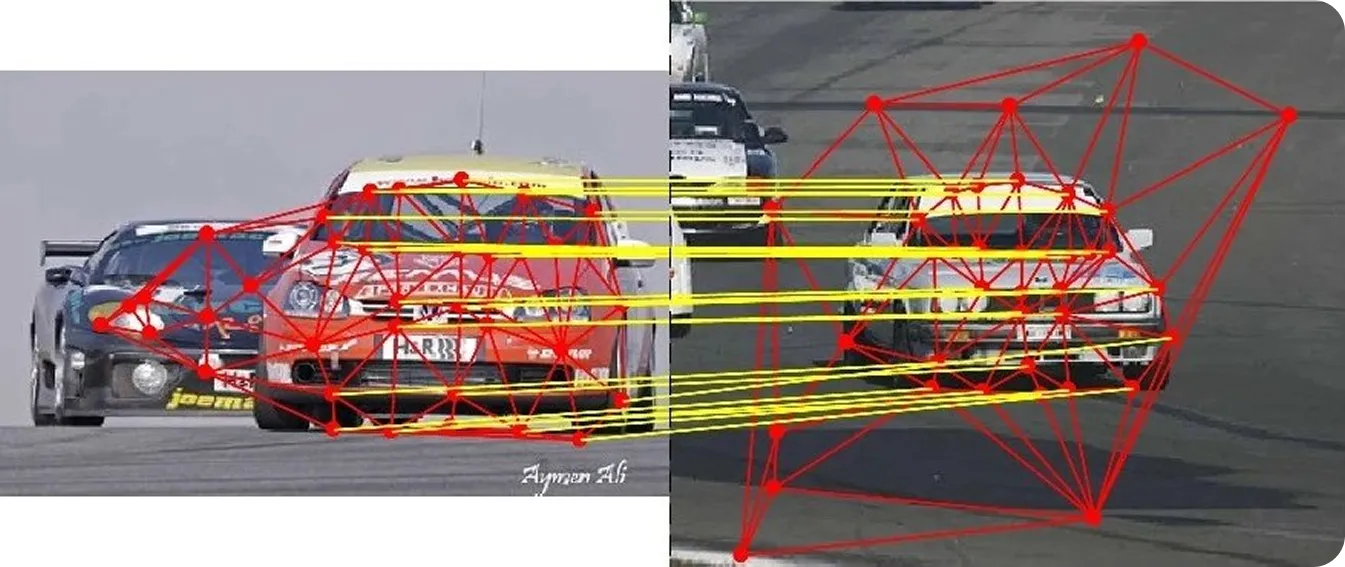

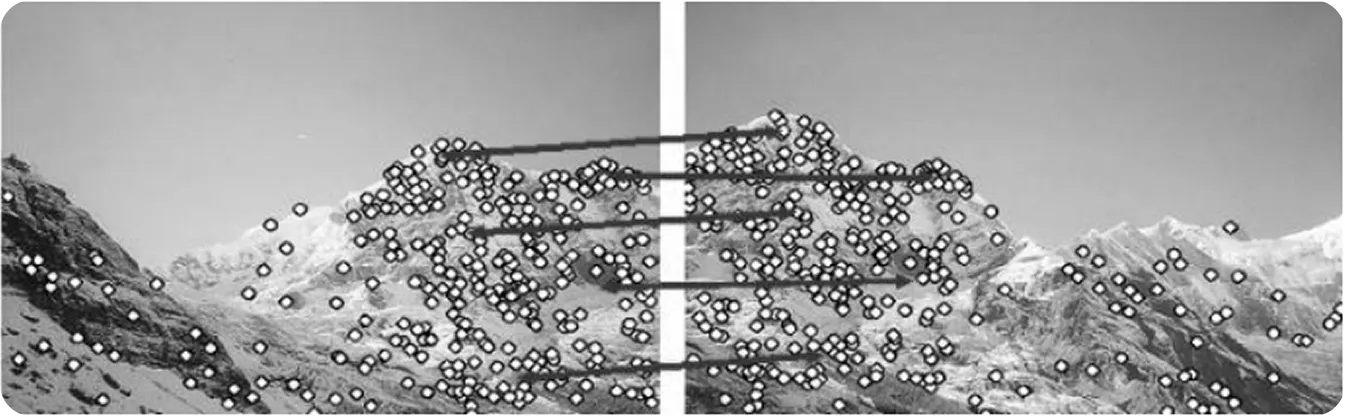

为了使比较更加一致,图像匹配侧重于局部特征或角落、边缘和纹理区域,即使图像稍有变化,这些特征也会保持稳定。通过在多幅图像中检测这些特征或关键点,系统可以更准确地进行比较。

这一过程被广泛应用于导航、定位、增强现实、制图、三维重建和视觉搜索等领域。当系统在不同图像或多帧图像中识别出相同点时,就能track 运动、了解场景结构,并在动态环境中做出可靠的决策。

图像匹配包括几个关键步骤,帮助系统识别和比较图像中的相似区域。每个步骤都能在不同条件下提高准确性、一致性和鲁棒性。

下面将逐步介绍图像匹配的工作原理:

在探讨图像匹配在现实世界中的应用之前,让我们先仔细了解一下计算机视觉系统中使用的图像匹配技术。

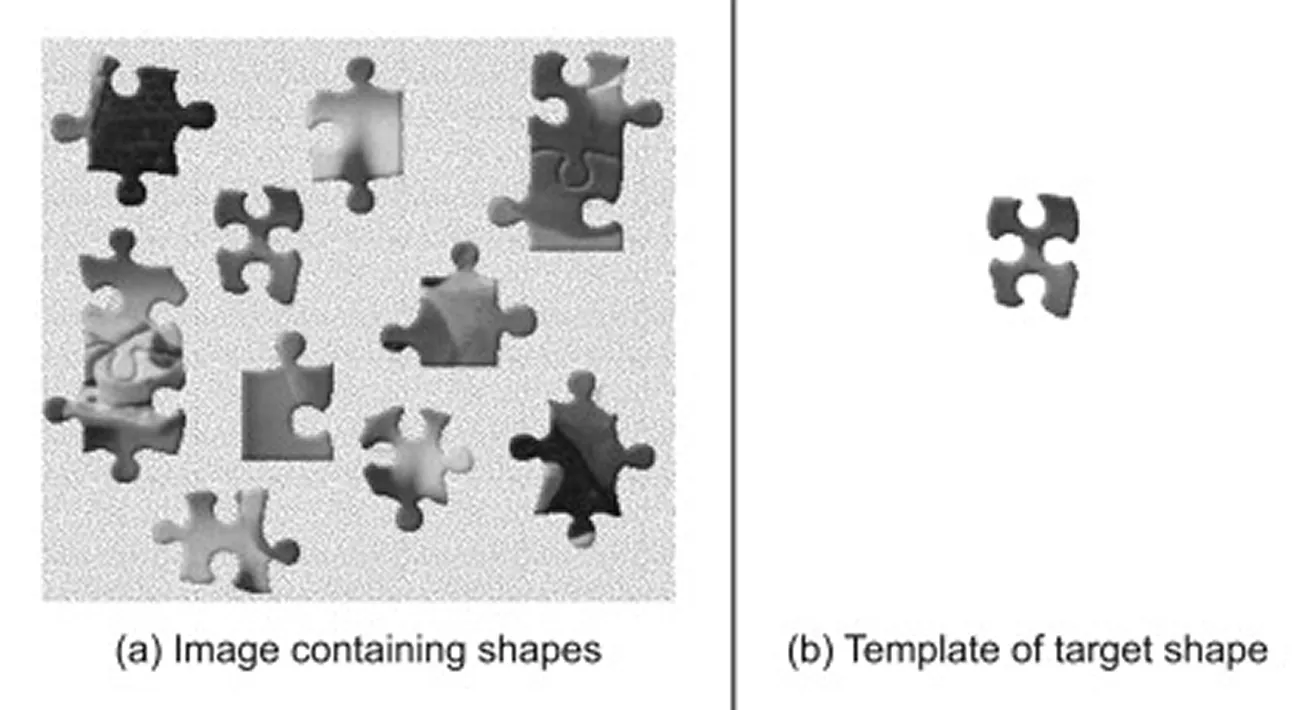

模板匹配是最直接的图像匹配方法之一。它通常被认为是一种图像处理技术,而不是现代计算机视觉方法,因为它依赖于直接的像素比较,并不提取更深层次的视觉特征。

它用于在较大的场景中定位较小的参考图像或模板。它使用一种算法,在主图像上滑动模板,并在每个位置计算相似度得分,以衡量两个区域的匹配程度。得分最高的区域被认为是最佳匹配区域,表明物体最有可能出现在场景中的位置。

当物体的比例、旋转和光照保持一致时,这种技术就能很好地发挥作用,因此是受控环境或基线比较的理想选择。但是,当物体看起来与模板不同时,比如物体的大小发生变化、旋转、部分遮挡或出现在嘈杂或复杂的背景下时,其性能就会下降。

在深度学习被广泛采用之前,图像匹配主要依赖于经典的计算机视觉算法,这种算法可以检测图像中的独特关键点。这些方法不对每个像素进行比较,而是分析图像的梯度或强度变化,以突出边角、边缘和纹理区域。

然后,每个检测到的关键点都会用一个紧凑的数字摘要(称为描述符)来表示。在比较两幅图像时,匹配器会评估这些描述符,找出最相似的图像对。

较高的相似度得分通常表明两个图像中出现了相同的物理点。匹配器还会使用特定的距离度量或评分规则来判断特征的一致性,从而提高整体可靠性。

以下是一些用于图像匹配的主要经典计算机视觉算法:

与依赖特定规则的传统方法不同,深度学习可自动从大型数据集(即人工智能模型从中学习模式的视觉数据集合)中学习特征。这些模型通常在 GPU(图形处理器)上运行,GPU 可提供处理大批量图像和高效训练复杂神经网络所需的高计算能力。

这使得人工智能模型有能力处理现实世界中的变化,如光线、摄像机角度和遮挡物。有些模型还能将所有步骤整合到一个工作流程中,支持在具有挑战性的条件下实现强大的性能。

以下是一些基于深度学习的图像特征提取和匹配方法:

现在,我们对图像匹配的工作原理有了更深入的了解,让我们来看看它在现实世界中发挥重要作用的一些应用。

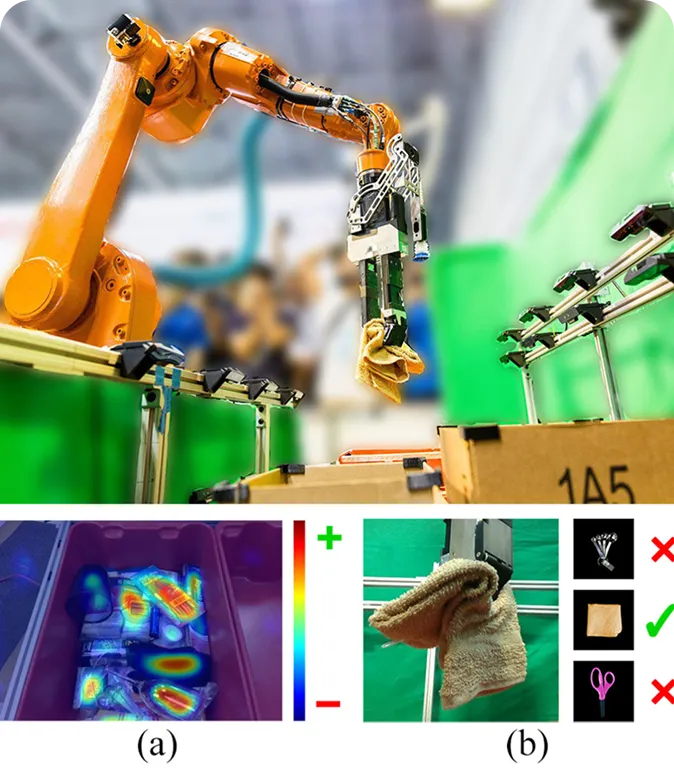

机器人经常在繁忙多变的环境中工作,它们需要了解哪些物体存在以及如何放置。图像匹配可以通过将图像与存储图像或参考图像进行比较,帮助机器人理解它们所看到的物体。这样,这些机器人就能更容易地识别物体、track 物体的移动,甚至在光线或摄像机角度发生变化时也能适应。

例如,在仓库中,机器人拾放系统可以利用图像匹配来识别和处理不同的物品。机器人首先抓取一个物品,然后将其图像与参考样本进行比较,从而对其进行识别。

一旦找到匹配对象,机器人就知道如何将其正确分类或放置。这种方法能让机器人识别熟悉的和新的物体,而无需重新训练整个系统。它还能帮助机器人做出更好的实时决策,如整理货架、组装零件或重新排列物品。

在无人机测绘、虚拟现实和建筑检测等领域,系统通常需要从多幅二维图像中重建三维模型。为此,系统需要通过图像匹配来识别多张图像中出现的共同关键点,如边角或纹理区域。

这些共享点有助于系统理解图像在三维空间中的相互关系。这一想法与 "运动中的结构"(SfM)密切相关,后者是一种通过识别和匹配从不同视角拍摄的图像中的关键点来构建三维结构的技术。

如果匹配不准确,生成的三维模型可能会失真或不完整。因此,研究人员一直在努力提高三维重建图像匹配的可靠性,最近的研究进展已经显示出良好的效果。

一个有趣的例子是HashMatch,这是一种更快、更强大的图像匹配算法。HashMatch 将图像细节转换成称为散列码的紧凑模式,这样即使在光线或视角不同的情况下,也能更容易地识别正确的匹配结果并移除异常值。

在大规模数据集上进行测试时,HashMatch 生成的三维重建模型更清晰、更逼真,对齐错误更少。这使得它特别适用于无人机测绘、AR 系统和文化遗产保护等对精度要求极高的应用。

说到增强现实技术(AR),保持虚拟对象与现实世界保持一致往往是一项挑战。室外环境会因阳光和天气等环境条件而不断变化。现实世界中的细微差别会使虚拟元素看起来不稳定或稍有偏差。

为了解决这个问题,AR 系统使用图像匹配来解释周围环境。通过比较实时相机帧和存储的参考图像,它们可以了解用户所处的位置以及场景的变化情况。

例如,在一项涉及使用 XR(扩展现实)眼镜进行军事风格户外 AR 培训的研究中,研究人员使用 SIFT 和其他基于特征的方法来匹配真实图像和参考图像之间的视觉细节。即使用户快速移动或光线发生变化,精确的匹配也能使虚拟元素与真实世界保持正确对齐。

图像匹配是计算机视觉的核心组成部分,它使系统能够理解不同图像之间的关系或场景随时间的变化。它在机器人技术、增强现实、三维重建、自主导航以及其他许多对精度和稳定性要求极高的实际应用中发挥着至关重要的作用。

借助 SuperPoint 和 LoFTR 等先进的人工智能模型,如今的系统正变得比早期的方法更加强大。随着机器学习技术、专用视觉模块、神经网络和数据集的不断进步,图像匹配可能会变得更快、更准确、适应性更强。

加入我们不断壮大的社区,探索我们的GitHub 存储库,获取人工智能实践资源。要立即使用 Vision AI 进行构建,请探索我们的许可选项。访问我们的解决方案页面,了解农业人工智能如何改变农业生产,以及Vision AI如何在医疗保健领域塑造未来。