了解姿势估计 如何用于detect 图像和视频中的detect 关键点,估计二维和三维姿势,并为各种视觉人工智能应用提供支持。

了解姿势估计 如何用于detect 图像和视频中的detect 关键点,估计二维和三维姿势,并为各种视觉人工智能应用提供支持。

作为人类,我们本能地解读动作。当有人前倾身体、转动头部或抬起手臂时,你便能立刻推断出他们的意图。这种无声的、近乎潜意识的技能,塑造着我们与他人互动的方式,也影响着我们探索世界的方式。

随着技术日益融入日常生活,我们自然希望设备能像人类一样流畅地理解动作。人工智能领域的最新进展,尤其是基于深度学习的突破,正使这一愿景成为可能。其中计算机视觉技术尤为关键,它帮助机器从图像和视频中提取意义,并推动着这一领域的进步。

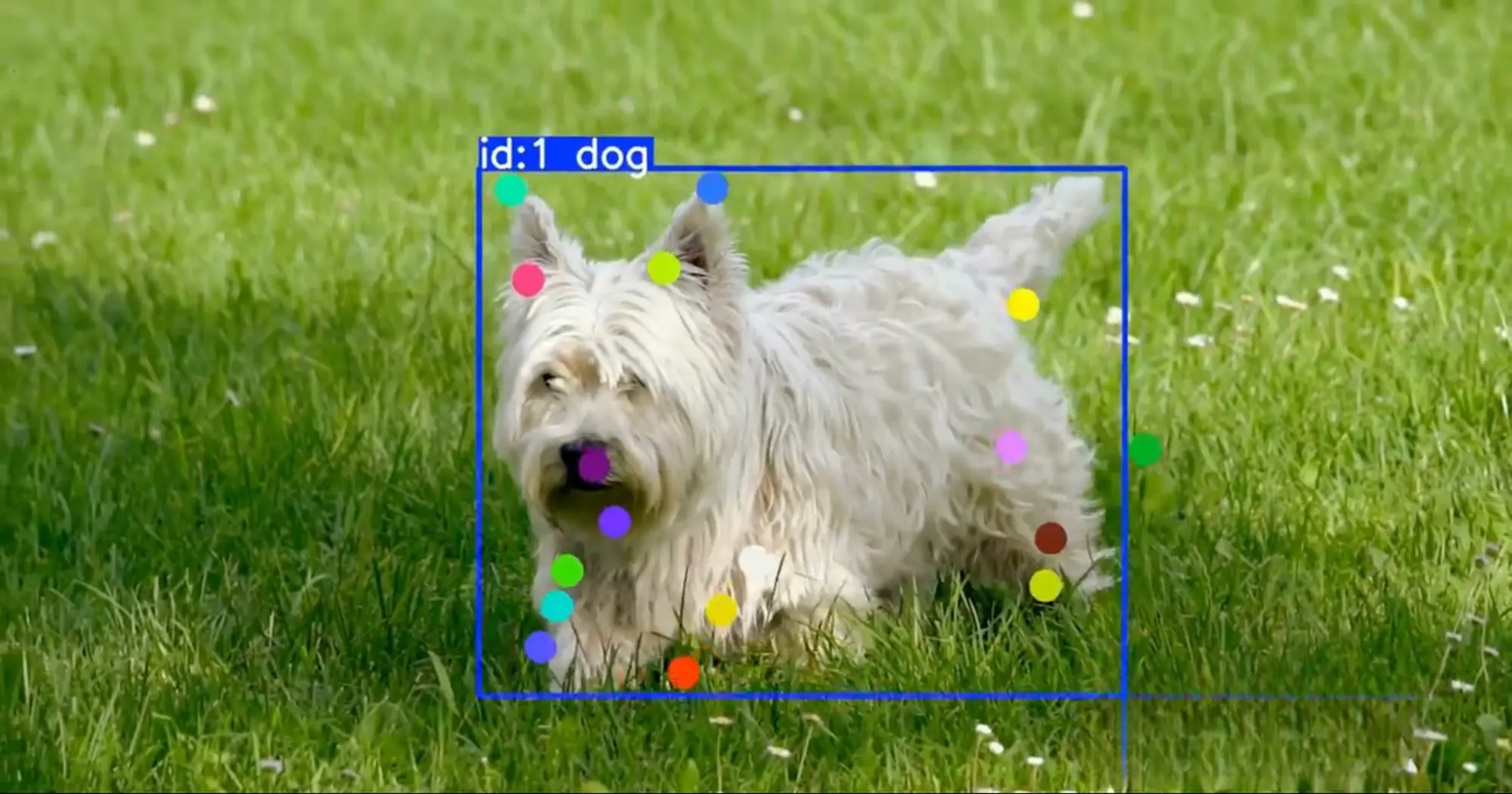

例如,姿势估计 计算机视觉领域常见的任务,旨在预测图像或视频帧中预定义人体关键点(如肩膀、肘部、髋部和膝盖)的位置。这些关键点可通过固定骨架定义连接起来,形成简化的姿势估计 。

计算机视觉模型,例如 Ultralytics YOLO11 以及即将Ultralytics 计算机视觉模型支持姿势估计 等任务,可用于驱动实时应用,包括健身运动中的动作反馈、安全监控以及交互式增强现实体验。

.webp)

本文将深入探讨姿势估计 解析姿势估计 、应用场景,并介绍当前顶尖的模型与库。让我们开始吧!

姿势估计 计算机视觉技术,它能帮助系统理解人或物体在图像或视频中的位置。该技术并非对每个像素进行同等分析,而是预测一组稳定的特征点,例如头部、肩膀、肘部、髋部、膝盖和脚踝。

大多数模型会输出这些关键点的坐标以及反映每个预测正确概率的评分。随后可通过预定义的骨架布局将这些关键点连接起来,形成简单的姿势估计 。

在视频中逐帧应用时,生成的关键点可随时间关联以估计运动轨迹。这使得形态检测、动作分析及基于手势的交互等应用成为可能。

.webp)

人体动作蕴含着大量信息。一个人弯腰、伸手或转移重心的方式,能揭示其意图、努力程度、疲劳状态,甚至受伤风险。直到最近,要捕捉如此精细的动作细节,通常需要专用传感器、动作捕捉服或受控实验室环境。

姿势估计 改变了这一现状。通过从常规图像和视频中提取关键身体特征点,计算机能够利用标准摄像头分析动作。这使得动作分析在现实场景中更易于获取、更具可扩展性且更具实用性。

姿势估计 可通过以下几种方式产生影响:

姿势估计的概念已存在多年。早期方法采用简单的几何模型和手工制定的规则,通常仅在受控条件下有效。

例如,当人静止于固定位置时,系统可能表现良好,但一旦开始行走、转身或与现实场景中的物体交互,系统便会失效。这些方法通常难以应对自然动作、变换的摄像机角度、杂乱的背景以及局部遮挡等问题。

现代姿势估计 依赖深度学习来应对这些挑战。通过在大型标注数据集上训练卷积神经网络,模型能够学习视觉模式,从而在不同姿势、人物和环境中更可靠地detect 。

随着更多示例的输入,该模型不断优化预测结果,并能更有效地推广至新场景。得益于这一进展,姿势估计 现已支持广泛的实际应用场景,包括工作场所监控与人体工学分析,以及运动数据分析——教练和分析师可借此研究运动员的运动模式。

姿势估计 多种形式,具体取决于场景和测量需求。以下是您可能遇到的主要类型:

.webp)

姿势估计 多种物体,但为简化说明,我们聚焦于人体姿势估计 。

大多数人体姿势估计 都是基于标注数据集进行训练的,这些数据集包含大量图像和视频帧,其中关键身体部位均被标注。通过学习这些示例,模型能够掌握与人体特征点(如肩膀、肘部、髋部、膝盖和脚踝)相关的视觉模式,从而在新场景中准确预测关键点。

另一个关键方面是模型的推理架构,它决定了模型如何检测关键点并将其组合成完整的姿态。有些系统先detect ,然后在每个人的区域内估计关键点;而另一些系统detect 在整个图像中detect ,然后将它们分组到个体中。新型单阶段设计能够一次性预测姿态,在速度和准确性之间取得平衡,以满足实时应用需求。

接下来,让我们详细探讨不同的姿势估计 。

在自底向上的方法中,模型首先观察整幅图像并定位身体关键点,如头部、肩膀、肘部、髋部、膝盖和脚踝。此阶段并非试图分离人物,而是通过姿势估计 在场景中检测所有关键点或身体关节。

随后,系统执行第二步进行点位连接。它将属于同一人的关键点进行关联,并将其聚合为完整的骨架模型,每人对应一个骨架。由于无需预先detect 存在,自下而上的方法在人群拥挤的场景中表现尤为出色——这类场景中人物可能相互重叠、体型差异显著或部分被遮挡。

相比之下,自上而下的系统首先检测图像中的每个人。它们为每个个体添加边界框,并将每个框视为独立区域进行分析。

当人被隔离后,模型会预测该区域内的身体关键点。这种分步设置通常能产生非常精确的结果,尤其当场景中只有少数人且每个人都清晰可见时。

单阶段模型(有时称为混合模型)能在单次处理中预测姿态。它们无需先进行人物检测再进行关键点估计,而是同时输出人物位置与身体关键点。

由于所有运算都在单一模块内完成,这类模型通常运行更快、效率更高,因此特别适合实时应用场景,例如实时运动追踪和动作捕捉。Ultralytics YOLO11 模型YOLO11 基于这一理念YOLO11 ,旨在实现速度与可靠关键点预测之间的平衡。

无论采用何种方法姿势估计 在现实世界中要具备可靠性,仍需经过精心训练和测试。该模型通常通过学习大量标注人体关键点的图像(有时还包括视频)来提升能力,从而能够处理不同的姿势、摄像机角度和环境。

一些知名的姿势估计 包括COCO 、MPII人体姿势估计、CrowdPose和OCHuman。当这些数据集无法反映模型部署时的实际环境时,工程师通常会从目标场景(如工厂车间、健身房或诊所)收集并标注额外图像。

.webp)

训练完成后,模型性能需在标准基准测试上进行评估,以衡量其准确性和鲁棒性,并为实际应用中的进一步调优提供指导。评估结果通常采用均值平均精度(mAP)进行报告,该指标通过将预测姿态与标注的真实姿态进行对比,综合反映不同置信度阈值下的性能表现。

在许多姿势估计 ,预测姿势估计 姿势估计 物体关键点相似度(OKS)与真实姿势估计 姿势估计 匹配。OKS衡量预测关键点与标注关键点的接近程度,同时考虑人体比例等因素以及每个关键点的典型定位难度。

姿势估计 还会为检测到的人体及各个关键点输出置信度分数。这些分数反映了模型的置信程度,用于对预测结果进行排序和过滤,这在遮挡、运动模糊或异常摄像机角度等挑战性条件下尤为重要。

如今有许多姿势估计 可供使用,每种工具都在速度、精度和易用性之间寻求平衡。以下是一些最常用的工具和库:

姿势估计 正日益被用于将普通视频转化为有价值的动作分析。通过逐帧追踪人体关键点,这些系统能够从摄像头画面中推断姿势、动作及身体行为,使该技术在众多现实场景中得以实际应用。

例如在医疗保健和康复姿势估计 能帮助临床医生观察并量化患者在治疗和康复过程中的动作表现。通过从普通视频记录中提取身体特征点,该技术可用于评估姿势、活动范围及随时间变化的整体运动模式。这些测量数据既能辅助优化传统临床评估,在某些情况下还能无需佩戴式传感器或专业设备即可轻松track 。

同样地,在体育和广播领域,姿势估计 直接从视频流中分析运动员的动作。一个有趣的例子是鹰眼系统——这种基于摄像头的追踪系统被用于职业体育赛事的裁判判定和转播图形制作。它通过从摄像机视角估算运动员的身体关键点,同时提供骨骼追踪功能。

选择合适的姿势估计 首先要明确计算机视觉项目的具体需求。某些应用场景更注重实时处理速度,而另一些则需要更高的精度和细节表现。

目标部署设备同样至关重要。移动应用和边缘设备通常需要轻量高效的模型,而大型模型则更适合服务器或云环境。

此外,易用性也可能发挥作用。完善的文档、流畅的部署以及对定制化训练的支持,都能使您的项目更高效。

简而言之,不同工具在不同领域各有优势。例如Ultralytics YOLO 在速度、精度和部署便捷性之间实现了实用平衡,适用于众多现实场景中的姿势估计 应用。

姿势估计 检测图像和视频中的身体关键点,帮助计算机理解人类动作。YOLO11 模型使得在体育、医疗、工作场所安全及交互体验等领域构建实时应用变得更为简便。随着模型持续提升速度与精度姿势估计 有望成为众多视觉人工智能系统的标准功能。

想了解更多关于人工智能的信息?欢迎访问我们的社区和 GitHub代码库。浏览解决方案页面,探索机器人领域的人工智能应用及 制造业中的计算机视觉技术。了解我们的授权方案,立即开始构建计算机视觉项目!