Pode a IA detect acções humanas? Explorar o reconhecimento de actividades

Desde aplicações de fitness à monitorização de pacientes, descubra como a visão computacional aborda a questão: pode a IA detect acções humanas em ambientes reais?

Desde aplicações de fitness à monitorização de pacientes, descubra como a visão computacional aborda a questão: pode a IA detect acções humanas em ambientes reais?

A vida diária é repleta de pequenos movimentos nos quais raramente paramos para pensar. Caminhar por uma sala, sentar-se em uma mesa ou acenar para um amigo pode parecer fácil para nós, mas detectá-los com IA é muito mais complicado. O que é natural para os humanos se traduz em algo muito mais complexo quando uma máquina está tentando compreendê-lo.

Esta capacidade é conhecida como reconhecimento da atividade humana (HAR) e permite aos computadores detect e interpretar padrões no comportamento humano. Uma aplicação de fitness é um excelente exemplo de HAR em ação. Ao seguir os passos e as rotinas de treino, mostra como a IA pode monitorizar as actividades diárias.

Vendo o potencial do HAR, muitas indústrias começaram a adotar essa tecnologia. De fato, espera-se que o mercado de reconhecimento de ação humana atinja mais de US$ 12,56 bilhões até 2033.

Uma parte significativa desse progresso é impulsionada pela visão computacional, um ramo da IA que permite que as máquinas analisem dados visuais, como imagens e vídeos. Com a visão computacional e o reconhecimento de imagem, o HAR evoluiu de um conceito de pesquisa para uma parte prática e empolgante de aplicações de IA de ponta.

Neste artigo, vamos explorar o que é a RA, os diferentes métodos utilizados para reconhecer acções humanas e como a visão por computador ajuda a responder à pergunta: Pode a IA detect acções humanas em aplicações do mundo real? Vamos lá começar!

O reconhecimento de ações humanas possibilita que os sistemas de computador compreendam as atividades ou ações humanas, analisando os movimentos do corpo. Ao contrário de simplesmente detectar uma pessoa em uma imagem, o HAR pode ajudar a identificar o que a pessoa está fazendo. Por exemplo, distinguir entre caminhar e correr, reconhecer um aceno de mão ou notar quando alguém cai.

A base do HAR reside em padrões de movimento e postura. Uma ligeira mudança na forma como os braços ou pernas de um humano estão posicionados pode sinalizar uma variedade de ações. Ao capturar e interpretar esses detalhes sutis, os sistemas HAR podem obter insights significativos dos movimentos do corpo.

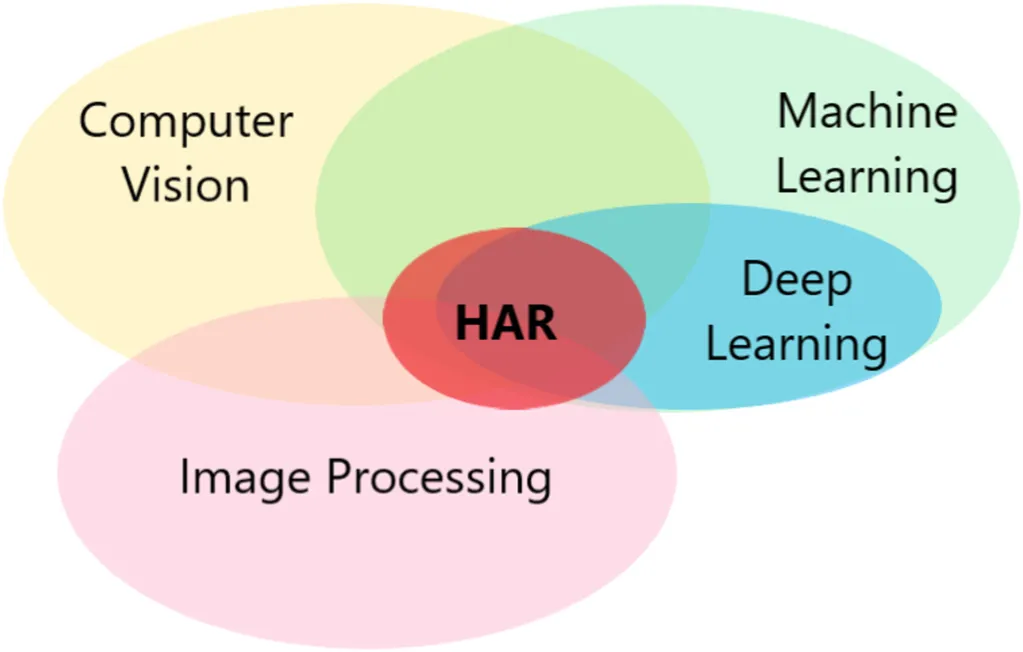

Para conseguir isso, o reconhecimento de ações humanas combina múltiplas tecnologias, como aprendizado de máquina, modelos de aprendizado profundo, visão computacional e processamento de imagem, que trabalham juntas para analisar movimentos corporais e interpretar ações humanas com maior precisão.

Os sistemas HAR anteriores eram muito mais limitados. Eles podiam lidar apenas com algumas ações simples e repetitivas em ambientes controlados e frequentemente tinham dificuldades em situações do mundo real.

Hoje, graças à IA e a grandes quantidades de dados de vídeo, o HAR avançou significativamente em precisão e robustez. Os sistemas modernos podem reconhecer uma ampla gama de atividades com muito mais precisão, tornando a tecnologia prática para áreas como saúde, segurança e dispositivos interativos.

Agora que compreendemos melhor o que é o reconhecimento de acções humanas, vamos analisar as diferentes formas como as máquinas podem detect acções humanas.

Aqui estão alguns dos métodos comuns:

Para qualquer modelo ou sistema HAR, os datasets são o ponto de partida. Um dataset HAR é uma coleção de exemplos, como videoclipes, imagens ou dados de sensores, que capturam ações como caminhar, sentar ou acenar. Esses exemplos são usados para treinar modelos de IA para reconhecer padrões no movimento humano, que podem ser aplicados em aplicações da vida real.

A qualidade dos dados de treinamento afeta diretamente o desempenho de um modelo. Dados limpos e consistentes facilitam o reconhecimento preciso de ações pelo sistema.

É por isso que os conjuntos de dados são frequentemente pré-processados antes do treinamento. Uma etapa comum é a normalização, que dimensiona os valores de forma consistente para reduzir erros e evitar o overfitting (quando um modelo tem um bom desempenho nos dados de treinamento, mas tem dificuldades com novos dados).

Para medir o desempenho dos modelos além do treino, os investigadores confiam em métricas de avaliação e conjuntos de dados de referência que permitem testes e comparações justas. Coleções populares como UCF101, HMDB51 e Kinetics incluem milhares de videoclipes rotulados para deteção de ação humana. No lado do sensor, os conjuntos de dados recolhidos de smartphones e wearables fornecem sinais de movimento valiosos que tornam os modelos de reconhecimento mais robustos em diferentes ambientes.

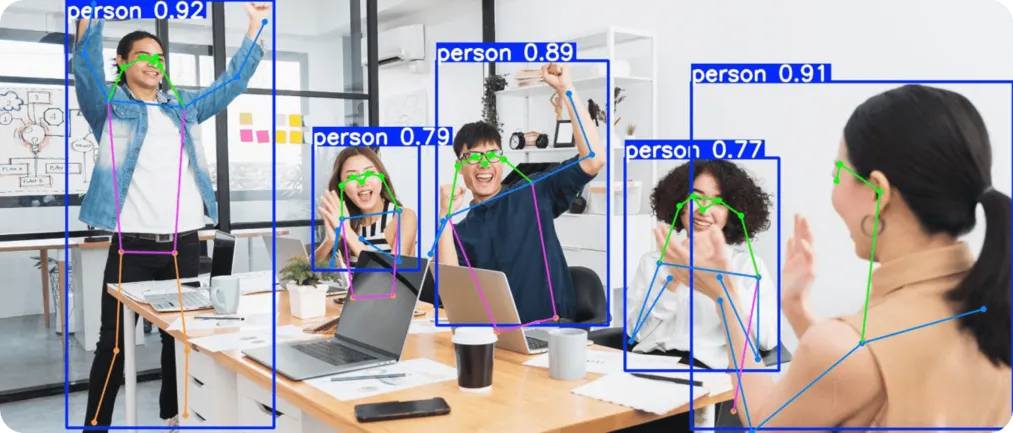

Das diferentes formas de detect acções humanas, a visão por computador tornou-se rapidamente uma das mais populares e amplamente investigadas. A sua principal vantagem é o facto de poder extrair detalhes ricos diretamente de imagens e vídeos. Ao olhar para os pixéis fotograma a fotograma e ao analisar os padrões de movimento, pode reconhecer actividades em tempo real sem a necessidade de as pessoas usarem dispositivos adicionais.

O progresso recente em deep learning, especialmente nas redes neurais convolucionais (CNNs), projetadas para analisar imagens, tornou a visão computacional mais rápida, precisa e confiável.

Por exemplo, modelos de visão computacional de última geração amplamente utilizados, como o Ultralytics YOLO11 são construídos com base nestes avanços. YOLO11 suporta tarefas como a deteção de objectos, a segmentação de instâncias, o seguimento de pessoas através de fotogramas de vídeo e a estimativa de poses humanas, o que o torna uma excelente ferramenta para o reconhecimento da atividade humana.

YOLO11 Ultralytics YOLO11 é um modelo de IA de visão concebido para ser rápido e preciso. Suporta as principais tarefas de visão por computador, como a deteção de objectos, o seguimento de objectos e a estimativa de pose. Estas capacidades são especialmente úteis para o reconhecimento da atividade humana.

A deteção de objectos identifica e localiza as pessoas numa cena, o seguimento segue os seus movimentos através de fotogramas de vídeo para reconhecer sequências de ação e a estimativa de pose mapeia as principais articulações do corpo humano para distinguir actividades semelhantes ou detect alterações súbitas como uma queda.

Por exemplo, insights do modelo podem ser usados para diferenciar alguém sentado em silêncio, que se levanta e, finalmente, levanta os braços para comemorar. Essas ações cotidianas simples podem parecer semelhantes à primeira vista, mas carregam significados muito diferentes quando analisadas em sequência.

Em seguida, vamos dar uma olhada mais de perto em como o reconhecimento de atividade humana, impulsionado pela visão computacional, é aplicado em casos de uso do mundo real que impactam nosso dia a dia.

Na área da saúde, pequenas mudanças no movimento podem fornecer informações úteis sobre a condição de uma pessoa. Por exemplo, um tropeço de um paciente idoso ou o ângulo de um membro durante a reabilitação podem revelar riscos ou progresso. Esses sinais são frequentemente fáceis de perder por meios tradicionais, como exames.

YOLO11 pode ajudar, utilizando a estimativa de pose e a análise de imagens para monitorizar os doentes em tempo real. Pode ser utilizado para detect quedas, track exercícios de recuperação e observar actividades diárias, como caminhar ou fazer alongamentos. Uma vez que funciona através de análise visual sem necessidade de sensores ou dispositivos portáteis, oferece uma forma simples de recolher informações exactas que apoiam os cuidados dos doentes.

Os sistemas de segurança baseiam-se na deteção rápida de actividades humanas invulgares, como alguém a vaguear, a correr numa área restrita ou a mostrar uma agressividade súbita. Estes sinais passam muitas vezes despercebidos em ambientes movimentados, onde os guardas de segurança não podem observar tudo manualmente. É aí que entram a visão computacional e YOLO11 .

YOLO11 facilita a monitorização da segurança, alimentando a videovigilância em tempo real que pode detect movimentos suspeitos e enviar alertas instantâneos. Apoia a segurança de multidões em espaços públicos e reforça a deteção de intrusões em áreas privadas.

Com esta abordagem, os seguranças podem trabalhar em conjunto com os sistemas de visão computacional, criando uma interação e parceria homem-computador que permite respostas mais rápidas e oportunas a atividades suspeitas.

Aqui estão algumas das vantagens de usar a visão computacional para o reconhecimento de atividades humanas:

Embora existam muitos benefícios no uso da visão computacional para HAR, também existem limitações a serem consideradas. Aqui estão alguns fatores a serem lembrados:

A inteligência artificial e a visão computacional estão permitindo que as máquinas reconheçam as ações humanas com mais precisão e em tempo real. Ao analisar quadros de vídeo e padrões de movimento, esses sistemas podem identificar gestos cotidianos e mudanças repentinas. À medida que a tecnologia continua a melhorar, o reconhecimento da atividade humana está saindo dos laboratórios de pesquisa e se tornando uma ferramenta prática para a área da saúde, segurança e aplicações cotidianas.

Explore mais sobre IA visitando nosso repositório GitHub e juntando-se à nossa comunidade. Consulte nossas páginas de soluções para saber mais sobre IA em robótica e visão computacional na indústria transformadora. Descubra nossas opções de licenciamento para começar a usar a Vision AI.