Modelos multimodais e aprendizado multimodal: Expandindo os recursos da IA

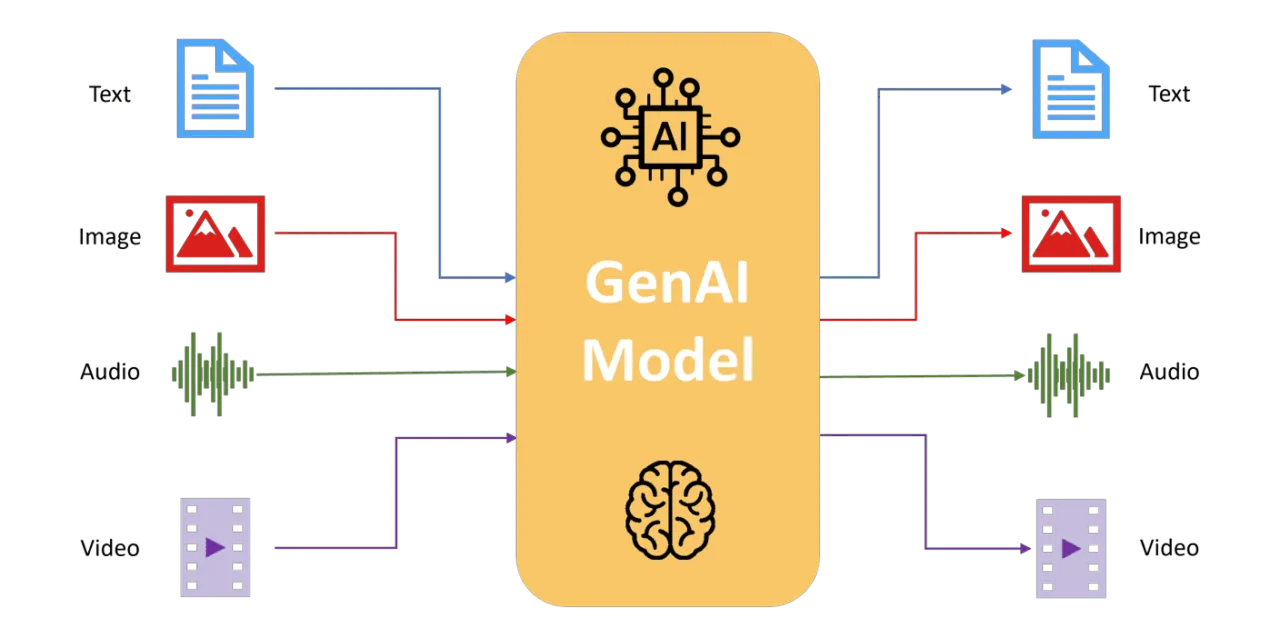

Explore como os modelos multimodais integram texto, imagens, áudio e dados de sensores para impulsionar a percepção, o raciocínio e a tomada de decisões da IA.

Explore como os modelos multimodais integram texto, imagens, áudio e dados de sensores para impulsionar a percepção, o raciocínio e a tomada de decisões da IA.

Os sistemas de IA tradicionais normalmente processam informações de uma única fonte de dados, como texto, imagens ou áudio. Embora essas abordagens unimodais se destaquem em tarefas especializadas, elas geralmente não conseguem lidar com cenários complexos do mundo real que envolvem múltiplas entradas simultâneas. O aprendizado multimodal aborda isso integrando diversos fluxos de dados em uma estrutura unificada, permitindo uma compreensão mais rica e consciente do contexto.

Inspirados pela percepção humana, os modelos multimodais analisam, interpretam e agem com base em entradas combinadas, assim como os humanos que naturalmente integram visão, som e linguagem. Esses modelos permitem que a IA lide com cenários complexos com maior precisão, robustez e adaptabilidade.

Neste artigo, exploraremos como os modelos multimodais evoluíram, detalharemos como eles funcionam, discutiremos suas aplicações práticas dentro da visão computacional e avaliaremos as vantagens e os desafios associados à integração de vários tipos de dados.

Você deve estar se perguntando o que exatamente é o aprendizado multimodal e por que ele é importante para a inteligência artificial (IA). Os modelos de IA tradicionais normalmente lidam com um tipo de dado por vez, sejam imagens, texto, áudio ou entradas de sensores.

O aprendizado multimodal, no entanto, vai um passo além, permitindo que os sistemas analisem, interpretem e integrem vários fluxos de dados diversos simultaneamente. Essa abordagem espelha de perto como o cérebro humano naturalmente integra entradas visuais, auditivas e linguísticas para formar uma compreensão coesa do mundo.

Ao combinar essas diferentes modalidades, a IA multimodal alcança uma compreensão mais profunda e diferenciada de cenários complexos.

Por exemplo, ao analisar filmagens de vídeo, um sistema multimodal não processa apenas o conteúdo visual; considera também o diálogo falado, os sons ambiente e as legendas que o acompanham.

Essa perspectiva integrada permite que a IA capture o contexto e as sutilezas que seriam perdidas se cada tipo de dado fosse analisado independentemente.

Na prática, o aprendizado multimodal expande o que a IA pode realizar. Ele alimenta aplicações como legendas de imagens, respondendo a perguntas com base no contexto visual, gerando imagens realistas a partir de descrições de texto e aprimorando sistemas interativos, tornando-os mais intuitivos e contextualmente conscientes.

Mas como os modelos multimodais combinam esses diferentes tipos de dados para alcançar esses resultados? Vamos detalhar os principais mecanismos por trás de seu sucesso passo a passo.

Os modelos de IA multimodal alcançam suas poderosas capacidades através de processos especializados: extração de características separadas para cada modalidade (processando cada tipo de dado - como imagens, texto ou áudio - individualmente), métodos de fusão (combinando os detalhes extraídos) e técnicas avançadas de alinhamento (garantindo que a informação combinada se encaixe de forma coerente).

Vamos detalhar como cada um desses processos funciona.

Os modelos de IA multimodal usam arquiteturas diferentes e especializadas para cada tipo de dado. Isso significa que as entradas visuais, textuais e de áudio ou sensor são processadas por sistemas projetados especificamente para elas. Ao fazer isso, torna-se possível para o modelo capturar os detalhes únicos de cada entrada antes de reuni-los.

Aqui estão alguns exemplos de como diferentes arquiteturas especializadas são usadas para extrair características de vários tipos de dados:

Uma vez processada individualmente, cada modalidade gera características de alto nível otimizadas para capturar a informação única contida dentro desse tipo de dado específico.

Após a extração das características, os modelos multimodais as fundem em uma representação unificada e coerente. Para fazer isso de forma eficaz, várias estratégias de fusão são usadas:

Finalmente, os sistemas multimodais utilizam técnicas avançadas de alinhamento e atenção para garantir que os dados de diferentes modalidades correspondam efetivamente.

Métodos como a aprendizagem contrastiva ajudam a alinhar representações visuais e textuais de perto dentro de um espaço semântico compartilhado. Ao fazer isso, os modelos multimodais podem estabelecer conexões fortes e significativas através de diversos tipos de dados, garantindo a consistência entre o que o modelo "vê" e "lê".

Os mecanismos de atenção baseados em Transformer aprimoram ainda mais este alinhamento, permitindo que os modelos se concentrem dinamicamente nos aspectos mais relevantes de cada entrada. Por exemplo, as camadas de atenção permitem que o modelo conecte diretamente descrições textuais específicas com suas regiões correspondentes em dados visuais, melhorando muito a precisão em tarefas complexas como o questionamento visual (VQA) e a legenda de imagens.

Essas técnicas aprimoram a capacidade da IA multimodal de entender o contexto profundamente, possibilitando que a IA forneça interpretações mais matizadas e precisas de dados complexos do mundo real.

A IA multimodal evoluiu significativamente, transitando de técnicas iniciais baseadas em regras para sistemas avançados de deep learning capazes de integração sofisticada.

Nos primeiros tempos, os sistemas multimodais combinavam diferentes tipos de dados, como imagens, áudio ou entradas de sensores, utilizando regras criadas manualmente por especialistas humanos ou métodos estatísticos simples. Por exemplo, a navegação robótica inicial combinava imagens de câmaras com dados de sonar para detect e evitar obstáculos. Embora eficazes, estes sistemas exigiam uma extensa engenharia manual das caraterísticas e eram limitados na sua capacidade de adaptação e generalização.

Com o advento do deep learning, os modelos multimodais tornaram-se muito mais populares. Redes neurais como autoencoders multimodais começaram a aprender representações conjuntas de diferentes tipos de dados, particularmente dados de imagem e texto, permitindo que a IA lidasse com tarefas como a recuperação cross-modal e a descoberta de imagens baseadas apenas em descrições textuais.

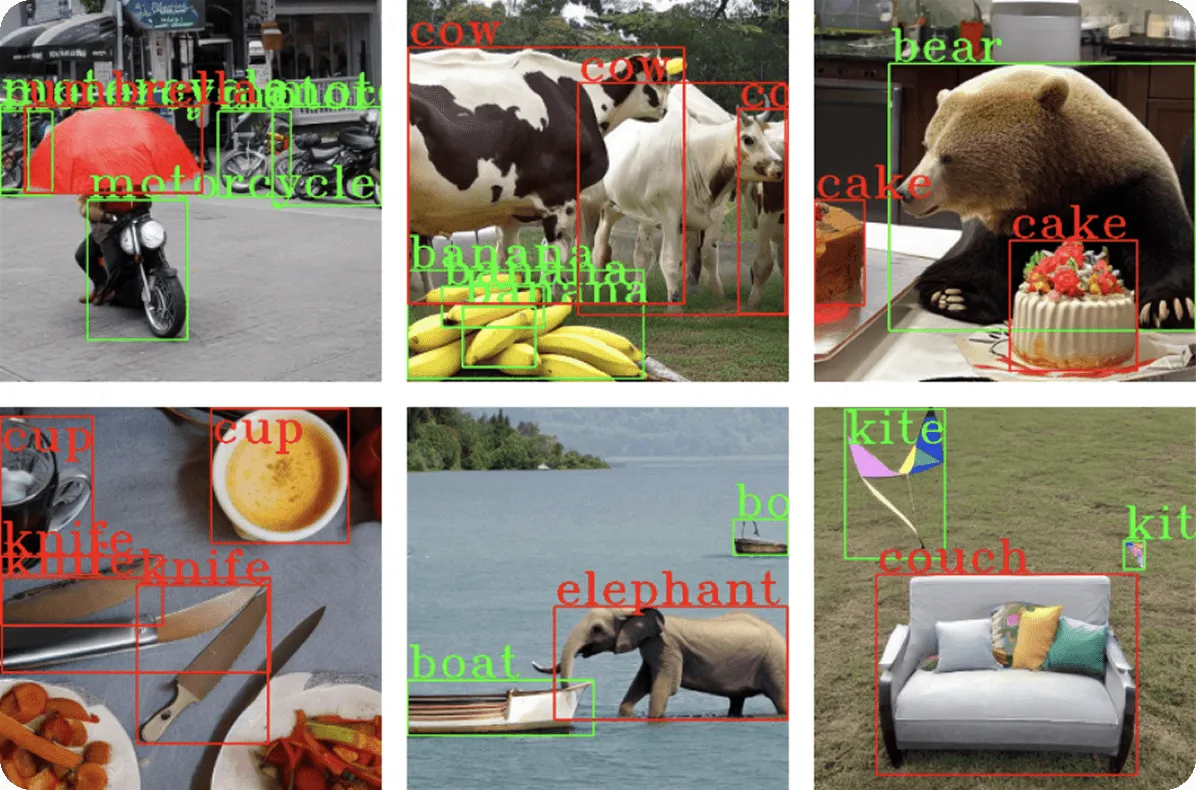

Os avanços continuaram à medida que sistemas como o Visual Question Answering (VQA) integraram CNNs para processar imagens e RNNs ou transformers para interpretar texto. Isso permitiu que os modelos de IA respondessem com precisão a perguntas complexas e dependentes do contexto sobre o conteúdo visual.

Mais recentemente, modelos multimodais de grande escala treinados em datasets massivos à escala da internet revolucionaram ainda mais as capacidades da IA.

Esses modelos aproveitam técnicas como o aprendizado contrastivo, permitindo-lhes identificar relações generalizáveis entre o conteúdo visual e as descrições textuais. Ao colmatar as lacunas entre as modalidades, as arquiteturas multimodais modernas melhoraram a capacidade da IA de executar tarefas complexas de raciocínio visual com uma precisão quase humana, ilustrando o quão longe a IA multimodal progrediu desde os seus estágios fundamentais.

Agora que exploramos como os modelos multimodais integram diversos fluxos de dados, vamos mergulhar em como essas capacidades podem ser aplicadas aos modelos de visão computacional.

Ao combinar a entrada visual com texto, áudio ou dados de sensores, o aprendizado multimodal permite que os sistemas de IA abordem aplicações cada vez mais sofisticadas e ricas em contexto.

A legenda de imagens envolve a geração de descrições em linguagem natural para dados visuais. Os métodos tradicionais de detecção de objetos identificam objetos individuais, mas a legenda multimodal vai mais longe, interpretando relações e contextos.

Por exemplo, um modelo multimodal pode analisar uma imagem de pessoas em um piquenique e gerar uma legenda descritiva como “Uma família fazendo um piquenique em um parque ensolarado,” fornecendo uma saída mais rica e acessível.

Esta aplicação é importante para a acessibilidade. Pode ser usada para gerar texto alternativo para indivíduos com deficiência visual e marcação de conteúdo para grandes bancos de dados. As arquiteturas Transformer desempenham um papel fundamental aqui, permitindo que o módulo de geração de texto se concentre em áreas visuais relevantes por meio de mecanismos de atenção, alinhando dinamicamente as descrições textuais com os recursos visuais.

Os modelos VQA respondem a perguntas em linguagem natural com base no conteúdo visual, combinando visão computacional com compreensão da linguagem. Essas tarefas exigem uma compreensão detalhada do conteúdo da imagem, do contexto e do raciocínio semântico.

As arquiteturas Transformer aprimoraram o VQA, permitindo que os componentes de texto e visuais do modelo interajam dinamicamente, identificando regiões exatas da imagem relacionadas à pergunta.

O modelo PaLI daGoogle, por exemplo, utiliza arquitecturas avançadas baseadas em transformadores que integram transformadores visuais (ViT) com codificadores e descodificadores de linguagem, permitindo responder com precisão a perguntas sofisticadas como "O que está a mulher na imagem a fazer?" ou "Quantos animais são visíveis?".

As camadas de atenção, que ajudam os modelos a se concentrarem nas partes mais relevantes de uma entrada, garantem que cada palavra da pergunta se conecte dinamicamente às pistas visuais, permitindo respostas diferenciadas além da detecção básica de objetos.

A geração de texto para imagem se refere à capacidade da IA de criar conteúdo visual diretamente a partir de descrições textuais, preenchendo a lacuna entre a compreensão semântica e a criação visual.

Os modelos multimodais que executam esta tarefa utilizam arquiteturas neurais avançadas, como transformadores ou processos de difusão, para gerar imagens detalhadas e contextualmente precisas.

Por exemplo, imagine gerar dados sintéticos de treinamento para modelos de visão computacional encarregados da detecção de veículos. Dadas descrições textuais como "um sedan vermelho estacionado em uma rua movimentada" ou "um SUV branco dirigindo em uma rodovia", esses modelos multimodais podem produzir imagens diversas e de alta qualidade retratando esses cenários precisos.

Essa capacidade permite que pesquisadores e desenvolvedores expandam com eficiência os datasets de detecção de objetos sem capturar manualmente milhares de imagens, reduzindo significativamente o tempo e os recursos necessários para a coleta de dados.

Métodos mais recentes aplicam técnicas baseadas em difusão, começando com ruído visual aleatório e refinando progressivamente a imagem para se alinhar estreitamente com a entrada textual. Este processo iterativo pode criar exemplos realistas e variados, garantindo dados de treinamento robustos que cobrem múltiplos pontos de vista, condições de iluminação, tipos de veículos e fundos.

Esta abordagem é particularmente valiosa em visão computacional, permitindo a rápida expansão do dataset, melhorando a precisão do modelo e aumentando a diversidade de cenários que os sistemas de IA podem reconhecer de forma confiável.

Os sistemas de recuperação multimodal facilitam a pesquisa convertendo texto e imagens em uma linguagem comum de significado. Por exemplo, modelos treinados em grandes conjuntos de dados - como o CLIP, que aprendeu com milhões de pares de imagem-texto - podem corresponder consultas de texto com as imagens certas, resultando em resultados de pesquisa mais intuitivos e precisos.

Por exemplo, uma consulta de pesquisa como “pôr do sol em uma praia” retorna resultados visualmente precisos, melhorando significativamente a eficiência da descoberta de conteúdo em plataformas de e-commerce, arquivos de mídia e bancos de dados de fotografia.

A abordagem multimodal garante a precisão da recuperação, mesmo quando as consultas e as descrições das imagens usam idiomas diferentes, graças aos alinhamentos semânticos aprendidos entre os domínios visual e textual.

O aprendizado multimodal oferece várias vantagens importantes que aprimoram os recursos da IA em visão computacional e além:

Apesar dessas vantagens, os modelos multimodais também apresentam seu próprio conjunto de desafios:

O aprendizado multimodal está remodelando a IA, permitindo uma compreensão mais rica e contextual em vários fluxos de dados. Aplicações em visão computacional, como legendagem de imagens, resposta visual a perguntas, geração de texto para imagem e recuperação de imagem aprimorada, demonstram o potencial da integração de diversas modalidades.

Embora os desafios computacionais e éticos permaneçam, as inovações contínuas em arquiteturas, como fusão baseada em transformadores e alinhamento contrastivo, continuam a abordar essas preocupações, impulsionando a IA multimodal em direção a uma inteligência cada vez mais semelhante à humana.

À medida que este campo evolui, os modelos multimodais se tornarão essenciais para tarefas complexas de IA no mundo real, aprimorando tudo, desde diagnósticos de saúde até robótica autônoma. Adotar o aprendizado multimodal posiciona as indústrias para aproveitar recursos poderosos que moldarão o futuro da IA.

Junte-se à nossa crescente comunidade! Explore nosso repositório GitHub para saber mais sobre IA. Pronto para começar seus próprios projetos de visão computacional? Confira nossas opções de licenciamento. Descubra a IA na manufatura e a Visão de IA em direção autônoma visitando nossas páginas de soluções!