Principais destaques da Ultralytics no YOLO Vision 2025 Shenzhen!

Revisite os principais momentos do YOLO Vision 2025 Shenzhen, onde Ultralytics reuniu inovadores, parceiros e a comunidade de IA para um dia de inspiração.

Revisite os principais momentos do YOLO Vision 2025 Shenzhen, onde Ultralytics reuniu inovadores, parceiros e a comunidade de IA para um dia de inspiração.

Em 26 de outubro, YOLO Vision 2025 (YV25) fez a sua estreia na China no Edifício B10 do Parque de Cultura Criativa OCT em Shenzhen. O evento híbrido Vision AI da Ultralyticsreuniu mais de 200 participantes presencialmente, com muitos mais a juntarem-se online através do YouTube e do Bilibili.

A transmissão em direto do YV25 Shenzhen já ultrapassou as 3.500 visualizações no YouTube e continua a ganhar atenção à medida que os destaques do evento são partilhados pela comunidade. Foi um dia repleto de ideias, conversas e exploração prática do caminho que a Vision AI está a seguir.

O dia começou com as calorosas boas-vindas do nosso anfitrião, Huang Xueying, que convidou toda a gente a ligar-se, a aprender e a participar nas discussões ao longo do evento. Ela explicou que este era o segundo YOLO Vision do ano, depois da edição de Londres em setembro, e partilhou o quão excitante era reunir novamente a comunidade Vision AI aqui em Shenzhen.

Neste artigo, vamos rever os destaques do dia, incluindo as actualizações de modelos, as sessões de oradores, as demonstrações ao vivo e os momentos da comunidade que juntaram toda a gente. Vamos começar!

A primeira palestra do dia foi conduzida pelo fundador e CEO da Ultralytics , Glenn Jocher, que partilhou a forma como os modelosYOLO da Ultralytics evoluíram de uma descoberta de investigação para alguns dos modelos de IA de visão mais utilizados no mundo. Glenn explicou que o seu trabalho inicial se centrou em tornar YOLO mais fácil de utilizar.

Ele portou os modelos para o PyTorch, melhorou a documentação e partilhou tudo abertamente para que os programadores de todo o mundo pudessem construir em cima dele. Como ele recorda, "entrei de cabeça em 2018. Decidi que era aqui que estava o meu futuro". O que começou como um esforço pessoal rapidamente se tornou um movimento global de código aberto.

Hoje em dia, os modelosYOLO Ultralytics permitem biliões de inferências todos os dias, e Glenn enfatizou que esta escala só foi possível graças às pessoas que ajudaram a construí-la. Pesquisadores, engenheiros, estudantes, amadores e colaboradores de código aberto de todo o mundo transformaram YOLO no que ele é hoje.

Como Glenn disse, "Há quase mil deles [contribuidores] por aí e estamos muito gratos por isso. Não estaríamos aqui onde estamos hoje sem estas pessoas".

O primeiro olhar sobre o Ultralytics YOLO26 foi partilhado no início deste ano no evento YOLO Vision 2025 London, onde foi apresentado como o próximo grande passo em frente na família de modelos Ultralytics YOLO . No YV25 Shenzhen, Glenn forneceu uma atualização sobre o progresso desde esse anúncio e deu à comunidade de IA uma visão mais próxima de como o modelo tem vindo a evoluir.

O YOLO26 foi concebido para ser mais pequeno, mais rápido e mais preciso, mantendo-se prático para utilização no mundo real. Glenn explicou que a equipa passou o último ano a aperfeiçoar a arquitetura, a avaliar o desempenho em vários dispositivos e a incorporar conhecimentos provenientes da investigação e do feedback da comunidade. O objetivo é proporcionar um desempenho topo de gama sem dificultar a implementação dos modelos.

Uma das principais actualizações destacadas por Glenn é o facto de o YOLO26 estar associado a uma campanha dedicada de afinação de hiperparâmetros, passando do treino totalmente do zero para a afinação em conjuntos de dados maiores. Ele explicou que essa abordagem está muito mais alinhada com casos reais de uso no mundo real.

Eis algumas das outras melhorias importantes partilhadas no evento:

Em conjunto, estas actualizações resultam em modelos que são até 43% mais rápidos na CPU , sendo também mais precisos do que o Ultralytics YOLO11tornando o YOLO26 especialmente impactante para dispositivos incorporados, robótica e sistemas de ponta.

O YOLO26 suportará todas as mesmas tarefas e tamanhos de modelos atualmente disponíveis no YOLO11, resultando em 25 variantes de modelos em toda a família. Isto inclui modelos para deteção, segmentação, estimativa de pose, caixas delimitadoras orientadas e classificação, variando de nano a extra grande.

A equipa está também a trabalhar em cinco variantes que podem ser solicitadas. Trata-se de modelos que podem receber uma mensagem de texto e devolver diretamente as caixas delimitadoras, sem necessidade de formação.

É um passo inicial em direção a fluxos de trabalho de visão mais flexíveis, baseados em instruções, que são mais fáceis de adaptar a diferentes casos de utilização. Os modelos YOLO26 ainda estão em desenvolvimento ativo, mas os primeiros resultados de desempenho são fortes e a equipa está a trabalhar para os lançar em breve.

Após a atualização do YOLO26, Glenn deu as boas-vindas a Prateek Bhatnagar, o nosso Chefe de Engenharia de Produtos, para fazer uma demonstração ao vivo da Plataforma Ultralytics . Esta plataforma está a ser construída para reunir as principais partes do fluxo de trabalho de visão computacional, incluindo a exploração de conjuntos de dados, anotação de imagens, modelos de treino e comparação de resultados.

Prateek salientou que a plataforma se mantém fiel às raízes de código aberto da Ultralytics, introduzindo dois espaços comunitários, uma comunidade de conjuntos de dados e uma comunidade de projectos, onde os programadores podem contribuir, reutilizar e melhorar o trabalho uns dos outros. Durante a demonstração, ele apresentou a anotação assistida por IA, o treinamento fácil na nuvem e a capacidade de ajustar modelos diretamente da comunidade, sem precisar de recursos locais GPU .

A plataforma está atualmente em desenvolvimento. Prateek encorajou o público a estar atento aos anúncios e referiu que a equipa está a crescer na China para apoiar o lançamento.

Com o ímpeto a aumentar, o evento passou a um painel de discussão com vários investigadores por detrás de diferentes modelos YOLO . O painel incluiu Glenn Jocher, juntamente com Jing Qiu, o nosso Engenheiro Sénior de Aprendizagem de Máquinas; Chen Hui, Engenheiro de Aprendizagem de Máquinas na Meta e um dos autores do YOLOv10; e Bo Zhang, Estratega de Algoritmos na Meituan e um dos autores do YOLOv6.

A discussão centrou-se na forma como YOLO continua a evoluir através da utilização no mundo real. Os oradores abordaram a forma como o progresso é frequentemente impulsionado por desafios práticos de implementação, como a execução eficiente em dispositivos de ponta, a melhoria da deteção de pequenos objectos e a simplificação da exportação de modelos.

Em vez de procurar apenas a precisão, o painel salientou a importância de equilibrar a velocidade, a facilidade de utilização e a fiabilidade em ambientes de produção. Outra lição partilhada foi o valor da iteração e do feedback da comunidade.

Eis algumas outras ideias interessantes da conversa:

Em seguida, vamos analisar mais detalhadamente algumas das palestras do YV25 Shenzhen, onde os líderes da comunidade de IA partilharam a forma como a visão da IA está a evoluir, desde os humanos digitais e a robótica até ao raciocínio multimodal e à implementação eficiente de limites.

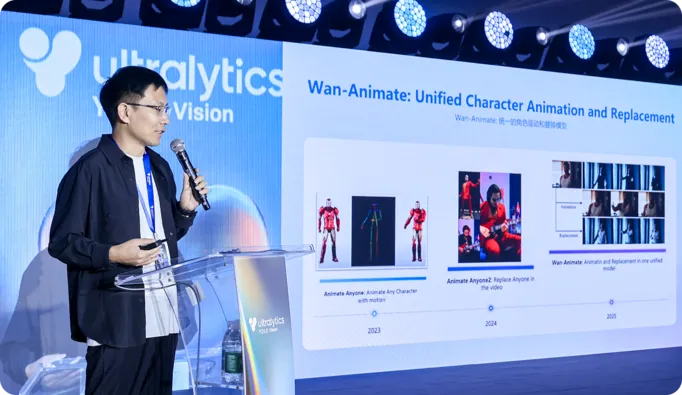

Numa sessão muito esclarecedora, o Dr. Peng Zhang, do Alibaba Qwen Lab, partilhou a forma como a sua equipa está a desenvolver grandes modelos de vídeo que podem gerar humanos digitais expressivos com movimentos e controlo mais naturais. Ele apresentou o Wan S2V e o Wan Animate, que usam referências de áudio ou movimento para produzir fala, gestos e animação realistas, abordando as limitações da geração puramente orientada por texto.

O Dr. Zhang também falou sobre os progressos que estão a ser feitos no sentido de criar avatares interactivos em tempo real, incluindo a clonagem de aparência e movimento sem disparos e modelos leves que podem animar um rosto diretamente a partir de uma câmara em direto, tornando os seres humanos digitais realistas mais próximos de funcionarem sem problemas nos dispositivos do dia a dia.

Um dos temas-chave do YV25 Shenzhen foi a passagem de modelos de visão que se limitam a ver o mundo para sistemas que podem atuar dentro dele. Por outras palavras, a perceção já não é o fim da linha de produção; está a tornar-se o início da ação.

Por exemplo, na sua apresentação, Hu Chunxu da D-Robotics descreveu a forma como os seus kits de desenvolvimento e soluções SoC (sistema num chip) integram a deteção, o controlo de movimentos em tempo real e a tomada de decisões numa pilha unificada de hardware e software. Ao tratar a perceção e a ação como um ciclo de feedback contínuo, em vez de fases separadas, a sua abordagem permite que os robôs se movam, se adaptem e interajam de forma mais fiável em ambientes reais.

Alex Zhang, do Baidu Paddle, fez eco desta ideia na sua palestra, explicando como YOLO e o PaddleOCR trabalham em conjunto para detect objectos e depois interpretar o texto e a estrutura à sua volta. Isto permite que os sistemas convertam imagens e documentos em informação utilizável e estruturada para tarefas como logística, inspecções e processamento automático.

Outro tópico interessante no YV25 Shenzhen foi a forma como a IA de visão está a tornar-se mais eficiente e capaz em dispositivos de ponta.

Paul Jung, da DEEPX, falou sobre a implementação de modelos YOLO diretamente em hardware incorporado, reduzindo a dependência da nuvem. Ao concentrar-se no baixo consumo de energia, na inferência optimizada e na afinação de modelos com reconhecimento de hardware, a DEEPX permite a perceção em tempo real para drones, robôs móveis e sistemas industriais que operam em ambientes dinâmicos.

Da mesma forma, Liu Lingfei, da Moore Threads, partilhou a forma como a plataforma Moore Threads E300 integra a unidade central de processamentoCPU), a unidade de processamento gráficoGPU) e a unidade de processamento neural (NPU) para fornecer inferência de visão a alta velocidade em dispositivos compactos.

A plataforma pode executar vários fluxos YOLO a elevadas velocidades de fotogramas e a sua cadeia de ferramentas simplifica passos como a quantização, a compilação estática e a afinação do desempenho. A Moore Threads também abriu um vasto conjunto de modelos de visão por computador e exemplos de implementação para reduzir a barreira para os programadores.

Até há pouco tempo, a construção de um único modelo capaz de compreender imagens e interpretar linguagem exigia arquitecturas de transformadores de grandes dimensões e de execução dispendiosa. No YV25 Shenzhen, Yue Ziyin da Yuanshi Intelligence apresentou uma visão geral do RWKV, uma arquitetura que combina as capacidades de raciocínio de contexto longo dos transformadores com a eficiência dos modelos recorrentes.

Explicou como o Vision-RWKV aplica esta conceção à visão por computador, processando as imagens de uma forma que aumenta linearmente com a resolução. Isto torna-o adequado para entradas de alta resolução e para dispositivos de ponta onde a computação é limitada.

Yue também mostrou como a RWKV está a ser utilizada em sistemas de visão-linguagem, em que as caraterísticas da imagem são combinadas com a compreensão do texto para ir além da deteção de objectos e passar a interpretar cenas, documentos e contextos do mundo real.

Enquanto as palestras no palco se debruçaram sobre o futuro da IA de visão, os stands no piso mostraram como já está a ser utilizada atualmente. Os participantes puderam ver modelos a funcionar ao vivo, comparar opções de hardware e falar diretamente com as equipas que constroem estes sistemas.

Aqui está um vislumbre da tecnologia que estava a ser exibida:

Além de toda a tecnologia empolgante, uma das melhores partes do YV25 Shenzhen foi reunir novamente a comunidade de visão computacional e a equipa Ultralytics pessoalmente. Ao longo do dia, as pessoas reuniram-se em torno de demonstrações, partilharam ideias durante as pausas para café e continuaram as conversas muito depois do fim das palestras.

Investigadores, engenheiros, estudantes e construtores compararam notas, colocaram questões e trocaram experiências do mundo real, desde a implementação à formação de modelos. E graças ao Cinco Jotas do Grupo Osborne, até trouxemos um toque de cultura espanhola ao evento com jamón acabado de cortar, criando um momento caloroso de ligação. Um belo local, uma multidão entusiasta e um sentido partilhado de dinâmica tornaram o dia verdadeiramente especial.

De palestras inspiradoras a demonstrações práticas, YOLO Vision 2025 Shenzhen capturou o espírito de inovação que define a comunidade Ultralytics . Ao longo do dia, palestrantes e participantes trocaram idéias, exploraram novas tecnologias e se conectaram com uma visão compartilhada para o futuro da IA. Juntos, eles saíram energizados e prontos para o que está por vir com o Ultralytics YOLO.

Reimaginar o que é possível com IA e visão computacional. Junte-se à nossa comunidade e ao repositório GitHub para descobrir mais. Saiba mais sobre aplicações como a visão computacional na agricultura e a IA no retalho. Explore nossas opções de licenciamento e comece a usar a visão computacional hoje mesmo!