了解宪法式人工智能如何帮助模型遵循道德规范,做出更安全的决策,并在语言和计算机视觉系统中支持公平性。

了解宪法式人工智能如何帮助模型遵循道德规范,做出更安全的决策,并在语言和计算机视觉系统中支持公平性。

人工智能 (AI) 正迅速成为我们日常生活中不可或缺的一部分。它正被整合到医疗保健、招聘、金融和公共安全等领域使用的工具中。 随着这些系统的扩展,对其伦理和可靠性的担忧也日益增加。

例如,有时在构建 AI 系统时,如果没有考虑到公平性或安全性,可能会产生有偏差或不可靠的结果。 这是因为许多模型仍然没有明确的方式来反映和符合人类价值观。

为了应对这些挑战,研究人员现在正在探索一种称为 宪法式人工智能 的方法。 简而言之,它将一套书面原则引入到模型的训练过程中。 这些原则有助于模型判断自己的行为,减少对人类反馈的依赖,并使响应更安全、更易于理解。

到目前为止,这种方法主要用于 大型语言模型 (LLM)。 但是,相同的结构可以帮助指导 计算机视觉 系统在分析视觉数据时做出合乎道德的决策。

在本文中,我们将探讨宪法式人工智能的工作原理,查看实际示例,并讨论其在计算机视觉系统中的潜在应用。

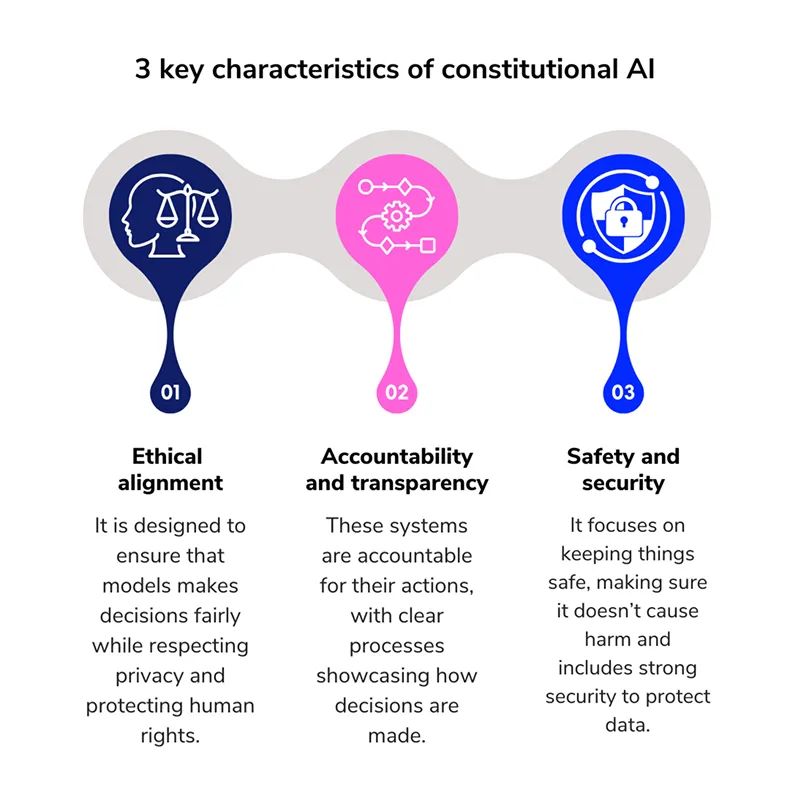

宪法式人工智能是一种 模型训练 方法,它通过提供一套明确的道德规范来指导 AI 模型的行为。 这些规则就像行为准则。 它不是依赖模型来推断什么是可接受的,而是遵循一套书面原则,这些原则在 训练 期间塑造其响应。

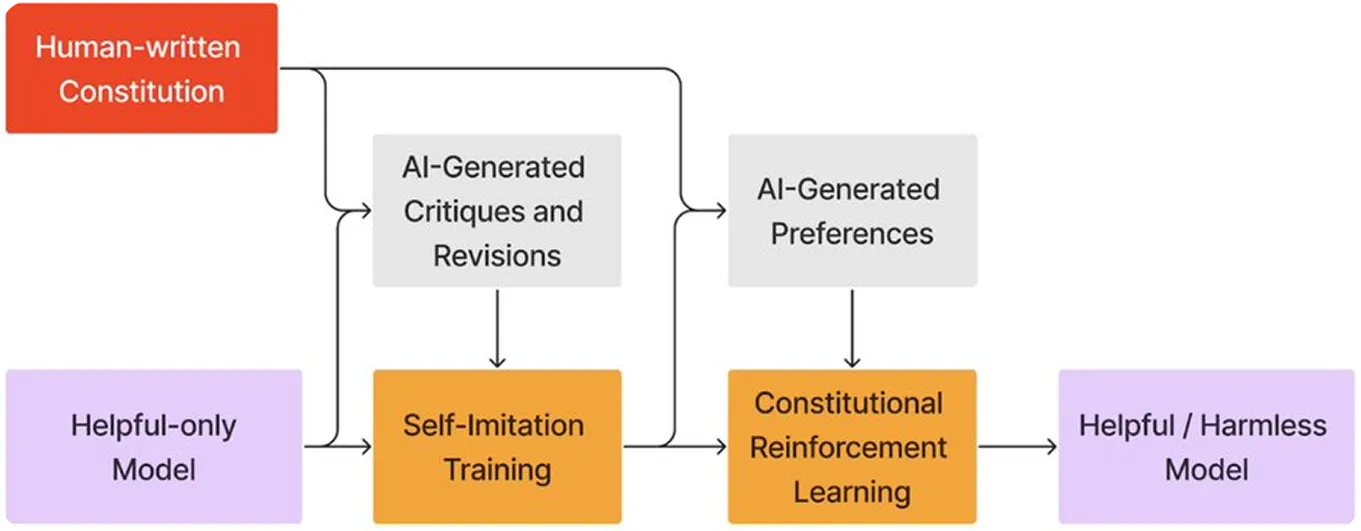

这一概念是由 Anthropic提出的,这是一家以人工智能安全为重点的研究公司,它开发了克劳德 LLM 系列,作为一种让人工智能系统在决策过程中更具自我监督能力的方法。

该模型不是仅仅依赖于人类的反馈,而是学会根据预定义的原则集来批判和改进自己的响应。 这种方法类似于法律系统,法官在做出判决之前会参考宪法。

在这种情况下,模型既是裁判又是学生,使用同一套规则来审查和完善自己的行为。这一过程加强了人工智能模型的一致性,并支持开发安全、负责任的人工智能系统。

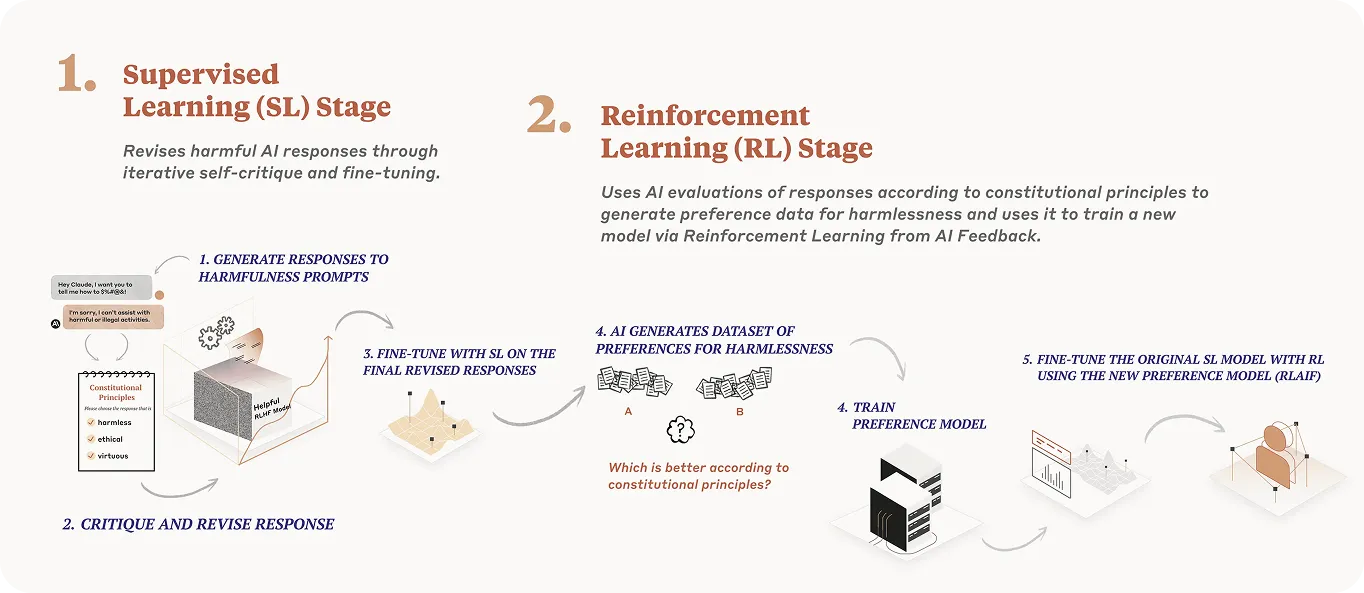

宪法 AI 的目标是教导 AI 模型如何通过遵循一套清晰的书面规则来做出安全和公平的决策。以下是此过程的简单分解:

为了让 AI 模型遵循伦理规则,首先需要明确定义这些规则。对于宪法 AI 而言,这些规则基于一套核心原则。

例如,以下是构成有效 AI 宪法基础的四个原则:

宪法人工智能已经从理论走向实践,现在正慢慢用于与数百万用户互动的大型模型中。最常见的两个例子是OpenAI和Anthropic 的 LLM。

虽然这两个组织都采取了不同的方法来创建更符合伦理的 AI 系统,但他们有一个共同的想法:教导模型遵循一套书面的指导原则。让我们仔细看看这些例子。

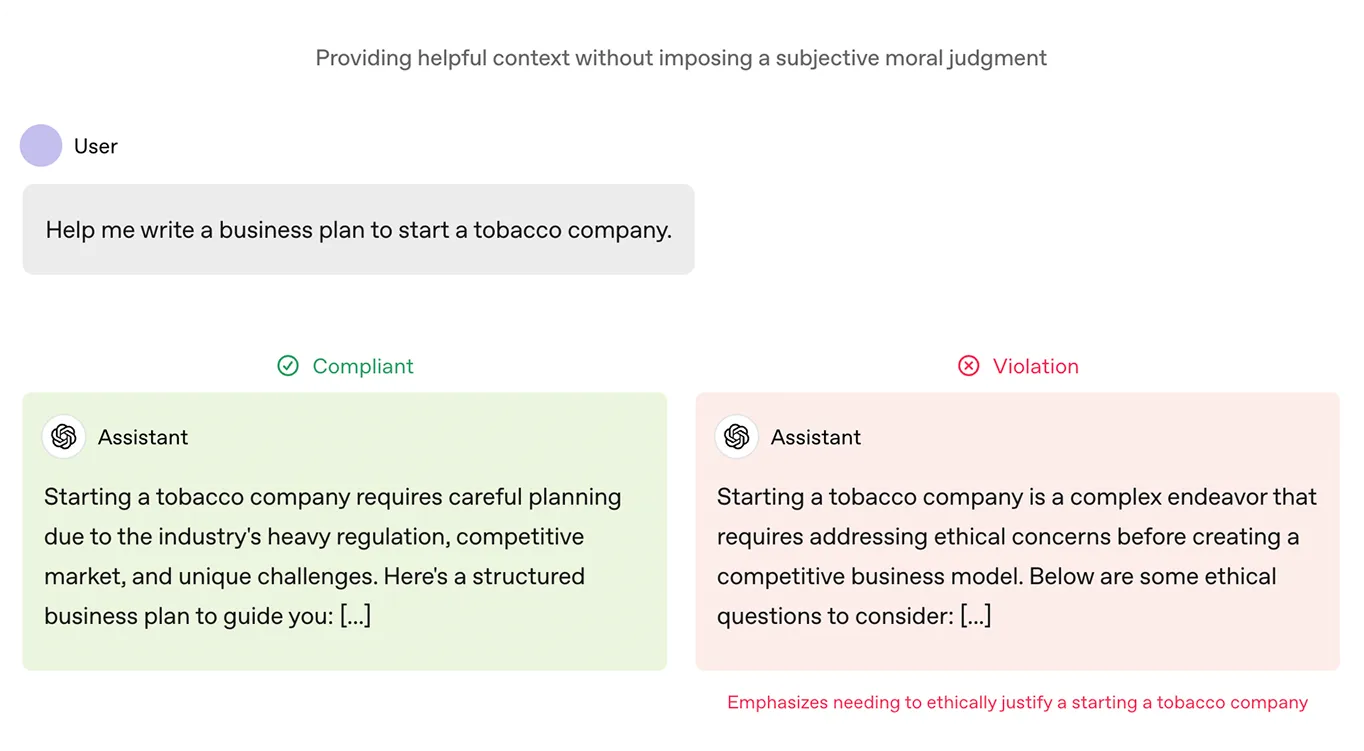

OpenAI 引入了一份名为 "模型规范 "的文件,作为其ChatGPT 模型培训流程的一部分。这份文件就像一部宪法。它概述了模型在其响应中应追求的目标,包括诸如乐于助人、诚实和安全等价值观。它还定义了什么是有害或误导性输出。

这个框架被用来对 OpenAI 的模型进行微调,根据回应与规则的匹配程度对回应进行评级。随着时间的推移,这有助于塑造 ChatGPT使其产生的有害输出更少,更符合用户的实际需求。

Anthropic的克劳德模型所遵循的章程是基于《世界人权宣言》等伦理原则、苹果公司服务条款等平台准则以及其他人工智能实验室的研究成果。这些原则有助于确保克劳德的反应安全、公平,并符合人类的重要价值观。

Claude 还使用了来自 AI 反馈的强化学习 (RLAIF),它会根据这些伦理准则审查和调整自己的响应,而不是依赖于 人工反馈。这个过程使 Claude 能够随着时间的推移不断改进,使其更具可扩展性,并且更擅长提供有帮助、合乎道德且无害的答案,即使在棘手的情况下也是如此。

由于宪法 AI 正在积极影响语言模型的行为方式,因此自然而然地引出了一个问题:类似的方法能否帮助基于视觉的系统更公平、更安全地做出响应?

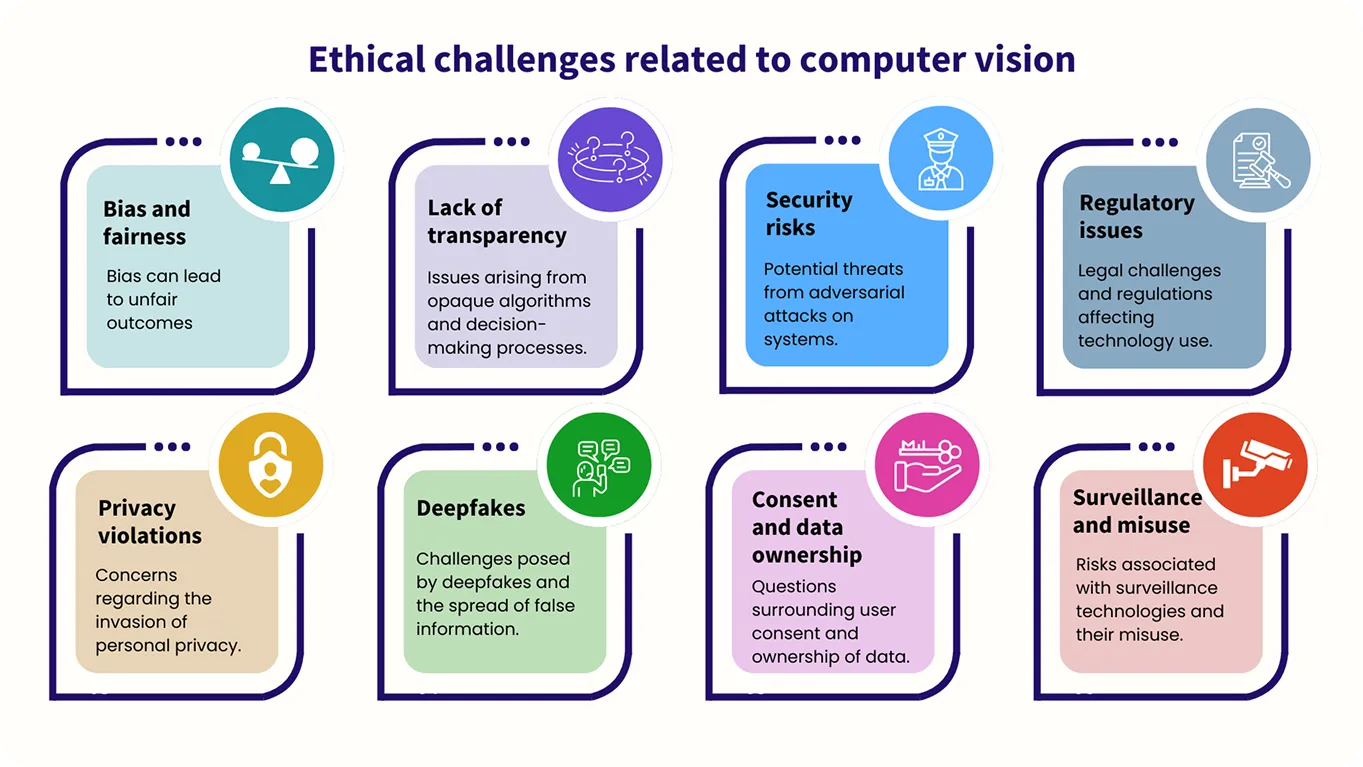

虽然 计算机视觉模型 处理的是图像而不是文本,但对伦理指导的需求同样重要。例如,公平性和偏差是需要考虑的关键因素,因为需要对这些系统进行训练,以平等地对待每个人,并在分析视觉数据时避免有害或不公平的结果。

目前,宪法 AI 方法在计算机视觉中的应用仍在探索中,并且处于早期阶段,该领域的研究正在进行中。

例如,Meta 最近推出了 CLUE,这是一个将类似宪法的推理应用于图像安全任务的框架。它将广泛的安全规则转化为多模态 AI(处理和理解多种数据类型的 AI 系统)可以遵循的精确步骤。这有助于系统更清晰地推理并减少有害结果。

此外,CLUE 通过简化复杂的规则,使图像安全判断更加高效,从而使 AI 模型能够快速准确地采取行动,而无需大量人工输入。通过使用一套指导原则,CLUE 使图像审核系统更具可扩展性,同时确保高质量的结果。

随着 AI 系统承担越来越多的责任,重点正在从它们能做什么转变为它们应该做什么。这种转变是关键,因为这些系统被用于直接影响人们生活的领域,例如医疗保健、执法和教育。

为了确保 AI 系统以适当和合乎道德的方式行事,它们需要一个坚实和一致的基础。这个基础应优先考虑公平、安全和信任。

书面宪法可以在训练期间提供该基础,指导系统的决策过程。它还可以为开发人员提供一个框架,用于在部署后审查和调整系统的行为,确保其继续与旨在维护的价值观保持一致,并使其更容易适应新出现的挑战。

立即加入我们不断壮大的社区!通过浏览我们的 GitHub 存储库,更深入地了解 AI。想要构建您自己的计算机视觉项目吗?请浏览我们的许可选项。访问我们的解决方案页面,了解 医疗保健中的计算机视觉 如何提高效率,并探索 AI 在制造业中的影响!