了解 Meta AI 的全新 Segment Anything ModelSAM 3 如何在真实世界的图像和视频中轻松detect、segment和track 物体。

了解 Meta AI 的全新 Segment Anything ModelSAM 3 如何在真实世界的图像和视频中轻松detect、segment和track 物体。

2025 年 11 月 19 日,Meta AI 发布了Segment Anything Model 3(又称SAM 3)。这个最新版本的 Segment Anything Model 引入了新的方法,利用文本提示、视觉提示和图像示例来detect、segment和track 真实世界图像和视频中的物体。

SAM 3 模型基于 SAM和SAM 2的基础上,带来了新的进步和功能,如概念分割、开放词汇检测和实时视频跟踪。它可以理解简短的名词短语,跨帧跟踪对象,并识别细粒度或罕见的概念,这些都是早期模型无法一致处理的。

作为SAM 3 版本的一部分,Meta 还推出了SAM 3D。这套新一代模型可从单张图像重建物体、场景和完整的人体,并将 Segment Anything 生态系统扩展到三维理解领域。这些新增功能为计算机视觉、机器人、媒体编辑和创意工作流程开辟了新的应用领域。

在本文中,我们将探讨什么是SAM 3、它与SAM 2 的区别、模型的工作原理及其在现实世界中的应用。让我们开始吧!

SAM 3 是一种先进的计算机视觉模型,可以根据简单的指令识别、分离和track 图像和视频中的物体。SAM 3 不依赖于固定的标签列表,它能理解自然语言和视觉线索,从而轻松地告诉模型您想找到什么。

例如,使用SAM 3,您可以输入 "黄色校车 "或 "一只条纹猫 "等短语,点击一个对象,或突出显示图像中的一个例子。然后,模型就会detect 每一个匹配的对象,并生成清晰的分割掩码(可视化轮廓,准确显示哪些像素属于某个对象)。SAM 3 还能在视频帧中跟踪这些对象,使它们在移动过程中保持一致。

Meta AI 发布的另一个令人兴奋的项目是SAM 3D ,它将 Segment Anything 项目扩展到了三维理解领域。SAM 3D 可以获取单张二维图像,并重建物体或人体的三维形状、姿势估计或结构。换句话说,即使只有一个视角,模型也能估算出物体在空间中的占位情况。

SAM 3D 已推出两种不同的模型:SAM 3D Objects 可重建日常物品的几何形状和纹理,而SAM 3D Body 可从单张图像中估计人体形状和姿势估计 。这两个模型都使用SAM 3 的分割输出,然后生成与原始照片中物体的外观和位置相一致的 3D 表示。

以下是SAM 3 引入的一些关键更新,它们将检测、细分和跟踪整合为一个统一的模型:

假设您正在观看一段有许多不同动物的野生动物园视频,而您只想detect 和segment 大象。在不同版本的SAM 中,这项任务会是怎样的呢?

使用SAM 时,您需要手动点击每帧中的每只大象来生成分割掩码。由于没有跟踪功能,所以每帧图像都需要重新点击。

使用SAM 2,您可以在大象身上点击一次,获得它的遮罩,然后模型就会在视频中track 这头大象。但是,如果您想segment 多头大象(特定对象),您仍然需要提供单独的点击,因为SAM 2 本身无法理解 "大象 "这样的类别。

有了SAM 3,工作流程变得简单多了。您可以键入 "大象 "或在单个大象周围画一个边界框来提供示例,模型就会自动找到视频中的每一只大象,对它们进行segment ,并在各帧中对它们进行一致的track 。它仍然支持早期版本中使用的点击和方框提示,但现在也能对文本提示和示例图像做出响应,这是SAM 和SAM 2 无法做到的。

接下来,让我们进一步了解SAM 3 模型的工作原理和训练方法。

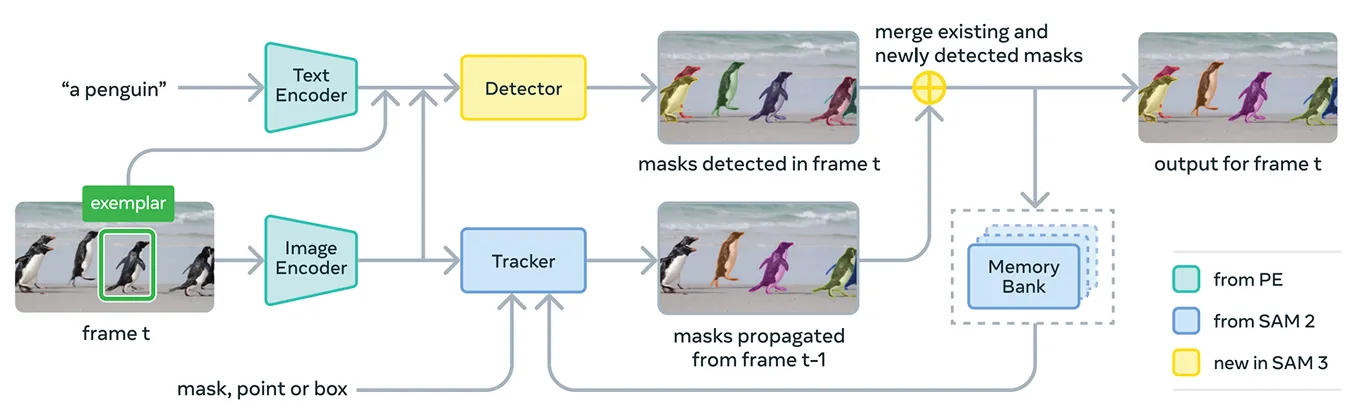

SAM 3 集合了多个组件,在一个系统中支持概念提示和视觉提示。该模型的核心是使用 Meta 感知编码器,这是 Meta 的统一开源图像文本编码器。

该编码器可同时处理图像和短名词短语。简而言之,这使得SAM 3 能够比之前版本的 "分段任何模型 "更有效地将语言和视觉特征联系起来。

在编码器的基础上,SAM 3 还包括一个基于 DETR 系列transformer 模型的检测器。该检测器可识别图像中的物体,并帮助系统确定哪些物体与用户的提示相对应。

具体来说,在视频分割方面,SAM 3 使用了以SAM 2 的记忆库和记忆编码器为基础的跟踪组件。这样,模型就能保存各帧中的物体信息,从而可以随着时间的推移重新识别和track 这些物体。

为了训练SAM 3,Meta 需要比互联网上现有数据多得多的注释数据。高质量的分割掩码和文本标签很难大规模创建,而完全勾勒出图像和视频中概念的每个实例既缓慢又昂贵。

为了解决这个问题,Meta 建立了一个新的数据引擎,将SAM 3 本身、其他人工智能模型和人类注释员结合在一起工作。工作流程从人工智能系统管道开始,包括SAM 3 和基于 Llama 的字幕模型。

这些系统可以扫描大量图像和视频,生成标题,将标题转换为文本标签,并生成早期分割掩码候选。然后,人类和人工智能注释者会对这些候选者进行审查。

人工智能注释器经过训练,在检查掩码质量和验证概念覆盖范围等任务上的准确率可以与人类相媲美,甚至超过人类。只有在模型仍有困难的更具挑战性的例子中,人类才会介入。

这种方法大大提高了 Meta 的注释速度。通过让人工智能注释员处理简单的案例,在细粒度领域中,注释管道处理负面提示的速度提高了约五倍,处理正面提示的速度提高了 36%。

这种效率使得数据集的规模可以扩展到四百多万个独特的概念。人工智能建议、人工修正和更新模型预测的不断循环也提高了标签的质量,并帮助SAM 3 学习更广泛的视觉和文本概念。

在性能方面,SAM 3 与早期型号相比有了明显改善。在 Meta 新推出的 SA-Co 基准(评估开放词汇概念检测和分割)上,SAM 3 在图像和视频方面的性能大约是以前系统的两倍。

在交互式视觉任务(如点对掩码和掩码对掩码)上,它也达到或超过了SAM 2。Meta 报告称,它在零镜头 LVIS(模型必须在没有训练示例的情况下识别稀有类别)和对象计数(衡量是否检测到对象的所有实例)等较难的评估中取得了更大的优势,凸显了更强的跨领域泛化能力。

除了精度方面的改进外,SAM 3 的效率也很高,在 H200GPU 上处理一幅包含 100 多个检测物体的图像只需约 30 毫秒,在视频中跟踪多个物体时也能保持接近实时的速度。

既然我们已经对SAM 3 有了更深入的了解,下面就让我们来了解一下它在实际应用中的使用情况,从高级文本引导推理到科学研究和 Meta 自己的产品。

SAM 3 还可以作为一个更大的多模态语言模型的工具,Meta 将其称为SAM 3 代理。代理可以将一个更复杂的问题分解成SAM 3 能够理解的更小的提示,而不是给SAM 3 一个像 "大象 "这样的短语。

例如,如果用户问:"图片中的什么物体用于控制和引导一匹马?"代理就会尝试不同的名词短语,将它们发送到SAM 3,并检查哪些掩码是有意义的。它将不断改进,直到找到正确的对象。

即使没有经过特殊推理数据集的训练,SAM 3 代理在 ReasonSeg 和 OmniLabel 等为复杂文本查询而设计的基准测试中也表现出色。这表明,SAM 3 可以支持同时需要语言理解和精细视觉分割的系统。

有趣的是,SAM 3 已经被用于研究环境中,在这些环境中,详细的视觉标签非常重要。Meta 与 Conservation X Labs 和 Osa Conservation 合作建立了 SA-FARI,这是一个公共野生动物监测数据集,包含 10,000 多个相机捕捉视频。

每帧图像中的每只动物都标有方框和分割掩码,而手工标注非常耗时。同样,在海洋研究领域,SAM 3 与 FathomNet 和 MBARI 一起用于为水下图像创建实例分割掩码,并支持新的评估基准。

这些数据集可帮助科学家更高效地分析视频片段,研究通常难以大规模track 的动物和栖息地。研究人员还可以利用这些资源建立自己的模型,用于物种识别、行为分析和自动生态监测。

除研究用途外,SAM 3 还为 Meta 消费品的新功能和用例提供了支持。下面我们就来看看它的一些集成方式:

SAM 3 在分段方面迈出了令人振奋的一步。它引入了概念分割、开放词汇文本提示和改进的跟踪功能。该模型套件在图像和视频方面的性能明显增强,并增加了SAM 3D 功能,为视觉人工智能、创意工具、科学研究和实际产品开辟了新的可能性。

加入我们的社区,探索我们的GitHub 存储库,了解有关人工智能的更多信息。如果您想建立自己的视觉人工智能项目,请查看我们的 许可选项。访问我们的解决方案页面,探索更多有关人工智能在医疗保健和零售业中的应用。