Apple 宣布了新的人工智能辅助功能,例如眼动追踪、音乐触感和语音快捷方式,可提供无缝的用户体验。

Apple 宣布了新的人工智能辅助功能,例如眼动追踪、音乐触感和语音快捷方式,可提供无缝的用户体验。

2024 年 5 月 15 日,苹果公司宣布即将推出iOS 18 的一系列更新,重点关注无障碍环境。新的苹果更新计划于今年晚些时候发布,其中包括眼球追踪、触觉音乐和语音快捷键等创新功能。

这些 Apple 辅助功能使行动不便、失聪或视力障碍以及有语言障碍的人们可以更轻松地使用 Apple 设备。Apple 芯片、人工智能 (AI) 和机器学习是这些功能背后的技术进步。让我们来探索 Apple 的新功能及其将对日常生活产生的影响。

作为一个社会,我们需要确保我们的技术进步对每个人都具有包容性。使技术具有可访问性可以改变许多人的生活。例如,技术是当今任何工作的重要组成部分,但难以访问的界面可能会为残疾人士造成职业障碍。研究表明,2018 年残疾人的失业率几乎是没有残疾人的两倍。

法律系统也在讨论使技术具有可访问性的问题。许多国家/地区都增加了法律,强制要求网站和数字产品的可访问性标准。在美国,与网站可访问性相关的诉讼一直在稳步增加,从 2017 年到 2022 年,提起了大约 14,000 起网站可访问性诉讼,仅 2022 年 就超过了 3,000 起。无论法律要求如何,可访问性对于每个人都可以充分参与的包容性社会至关重要。这就是以下 Apple 辅助功能发挥作用的地方。

自 2009 年以来,Apple 一直致力于让每个人都能使用技术。那一年,他们推出了 VoiceOver,这项功能允许盲人和视障用户通过手势和语音反馈来操作他们的 iPhone。通过读出屏幕上的内容,使用户可以更轻松地与他们的设备互动。

从那时起,Apple 不断改进和扩展其辅助功能。他们推出了用于屏幕放大的 Zoom、用于更好视觉对比度的反转颜色以及用于听力障碍人士的单声道音频。这些功能大大改善了各种残疾用户与设备互动的方式。

以下是过去我们看到的一些关键 Apple 辅助功能的详细介绍:

手部活动不便的人现在只需看着屏幕,就可以轻松浏览互联网、发送消息,甚至控制智能家居设备。这些进步使他们的日常生活更易于管理,使他们能够独立完成以前觉得困难的任务。

另一项令人兴奋的 Apple 即将推出的辅助功能是眼动追踪,它使这一切成为现实。眼动追踪专为有身体残疾的用户设计,在 iPad 和 iPhone 上提供免手动导航选项。通过使用 AI 和前置摄像头来识别您的视线位置,它可以让您毫不费力地激活按钮、滑动和其他手势。

前置摄像头可在数秒内设置和校准眼动追踪功能。您可以使用 Dwell Control 与应用程序元素进行交互,只需用眼睛就能访问按钮和轻扫等功能。用户可以相信自己的隐私会得到保护,因为设备会使用设备上的机器学习功能安全地处理所有数据。眼动追踪技术可在 iPadOS 和iOS 应用程序中无缝运行,无需额外的硬件或配件。Apple Vision Pro 的 VisionOS 还包含眼球跟踪功能,可轻松导航。

音乐触感是 Apple 即将发布的另一项辅助功能。它专为失聪或听力障碍的用户设计,让他们可以在 iPhone 上体验音乐。使用时,Taptic Engine 会生成与音频同步的点击、纹理和精细振动。您可以感受到音乐的节奏和细微差别。这非常深入,这要归功于 Taptic Engine 产生各种强度、模式和持续时间的振动来捕捉音乐感觉的能力。

音乐触感可以将听力障碍人士与以前不可能的方式连接到音乐。这开启了他们日常生活中各种体验。一边跑步一边听音乐或与朋友一起欣赏歌曲成为一种共享和身临其境的体验。振动可以匹配锻炼播放列表的能量,使锻炼更具动力,或者通过最喜欢的冥想曲调帮助平静神经。音乐触感支持 Apple Music 目录中的数百万首歌曲,并将作为开发人员的 API 提供,允许他们创建更易于访问的应用程序。

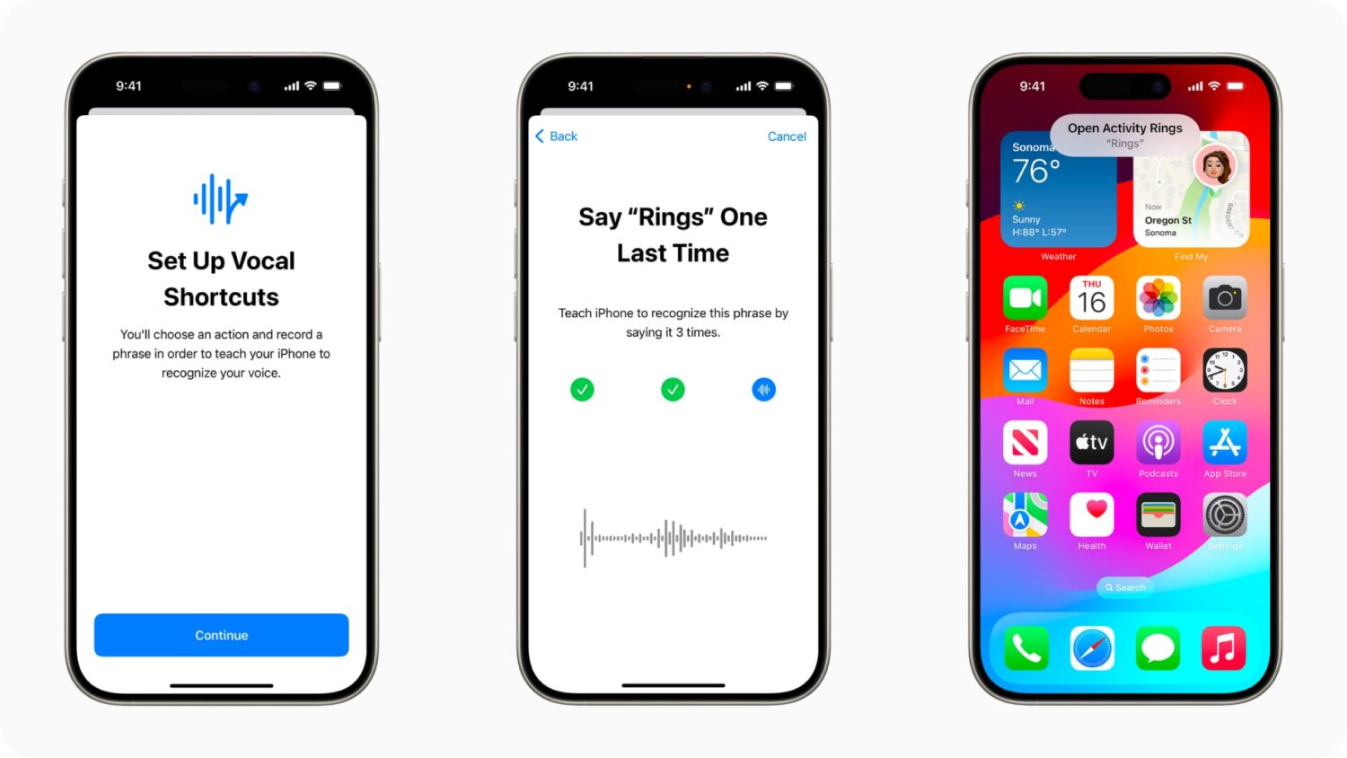

Apple 设计了语音快捷指令,以使用 AI 改进新辅助功能列表中的语音系统。它允许 iPhone 和 iPad 用户创建“自定义发声”,以便 Siri 可以启动快捷指令并管理复杂任务。这对于患有脑瘫、ALS 或中风等疾病的人特别有帮助。

“听取非典型语音”功能使用设备上的机器学习来识别和适应不同的语音模式,从而使发送消息或设置提醒等任务更容易。通过支持自定义词汇和复杂单词,语音快捷指令提供个性化和高效的用户体验。

还有一些新的 Apple 辅助功能可以帮助乘客在旅途中更舒适地使用他们的设备。例如,车辆运动提示是 iPhone 和 iPad 的一项新功能,可帮助减少移动车辆中乘客的晕动病。

晕动症的发生往往是由于人的视觉和感觉不匹配,导致在运动中使用设备时感到不舒服。车辆运动提示通过在屏幕边缘显示动画点来表示车辆运动的变化,从而解决了这一问题。它可以在不干扰主要内容的情况下减少感官冲突。该功能利用 iPhone 和 iPad 的内置传感器来detect 用户是否处于移动的车辆中,并做出相应调整。

CarPlay 也进行了一些更新,以增强其辅助功能。“语音控制”允许用户通过语音命令操作 CarPlay 及其应用程序,而“声音识别”则会在失聪或听力障碍人士听到汽车喇叭和警笛时发出警报。对于色盲用户,“颜色滤镜”提高了 CarPlay 界面的视觉可用性。这些增强功能有助于让所有乘客在乘车过程中更加舒适。

Apple Vision Pro 已经为苹果公司提供了字幕、隐藏式字幕和转录等辅助功能,帮助用户跟踪音频和视频。现在,苹果正在进一步扩展这些功能。新的人工智能驱动的实时字幕功能通过在屏幕上实时显示文字,让每个人都能跟上实时对话中的口语对话和应用程序中的音频。这对耳聋或重听人士尤其有益。

例如,在 VisionOS 的 FaceTime 通话中,用户可以看到屏幕上转录的语音对话,从而更方便地使用自己的角色(计算机生成的虚拟化身)进行连接和协作。

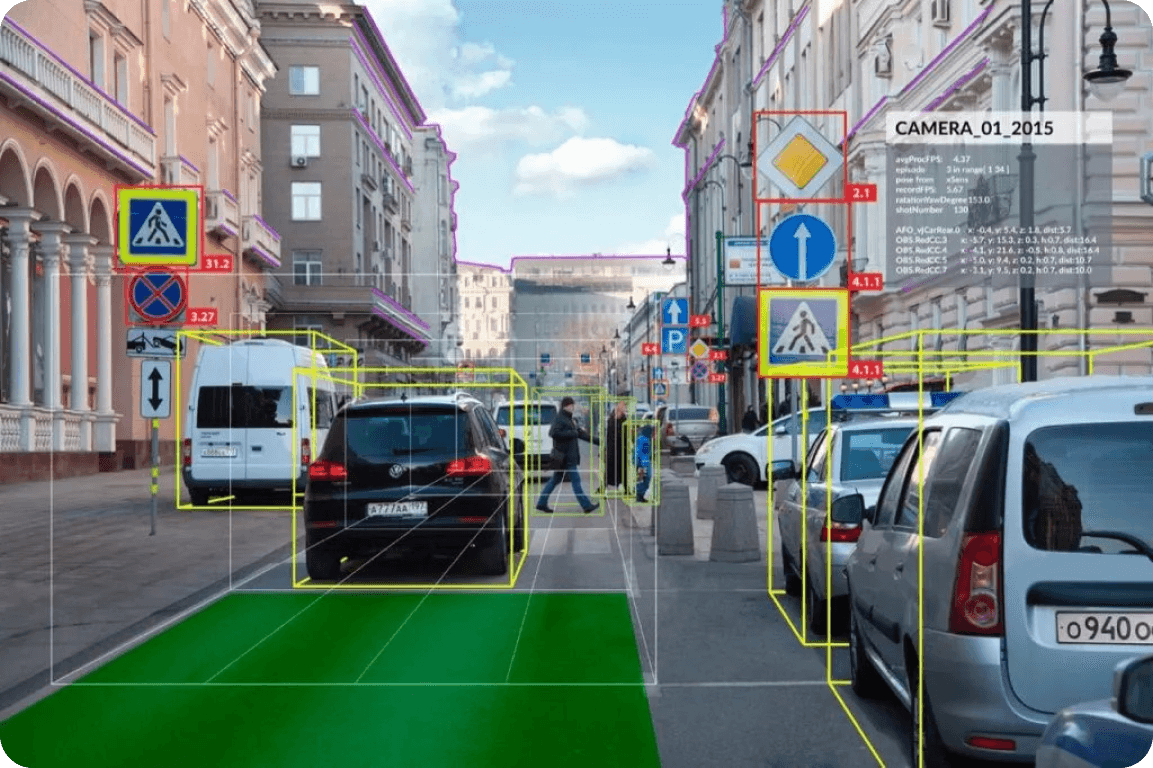

与 Apple 在辅助功能方面的举措类似,许多其他公司也在积极研究和创新,利用人工智能来创建辅助解决方案。例如,支持人工智能的 自动驾驶汽车 可以让行动不便的人更容易驾驶,从而获得独立性。到目前为止,残疾人士一直能够使用经过专门改装的车辆驾驶,这些车辆配备了手动控制、转向辅助和轮椅可访问功能等改装。随着计算机视觉等人工智能技术的集成,这些车辆现在可以提供更多支持。

特斯拉的自动驾驶系统(Autopilot)就是人工智能辅助驾驶的一个很好的例子。它利用先进的传感器和摄像头detect 障碍物、解读交通信号并提供实时导航辅助。有了这些人工智能输入,车辆可以处理各种驾驶任务,如保持在车道内行驶,并根据交通状况调整车速。计算机视觉的洞察力让每个人都能获得更安全、更便捷的驾驶体验。

通过这些新的 Apple 更新,我们正在迎来人工智能驱动的包容性的新时代。通过将人工智能集成到其辅助功能中,Apple 正在使残疾人的日常任务变得更加轻松,并促进技术领域的包容性和创新。这些进步将影响各个市场:科技公司将设定新的包容性基准,医疗保健 将受益于残疾人独立性的提高,并且 消费电子产品 将看到对辅助设备的更高需求。技术的未来很可能涉及为每个人创造无缝的用户体验。

查看我们的 GitHub 存储库 并加入我们的 社区,以随时了解前沿的人工智能发展。了解人工智能如何重塑自动驾驶技术、制造业、医疗保健等领域。