了解评分者间信度、科恩 Kappa 系数、ICC、评分员培训和百分比一致性。了解这些统计测量如何确保研究和数据分析中观察者之间的一致性和协议。

了解评分者间信度、科恩 Kappa 系数、ICC、评分员培训和百分比一致性。了解这些统计测量如何确保研究和数据分析中观察者之间的一致性和协议。

当您构建 AI 模型时,数据的质量与背后的算法同等重要。 每当多个人标记或审查相同的数据时,都难免会发生分歧。 这在包括研究、医疗保健和教育在内的许多领域都是如此。

特别是在计算机视觉领域,这是人工智能的一个分支,涉及到训练模型,如 Ultralytics YOLO11这样的模型来解释图像或视频等视觉数据。如果这些标签不一致,计算机视觉模型就很难学习到正确的模式。

评分者间信度 (IRR) 衡量不同个体或标注者在任务上达成一致的程度。它有助于监控一致性并识别培训、指南或解释中的差距。这在自定义模型训练中尤为重要,因为 AI 模型是使用特定数据为特定目的而构建的。

在本文中,我们将探讨评估者间信度是什么,如何衡量它,以及如何在实际项目中提高它。让我们开始吧!

评分者间信度衡量的是两个或更多人(也称为评分者)在标注、评分或审查相同内容时达成一致的频率。它用于检查不同评分者使用给定标准的一致性。评分者之间的高度一致意味着任务定义明确且易于理解。

这个概念被用于不同的领域。根据领域,它有不同的名称,例如评分者间一致性、观察者间信度或编码者间信度。但是,其基本原理保持不变。

在视觉 AI 中,评估者间信度是数据标注过程的关键部分。训练 计算机视觉模型 通常需要标注大量的图像或视频帧数据集,因此多个 AI 开发人员一起处理相同的数据。

为了获得准确的结果,他们必须遵循相同的标注指南。例如,在标注动物时,每个人都需要对什么是狗、如何绘制其周围的边界框,以及是否标注或忽略模糊对象达成明确的共识。

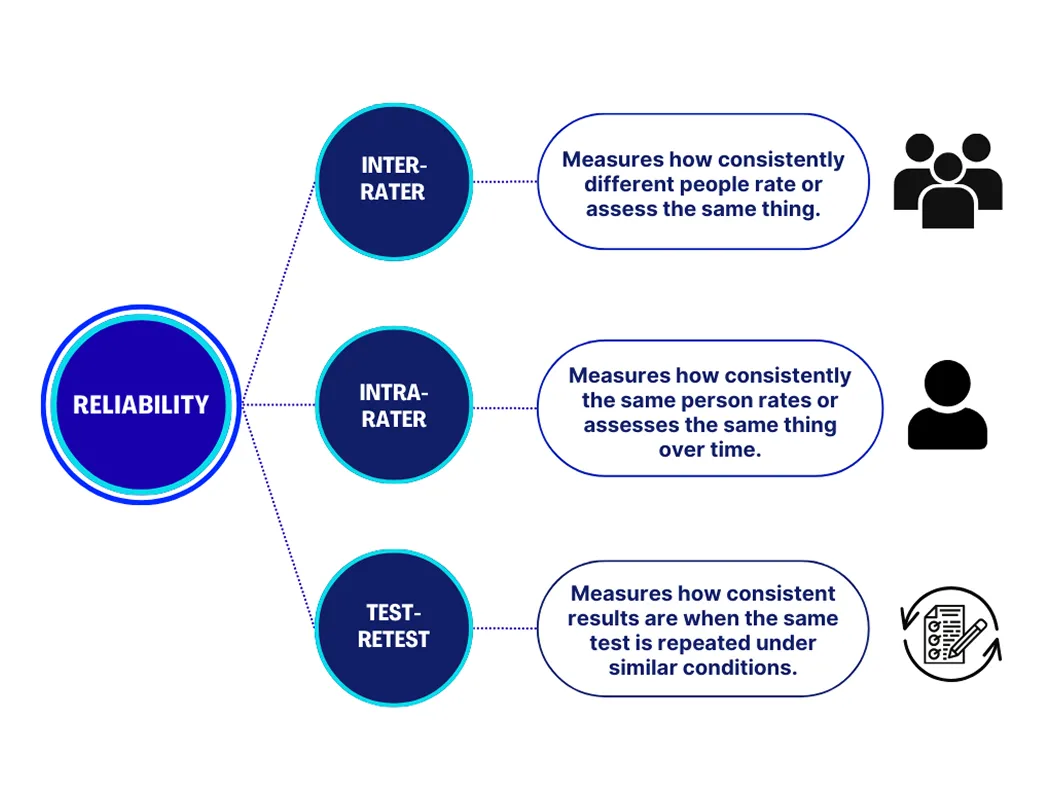

当人们参与标记或评分数据时,需要考虑三种主要类型的可靠性。 每一种都在衡量结果的一致性方面发挥着不同的作用。 以下是每种方法的详细介绍:

这些措施共同帮助确认人员和流程都在产生稳定、可信的结果。

在大型视觉 AI 项目中,标记数据的质量直接影响模型的性能。即使注释者应用指南的方式存在细微差异,也可能会引入不一致之处,从而在训练期间使模型感到困惑。随着时间的推移,这可能会导致不准确的预测、资源浪费以及需要进行昂贵的重新标记。

测量评估者间信度有助于及早发现这些问题。 高度一致意味着标注者已对齐,从而产生更清晰、更可靠的数据集。 低度一致表明在项目推进之前可能需要改进说明、示例或培训。 通过确保标签员同步工作,团队可以构建更有效地学习并在实际应用中提供更好结果的 AI 模型。

以下是在与多个评估者合作并力求保持高评估者间信度时,需要牢记的一些关键实际考虑因素:

有几种方法可以衡量评分者间信度,最佳选择取决于数据的类型和任务。有些方法适用于处理简单的是非问题的单个评分者,而另一些方法则专为涉及多个评分者的情况而设计。

常用的方法包括百分比一致性、Cohen's Kappa系数、Fleiss' Kappa系数和组内相关系数。每种方法都衡量评估者之间的一致性水平,并考虑到某些一致性可能偶然发生的可能性。

Cohen Kappa 系数是一种广泛使用的方法,用于衡量两个评分者之间的一致性。它计算他们在一项任务上达成一致的频率,同时调整了某些一致性可能偶然发生的可能性。分数范围从 -1 到 1,其中 1 表示完全一致,0 表示一致性不比随机猜测好。

同样,当涉及两个以上的评分者时,使用 Fleiss' Kappa。它提供了一个总体分数,显示了群体的一致性。这两种方法都用于具有设定类别的任务,例如标记图像或标记情绪。它们易于计算,并且受到大多数标注工具的支持。

衡量评分者间信度的另一种方法是百分比一致性,它计算评分者做出相同决定的次数的百分比。虽然使用简单,但它没有考虑到可能偶然发生的一致性。

同时,组内相关系数是一种更高级的方法,用于连续或基于尺度的数据。 它衡量多个评分者之间评分的一致性,通常应用于涉及分数、测量或其他超出固定类别的数据类型的研究。

现在我们对如何衡量评分者间信度有了更好的了解,接下来让我们了解一下这些方法如何在实际应用中使用。

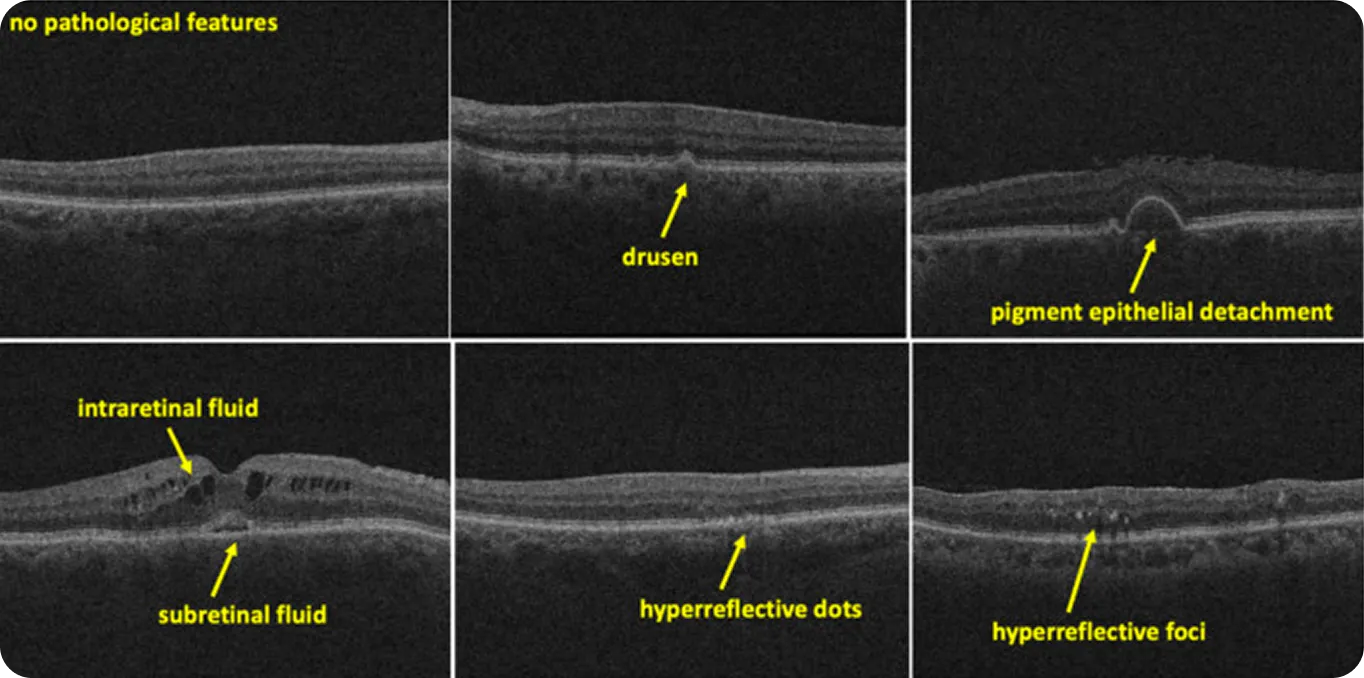

在医学影像方面,即使是细微的解读差异也可能导致结果的重大变化。 例如,放射科医生经常被要求识别微妙、模糊或难以定义的模式。 当这些模式成为 AI 系统的训练数据时,风险会更高。 如果专家对同一扫描结果的标记不同,则模型可能会学习错误的模式或根本无法学习。

评分者间信度帮助处理此类数据的团队评估专家判断的真实一致性。例如,在最近一项关于 视网膜 OCT 扫描 的研究中,两位评分者标注了 500 张图像。

对于诸如玻璃膜疣(视网膜下的黄色沉积物)等清晰特征,一致性很高,kappa 得分为 0.87。但对于诸如高反射灶(在视网膜扫描中看到的小而亮点)等更难定义的元素,得分降至 0.33。这表明更清晰、更明确的特征往往会产生更一致的专家判断,而模糊的特征则留有更多的解释空间。

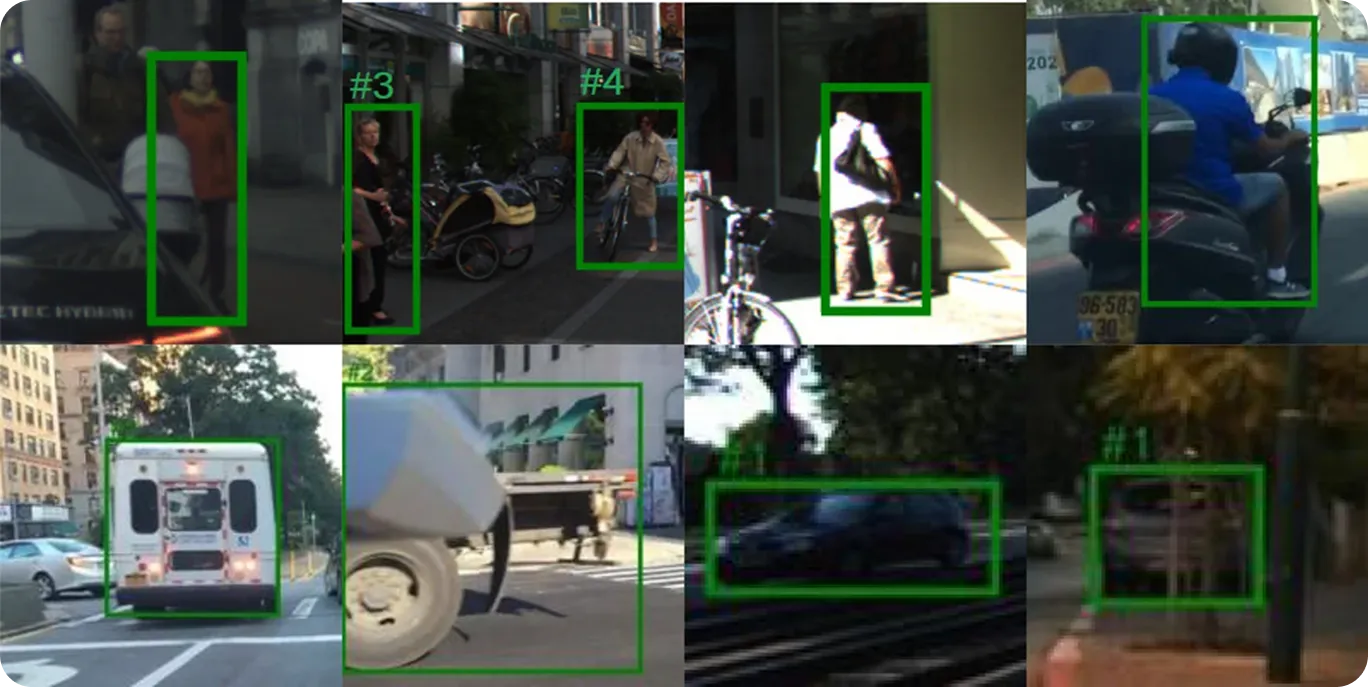

训练用于自动驾驶系统的人工智能模型取决于在各种道路条件下准确、一致的标签。从事此类项目的标注员通常被要求识别行人、车辆、交通标志和车道标记,通常在光线不足或拥挤的场景中进行。

这些决策决定了模型如何在严酷的真实环境中学习响应。评估者间信度使团队可以检查标注者是否以相同的方式应用这些标签。

虽然衡量评估者间信度是构建人工智能解决方案的关键步骤,但它是更广泛的质量保证过程的一部分。以下是一些其他实践,可以帮助提高团队和项目的数据质量:

评分者间信度衡量人们应用标签或做出决策的一致性。Cohen’s Kappa、Fleiss’ Kappa 和 ICC 等方法有助于量化这种一致性。通过明确的指南、培训和偏差控制,可靠的标注可以带来更强大的数据和更好的模型结果。

加入我们的社区,并探索我们的GitHub代码仓库,以了解更多关于AI的信息。如果您希望启动自己的视觉AI项目,请查看我们的许可选项以开始使用。您还可以通过访问我们的解决方案页面,了解医疗保健领域的AI和零售领域的视觉AI如何产生影响。