重温YOLO Vision 2025 深圳峰会的重要时刻,Ultralytics 将创新者、合作伙伴和人工智能社区聚集在一起,共同度过了充满灵感的一天。

重温YOLO Vision 2025 深圳峰会的重要时刻,Ultralytics 将创新者、合作伙伴和人工智能社区聚集在一起,共同度过了充满灵感的一天。

10 月 26 日,YOLO Vision 2025(YV25)在深圳华侨城创意文化园 B10 栋首次亮相中国。Ultralytics的视觉人工智能混合活动吸引了 200 多名与会者亲临现场,还有更多与会者通过 YouTube 和 Bilibili 在线参加了活动。

YV25深圳峰会的现场直播在YouTube上的观看次数已超过3500次,随着活动亮点在社区中的分享,关注度也在持续上升。这一天充满了创意、对话和对视觉人工智能下一步发展方向的实践探索。

活动伊始,主持人黄雪莹对大家的到来表示热烈欢迎,并邀请大家在整个活动期间进行交流、学习和讨论。她解释说,这是继今年 9 月在伦敦举办的YOLO Vision 之后,今年举办的第二届YOLO Vision,并分享了在深圳再次将 Vision AI 社区聚集在一起是多么令人兴奋。

在这篇文章中,我们将重温当天的精彩瞬间,包括模型更新、演讲环节、现场演示以及让大家欢聚一堂的社区时刻。让我们开始吧!

Ultralytics 创始人兼首席执行官格伦-乔彻(Glenn Jocher)主持了当天的第一个主题演讲,他分享了Ultralytics YOLO 模型如何从一个研究突破发展成为世界上应用最广泛的视觉人工智能模型。Glenn 解释说,他早期的工作重点是让YOLO 更容易使用。

他将模型移植到PyTorch,改进了文档,并公开分享一切,以便各地的开发人员都能在此基础上进行开发。他回忆说:"2018 年,我一头扎了进去。我决定这就是我的未来。最初的个人努力很快变成了一场全球性的开源运动。

今天,Ultralytics YOLO 模型每天为数十亿次推断提供动力,格伦强调,这种规模的实现离不开帮助构建它的人们。来自世界各地的研究人员、工程师、学生、业余爱好者和开源贡献者将YOLO 塑造成了今天的样子。

正如格伦所说:"外面有近千名(贡献者),我们对此非常感激。没有这些人,就没有我们的今天"。

今年早些时候,Ultralytics YOLO26 在伦敦举行的 "YOLO 2025 愿景"活动上首次亮相,并作为Ultralytics YOLO 模型家族的下一个重要步骤进行了介绍。在深圳 YV25 大会上,Glenn 介绍了自发布以来的最新进展,并让人工智能社区近距离了解了该模型的演变过程。

YOLO26 设计得更小、更快、更准确,同时又能满足实际使用的需要。格伦解释说,团队在过去的一年中不断完善架构,对各种设备的性能进行基准测试,并吸收了研究和社区反馈的意见。我们的目标是在不增加模型部署难度的情况下提供最先进的性能。

Glenn 强调的核心更新之一是,YOLO26 搭配了专门的超参数调整活动,从完全从零开始的训练转变为在更大的数据集上进行微调。他解释说,这种方法更符合实际使用情况。

以下是活动中分享的其他一些主要改进:

这些更新使模型的CPU 运算速度提高了 43%,同时准确度也高于 Ultralytics YOLO11的准确性,这使得 YOLO26 对嵌入式设备、机器人和边缘系统尤其具有影响力。

YOLO26 将支持YOLO11 目前提供的所有相同任务和模型大小,从而在整个系列中提供 25 种模型变体。其中包括用于检测、分割、姿势估计 、定向边界框和分类的模型,范围从纳米级到超大型。

该团队还在开发五个可提示变体。这些模型可以接受文本提示,直接返回边界框,无需训练。

这是迈向更灵活、基于指令的视觉工作流程的第一步,更容易适应不同的使用情况。YOLO26 模型仍在积极开发中,但早期的性能结果很好,团队正在努力尽快发布这些模型。

在 YOLO26 更新之后,Glenn 欢迎我们的产品工程主管Prateek Bhatnagar 现场演示Ultralytics 平台。这个平台的建立是为了将计算机视觉工作流程的关键部分整合在一起,包括探索数据集、注释图像、训练模型和比较结果。

Prateek指出,该平台秉承了Ultralytics的开源理念,引入了两个社区空间--数据集社区和项目社区,开发人员可以在这里贡献、重用和改进彼此的工作。在演示过程中,他展示了人工智能辅助注释、简易云培训以及直接从社区微调模型的能力,而无需本地GPU 资源。

该平台目前正在开发中。Prateek 鼓励听众关注相关公告,并指出中国的团队正在不断壮大,以支持平台的推出。

随着声势的扩大,活动进入了小组讨论环节,不同YOLO 模型背后的几位研究人员参与了讨论。小组成员包括 Glenn Jocher、我们的高级机器学习工程师邱晶、Meta 的机器学习工程师兼YOLOv10 的作者之一陈辉,以及美团的算法策略师兼YOLOv6 的作者之一张博。

讨论的重点是YOLO 如何通过实际应用不断发展。发言者谈到了实际部署挑战是如何推动进展的,例如在边缘设备上高效运行、改进小物体检测和简化模型导出。

小组成员指出,在生产环境中,平衡速度、可用性和可靠性非常重要,而不是一味追求准确性。另一个共同收获是迭代和社区反馈的价值。

以下是对话中其他一些有趣的见解:

接下来,让我们来看看 YV25 深圳峰会上的一些主题演讲,人工智能界的领袖们分享了视觉人工智能是如何发展的,从数字人类和机器人到多模态推理和高效边缘部署。

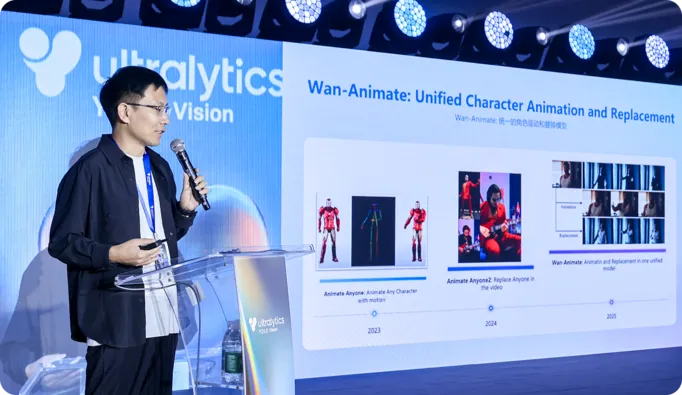

阿里巴巴奇文实验室的张鹏博士在会上分享了他的团队如何开发大型视频模型,以生成动作和控制更自然、更有表现力的数字人。他介绍了 Wan S2V 和 Wan Animate,这两款软件使用音频或动作参考来生成逼真的语音、手势和动画,解决了纯文本驱动生成的局限性。

张博士还谈到了在实时交互化身方面取得的进展,包括外观和动作的零镜头克隆,以及可以直接从实时摄像机画面中生成面部动画的轻量级模型,从而使栩栩如生的数字人更接近于在日常设备上流畅运行。

YV25 深圳峰会的主题之一,就是从单纯观察世界的视觉模型,转变为能够在其中行动的系统。换句话说,感知不再是管道的终点,而是行动的起点。

例如,D-Robotics 公司的Hu Chunxu在主题演讲中介绍了他们的开发套件和 SoC(片上系统)解决方案如何在统一的硬件和软件堆栈上集成感知、实时运动控制和决策功能。通过将感知和行动视为一个连续的反馈回路,而不是单独的阶段,他们的方法支持机器人在真实环境中更可靠地移动、适应和互动。

来自百度 Paddle 的Alex Zhang在他的演讲中也表达了这一观点,他解释了YOLO 和 PaddleOCR 如何协同工作来detect 物体,然后解释物体周围的文本和结构。这样,系统就能将图像和文档转换成可用的结构化信息,用于物流、检查和自动处理等任务。

YV25 深圳峰会上另一个有趣的话题是视觉人工智能如何在边缘设备上变得更加高效和强大。

来自DEEPX的Paul Jung介绍了直接在嵌入式硬件上部署YOLO 模型,从而减少对云计算的依赖。通过专注于低功耗、优化推理和硬件感知模型调整,DEEPX 实现了无人机、移动机器人和在动态环境中运行的工业系统的实时感知。

同样,摩尔线程的刘凌飞也分享了摩尔线程 E300 平台如何集成中央处理器CPU)、图形处理器GPU)和神经处理单元(NPU)计算,在紧凑型设备上实现高速视觉推理。

该平台可以高帧率运行多个YOLO 流,其工具链简化了量化、静态编译和性能调整等步骤。Moore Threads 还开源了大量计算机视觉模型和部署示例,以降低开发人员的门槛。

直到最近,要建立一个既能理解图像又能解释语言的单一模型,还需要大量的 transformer架构,运行成本高昂。在深圳 YV25 大会上,来自元石智能的岳子言介绍了 RWKV,这是一种融合了转换器的长语境推理能力和递归模型效率的架构。

他解释了 Vision-RWKV 如何将这一设计应用于计算机视觉,以一种随分辨率线性扩展的方式处理图像。这使其适用于高分辨率输入和计算能力有限的边缘设备。

Yue 还展示了 RWKV 在视觉语言系统中的应用,在视觉语言系统中,图像特征与文本理解相结合,从而超越了物体检测的范畴,成为对场景、文档和现实世界背景的解释。

台上的演讲展望了视觉人工智能的发展前景,而会场上的展台则展示了视觉人工智能在当今的应用情况。与会者可以看到实时运行的模型,比较硬件选项,并与构建这些系统的团队直接交流。

下面是展示的技术一瞥:

除了令人兴奋的技术之外,YV25 深圳站最精彩的部分之一就是让计算机视觉社区和Ultralytics 团队再次聚首一堂。整整一天,人们围着演示产品,在茶歇时间交流想法,并在演讲结束后继续长时间交谈。

研究人员、工程师、学生和建设者们相互交流,提出问题,并交换了从部署到模型培训的实际经验。在奥斯本集团 Cinco Jotas 的帮助下,我们还用新鲜的火腿为活动带来了西班牙文化的气息,创造了一个温馨的交流时刻。美丽的场地、热情的人群和共同的动力感让这一天变得与众不同。

从鼓舞人心的主题演讲到实际操作演示,深圳YOLO Vision 2025 大会充分体现了Ultralytics 社区的创新精神。在整整一天的会议中,演讲者和与会者交流思想、探索新技术,并就人工智能的未来共同愿景进行了交流。他们一起为Ultralytics YOLO 的下一步做好了准备。

用人工智能和计算机视觉重新想象可能。加入我们的社区和GitHub 存储库,了解更多信息。进一步了解计算机视觉在农业和零售业 中的应用。了解我们的许可选项,现在就开始使用计算机视觉!