Kann KI menschliche Handlungen detect ? Erforschung der Aktivitätserkennung

Von Fitness-Apps bis hin zur Patientenüberwachung: Entdecken Sie, wie Computer Vision die Frage beantwortet: Kann KI menschliche Handlungen in realen Umgebungen detect ?

Von Fitness-Apps bis hin zur Patientenüberwachung: Entdecken Sie, wie Computer Vision die Frage beantwortet: Kann KI menschliche Handlungen in realen Umgebungen detect ?

Das tägliche Leben ist voller kleiner Bewegungen, über die wir selten nachdenken. Durch einen Raum gehen, an einem Schreibtisch sitzen oder einem Freund zuwinken mag uns mühelos erscheinen, doch sie mit KI zu erkennen, ist weitaus komplizierter. Was dem Menschen ganz natürlich vorkommt, wird viel komplexer, wenn eine Maschine versucht, es zu verstehen.

Diese Fähigkeit wird als menschliche Aktivitätserkennung (HAR) bezeichnet und ermöglicht es Computern, Muster im menschlichen Verhalten detect und zu interpretieren. Eine Fitness-App ist ein gutes Beispiel für HAR in Aktion. Indem sie Schritte und Trainingsroutinen aufzeichnet, zeigt sie, wie KI tägliche Aktivitäten überwachen kann.

Viele Branchen haben das Potenzial von HAR erkannt und begonnen, diese Technologie einzusetzen. Tatsächlich wird erwartet, dass der Markt für Aktionserkennung bis 2033 über 12,56 Milliarden Dollar erreichen wird.

Ein wesentlicher Teil dieses Fortschritts wird durch Computer Vision vorangetrieben, einem Zweig der KI, der es Maschinen ermöglicht, visuelle Daten wie Bilder und Videos zu analysieren. Mit Computer Vision und Bilderkennung hat sich HAR von einem Forschungskonzept zu einem praktischen und aufregenden Teil hochmoderner KI-Anwendungen entwickelt.

In diesem Artikel erfahren Sie, was HAR ist, welche verschiedenen Methoden zur Erkennung menschlicher Handlungen verwendet werden und wie Computer Vision bei der Beantwortung dieser Frage hilft: Kann KI menschliche Handlungen in realen Anwendungen detect ? Legen wir los!

Die Erkennung menschlicher Handlungen ermöglicht es Computersystemen, menschliche Aktivitäten oder Handlungen durch die Analyse von Körperbewegungen zu verstehen. Anders als nur eine Person in einem Bild zu erkennen, kann HAR dabei helfen, zu identifizieren, was die Person tut. Zum Beispiel die Unterscheidung zwischen Gehen und Laufen, das Erkennen eines Handwinkens oder das Bemerken, wenn jemand hinfällt.

Die Grundlage von HAR liegt in Bewegungsmustern und Körperhaltungen. Eine leichte Veränderung der Positionierung der Arme oder Beine eines Menschen kann eine Vielzahl von Aktionen signalisieren. Durch die Erfassung und Interpretation dieser subtilen Details können HAR-Systeme aussagekräftige Erkenntnisse aus Körperbewegungen gewinnen.

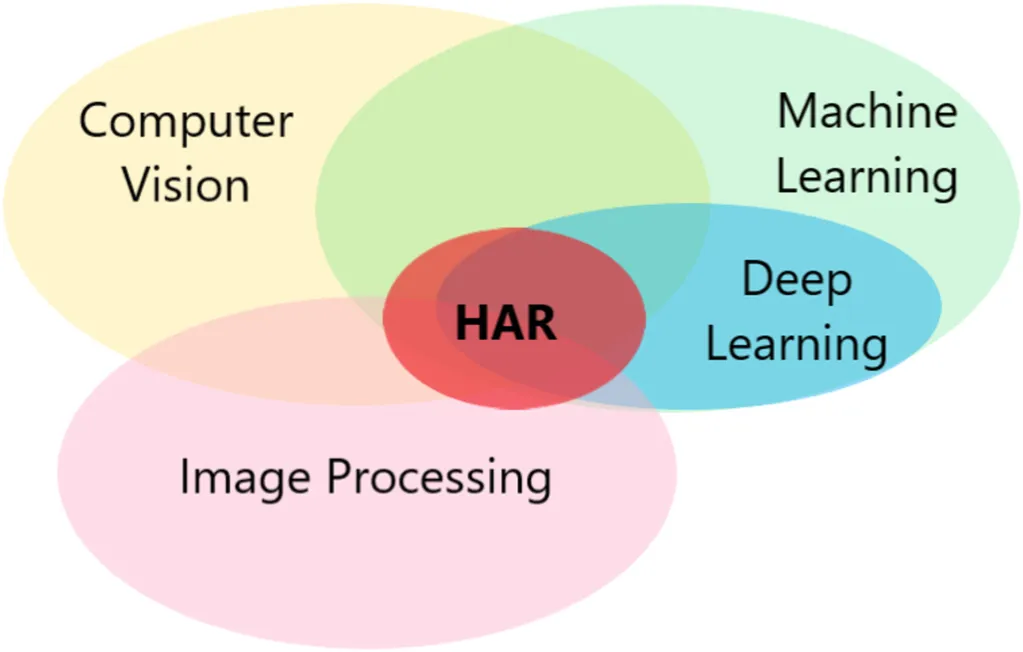

Um dies zu erreichen, kombiniert die Erkennung menschlicher Handlungen mehrere Technologien wie maschinelles Lernen, Deep-Learning-Modelle, Computer Vision und Bildverarbeitung, die zusammenarbeiten, um Körperbewegungen zu analysieren und menschliche Handlungen mit höherer Genauigkeit zu interpretieren.

Frühere HAR-Systeme waren viel eingeschränkter. Sie konnten nur wenige einfache, sich wiederholende Aktionen in kontrollierten Umgebungen ausführen und hatten oft Schwierigkeiten in realen Situationen.

Heute hat HAR dank KI und großen Mengen an Videodaten sowohl in Bezug auf Genauigkeit als auch auf Robustheit erhebliche Fortschritte gemacht. Moderne Systeme können ein breites Spektrum an Aktivitäten mit viel größerer Genauigkeit erkennen, was die Technologie für Bereiche wie Gesundheitswesen, Sicherheit und interaktive Geräte praktikabel macht.

Nachdem wir nun besser verstanden haben, was die Erkennung menschlicher Handlungen ist, wollen wir einen Blick auf die verschiedenen Möglichkeiten werfen, mit denen Maschinen menschliche Handlungen detect können.

Hier sind einige der gängigen Methoden:

Für jedes HAR-Modell oder -System sind Datensätze der Ausgangspunkt. Ein HAR-Datensatz ist eine Sammlung von Beispielen, wie Videoclips, Bilder oder Sensordaten, die Aktionen wie Gehen, Sitzen oder Winken erfassen. Diese Beispiele werden verwendet, um KI-Modelle zu trainieren, um Muster in menschlichen Bewegungen zu erkennen, die dann in realen Anwendungen eingesetzt werden können.

Die Qualität der Trainingsdaten wirkt sich direkt auf die Leistungsfähigkeit eines Modells aus. Saubere, konsistente Daten erleichtern es dem System, Aktionen präzise zu erkennen.

Aus diesem Grund werden Datensätze oft vor dem Training vorverarbeitet. Ein üblicher Schritt ist die Normalisierung, die Werte konsistent skaliert, um Fehler zu reduzieren und Overfitting zu verhindern (wenn ein Modell bei Trainingsdaten gut abschneidet, aber bei neuen Daten Schwierigkeiten hat).

Um zu messen, wie Modelle über das Training hinaus funktionieren, greifen Forscher auf Evaluationsmetriken und Benchmark-Datensätze zurück, die faire Tests und Vergleiche ermöglichen. Beliebte Sammlungen wie UCF101, HMDB51 und Kinetics enthalten Tausende von beschrifteten Videoclips zur Erkennung menschlicher Handlungen. Auf der Sensorseite liefern Datensätze, die von Smartphones und Wearables gesammelt wurden, wertvolle Bewegungssignale, die Erkennungsmodelle in verschiedenen Umgebungen robuster machen.

Unter den verschiedenen Methoden zur detect menschlicher Handlungen hat sich die Computer Vision schnell zu einer der beliebtesten und am meisten erforschten entwickelt. Ihr Hauptvorteil besteht darin, dass sie zahlreiche Details direkt aus Bildern und Videos gewinnen kann. Durch die Betrachtung von Pixeln Bild für Bild und die Analyse von Bewegungsmustern können Aktivitäten in Echtzeit erkannt werden, ohne dass die Menschen zusätzliche Geräte tragen müssen.

Jüngste Fortschritte im Deep Learning, insbesondere bei Convolutional Neural Networks (CNNs), die für die Analyse von Bildern entwickelt wurden, haben Computer Vision schneller, genauer und zuverlässiger gemacht.

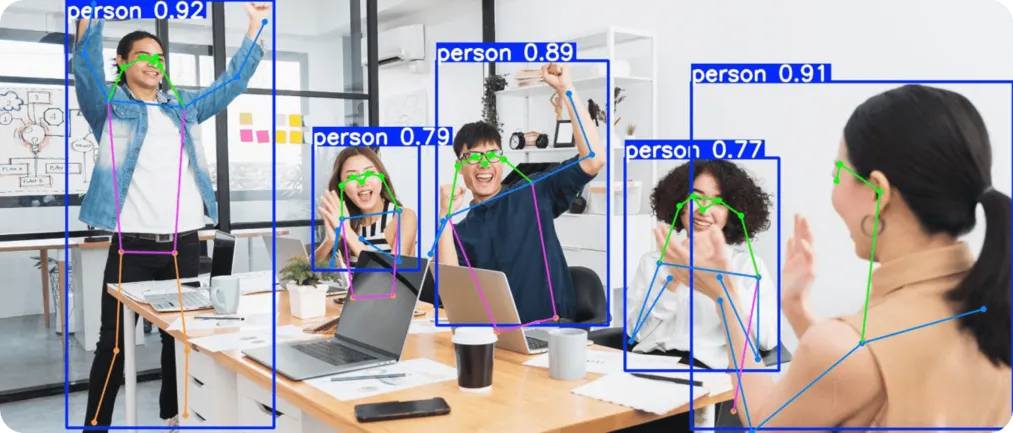

Zum Beispiel sind weit verbreitete moderne Computer-Vision-Modelle wie Ultralytics YOLO11 beruhen auf diesen Fortschritten. YOLO11 unterstützt Aufgaben wie die Erkennung von Objekten, die Segmentierung von Instanzen, die Verfolgung von Personen über Videobilder hinweg und die Schätzung menschlicher Posen, was es zu einem hervorragenden Werkzeug für die Erkennung menschlicher Aktivitäten macht.

Ultralytics YOLO11 ist ein Bildverarbeitungsmodell, das auf Geschwindigkeit und Präzision ausgelegt ist. Es unterstützt Kernaufgaben der Computer Vision wie Objekterkennung, Objektverfolgung und Posenschätzung. Diese Fähigkeiten sind besonders nützlich für die Erkennung menschlicher Aktivitäten.

Die Objekterkennung identifiziert und lokalisiert Personen in einer Szene, die Verfolgung verfolgt ihre Bewegungen über Videobilder hinweg, um Aktionssequenzen zu erkennen, und die Posenschätzung bildet wichtige menschliche Körpergelenke ab, um zwischen ähnlichen Aktivitäten zu unterscheiden oder plötzliche Veränderungen wie einen Sturz detect .

Beispielsweise können Erkenntnisse aus dem Modell verwendet werden, um den Unterschied zwischen jemandem, der ruhig sitzt, dann aufsteht und schließlich die Arme zum Jubeln hebt, zu erkennen. Diese einfachen alltäglichen Handlungen mögen auf den ersten Blick ähnlich erscheinen, haben aber bei der Analyse in einer Sequenz eine sehr unterschiedliche Bedeutung.

Als Nächstes wollen wir uns genauer ansehen, wie die durch Computer Vision unterstützte Erkennung menschlicher Aktivitäten in realen Anwendungsfällen eingesetzt wird, die unser tägliches Leben beeinflussen.

Im Gesundheitswesen können kleine Veränderungen in der Bewegung nützliche Einblicke in den Zustand einer Person geben. So kann beispielsweise ein Stolpern eines älteren Patienten oder der Winkel einer Gliedmaße während der Rehabilitation Risiken oder Fortschritte aufzeigen. Diese Anzeichen werden oft durch traditionelle Mittel, wie z. B. Kontrolluntersuchungen, leicht übersehen.

YOLO11 kann mit Hilfe von Posenschätzung und Bildanalyse helfen, Patienten in Echtzeit zu überwachen. Es kann verwendet werden, um Stürze detect , Erholungsübungen track und tägliche Aktivitäten wie Gehen oder Dehnen zu beobachten. Da es durch visuelle Analyse funktioniert, ohne dass Sensoren oder tragbare Geräte erforderlich sind, bietet es eine einfache Möglichkeit, genaue Informationen zu sammeln, die die Patientenversorgung unterstützen.

Sicherheitssysteme sind darauf angewiesen, ungewöhnliche menschliche Aktivitäten schnell zu erkennen, z. B. wenn jemand herumlungert, in einem gesperrten Bereich läuft oder plötzlich aggressiv wird. Diese Anzeichen werden in geschäftigen Umgebungen, in denen das Sicherheitspersonal nicht alles manuell überwachen kann, oft übersehen. An dieser Stelle kommen Computer Vision und YOLO11 ins Spiel.

YOLO11 vereinfacht die Sicherheitsüberwachung durch Echtzeit-Videoüberwachung, die verdächtige Bewegungen detect und sofortige Warnmeldungen senden kann. Es unterstützt die Sicherheit von Menschenmengen im öffentlichen Raum und verstärkt die Erkennung von Eindringlingen in privaten Bereichen.

Mit diesem Ansatz können Sicherheitskräfte mit Computer-Vision-Systemen zusammenarbeiten und so eine Mensch-Computer-Interaktion und Partnerschaft schaffen, die schnellere und zeitnahere Reaktionen auf verdächtige Aktivitäten ermöglicht.

Hier sind einige der Vorteile der Verwendung von Computer Vision für die Erkennung menschlicher Aktivitäten:

Obwohl die Verwendung von Computer Vision für HAR viele Vorteile bietet, gibt es auch Einschränkungen zu berücksichtigen. Hier sind einige Faktoren, die Sie beachten sollten:

Künstliche Intelligenz und Computer Vision ermöglichen es Maschinen, menschliche Handlungen genauer und in Echtzeit zu erkennen. Durch die Analyse von Videobildern und Bewegungsmustern können diese Systeme sowohl alltägliche Gesten als auch plötzliche Veränderungen identifizieren. Da sich die Technologie ständig verbessert, geht die Erkennung menschlicher Aktivitäten über Forschungslabore hinaus und wird zu einem praktischen Werkzeug für das Gesundheitswesen, die Sicherheit und alltägliche Anwendungen.

Erfahren Sie mehr über KI, indem Sie unser GitHub-Repository besuchen und unserer Community beitreten. Auf unseren Lösungsseiten erfahren Sie mehr über KI in der Robotik und Computer Vision in der Fertigung. Entdecken Sie unsere Lizenzoptionen, um mit Vision AI zu beginnen.