Erfahren Sie, wie Sie die Experimentverfolgung nutzen können, um Ihre Ultralytics YOLO11 mit der DVC-Integration für eine bessere Modellleistung zu optimieren.

.webp)

Erfahren Sie, wie Sie die Experimentverfolgung nutzen können, um Ihre Ultralytics YOLO11 mit der DVC-Integration für eine bessere Modellleistung zu optimieren.

.webp)

Die Verfolgung und Überwachung von Computer-Vision-Experimenten, bei denen Maschinen darauf trainiert werden, visuelle Daten zu interpretieren und zu verstehen, ist ein entscheidender Bestandteil der Entwicklung und Feinabstimmung von Vision AI-Modellen wie Ultralytics YOLO11. Bei diesen Experimenten werden oft verschiedene Schlüsselparameter getestet und Metriken und Ergebnisse aus mehreren Modell-Trainingsläufen protokolliert. Auf diese Weise kann die Modellleistung analysiert und das Modell datengesteuert verbessert werden.

Ohne ein klar definiertes System zur Verfolgung von Experimenten kann der Vergleich von Ergebnissen und die Änderung von Modellen kompliziert werden und zu Fehlern führen. Tatsächlich ist die Automatisierung dieses Prozesses eine gute Option, die eine bessere Konsistenz gewährleisten kann.

Genau das ist das Ziel der von Ultralytics unterstützten DVCLive-Integration. DVCLive bietet eine vereinfachte Möglichkeit zur automatischen Protokollierung von Versuchsdetails, zur Visualisierung von Ergebnissen und zur Verwaltung der Modellleistungsverfolgung - alles innerhalb eines einzigen Arbeitsablaufs.

In diesem Artikel besprechen wir, wie man die DVCLive-Integration beim Training von Ultralytics YOLO11 verwendet. Wir werden auch einen Blick auf die Vorteile werfen und darauf, wie sie die Verfolgung von Experimenten für eine bessere Entwicklung von Vision AI-Modellen erleichtert.

DVCLive wurde von DVC (Data Version Control) entwickelt und ist ein zuverlässiges Open-Source-Tool für die Verfolgung von Experimenten zum maschinellen Lernen. Die Python DVCLive bietet einen Echtzeit-Experiment-Logger, der es KI-Entwicklern und -Forschern ermöglicht, die Metriken und Parameter ihrer Experimente track .

Zum Beispiel kann es automatisch wichtige Metriken zur Modellleistung protokollieren, Ergebnisse über Trainingsläufe hinweg vergleichen und die Modellleistung visualisieren. Diese Funktionen ermöglichen es DVCLive, Sie bei der Aufrechterhaltung eines strukturierten und reproduzierbaren Machine-Learning-Workflows zu unterstützen.

Die DVCLive-Integration ist einfach zu bedienen und kann Ihre Computer-Vision-Projekte durch klare, leicht verständliche Datenvisualisierungen und Analysetools verbessern. Hier sind einige weitere Hauptmerkmale von DVCLive:

Wenn Sie die Ultralytics Dokumentation durchgehen und die verfügbaren Integrationen erkunden, werden Sie sich vielleicht fragen: Was zeichnet die DVCLive-Integration aus, und warum sollte ich sie für meinen Arbeitsablauf wählen?

Angesichts von Integrationen wie TensorBoard und MLflow, die ebenfalls Tools zur Verfolgung von Metriken und zur Visualisierung von Ergebnissen bieten, ist es wichtig, die einzigartigen Eigenschaften zu verstehen, die diese Integration auszeichnen.

Hier erfahren Sie, warum DVCLive die ideale Wahl für Ihre Ultralytics YOLO sein könnte:

Ultralytics YOLO11 mit DVCLive zu verfolgen ist einfacher, als Sie vielleicht erwarten. Sobald die erforderlichen Bibliotheken installiert und konfiguriert sind, können Sie schnell mit dem individuellen Training Ihres YOLO11 beginnen.

Nach dem Training können Sie wichtige Einstellungen wie Epochen (die Anzahl der Durchläufe des Modells durch den gesamten Datensatz), Geduld (wie lange gewartet werden soll, bevor gestoppt wird, wenn keine Verbesserung eintritt) und Zielbildgröße (die Auflösung der für das Training verwendeten Bilder) anpassen, um die Genauigkeit zu verbessern. Anschließend können Sie mit dem Visualisierungstool von DVCLive verschiedene Versionen Ihres Modells vergleichen und deren Leistung analysieren.

Ein detaillierteres Verständnis des Modellschulungsprozesses und der besten Praktiken finden Sie in unserer Dokumentation zur individuellen Schulung von Ultralytics YOLO .

Als Nächstes möchten wir Ihnen zeigen, wie Sie die DVCLive-Integration installieren und verwenden, während Sie YOLO11 individuell trainieren.

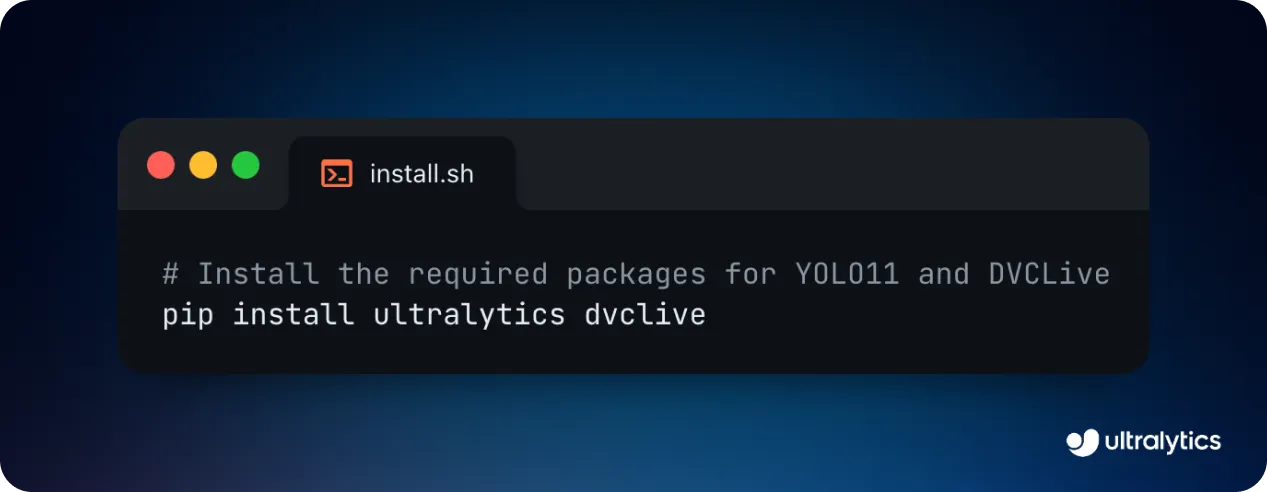

Bevor Sie mit dem Training YOLO11 beginnen können, müssen Sie sowohl das Ultralytics Python als auch DVCLive installieren. Diese Integration wurde so konzipiert, dass beide Bibliotheken standardmäßig nahtlos zusammenarbeiten, so dass Sie sich nicht um komplexe Konfigurationen kümmern müssen.

Der gesamte Installationsprozess kann mit einem einzigen Pip-Befehl in wenigen Minuten abgeschlossen werden. Pip ist ein Paketverwaltungstool für die Installation von Python , wie in der Abbildung unten dargestellt.

Sobald Sie die Pakete installiert haben, können Sie Ihre Umgebung einrichten und die erforderlichen Anmeldeinformationen hinzufügen, um sicherzustellen, dass DVCLive reibungslos läuft. Das Einrichten eines Git-Repositorys ist ebenfalls hilfreich, um Ihren Code und alle Änderungen an Ihren DVCLive-Einstellungen track .

Eine detaillierte Schritt-für-Schritt-Anleitung und weitere hilfreiche Tipps finden Sie in unserem Installationsleitfaden. Falls Sie bei der Installation der erforderlichen Pakete auf Probleme stoßen, bietet unser Leitfaden zu häufigen Problemen Lösungen und Ressourcen, die Ihnen weiterhelfen.

Nachdem Ihr YOLO11 abgeschlossen ist, können Sie die Visualisierungswerkzeuge verwenden, um die Ergebnisse eingehend zu analysieren. Insbesondere können Sie die API von DVC verwenden, um die Daten zu extrahieren und sie mit Pandas (einer Python , die die Arbeit mit Daten erleichtert, wie z. B. die Organisation in Tabellen für Analysen und Vergleiche) für eine einfachere Handhabung und Visualisierung zu verarbeiten.

Für eine interaktivere und visuelle Möglichkeit, Ihre Ergebnisse zu untersuchen, können Sie auch Plotlys Parallelkoordinatenplot verwenden (eine Diagrammart, die zeigt, wie verschiedene Modellparameter und Leistungsergebnisse miteinander verbunden sind).

Letztendlich können Sie die Erkenntnisse aus diesen Visualisierungen nutzen, um bessere Entscheidungen hinsichtlich der Optimierung Ihres Modells, des Hyperparameter-Tunings oder anderer Modifikationen zu treffen, um seine Gesamtleistung zu steigern.

Nachdem wir nun gelernt haben, wie man YOLO11 mit Hilfe der DVCLive-Integration installiert und visualisiert, wollen wir nun einige der Anwendungen untersuchen, die diese Integration verbessern kann.

Wenn es um die Landwirtschaft und die Ernte von Nahrungsmitteln geht, kann Präzision einen großen Unterschied machen. Landwirte können zum Beispiel die Unterstützung von YOLO11für die Objekterkennung und Instanzsegmentierung nutzen, um potenzielle Pflanzenkrankheiten zu erkennen, Vieh track und Schädlingsbefall detect .

Insbesondere kann YOLO11 durch die Analyse von Drohnen- oder Kamerabildern helfen, Anzeichen von Pflanzenkrankheiten, Schädlingen oder ungesunden Tieren frühzeitig zu erkennen. Diese Art von KI-Systemen ermöglicht es Landwirten, schnell zu handeln, um die Ausbreitung von Problemen zu verhindern, Zeit zu sparen und Verluste zu verringern.

Da sich die Bedingungen in der Landwirtschaft mit dem Wetter und den Jahreszeiten ständig ändern, ist es wichtig, die Modelle mit einer Vielzahl von Bildern zu testen, um sicherzustellen, dass sie in verschiedenen Situationen gut funktionieren. Die Verwendung der DVCLive-Integration für das benutzerdefinierte Training YOLO11 für landwirtschaftliche Anwendungen ist eine großartige Möglichkeit, die Leistung des Modells zu track , insbesondere bei unterschiedlichen Datensätzen.

Einzelhandelsgeschäfte können KI und Computer Vision nutzen, um das Kundenverhalten zu verstehen und Verbesserungen vorzunehmen, um das Einkaufserlebnis zu verbessern.

Durch die Analyse der Videos von Sicherheitskameras kann YOLO11 track , wie sich die Menschen im Laden bewegen, welche Bereiche am meisten frequentiert werden und wie die Kunden mit den Produkten interagieren. Diese Daten können dann verwendet werden, um Heatmaps zu erstellen, die zeigen, welche Regale die meiste Aufmerksamkeit auf sich ziehen, wie lange sich Kunden in den verschiedenen Gängen aufhalten und ob Werbedisplays wahrgenommen werden.

Mit dieser Business Intelligence können Ladenbesitzer Produkte umstellen, um den Umsatz zu steigern, die Kassenschlangen beschleunigen und das Personal so einsetzen, dass es Kunden dort und dann unterstützt, wo es am dringendsten benötigt wird.

Einzelhandelsgeschäfte weisen oft einzigartige Merkmale auf, wie z. B. unterschiedliche Lichtverhältnisse, Layouts und Menschenmengen. Aufgrund dieser Unterschiede müssen Computer-Vision-Modelle, die zur Analyse von Ladenaktivitäten verwendet werden, sorgfältig getestet und für jeden Standort angepasst werden, um Genauigkeit zu gewährleisten. Die DVCLive-Integration kann beispielsweise bei der Feinabstimmung von YOLO11 behilflich sein, so dass es für Einzelhandelsanwendungen präziser und zuverlässiger wird und bessere Einblicke in das Kundenverhalten und die Abläufe im Geschäft ermöglicht.

Das benutzerdefinierte Training YOLO11 mit der DVCLive-Integration macht es einfacher, Ihre Computer-Vision-Experimente track und zu verbessern. Es protokolliert automatisch wichtige Details, zeigt klare visuelle Ergebnisse und hilft Ihnen, verschiedene Versionen Ihres Modells zu vergleichen.

Egal, ob Sie die Produktivität in der Landwirtschaft steigern oder das Einkaufserlebnis in einem Geschäft verbessern möchten, diese Integration stellt sicher, dass Ihre Vision-KI-Modelle gut funktionieren. Mit der Experimentverfolgung können Sie Ihre Modelle systematisch testen, verfeinern und optimieren, was zu kontinuierlichen Verbesserungen in Bezug auf Genauigkeit und Leistung führt.

Treten Sie unserer Community bei und erkunden Sie unser GitHub-Repository, um mehr über Vision AI zu erfahren. Informieren Sie sich über unsere Lizenzoptionen, um Ihre Computer-Vision-Projekte zu starten. Interessieren Sie sich für Innovationen wie KI in der Fertigung oder Computer Vision im Bereich des autonomen Fahrens? Besuchen Sie unsere Lösungsseiten, um mehr zu erfahren.