Erforschung der Erkennung kleiner Objekte mit Ultralytics YOLO11

Entdecken Sie, wie Ultralytics YOLO11 eine schnelle und genaue Erkennung kleiner Objekte in realen Anwendungen wie Überwachung und RobotikYOLO11 .

Entdecken Sie, wie Ultralytics YOLO11 eine schnelle und genaue Erkennung kleiner Objekte in realen Anwendungen wie Überwachung und RobotikYOLO11 .

Mit Vision AI integrierte Drohnen können Hunderte von Metern über dem Boden fliegen und dennoch detect Person detect , die in ihrem Videofeed nur als wenige Pixel erscheint. Tatsächlich ist dies eine häufige Herausforderung in Anwendungen wie Robotik, Überwachung und Fernerkundung, wo Systeme sehr kleine Objekte innerhalb eines Bildes identifizieren müssen.

Herkömmliche Objekterkennungsmodelle haben damit jedoch Schwierigkeiten. Kleine Objekte in Bildern und Videos liefern nur sehr begrenzte visuelle Informationen. Einfach ausgedrückt: Wenn ein Modell sie betrachtet, gibt es nicht viele Details, aus denen es lernen oder die es erkennen kann.

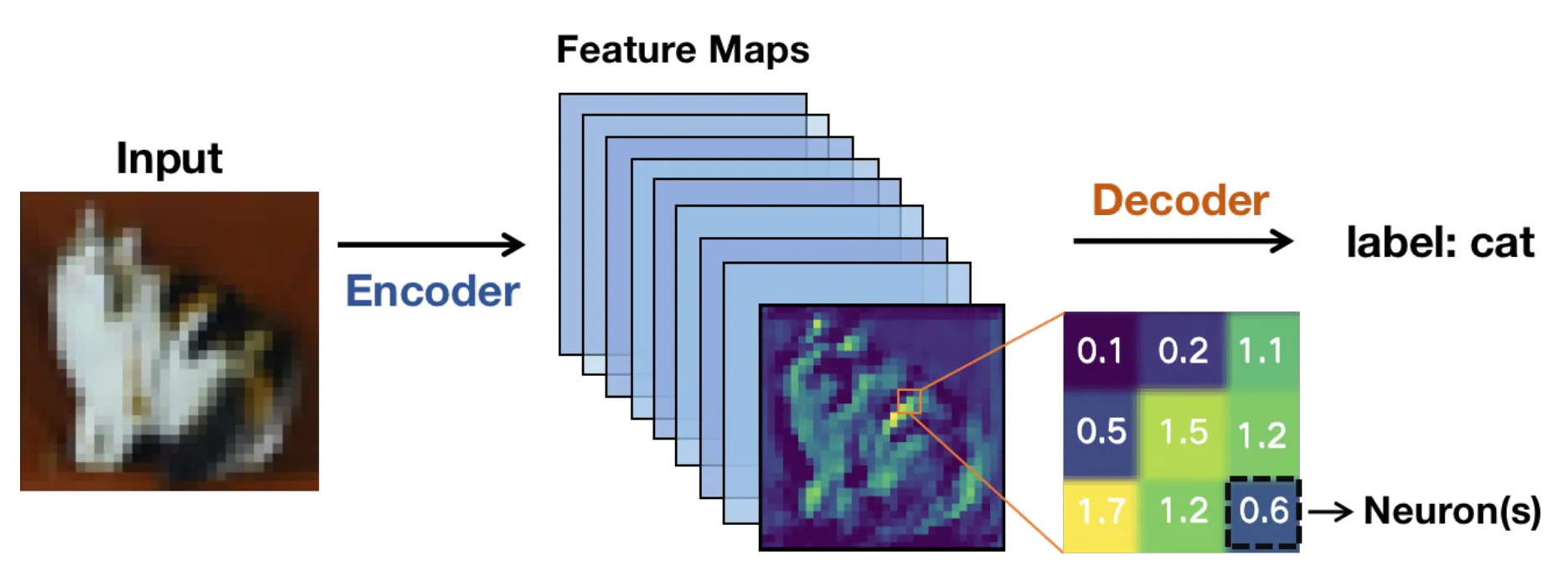

Unter der Haube basieren diese Modelle in der Regel auf einer auf einem Convolutional Neural Network (CNN) basierenden Architektur. Bilder werden durch die Schichten des Netzwerks geleitet und in Merkmalskarten oder vereinfachte Darstellungen umgewandelt, die relevante Muster anstelle von Rohpixeln hervorheben.

Je tiefer das Bild durch das Netzwerk wandert, desto kleiner werden diese Merkmalskarten. Das beschleunigt die Berechnung, bedeutet aber auch, dass feine Details verloren gehen können.

Bei winzigen Objekten sind diese Details entscheidend. Sobald diese Details verschwinden, kann ein Computervisionsmodell Schwierigkeiten haben, das Objekt zu erkennen, was zu weniger genauen oder inkonsistenten Begrenzungsrahmen führen kann.

Echtzeit-End-to-End-Computervisionsysteme machen dies noch schwieriger. Hochauflösende Bilder tragen dazu bei, Details zu erhalten, verlangsamen jedoch die Inferenz und erfordern mehr GPU . Niedrigere Auflösungen laufen schneller, aber kleine Objekte sind dadurch noch schwieriger zu detect.

Es wird zu einem ständigen Balanceakt zwischen Geschwindigkeit, Genauigkeit und Hardware-Grenzen. Dank der jüngsten technologischen Fortschritte können Computer-Vision-Modelle wie Ultralytics YOLO11 und das in Kürze erscheinende Ultralytics so konzipiert, dass sie diesen Kompromiss effektiver bewältigen können.

In diesem Artikel untersuchen wir, warum die Erkennung kleiner Objekte schwierig ist und wie YOLO11 dies vereinfachen YOLO11 . Los geht's!

Die Erkennung kleiner Objekte ist eine Aufgabe der Bildverarbeitung, einem Teilgebiet der KI, die sich auf die Identifizierung und Lokalisierung von Objekten konzentriert, die nur einen sehr kleinen Teil eines Bildes einnehmen. Diese Objekte werden innerhalb des Bildes oft durch eine begrenzte Anzahl von Pixeln dargestellt, die die kleinsten Einheiten eines digitalen Bildes sind. Dadurch sind sie schwieriger zu detect größere und klarere Ziele (die oft mehr Pixel enthalten).

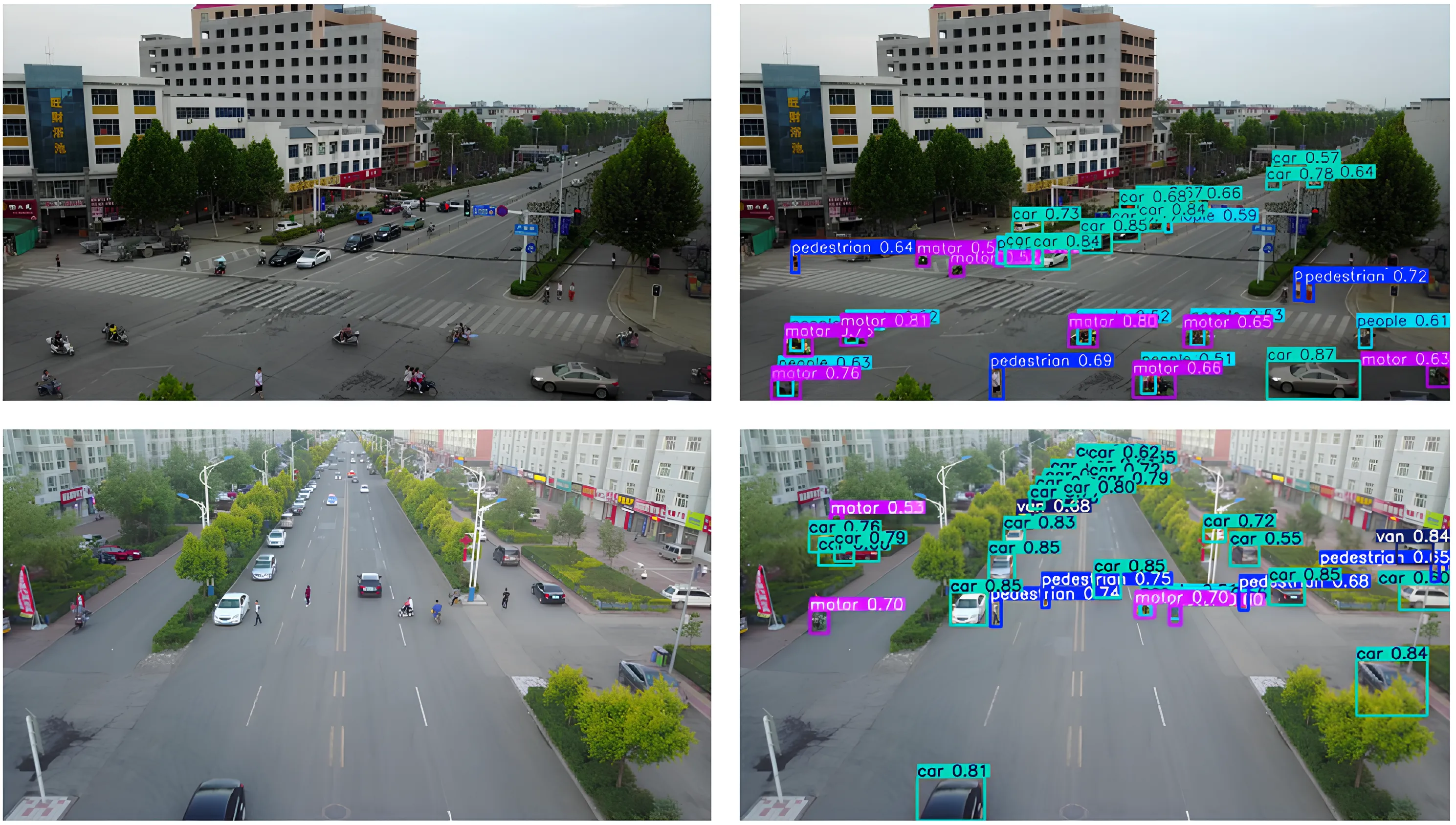

Beispielsweise können Fahrzeuge in Luftbildern, Werkzeuge in einer Fabrikhalle oder Personen, die von Weitwinkel-Überwachungskameras erfasst werden, als kleine Objekte innerhalb des Bildes erscheinen. Ihre Erkennung ist wichtig, da sie oft wichtige Informationen enthalten und viele reale Anwendungen, wie z. B. die Überwachung, auf diese Erkennung angewiesen sind, um korrekt zu funktionieren.

Wenn kleine Objekte übersehen werden, kann dies die Systemleistung und die Entscheidungsfindung beeinträchtigen. Ein gutes Beispiel hierfür ist die Überwachung durch unbemannte Luftfahrzeuge (UAV), bei der das Übersehen eines kleinen sich bewegenden Objekts am Boden die Navigations- oder Verfolgungsgenauigkeit beeinträchtigen kann.

Frühere Systeme verwendeten handgefertigte Funktionen und traditionelle Methoden der Bildverarbeitung, die in belebten oder abwechslungsreichen Szenen Probleme hatten. Selbst heute, wo Deep-Learning-Modelle weitaus bessere Leistungen erbringen, ist es immer noch schwierig, kleine Ziele zu erkennen, wenn sie nur einen winzigen Teil des Bildes einnehmen.

Als Nächstes wollen wir uns einige der häufigsten Herausforderungen ansehen, die in verschiedenen realen Szenarien bei der Erkennung kleiner Objekte auftreten.

Kleine Objekte enthalten nur sehr wenige Pixel, was die Menge an visuellen Details begrenzt, die ein Modell in Phasen wie der Merkmalsextraktion lernen kann. Infolgedessen sind Muster wie Kanten, Formen und Texturen schwieriger zu detect, wodurch kleine Objekte eher mit dem Hintergrund verschmelzen.

Während Bilder durch die Faltungsschichten eines neuronalen Netzwerks wandern, werden die visuellen Informationen in den Pixeln nach und nach zu Merkmalsabbildungen komprimiert. Dies trägt zur Effizienz des Modells bei, bedeutet aber auch, dass feine Details verloren gehen.

Bei kleinen Zielen können wichtige Hinweise verschwinden, bevor das Erkennungsnetzwerk reagieren kann. In diesem Fall wird die Lokalisierung weniger zuverlässig, und Begrenzungsrahmen können sich verschieben, überlappen oder die Zielobjekte vollständig verfehlen.

Größenbezogene Herausforderungen werden auch häufig durch Okklusion hervorgerufen. Okklusion tritt auf, wenn Objekte, insbesondere kleinere, teilweise durch andere Objekte in der Szene verdeckt werden.

Dadurch wird der sichtbare Bereich eines Ziels verringert, was die dem Objektdetektor zur Verfügung stehenden Informationen einschränkt. Selbst eine kleine Verdeckung kann Erkennungsnetzwerke verwirren, insbesondere in Kombination mit Eingaben mit niedriger Auflösung. Ein interessantes Beispiel hierfür findet sich in UAV-Datensätzen wie VisDrone, wo Fußgänger, Fahrräder oder Fahrzeuge teilweise durch Gebäude, Bäume oder andere sich bewegende Objekte verdeckt sein können.

Ebenso führt die Skalierungsabweichung zu einer weiteren Schwierigkeit, wenn dasselbe Objekt je nach Entfernung und Kameraposition sehr klein oder relativ groß erscheint. Trotz dieser Hürden müssen Erkennungsalgorithmen diese kleinen Objekte über verschiedene Maßstäbe hinweg erkennen, ohne an Genauigkeit zu verlieren.

Auch der Kontext spielt bei der Erkennung eine wichtige Rolle. So erscheinen große Objekte in der Regel vor einem klar erkennbaren Hintergrund, der hilfreiche visuelle Anhaltspunkte liefert. Bei kleinen Objekten fehlen diese Kontextinformationen hingegen oft, was die Mustererkennung erschwert.

Gängige Bewertungsmetriken wie Intersection over Union (IoU) messen, wie gut eine vorhergesagte Begrenzungsbox mit der Ground-Truth-Box übereinstimmt. Während IoU bei größeren Objekten gut IoU , verhält es sich bei kleinen Objekten ganz anders.

Kleine Objekte nehmen nur wenige Pixel ein, sodass selbst eine geringfügige Verschiebung des vorhergesagten Kastens einen großen proportionalen Fehler verursachen und den IoU stark senken kann. Das bedeutet, dass kleine Objekte oft den IoU nicht erreichen, der verwendet wird, um eine Vorhersage als richtig zu werten, selbst wenn das Objekt im Bild sichtbar ist.

Infolgedessen werden Lokalisierungsfehler eher als falsch-positive oder falsch-negative Ergebnisse klassifiziert. Diese Einschränkungen haben Forscher dazu veranlasst, die Art und Weise zu überdenken, wie Objekterkennungssysteme kleine,detect bewerten und behandeln.

Als Forscher daran arbeiteten, die Erkennung kleiner Objekte zu verbessern, wurde deutlich, dass die Erhaltung und Darstellung visueller Informationen über mehrere Maßstäbe hinweg von entscheidender Bedeutung ist. Diese Erkenntnis spiegelt sich in aktuellen arXiv-Forschungsarbeiten und in Beiträgen wider, die auf Veranstaltungen wie den IEEE International Conferences und der European Computer Vision Association (ECCV) vorgestellt wurden.

Wenn Bilder tiefer durch ein neuronales Netzwerk wandern, können kleine Objekte Details verlieren oder ganz verschwinden. Aus diesem Grund YOLO11 moderne Computervisionsmodelle wie YOLO11 einen starken Fokus auf eine bessere Merkmalsextraktion. Als Nächstes wollen wir uns die Kernkonzepte hinter Merkmalskarten und Merkmalspyramidennetzwerken genauer ansehen, um sie besser zu verstehen.

Wenn ein Eingabebild, beispielsweise ein Fernerkundungsbild, in ein neuronales Netzwerk gelangt, wird es schrittweise in Merkmalskarten umgewandelt. Dabei handelt es sich um vereinfachte Darstellungen des Bildes, die visuelle Muster wie Kanten, Formen und Texturen hervorheben.

Je tiefer das Netzwerk wird, desto kleiner werden diese Merkmalskarten in ihrer räumlichen Größe. Diese Verkleinerung trägt dazu bei, dass das Modell effizient läuft und sich auf hochrangige Informationen konzentrieren kann. Allerdings verringern sich durch die Verkleinerung und Vertiefung der Merkmalskarten auch die räumlichen Details.

Während große Objekte genügend visuelle Informationen für eine genaue Erkennung enthalten, können kleine Ziele bereits nach wenigen Netzwerkschichten wichtige Details verlieren. In diesem Fall kann es für ein Modell schwierig sein, die Existenz eines kleinen Objekts überhaupt zu erkennen. Dies ist einer der Hauptgründe, warum kleine Objekte in Deep-Object-Detection-Modellen übersehen werden.

Feature Pyramid Networks, oft auch als FPN bezeichnet, wurden eingeführt, um den Verlust räumlicher Details zu beheben. Sie fungieren als unterstützendes Modul, das Informationen aus mehreren Ebenen kombiniert, damit Modelle detect Objekte effektiver detect können. Dieser Prozess wird auch als Feature-Aggregation und Feature-Fusion bezeichnet.

Flache Schichten liefern feine räumliche Details, während tiefere Schichten semantischen Kontext hinzufügen, was ein effektives mehrskaliges Feature-Lernen ermöglicht. Im Gegensatz zum naiven Upsampling, das lediglich Feature-Maps vergrößert, bewahrt FPN aussagekräftige Informationen und verbessert die Erkennung kleiner Objekte.

Moderne Ansätze bauen auf dieser Idee auf und verwenden adaptive Merkmalsfusion und kontextbezogene Designs, um die Erkennung kleiner Ziele weiter zu verbessern. Mit anderen Worten: FPN hilft Modellen dabei, sowohl das Gesamtbild als auch die winzigen Details gleichzeitig zu sehen. Diese Optimierung ist besonders wichtig, wenn Objekte klein sind.

Hier ein kurzer Überblick darüber, wie sich Modelle zur Objekterkennung im Laufe der Zeit weiterentwickelt und verbessert haben, um detect unterschiedlicher Größe, darunter auch sehr kleine, besser detect :

Nachdem wir nun besser verstehen, wie die Erkennung kleiner Objekte funktioniert, wollen wir uns einige praktische Anwendungsbeispiele ansehen, bei denen YOLO11 zum Einsatz kommen YOLO11 .

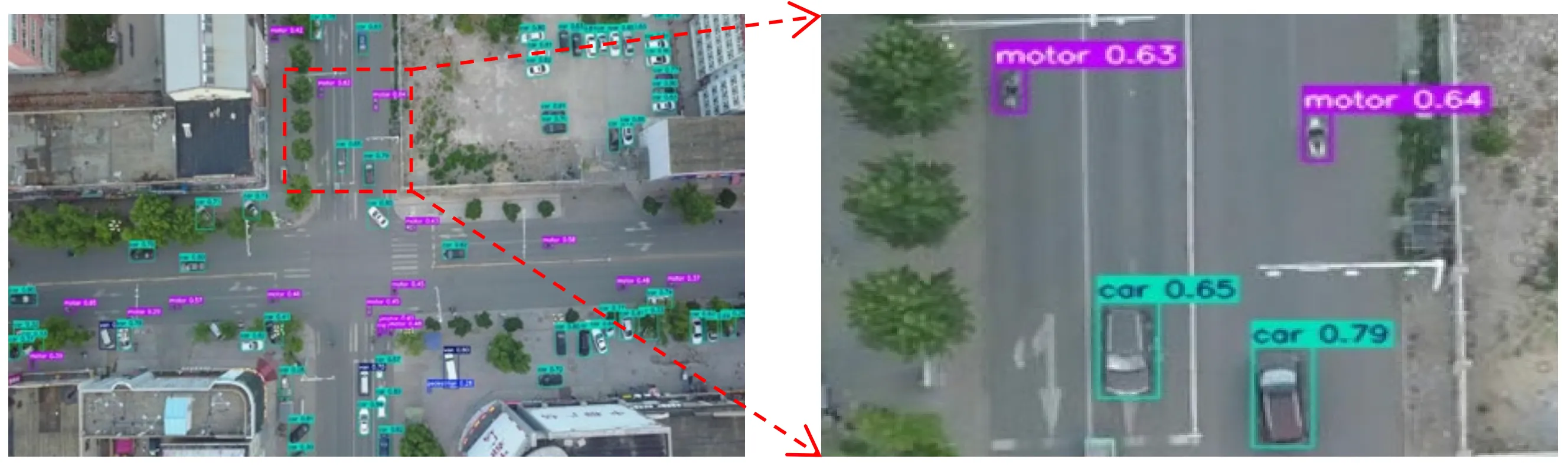

Stellen Sie sich eine Drohne vor, die hoch über einer belebten Stadtstraße fliegt. Aus dieser Höhe schrumpfen Autos, Fahrräder und sogar Menschen zu nur wenigen Pixeln auf einem Bildschirm.

UAV- und Luftbildmodule erfassen häufig Szenen wie diese, in denen die interessanten Objekte winzig sind und von unübersichtlichen Hintergründen umgeben sind, was ihre detect durch Computer-Vision-Modelle erschwert.

In solchen Szenarien YOLO11 die ideale Modellwahl sein. Beispielsweise YOLO11 eine mit einem Modell wie YOLO11 ausgestattete Drohne den Verkehr in Echtzeit überwachen und Fahrzeuge, Radfahrer und Fußgänger erkennen, während sie sich durch die Szene bewegen, selbst wenn jedes Objekt nur einen kleinen Teil des Bildes einnimmt. Dies ermöglicht eine schnellere Entscheidungsfindung und genauere Erkenntnisse in Anwendungen wie Verkehrsmanagement, öffentliche Sicherheit oder Stadtplanung.

Roboter werden häufig in Umgebungen eingesetzt, in denen Genauigkeit und Timing entscheidend sind. In Umgebungen wie Lagerhäusern, Fabriken und landwirtschaftlichen Betrieben muss ein Roboter möglicherweise sehr kleine Objekte erkennen, wie beispielsweise ein Teil auf einem Fließband, ein Etikett auf einer Verpackung oder eine kleine Pflanzenknospe auf einem Feld, und schnell reagieren.

Das Erkennen von Objekten dieser Größe kann kompliziert sein, insbesondere wenn sie im Kamerabild nur wenige Pixel groß sind oder teilweise von anderen Objekten verdeckt werden. Das Übersehen dieser kleinen Details kann die Automatisierung verlangsamen oder die Fähigkeit des Roboters beeinträchtigen, eine Aufgabe auszuführen.

YOLO11 in solchen Situationen einen Unterschied machen. Dank seiner verbesserten Merkmalsextraktion und schnellen Inferenz können Roboter detect Objekte in Echtzeit detect und sofort Maßnahmen ergreifen.

YOLO11 unterstützt YOLO11 die Instanzsegmentierung, die Robotern dabei helfen kann, Objektgrenzen und Greifpunkte genauer zu verstehen, anstatt nur allgemeine Begrenzungsrahmen zu lokalisieren. Ein mit YOLO11 integrierter Roboterarm YOLO11 beispielsweise kleine Komponenten auf einem Förderband erkennen, segment genaue Form segment und sie aufnehmen, bevor sie außer Reichweite geraten, wodurch das System effizient und zuverlässig bleibt.

Bei der Vielzahl der heute verfügbaren Computer-Vision-Modelle fragen Sie sich vielleicht, was Ultralytics YOLO11 macht.

Hier sind einige Gründe, warum Ultralytics YOLO11 eine hervorragende Option für AnwendungenYOLO11 , bei denen kleine Objekte erkannt werden müssen:

Neben der Verwendung eines Modells wie YOLO11 können auch die Art und Weise, wie Sie Ihre Annotationen vorbereiten, der gesamte Datensatz und das Modelltrainingsverfahren einen erheblichen Einfluss auf die Erkennungsleistung haben.

Hier ein kurzer Überblick darüber, worauf Sie sich konzentrieren sollten:

Die Erkennung kleiner Objekte ist schwierig, da kleine Ziele an Details verlieren, wenn Bilder durch ein Computer-Vision-Modell laufen. YOLO11 die Erhaltung dieser Details und macht die Erkennung kleiner Objekte zuverlässiger, ohne die Echtzeitleistung zu beeinträchtigen. YOLO11 dieser Ausgewogenheit YOLO11 eine genaue und effiziente Erkennung in realen Anwendungen.

Treten Sie unserer wachsenden Community bei! Erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren. Entdecken Sie Innovationen wie Computer Vision im Einzelhandel und KI in der Automobilindustrie, indem Sie unsere Lösungsseiten besuchen. Um noch heute mit Computer Vision zu entwickeln, sehen Sie sich unsere Lizenzoptionen an.