Die Auswirkungen des schnelleren, Edge-First-Designs Ultralytics

Sehen Sie selbst, wie Ultralytics am Rand schneller ist und warum dies für Computer-Vision-Anwendungen der nächsten Generation wichtig ist, die geringe Latenz und Effizienz erfordern.

Sehen Sie selbst, wie Ultralytics am Rand schneller ist und warum dies für Computer-Vision-Anwendungen der nächsten Generation wichtig ist, die geringe Latenz und Effizienz erfordern.

Anfang dieser Woche hat Ultralytics Ultralytics vorgestellt, ein schnelleres, schlankeres und kleineres YOLO , das die Leistungsfähigkeit von Computer-Vision-Systemen am Rand neu definieren soll. YOLO26 unterstützt dieselben Kernaufgaben der Bildverarbeitung wie frühere YOLO , darunter Objekterkennung und Instanzsegmentierung.

Der entscheidende Unterschied zwischen YOLO26 und früheren Modellen ist die Umgebung, für die es entwickelt wurde. Anstatt in erster Linie für Cloud-Grafikprozessoren (GPUs) oder benchmarkorientierte Leistung optimiert zu sein, wurde YOLO26 von Grund auf für den realen Einsatz auf Edge-Geräten und eingebetteter Hardware entwickelt.

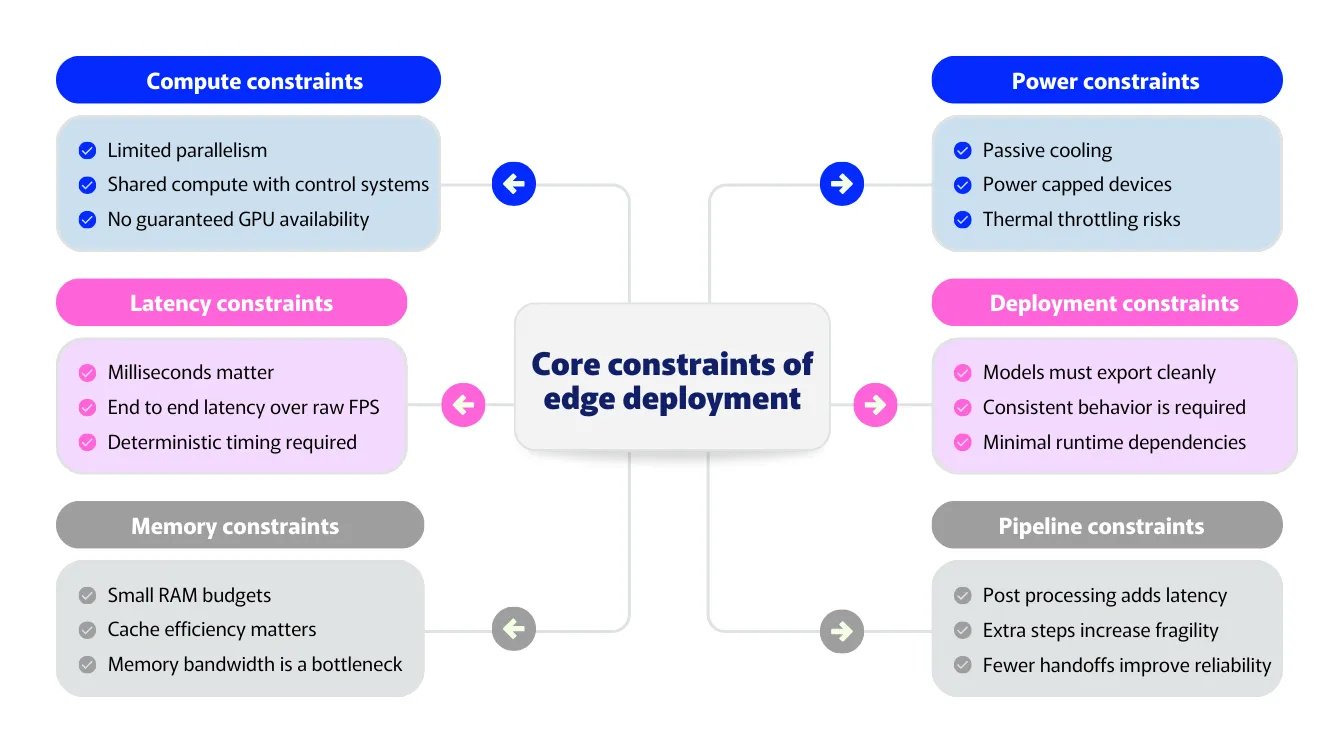

Mit dem Übergang der Computervision von der Forschung in die Produktion werden die tatsächlichen Leistungsbeschränkungen immer deutlicher. Edge-Umgebungen sind geprägt von engen Latenzbudgets, begrenzten Speicher-, Strom- und Wärmebeschränkungen sowie der Notwendigkeit eines vorhersehbaren Verhaltens auf verschiedenen Plattformen.

In diesen Umgebungen hängt die Gesamtleistung des Systems nicht nur von der reinen Inferenzgeschwindigkeit ab, sondern auch davon, wie effizient die gesamte Pipeline arbeitet. Nachbearbeitungsaufwand, Speicherbelastung und plattformspezifische Ausführungspfade sind häufig Engpässe.

YOLO26 begegnet diesen Herausforderungen mit einem schnelleren, Edge-First-Ansatz, der die gesamte Inferenz-Pipeline und nicht einzelne Modellmetriken betrachtet. Durch die Konzentration auf die Edge-Optimierung, die Vereinfachung der Inferenz-Pipeline und die Eliminierung unnötiger Nachbearbeitungsschritte erzielt YOLO26 Geschwindigkeitsverbesserungen, die zu einer geringeren Latenz und einem zuverlässigeren Verhalten in der Produktion führen.

In diesem Artikel untersuchen wir, wie sich die architektonischen Entscheidungen von YOLO26 in realen Leistungsverbesserungen niederschlagen und warum eine höhere Geschwindigkeit am Rand grundlegend die Möglichkeiten für Computer-Vision-Anwendungen der nächsten Generation verändert.

Die Ausführung von Computervisionsmodellen am Rand unterscheidet sich erheblich von der Ausführung in der Cloud. In Cloud-Umgebungen verfügen Systeme in der Regel über leistungsstarke GPUs, große Speicherkapazitäten und stabile Hardware. Am Rand gelten diese Voraussetzungen nicht.

Die meisten Edge-Bereitstellungen laufen auf unterschiedlichen Hardwarearchitekturen, nicht auf GPUs. Geräte verwenden in der Regel mehrere spezialisierte Prozessoren für verschiedene Aufgaben, die eher auf Effizienz und geringen Stromverbrauch als auf die reine Rechenleistung von Cloud-GPUs optimiert sind.

Die Latenz ist eine weitere große Einschränkung. Edge-Systeme arbeiten oft unter strengen Echtzeitbeschränkungen, bei denen selbst kleine Verzögerungen die Reaktionsfähigkeit oder Sicherheit beeinträchtigen können. In diesen Fällen ist die End-to-End-Latenz wichtiger als die reine Inferenzgeschwindigkeit. Ein Modell kann auf dem Papier schnell sein, aber dennoch zu kurz greifen, wenn Nachbearbeitung und Datenbewegung hinzukommen.

Auch der Speicher spielt eine große Rolle. Viele Edge-Geräte verfügen nur über begrenzten Speicher und gemeinsam genutzte Caches. Große Zwischenspeicher-Tensoren und eine ineffiziente Speichernutzung können Systeme verlangsamen, selbst wenn das Modell selbst effizient ist.

Leistungs- und thermische Grenzen bringen weitere Einschränkungen mit sich. Edge-Geräte laufen oft ohne aktive Kühlung und innerhalb festgelegter Leistungsbudgets. Die Leistung muss effizient und nachhaltig sein, nicht nur kurzzeitig schnell.

Darüber hinaus erfordern Edge-Implementierungen Konsistenz. Modelle müssen sich auf allen Geräten und in allen Laufzeiten gleich verhalten. Plattformspezifischer Code oder komplexe Nachbearbeitungsschritte können zu subtilen Unterschieden führen, die die Implementierung und Wartung von Systemen erschweren.

Diese Einschränkungen definieren, was Leistung am Rand wirklich bedeutet. Mit anderen Worten: Leistung wird durch die gesamte Pipeline definiert, nicht durch eine einzelne Kennzahl.

Wie hängen also die Einschränkungen der Edge-Bereitstellung mit den Anforderungen eines für den Edge entwickelten Computer-Vision-Modells zusammen? Der Zusammenhang wird deutlich, sobald Modelle aus der Forschungsumgebung in reale Systeme übertragen werden.

In Cloud-Umgebungen wird die Leistung häufig anhand von Benchmarks wie Inferenzgeschwindigkeit und Genauigkeit gemessen. Am Rand geben diese Kennzahlen jedoch nur einen Teil der Wahrheit wieder. Bildverarbeitungssysteme laufen in der Regel auf heterogener Hardware, wobei die neuronale Netzwerkinferenz auf spezielle Beschleuniger ausgelagert wird, während andere Teile der Pipeline auf Allzweckprozessoren ausgeführt werden.

In diesem Zusammenhang reicht die Modellgeschwindigkeit nicht aus. Entscheidend ist, wie das gesamte System nach der Bereitstellung des Modells funktioniert. Ein Modell kann für sich genommen schnell erscheinen, aber dennoch unzureichend sein, wenn Nachbearbeitung, Datenübertragung oder plattformspezifische Schritte zusätzlichen Aufwand verursachen.

Aus diesem Grund erfordert Edge-Vision ein Leistungsmodell, das sich auf die Effizienz auf Systemebene konzentriert und nicht auf isolierte Benchmarks. YOLO26 spiegelt diesen Wandel wider, indem es sich auf Edge-First-Optimierung, optimierte Inferenz und End-to-End-Ausführung konzentriert, die für den Einsatz in der Praxis entwickelt wurden.

Am Rand wird die Leistung dadurch bestimmt, wie gut ein Modell auf die tatsächliche Hardwarearchitektur des Geräts abgestimmt ist. Durch die Ausrichtung auf den Rand wird zunächst sichergestellt, dass Bildverarbeitungssysteme unabhängig von der spezifischen Kombination der verfügbaren Verarbeitungseinheiten zuverlässig auf realen Plattformen laufen.

Ein Edge-First-Ansatz priorisiert eine vorhersehbare und effiziente Ausführung auf heterogener Hardware, anstatt Modelle nachträglich an Cloud-GPUs anzupassen, für die sie optimiert wurden. Einfach ausgedrückt bedeutet dies, dass Operationen bevorzugt werden, die sich gut auf neuronale Netzwerkbeschleuniger übertragen lassen, nicht-neuronale Arbeiten außerhalb des Modells minimiert werden und unnötige Komplexität reduziert wird, die die End-to-End-Ausführung verlangsamen kann.

YOLO26 wurde unter Berücksichtigung dieser Einschränkungen entwickelt. Seine Architektur konzentriert sich auf konsistente Leistung statt auf Spitzen-Durchsatz unter idealen Bedingungen. Durch die Vereinfachung der Ausführungspfade und die Eliminierung unnötiger Berechnungen reduziert YOLO26 den Overhead in der gesamten Inferenz-Pipeline und nutzt die verfügbare Beschleunigung und Speicherhierarchie des Geräts besser aus.

Dieser Ansatz verbessert auch die Zuverlässigkeit. Die Edge-First-Optimierung führt zu einem besser vorhersehbaren Timing und weniger Leistungsspitzen, was für Echtzeitsysteme von entscheidender Bedeutung ist. Anstatt sich auf spezielle Hardware oder aufwendige Nachbearbeitung zu verlassen, um Geschwindigkeit zu erreichen, legt YOLO26 den Schwerpunkt auf Effizienz in der gesamten Inferenz-Pipeline.

Sie fragen sich vielleicht, was es bedeutet, unnötige Nachbearbeitungsschritte zu eliminieren. Um dies zu verstehen, lassen Sie uns einen Schritt zurücktreten und uns ansehen, wie herkömmliche Objekterkennungssysteme funktionieren.

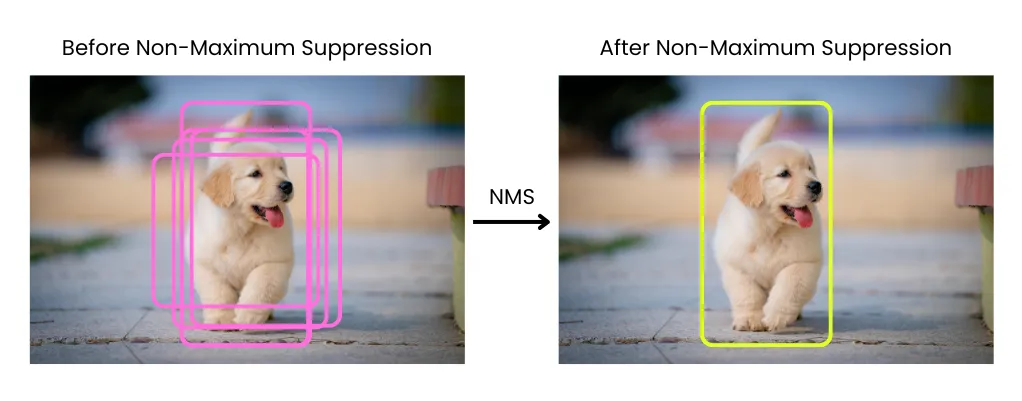

In vielen Objekterkennungs-Pipelines endet die Inferenz nicht, wenn das Modell seine Vorhersagen liefert. Stattdessen gibt das Modell eine große Anzahl überlappender Begrenzungsrahmen aus, die dann gefiltert und verfeinert werden müssen, bevor sie verwendet werden können. Diese Bereinigung erfolgt durch Nachbearbeitungsschritte, die außerhalb des Modells selbst ausgeführt werden.

Einer der häufigsten Nachbearbeitungsschritte ist die Nicht-Maximalunterdrückung ( NMS Suppression, NMS). NMS überlappende Begrenzungsrahmen und behält nur die sichersten Erkennungen bei, wobei Duplikate, die sich auf dasselbe Objekt beziehen, entfernt werden. Dieser Ansatz ist zwar effektiv, erfordert jedoch nach Abschluss der Inferenz zusätzliche Berechnungen.

Am Rande ist diese zusätzliche Arbeit mit Kosten verbunden. Nachbearbeitungsschritte wie NMS nicht gut für die speziellen Beschleuniger, die für die Inferenz neuronaler Netze verwendet werden, da diese eher für dichte neuronale Berechnungen als für steuerungsintensive oder speicherintensive Vorgänge optimiert sind.

Infolgedessen NMS zusätzliche Latenz und Speicher-Overhead, und seine Kosten steigen mit zunehmender Anzahl von Erkennungen. Selbst wenn das Modell selbst schnell ist, NMS dennoch einen erheblichen Teil der Gesamtlaufzeit in Anspruch nehmen.

Die Nachbearbeitung erhöht auch die Komplexität des Systems. Da sie außerhalb des Modells stattfindet, muss sie für verschiedene Laufzeiten und Hardwareziele separat implementiert werden. Dies führt häufig zu plattformspezifischen Codepfaden, inkonsistentem Verhalten auf verschiedenen Geräten und anfälligeren Bereitstellungspipelines.

Vor allem aber widerspricht die Nachbearbeitung dem Konzept einer echten End-to-End-Leistung. Die Messung der Modell-Inferenzgeschwindigkeit spiegelt nicht wider, wie sich das System in der Produktion verhält. Letztendlich zählt die Gesamtzeit von der Eingabe bis zur endgültigen Ausgabe, einschließlich aller Schritte in der Pipeline.

In diesen Situationen wird die Nachbearbeitung zu einem versteckten Engpass am Rand. Sie verursacht Latenz, verbraucht CPU und erschwert die Bereitstellung, während sie außerhalb des Modells selbst stattfindet.

YOLO26 beseitigt NMS, indem es die Ursache für doppelte Erkennungen bekämpft, anstatt diese nach der Inferenz zu bereinigen. Anstatt viele sich überschneidende Vorhersagen zu produzieren, die gefiltert werden müssen, wird das Modell so trainiert, dass es direkt eine kleinere Menge zuverlässiger, endgültiger Erkennungen generiert.

Dies wird durch eine Änderung der Art und Weise ermöglicht, wie Erkennungen während des Trainings gelernt werden. YOLO26 fördert eine klarere Eins-zu-Eins-Beziehung zwischen Objekten und Vorhersagen und reduziert so Redundanzen an ihrer Quelle. Dadurch werden doppelte Erkennungen innerhalb des Netzwerks selbst und nicht durch externe Nachbearbeitung aufgelöst.

Das Entfernen NMS unmittelbare Auswirkungen auf die Edge-Leistung. Da NMS gut auf neuronale Netzwerkbeschleuniger abgebildet werden NMS , reduziert dessen Eliminierung die Speicherbewegungen und vermeidet kostspielige nicht-neuronale Verarbeitungsschritte. Dies senkt die End-to-End-Latenz und macht die Leistung vorhersehbarer, insbesondere auf Edge-Geräten, wo die Nachbearbeitung ansonsten einen erheblichen Teil der Gesamtlaufzeit in Anspruch nehmen kann.

Außerdem vereinfacht es die Inferenz-Pipeline. Mit weniger Schritten außerhalb des Modells gibt es weniger Datenbewegungen und weniger Übergaben zwischen den Komponenten. Die Ausgabe des Modells ist bereits das Endergebnis, wodurch die Ausführung vorhersehbarer wird.

Eine weitere Neuerung in YOLO26 ist die Entfernung von Distribution Focal Loss (DFL), das in früheren YOLO für die Bounding-Box-Regression verwendet wurde. Anstatt eine einzelne Koordinate direkt vorherzusagen, lernten Modelle, die DFL verwendeten, eine Verteilung möglicher Werte und leiteten dann aus dieser Verteilung eine endgültige Bounding Box ab. Dieser Ansatz trug zur Verbesserung der Lokalisierungsgenauigkeit bei und war ein wichtiger Fortschritt gegenüber früheren Generationen.

Im Laufe der Zeit führte DFL jedoch auch Kompromisse ein. Die Vorhersage von Verteilungen erhöht den Rechenaufwand und macht die Modellarchitektur komplexer, was die Inferenz auf CPUs verlangsamen und den Export von Modellen in verschiedene Bereitstellungsformate erschweren kann. DFL schrieb außerdem feste Regressionsbereiche vor, was die Flexibilität bei der Erkennung sehr großer Objekte einschränken konnte.

YOLO26 entfernt DFL als Teil seiner Umstellung auf ein einfacheres End-to-End-Design. Die Bounding-Box-Regression wurde überarbeitet, um direkter zu sein, wodurch unnötige Berechnungen reduziert werden, während die Genauigkeit erhalten bleibt. Diese Änderung steht im Einklang mit dem NMS Ansatz von YOLO26.

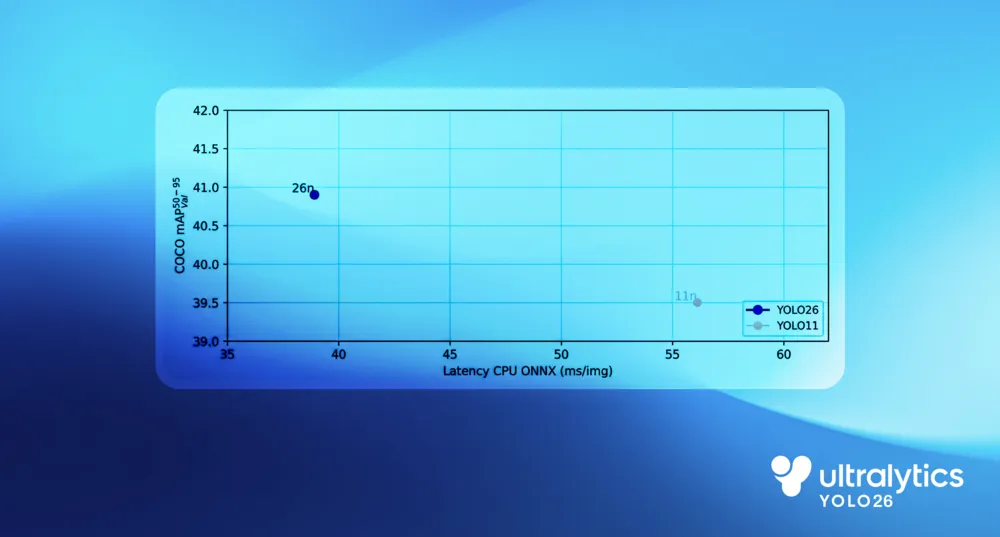

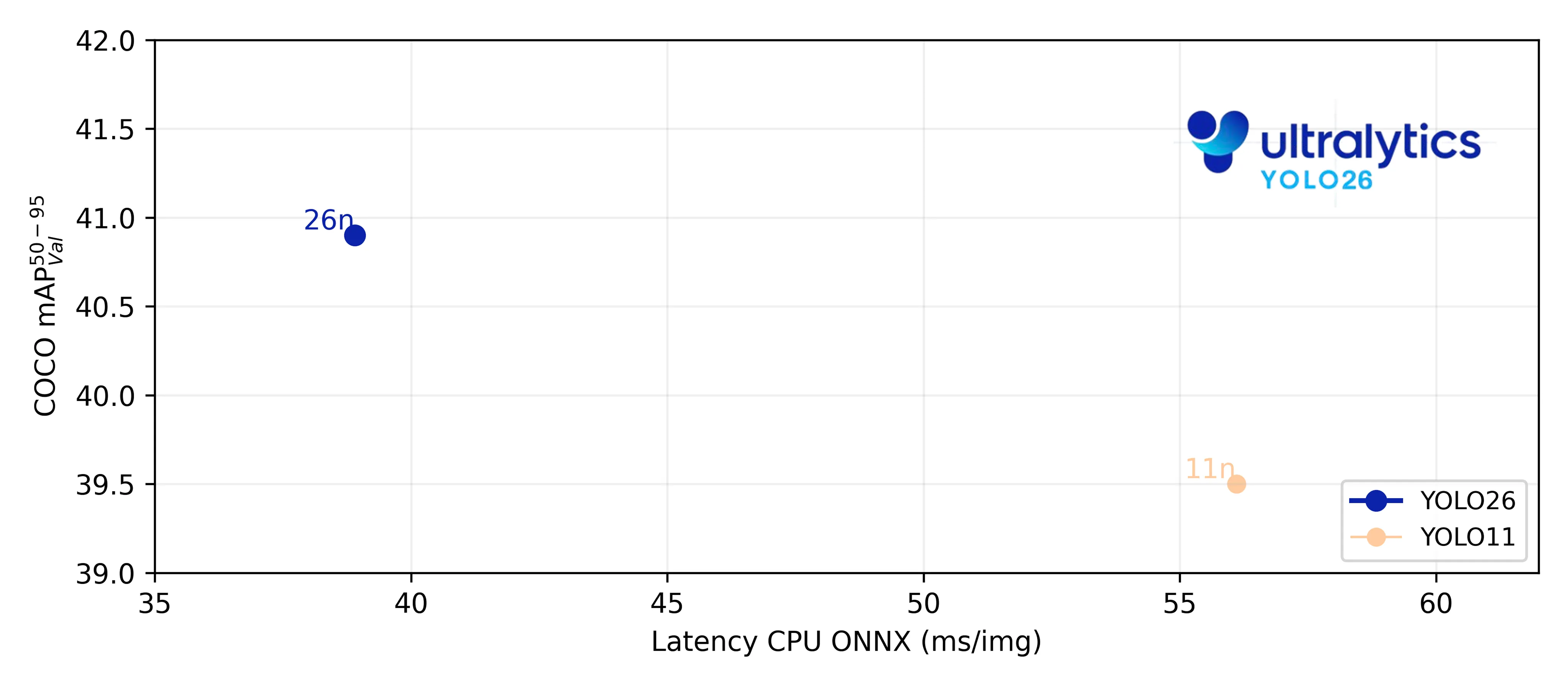

In CPU Benchmarks zeigt YOLO26 eine deutliche Leistungssteigerung gegenüber früheren YOLO . Im Vergleich zu Ultralytics YOLO11liefert das YOLO26-Nano-Modell CPU um bis zu 43 % schnellere CPU , ein Unterschied, der sich in realen Edge-Implementierungen deutlich bemerkbar macht.

Dieser Gewinn resultiert aus der Vereinfachung der gesamten Inferenz-Pipeline und nicht aus der Optimierung einer einzelnen Komponente. Die End-to-End-Ausführung beseitigt den Overhead der Nachbearbeitung, eine direktere Bounding-Box-Regressionsmethode reduziert den Rechenaufwand und CPU verbessern die Ausführungseffizienz auf Allzweckprozessoren.

Zusammen reduzieren diese Änderungen die Latenz, senken CPU und führen zu einer schnelleren, konsistenteren Leistung auf realer Edge-Hardware.

Die Leistungssteigerungen von YOLO26 gehen über eine schnellere Inferenz hinaus. Durch die Vereinfachung des Modells und die Reduzierung des Speicherbedarfs wird es einfacher zu implementieren und läuft zuverlässiger in Edge-Umgebungen.

Das End-to-End-Design von YOLO26 vereinfacht auch den Export. Mit weniger Zusatzkomponenten und ohne externe Nachbearbeitungsschritte sind exportierte Modelle vollständig in sich geschlossen. Dies reduziert plattformspezifische Abhängigkeiten und trägt dazu bei, ein konsistentes Verhalten über Laufzeiten und Hardware-Ziele hinweg sicherzustellen.

In der Praxis bedeutet dies, dass YOLO26 mithilfe verschiedener Exportformate einfacher auf Edge-Geräten wie Kameras, Robotern und eingebetteten Systemen eingesetzt werden kann. Was Sie exportieren, ist das, was Sie ausführen – mit weniger Integrationsschritten und einem geringeren Risiko von Abweichungen bei der Bereitstellung.

Bisher haben wir uns angesehen, wie das Edge-First-Design von YOLO26 die Leistung auf Systemebene verbessert. Die eigentliche Auswirkung liegt jedoch darin, dass sich Vision AI dadurch leichter in reale Anwendungen integrieren lässt.

Beispielsweise arbeiten Bildverarbeitungssysteme in der Robotik und in industriellen Umgebungen oft unter strengen Echtzeitanforderungen. Entscheidungen müssen schnell und konsistent getroffen werden, wobei nur begrenzte Rechenkapazitäten zur Verfügung stehen und keine Cloud-Verbindung genutzt werden kann. Mit Ultralytics lassen sich diese Anforderungen nun praktisch umsetzen.

Anwendungen wie Roboternavigation und Objektmanipulation profitieren von geringerer Latenz und besser vorhersagbaren Schlussfolgerungen, sodass Roboter reibungslos auf Veränderungen in ihrer Umgebung reagieren können. In ähnlicher Weise können Bildverarbeitungsmodelle in industriellen Umgebungen direkt in Produktionslinien eingesetzt werden, um detect , track und Prozesse zu überwachen, ohne dass es zu Verzögerungen oder zusätzlicher Komplexität kommt.

Durch die schnelle und zuverlässige Inferenz auf Edge-Hardware trägt YOLO26 dazu bei, dass Vision AI zu einem selbstverständlichen Bestandteil von Robotik und industriellen Systemen wird und nicht länger eine Herausforderung hinsichtlich Implementierung und Wartung darstellt.

YOLO26 wurde für den Einsatz am Rand entwickelt, wo reale Einschränkungen wie Latenz, Speicher und Zuverlässigkeit die Möglichkeiten bestimmen. Durch die Auslegung des Modells auf CPU, End-to-End-Inferenz und einfachere Bereitstellung macht YOLO26 die Integration von Vision-KI in reale Systeme praktikabel. Dieser Edge-first-Ansatz ermöglicht eine Vielzahl von Anwendungen, von Robotik und industrieller Bildverarbeitung bis hin zu eingebetteter und gerätebasierter KI, bei denen Leistung und Vorhersagbarkeit am wichtigsten sind.

Schließen Sie sich unserer wachsenden Community an und erkunden Sie unser GitHub-Repository für praktische KI-Ressourcen. Wenn Sie noch heute mit Vision AI arbeiten möchten, erkunden Sie unsere Lizenzierungsoptionen. Erfahren Sie auf unseren Lösungsseiten, wie KI in der Landwirtschaft die Landwirtschaft verändert und wie Vision AI im Gesundheitswesen die Zukunft prägt.