Aplicações do modelo 2 de qualquer segmento da Meta AISAM 2)

Junte-se a nós enquanto mergulhamos no Segment Anything Model 2SAM 2) da Meta AI e compreendemos para que aplicações em tempo real pode ser utilizado em várias indústrias.

Junte-se a nós enquanto mergulhamos no Segment Anything Model 2SAM 2) da Meta AI e compreendemos para que aplicações em tempo real pode ser utilizado em várias indústrias.

Em 29 de julho de 2024, a Meta AI lançou a segunda versão do seu modelo Segment Anything Model, SAM 2. O novo modelo consegue identificar quais os pixels que pertencem a um objeto alvo, tanto em imagens como em vídeos! A melhor parte é que o modelo é capaz de seguir consistentemente um objeto em todos os fotogramas de um vídeo em tempo real. SAM 2 abre possibilidades interessantes para a edição de vídeo, experiências de realidade mista e anotação mais rápida de dados visuais para treinar sistemas de visão por computador.

Com base no sucesso do SAM original, que tem sido utilizado em áreas como a ciência marinha, imagens de satélite e medicina, SAM 2 enfrenta desafios como objectos em movimento rápido e alterações na aparência. A sua precisão e eficiência melhoradas tornam-no uma ferramenta versátil para uma vasta gama de aplicações. Neste artigo, centrar-nos-emos nas áreas em que SAM 2 pode ser aplicado e na sua importância para a comunidade de IA.

O Segment Anything Model 2 é um modelo de base avançado que suporta a segmentação visual promptable ou PVS em imagens e vídeos. O PVS é uma técnica em que um modelo pode segment ou identificar diferentes partes de uma imagem ou de um vídeo com base em instruções ou entradas específicas dadas pelo utilizador. Estes avisos podem assumir a forma de cliques, caixas ou máscaras que realçam a área de interesse. O modelo gera então uma máscara de segmentação que delineia a área especificada.

A arquitetura SAM 2 baseia-se no SAM original, expandindo a segmentação de imagem para incluir também a segmentação de vídeo. Inclui um descodificador de máscaras leve que utiliza dados de imagem e avisos para criar máscaras de segmentação. Para vídeos, SAM 2 introduz um sistema de memória que o ajuda a recordar informações de fotogramas anteriores, garantindo um seguimento preciso ao longo do tempo. O sistema de memória inclui componentes que armazenam e recuperam detalhes sobre os objectos que estão a ser segmentados. SAM 2 também pode lidar com oclusões, track objectos através de vários fotogramas e gerir avisos ambíguos gerando várias máscaras possíveis. A arquitetura avançada do SAM 2 torna-o altamente capaz em ambientes visuais estáticos e dinâmicos.

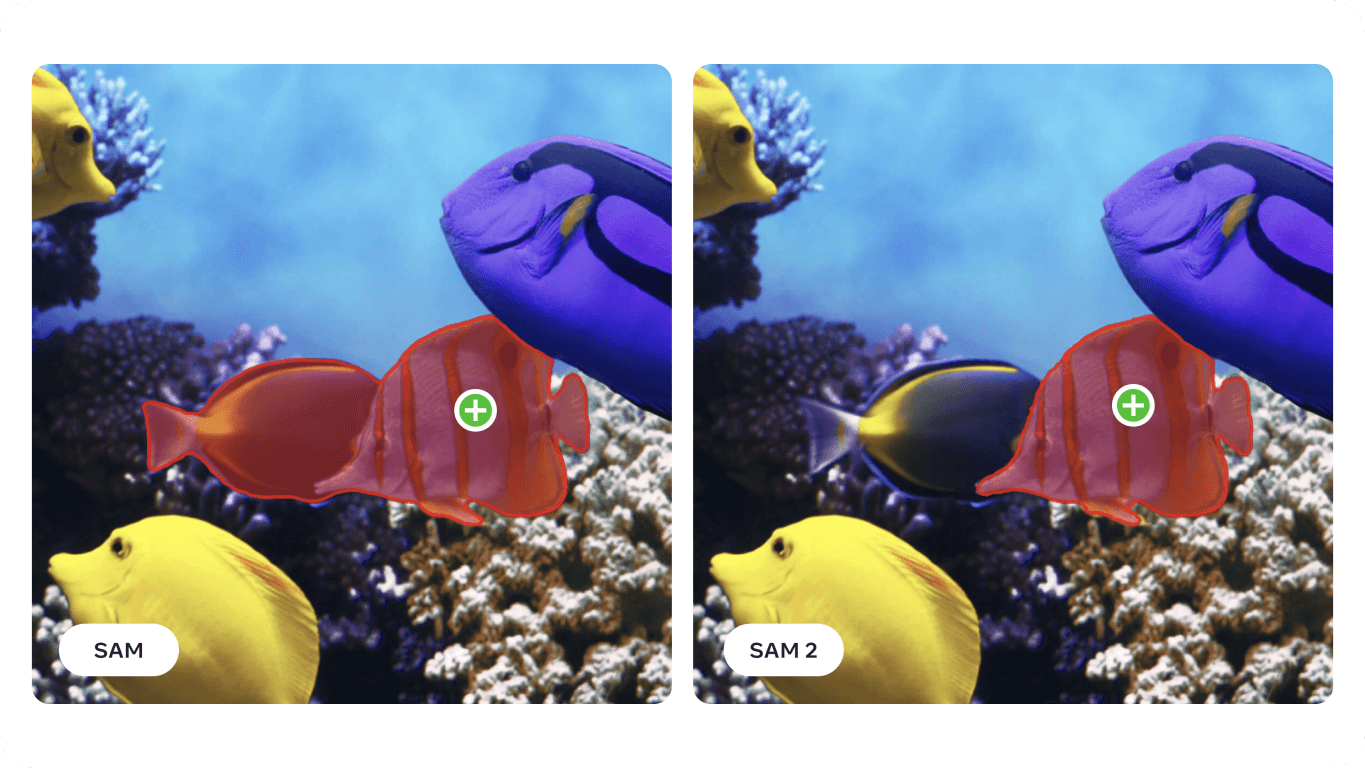

Especificamente, no que diz respeito à segmentação de vídeo, SAM 2 atinge uma maior precisão com três vezes menos interações do utilizador em comparação com os métodos anteriores. Para a segmentação de imagens, SAM 2 supera o Segment Anything Model (SAM) original, sendo seis vezes mais rápido e mais exato. Esta melhoria foi apresentada no artigo de investigação SAM 2 em 37 conjuntos de dados diferentes, incluindo 23 em que SAM foi previamente testado.

Curiosamente, o SAM 2 da Meta AI foi desenvolvido através da criação do maior conjunto de dados de segmentação de vídeo até à data, o conjunto de dados SA-V. O extenso conjunto de dados inclui mais de 50.000 vídeos e 35,5 milhões de máscaras de segmentação e foi recolhido através de contribuições interactivas dos utilizadores. Os anotadores forneceram avisos e correcções para ajudar o modelo a aprender com uma grande variedade de cenários e tipos de objectos.

Graças às suas capacidades avançadas de segmentação de imagem e vídeo, SAM 2 pode ser utilizado em vários sectores. Vamos explorar algumas destas aplicações.

O novo modelo de segmentação da Meta AI pode ser utilizado para aplicações de Realidade Aumentada (RA) e Realidade Virtual (RV). Por exemplo, SAM 2 pode identificar e segment com precisão objectos do mundo real e tornar a interação com objectos virtuais mais realista. Pode ser útil em vários domínios, como os jogos, a educação e a formação, em que é essencial uma interação realista entre elementos virtuais e reais.

Com dispositivos como os óculos AR a tornarem-se mais avançados, as capacidades do SAM 2 poderão em breve ser integradas neles. Imagine que coloca os óculos e olha para a sua sala de estar. Quando os óculos segment e reparam na tigela de água do seu cão, podem lembrá-lo de a encher, como mostra a imagem abaixo. Ou, se estiver a cozinhar uma nova receita, os óculos podem identificar os ingredientes na sua bancada e fornecer instruções e dicas passo a passo, melhorando a sua experiência culinária e garantindo que tem todos os itens necessários à mão.

A investigação que utiliza o modelo SAM demonstrou que este pode ser aplicado em domínios especializados, como a imagiologia por sonar. As imagens de sonar apresentam desafios únicos devido à sua baixa resolução, aos elevados níveis de ruído e às formas complexas dos objectos nas imagens. Ao ajustar o SAM para imagens de sonar, os investigadores demonstraram a sua capacidade de segment com precisão vários objectos subaquáticos, como detritos marinhos, formações geológicas e outros itens de interesse. Imagens subaquáticas precisas e fiáveis podem ser utilizadas na investigação marinha, arqueologia subaquática, gestão de pescas e vigilância para tarefas como o mapeamento de habitats, descoberta de artefactos e deteção de ameaças.

%25252525201.png)

Uma vez que SAM 2 se baseia e melhora muitos dos desafios SAM enfrenta, tem o potencial de melhorar ainda mais a análise das imagens de sonar. As suas capacidades de segmentação precisas podem ajudar em várias aplicações marinhas, incluindo investigação científica e pescas. Por exemplo, SAM 2 pode delinear eficazmente estruturas subaquáticas, detect detritos marinhos e identificar objectos em imagens de sonar orientadas para o futuro, contribuindo para uma exploração e monitorização subaquáticas mais precisas e eficientes.

Eis os potenciais benefícios da utilização do SAM 2 para analisar imagens de sonar:

Ao integrar o SAM 2 nos processos de imagiologia por sonar, a indústria marinha pode alcançar uma maior eficiência, precisão e fiabilidade na exploração e análise subaquáticas, conduzindo, em última análise, a melhores resultados na investigação marinha.

Outra aplicação do SAM 2 é em veículos autónomos. SAM 2 pode identificar com precisão objectos como peões, outros veículos, sinais de trânsito e obstáculos em tempo real. O nível de pormenor que SAM 2 pode fornecer é essencial para tomar decisões seguras de navegação e prevenção de colisões. Ao processar dados visuais com precisão, SAM 2 ajuda a criar um mapa detalhado e fiável do ambiente e conduz a uma melhor tomada de decisões.

A capacidade do SAM 2 para funcionar bem em diferentes condições de iluminação, alterações climáticas e ambientes dinâmicos torna-o fiável para veículos autónomos. Quer se trate de uma rua urbana movimentada ou de uma autoestrada com nevoeiro, SAM 2 consegue identificar e segment objectos de forma consistente e precisa, para que o veículo possa responder corretamente a várias situações.

No entanto, existem algumas limitações a ter em conta. Para objectos complexos e em movimento rápido, SAM 2 pode por vezes falhar detalhes finos e as suas previsões podem tornar-se instáveis ao longo dos fotogramas. Além disso, SAM 2 pode por vezes confundir vários objectos de aspeto semelhante em cenas com muita gente. Estes desafios são a razão pela qual a integração de sensores e tecnologias adicionais é fundamental nas aplicações de condução autónoma.

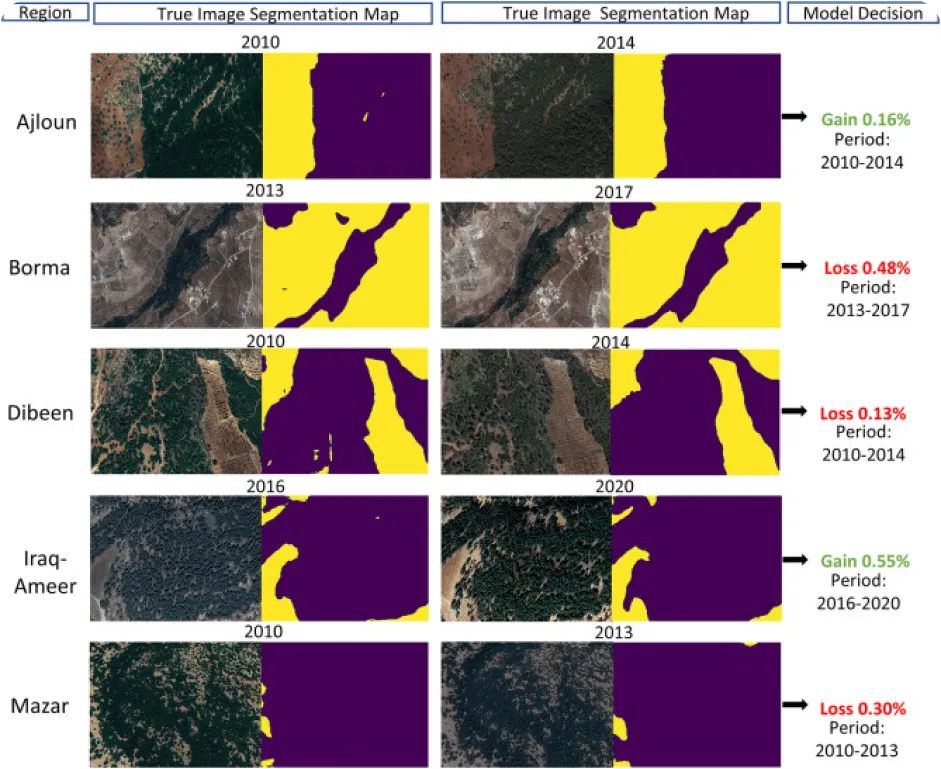

A monitorização ambiental utilizando a visão por computador pode ser complicada, especialmente quando há falta de dados anotados, mas é também isso que a torna uma aplicação interessante para o SAM 2. SAM 2 pode ser utilizado para track e analisar alterações em paisagens naturais, segmentando e identificando com precisão várias caraterísticas ambientais, como florestas, massas de água, áreas urbanas e terrenos agrícolas, a partir de imagens de satélite ou de drones. Especificamente, a segmentação precisa ajuda a monitorizar a desflorestação, a urbanização e as alterações na utilização dos solos ao longo do tempo, fornecendo dados valiosos para a conservação e o planeamento ambiental.

Eis algumas das vantagens de utilizar um modelo como o SAM 2 para analisar as alterações ambientais ao longo do tempo:

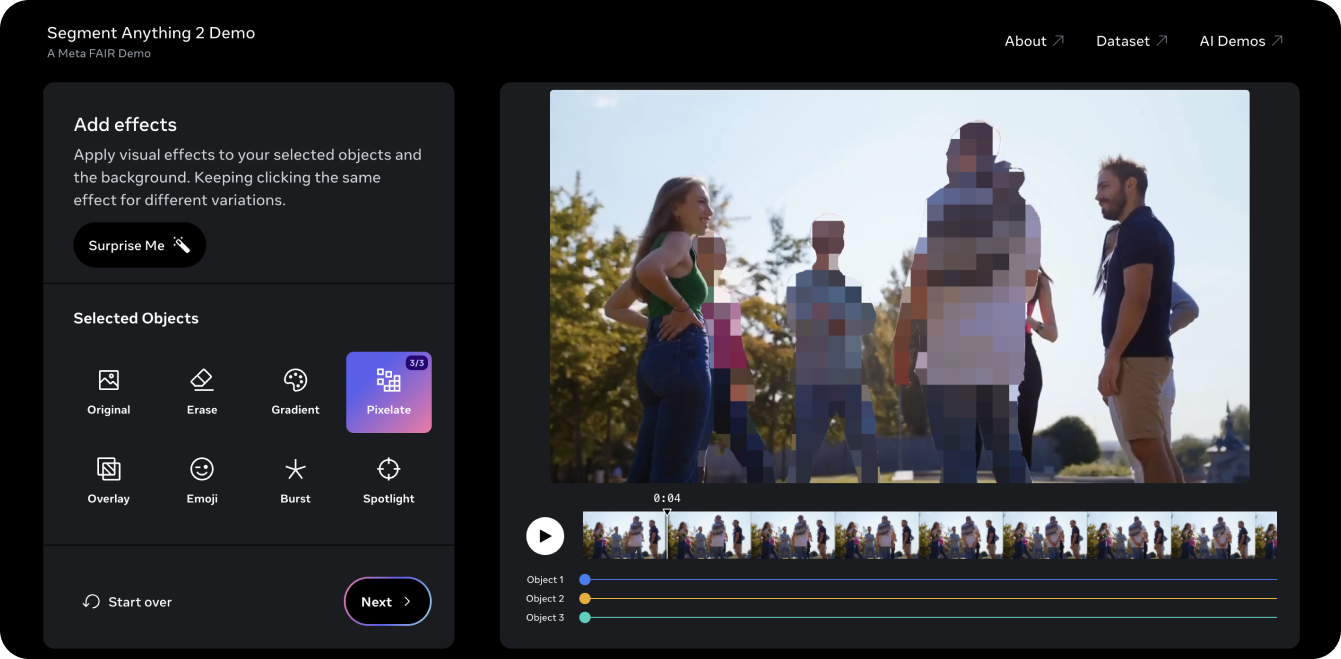

A demonstração do Segment Anything 2 é uma excelente forma de experimentar o modelo num vídeo. Utilizando as capacidades de PVS do SAM 2, pegámos num vídeo antigo do YouTubeUltralytics e conseguimos segment três objectos ou pessoas no vídeo e pixelizá-los. Tradicionalmente, editar três indivíduos de um vídeo como esse seria demorado e tedioso e exigiria o mascaramento manual quadro a quadro. No entanto, SAM 2 simplifica este processo. Com alguns cliques na demonstração, pode proteger a identidade de três objectos de interesse numa questão de segundos.

A demonstração também lhe permite experimentar alguns efeitos visuais diferentes, como colocar um foco de luz nos objectos selecionados para seguimento e apagar os objectos que estão a ser seguidos. Se gostou da demonstração e está pronto para começar a inovar com o SAM 2, consulte a página de documentos do modeloUltralytics SAM 2 para obter instruções detalhadas sobre como utilizar o modelo. Explore as funcionalidades, os passos de instalação e os exemplos para tirar o máximo partido do potencial do SAM 2 nos seus projectos!

O Segment Anything Model 2SAM 2) da Meta AI está a transformar a segmentação de vídeo e imagem. À medida que tarefas como a localização de objectos melhoram, estamos a descobrir novas oportunidades na edição de vídeo, realidade mista, investigação científica e imagiologia médica. Ao facilitar tarefas complexas e acelerar as anotações, SAM 2 está preparado para se tornar uma ferramenta importante para a comunidade de IA. À medida que continuamos a explorar e a inovar com modelos como o SAM 2, podemos antecipar ainda mais aplicações inovadoras e avanços em vários domínios!

Saiba mais sobre IA explorando nosso repositório GitHub e juntando-se à nossa comunidade. Confira nossas páginas de soluções para obter informações detalhadas sobre IA em manufatura e saúde. 🚀