Veja como o aprendizado ensemble aumenta o desempenho do modelo de IA por meio de técnicas como bagging, boosting e stacking para fornecer previsões mais precisas e estáveis.

Veja como o aprendizado ensemble aumenta o desempenho do modelo de IA por meio de técnicas como bagging, boosting e stacking para fornecer previsões mais precisas e estáveis.

Para uma explicação visual dos conceitos abordados neste artigo, assista ao vídeo abaixo.

Inovações de IA, como mecanismos de recomendação e sistemas de detecção de fraudes, dependem de algoritmos e modelos de aprendizado de máquina para fazer previsões e tomar decisões com base em dados. Esses modelos podem identificar padrões, prever tendências e ajudar a automatizar tarefas complexas.

No entanto, um único modelo pode ter dificuldades para capturar todos os detalhes em dados do mundo real. Ele pode ter um bom desempenho em alguns casos, mas falhar em outros, como um modelo de detecção de fraudes que perde novos tipos de transações.

Essa limitação é algo que os engenheiros de IA frequentemente enfrentam ao construir e implantar modelos de aprendizado de máquina. Alguns modelos sofrem overfitting ao aprender os dados de treinamento muito de perto, enquanto outros sofrem underfitting ao perder padrões importantes. O aprendizado ensemble é uma técnica de IA que ajuda a enfrentar esses desafios combinando vários modelos, conhecidos como aprendizes de base, em um único sistema mais poderoso.

Você pode pensar nisso como uma equipe de especialistas trabalhando juntos para resolver um problema. Neste artigo, exploraremos o que é ensemble learning, como funciona e onde pode ser usado. Vamos começar!

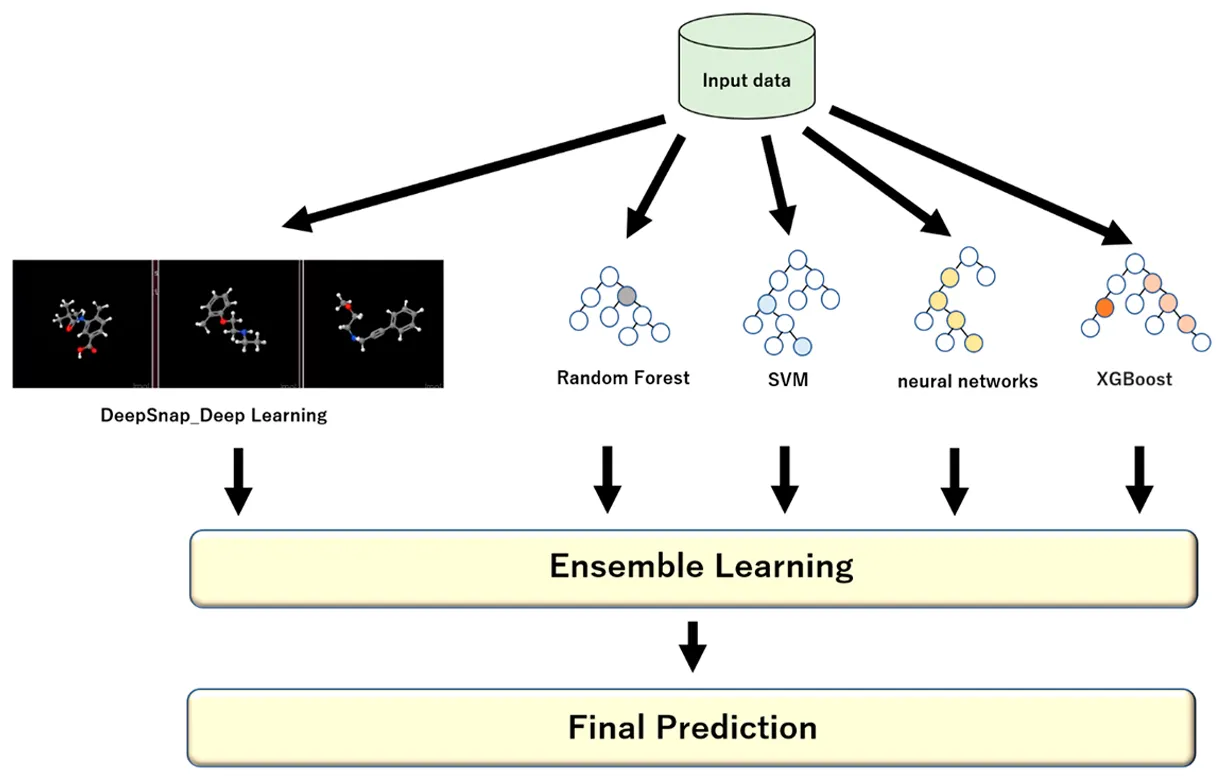

O aprendizado Ensemble refere-se a um conjunto de técnicas que combinam múltiplos modelos para resolver o mesmo problema e produzir um único resultado aprimorado. Ele pode ser aplicado tanto no aprendizado supervisionado (onde os modelos aprendem a partir de dados rotulados) quanto no aprendizado não supervisionado (onde os modelos encontram padrões em dados não rotulados).

Em vez de depender de um modelo para fazer previsões, um ensemble usa vários modelos que analisam os dados cada um à sua maneira. Quando suas saídas são combinadas, o resultado é frequentemente mais preciso, estável e generalizável do que qualquer modelo individual poderia alcançar sozinho.

Você pode compará-lo a um painel de analistas abordando o mesmo problema. Cada analista ou modelo individual interpreta os dados de forma diferente.

Um pode concentrar-se em padrões, outro em anomalias e outro em contexto. Ao juntar as suas perspetivas, o grupo pode tomar uma decisão que é mais equilibrada e fiável do que qualquer julgamento individual.

Essa abordagem também ajuda a resolver dois dos maiores desafios no aprendizado de máquina: viés e variância. Um modelo com alto viés é muito simples e ignora padrões importantes, enquanto um com alta variância é excessivamente sensível e se ajusta muito aos dados de treinamento. Ao combinar modelos, o aprendizado de conjunto encontra um equilíbrio entre os dois, melhorando o desempenho do sistema em dados novos e não vistos.

Cada modelo em um ensemble é conhecido como um aprendedor base ou modelo base. Estes podem ser o mesmo tipo de algoritmo ou uma mistura de algoritmos diferentes, dependendo da técnica de ensemble que está sendo usada.

Aqui estão alguns exemplos comuns dos diferentes modelos usados no aprendizado de ensemble:

Um ensemble de modelos combinado é geralmente chamado de aprendizado forte porque integra os pontos fortes dos aprendizados de base (também referidos como modelos fracos), minimizando suas fraquezas. Ele faz isso combinando as previsões de cada modelo de forma estruturada, usando votação majoritária para tarefas de classificação ou média ponderada para tarefas de regressão para produzir um resultado final mais preciso.

Antes de nos aprofundarmos em várias técnicas de ensemble learning, vamos dar um passo atrás e entender quando esse tipo de abordagem deve ser usado em um projeto de machine learning ou IA.

O aprendizado Ensemble é mais impactante quando um único modelo tem dificuldades para fazer previsões precisas ou consistentes. Ele também pode ser usado em situações onde os dados são complexos, ruidosos ou imprevisíveis.

Aqui estão alguns casos comuns em que os métodos de ensemble são particularmente eficazes:

Também é mais simples de treinar, mais fácil de interpretar e mais rápido de manter. Antes de usar um ensemble, é importante ponderar o benefício de maior precisão em relação ao tempo adicional, poder de computação e complexidade que ele exige.

Em seguida, vamos analisar as principais formas pelas quais o aprendizado por conjunto pode ser aplicado em projetos de aprendizado de máquina. Existem várias técnicas básicas usadas para combinar modelos, cada uma melhorando o desempenho à sua maneira. Os métodos de conjunto mais comuns são bagging, boosting, stacking e blending.

Bagging, abreviação de bootstrap aggregating, é um método de aprendizado de conjunto que ajuda a melhorar a estabilidade e a precisão do modelo, treinando várias versões do mesmo modelo em diferentes partes dos dados.

Cada subconjunto é criado usando um processo chamado amostragem bootstrap, onde os pontos de dados são selecionados aleatoriamente com reposição. Isso significa que, após a escolha de um ponto de dados, ele é colocado de volta no conjunto antes que o próximo seja escolhido, de modo que o mesmo ponto pode aparecer mais de uma vez, enquanto outros podem ser deixados de fora. Essa aleatoriedade garante que cada modelo seja treinado em uma versão ligeiramente diferente do conjunto de dados.

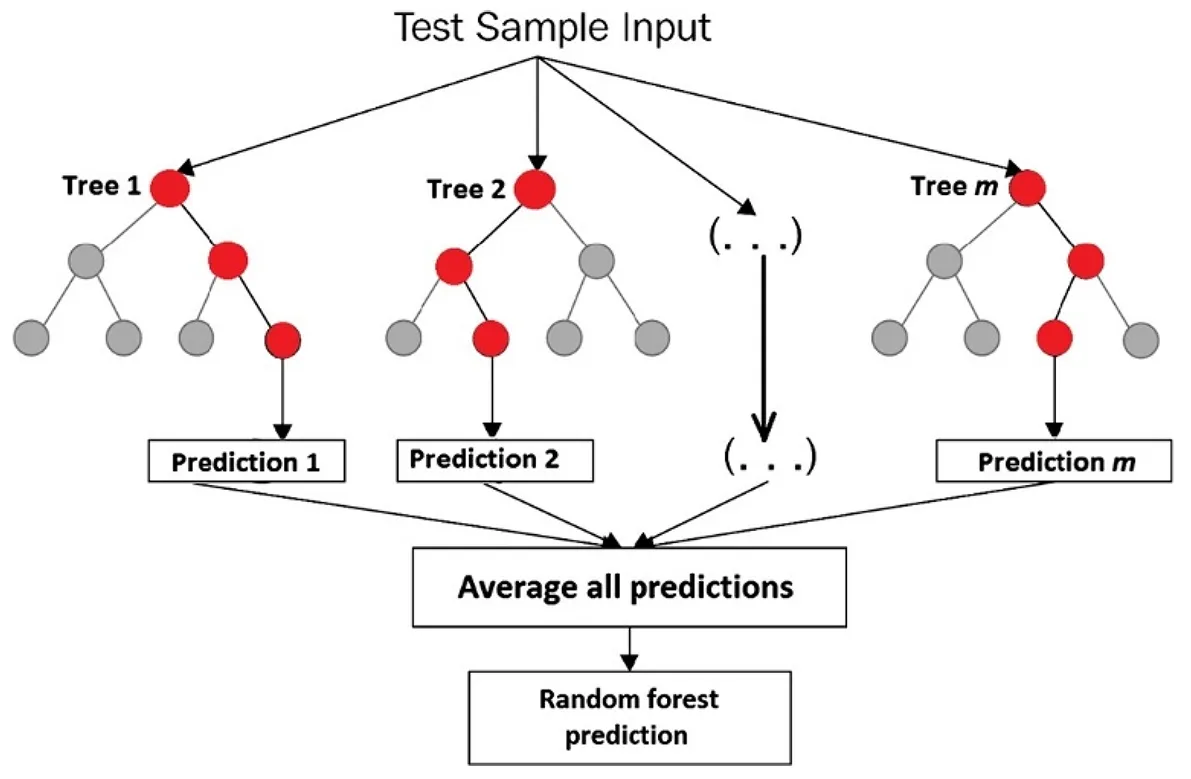

Durante a inferência, todos os modelos treinados são executados em paralelo para fazer previsões sobre dados novos e não vistos. Cada modelo produz sua própria saída com base no que aprendeu, e essas previsões individuais são então combinadas para formar o resultado final.

Para tarefas de regressão, como prever preços de casas ou previsões de vendas, isso geralmente significa calcular a média das saídas de todos os modelos para obter uma estimativa mais suave. Para tarefas de classificação, como identificar se uma transação é fraudulenta ou não, o ensemble geralmente faz uma votação majoritária para decidir a classe final.

Um bom exemplo de onde o bagging funciona bem é com árvores de decisão, que podem facilmente sofrer overfitting quando treinadas em um único conjunto de dados. Ao treinar muitas árvores em amostras ligeiramente diferentes e combinar seus resultados, o bagging reduz o overfitting e melhora a confiabilidade.

Considere o algoritmo Random Forest. É um conjunto de árvores de decisão, onde cada árvore é treinada em um subconjunto aleatório do conjunto de dados de treinamento, bem como em um subconjunto aleatório de recursos.

Esta aleatoriedade das caraterísticas ajuda a garantir que as árvores estão menos correlacionadas e que o modelo global é mais estável e exato. Um algoritmo Random Forest pode ser utilizado para classify imagens, detect fraudes, prever a rotatividade de clientes, prever vendas ou estimar preços de imóveis.

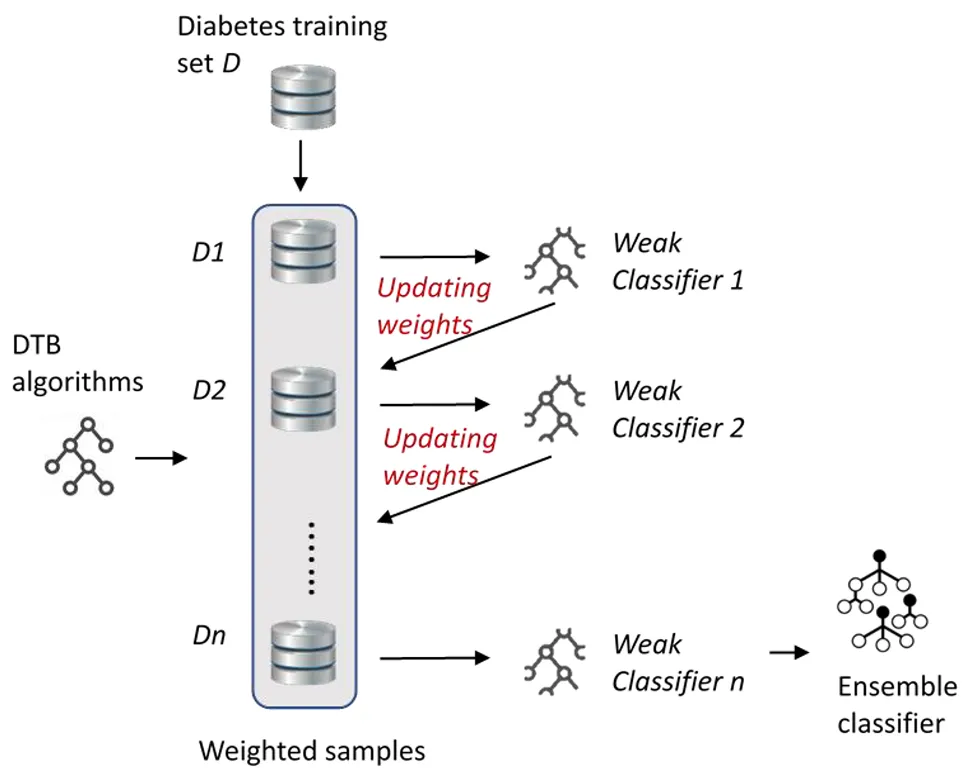

Boosting é outra técnica de aprendizado ensemble que se concentra em aprimorar aprendizes fracos (modelos) treinando-os sequencialmente, um após o outro, em vez de em paralelo. O conceito central do boosting é que cada novo modelo aprende com os erros dos anteriores, melhorando gradualmente o desempenho geral do modelo.

Ao contrário do bagging, que reduz a variância ao fazer a média de modelos independentes, o boosting reduz o viés, fazendo com que cada novo modelo preste mais atenção aos casos difíceis com os quais os modelos anteriores tiveram dificuldades.

Como os modelos de boosting são treinados sequencialmente, a forma como suas previsões são combinadas no final difere ligeiramente de outros métodos de ensemble. Cada modelo contribui para a previsão final em proporção ao seu desempenho durante o treinamento, com modelos mais precisos recebendo maior peso.

Para tarefas de regressão, o resultado final é geralmente uma soma ponderada de todas as previsões do modelo. Para tarefas de classificação, o algoritmo combina os votos ponderados dos modelos para decidir a classe final. Essa abordagem ajuda o boosting a criar um modelo geral forte, dando mais peso aos modelos que são mais precisos, enquanto ainda aprende com os outros.

Aqui estão alguns tipos comuns de algoritmos de boosting:

O empilhamento, também chamado de generalização empilhada, leva as coisas um passo adiante, usando as previsões de vários modelos como entrada para um modelo final conhecido como meta-aprendiz. Pode pensar nisso como ter um grupo de especialistas que partilham a sua opinião e, em seguida, um decisor final aprende a ponderar essas opiniões para tomar a melhor decisão possível.

Por exemplo, um modelo pode ser ótimo para identificar fraudes, enquanto outro é melhor para prever a rotatividade de clientes. O meta-aprendiz estuda o desempenho de cada um e usa seus pontos fortes em conjunto para fazer uma previsão final mais precisa.

O blending funciona de forma semelhante ao stacking, pois também combina as previsões de vários modelos para tomar uma decisão final, mas adota uma abordagem mais simples e rápida. Em vez de usar a validação cruzada (um método que divide os dados em várias partes e as alterna entre treinamento e teste para tornar o modelo mais confiável), como o stacking faz, o blending reserva uma pequena porção dos dados, chamada de conjunto de retenção.

Os modelos base são treinados com os dados restantes e, em seguida, fazem previsões no conjunto de retenção, que não viram antes. Isso produz duas informações importantes: as respostas reais, ou rótulos verdadeiros, e as previsões feitas por cada modelo base.

Essas previsões são então passadas para outro modelo chamado modelo de blending ou meta modelo. Este modelo final estuda a precisão das previsões de cada modelo base e aprende a combiná-las da melhor maneira possível.

Como o blending depende de apenas uma divisão de treino e teste em vez de repetir o processo várias vezes, ele é executado mais rapidamente e é mais fácil de configurar. A desvantagem é que ele tem um pouco menos de informação para aprender, o que pode torná-lo um pouco menos preciso.

Uma parte importante do aprendizado por conjunto é avaliar o desempenho de um modelo em dados que ele nunca viu antes. Não importa quão avançada seja uma técnica, ela deve ser testada para garantir que possa generalizar, o que significa que deve fazer previsões precisas em exemplos novos e do mundo real, em vez de apenas memorizar os dados de treinamento.

Aqui estão algumas métricas de desempenho comuns usadas para avaliar modelos de IA:

Até agora, exploramos como funciona a aprendizagem por conjunto e as técnicas por trás dela. Agora, vamos ver onde esta abordagem está a ter impacto.

Aqui estão algumas áreas-chave onde o aprendizado ensemble é comumente aplicado:

Embora o aprendizado por conjunto seja mais comumente usado com dados estruturados ou tabulares, como planilhas contendo informações numéricas ou categóricas, ele também pode ser aplicado a dados não estruturados, como texto, imagens, áudio e vídeo.

Esses tipos de dados são mais complexos e difíceis de interpretar para os modelos, mas os métodos de ensemble ajudam a melhorar a precisão e a confiabilidade. Por exemplo, em visão computacional, os ensembles podem aprimorar tarefas como classificação de imagens e detecção de objetos.

Ao combinar as previsões de vários modelos de visão, como redes neurais convolucionais (CNNs), o sistema pode reconhecer objetos com mais precisão e lidar com variações de iluminação, ângulo ou fundo que podem confundir um único modelo.

Um exemplo interessante do uso de aprendizado por conjunto em visão computacional é quando um engenheiro combina vários modelos de detecção de objetos para melhorar a precisão. Imagine um engenheiro trabalhando em um sistema de monitoramento de segurança para um canteiro de obras, onde a iluminação, os ângulos e os tamanhos dos objetos mudam constantemente.

Um único modelo pode não detectar um trabalhador nas sombras ou confundir máquinas em movimento. Ao usar um conjunto de modelos, cada um com diferentes pontos fortes, o sistema se torna mais confiável e menos propenso a cometer esses erros.

Em particular, modelos como Ultralytics YOLOv5 andam de mãos dadas com o agrupamento de modelos. Os engenheiros podem combinar diferentes variantes YOLOv5 , como o YOLOv5x e o YOLOv5l6, para efetuar previsões em conjunto. Cada modelo analisa a mesma imagem e produz as suas próprias detecções, que são depois calculadas como média para gerar um resultado final mais forte e mais preciso.

Aqui estão alguns benefícios importantes de usar o aprendizado ensemble:

Embora o aprendizado por conjunto traga várias vantagens, também existem alguns desafios a serem considerados. Aqui estão alguns fatores a serem lembrados:

O aprendizado Ensemble mostra como combinar múltiplos modelos pode tornar os sistemas de IA mais precisos e confiáveis. Ele ajuda a reduzir erros e melhorar o desempenho em diferentes tipos de tarefas. À medida que o aprendizado de máquina e a IA continuam a crescer, técnicas como esta estão impulsionando uma adoção mais ampla e soluções de IA práticas e de alto desempenho.

Junte-se à nossa crescente comunidade e ao nosso repositório GitHub para saber mais sobre Vision AI. Explore nossas páginas de soluções para aprender sobre aplicações de visão computacional na agricultura e IA na logística. Confira nossas opções de licenciamento para começar a usar seu próprio modelo de visão computacional hoje mesmo!