Como Ultralytics treina de forma mais inteligente com ProgLoss, STAL e MuSGD

Saiba como Ultralytics treina de forma mais fiável usando o Progressive Loss Balancing, a Small-Target-Aware Label Assignment e o otimizador MuSGD.

.webp)

Saiba como Ultralytics treina de forma mais fiável usando o Progressive Loss Balancing, a Small-Target-Aware Label Assignment e o otimizador MuSGD.

.webp)

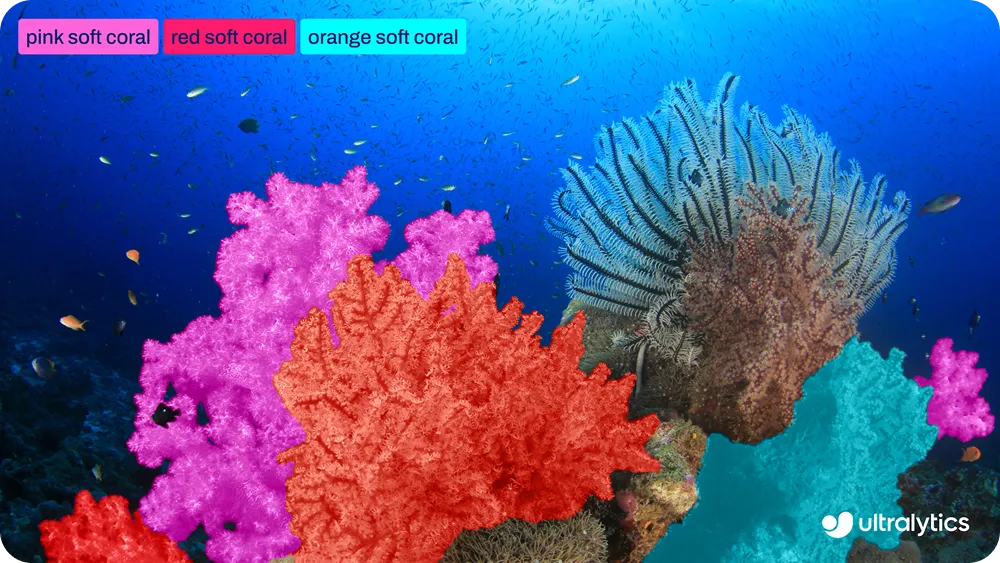

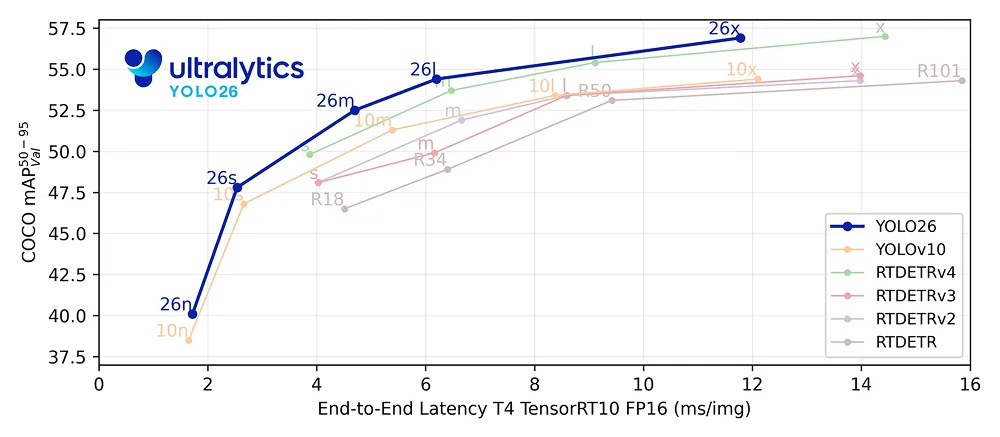

Na semana passada, lançámos Ultralytics , estabelecendo um novo padrão para modelos de visão computacional em tempo real e com prioridade para a borda. Semelhante aos YOLO Ultralytics YOLO anteriores, como o Ultralytics YOLO11, o YOLO26 suporta as principais tarefas de visão computacional com as quais os utilizadores estão familiarizados, incluindo deteção de objetos, segmentação de instâncias e estimativa de pose.

No entanto, o YOLO26 não é apenas uma atualização incremental. Embora as tarefas suportadas possam parecer familiares, este novo modelo representa um passo inovador na forma como os modelos de visão computacional são treinados. Com o YOLO26, o foco vai além da eficiência da inferência, tornando o treinamento mais estável.

O YOLO26 foi projetado tendo em mente todo o ciclo de vida do treinamento. Isso significa convergência mais rápida, execuções de treinamento mais confiáveis e comportamento consistente do modelo. Essas melhorias são especialmente importantes em fluxos de trabalho do mundo real, onde a confiabilidade do treinamento afeta diretamente a rapidez com que os modelos podem ser iterados e implementados.

Para permitir isso, o YOLO26 introduz várias inovações de treino direcionadas, como Progressive Loss Balancing (ProgLoss), Small-Target-Aware Label Assignment (STAL) e o otimizador MuSGD. Juntas, essas mudanças melhoram a forma como a perda de aprendizagem é equilibrada, como os rótulos são atribuídos e como a otimização se comporta ao longo do tempo.

Neste artigo, exploraremos como cada um desses mecanismos funciona e por que eles tornam Ultralytics mais fácil de treinar e mais confiável em escala. Vamos começar!

Ultralytics simplifica nativamente todo o pipeline de inferência, eliminando a dependência de etapas de pós-processamento, como a supressão não máxima. Em vez de gerar muitas previsões sobrepostas e filtrá-las posteriormente, o YOLO26 produz detecções finais diretamente da rede.

Isso torna o YOLO26 um modelo completo, no qual a previsão, a resolução de duplicatas e os resultados finais são aprendidos dentro da própria rede. Isso simplifica a implementação e melhora a eficiência da inferência, ao mesmo tempo que molda a forma como o modelo aprende durante o treinamento.

Num sistema completo como este, o treino e a inferência estão intimamente ligados. Como não há uma etapa externa de pós-processamento para corrigir as previsões posteriormente, o modelo precisa aprender a tomar decisões claras e confiáveis durante o próprio treino.

Isso torna o alinhamento entre os objetivos de treino e o comportamento de inferência especialmente importante. Qualquer incompatibilidade entre a forma como o modelo é treinado e como é usado no momento da inferência pode levar a uma aprendizagem instável ou a uma convergência mais lenta.

O YOLO26 lida com isso projetando seu processo de treinamento com base no uso no mundo real desde o início. Em vez de se concentrar apenas na velocidade de inferência, o sistema de treinamento foi criado para oferecer suporte a um aprendizado estável em longas execuções, convergência consistente em modelos de tamanhos variados, de Nano a Extra Grande, e desempenho robusto em diversos conjuntos de dados.

Uma das principais inovações de treino no Ultralytics baseia-se numa abordagem de treino de duas cabeças utilizada nos YOLO anteriores. Nos modelos de detecção de objetos, uma cabeça refere-se à parte da rede responsável por fazer previsões.

Em outras palavras, os cabeçotes de detecção aprendem a prever onde os objetos estão localizados em uma imagem e quais são esses objetos. Eles fazem isso através da regressão das coordenadas da caixa delimitadora, o que significa que aprendem a estimar a posição e o tamanho de cada objeto na imagem de entrada.

Durante o treino, o modelo aprende minimizando uma perda, que é uma medida numérica de quão distantes as suas previsões estão das respostas corretas ou da verdade fundamental. Uma perda menor significa que as previsões do modelo estão mais próximas da verdade fundamental, enquanto uma perda maior indica erros maiores. O cálculo da perda orienta como o modelo atualiza os seus parâmetros durante o treino.

O YOLO26 usa duas cabeças de detecção durante o treinamento que compartilham o mesmo modelo subjacente, mas servem a propósitos diferentes. A cabeça um-para-um é a cabeça usada no momento da inferência. Ela aprende a associar cada objeto a uma única previsão confiável, o que é essencial para o design completo e NMS do YOLO26.

Entretanto, o cabeçote um-para-muitos é usado apenas durante o treinamento. Ele permite que várias previsões sejam associadas ao mesmo objeto, proporcionando uma supervisão mais densa. Esse sinal de aprendizagem mais rico ajuda a estabilizar o treinamento e melhorar a precisão, especialmente nos estágios iniciais.

No YOLO26, ambos os cabeçotes utilizam o mesmo cálculo de perda para regressão de caixa e classificação. Implementações anteriores aplicavam um equilíbrio fixo entre esses dois sinais de perda durante todo o treinamento.

Na prática, porém, a importância de cada cabeça muda com o tempo. A supervisão densa é mais útil no início, enquanto o alinhamento com o comportamento de inferência se torna mais importante mais tarde no treino. O YOLO26 foi projetado com base nessa percepção, o que leva diretamente à forma como ele reequilibra os sinais de aprendizagem à medida que o treino avança.

Então, como Ultralytics lida com essas necessidades de aprendizagem em constante mudança durante o treinamento? Ele usa o Progressive Loss Balancing (Equilíbrio Progressivo de Perdas) para ajustar a forma como os sinais de aprendizagem são ponderados ao longo do tempo.

O ProgLoss funciona alterando dinamicamente a contribuição de cada cabeça para a perda total à medida que o treino avança. No início, é atribuído mais peso à cabeça um-para-muitos para estabilizar a aprendizagem e melhorar a recuperação. À medida que o treino continua, o equilíbrio muda gradualmente para a cabeça um-para-um, alinhando o treino mais estreitamente com o comportamento de inferência.

Essa transição gradual permite que o YOLO26 aprenda na ordem correta. Em vez de forçar o modelo a otimizar objetivos concorrentes de uma só vez, o Progressive Loss Balancing prioriza o sinal de aprendizagem mais útil em cada etapa do treinamento. O resultado é uma convergência mais suave, menos execuções de treinamento instáveis e um desempenho final mais consistente.

Outra melhoria interessante no treinamento Ultralytics vem da forma como o modelo atribui metas de treinamento às previsões, um processo conhecido como atribuição de rótulos. Ele é responsável por combinar objetos de referência com previsões candidatas, frequentemente chamadas de âncoras.

Essas correspondências determinam quais previsões recebem supervisão e contribuem para a perda. O YOLO26 baseia-se num método de atribuição de rótulos existente chamado Task Alignment Learning (TAL), que foi concebido para alinhar melhor a classificação e a localização durante o treino.

Embora o TAL funcione bem para a maioria dos objetos, o treinamento revelou uma limitação importante. Durante o processo de correspondência, objetos muito pequenos podiam ser totalmente descartados. Na prática, objetos menores que cerca de 8 pixels em uma imagem de entrada de 640 pixels muitas vezes não recebiam nenhuma atribuição de âncora. Quando isso acontece, o modelo recebe pouca ou nenhuma supervisão para esses objetos, dificultando o aprendizado para detect de forma confiável.

Para resolver esta questão, o YOLO26 introduz a Atribuição de Etiquetas Consciente de Alvos Pequenos (STAL). A STAL modifica o processo de atribuição para garantir que objetos pequenos não sejam ignorados durante o treino. Especificamente, ela impõe um mínimo de quatro atribuições de âncora para objetos menores que 8 pixels. Isso garante que mesmo objetos minúsculos contribuam consistentemente para a perda de treino.

Ao reforçar a supervisão de alvos pequenos, o STAL melhora a estabilidade da aprendizagem e o desempenho de deteção em cenários onde objetos pequenos ou distantes são comuns. Essa melhoria é especialmente importante para aplicações YOLO26 edge-first , como imagens aéreas, robótica e sistemas de Internet das Coisas (IoT), onde os objetos são frequentemente pequenos, distantes ou parcialmente visíveis e a deteção confiável é fundamental.

Para oferecer um treinamento mais estável e previsível, Ultralytics também apresenta um novo otimizador chamado MuSGD. Esse otimizador foi projetado para melhorar a convergência e a confiabilidade do treinamento em modelos de detecção de ponta a ponta, especialmente à medida que o tamanho do modelo e a complexidade do treinamento aumentam.

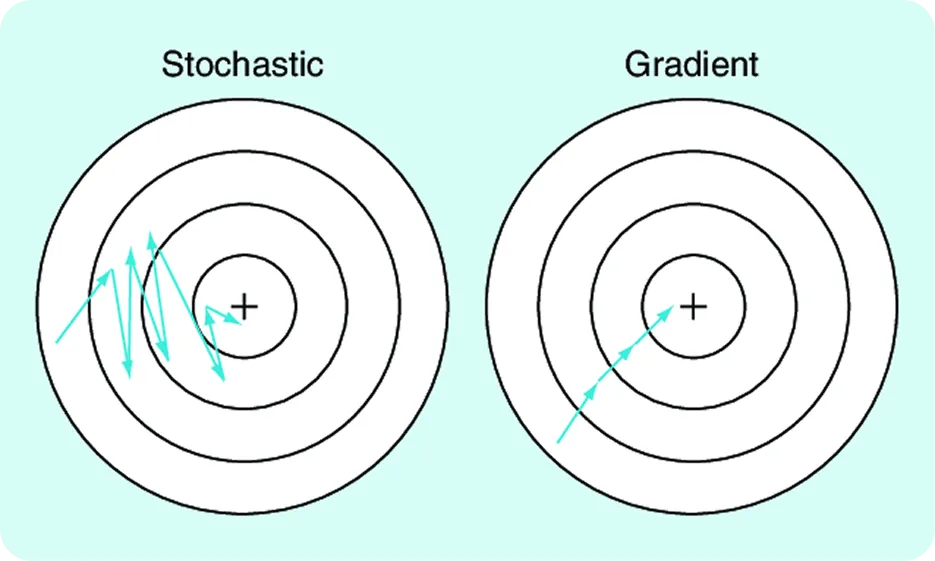

Para que uma rede neural aprenda e, consequentemente, altere os pesos de acordo com isso, durante o treino, calculamos um erro (também chamado de «perda»). O modelo, portanto, mede o quão erradas são as suas previsões usando um valor de perda, calcula gradientes que indicam como os seus parâmetros devem mudar e, em seguida, atualiza esses parâmetros para reduzir o erro. O Stochastic Gradient Descent (SGD) é um otimizador amplamente utilizado que realiza essas atualizações, tornando o treino eficiente e escalável.

O MuSGD baseia-se nesta fundação familiar, incorporando ideias de otimização inspiradas no Muon, um método utilizado no treino de grandes modelos de linguagem. Estas ideias foram influenciadas por avanços recentes, como o Kimi K2 da Moonshot AI, que demonstrou um comportamento de treino melhorado através de atualizações de parâmetros mais estruturadas.

O YOLO26 utiliza uma estratégia de atualização híbrida. Alguns parâmetros são atualizados utilizando uma combinação de atualizações inspiradas no Muon e SGD, enquanto outros utilizam SGD . Isso permite que o YOLO26 introduza uma estrutura adicional no processo de otimização, mantendo as propriedades de robustez e generalização que tornaram SGD .

O resultado é uma otimização mais suave, convergência mais rápida e comportamento de treino mais previsível em todos os tamanhos de modelo, tornando o MuSGD uma parte fundamental do motivo pelo qual o YOLO26 é mais fácil de treinar e mais confiável em escala.

As inovações de treino Ultralytics , combinadas com funcionalidades essenciais, como o seu design completo, NMS e com prioridade para a periferia, tornam o modelo mais fácil de treinar e mais fiável em escala. Pode estar a perguntar-se o que isso realmente significa para as aplicações de visão computacional.

Na prática, isso facilita muito a implementação da visão computacional onde ela realmente funciona. Os modelos são treinados de forma mais previsível, escalam de maneira mais consistente em todos os tamanhos e são mais fáceis de adaptar a novos conjuntos de dados. Isso reduz o atrito entre a experimentação e a implementação, especialmente em ambientes onde a confiabilidade e a eficiência são tão importantes quanto o desempenho bruto.

Por exemplo, em aplicações de robótica e visão industrial, os modelos muitas vezes precisam ser retreinados com frequência, à medida que os ambientes, sensores ou tarefas mudam. Com o YOLO26, as equipas podem iterar mais rapidamente sem se preocupar com execuções de treino instáveis ou comportamento inconsistente entre tamanhos de modelos.

Sistemas de visão computacional confiáveis dependem tanto de como os modelos são treinados quanto de como eles se comportam no momento da inferência. Ao melhorar o equilíbrio dos sinais de aprendizagem, o tratamento de objetos pequenos e o progresso da otimização, o YOLO26 torna o treinamento mais estável e fácil de escalar. Esse foco no treinamento confiável ajuda as equipas a passar mais facilmente da experimentação para a implementação no mundo real, especialmente em aplicações edge-first.

Quer aprender sobre IA? Visite o nosso repositório GitHub para descobrir mais. Junte-se à nossa comunidade ativa e descubra as inovações em setores como IA em logística e IA de visão na indústria automóvel. Para começar a usar a visão computacional hoje mesmo, confira as nossas opções de licenciamento.