O impacto do design mais rápido e voltado para a borda Ultralytics

Veja como Ultralytics é mais rápido na borda e por que isso é importante para aplicações de visão computacional de última geração que exigem baixa latência e eficiência.

Veja como Ultralytics é mais rápido na borda e por que isso é importante para aplicações de visão computacional de última geração que exigem baixa latência e eficiência.

No início desta semana, Ultralytics lançou Ultralytics Ultralytics , um YOLO mais rápido, leve e pequeno que visa redefinir o desempenho dos sistemas de visão computacional na borda. O YOLO26 suporta as mesmas tarefas de visão essenciais dos YOLO anteriores, incluindo deteção de objetos e segmentação de instâncias.

A diferença determinante entre o YOLO26 e os modelos anteriores é o ambiente em que ele foi projetado para operar. Em vez de otimizar principalmente para unidades de processamento gráfico (GPUs) em nuvem ou desempenho orientado por benchmarks, o YOLO26 foi projetado desde o início para implantação no mundo real em dispositivos de ponta e hardware incorporado.

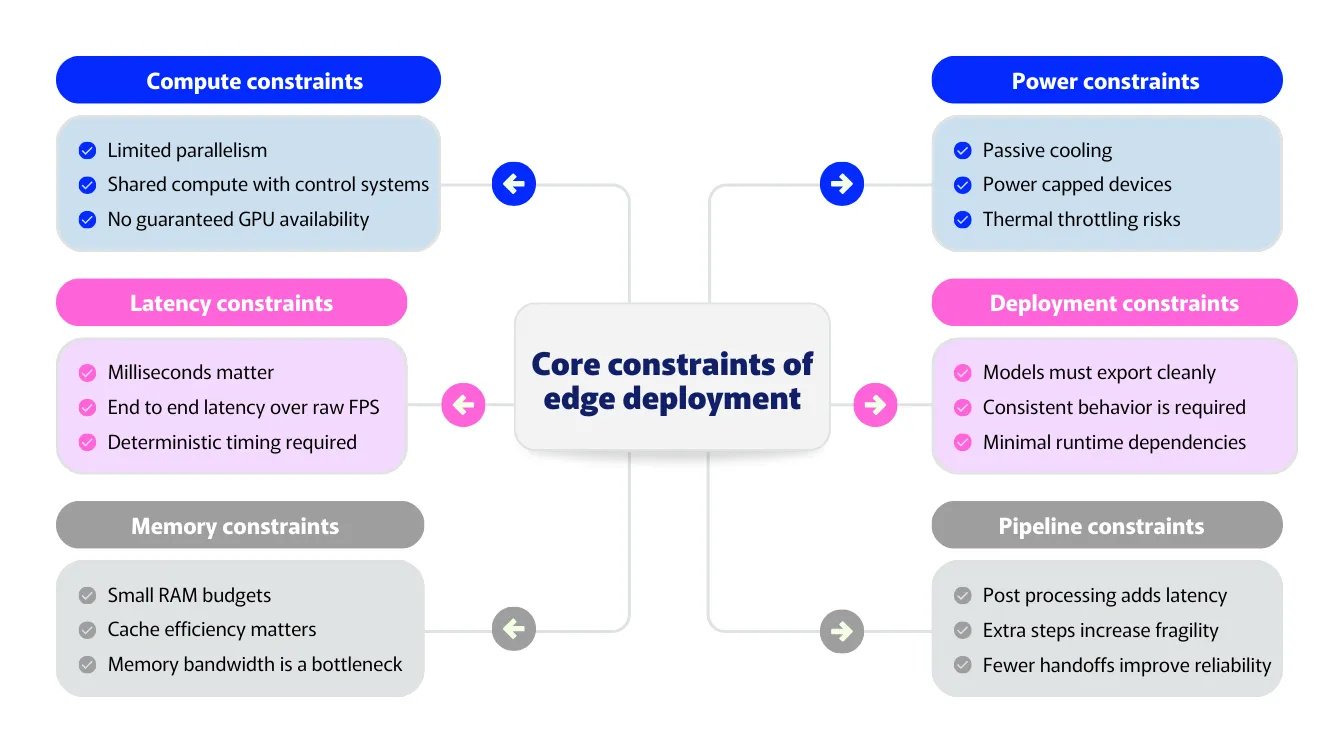

À medida que a visão computacional passa da investigação para a produção, a realidade das limitações de desempenho torna-se mais clara. Os ambientes de ponta são moldados por orçamentos de latência restritos, memória limitada, energia e restrições térmicas, além da necessidade de um comportamento previsível em diversas plataformas.

Nestas configurações, o desempenho geral do sistema depende não apenas da velocidade bruta de inferência, mas também da eficiência com que todo o pipeline opera. A sobrecarga de pós-processamento, a pressão da memória e os caminhos de execução específicos da plataforma são frequentemente pontos de estrangulamento.

O YOLO26 aborda esses desafios adotando uma abordagem mais rápida e voltada para a borda, que analisa todo o pipeline de inferência, em vez de métricas individuais do modelo. Ao se concentrar na otimização da borda, simplificar o pipeline de inferência e remover etapas desnecessárias de pós-processamento, o YOLO26 oferece melhorias de velocidade que resultam em menor latência e comportamento mais confiável na produção.

Neste artigo, exploraremos como as escolhas arquitetónicas do YOLO26 se traduzem em melhorias de desempenho no mundo real e por que ser mais rápido na borda muda fundamentalmente o que é possível para as aplicações de visão computacional de última geração.

Executar modelos de visão computacional na periferia é muito diferente de executá-los na nuvem. Em ambientes de nuvem, os sistemas normalmente têm acesso a GPUs potentes, grandes quantidades de memória e hardware estável. Na periferia, as mesmas premissas não se aplicam.

A maioria das implementações de ponta é executada em diversas arquiteturas de hardware, não em GPUs. Os dispositivos normalmente utilizam vários processadores especializados para diferentes tarefas, que são otimizados para eficiência e baixo consumo de energia, em vez da capacidade de computação bruta das GPUs na nuvem.

A latência é outra grande limitação. Os sistemas de ponta geralmente operam sob rígidos limites de tempo real, onde mesmo pequenos atrasos podem afetar a capacidade de resposta ou a segurança. Nesses casos, a latência de ponta a ponta é mais importante do que a velocidade bruta de inferência. Um modelo pode ser rápido no papel, mas ainda assim ficar aquém quando o pós-processamento e a movimentação de dados são adicionados.

A memória também desempenha um papel importante. Muitos dispositivos de ponta têm memória limitada e caches partilhados. Tensores intermediários grandes e uso ineficiente da memória podem tornar os sistemas lentos, mesmo quando o modelo em si é eficiente.

Os limites de energia e térmicos acrescentam mais restrições. Os dispositivos de ponta geralmente funcionam sem refrigeração ativa e dentro de orçamentos de energia fixos. O desempenho precisa ser eficiente e sustentável, não apenas rápido em curtos períodos.

Além de tudo isso, as implementações de ponta exigem consistência. Os modelos precisam se comportar da mesma forma em todos os dispositivos e tempos de execução. Códigos específicos da plataforma ou etapas complexas de pós-processamento podem introduzir diferenças sutis que tornam os sistemas mais difíceis de implementar e manter.

Essas restrições definem o que realmente significa desempenho na borda. Em outras palavras, o desempenho é definido por todo o pipeline, não por uma única métrica.

Então, como as restrições da implementação de borda estão relacionadas aos requisitos de um modelo de visão computacional criado para a borda? A conexão fica clara quando os modelos saem do ambiente de pesquisa e entram em sistemas do mundo real.

Em ambientes de nuvem, o desempenho é frequentemente medido usando benchmarks como velocidade e precisão de inferência. Na borda, essas métricas contam apenas parte da história. Os sistemas de visão normalmente são executados em hardware heterogéneo, onde a inferência da rede neural é descarregada para aceleradores especializados, enquanto outras partes do pipeline são executadas em processadores de uso geral.

Neste contexto, a velocidade do modelo não é suficiente. O desempenho de todo o sistema após a implementação do modelo é fundamental. Um modelo pode parecer rápido por si só, mas ainda assim ficar aquém do esperado se o pós-processamento, a movimentação de dados ou etapas específicas da plataforma adicionarem sobrecarga.

É por isso que a visão de ponta requer um modelo de desempenho que se concentre na eficiência ao nível do sistema, em vez de benchmarks isolados. O YOLO26 reflete essa mudança ao se concentrar na otimização de ponta, inferência simplificada e execução de ponta a ponta, criada para implementação no mundo real.

Na periferia, o desempenho é definido pela qualidade do mapeamento do modelo para a arquitetura de hardware real do dispositivo. Projetar primeiro para a periferia garante que os sistemas de visão funcionem de forma confiável em plataformas do mundo real, independentemente da combinação específica de unidades de processamento disponíveis.

Uma abordagem edge-first prioriza a execução previsível e eficiente em hardware heterogéneo, em vez de adaptar modelos que foram otimizados para GPUs na nuvem após o facto. Simplificando, isso significa favorecer operações que se traduzem bem em aceleradores de redes neurais, minimizando o trabalho não neural fora do modelo e reduzindo a complexidade desnecessária que pode retardar a execução de ponta a ponta.

O YOLO26 foi projetado tendo em mente essas restrições. A sua arquitetura concentra-se no desempenho consistente, em vez do rendimento máximo em condições ideais. Ao simplificar os caminhos de execução e eliminar cálculos desnecessários, o YOLO26 reduz a sobrecarga em todo o pipeline de inferência e faz melhor uso da aceleração disponível e da hierarquia de memória do dispositivo.

Essa abordagem também melhora a confiabilidade. A otimização edge-first leva a um tempo mais previsível e menos picos de desempenho, o que é fundamental para sistemas em tempo real. Em vez de depender de hardware especializado ou pós-processamento pesado para atingir velocidade, o YOLO26 enfatiza a eficiência em todo o pipeline de inferência.

Pode estar a perguntar-se o que significa eliminar etapas desnecessárias de pós-processamento. Para entender isso, vamos dar um passo atrás e ver como funcionam os sistemas tradicionais de deteção de objetos.

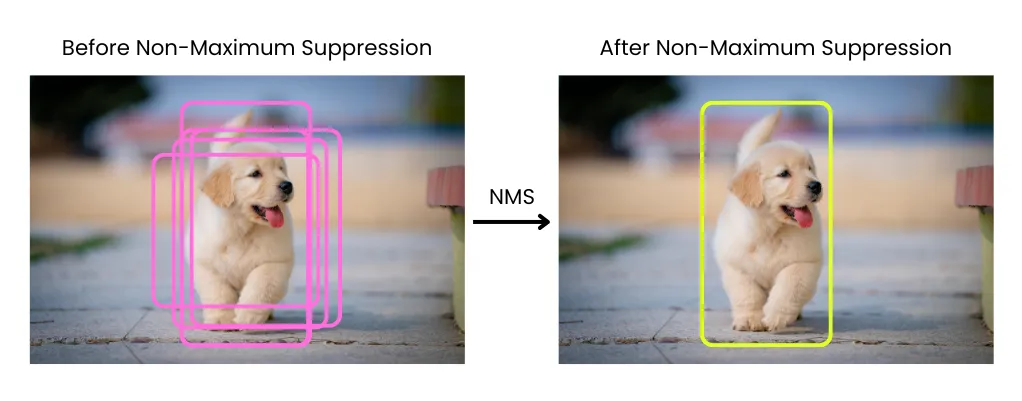

Em muitos pipelines de deteção de objetos, a inferência não termina quando o modelo produz as suas previsões. Em vez disso, o modelo gera um grande número de caixas delimitadoras sobrepostas, que precisam ser filtradas e refinadas antes de poderem ser utilizadas. Essa limpeza ocorre por meio de etapas de pós-processamento executadas fora do próprio modelo.

Uma das etapas de pós-processamento mais comuns é a supressão não máxima, ou NMS. NMS caixas delimitadoras sobrepostas e mantém apenas as detecções mais confiáveis, removendo duplicatas que se referem ao mesmo objeto. Embora essa abordagem seja eficaz, ela introduz cálculos extras após a conclusão da inferência.

No limite, esse trabalho extra tem um custo. Etapas de pós-processamento como NMS não NMS adequadas para os aceleradores especializados usados para inferência de redes neurais, que são otimizados para computação neural densa, em vez de operações pesadas em termos de controlo ou que exigem muita memória.

Como resultado, NMS latência adicional e sobrecarga de memória, e o seu custo aumenta à medida que o número de detecções aumenta. Mesmo quando o modelo em si é rápido, NMS ainda NMS consumir uma parte significativa do tempo total de execução.

O pós-processamento também aumenta a complexidade do sistema. Como ele fica fora do modelo, precisa ser implementado separadamente para diferentes tempos de execução e destinos de hardware. Isso muitas vezes leva a caminhos de código específicos da plataforma, comportamento inconsistente entre dispositivos e pipelines de implementação mais frágeis.

Mais importante ainda, o pós-processamento quebra a ideia de desempenho verdadeiro de ponta a ponta. Medir a velocidade de inferência do modelo não reflete como o sistema se comporta na produção. O que importa, em última análise, é o tempo total desde a entrada até a saída final, incluindo todas as etapas do pipeline.

Nestas situações, o pós-processamento torna-se um gargalo oculto na periferia. Ele adiciona latência, consome CPU e complica a implementação, tudo isso enquanto permanece fora do próprio modelo.

O YOLO26 elimina NMS ao abordar a causa raiz das detecções duplicadas, em vez de limpá-las após a inferência. Em vez de produzir muitas previsões sobrepostas que precisam ser filtradas, o modelo é treinado para gerar diretamente um conjunto menor de detecções finais confiáveis.

Isso é possível graças à alteração da forma como as detecções são aprendidas durante o treinamento. O YOLO26 promove uma relação mais clara entre objetos e previsões, reduzindo a redundância na sua origem. Como resultado, as detecções duplicadas são resolvidas dentro da própria rede, em vez de por meio de pós-processamento externo.

Remover NMS um impacto imediato no desempenho da borda. Como NMS se adapta bem aos aceleradores de redes neurais, eliminá-lo reduz o movimento da memória e evita etapas de processamento não neurais dispendiosas. Isso diminui a latência de ponta a ponta e torna o desempenho mais previsível, especialmente em dispositivos de borda, onde o pós-processamento pode consumir uma parte significativa do tempo total de execução.

Isso também simplifica o pipeline de inferência. Com menos etapas fora do modelo, há menos movimentação de dados e menos transferências entre componentes. A saída do modelo já é o resultado final, o que torna a execução mais previsível.

Outra inovação no YOLO26 é a remoção da Distribuição Focal Loss, ou DFL, que era usada nos YOLO anteriores para regressão de caixas delimitadoras. Em vez de prever uma única coordenada diretamente, os modelos que usavam DFL aprendiam uma distribuição de valores possíveis e, então, derivavam uma caixa delimitadora final a partir dessa distribuição. Essa abordagem ajudou a melhorar a precisão da localização e foi um importante passo à frente nas gerações anteriores.

Com o tempo, porém, o DFL também introduziu algumas desvantagens. Prever distribuições aumenta a computação e adiciona complexidade à arquitetura do modelo, o que pode tornar a inferência mais lenta nas CPUs e dificultar a exportação dos modelos entre formatos de implementação. O DFL também impôs intervalos de regressão fixos, o que poderia limitar a flexibilidade ao detectar objetos muito grandes.

O YOLO26 remove o DFL como parte de sua mudança para um design mais simples e completo. A regressão da caixa delimitadora foi redesenhada para ser mais direta, reduzindo cálculos desnecessários e mantendo a precisão. Essa mudança está alinhada com a abordagem NMS do YOLO26.

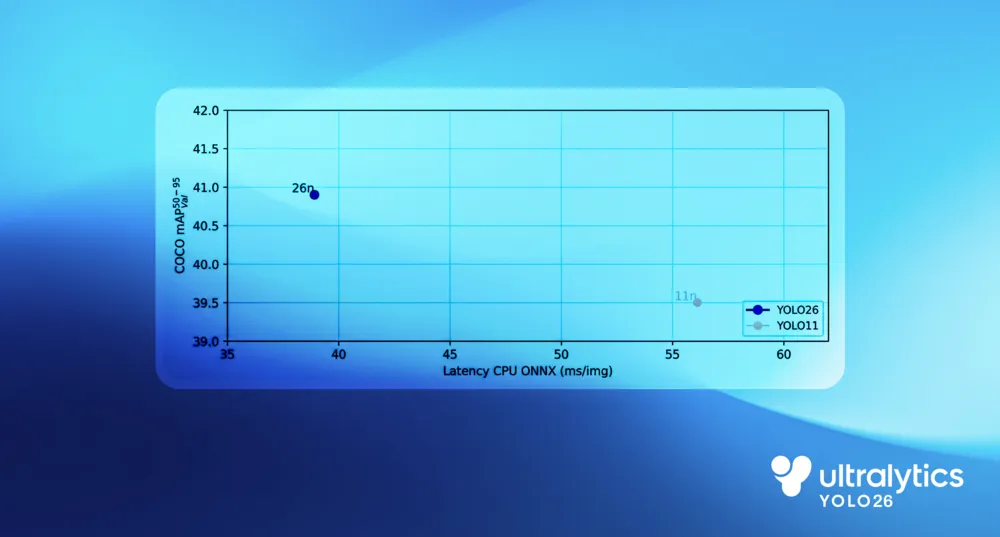

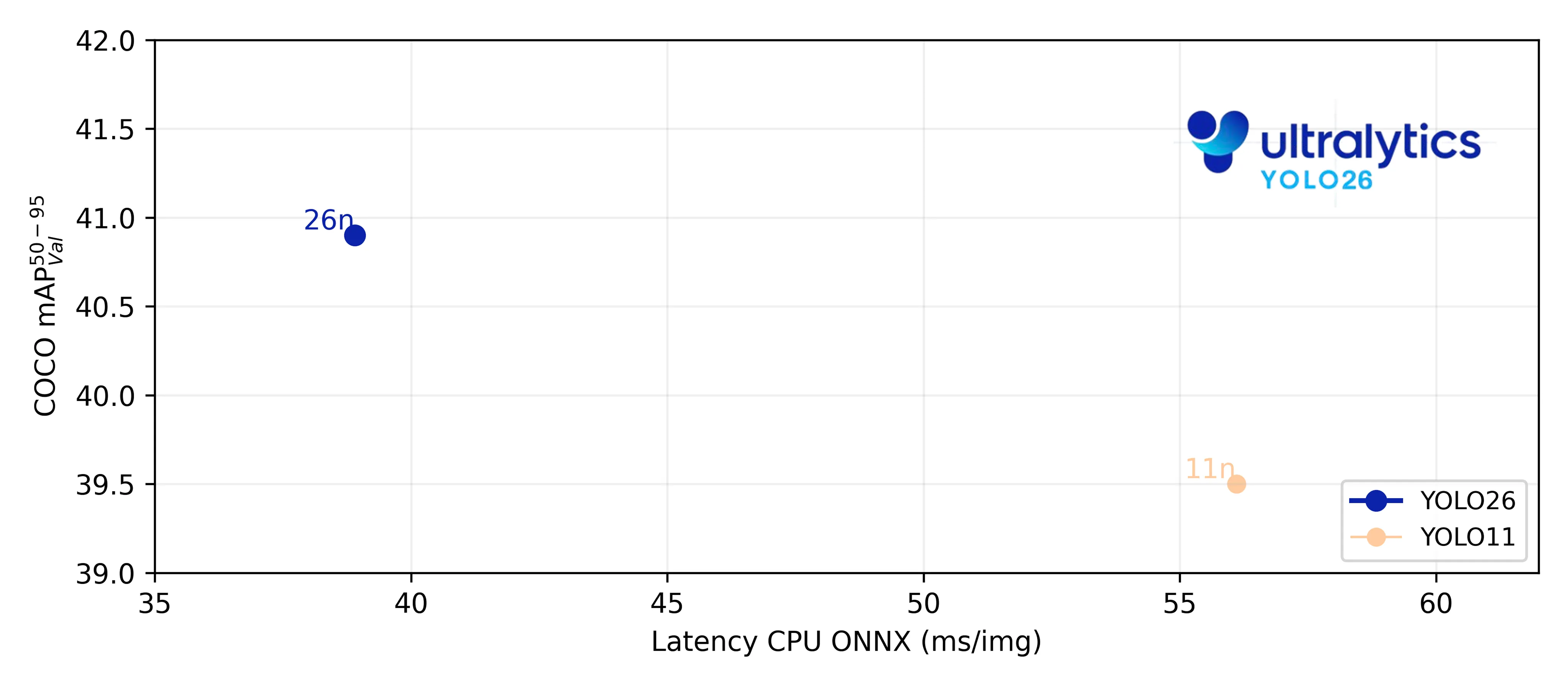

Em benchmarks CPU, o YOLO26 mostra uma clara melhoria de desempenho em relação YOLO anteriores. Em comparação com o Ultralytics YOLO11, o modelo nano YOLO26 oferece CPU até 43% mais rápida, uma diferença que tem um impacto significativo nas implementações de ponta no mundo real.

Este ganho advém da simplificação de todo o pipeline de inferência, em vez da otimização de um único componente. A execução de ponta a ponta elimina a sobrecarga do pós-processamento, um método de regressão de caixa delimitadora mais direto reduz a computação e as escolhas de design CPU melhoram a eficiência da execução em processadores de uso geral.

Juntas, essas alterações reduzem a latência, diminuem CPU e levam a um desempenho mais rápido e consistente em hardware de ponta do mundo real.

Os ganhos de desempenho do YOLO26 vão além de uma inferência mais rápida. Ao simplificar o modelo e reduzir a sobrecarga de memória, ele se torna mais fácil de implementar e mais confiável para execução em ambientes de ponta.

O design completo do YOLO26 também simplifica a exportação. Com menos componentes auxiliares e sem etapas de pós-processamento externo, os modelos exportados são totalmente independentes. Isso reduz as dependências específicas da plataforma e ajuda a garantir um comportamento consistente entre tempos de execução e destinos de hardware.

Na prática, isso significa que o YOLO26 pode ser implementado mais facilmente em dispositivos de ponta, como câmaras, robôs e sistemas incorporados, usando vários formatos de exportação. O que você exporta é o que você executa, com menos etapas de integração e menos risco de desvio na implementação.

Até agora, vimos como o design edge-first do YOLO26 melhora o desempenho a nível do sistema. O verdadeiro impacto, no entanto, está na forma como ele facilita a integração da IA de visão em aplicações do mundo real.

Por exemplo, em robótica e ambientes industriais, os sistemas de visão geralmente operam sob restrições rigorosas em tempo real. As decisões precisam ser tomadas de forma rápida e consistente, usando recursos computacionais limitados e sem depender da conectividade da nuvem. Com Ultralytics , atender a esses requisitos torna-se prático.

Aplicações como navegação robótica e manipulação de objetos se beneficiam de menor latência e inferência mais previsível, permitindo que os robôs respondam suavemente às mudanças no ambiente. Da mesma forma, em ambientes industriais, os modelos de visão podem ser executados diretamente nas linhas de produção para detect , track e monitorar processos sem introduzir atrasos ou complexidade adicional.

Ao permitir uma inferência rápida e fiável em hardware de ponta, o YOLO26 ajuda a tornar a IA visual uma parte natural da robótica e dos sistemas industriais, em vez de um desafio para implementar e manter.

O YOLO26 foi criado para a borda, onde restrições do mundo real, como latência, memória e confiabilidade, definem o que é possível. Ao projetar o modelo com base na execução CPU, inferência de ponta a ponta e implementação mais simples, o YOLO26 torna a IA de visão prática para integração em sistemas reais. Essa abordagem prioritária da borda permite uma ampla gama de aplicações, desde robótica e visão industrial até IA incorporada e no dispositivo, onde o desempenho e a previsibilidade são mais importantes.

Junte-se à nossa crescente comunidade e explore o nosso repositório GitHub para obter recursos práticos de IA. Para construir com o Vision AI hoje, explore as nossas opções de licenciamento. Saiba como a IA na agricultura está a transformar a agricultura e como a Vision AI nos cuidados de saúde está a moldar o futuro, visitando as nossas páginas de soluções.