Изучите согласованность между экспертами, каппа Коэна, ICC, обучение оценщиков и процент согласования. Узнайте, как эти статистические показатели обеспечивают согласованность и согласие между наблюдателями в исследованиях и анализе данных.

Изучите согласованность между экспертами, каппа Коэна, ICC, обучение оценщиков и процент согласования. Узнайте, как эти статистические показатели обеспечивают согласованность и согласие между наблюдателями в исследованиях и анализе данных.

Когда вы создаете модель ИИ, качество ваших данных так же важно, как и алгоритмы, лежащие в ее основе. Всякий раз, когда несколько человек маркируют или проверяют одни и те же данные, неизбежны разногласия. Это верно во многих областях, включая исследования, здравоохранение и образование.

В частности, в компьютерном зрении, отрасли искусственного интеллекта, которая включает в себя обучение моделей типа Ultralytics YOLO11 для интерпретации визуальных данных, таких как изображения или видео, решающую роль играют маркированные примеры. Если эти метки непоследовательны, модели компьютерного зрения с трудом обучаются правильным паттернам.

Межэкспертная надежность (IRR) измеряет, насколько согласованно разные люди или разметчики выполняют задачу. Это помогает отслеживать согласованность и выявлять пробелы в обучении, руководствах или интерпретации. Это особенно важно при обучении пользовательских моделей, когда модели ИИ создаются с использованием определенных данных для конкретной цели.

В этой статье мы рассмотрим, что такое согласованность оценок между экспертами, как ее измерить и как улучшить в реальных проектах. Начнем!

Межэкспертная надежность измеряет, как часто два или более человека (также известных как эксперты) соглашаются при маркировке, оценке или проверке одного и того же контента. Она используется для проверки того, насколько последовательно разные эксперты используют заданные критерии. Высокая степень согласия между экспертами означает, что задача хорошо определена и четко понятна.

Эта концепция используется в различных областях. В зависимости от области она известна под разными названиями, такими как согласованность между экспертами, надежность между наблюдателями или надежность между кодировщиками. Однако основной принцип остается тем же.

В Vision AI согласованность между оценщиками является ключевой частью процесса маркировки данных. Обучение моделей компьютерного зрения часто требует маркировки огромных наборов данных изображений или видеокадров, поэтому несколько разработчиков AI работают над одними и теми же данными вместе.

Чтобы получить точные результаты, они должны следовать тем же правилам маркировки. Например, при маркировке животных всем необходимо четкое соглашение о том, что считается собакой, как нарисовать ограничивающий прямоугольник вокруг нее и следует ли маркировать или игнорировать размытые объекты.

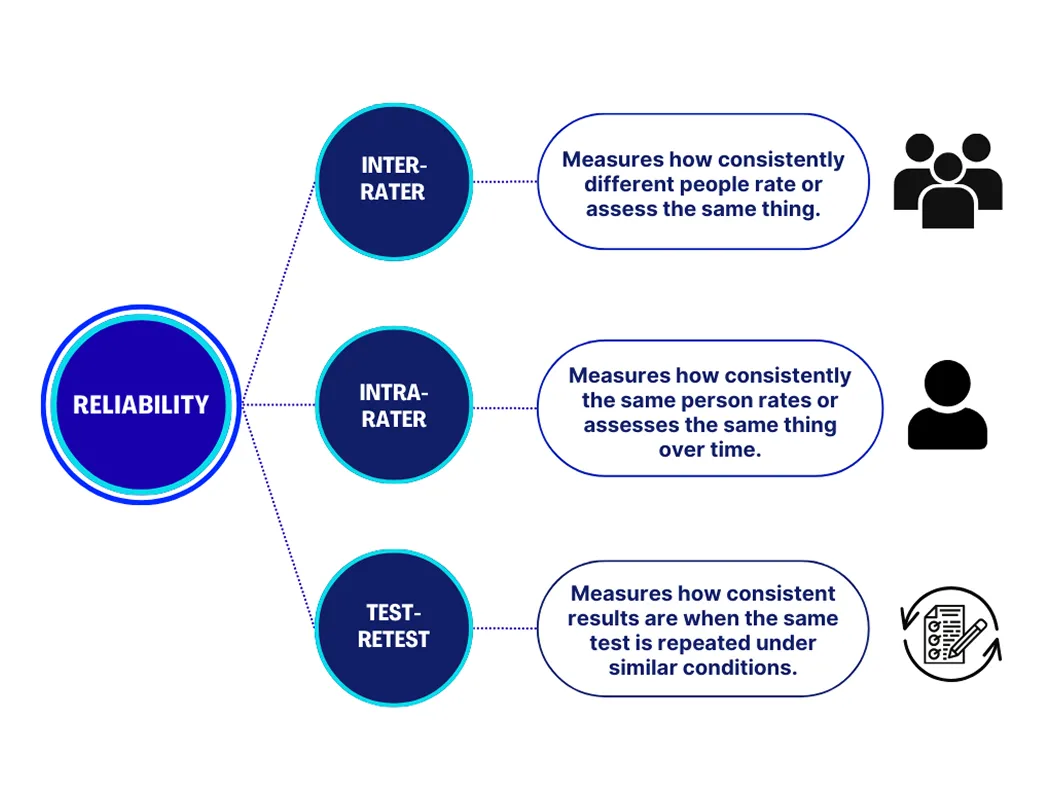

Когда люди участвуют в маркировке или оценке данных, необходимо учитывать три основных типа надежности. Каждый из них служит разной цели в измерении того, насколько последовательны результаты. Вот более подробный взгляд на каждый из них:

Вместе эти меры помогают подтвердить, что и люди, и процессы обеспечивают стабильные и надежные результаты.

В крупномасштабных проектах Vision AI качество размеченных данных напрямую влияет на эффективность модели. Даже небольшие различия в том, как аннотаторы применяют рекомендации, могут внести несоответствия, которые сбивают модель с толку во время обучения. Со временем это может привести к неточным прогнозам, напрасной трате ресурсов и необходимости дорогостоящей повторной маркировки.

Измерение согласованности между оценщиками помогает выявить эти проблемы на ранней стадии. Высокая согласованность означает, что аннотаторы работают согласованно, создавая более чистые и надежные наборы данных. Низкая согласованность сигнализирует о том, что инструкции, примеры или обучение, возможно, необходимо уточнить, прежде чем проект будет продвигаться вперед. Обеспечивая синхронную работу специалистов по маркировке, команды могут создавать модели ИИ, которые учатся более эффективно и обеспечивают лучшие результаты в реальных приложениях.

Вот некоторые ключевые практические соображения, которые следует учитывать при работе с несколькими оценщиками и стремлении к поддержанию высокой согласованности между оценщиками:

Существует несколько способов измерения согласованности между экспертами, и лучший выбор зависит от типа данных и задачи. Некоторые методы хорошо работают для отдельных экспертов, работающих с простыми вопросами, требующими ответа «да» или «нет», в то время как другие предназначены для ситуаций с участием нескольких экспертов.

Общие подходы включают процентное согласие, каппа Коэна, каппа Флейсса и коэффициент внутриклассовой корреляции. Каждый метод измеряет уровень согласия между экспертами и учитывает вероятность того, что некоторое согласие может произойти случайно.

Каппа Коэна — это широко используемый метод измерения согласованности между двумя экспертами. Он вычисляет, как часто они соглашаются при выполнении задачи, с поправкой на вероятность того, что некоторое согласие может произойти случайно. Оценки варьируются от -1 до 1, где 1 означает идеальное согласие, а 0 означает, что согласие не лучше случайного угадывания.

Аналогично, каппа Флейсса используется, когда задействовано более двух оценщиков. Он предоставляет общую оценку, которая показывает, насколько согласована группа. Оба метода используются для задач с установленными категориями, таких как маркировка изображений или тегирование эмоций. Их легко рассчитать, и они поддерживаются большинством инструментов аннотирования.

Другой способ измерения согласованности между экспертами — процентное согласие, которое вычисляет процент случаев, когда эксперты принимают одно и то же решение. Хотя этот метод прост в использовании, он не учитывает согласие, которое может произойти случайно.

Между тем, коэффициент внутриклассовой корреляции является более продвинутым методом, используемым для непрерывных или основанных на шкале данных. Он измеряет, насколько согласованы оценки между несколькими оценщиками, и часто применяется в исследованиях, которые включают баллы, измерения или другие типы данных, выходящие за рамки фиксированных категорий.

Теперь, когда у нас есть лучшее понимание того, как измерить надежность межэкспертной оценки, давайте рассмотрим, как эти методы можно использовать в реальных приложениях.

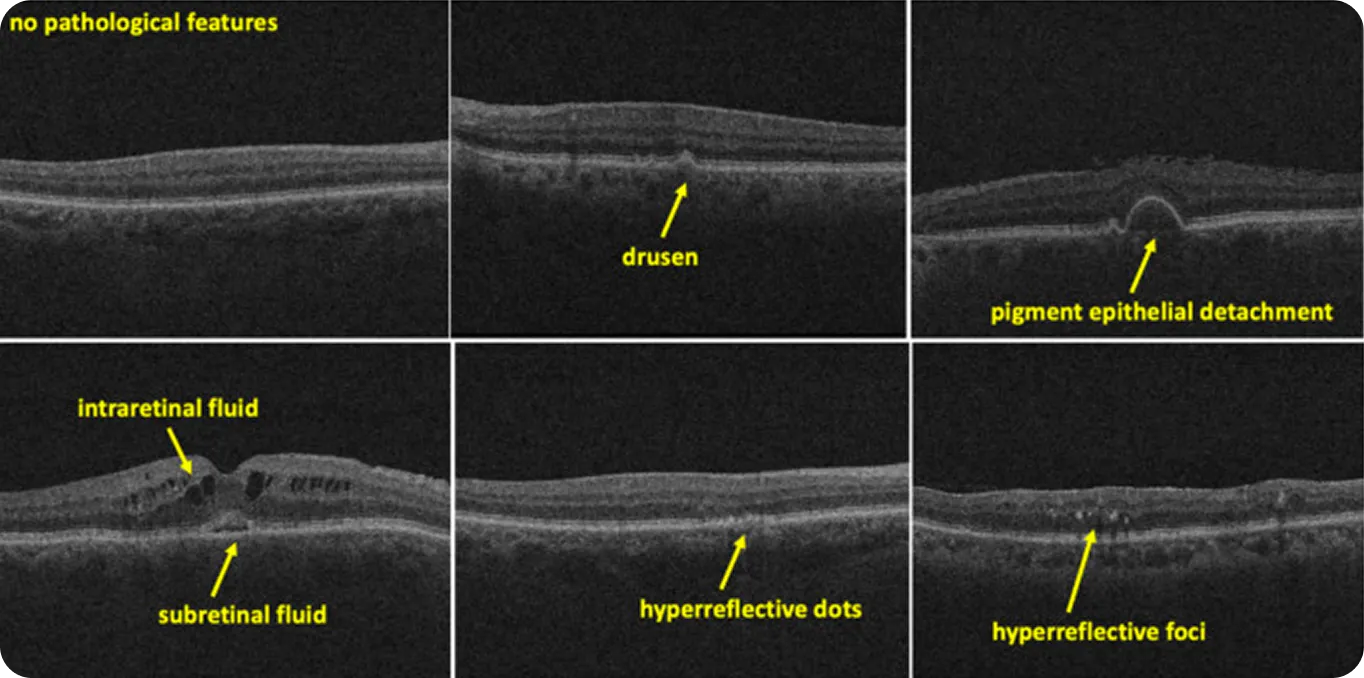

Когда речь идет об медицинской визуализации, даже незначительные различия в интерпретации могут привести к значительным изменениям в результатах. Например, радиологов часто просят идентифицировать закономерности, которые являются тонкими, неоднозначными или трудными для определения. Когда эти закономерности становятся данными для обучения систем ИИ, ставки становятся выше. Если эксперты по-разному маркируют одно и то же сканирование, модель может усвоить неправильные закономерности или вообще не усвоить их.

Межэкспертная надежность помогает командам, работающим с такими данными, оценить, насколько действительно согласованы экспертные оценки. Например, в недавнем исследовании, посвященном сканированию сетчатки глаза методом оптической когерентной томографии (ОКТ), два эксперта разметили 500 изображений.

Согласованность была высокой для четких признаков, таких как друзы (желтые отложения под сетчаткой), со значением каппа 0,87. Но для более сложных для определения элементов, таких как гиперрефлективные очаги (маленькие яркие пятна, видимые на сканах сетчатки), оценка упала до 0,33. Это показывает, что более четкие, более четко определенные признаки, как правило, дают более последовательные экспертные оценки, в то время как неоднозначные признаки оставляют больше места для интерпретации.

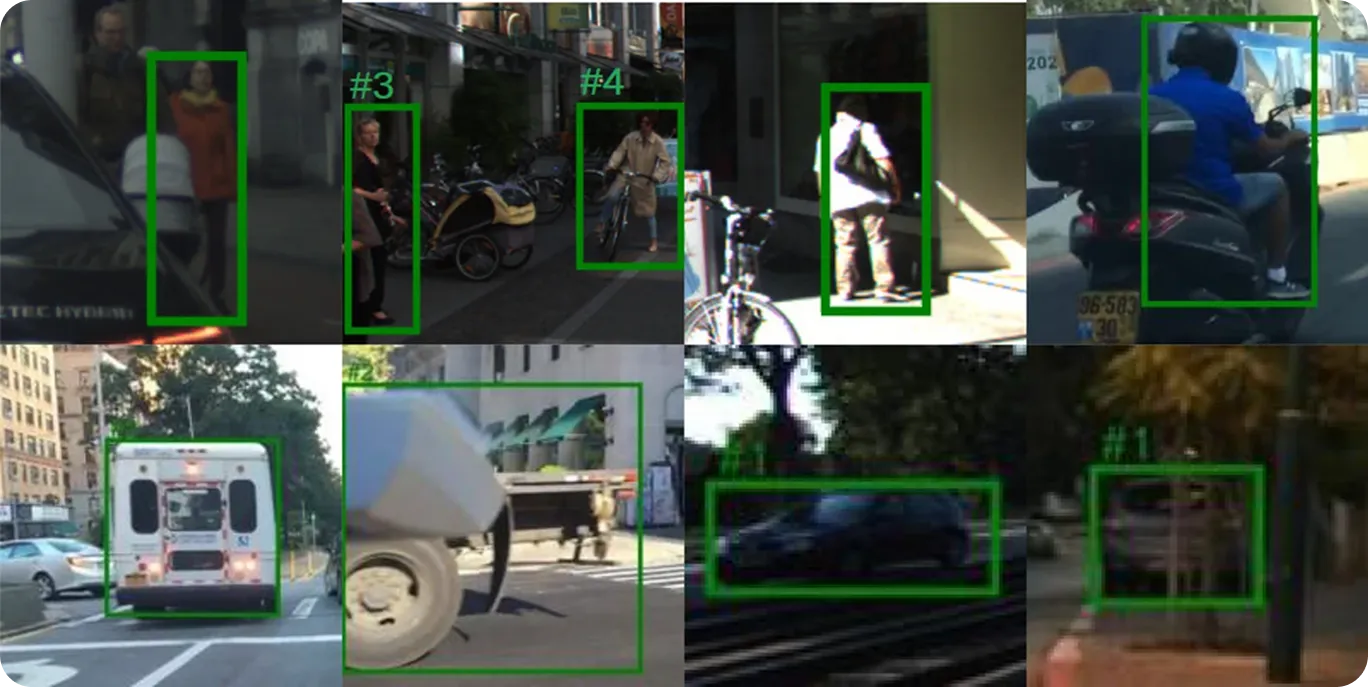

Обучение моделей ИИ для системы автономного вождения зависит от точных и последовательных меток в широком диапазоне дорожных условий. Аннотаторов, работающих над такими проектами, обычно просят идентифицировать пешеходов, транспортные средства, дорожные знаки и дорожную разметку, часто в условиях плохого освещения или в людных местах.

Эти решения определяют, как модель учится реагировать в суровых реальных условиях. Межэкспертная надежность позволяет командам проверять, применяются ли эти метки одинаково разными аннотаторами.

Хотя измерение согласованности оценок между экспертами является важным шагом в создании решения на основе ИИ, это часть более широкого процесса обеспечения качества. Вот некоторые другие методы, которые могут помочь улучшить качество данных в командах и проектах:

Межэкспертная надежность измеряет, насколько последовательно люди применяют метки или принимают решения. Такие методы, как каппа Коэна, каппа Флейсса и ICC, помогают количественно оценить это согласие. Благодаря четким инструкциям, обучению и контролю предвзятости надежные аннотации приводят к более качественным данным и лучшим результатам модели.

Присоединяйтесь к нашему сообществу и изучите наш репозиторий GitHub, чтобы узнать больше об ИИ. Если вы хотите начать свой собственный проект Vision AI, ознакомьтесь с нашими вариантами лицензирования, чтобы начать работу. Вы также можете узнать, как ИИ в здравоохранении и Vision AI в розничной торговле оказывают влияние, посетив страницы наших решений.