了解导航解决方案中的计算机视觉如何增强实时地图绘制、物体识别和增强现实技术,从而实现更智能、更安全的旅行体验。

了解导航解决方案中的计算机视觉如何增强实时地图绘制、物体识别和增强现实技术,从而实现更智能、更安全的旅行体验。

如今,拿出手机,输入目的地,然后按照逐步指示到达那里,感觉毫不费力。这只需要几秒钟的时间。但这种日常便利是多年技术进步的结果。导航已经走了很长一段路,从纸质地图和指南针到可以实时理解和响应世界的智能系统。

推动这一转变的技术之一是计算机视觉,它是人工智能 (AI) 的一个分支,使机器能够像人类一样解释视觉信息。目前,先进的导航工具使用来自卫星、行车记录仪和街道传感器提供的实时图像来提高地图的准确性、监控路况并引导用户通过复杂的环境。

在本文中,我们将探讨计算机视觉如何通过改进 GPS 地图、提供实时交通更新以及支持增强现实导航和自动驾驶汽车等技术来增强导航。

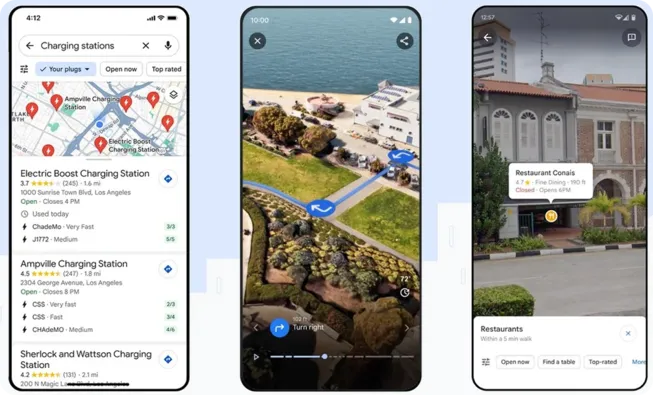

使用Google 地图等工具为日常生活导航已经变得非常普遍,无论你是要穿过城市还是寻找附近的咖啡馆。随着人工智能技术的广泛应用,我们看到了越来越先进的功能,比如Google 地图在 2023 年推出的沉浸式视图,它可以让用户在三维环境中预览部分行程。这是通过人工智能、摄影测量和计算机视觉的结合实现的。

这一切都始于一系列专用设备捕获的数十亿张高分辨率图像。这包括街景车,即配备 360 度摄像头并在城市中行驶的车辆,以及 Trekker 设备,即可穿戴的背包,带有安装的摄像头,用于捕获车辆无法到达的地方(如远足径或狭窄的小巷)的图像。

这些图像通过摄影测量技术与地图数据对齐。摄影测量是一种将从不同角度拍摄的 2D 照片拼接在一起,以创建精确的街道、建筑物和地形 3D 模型的技术。

然后,使用计算机视觉通过目标检测和 图像分割 来分析这些模型,以识别和标记重要的特征,例如道路标志、人行道、人行横道和建筑物入口。

标记数据用于训练AI系统,以识别视觉线索在不同区域的差异。例如,该系统可以轻松区分美国通常为黄色或橙色菱形的“SLOW”标志和日本通常为红色和白色三角形的类似标志。这种理解水平使导航体验更加准确和具有文化意识。

最后,沉浸式视图将实时导航路径叠加到 3D 环境中,提供流畅、直观的体验,准确显示您的前进方向。

我们可能都有过兜圈子的经历,试图搞清楚Google 地图为我们指明的方向。这种困惑正是增强现实(AR)导航所要解决的问题,它是一种将数字信息叠加到现实世界摄像头视图上的技术。它正在改变人们在城市街道或大型室内区域等繁忙场所的寻路方式。

普通的地图可能难以理解,尤其是在 GPS 信号较弱或无法正常工作时。AR 导航通过在真实世界的实时摄像头视图上显示数字方向、箭头和标签来解决这个问题。这意味着用户看到的引导与周围的街道和建筑物相匹配,从而更容易知道该往哪里走。

AR导航依赖于计算机视觉模型,通过设备的摄像头来理解环境。这涉及到各种任务,如图像定位,即检测建筑物边缘或街道标志等特征,并将它们与存储的地图进行匹配。同步定位与地图构建(SLAM)在实时跟踪设备位置的同时,创建环境地图。

例如,苏黎世机场率先使用Google 地图的实时视图进行室内导航。乘客可以使用手机摄像头看到叠加在现实环境中的箭头和指示,引导他们穿过航站楼到达登机口、商店和服务设施。这使复杂室内空间的导航变得更加容易,从而改善了乘客的体验。

城市街道每天都变得越来越繁忙。随着道路上汽车的增多、人行道的拥挤和持续不断的活动,保持交通顺畅和安全是一项日益严峻的挑战。为了帮助管理这种混乱,许多城市正在转向人工智能和计算机视觉。

安装在十字路口和道路沿线的智能摄像头和传感器可以捕捉到源源不断的视觉数据。这些画面经过实时处理,可用于detect 事故、监控交通流量、发现坑洼,以及捕捉违章停车或危险的行人行为。

中国杭州的智慧机场高速公路就是一个有趣的例子。这条连接杭州市中心和萧山国际机场的 20 公里高速公路已经升级,配备了高分辨率摄像头和毫米波雷达。这些设备持续收集视频和传感器数据,然后使用计算机视觉进行分析。

该系统不仅能记录画面,还能解读道路上发生的情况。计算机视觉算法可以detect 车辆碰撞、识别交通违规行为,甚至可以识别高速公路出口附近的行人或异常移动。这样,交通官员就可以在几秒钟内对事故做出反应,而无需亲临现场。

这些数据还被输入到数字孪生中:这是一个高速公路的实时 3D 虚拟模型,显示实时交通状况、车辆详细信息和新兴拥堵情况。交通管理人员监控此可视化界面以管理流量、发布智能警报并快速准确地响应事件。

如今,导航已远不止是从 A 点到达 B 点。它现在是智能系统的重要组成部分,这些智能系统可以移动人员、管理货物并做出实时决策——无论是在道路上还是在仓库内。

许多此类系统的核心是计算机视觉,它使机器能够解释视觉数据并立即对其周围环境做出反应。 让我们来看一些示例,了解这项技术如何改变不同环境中的导航。

机器人正变得对物流的未来至关重要,尤其是在大型仓库运营中。随着电子商务需求的增长,公司越来越依赖计算机视觉驱动的机器来导航复杂环境、分拣物品并快速准确地管理库存。

以 亚马逊的物流中心为例,超过 750,000 个机器人与人类协同工作,以保持运营高效运行。这些机器人严重依赖计算机视觉来在繁忙的仓库地面上导航、识别物品并做出快速、准确的决策。

Sequoia 就是这样一个系统,它是一个旨在加速库存处理的机器人平台。它使用先进的计算机视觉来扫描、计数和组织进货产品,从而帮助简化存储和检索流程。

同样,机器人手臂 Vulcan 使用摄像头和图像分析从货架上安全地拣选物品,根据每个物品的形状和位置调整其抓握力,甚至可以识别何时需要人工协助。与此同时,另一个支持视觉的机器人 Cardinal 专门用于分拣:它扫描混合的包裹堆,并将它们精确地放入正确的出站车中。

到目前为止,我们已经了解了计算机视觉如何帮助人类和机器人导航其环境。但它对于自动驾驶系统(如 自动驾驶汽车)也同样至关重要,在这些系统中,导航完全取决于车辆可以实时看到和理解的内容。

一个很好的例子是 特斯拉视觉系统。特斯拉已采用纯摄像头方法来实现自动驾驶,取消了雷达和其他传感器,转而使用摄像头网络来提供车辆周围 360 度的全方位视野。这些摄像头将视觉数据馈送到完全自动驾驶 (FSD) 计算机,该计算机使用深度神经网络来解释环境并做出瞬间驾驶决策。

该系统根据其所看到的内容来决定何时转向、加速、制动或变换车道——就像人类驾驶员一样,但完全通过视觉输入。 特斯拉通过收集和学习其车队中海量的真实驾驶数据,不断改进该系统。

以下是在导航中使用计算机视觉的一些主要优势,尤其是在精度、安全性和实时决策至关重要的系统中:

虽然计算机视觉为导航带来了许多好处,但在实施此类解决方案时,还需要考虑一些重要的局限性。以下是一些需要记住的关键挑战:

计算机视觉正在通过使地图更具动态性、交通系统更智能以及移动性更易于访问来重塑导航。曾经的静态路线现在是实时的、交互式的体验——由沉浸式 3D 预览、AR 引导的方向和自动驾驶技术提供支持。

随着技术的进步,重点可能会转向使这些系统更具包容性、适应性和责任感。 不断进步将取决于提高各种环境中的准确性、保持可靠的性能以及保护用户隐私。 计算机视觉在导航中的未来在于构建不仅智能,而且在设计和影响方面也周到的解决方案。

加入我们不断壮大的社区!探索我们的GitHub仓库以了解关于人工智能的更多信息,并查看我们的许可选项以开始您的视觉人工智能项目。对零售业中的人工智能和农业中的计算机视觉等创新感兴趣吗?访问我们的解决方案页面以了解更多信息!