探索Ultralytics YOLO11 如何在监控和机器人等实际应用场景中YOLO11 快速精准的小型物体检测。

探索Ultralytics YOLO11 如何在监控和机器人等实际应用场景中YOLO11 快速精准的小型物体检测。

搭载视觉人工智能的无人机可在数百米高空飞行,仍需detect 视频画面中仅有几个像素大小detect 。事实上,在机器人技术、监控系统和遥感等应用领域,系统必须识别图像中极其微小的物体,这已成为普遍存在的技术挑战。

但传统目标检测模型往往难以胜任此类任务。图像和视频中的微小物体所呈现的视觉信息极为有限。简而言之,当模型观察这些物体时,可供学习或识别的细节内容寥寥无几。

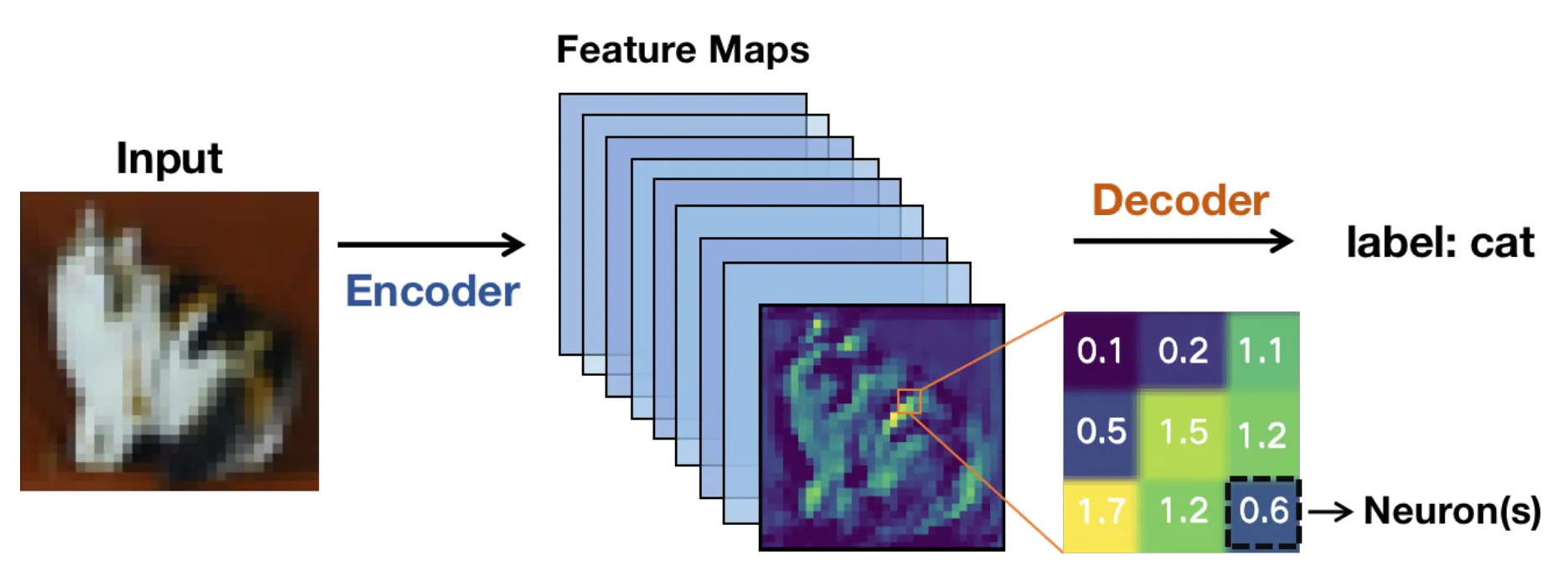

在技术层面,这些模型通常基于卷积神经网络(CNN)架构。图像通过网络各层处理后,会被转化为特征图或简化表示形式,这些表示突出了相关模式而非原始像素。

随着图像在网络中不断深入处理,这些特征图会逐渐缩小。这使得计算速度加快,但也意味着精细细节可能消失。

对于微小物体而言,这些细节至关重要。一旦这些细节消失,计算机视觉模型可能难以检测到该物体,从而导致边界框的准确性降低或出现不一致的情况。

实时端到端计算机视觉系统使问题更加棘手。高分辨率图像有助于保留细节,但会降低推理速度并消耗GPU 。低分辨率图像运行更快,但微小物体的detect难度随之增加。

这成为速度、准确性与硬件限制之间持续的平衡术。得益于近期技术进步,计算机视觉模型如 Ultralytics YOLO11 以及即将Ultralytics 计算机视觉模型,旨在更高效地管理这种权衡关系。

本文将探讨微小物体检测为何困难,以及YOLO11 如何简化这一过程。让我们开始吧!

小目标检测是人工智能分支计算机视觉中的一项任务,专注于识别和定位仅占据图像极小区域的物体。这些物体在图像中通常仅由有限数量的像素点构成——像素点是数字图像的最小单位。这使得它们detect 更大更清晰的目标(通常包含更多像素)更难被detect 。

例如,航空影像中的车辆、工厂车间里的工具,或是广角监控摄像头捕捉到的人群,在图像中都可能呈现为微小物体。检测这些物体至关重要,因为它们往往承载着关键信息,而许多现实应用(如监控系统)的正常运作都依赖于这些检测结果。

当遗漏小型物体时,系统性能和决策能力可能受到影响。无人机监控便是典型例证——若未能捕捉到地面上的微小移动物体,可能影响导航或追踪精度。

早期系统采用人工设计特征和传统计算机视觉方法,在复杂多变的场景中表现欠佳。即便在深度学习模型性能大幅提升的今天,当微小目标仅占据图像极小部分时,其检测仍面临挑战。

接下来,让我们看看在检测小型物体时,不同实际场景中常见的一些挑战。

小尺寸物体包含的像素极少,这限制了模型在特征提取等阶段所能学习到的视觉细节量。因此,边缘、形状和纹理等特征更难被detect,导致小尺寸物体更容易与背景融合。

当图像穿过神经网络的卷积层时,像素中的视觉信息会被逐步压缩成特征图。这有助于模型保持高效,但也意味着精细细节逐渐消失。

对于小型目标,关键特征可能在检测网络启动前就消失。此时定位可靠性下降,边界框可能发生偏移、重叠,甚至完全漏检目标物体。

遮挡现象也常引发与尺寸相关的挑战。当场景中物体(尤其是较小的物体)被其他物体部分遮挡时,就会发生遮挡现象。

这会减少目标的可见区域,从而限制物体检测器可获取的信息。即使是轻微的遮挡也可能干扰检测网络,尤其当结合低分辨率输入时。在VisDrone等无人机数据集中可见此现象的典型案例:行人、自行车或车辆可能被建筑物、树木或其他移动物体部分遮挡。

同样地,当同一物体因距离和摄像机位置不同而显得非常小或相对较大时,尺度变化会带来另一层挑战。尽管存在这些障碍,检测算法仍需在不同尺度下识别这些微小物体,且不影响检测精度。

上下文在检测中同样起着重要作用。例如,大型物体通常出现在清晰的环境中,这些环境能提供有用的视觉线索。另一方面,小型目标往往缺乏这种上下文信息,这使得模式识别变得更加困难。

常见的评估指标(如交并IoU)用于衡量预测边界框与真实边界框的重合程度。IoU 对较大目标IoU 良好,但对于小目标而言其表现则截然不同。

小目标仅占据少量像素,因此预测框的微小偏移便会产生比例失真,导致IoU 急剧下降。这意味着即使目标在图像中可见,小目标也常因达不到判定预测正确的标准IoU 而被排除在外。

因此,定位错误更可能被归类为假阳性或假阴性。这些局限性促使研究人员重新思考物体检测系统如何评估和处理微小且detect 。

随着研究人员致力于改进小目标检测技术,一个关键认识逐渐明晰:在多尺度层面完整保留并准确呈现视觉信息至关重要。这一洞见不仅体现在近期arXiv平台的研究成果中,更在IEEE国际会议、欧洲计算机视觉协会(ECCV)等学术平台发表的论文中得到广泛呼应。

随着图像在神经网络中不断深入处理,小目标可能丢失细节甚至完全消失,这正是现代计算机视觉模型(如YOLO11 )极度YOLO11 改进特征提取的原因。接下来,我们将深入解析特征图与特征金字塔网络的核心原理,以加深对它们的理解。

当输入图像(如遥感图像)进入神经网络时,会逐步转化为特征图。这些特征图是对图像的简化表示,突出了边缘、形状和纹理等视觉模式。

随着网络层级加深,这些特征图的空间尺寸逐渐缩小。这种缩减有助于模型高效运行并聚焦于高级信息。然而,特征图的缩小与加深也会导致空间细节的损失。

大型物体能保留足够的视觉信息以实现精准检测,而小型目标在经过几层网络处理后便可能丢失关键细节。一旦发生这种情况,模型甚至难以识别小型物体的存在。这正是深度目标检测模型中遗漏小型物体的主要原因之一。

特征金字塔网络(常称为FPN)的引入旨在解决空间细节丢失的问题,其作为辅助模块整合多层信息,使模型能更有效地detect 目标。该过程也被称为特征聚合与特征融合。

浅层提供精细的空间细节,深层则增添语义上下文,从而实现高效的多尺度特征学习。不同于单纯放大特征图的简单上采样,FPN能保留有效信息并提升小目标检测能力。

现代方法在此基础上,通过自适应特征融合和上下文感知设计进一步提升了对微小目标的检测能力。换言之,FPN使模型能够同时兼顾整体格局与微小细节。当目标尺寸微小时,这种优化至关重要。

以下简要展示了物体检测模型如何随着时间推移不断演进与进步,从而更好地detect 不同尺寸的detect ,包括极其微小的物体:

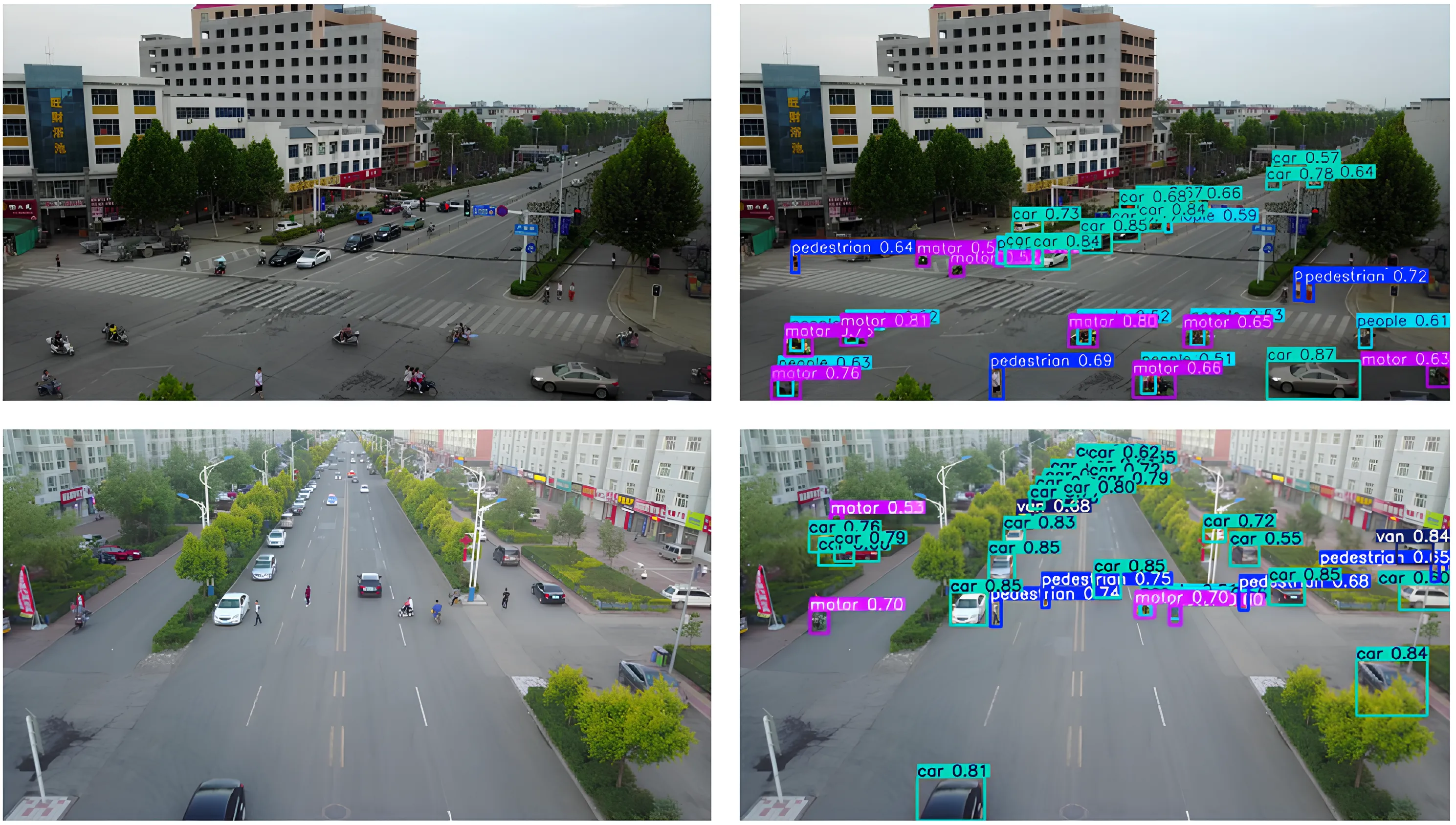

既然我们已经更深入地理解了小目标检测的工作原理,接下来让我们看看YOLO11 在现实世界中的几个应用场景。

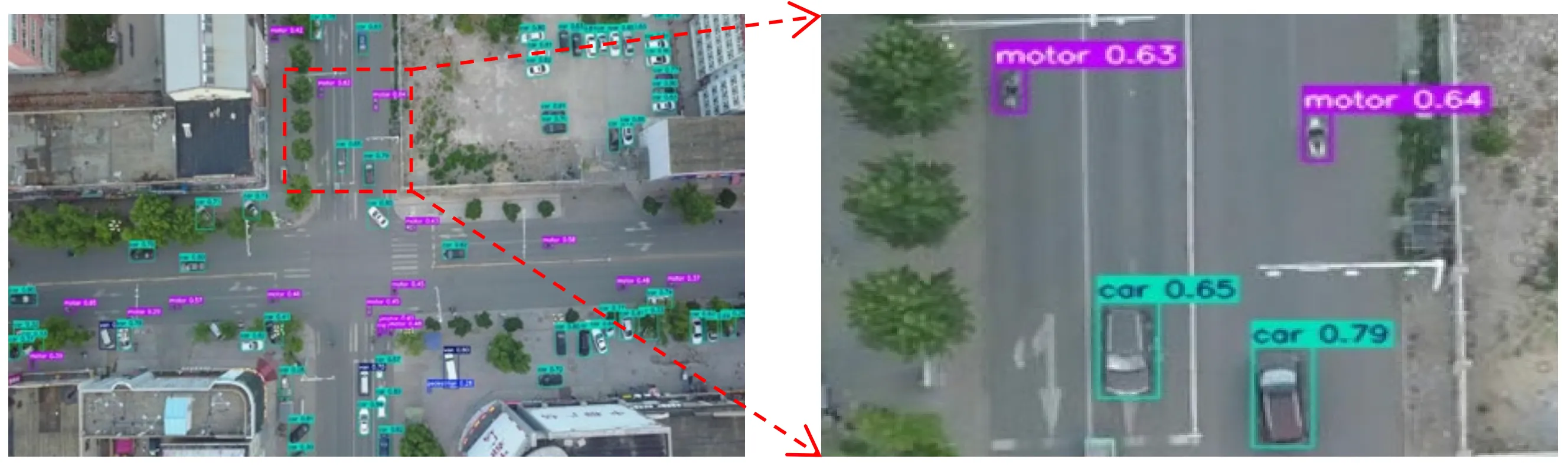

想象一架无人机在繁忙的城市街道上空盘旋。从那样的高度俯瞰,汽车、自行车乃至行人,都缩小成屏幕上寥寥几个像素点。

无人机和航空成像模块常会捕捉到此类场景:目标物体微小且被杂乱背景包围,这使得计算机视觉模型难以进行detect。

在这些场景中YOLO11 理想的模型选择。例如YOLO11 搭载YOLO11 模型的无人机YOLO11 实时监控交通状况,在场景中移动的车辆、自行车和行人即使仅占据图像的极小部分也能被精准识别。这使得在交通管理、公共安全或城市规划等应用中,决策速度得以提升,洞察力更为精准。

机器人常被应用于对精度和时效要求极高的环境。在仓库、工厂和农场等场景中,机器人可能需要识别极其微小的物体——例如装配线上的零件、包装上的标签或田间细小的植物芽苞——并迅速作出响应。

检测此类尺寸的物体可能相当复杂,尤其当它们在摄像头画面中仅呈现为几个像素点,或被其他物体部分遮挡时。遗漏这些细微细节可能导致自动化进程减缓,或影响机器人完成任务的能力。

YOLO11 这些场景中YOLO11 发挥关键作用。其增强的特征提取能力与快速推理特性,使机器人能够实时detect 物体并立即采取行动。

YOLO11 支持实例分割YOLO11 ,这能帮助机器人更精确地理解物体边界和抓取点,而非仅定位粗略的边界框。例如,集成YOLO11 的机械臂YOLO11 传送带上识别小型部件,精确segment 形状,并在部件移出可触及范围前完成拾取,从而保障系统的高效可靠运行。

面对如今琳琅满目的计算机视觉模型,您或许会好奇:Ultralytics YOLO11 究竟有何YOLO11 ?

Ultralytics YOLO11 需要检测小目标的应用场景中绝佳选择的几个原因:

除了使用YOLO11外,标注数据的准备方式、整体数据集以及模型训练流程都会对检测性能产生显著影响。

以下是重点关注事项的简要概述:

小目标检测之所以困难,是因为当图像通过计算机视觉模型处理时,微小目标会丢失细节。YOLO11 细节保留机制,在不牺牲实时性能的前提下提升了小目标检测的可靠性。这种平衡YOLO11 实际应用中实现精准高效的检测。

加入我们不断壮大的社区!探索我们的GitHub 代码仓库,以了解更多关于人工智能的信息。访问我们的解决方案页面,了解零售领域的计算机视觉和汽车行业的人工智能等创新应用。要立即开始使用计算机视觉进行构建,请查看我们的许可选项。

.webp)

.webp)