Apple 在 CVPR 2025 大会上发布 FastVLM。这款开源视觉语言模型采用了 FastViTHD 编码器,首次生成令牌 (time-to-first-token) 的速度提升高达 85 倍。

Apple 在 CVPR 2025 大会上发布 FastVLM。这款开源视觉语言模型采用了 FastViTHD 编码器,首次生成令牌 (time-to-first-token) 的速度提升高达 85 倍。

在CVPR 2025 会议上,Apple 推出了一款名为 FastVLM 的新型开源 AI 模型。它旨在理解图像和语言,并且可以在 iPhone、iPad 和 Mac 等 Apple 设备上运行。这意味着它可以快速提供智能结果,而无需将您的数据发送到云端。

FastVLM 尤其引人关注的地方在于其速度和效率。Apple 开发了一种名为 FastViTHD 的新型视觉编码器,该编码器有助于模型在消耗更少内存和功耗的同时,解释高质量图像。所有处理都在本地设备上进行,从而在保护用户隐私的同时,加快了响应速度。

在本文中,我们将探讨 FastVLM 的工作原理、它的独特之处,以及为什么 Apple 的这一发布可能是日常 AI 应用在您的设备上向前迈出的重要一步。

在深入探讨 FastVLM 的特别之处之前,让我们先了解一下其名称中的“VLM”代表什么。它指的是视觉语言模型,旨在理解和连接视觉内容与语言。

VLM 将视觉理解和语言结合在一起,使它们能够执行诸如描述照片、回答有关屏幕截图的问题或从文档中提取文本之类的任务。视觉语言模型通常分两个部分工作:一部分处理图像并将其转换为数据,另一部分解释该数据以生成您可以阅读或听到的响应。

您可能已经在不知不觉中使用了这种 AI 创新。扫描收据、读取身份证、生成图像标题或帮助弱视人士与屏幕交互的应用程序通常依赖于在后台静默运行的视觉语言模型。

Apple 构建了 FastVLM 来执行与其他视觉语言模型相同的任务,但速度更快、隐私性更强,并在其自己的设备上进行了优化。它可以理解图像的内容并以文本回复,但与许多依赖云服务器的模型不同,FastVLM 可以完全在您的 iPhone、iPad 或 Mac 上运行。

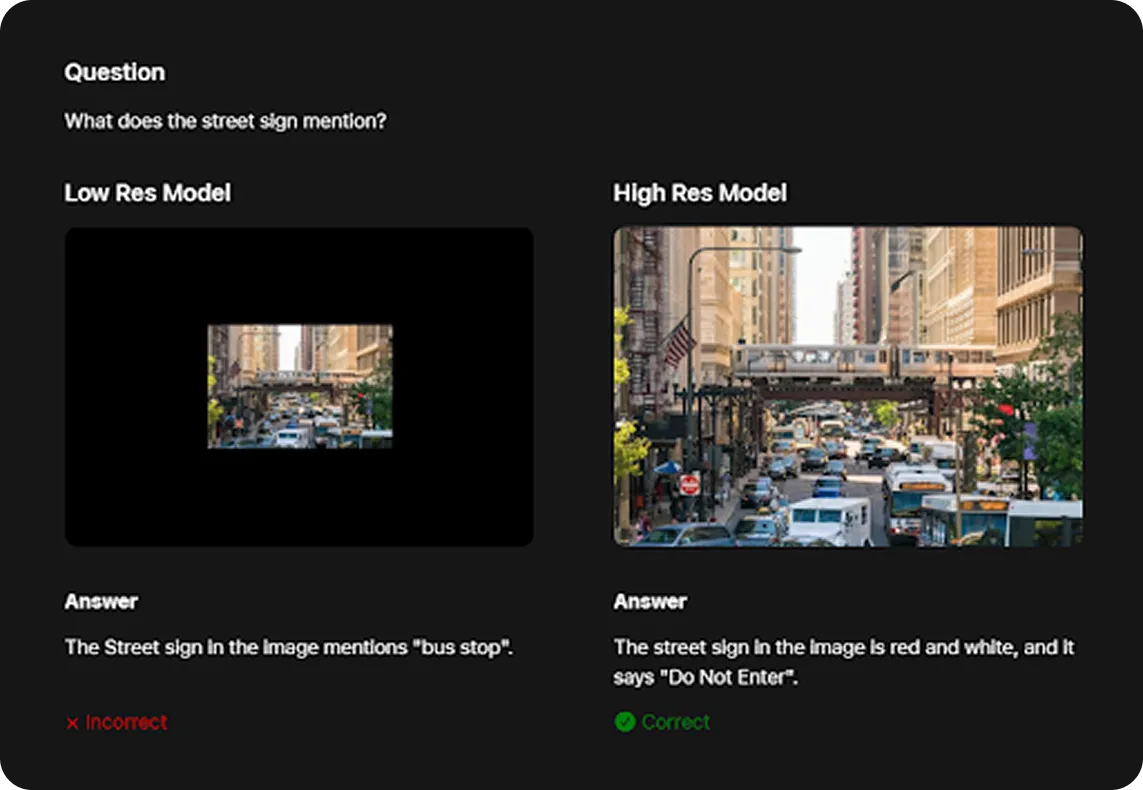

VLM 通常在高分辨率图像下表现更好。例如,如下所示,FastVLM 只有在获得图像的高分辨率版本时才能正确地将街道标志识别为“禁止驶入”。但是,高分辨率输入通常会降低模型速度。这就是 FastViTHD 发挥作用的地方。

Apple 新推出的视觉编码器 FastViTHD 帮助 FastVLM 更高效地处理高质量图像,同时降低内存和功耗。具体来说,FastViTHD 非常轻量,即使在小型设备上也能流畅运行。

此外,FastVLM 在 FastVLM GitHub 存储库上公开发布,开发人员可以在其中访问源代码、进行更改,并根据 Apple 的许可条款将其用于自己的应用程序中。

与其他视觉语言模型相比,FastVLM 经过优化,可在智能手机和笔记本电脑等日常设备上运行。在性能测试中,FastVLM 生成其第一个单词或输出的速度比 LLaVA-OneVision-0.5B 等模型快 85 倍。

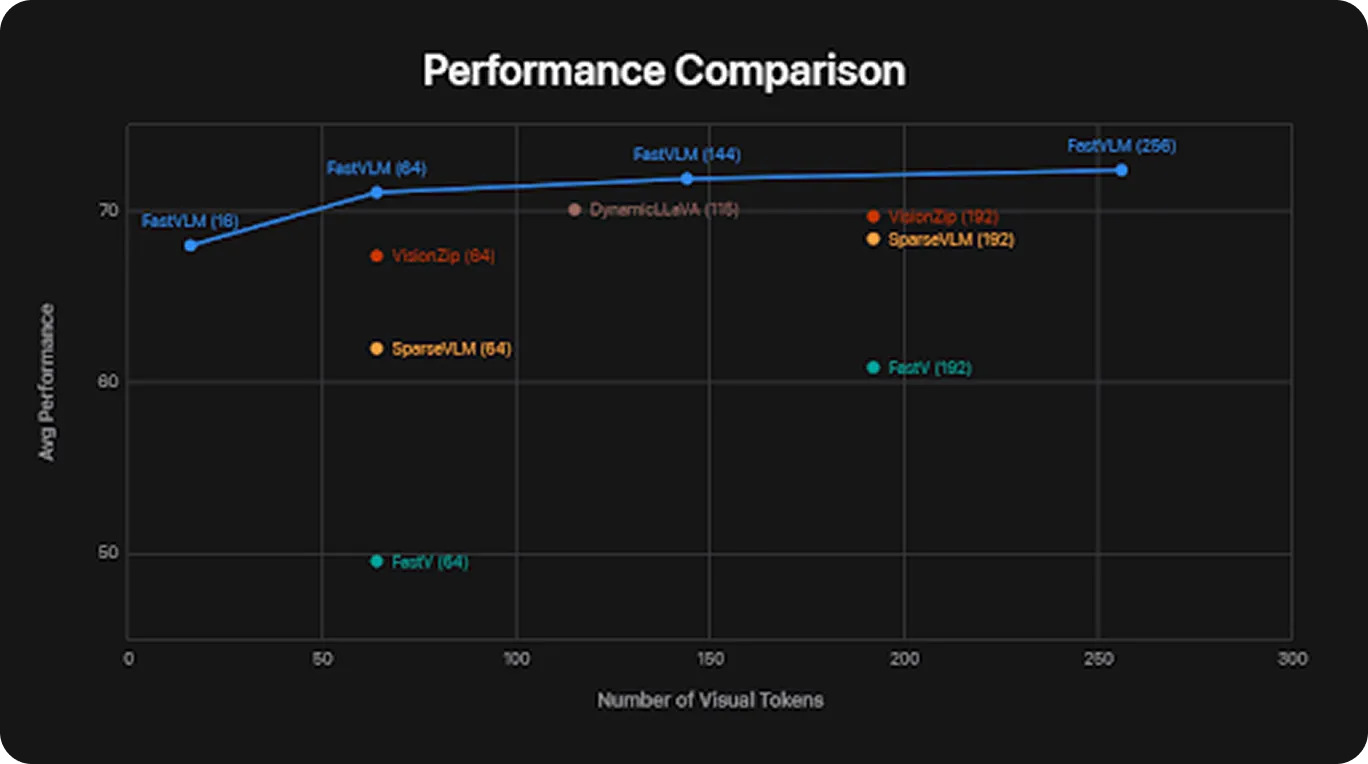

以下是 FastVLM 经过评估的一些标准基准测试概览:

在这些基准测试中,FastVLM 在使用更少资源的同时取得了有竞争力的结果。它将实用的视觉 AI 带到手机、平板电脑和笔记本电脑等日常设备上。

接下来,让我们仔细了解 FastViTHD,这是一种视觉编码器,在 FastVLM 的图像处理性能中起着至关重要的作用。

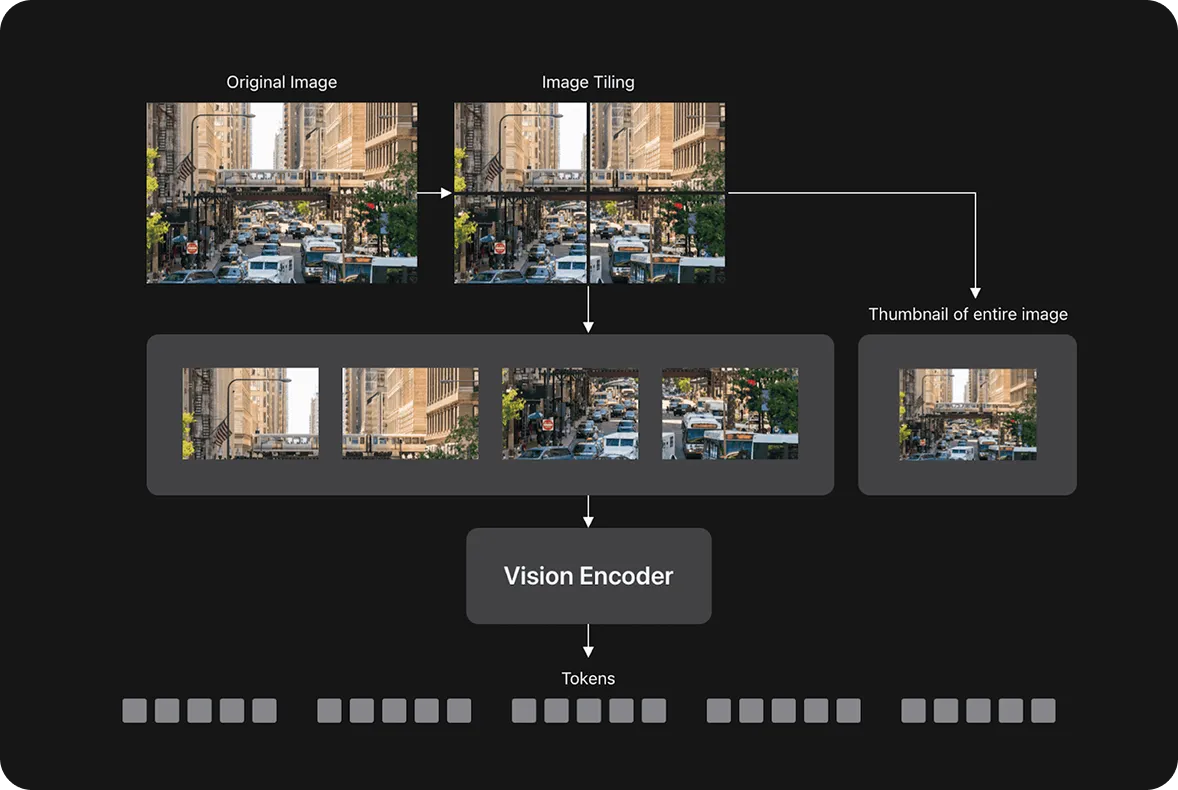

大多数视觉语言模型将图像分成数千个称为令牌的小块。 令牌越多,模型理解图像所需的时间和功率就越多。 这会使事情变慢,尤其是在手机或笔记本电脑上。

FastViTHD 通过减少使用的 tokens 数量来避免处理过多 tokens 带来的速度下降,同时仍然能够理解完整的图像。它结合了两种方法:transformers(转换器),擅长建模模式和关系;以及 卷积层,擅长处理视觉数据。最终形成一个工作更快、占用内存更少的系统。

根据 Apple 的说法,FastViTHD 比一些传统的视觉编码器小 3.4 倍,同时仍保持高精度。它没有依赖诸如令牌修剪(删除不太重要的图像块以加快处理速度)之类的模型优化技术,而是通过更简单、更精简的架构来实现效率。

Apple 发布了三种不同尺寸的 FastVLM:0.5B、1.5B 和 7B 参数(其中“B”代表十亿,指的是模型中可训练权重的数量)。每个版本都旨在适应不同类型的设备。较小的模型可以在手机和平板电脑上运行,而较大的 7B 模型更适合桌面或更苛刻的任务。

这使开发人员能够灵活地选择最适合其应用程序的方案。他们可以构建快速轻量级的移动应用,或者为大型系统构建更复杂的应用,所有这些都使用相同的底层模型架构。

Apple 使用 LLaVA-1.5 管道训练了 FastVLM 模型变体,LLaVA-1.5 管道是一个用于对齐视觉和语言模型的框架。对于语言组件,他们使用现有的开源模型(如 Qwen 和 Vicuna)评估了 FastVLM,这些模型以生成自然且连贯的文本而闻名。这种设置允许 FastVLM 处理简单和复杂的图像,并生成可读、相关的响应。

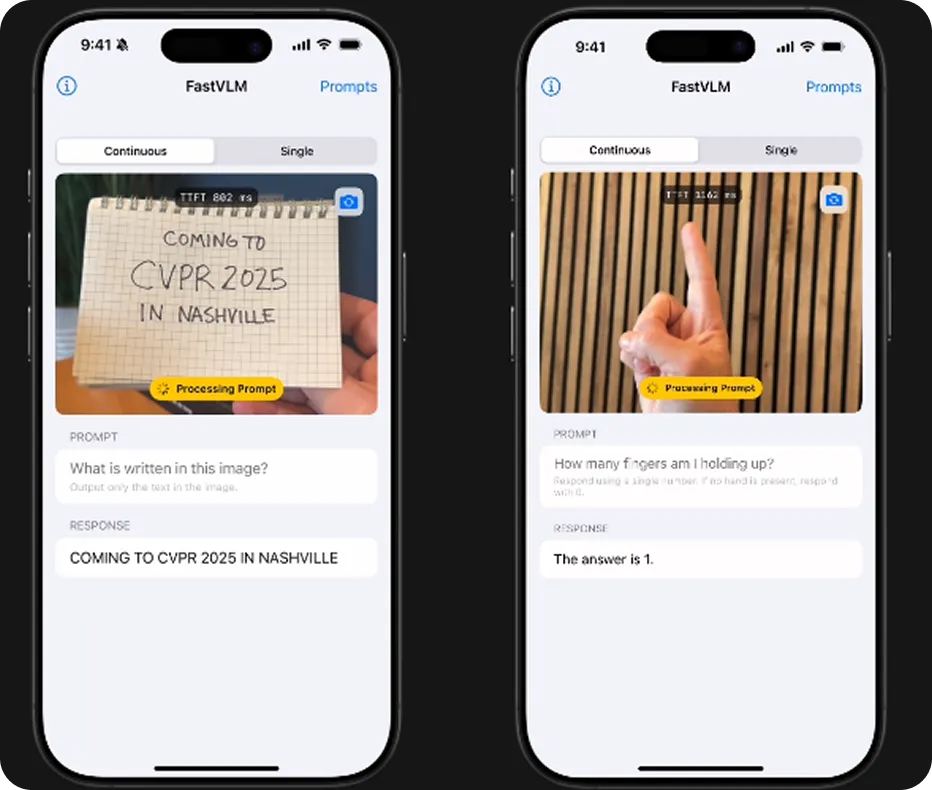

您可能想知道,FastVLM 高效的图像处理为什么重要?这归结为应用程序在不依赖云的情况下实时运行的流畅程度。FastVLM 可以处理高达 1152 x 1152 像素的高分辨率图像,同时保持足够的速度和轻便性,可以直接在您的设备上运行。

这意味着应用程序可以描述相机看到的内容,在捕获时扫描收据,或响应屏幕上的变化,同时保持一切都在本地进行。它对教育、辅助功能、生产力和摄影等领域尤其有帮助。

由于 FastViTHD 即使在处理大型图像时也很高效,因此它有助于保持设备的响应速度和凉爽。它适用于所有模型尺寸,包括最小的模型,该模型可在入门级 iPhone 上运行。这意味着相同的人工智能功能可以在手机、平板电脑和 Mac 上运行。

FastVLM 具有速度、效率和设备端隐私等关键优势,因此可以支持广泛的应用。以下是它的一些用途:

设备端 AI 助手: FastVLM 可以很好地与需要快速了解屏幕上内容的 AI 助手配合使用。由于它直接在设备上运行并保护数据隐私,因此它可以帮助完成诸如阅读文本、识别按钮或图标以及实时指导用户等任务,而无需将信息发送到云端。

FastVLM 将设备端视觉语言 AI 带到 Apple 设备,结合了速度、隐私和效率。凭借其轻量级设计和开源发布,它能够在移动和桌面应用程序中实现实时图像理解。

这有助于使 AI 更实用,更易于日常使用,并为开发人员构建有用的、注重隐私的应用程序奠定了坚实的基础。展望未来,视觉语言模型可能会在我们与技术互动的方式中发挥重要作用,从而使 AI 在日常情况下更具响应性、上下文感知能力和实用性。

探索我们的GitHub 仓库以了解更多关于 AI 的信息。加入我们活跃的社区,探索汽车行业中的 AI和制造业中的视觉 AI等领域的创新。要立即开始使用计算机视觉,请查看我们的许可选项。