了解Ultralytics 如何通过渐进式损失平衡、小目标感知标签分配以及MuSGD优化器实现更可靠的训练。

.webp)

了解Ultralytics 如何通过渐进式损失平衡、小目标感知标签分配以及MuSGD优化器实现更可靠的训练。

.webp)

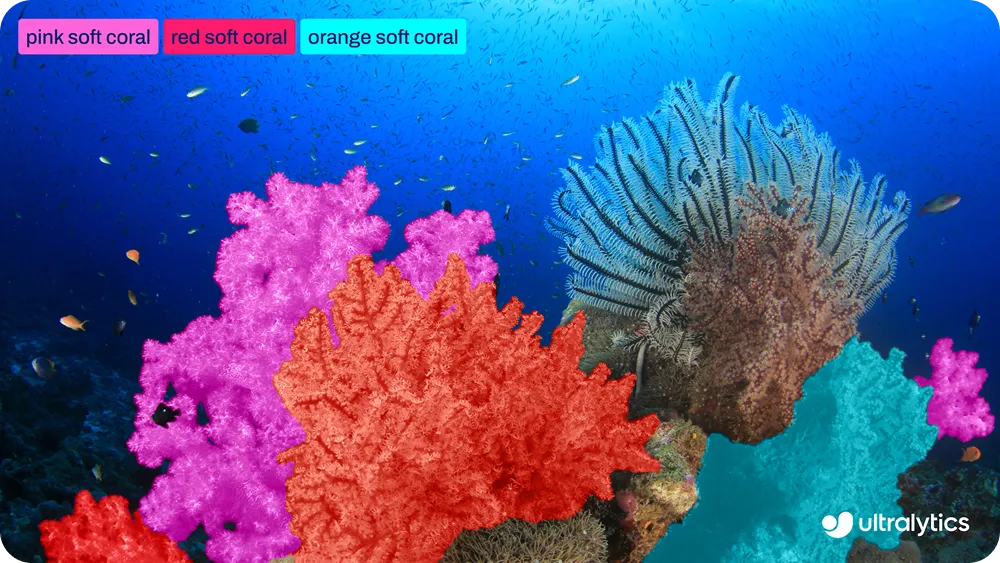

上周,我们Ultralytics 为边缘优先的实时计算机视觉模型树立了新标杆。与之前的Ultralytics YOLO 类似,例如 Ultralytics YOLO11,YOLO26支持用户熟悉的核心计算机视觉任务,包括目标检测、实例分割和姿势估计 。

然而,YOLO26并非简单的迭代更新。尽管其支持的任务看似熟悉,但该新模型在计算机视觉模型的训练方式上实现了创新性突破。YOLO26的关注点不仅限于推理效率,更致力于提升训练过程的稳定性。

YOLO26的设计充分考虑了完整的训练生命周期。这意味着更快的收敛速度、更可靠的训练过程以及一致的模型行为。这些改进在实际工作流程中尤为重要,因为训练可靠性直接影响模型迭代和部署的速度。

为实现这一目标,YOLO26引入了多项针对性训练创新,包括渐进式损失平衡(ProgLoss)、小目标感知标签分配(STAL)以及MuSGD优化器。这些改进共同优化了学习损失的平衡机制、标签分配策略以及随时间推移的优化行为。

本文将探讨这些机制各自的运作原理,以及它们如何Ultralytics 更易于训练,并在大规模应用中更具可靠性。让我们开始吧!

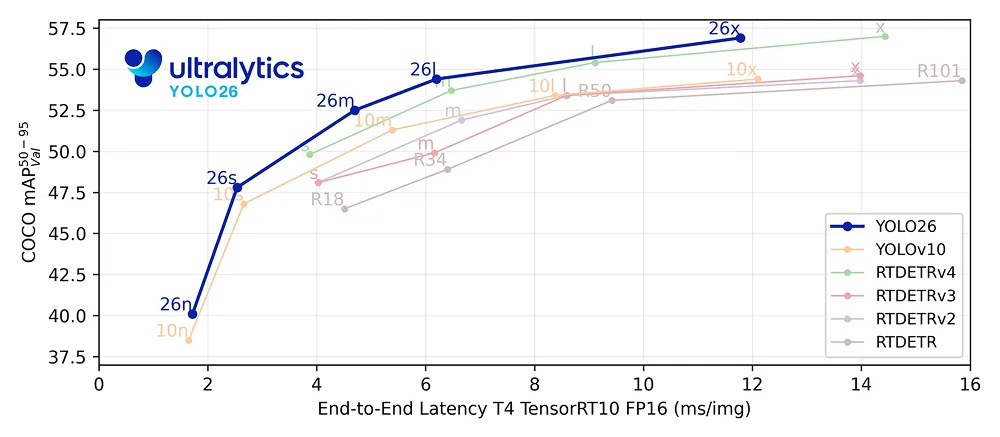

Ultralytics 通过消除对非最大抑制等后处理步骤的依赖,原生优化了整个推理管道。它不再生成大量重叠预测结果再进行后续过滤,而是直接从网络中输出最终检测结果。

这使得YOLO26成为一种端到端模型,其中预测、重复检测和最终输出均在网络内部完成学习。这种设计简化了部署流程,提升了推理效率,同时塑造了模型在训练过程中的学习方式。

在这样的端到端系统中,训练与推理紧密相连。由于不存在后期校正预测结果的外部后处理阶段,模型必须在训练过程中学会做出清晰且自信的决策。

这使得训练目标与推理行为的协调尤为重要。模型训练方式与推理时使用方式之间的任何不匹配,都可能导致学习不稳定或收敛速度变慢。

YOLO26通过从设计之初就围绕实际应用场景构建训练流程来解决这一问题。该训练系统不仅关注推理速度,更致力于支持长期稳定学习、实现从Nano到超大型等不同规模模型的统一收敛,并在多样化数据集上保持强健性能。

Ultralytics 中的关键训练创新之一,是在先前YOLO 采用的双头训练方法基础上进行的。在目标检测模型中,"头"指的是负责进行预测的网络部分。

换言之,检测头通过回归边界框坐标来学习预测图像中物体的位置及其类别,这意味着它们能够估计输入图像中每个物体的位置和尺寸。

在训练过程中,模型通过最小化损失函数来学习,该函数是衡量其预测结果与正确答案或真实值之间偏差的数值指标。较低的损失值表明模型预测更接近真实值,而较高的损失值则意味着更大的预测误差。损失函数的计算过程指导着模型在训练期间如何更新其参数。

YOLO26在训练过程中使用两个检测头,它们共享相同的底层模型但服务于不同目的。一对一检测头是推理阶段使用的检测头。它学会将每个目标与单一的高置信度预测关联起来,这对YOLO26的端到端、NMS的设计至关重要。

与此同时,一对多头仅在训练阶段使用。它允许将多个预测结果关联到同一对象,从而提供更密集的监督。这种更丰富的学习信号有助于稳定训练过程并提升准确性,尤其在训练初期效果显著。

在YOLO26中,两个头部都采用相同的损失计算方式进行框回归和分类。早期实现方案在整个训练过程中对这两种损失信号应用了固定的平衡。

然而在实际应用中,各监督头的重要性会随时间变化。密集监督在训练初期最为有效,而随着训练推进,与推理行为的协调性变得愈发重要。YOLO26正是基于这一洞察进行设计,这直接决定了其在训练过程中如何重新平衡学习信号。

那么,Ultralytics 如何在训练过程中应对这些不断变化的学习需求呢?它通过渐进式损失平衡机制,动态调整学习信号随时间推移的权重分配。

ProgLoss通过动态调整每个头部对总损失的贡献来实现效果。在训练初期,系统会赋予一对多头部更高的权重,以稳定学习过程并提升召回率。随着训练的深入,权重分配逐渐向一对一头部倾斜,使训练过程更贴近推理行为。

这种渐进式过渡使YOLO26能够按正确顺序进行学习。渐进式损失平衡机制避免了强迫模型同时优化相互冲突的目标,而是优先处理训练各阶段中最有价值的学习信号。由此实现更平滑的收敛过程,减少不稳定的训练运行次数,并获得更稳定的最终性能表现。

Ultralytics 训练机制的另一项改进在于模型如何为预测结果分配训练目标,这一过程称为标签分配。该机制负责将真实目标与候选预测(通常称为锚点)进行匹配。

这些匹配决定了哪些预测会受到监督并影响损失值。YOLO26基于现有的标签分配方法——任务对齐学习(TAL),该方法旨在更好地协调训练过程中的分类与定位任务。

虽然TAL模型对大多数物体效果良好,但训练过程中暴露了一个重要局限:在匹配过程中,极小物体可能完全被忽略。实际应用中,在640像素输入图像中,小于约8像素的物体往往无法获得任何锚点分配。这种情况下,模型对这些物体几乎无法获得监督信息,导致难以可靠地学习detect 。

为解决此问题,YOLO26引入了小目标感知标签分配(STAL)机制。该机制通过调整分配流程,确保训练过程中不会忽略小目标。具体而言,它强制要求小于8像素的物体至少获得四个锚点分配,从而保证即使微小目标也能持续贡献训练损失。

通过强化对小型目标的监督,STAL在常见小型或远距离物体的场景中显著提升了学习稳定性和检测性能。这种改进对边缘优先的YOLO26应用 尤为重要,例如航空影像、机器人技术和物联网(IoT)系统——这些场景中物体往往体积小、距离远或部分可见,可靠检测至关重要。

为支持更稳定、更可预测的训练Ultralytics 还引入了名为MuSGD的新优化器。该优化器旨在提升端到端检测模型的收敛性和训练可靠性,尤其在模型规模和训练复杂度增加时效果显著。

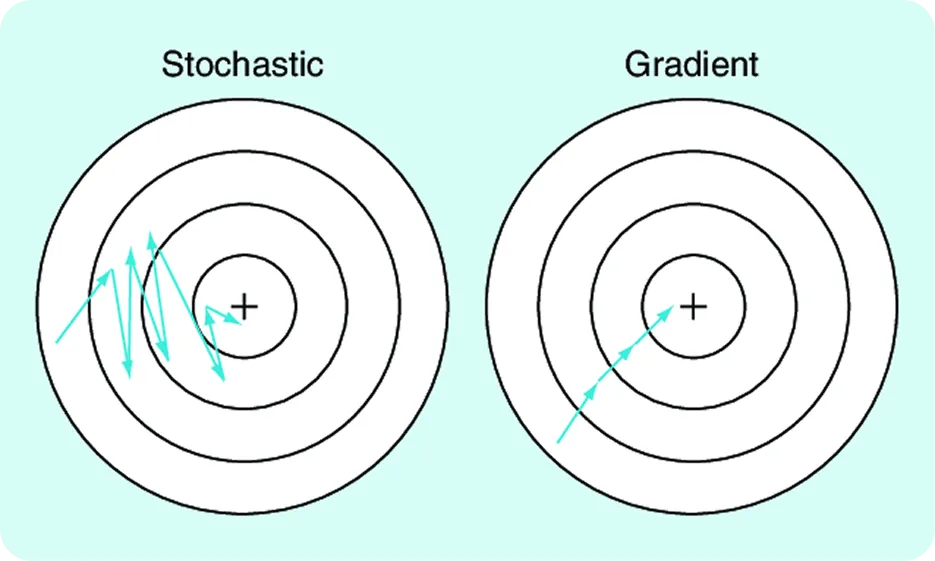

为了使神经网络在训练过程中能够学习并相应调整权重,我们计算一个误差(也称为"损失")。因此,模型通过损失值衡量其预测的偏差程度,计算出指示参数应如何调整的梯度,然后更新这些参数以减少误差。随机梯度下降(SGD)是一种广泛使用的优化器,它执行这些更新操作,使训练过程高效且可扩展。

MuSGD在此熟悉的基础上,融入了受大型语言模型训练方法Muon启发的优化理念。这些理念受到近期进展的影响,例如Moonshot AI的Kimi K2模型——该模型通过更结构化的参数更新,展现出优化的训练行为。

YOLO26采用混合更新策略。部分参数通过结合受μ子启发的更新与SGD进行更新,其余参数则SGD 使用SGD 。这种设计使YOLO26能够在优化过程中引入额外结构,同时保持梯度下降的鲁棒性和泛化能力——正是这些特性SGD 。

其结果是优化过程更平滑、收敛更快,且在不同模型规模下训练行为更可预测,这使得MuSGD成为YOLO26更易训练且在大规模应用中更可靠的关键因素。

Ultralytics 训练创新,结合其端到端、NMS和边缘优先等关键特性,使该模型更易于训练且在大规模应用中更可靠。您或许会好奇,这对计算机视觉应用究竟意味着什么。

在实际应用中,它使计算机视觉技术更轻松地部署到实际运行环境。模型训练过程更具可预测性,不同规模下的扩展性更一致,且更易于适应新数据集。这有效降低了实验与部署之间的摩擦,尤其在那些对可靠性、效率要求与原始性能同等重要的场景中。

例如,在机器人和工业视觉应用中,随着环境、传感器或任务的变化,模型往往需要频繁地重新训练。借助YOLO26,团队能够更快地迭代,无需担心训练过程不稳定或不同模型尺寸间行为不一致的问题。

可靠的计算机视觉系统不仅取决于模型在推理时的表现,更取决于其训练过程的稳定性。通过优化学习信号的平衡机制、微小物体处理方式以及优化流程的推进方式,YOLO26显著提升了训练过程的稳定性并增强了可扩展性。这种对可靠训练的专注,助力团队更顺畅地从实验阶段过渡到实际部署,尤其在边缘优先的应用场景中效果显著。

想了解人工智能?访问我们的GitHub仓库获取更多信息。加入活跃的社区,探索物流领域的人工智能和 汽车行业的视觉人工智能等创新应用。立即开始计算机视觉之旅,查看我们的许可方案。

.webp)

.webp)