Erfahren Sie, wie SAM 3, das neue Segment Anything Model von Meta AI, das detect, segment und track Objekten in realen Bildern und Videos erleichtert.

Erfahren Sie, wie SAM 3, das neue Segment Anything Model von Meta AI, das detect, segment und track Objekten in realen Bildern und Videos erleichtert.

Am 19. November 2025 veröffentlichte Meta AI das Segment Anything Model 3, auch bekannt als SAM 3. Diese neueste Version des Segment Anything Model bietet neue Möglichkeiten zur detect, segment und track von Objekten in realen Bildern und Videos mithilfe von Textaufforderungen, visuellen Aufforderungen und Bildbeispielen.

Das SAM 3-Modell baut auf folgenden Elementen auf SAM und SAM 2 auf und bietet neue Verbesserungen und Funktionen wie Konzept-Segmentierung, Erkennung von offenem Vokabular und Video-Tracking in Echtzeit. Es kann kurze Substantivphrasen verstehen, Objekte über Frames hinweg verfolgen und feinkörnige oder seltene Konzepte identifizieren, die frühere Modelle nicht so konsequent verarbeiten konnten.

Als Teil der SAM 3 Version hat Meta auch SAM 3D eingeführt. Diese Suite von Modellen der nächsten Generation rekonstruiert Objekte, Szenen und ganze menschliche Körper aus einem einzigen Bild und erweitert das Segment Anything-Ökosystem um 3D-Verständnis. Diese Ergänzungen eröffnen neue Anwendungen in den Bereichen Computer Vision, Robotik, Medienbearbeitung und kreative Workflows.

In diesem Artikel werden wir untersuchen, was SAM 3 ist, was es von SAM 2 unterscheidet, wie das Modell funktioniert und wie es in der Praxis angewendet wird. Legen wir los!

SAM 3 ist ein hochmodernes Computer-Vision-Modell, das auf der Grundlage einfacher Anweisungen Objekte in Bildern und Videos identifizieren, trennen und track kann. Anstatt sich auf eine feste Liste von Bezeichnungen zu verlassen, versteht SAM 3 natürliche Sprache und visuelle Hinweise, so dass es einfach ist, dem Modell mitzuteilen, was Sie finden möchten.

Mit SAM 3 können Sie zum Beispiel einen kurzen Satz wie "gelber Schulbus" oder "gestreifte Katze" eingeben, auf ein Objekt klicken oder ein Beispiel in einem Bild markieren. Das Modell detect dann jedes übereinstimmende Objekt und erstellt saubere Segmentierungsmasken (ein visueller Umriss, der genau zeigt, welche Pixel zu einem Objekt gehören). SAM 3 kann diese Objekte auch über Videobilder hinweg verfolgen und sie konsistent halten, während sie sich bewegen.

Ein weiterer spannender Teil der Ankündigung von Meta AI ist SAM 3D, das das Segment Anything Projekt auf das 3D-Verständnis erweitert. SAM 3D kann ein einzelnes 2D-Bild nehmen und die Form, Haltung oder Struktur eines Objekts oder eines menschlichen Körpers in drei Dimensionen rekonstruieren. Mit anderen Worten: Das Modell kann abschätzen, wie etwas den Raum einnimmt, auch wenn nur ein Blickwinkel verfügbar ist.

SAM 3D wurde als zwei verschiedene Modelle veröffentlicht: SAM 3D Objects, das Alltagsgegenstände mit Geometrie und Textur rekonstruiert, und SAM 3D Body, das die Form und Haltung des menschlichen Körpers aus einem einzigen Bild schätzt. Beide Modelle verwenden die Segmentierungsergebnisse von SAM 3 und erzeugen dann eine 3D-Darstellung, die mit dem Aussehen und der Position des Objekts im Originalfoto übereinstimmt.

Im Folgenden finden Sie einige der wichtigsten Neuerungen von SAM 3, die Erkennung, Segmentierung und Verfolgung in einem einheitlichen Modell vereinen:

Angenommen, Sie sehen sich ein Safari-Video mit vielen verschiedenen Tieren an und möchten nur die Elefanten detect und segment . Wie würde diese Aufgabe in den verschiedenen Versionen von SAM aussehen?

Bei SAM müssten Sie manuell auf jeden Elefanten in jedem Bild klicken, um eine Segmentierungsmaske zu erstellen. Es gibt keine Nachverfolgung, so dass jedes neue Bild neue Klicks erfordert.

Mit SAM 2 konnten Sie einmal auf einen Elefanten klicken, um seine Maske zu erhalten, und das Modell würde denselben Elefanten durch das Video track . Wenn Sie jedoch mehrere Elefanten (bestimmte Objekte) segment wollten, müssten Sie immer noch separate Klicks durchführen, da SAM 2 Kategorien wie "Elefant" nicht von sich aus versteht.

Mit SAM 3 wird der Arbeitsablauf viel einfacher. Sie können "Elefant" eingeben oder eine Bounding Box um einen einzelnen Elefanten zeichnen, um ein Beispiel zu liefern, und das Modell findet automatisch jeden Elefanten im Video, segment ihn und track ihn konsistent über alle Frames. Es unterstützt nach wie vor die Klick- und Box-Eingabeaufforderungen, die in früheren Versionen verwendet wurden, aber jetzt kann es auch auf Textaufforderungen und Beispielbilder reagieren, was SAM und SAM 2 nicht konnten.

Schauen wir uns nun genauer an, wie das SAM 3-Modell funktioniert und wie es trainiert wurde.

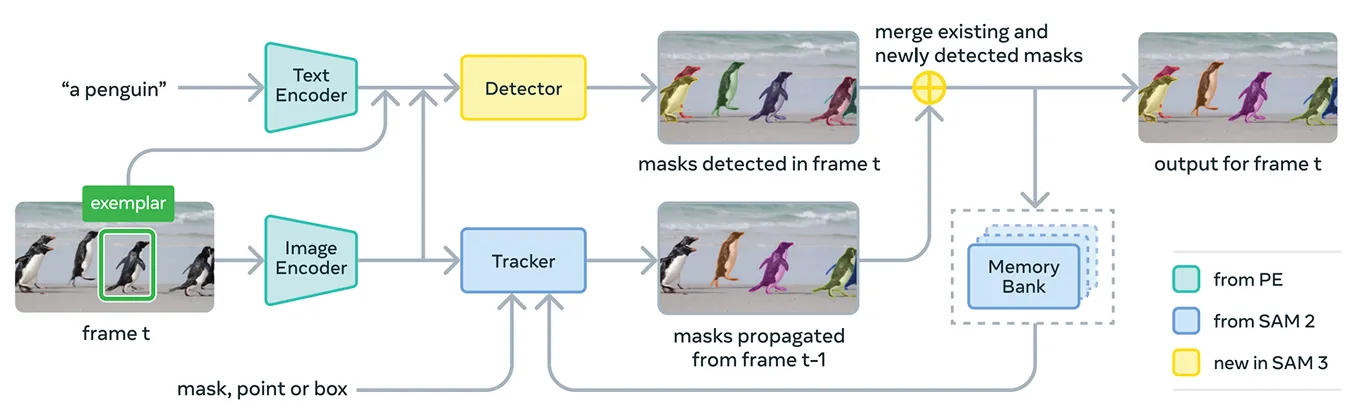

SAM 3 vereint mehrere Komponenten zur Unterstützung von Konzeptaufforderungen und visuellen Aufforderungen in einem einzigen System. Im Kern verwendet das Modell den Meta Perception Encoder, den einheitlichen Open-Source Bild-Text-Encoder von Meta.

Dieser Encoder kann sowohl Bilder als auch kurze Substantivphrasen verarbeiten. Einfach ausgedrückt: SAM 3 kann dadurch Sprache und visuelle Merkmale effektiver miteinander verknüpfen als frühere Versionen des Segment Anything Model.

Zusätzlich zu diesem Kodierer enthält SAM 3 einen Detektor, der auf der DETR-Familie von Transformatormodellen basiert. Dieser Detektor identifiziert Objekte im Bild und hilft dem System zu bestimmen, welche Objekte der Eingabeaufforderung des Benutzers entsprechen.

Speziell für die Videosegmentierung verwendet SAM 3 eine Tracking-Komponente, die auf der Speicherbank und dem Speicher-Encoder von SAM 2 aufbaut. Dadurch kann das Modell Informationen über Objekte über mehrere Frames hinweg speichern, so dass es sie im Laufe der Zeit wiedererkennen und track kann.

Um SAM 3 zu trainieren, benötigte Meta weit mehr kommentierte Daten, als derzeit im Internet vorhanden sind. Qualitativ hochwertige Segmentierungsmasken und Textbeschriftungen lassen sich nur schwer in großem Umfang erstellen, und die vollständige Beschreibung aller Instanzen eines Konzepts in Bildern und Videos ist langsam und teuer.

Um dieses Problem zu lösen, hat Meta eine neue Daten-Engine entwickelt, die SAM 3 selbst, zusätzliche KI-Modelle und menschliche Annotatoren miteinander kombiniert. Der Arbeitsablauf beginnt mit einer Pipeline von KI-Systemen, einschließlich SAM 3 und einem Llama-basierten Untertitelungsmodell.

Diese Systeme scannen große Bild- und Videosammlungen, erzeugen Beschriftungen, wandeln diese Beschriftungen in Textetiketten um und erstellen erste Kandidaten für Segmentierungsmasken. Menschliche und künstliche Kommentatoren überprüfen dann diese Kandidaten.

Die KI-Kommentatoren, die so geschult sind, dass sie bei Aufgaben wie der Prüfung der Maskenqualität und der Überprüfung der Konzeptabdeckung die menschliche Genauigkeit erreichen oder sogar übertreffen, filtern einfache Fälle heraus. Der Mensch greift nur bei schwierigeren Beispielen ein, bei denen das Modell noch Schwierigkeiten hat.

Dieser Ansatz verleiht Meta einen erheblichen Geschwindigkeitszuwachs bei der Annotation. Dadurch, dass KI-Annotatoren einfache Fälle bearbeiten, wird die Pipeline bei negativen Prompts etwa fünfmal und bei positiven Prompts in feinkörnigen Domänen 36 % schneller.

Dank dieser Effizienz konnte der Datensatz auf mehr als vier Millionen eindeutige Konzepte skaliert werden. Die konstante Schleife aus KI-Vorschlägen, menschlichen Korrekturen und aktualisierten Modellvorhersagen verbessert auch die Qualität der Bezeichnungen im Laufe der Zeit und hilft SAM 3, eine viel breitere Palette von visuellen und textbasierten Konzepten zu lernen.

In Bezug auf die Leistung bietet SAM 3 eine deutliche Verbesserung gegenüber früheren Modellen. Beim neuen SA-Co Benchmark von Meta, der die Erkennung und Segmentierung von Konzepten mit offenem Vokabular bewertet, erreicht SAM 3 sowohl bei Bildern als auch bei Videos etwa die doppelte Leistung früherer Systeme.

Auch bei interaktiven visuellen Aufgaben wie Punkt-zu-Maske und Maske-zu-Maske erreicht oder übertrifft es SAM 2. Meta meldet zusätzliche Gewinne bei schwierigeren Evaluierungen wie LVIS mit Nullschüssen (wo Modelle seltene Kategorien ohne Trainingsbeispiele erkennen müssen) und Objektzählung (Messung, ob alle Instanzen eines Objekts erkannt werden), was eine stärkere Generalisierung über verschiedene Bereiche hinweg hervorhebt.

Zusätzlich zu diesen Genauigkeitsverbesserungen ist SAM 3 effizient: Es verarbeitet ein Bild mit mehr als 100 erkannten Objekten in etwa 30 Millisekunden auf einem GPU und hält die Geschwindigkeit beim Verfolgen mehrerer Objekte im Video nahezu in Echtzeit.

Nachdem wir nun ein besseres Verständnis von SAM 3 haben, wollen wir uns ansehen, wie es in realen Anwendungen eingesetzt wird, von fortgeschrittenem textgestütztem Denken bis hin zu wissenschaftlicher Forschung und den eigenen Produkten von Meta.

SAM 3 kann auch als Werkzeug innerhalb eines größeren multimodalen Sprachmodells verwendet werden, das Meta SAM 3 Agent nennt. Anstatt SAM 3 einen kurzen Satz wie "Elefant" zu geben, kann der Agent eine kompliziertere Frage in kleinere Aufforderungen aufteilen, die SAM 3 versteht.

Fragt der Benutzer zum Beispiel: "Welches Objekt auf dem Bild wird zum Steuern und Führen eines Pferdes verwendet?", probiert der Agent verschiedene Substantivphrasen aus, sendet sie an SAM 3 und prüft, welche Masken sinnvoll sind. Er verfeinert so lange, bis er das richtige Objekt gefunden hat.

Auch ohne auf speziellen Reasoning-Datensätzen trainiert worden zu sein, schneidet der SAM 3 Agent bei Benchmarks, die für komplexe Textabfragen entwickelt wurden, wie ReasonSeg und OmniLabel, gut ab. Dies zeigt, dass SAM 3 Systeme unterstützen kann, die sowohl Sprachverständnis als auch feinkörnige visuelle Segmentierung benötigen.

Interessanterweise wird SAM 3 bereits in Forschungsumgebungen eingesetzt, in denen detaillierte visuelle Kennzeichnungen wichtig sind. Meta arbeitete mit Conservation X Labs und Osa Conservation zusammen, um SA-FARI aufzubauen, einen öffentlichen Datensatz zur Überwachung von Wildtieren mit mehr als 10.000 Kamerafallen-Videos.

Jedes Tier in jedem Bild wird mit Kästchen und Segmentierungsmasken gekennzeichnet, was bei einer manuellen Beschriftung extrem zeitaufwändig wäre. In ähnlicher Weise wird SAM 3 in der Meeresforschung zusammen mit FathomNet und MBARI eingesetzt, um Instanzsegmentierungsmasken für Unterwasserbilder zu erstellen und neue Bewertungsmaßstäbe zu unterstützen.

Solche Datensätze helfen Wissenschaftlern, Videomaterial effizienter zu analysieren und Tiere und Lebensräume zu untersuchen, die normalerweise nur schwer in großem Maßstab zu track sind. Forscher können diese Ressourcen auch nutzen, um ihre eigenen Modelle für die Identifizierung von Arten, die Verhaltensanalyse und die automatisierte ökologische Überwachung zu entwickeln.

SAM 3 wird nicht nur in der Forschung eingesetzt, sondern ermöglicht auch neue Funktionen und Anwendungsfälle in den Verbraucherprodukten von Meta. Hier ein kleiner Einblick in einige der Möglichkeiten, wie es bereits integriert ist:

SAM 3 ist ein aufregender Schritt nach vorn für die Segmentierung. Es führt die Konzept-Segmentierung, Textaufforderungen mit offenem Vokabular und verbessertes Tracking ein. Mit einer deutlich verbesserten Leistung sowohl bei Bildern als auch bei Videos und der Hinzufügung von SAM 3D eröffnet die Modellsuite neue Möglichkeiten für Vision AI, kreative Tools, wissenschaftliche Forschung und reale Produkte.

Werden Sie Mitglied unserer Community und erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren. Wenn Sie Ihr eigenes Vision AI-Projekt aufbauen möchten, informieren Sie sich über unsere Lizenzierungsoptionen. Erfahren Sie mehr über Anwendungen wie KI im Gesundheitswesen und Vision AI im Einzelhandel, indem Sie unsere Lösungsseiten besuchen.