Tauchen Sie mit uns in das Segment Anything Model 2SAM 2) von Meta AI ein und erfahren Sie, für welche Echtzeitanwendungen es in verschiedenen Branchen eingesetzt werden kann.

Tauchen Sie mit uns in das Segment Anything Model 2SAM 2) von Meta AI ein und erfahren Sie, für welche Echtzeitanwendungen es in verschiedenen Branchen eingesetzt werden kann.

Am 29. Juli 2024 veröffentlichte Meta AI die zweite Version ihres Segment Anything Model, SAM 2. Das neue Modell kann sowohl in Bildern als auch in Videos genau feststellen, welche Pixel zu einem Zielobjekt gehören! Das Beste daran ist, dass das Modell in der Lage ist, ein Objekt über alle Bilder eines Videos hinweg in Echtzeit zu verfolgen. SAM 2 eröffnet spannende Möglichkeiten für die Videobearbeitung, Mixed-Reality-Erlebnisse und eine schnellere Kommentierung visueller Daten für das Training von Computer-Vision-Systemen.

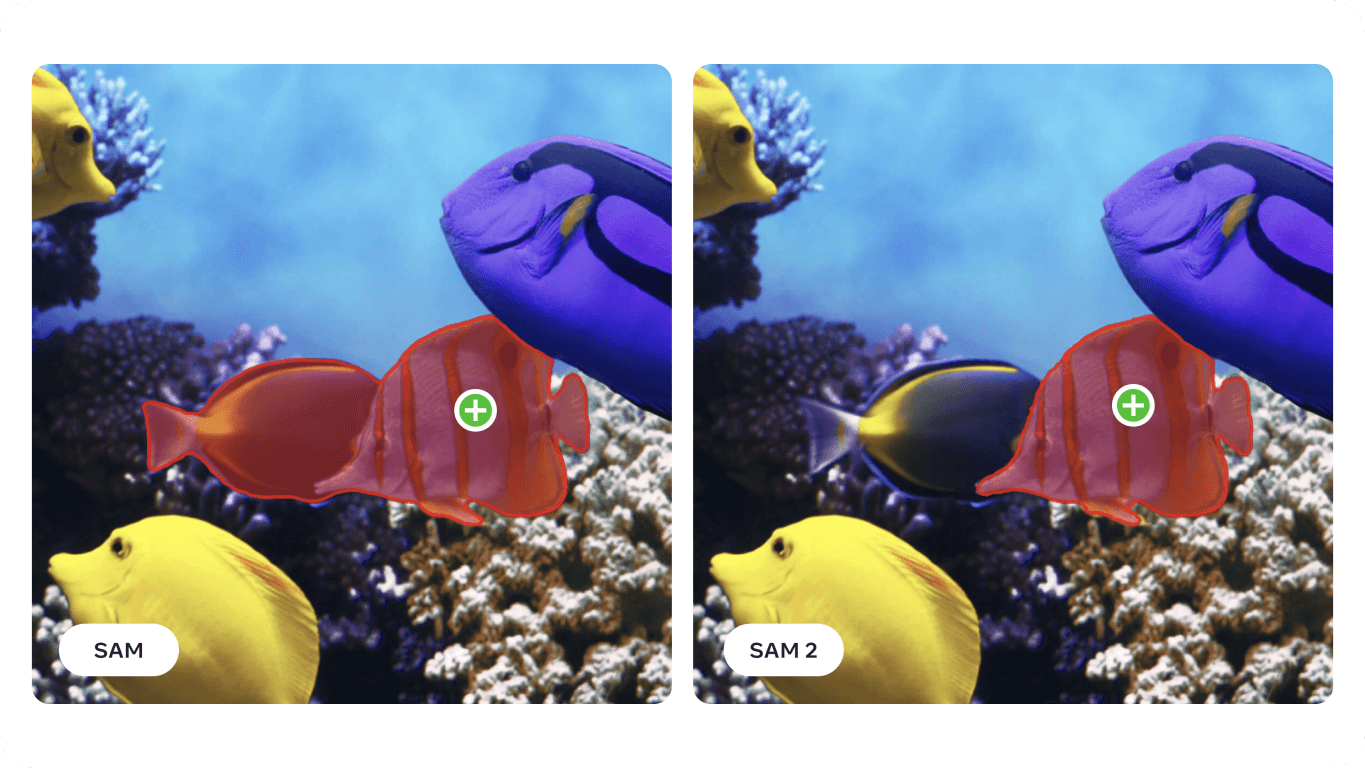

SAM 2 baut auf dem Erfolg des ursprünglichen SAM auf, das in Bereichen wie Meeresforschung, Satellitenbilder und Medizin eingesetzt wurde, und meistert Herausforderungen wie sich schnell bewegende Objekte und Veränderungen im Aussehen. Seine verbesserte Genauigkeit und Effizienz machen es zu einem vielseitigen Werkzeug für eine breite Palette von Anwendungen. In diesem Artikel werden wir uns darauf konzentrieren, wo SAM 2 eingesetzt werden kann und warum es für die KI-Gemeinschaft wichtig ist.

Das Segment Anything Model 2 ist ein fortschrittliches Basismodell, das die prompte visuelle Segmentierung (PVS) sowohl in Bildern als auch in Videos unterstützt. PVS ist eine Technik, bei der ein Modell segment oder verschiedene Teile eines Bildes oder Videos auf der Grundlage spezifischer Aufforderungen oder Eingaben des Benutzers identifizieren kann. Diese Aufforderungen können in Form von Klicks, Kästchen oder Masken erfolgen, die den Bereich von Interesse hervorheben. Das Modell erzeugt dann eine Segmentierungsmaske, die den angegebenen Bereich umreißt.

Die SAM 2-Architektur baut auf dem ursprünglichen SAM auf, indem sie die Bildsegmentierung auf die Videosegmentierung ausweitet. Es verfügt über einen leichtgewichtigen Maskendecoder, der Bilddaten und Eingabeaufforderungen zur Erstellung von Segmentierungsmasken verwendet. Für Videos führt SAM 2 ein Speichersystem ein, mit dem es sich Informationen aus früheren Bildern merken kann, um eine genaue Verfolgung über die Zeit zu gewährleisten. Das Speichersystem umfasst Komponenten, die Details über die zu segmentierenden Objekte speichern und abrufen. SAM 2 kann auch mit Verdeckungen umgehen, Objekte über mehrere Frames hinweg track und mit mehrdeutigen Aufforderungen umgehen, indem es mehrere mögliche Masken erzeugt. Die fortschrittliche Architektur von SAM 2 macht es sowohl in statischen als auch in dynamischen visuellen Umgebungen äußerst leistungsfähig.

Insbesondere bei der Videosegmentierung erreicht SAM 2 im Vergleich zu früheren Methoden eine höhere Genauigkeit bei dreimal weniger Benutzerinteraktionen. Bei der Bildsegmentierung übertrifft SAM 2 das ursprüngliche Segment Anything Model (SAM) und ist sechsmal schneller und genauer. Diese Verbesserung wurde in der SAM 2-Forschungsarbeit anhand von 37 verschiedenen Datensätzen, darunter 23, an denen SAM zuvor getestet wurde, aufgezeigt.

Interessanterweise wurde SAM 2 von Meta AI durch die Erstellung des bisher größten Datensatzes zur Videosegmentierung, des SA-V-Datensatzes, entwickelt. Der umfangreiche Datensatz umfasst über 50.000 Videos und 35,5 Millionen Segmentierungsmasken und wurde durch interaktive Nutzerbeiträge gesammelt. Kommentatoren gaben Hinweise und Korrekturen, damit das Modell aus einer Vielzahl von Szenarien und Objekttypen lernen konnte.

Dank seiner fortschrittlichen Fähigkeiten bei der Bild- und Videosegmentierung kann SAM 2 in verschiedenen Branchen eingesetzt werden. Sehen wir uns einige dieser Anwendungen an.

Das neue Segmentierungsmodell von Meta AI kann für Augmented Reality (AR)- und Virtual Reality (VR)-Anwendungen verwendet werden. SAM 2 kann zum Beispiel reale Objekte genau identifizieren und segment und die Interaktion mit virtuellen Objekten realistischer gestalten. Dies kann in verschiedenen Bereichen wie Gaming, Bildung und Ausbildung nützlich sein, wo eine realistische Interaktion zwischen virtuellen und realen Elementen wichtig ist.

Da Geräte wie AR-Brillen immer fortschrittlicher werden, könnten die Fähigkeiten von SAM 2 bald in sie integriert werden. Stellen Sie sich vor, Sie setzen die Brille auf und schauen sich in Ihrem Wohnzimmer um. Wenn die Brille segment Wassernapf Ihres Hundes erkennt, könnte sie Sie daran erinnern, ihn nachzufüllen, wie auf dem Bild unten zu sehen. Oder wenn Sie ein neues Rezept kochen, könnte die Brille die Zutaten auf Ihrer Arbeitsplatte erkennen und Ihnen Schritt-für-Schritt-Anweisungen und Tipps geben, um Ihr Kocherlebnis zu verbessern und sicherzustellen, dass Sie alle notwendigen Zutaten zur Hand haben.

Die Forschung mit dem SAM hat gezeigt, dass es in speziellen Bereichen wie der Sonar-Bildgebung eingesetzt werden kann. Die Sonarbildgebung ist aufgrund der geringen Auflösung, des hohen Rauschpegels und der komplexen Formen der Objekte auf den Bildern mit besonderen Herausforderungen verbunden. Durch die Feinabstimmung von SAM für Sonarbilder haben Forscher gezeigt, dass es in der Lage ist, verschiedene Unterwasserobjekte wie Meeresmüll, geologische Formationen und andere interessante Objekte genau zu segment . Präzise und zuverlässige Unterwasserbilder können in der Meeresforschung, der Unterwasserarchäologie, dem Fischereimanagement und der Überwachung für Aufgaben wie die Kartierung von Lebensräumen, die Entdeckung von Artefakten und die Erkennung von Gefahren eingesetzt werden.

%25252525201.png)

Da SAM 2 auf vielen der Herausforderungen von SAM aufbaut und diese verbessert, hat es das Potenzial, die Analyse von Sonaraufnahmen weiter zu verbessern. Seine präzisen Segmentierungsfähigkeiten können bei verschiedenen maritimen Anwendungen helfen, einschließlich wissenschaftlicher Forschung und Fischerei. So kann SAM 2 beispielsweise Unterwasserstrukturen effektiv umreißen, Meeresmüll detect und Objekte in vorwärtsgerichteten Sonarbildern identifizieren, was zu einer genaueren und effizienteren Unterwasserforschung und -überwachung beiträgt.

Hier sind die potenziellen Vorteile der Verwendung von SAM 2 zur Analyse von Sonarbildern:

Durch die Integration von SAM 2 in Sonarbildgebungsverfahren kann die Meeresindustrie eine höhere Effizienz, Genauigkeit und Zuverlässigkeit bei der Unterwasserforschung und -analyse erreichen, was letztlich zu besseren Ergebnissen in der Meeresforschung führt.

Eine weitere Anwendung von SAM 2 ist der Einsatz in autonomen Fahrzeugen. SAM 2 kann Objekte wie Fußgänger, andere Fahrzeuge, Straßenschilder und Hindernisse in Echtzeit genau erkennen. Der Detailgrad, den SAM 2 liefern kann, ist für sichere Navigations- und Kollisionsvermeidungsentscheidungen unerlässlich. Durch die präzise Verarbeitung visueller Daten trägt SAM 2 dazu bei, eine detaillierte und zuverlässige Karte der Umgebung zu erstellen, was zu einer besseren Entscheidungsfindung führt.

Die Fähigkeit von SAM 2, bei unterschiedlichen Lichtverhältnissen, Wetterveränderungen und dynamischen Umgebungen gut zu funktionieren, macht es für autonome Fahrzeuge zuverlässig. Ob es sich um eine belebte Straße oder eine neblige Autobahn handelt, SAM 2 kann Objekte stets genau identifizieren und segment , sodass das Fahrzeug in verschiedenen Situationen richtig reagieren kann.

Es gibt jedoch einige Einschränkungen, die zu beachten sind. Bei komplexen, sich schnell bewegenden Objekten kann SAM 2 manchmal feine Details übersehen, und seine Vorhersagen können über mehrere Bilder hinweg instabil werden. Außerdem kann SAM 2 manchmal mehrere ähnlich aussehende Objekte in überfüllten Szenen verwechseln. Diese Herausforderungen sind der Grund, warum die Integration zusätzlicher Sensoren und Technologien für autonome Fahranwendungen so wichtig ist.

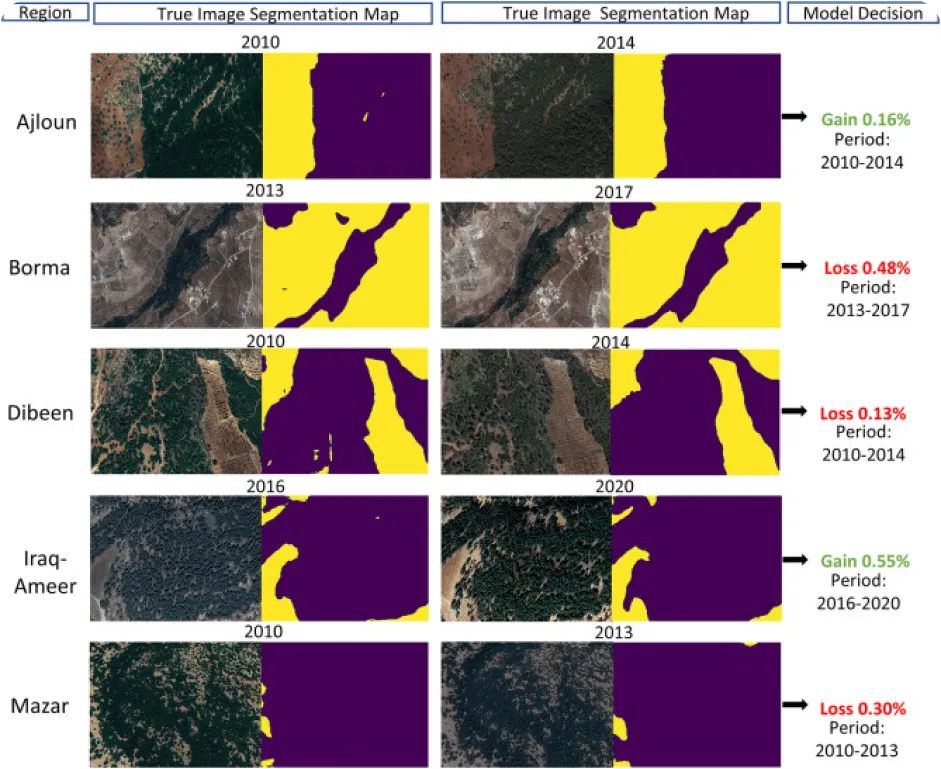

Die Umweltüberwachung mit Hilfe von Computer Vision kann schwierig sein, vor allem wenn es an kommentierten Daten mangelt, aber genau das macht sie zu einer interessanten Anwendung für SAM 2. SAM 2 kann dazu verwendet werden, Veränderungen in natürlichen Landschaften track und zu analysieren, indem verschiedene Umweltmerkmale wie Wälder, Gewässer, städtische Gebiete und landwirtschaftliche Flächen aus Satelliten- oder Drohnenbildern genau segmentiert und identifiziert werden. Insbesondere hilft die präzise Segmentierung bei der Überwachung von Abholzung, Verstädterung und Änderungen der Landnutzung im Laufe der Zeit, um wertvolle Daten für den Umweltschutz und die Planung zu liefern.

Hier sind einige der Vorteile der Verwendung eines Modells wie SAM 2 zur Analyse von Umweltveränderungen im Laufe der Zeit:

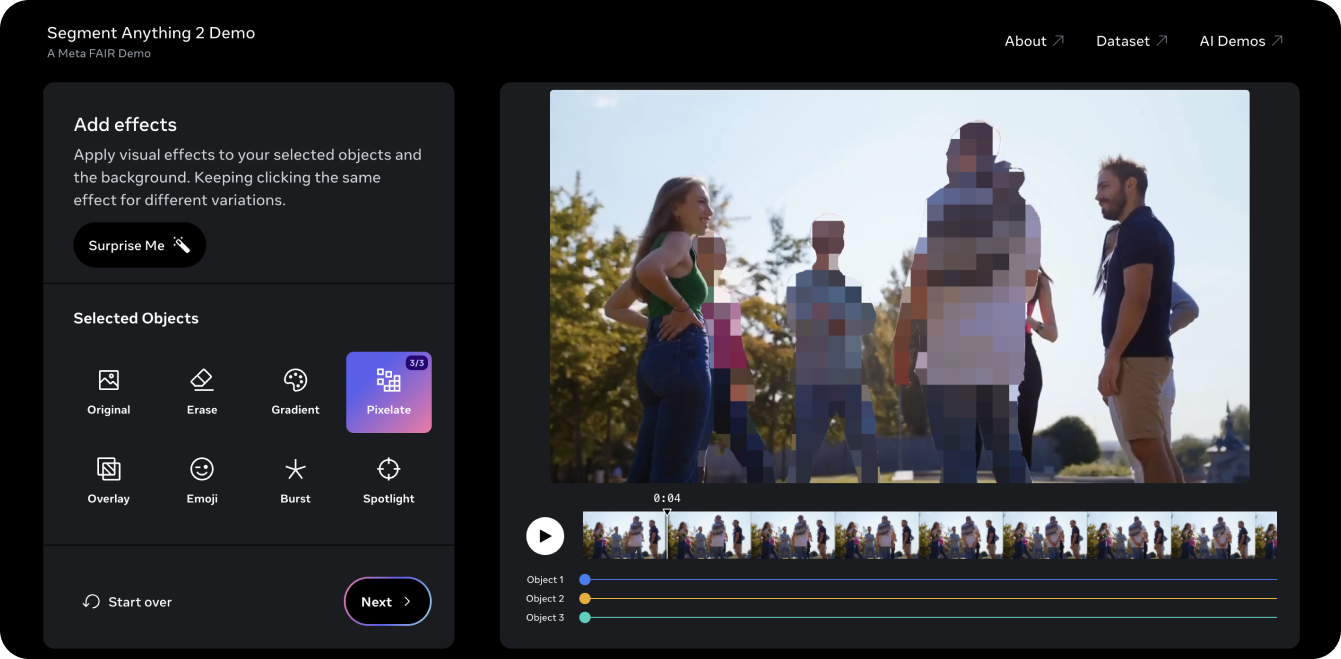

Die Segment Anything 2 Demo ist eine gute Möglichkeit, das Modell an einem Video auszuprobieren. Mit den PVS-Funktionen von SAM 2 haben wir ein altes Ultralytics YouTube-Video genommen und konnten drei Objekte oder Personen im Video segment und verpixeln. Normalerweise wäre das Herausschneiden von drei Personen aus einem solchen Video zeitaufwändig und mühsam und würde eine manuelle Maskierung von Bild zu Bild erfordern. SAM 2 vereinfacht diesen Prozess jedoch. Mit ein paar Klicks in der Demo können Sie die Identität von drei interessanten Objekten in Sekundenschnelle schützen.

In der Demo können Sie auch verschiedene visuelle Effekte ausprobieren, wie z. B. das Aufleuchten eines Scheinwerfers auf die für die Verfolgung ausgewählten Objekte und das Löschen der verfolgten Objekte. Wenn Ihnen die Demo gefallen hat und Sie bereit sind, mit SAM 2 innovativ tätig zu werden, finden Sie auf der SAM 2-ModellseiteUltralytics ausführliche Anleitungen für den praktischen Umgang mit dem Modell. Erforschen Sie die Funktionen, Installationsschritte und Beispiele, um das Potenzial von SAM 2 in Ihren Projekten voll auszuschöpfen!

Das Segment Anything Model 2SAM 2) von Meta AI revolutioniert die Video- und Bildsegmentierung. Mit der Verbesserung von Aufgaben wie der Objektverfolgung entdecken wir neue Möglichkeiten für die Videobearbeitung, Mixed Reality, wissenschaftliche Forschung und medizinische Bildgebung. Durch die Vereinfachung komplexer Aufgaben und die Beschleunigung von Anmerkungen ist SAM 2 bereit, ein wichtiges Werkzeug für die KI-Community zu werden. Wenn wir mit Modellen wie SAM 2 weiter forschen und innovieren, können wir mit noch mehr bahnbrechenden Anwendungen und Fortschritten in verschiedenen Bereichen rechnen!

Erfahren Sie mehr über KI, indem Sie unser GitHub-Repository erkunden und unserer Community beitreten. Auf unseren Lösungsseiten finden Sie detaillierte Einblicke in KI in der Fertigung und im Gesundheitswesen. 🚀