Wie Ultralytics mit ProgLoss, STAL und MuSGD intelligenter trainiert

Erfahren Sie, wie Ultralytics mithilfe von Progressive Loss Balancing, Small-Target-Aware Label Assignment und dem MuSGD-Optimierer zuverlässiger trainiert.

.webp)

Erfahren Sie, wie Ultralytics mithilfe von Progressive Loss Balancing, Small-Target-Aware Label Assignment und dem MuSGD-Optimierer zuverlässiger trainiert.

.webp)

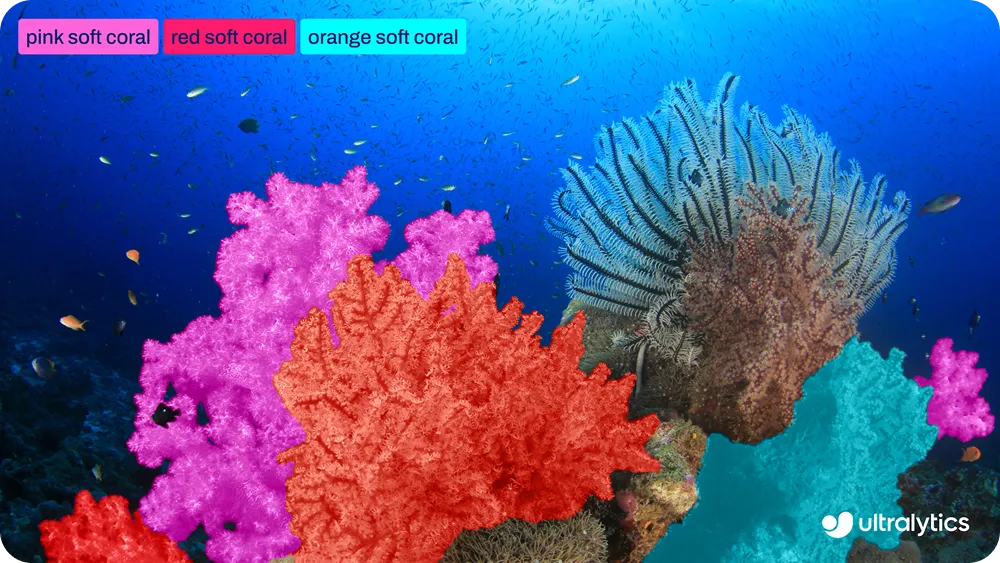

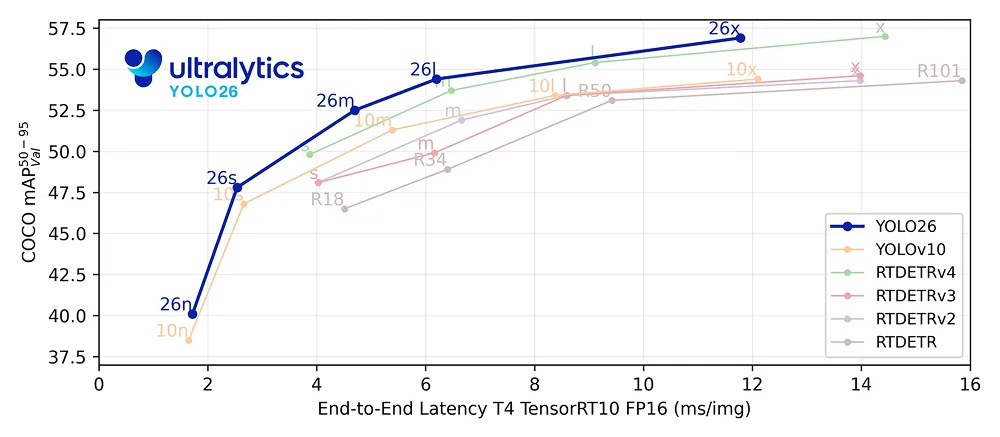

Letzte Woche haben wir Ultralytics veröffentlicht und damit einen neuen Standard für Edge-First-Echtzeit-Computervisionsmodelle gesetzt. Ähnlich wie frühere Ultralytics YOLO , wie z. B. Ultralytics YOLO11, unterstützt YOLO26 die wichtigsten Computer-Vision-Aufgaben, mit denen Benutzer vertraut sind, darunter Objekterkennung, Instanzsegmentierung und Posenschätzung.

YOLO26 ist jedoch nicht nur ein inkrementelles Update. Auch wenn die unterstützten Aufgaben vertraut erscheinen mögen, stellt dieses neue Modell einen innovativen Fortschritt in der Art und Weise dar, wie Computer-Vision-Modelle trainiert werden. Bei YOLO26 geht es nicht nur um die Effizienz der Inferenz, sondern auch darum, das Training stabiler zu gestalten.

YOLO26 wurde unter Berücksichtigung des gesamten Trainingslebenszyklus entwickelt. Das bedeutet schnellere Konvergenz, zuverlässigere Trainingsläufe und konsistentes Modellverhalten. Diese Verbesserungen sind besonders wichtig in realen Arbeitsabläufen, in denen die Zuverlässigkeit des Trainings direkten Einfluss darauf hat, wie schnell Modelle iteriert und bereitgestellt werden können.

Um dies zu ermöglichen, führt YOLO26 mehrere gezielte Trainingsinnovationen ein, darunter Progressive Loss Balancing (ProgLoss), Small-Target-Aware Label Assignment (STAL) und den MuSGD-Optimierer. Zusammen verbessern diese Änderungen die Ausgewogenheit des Lernverlusts, die Zuweisung von Labels und das Optimierungsverhalten im Zeitverlauf.

In diesem Artikel werden wir untersuchen, wie jeder dieser Mechanismen funktioniert und warum sie Ultralytics einfacher trainierbar und in großem Maßstab zuverlässiger machen. Lassen Sie uns beginnen!

Ultralytics optimiert die gesamte Inferenz-Pipeline, indem es die Abhängigkeit von Nachbearbeitungsschritten wie der Nicht-Maximalunterdrückung beseitigt. Anstatt viele überlappende Vorhersagen zu generieren und diese anschließend zu filtern, erzeugt YOLO26 die endgültigen Erkennungsergebnisse direkt aus dem Netzwerk.

Dadurch wird YOLO26 zu einem End-to-End-Modell, bei dem Vorhersagen, Duplikatsauflösung und endgültige Ergebnisse alle innerhalb des Netzwerks selbst gelernt werden. Dies vereinfacht die Bereitstellung und verbessert die Inferenz-Effizienz, während gleichzeitig die Art und Weise geprägt wird, wie das Modell während des Trainings lernt.

In einem End-to-End-System wie diesem sind Training und Inferenz eng miteinander verbunden. Da es keine externe Nachbearbeitungsphase gibt, um Vorhersagen später zu korrigieren, muss das Modell lernen, während des Trainings selbst klare und sichere Entscheidungen zu treffen.

Dies macht die Abstimmung zwischen Trainingszielen und Inferenzverhalten besonders wichtig. Jede Diskrepanz zwischen der Art und Weise, wie das Modell trainiert wird, und der Art und Weise, wie es zum Zeitpunkt der Inferenz verwendet wird, kann zu instabilem Lernen oder einer langsameren Konvergenz führen.

YOLO26 löst dieses Problem, indem es seinen Trainingsprozess von Anfang an auf die reale Anwendung ausrichtet. Anstatt sich nur auf die Inferenzgeschwindigkeit zu konzentrieren, ist das Trainingssystem so konzipiert, dass es ein stabiles Lernen über lange Zeiträume, eine konsistente Konvergenz über alle Modellgrößen von Nano bis Extra Large und eine robuste Leistung bei verschiedenen Datensätzen unterstützt.

Eine der wichtigsten Trainingsinnovationen in Ultralytics baut auf einem Zwei-Kopf-Trainingsansatz auf, der bereits in früheren YOLO verwendet wurde. In Objekterkennungsmodellen bezieht sich ein Kopf auf den Teil des Netzwerks, der für die Erstellung von Vorhersagen verantwortlich ist.

Mit anderen Worten: Erkennungsköpfe lernen, vorherzusagen, wo sich Objekte in einem Bild befinden und um welche Objekte es sich handelt. Dazu führen sie eine Regression der Koordinaten der Begrenzungsrahmen durch, d. h. sie lernen, die Position und Größe jedes Objekts im Eingabebild zu schätzen.

Während des Trainings lernt das Modell, indem es einen Verlust minimiert, der ein numerisches Maß dafür ist, wie weit seine Vorhersagen von den richtigen Antworten oder der Grundwahrheit entfernt sind. Ein geringerer Verlust bedeutet, dass die Vorhersagen des Modells näher an der Grundwahrheit liegen, während ein höherer Verlust auf größere Fehler hinweist. Die Verlustberechnung steuert, wie das Modell seine Parameter während des Trainings aktualisiert.

YOLO26 verwendet während des Trainings zwei Erkennungsköpfe, die dasselbe zugrunde liegende Modell verwenden, aber unterschiedlichen Zwecken dienen. Der Eins-zu-Eins-Kopf ist der Kopf, der zum Zeitpunkt der Inferenz verwendet wird. Er lernt, jedes Objekt mit einer einzigen, sicheren Vorhersage zu verknüpfen, was für das durchgängige, NMS Design von YOLO26 unerlässlich ist.

Der One-to-Many-Kopf wird hingegen nur während des Trainings verwendet. Er ermöglicht es, mehrere Vorhersagen mit demselben Objekt zu verknüpfen, wodurch eine dichtere Überwachung erreicht wird. Dieses reichhaltigere Lernsignal trägt zur Stabilisierung des Trainings und zur Verbesserung der Genauigkeit bei, insbesondere in den frühen Phasen.

In YOLO26 verwenden beide Köpfe dieselbe Verlustberechnung für die Box-Regression und die Klassifizierung. Frühere Implementierungen wendeten während des gesamten Trainings ein festes Gleichgewicht zwischen diesen beiden Verlustsignalen an.

In der Praxis ändert sich jedoch die Bedeutung der einzelnen Köpfe im Laufe der Zeit. Eine intensive Überwachung ist zu Beginn am nützlichsten, während die Anpassung an das Inferenzverhalten später im Training an Bedeutung gewinnt. YOLO26 basiert auf dieser Erkenntnis, was sich direkt darauf auswirkt, wie es die Lernsignale im Laufe des Trainings neu ausbalanciert.

Wie geht Ultralytics mit diesen sich ändernden Lernanforderungen während des Trainings um? Es verwendet Progressive Loss Balancing, um die Gewichtung der Lernsignale im Laufe der Zeit anzupassen.

ProgLoss funktioniert, indem es im Laufe des Trainings dynamisch verschiebt, wie viel jeder Kopf zum Gesamtverlust beiträgt. Zu Beginn wird mehr Gewicht auf den One-to-Many-Kopf gelegt, um das Lernen zu stabilisieren und das Erinnerungsvermögen zu verbessern. Im Laufe des Trainings verschiebt sich das Gleichgewicht allmählich in Richtung des One-to-One-Kopfes, wodurch das Training enger an das Inferenzverhalten angepasst wird.

Dieser schrittweise Übergang ermöglicht es YOLO26, in der richtigen Reihenfolge zu lernen. Anstatt das Modell zu zwingen, konkurrierende Ziele auf einmal zu optimieren, priorisiert Progressive Loss Balancing das nützlichste Lernsignal in jeder Phase des Trainings. Das Ergebnis ist eine gleichmäßigere Konvergenz, weniger instabile Trainingsläufe und eine konsistentere Endleistung.

Eine weitere interessante Verbesserung des Trainings in Ultralytics ergibt sich daraus, wie das Modell Trainingsziele den Vorhersagen zuordnet, ein Prozess, der als Label-Zuweisung bekannt ist. Er ist dafür verantwortlich, Ground-Truth-Objekte mit Kandidatenvorhersagen abzugleichen, die oft als Anker bezeichnet werden.

Diese Übereinstimmungen bestimmen, welche Vorhersagen überwacht werden und zum Verlust beitragen. YOLO26 baut auf einer bestehenden Methode zur Label-Zuweisung namens Task Alignment Learning (TAL) auf, die entwickelt wurde, um die Klassifizierung und Lokalisierung während des Trainings besser aufeinander abzustimmen.

Während TAL für die meisten Objekte gut funktioniert, hat das Training eine wichtige Einschränkung aufgezeigt. Während des Abgleichprozesses konnten sehr kleine Objekte vollständig übersehen werden. In der Praxis erhielten Objekte, die kleiner als etwa 8 Pixel in einem 640-Pixel-Eingabebild waren, oft keine Ankerzuweisungen. In diesem Fall erhält das Modell wenig oder gar keine Überwachung für diese Objekte, was es schwierig macht, detect zuverlässig zu detect .

Um dieses Problem zu beheben, führt YOLO26 die Small-Target-Aware Label Assignment (STAL) ein. STAL modifiziert den Zuordnungsprozess, um sicherzustellen, dass kleine Objekte während des Trainings nicht ignoriert werden. Konkret schreibt es mindestens vier Ankerzuordnungen für Objekte vor, die kleiner als 8 Pixel sind. Dadurch wird gewährleistet, dass auch winzige Objekte konsistent zum Trainingsverlust beitragen.

Durch die verstärkte Überwachung kleiner Ziele verbessert STAL die Lernstabilität und Erkennungsleistung in Szenarien, in denen kleine oder weit entfernte Objekte häufig vorkommen. Diese Verbesserung ist besonders wichtig für Edge-First-YOLO26-Anwendungen wie Luftbildaufnahmen, Robotik und Internet-of-Things-Systeme (IoT), bei denen Objekte oft klein, weit entfernt oder nur teilweise sichtbar sind und eine zuverlässige Erkennung von entscheidender Bedeutung ist.

Um ein stabileres und vorhersehbareres Training zu unterstützen, führt Ultralytics außerdem einen neuen Optimierer namens MuSGD ein. Dieser Optimierer wurde entwickelt, um die Konvergenz und Trainingszuverlässigkeit in End-to-End-Erkennungsmodellen zu verbessern, insbesondere wenn die Modellgröße und die Trainingskomplexität zunehmen.

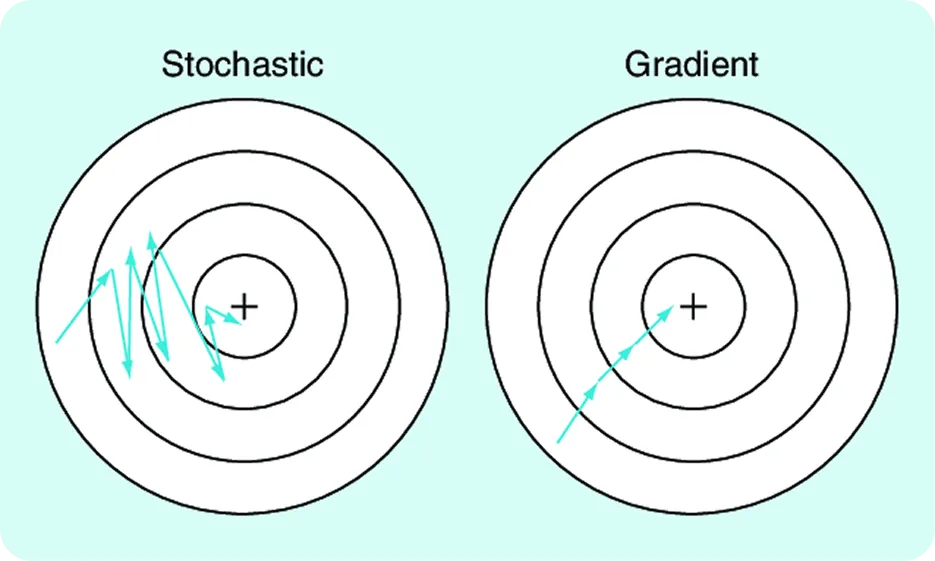

Damit ein neuronales Netzwerk lernen und folglich die Gewichte entsprechend ändern kann, berechnen wir während des Trainings einen Fehler (auch „Verlust“ genannt). Das Modell misst also anhand eines Verlustwerts, wie falsch seine Vorhersagen sind, berechnet Gradienten, die angeben, wie sich seine Parameter ändern sollten, und aktualisiert dann diese Parameter, um den Fehler zu reduzieren. Der stochastische Gradientenabstieg (SGD) ist ein weit verbreiteter Optimierer, der diese Aktualisierungen durchführt und das Training effizient und skalierbar macht.

MuSGD baut auf dieser bekannten Grundlage auf und integriert Optimierungsideen, die von Muon inspiriert sind, einer Methode, die beim Training großer Sprachmodelle zum Einsatz kommt. Diese Ideen wurden durch aktuelle Fortschritte wie Moonshot AI's Kimi K2 beeinflusst, das durch strukturiertere Parameteraktualisierungen ein verbessertes Trainingsverhalten demonstrierte.

YOLO26 verwendet eine hybride Aktualisierungsstrategie. Einige Parameter werden mithilfe einer Kombination aus Muon-inspirierten Aktualisierungen und SGD aktualisiert, während andere SGD verwenden. Dadurch kann YOLO26 zusätzliche Strukturen in den Optimierungsprozess einführen und gleichzeitig die Robustheit und Generalisierungseigenschaften beibehalten, die SGD so SGD machen.

Das Ergebnis ist eine reibungslosere Optimierung, eine schnellere Konvergenz und ein besser vorhersehbares Trainingsverhalten über alle Modellgrößen hinweg, wodurch MuSGD zu einem wesentlichen Faktor dafür wird, dass YOLO26 einfacher zu trainieren und in großem Maßstab zuverlässiger ist.

Die Trainingsinnovationen Ultralytics in Kombination mit wichtigen Funktionen wie dem End-to-End-, NMS und Edge-First-Design machen das Modell einfacher zu trainieren und zuverlässiger in großem Maßstab. Sie fragen sich vielleicht, was das für Computer-Vision-Anwendungen konkret bedeutet.

In der Praxis erleichtert dies die Einführung von Computer Vision dort, wo sie tatsächlich zum Einsatz kommt. Modelle lassen sich vorhersehbarer trainieren, lassen sich konsistenter über verschiedene Größen hinweg skalieren und lassen sich einfacher an neue Datensätze anpassen. Dies verringert die Reibung zwischen Experimentieren und Bereitstellung, insbesondere in Umgebungen, in denen Zuverlässigkeit und Effizienz ebenso wichtig sind wie die reine Leistung.

Beispielsweise müssen Modelle in der Robotik und in industriellen Bildverarbeitungsanwendungen häufig neu trainiert werden, wenn sich Umgebungen, Sensoren oder Aufgaben ändern. Mit YOLO26 können Teams schneller iterieren, ohne sich um instabile Trainingsläufe oder inkonsistentes Verhalten über Modellgrößen hinweg sorgen zu müssen.

Zuverlässige Computer-Vision-Systeme hängen ebenso sehr davon ab, wie Modelle trainiert werden, wie davon, wie sie zum Zeitpunkt der Inferenz funktionieren. Durch die Verbesserung der Ausgewogenheit der Lernsignale, der Behandlung kleiner Objekte und des Optimierungsfortschritts macht YOLO26 das Training stabiler und leichter skalierbar. Dieser Fokus auf zuverlässiges Training hilft Teams, reibungsloser vom Experimentieren zum Einsatz in der Praxis überzugehen, insbesondere bei Edge-First-Anwendungen.

Möchten Sie mehr über KI erfahren? Besuchen Sie unser GitHub-Repository, um mehr zu erfahren. Werden Sie Teil unserer aktiven Community und informieren Sie sich über Innovationen in Bereichen wie KI in der Logistik und Vision KI in der Automobilindustrie. Wenn Sie noch heute mit Computer Vision beginnen möchten, sehen Sie sich unsere Lizenzoptionen an.