Verstehen Sie Interrater-Reliabilität, Cohens Kappa, ICC, Rater-Training und prozentuale Übereinstimmung. Erfahren Sie, wie diese statistischen Maße Konsistenz und Übereinstimmung zwischen Beobachtern in Forschung und Datenanalyse gewährleisten.

Verstehen Sie Interrater-Reliabilität, Cohens Kappa, ICC, Rater-Training und prozentuale Übereinstimmung. Erfahren Sie, wie diese statistischen Maße Konsistenz und Übereinstimmung zwischen Beobachtern in Forschung und Datenanalyse gewährleisten.

Wenn Sie ein KI-Modell erstellen, ist die Qualität Ihrer Daten genauso wichtig wie die Algorithmen, die dahinter stehen. Immer wenn mehrere Personen dieselben Daten kennzeichnen oder überprüfen, sind Meinungsverschiedenheiten vorprogrammiert. Dies gilt für viele Bereiche, darunter Forschung, Gesundheitswesen und Bildung.

Insbesondere im Bereich der Computer Vision, einem Zweig der KI, der das Training von Modellen wie Ultralytics YOLO11 trainiert werden, um visuelle Daten wie Bilder oder Videos zu interpretieren, spielen beschriftete Beispiele eine entscheidende Rolle. Wenn diese Beschriftungen inkonsistent sind, können Computer-Vision-Modelle Schwierigkeiten haben, die richtigen Muster zu lernen.

Die Inter-Rater-Reliabilität (IRR) misst, wie konsistent verschiedene Personen oder Kennzeichner bei einer Aufgabe übereinstimmen. Sie hilft, die Konsistenz zu überwachen und Lücken in Schulungen, Richtlinien oder Interpretationen zu identifizieren. Dies ist besonders wichtig beim benutzerdefinierten Modelltraining, bei dem KI-Modelle mit spezifischen Daten für einen bestimmten Zweck erstellt werden.

In diesem Artikel werden wir untersuchen, was Interrater-Reliabilität ist, wie man sie misst und wie man sie in realen Projekten verbessern kann. Los geht's!

Die Inter-Rater-Reliabilität misst, wie oft zwei oder mehr Personen (auch bekannt als Rater) bei der Kennzeichnung, Bewertung oder Überprüfung desselben Inhalts übereinstimmen. Sie wird verwendet, um zu überprüfen, wie konsistent verschiedene Rater die vorgegebenen Kriterien anwenden. Eine hohe Übereinstimmung zwischen den Ratern bedeutet, dass eine Aufgabe gut definiert und klar verstanden ist.

Dieses Konzept wird in verschiedenen Bereichen verwendet. Je nach Bereich ist es unter verschiedenen Namen bekannt, z. B. Interrater-Übereinstimmung, Interobserver-Reliabilität oder Intercoder-Reliabilität. Das zugrunde liegende Prinzip bleibt jedoch dasselbe.

In Vision AI ist die Interrater-Reliabilität ein wichtiger Bestandteil des Datenkennzeichnungsprozesses. Das Training von Computer-Vision-Modellen erfordert oft die Kennzeichnung riesiger Datensätze von Bildern oder Video-Frames, sodass mehrere KI-Entwickler gemeinsam an denselben Daten arbeiten.

Um genaue Ergebnisse zu erzielen, müssen sie die gleichen Richtlinien für die Beschriftung befolgen. Wenn beispielsweise Tiere beschriftet werden, benötigt jeder eine klare Übereinkunft darüber, was als Hund zählt, wie der Bounding Box darum gezeichnet wird und ob verschwommene Objekte beschriftet oder ignoriert werden sollen.

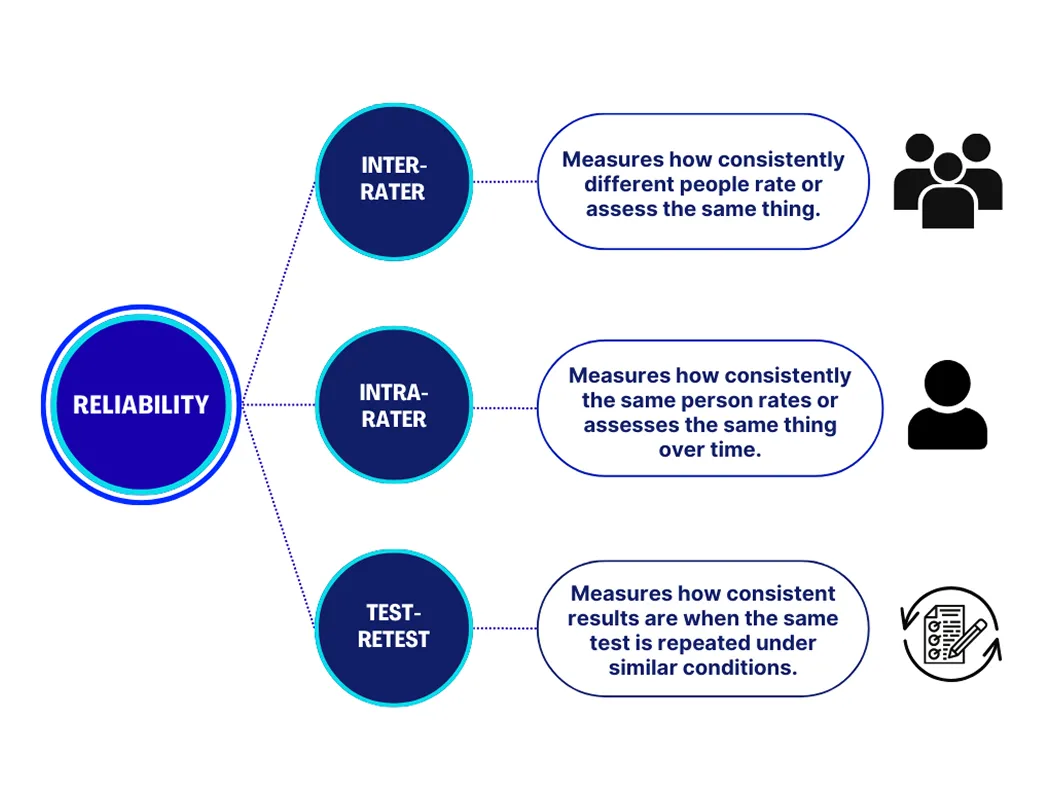

Wenn Personen an der Kennzeichnung oder Bewertung von Daten beteiligt sind, gibt es drei Haupttypen von Reliabilität, die zu berücksichtigen sind. Jeder dient einem anderen Zweck bei der Messung, wie konsistent die Ergebnisse sind. Hier ist eine genauere Betrachtung der einzelnen:

Zusammengenommen tragen diese Maßnahmen dazu bei, zu bestätigen, dass sowohl Menschen als auch Prozesse stetige, vertrauenswürdige Ergebnisse liefern.

In groß angelegten Vision-AI-Projekten beeinflusst die Qualität der gelabelten Daten direkt die Leistung eines Modells. Selbst kleine Unterschiede in der Art und Weise, wie Annotatoren Richtlinien anwenden, können Inkonsistenzen verursachen, die das Modell während des Trainings verwirren. Im Laufe der Zeit kann dies zu ungenauen Vorhersagen, verschwendeten Ressourcen und der Notwendigkeit einer kostspieligen Neukennzeichnung führen.

Die Messung der Interrater-Reliabilität hilft, diese Probleme frühzeitig zu erkennen. Eine hohe Übereinstimmung bedeutet, dass die Annotatoren aufeinander abgestimmt sind und sauberere und zuverlässigere Datensätze erstellen. Eine geringe Übereinstimmung signalisiert, dass Anweisungen, Beispiele oder Schulungen verfeinert werden müssen, bevor das Projekt fortgesetzt wird. Indem sichergestellt wird, dass die Labeler synchron arbeiten, können Teams KI-Modelle erstellen, die effektiver lernen und bessere Ergebnisse in realen Anwendungen liefern.

Hier sind einige wichtige praktische Überlegungen, die Sie bei der Arbeit mit mehreren Bewertern beachten sollten, um eine hohe Interrater-Reliabilität zu gewährleisten:

Es gibt verschiedene Möglichkeiten, die Interrater-Reliabilität zu messen, und die beste Wahl hängt von der Art der Daten und der Aufgabe ab. Einige Methoden funktionieren gut für einzelne Bewerter, die einfache Ja-Nein-Fragen bearbeiten, während andere für Situationen mit mehreren Bewertern konzipiert sind.

Gängige Ansätze umfassen die prozentuale Übereinstimmung, Cohens Kappa, Fleiss' Kappa und den Intraklassen-Korrelationskoeffizienten. Jede Methode misst den Grad der Übereinstimmung zwischen den Beurteilern und berücksichtigt die Möglichkeit, dass ein Teil der Übereinstimmung zufällig erfolgt.

Cohen’s Kappa ist eine weit verbreitete Methode zur Messung der Interrater-Reliabilität zwischen zwei Beurteilern. Es berechnet, wie oft sie bei einer Aufgabe übereinstimmen, und berücksichtigt dabei die Möglichkeit, dass ein Teil der Übereinstimmung zufällig sein könnte. Die Werte reichen von -1 bis 1, wobei 1 eine perfekte Übereinstimmung und 0 bedeutet, dass die Übereinstimmung nicht besser ist als reines Raten.

In ähnlicher Weise wird Fleiss' Kappa verwendet, wenn mehr als zwei Bewerter beteiligt sind. Es liefert eine Gesamtbewertung, die zeigt, wie konsistent die Gruppe ist. Beide Methoden werden für Aufgaben mit festgelegten Kategorien verwendet, wie z. B. das Beschriften von Bildern oder das Taggen von Emotionen. Sie sind einfach zu berechnen und werden von den meisten Annotationstools unterstützt.

Eine andere Möglichkeit, die Interrater-Reliabilität zu messen, ist die prozentuale Übereinstimmung (Percent Agreement), die den Prozentsatz der Fälle berechnet, in denen die Rater die gleiche Entscheidung treffen. Sie ist zwar einfach anzuwenden, berücksichtigt aber keine Übereinstimmung, die zufällig auftreten könnte.

Unterdessen ist der Intraclass-Korrelationskoeffizient eine fortgeschrittenere Methode, die für kontinuierliche oder skalenbasierte Daten verwendet wird. Er misst, wie konsistent Bewertungen über mehrere Bewerter hinweg sind, und wird häufig in der Forschung angewendet, die Bewertungen, Messungen oder andere Datentypen jenseits fester Kategorien umfasst.

Nachdem wir nun ein besseres Verständnis dafür haben, wie man die Inter-Rater-Reliabilität misst, wollen wir durchgehen, wie diese Methoden in realen Anwendungen eingesetzt werden können.

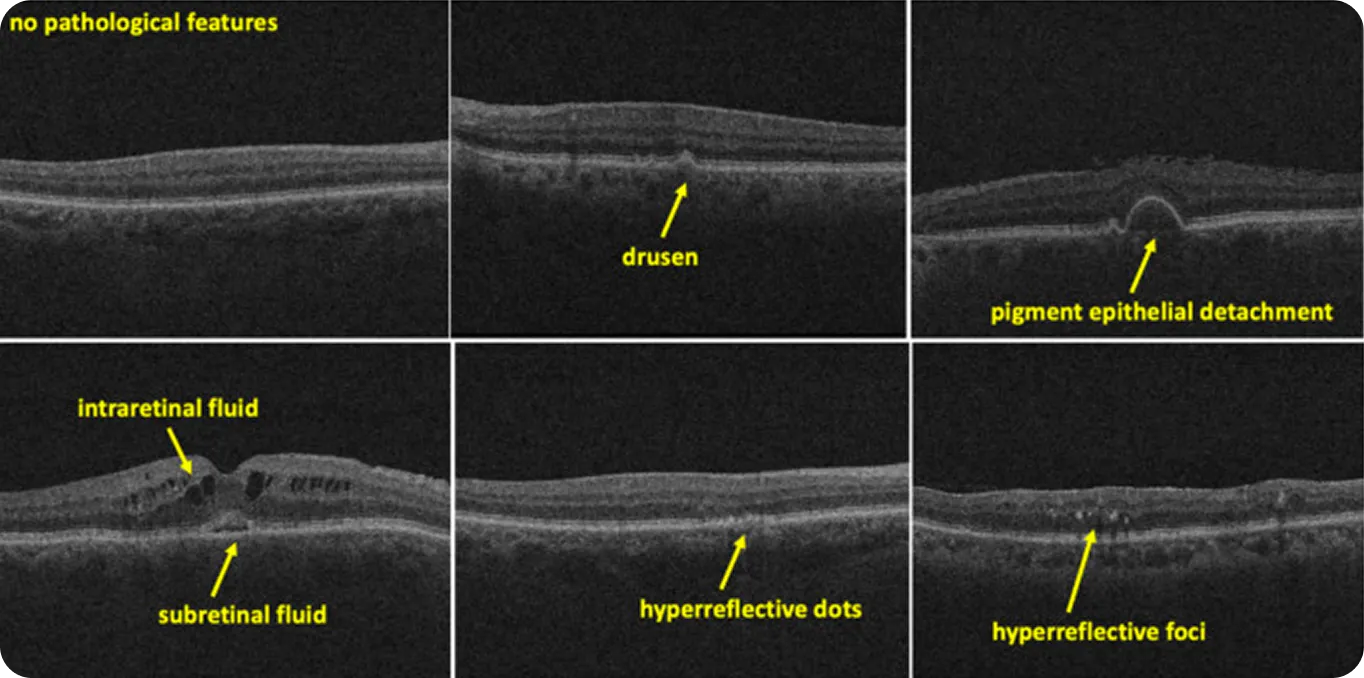

Im Bereich der medizinischen Bildgebung können selbst geringfügige Unterschiede in der Interpretation zu erheblichen Veränderungen der Ergebnisse führen. Radiologen werden beispielsweise häufig gebeten, Muster zu identifizieren, die subtil, mehrdeutig oder schwer zu definieren sind. Wenn diese Muster zu Trainingsdaten für KI-Systeme werden, steigt das Risiko. Wenn Experten denselben Scan unterschiedlich kennzeichnen, lernt das Modell möglicherweise die falschen Muster oder lernt überhaupt nicht.

Die Inter-Rater-Reliabilität hilft Teams, die mit solchen Daten arbeiten, zu beurteilen, wie konsistent Expertenurteile wirklich sind. In einer aktuellen Studie, die sich auf retinale OCT-Scans konzentrierte, kennzeichneten beispielsweise zwei Bewerter 500 Bilder.

Die Übereinstimmung war hoch für eindeutige Merkmale wie Drusen (gelbe Ablagerungen unter der Netzhaut) mit einem Kappa-Wert von 0,87. Aber für schwerer zu definierende Elemente wie hyperreflektive Foci (kleine, helle Flecken in Netzhautscans) sank der Wert auf 0,33. Dies zeigt, dass klarere, besser definierte Merkmale tendenziell zu konsistenteren Expertenurteilen führen, während mehrdeutige Merkmale mehr Interpretationsspielraum lassen.

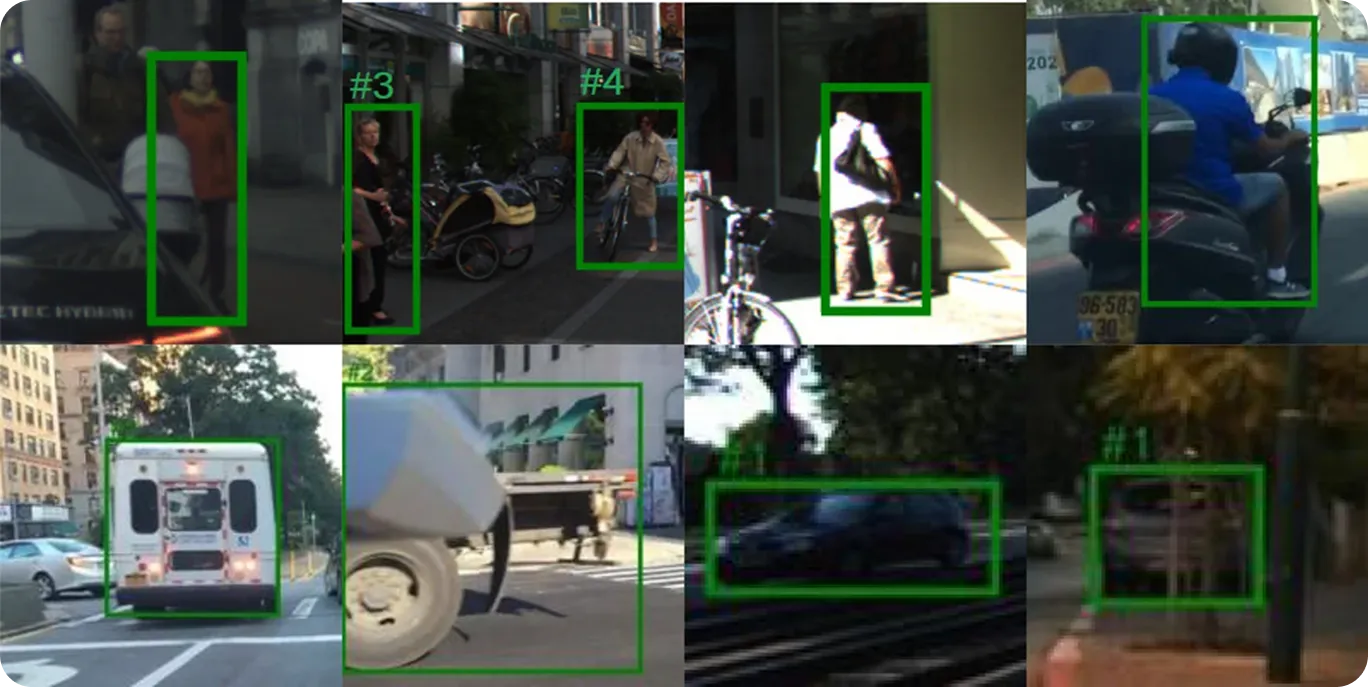

Das Training von KI-Modellen für ein autonomes Fahrsystem hängt von genauen, konsistenten Beschriftungen unter einer Vielzahl von Straßenbedingungen ab. Annotatoren, die an solchen Projekten arbeiten, werden in der Regel gebeten, Fußgänger, Fahrzeuge, Verkehrszeichen und Fahrbahnmarkierungen zu identifizieren, oft bei schlechten Lichtverhältnissen oder in überfüllten Szenen.

Diese Entscheidungen prägen, wie das Modell lernt, in rauen realen Umgebungen zu reagieren. Die Inter-Rater-Reliabilität ermöglicht es Teams zu überprüfen, ob diese Labels von allen Annotatoren auf die gleiche Weise angewendet werden.

Die Messung der Inter-Rater-Reliabilität ist zwar ein entscheidender Schritt beim Aufbau einer KI-Lösung, aber sie ist Teil eines umfassenderen Qualitätssicherungsprozesses. Hier sind einige andere Praktiken, die dazu beitragen können, die Datenqualität über Teams und Projekte hinweg zu verbessern:

Die Inter-Rater-Reliabilität misst, wie konsistent Personen Labels anwenden oder Entscheidungen treffen. Methoden wie Cohen’s Kappa, Fleiss’ Kappa und ICC helfen, diese Übereinstimmung zu quantifizieren. Mit klaren Richtlinien, Schulungen und Bias-Kontrolle führen zuverlässige Annotationen zu stärkeren Daten und besseren Modellergebnissen.

Treten Sie unserer Community bei und erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren. Wenn Sie Ihr eigenes Vision-KI-Projekt starten möchten, informieren Sie sich über unsere Lizenzoptionen. Auf unseren Lösungsseiten erfahren Sie auch, wie KI im Gesundheitswesen und Vision AI im Einzelhandel Wirkung zeigen.