Was bedeutet Bildabgleich bei Vision AI? Eine kurze Einführung

Erfahren Sie, wie der Bildabgleich in Vision AI funktioniert, und lernen Sie die Kerntechnologien kennen, mit denen Maschinen visuelle Daten detect, vergleichen und verstehen können.

Erfahren Sie, wie der Bildabgleich in Vision AI funktioniert, und lernen Sie die Kerntechnologien kennen, mit denen Maschinen visuelle Daten detect, vergleichen und verstehen können.

Wenn man sich zwei Bilder desselben Objekts anschaut, z. B. ein Gemälde und ein Foto eines Autos, ist es leicht zu erkennen, was sie gemeinsam haben. Bei Maschinen ist dies jedoch nicht so einfach.

Um solche Vergleiche anstellen zu können, stützen sich Maschinen auf die Computer Vision, einen Zweig der künstlichen Intelligenz (AI), der ihnen hilft, visuelle Informationen zu interpretieren und zu verstehen. Mit Hilfe der Computer Vision können Systeme Objekte detect , Szenen verstehen und Muster aus Bildern oder Videos extrahieren.

Insbesondere einige visuelle Aufgaben gehen über die Analyse eines einzelnen Bildes hinaus. Sie beinhalten den Vergleich von Bildern, um Ähnlichkeiten zu finden, Unterschiede zu erkennen oder Veränderungen im Laufe der Zeit track .

KI im Bereich der Bildverarbeitung umfasst ein breites Spektrum von Techniken. Eine wesentliche Fähigkeit, der so genannte Bildabgleich, konzentriert sich auf die Erkennung von Ähnlichkeiten zwischen Bildern, selbst wenn Beleuchtung, Winkel oder Hintergrund variieren. Diese Technik kann in verschiedenen Anwendungen eingesetzt werden, z. B. in der Robotik, Augmented Reality und Geo-Mapping.

In diesem Artikel erfahren Sie, was der Bildabgleich ist, seine wichtigsten Techniken und einige seiner praktischen Anwendungen. Legen wir los!

Der Bildabgleich ermöglicht es einem Computersystem zu erkennen, ob zwei Bilder einen ähnlichen Inhalt haben. Der Mensch kann dies intuitiv tun, indem er Formen, Farben und Muster wahrnimmt.

Computer hingegen stützen sich auf numerische Daten. Sie analysieren Bilder, indem sie jedes Pixel, die kleinste Einheit eines digitalen Bildes, untersuchen.

Jedes Bild wird als ein Raster von Pixeln gespeichert, und jedes Pixel enthält normalerweise Werte für Rot, Grün und Blau (RGB). Diese Werte können sich ändern, wenn ein Bild gedreht, in der Größe verändert, aus einem anderen Winkel betrachtet oder unter anderen Lichtverhältnissen aufgenommen wird. Aufgrund dieser Schwankungen ist ein Vergleich von Bildern Pixel für Pixel oft unzuverlässig.

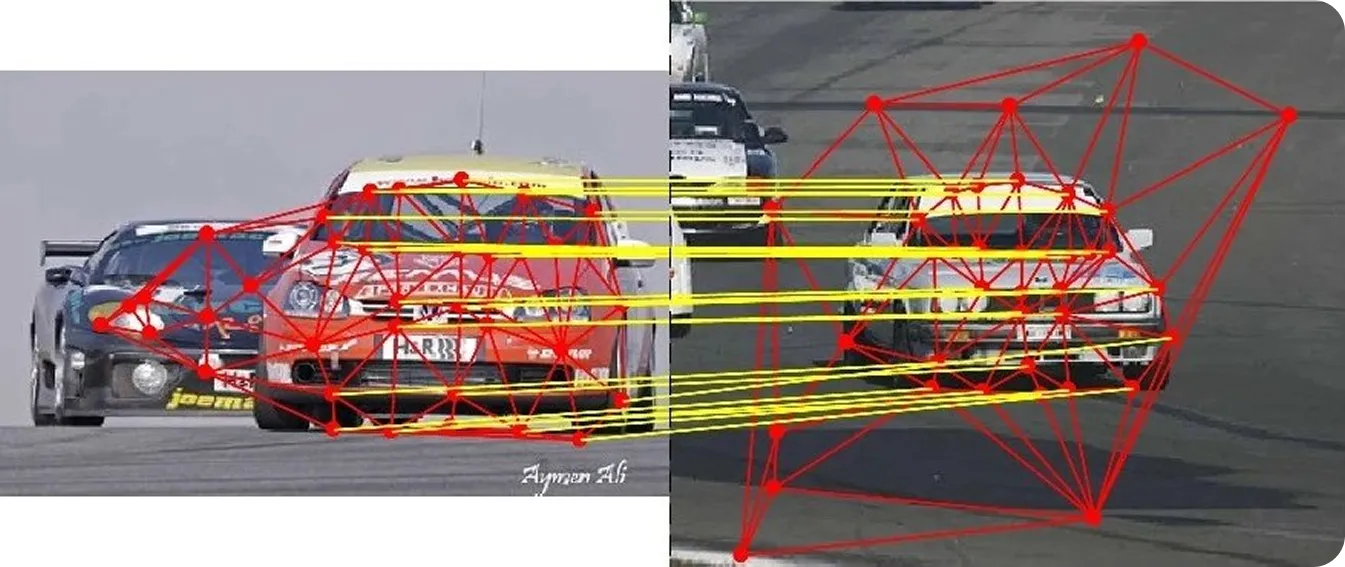

Um Vergleiche konsistenter zu machen, konzentriert sich der Bildabgleich auf lokale Merkmale wie Ecken, Kanten und strukturierte Bereiche, die auch bei geringfügigen Änderungen eines Bildes stabil bleiben. Durch die Erkennung dieser Merkmale oder Schlüsselpunkte über mehrere Bilder hinweg kann ein System diese mit viel größerer Genauigkeit vergleichen.

Dieser Prozess wird häufig in Anwendungsfällen wie Navigation, Lokalisierung, Augmented Reality, Kartierung, 3D-Rekonstruktion und visuelle Suche eingesetzt. Wenn Systeme dieselben Punkte in verschiedenen Bildern oder mehreren Frames identifizieren, können sie Bewegungen track , die Struktur der Szene verstehen und in dynamischen Umgebungen zuverlässige Entscheidungen treffen.

Der Bildabgleich umfasst mehrere wichtige Schritte, mit deren Hilfe Systeme ähnliche Regionen in Bildern erkennen und vergleichen können. Jeder Schritt verbessert die Genauigkeit, Konsistenz und Robustheit unter verschiedenen Bedingungen.

Im Folgenden wird Schritt für Schritt erklärt, wie der Bildabgleich funktioniert:

Bevor wir uns mit den realen Anwendungen des Bildabgleichs befassen, wollen wir zunächst einen genaueren Blick auf die in Computer-Vision-Systemen verwendeten Bildabgleichstechniken werfen.

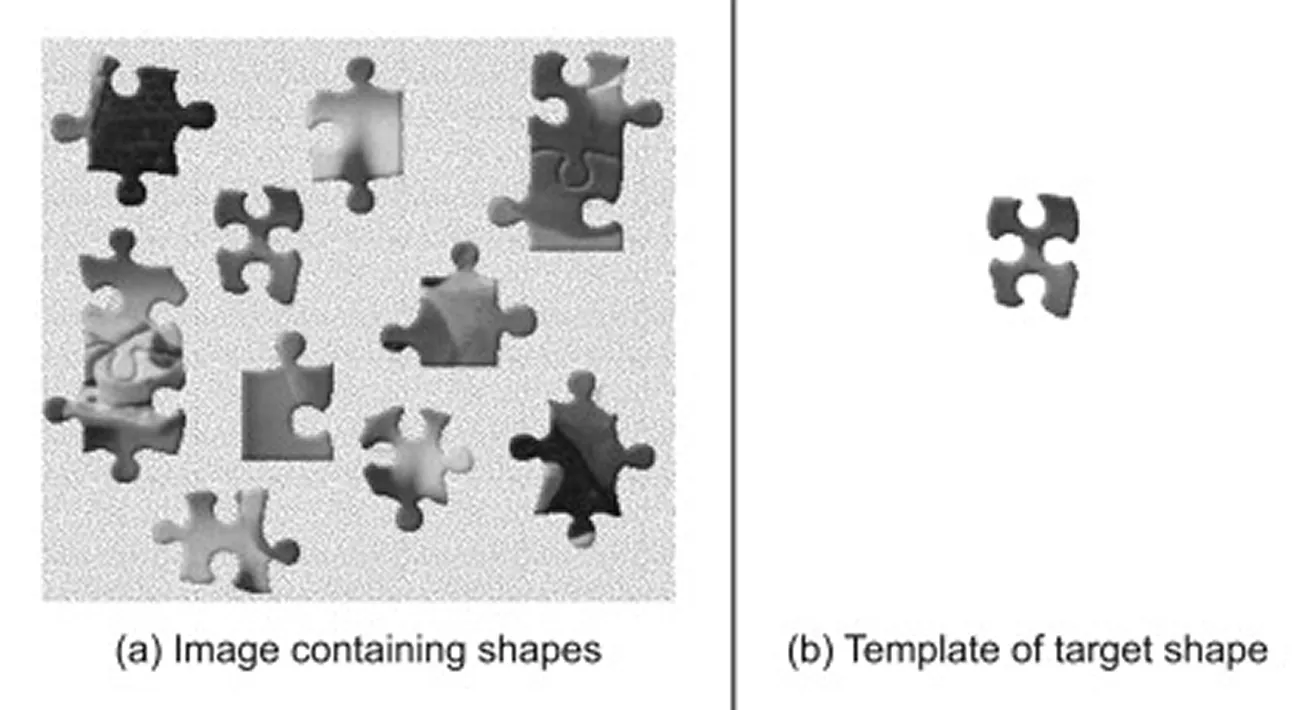

Der Schablonenabgleich ist eine der einfachsten Methoden für den Bildabgleich. Sie wird im Allgemeinen eher als Bildverarbeitungstechnik denn als moderne Computer-Vision-Methode betrachtet, da sie sich auf direkte Pixelvergleiche stützt und keine tieferen visuellen Merkmale extrahiert.

Es wird verwendet, um ein kleineres Referenzbild oder eine Vorlage innerhalb einer größeren Szene zu finden. Es arbeitet mit einem Algorithmus, der eine Vorlage über das Hauptbild schiebt und an jeder Position einen Ähnlichkeitswert berechnet, um zu messen, wie gut die beiden Regionen übereinstimmen. Der Bereich mit der höchsten Punktzahl gilt als die beste Übereinstimmung und zeigt an, wo das Objekt in der Szene am wahrscheinlichsten zu finden ist.

Diese Technik funktioniert gut, wenn Maßstab, Drehung und Beleuchtung des Objekts konstant bleiben, was sie zu einer guten Wahl für kontrollierte Umgebungen oder Basisvergleiche macht. Die Leistung nimmt jedoch ab, wenn das Objekt von der Vorlage abweicht, z. B. wenn sich seine Größe ändert, es gedreht oder teilweise verdeckt ist oder vor einem verrauschten oder komplexen Hintergrund erscheint.

Bevor sich Deep Learning durchsetzte, beruhte der Bildabgleich meist auf klassischen Computer-Vision-Algorithmen, die markante Schlüsselpunkte in einem Bild erkannten. Anstatt jeden einzelnen Pixel zu vergleichen, analysieren diese Methoden Bildgradienten oder Intensitätsänderungen, um Ecken, Kanten und strukturierte Bereiche hervorzuheben, die besonders auffallen.

Jeder erkannte Schlüsselpunkt wird dann durch eine kompakte numerische Zusammenfassung, einen so genannten Deskriptor, dargestellt. Beim Vergleich zweier Bilder wertet ein Matcher diese Deskriptoren aus, um die ähnlichsten Paare zu finden.

Ein hoher Ähnlichkeitswert deutet in der Regel darauf hin, dass derselbe physische Punkt in beiden Bildern vorkommt. Matcher verwenden auch spezifische Abstandsmetriken oder Bewertungsregeln, um zu beurteilen, wie eng die Merkmale übereinstimmen, was die allgemeine Zuverlässigkeit erhöht.

Im Folgenden werden einige der wichtigsten klassischen Computer-Vision-Algorithmen vorgestellt, die für den Bildabgleich verwendet werden:

Im Gegensatz zu klassischen Methoden, die sich auf bestimmte Regeln stützen, lernt Deep Learning automatisch Merkmale aus großen Datensätzen, d. h. aus Sammlungen visueller Daten, aus denen KI-Modelle Muster lernen. Diese Modelle laufen in der Regel auf GPUs (Graphics Processing Units), die die hohe Rechenleistung bereitstellen, die für die Verarbeitung großer Bildmengen und das effiziente Training komplexer neuronaler Netze erforderlich ist.

Dadurch sind KI-Modelle in der Lage, mit realen Veränderungen wie Beleuchtung, Kamerawinkel und Verdeckungen umzugehen. Einige Modelle fassen auch alle Schritte in einem einzigen Arbeitsablauf zusammen und unterstützen so eine robuste Leistung unter schwierigen Bedingungen.

Hier sind einige auf Deep Learning basierende Ansätze für die Extraktion und den Abgleich von Bildmerkmalen:

Nachdem wir nun ein besseres Verständnis für die Funktionsweise des Bildabgleichs haben, wollen wir uns einige reale Anwendungen ansehen, bei denen er eine wichtige Rolle spielt.

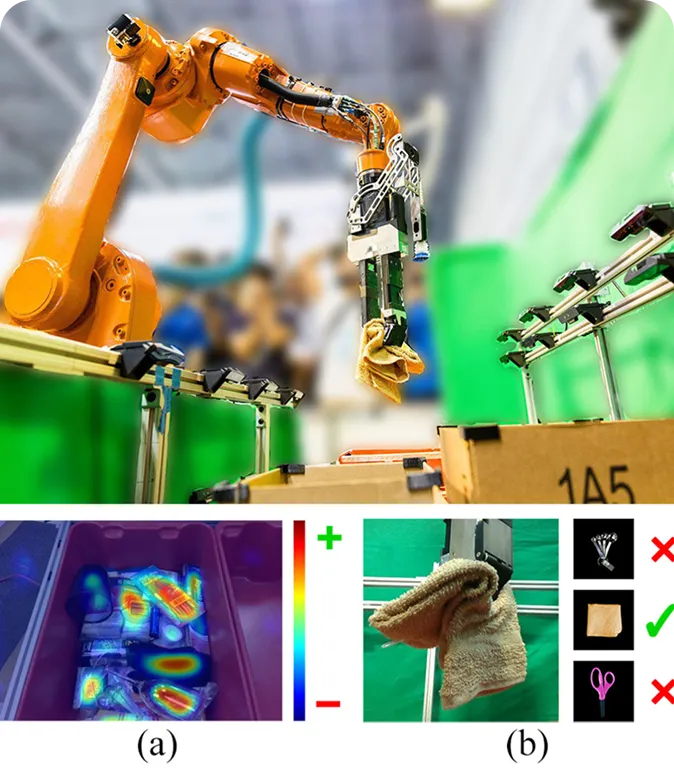

Roboter arbeiten oft in belebten und sich verändernden Umgebungen, in denen sie verstehen müssen, welche Objekte vorhanden sind und wie sie platziert sind. Der Bildabgleich kann Robotern helfen, Objekte zu verstehen, die sie sehen, indem sie sie mit gespeicherten oder Referenzbildern vergleichen. Dies erleichtert es den Robotern, Objekte zu erkennen, ihre Bewegungen track und sich anzupassen, selbst wenn sich die Beleuchtung oder der Kamerawinkel ändert.

In einem Lagerhaus beispielsweise kann ein robotergestütztes Pick-and-Place-System den Bildabgleich nutzen, um verschiedene Gegenstände zu identifizieren und zu handhaben. Der Roboter ergreift zunächst ein Objekt und vergleicht dann sein Bild mit Referenzmustern, um es zu identifizieren.

Sobald die Übereinstimmung gefunden ist, weiß der Roboter, wie er sie richtig sortieren oder platzieren muss. Mit diesem Ansatz können Roboter sowohl bekannte als auch neue Objekte erkennen, ohne das gesamte System neu zu trainieren. Er hilft ihnen auch, bessere Entscheidungen in Echtzeit zu treffen, z. B. beim Einräumen von Regalen, Zusammenbauen von Teilen oder Umordnen von Gegenständen.

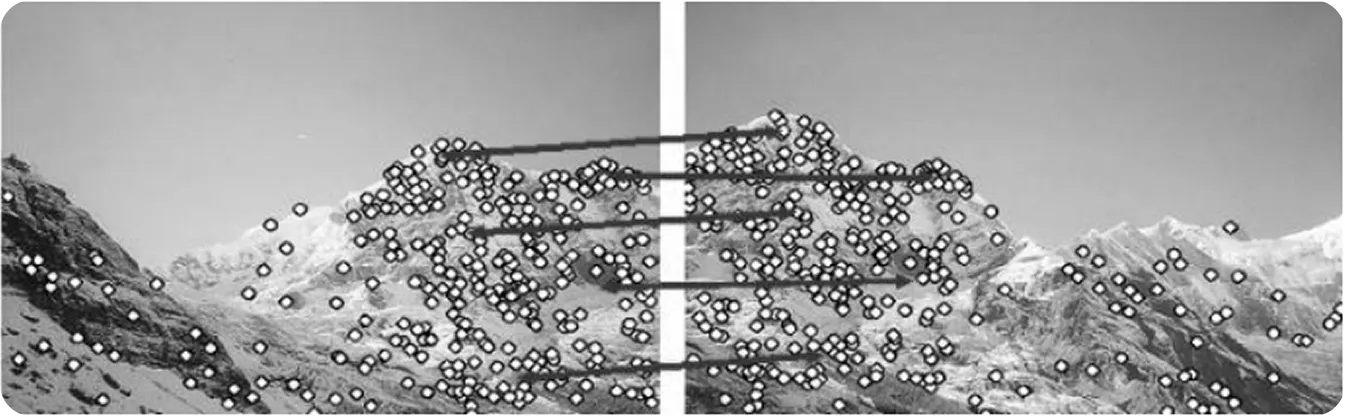

In Bereichen wie der Drohnenkartierung, der virtuellen Realität und der Gebäudeinspektion müssen Systeme häufig ein 3D-Modell aus mehreren 2D-Bildern rekonstruieren. Zu diesem Zweck stützen sie sich auf den Bildabgleich, um gemeinsame Schlüsselpunkte wie Ecken oder strukturierte Bereiche zu identifizieren, die in mehreren Bildern vorkommen.

Diese gemeinsamen Punkte helfen dem System zu verstehen, wie die Bilder im 3D-Raum zueinander stehen. Diese Idee ist eng verwandt mit Structure from Motion (SfM), einer Technik, die 3D-Strukturen aufbaut, indem sie Schlüsselpunkte in Bildern identifiziert und abgleicht, die aus verschiedenen Blickwinkeln aufgenommen wurden.

Wenn der Abgleich nicht genau ist, kann das resultierende 3D-Modell verzerrt oder unvollständig erscheinen. Aus diesem Grund haben Forscher daran gearbeitet, die Zuverlässigkeit des Bildabgleichs für die 3D-Rekonstruktion zu verbessern, und die jüngsten Fortschritte haben vielversprechende Ergebnisse gezeigt.

Ein interessantes Beispiel ist HashMatch, ein schneller und robuster Algorithmus für den Bildabgleich. HashMatch wandelt Bilddetails in kompakte Muster um, die als Hash-Codes bezeichnet werden. Dies erleichtert die Identifizierung korrekter Übereinstimmungen und die Entfernung von Ausreißern, selbst wenn die Beleuchtung oder der Blickwinkel variieren.

Bei Tests mit großen Datensätzen erzeugte HashMatch sauberere und realistischere 3D-Rekonstruktionsmodelle mit weniger Ausrichtungsfehlern. Dies macht es besonders nützlich für Anwendungen wie Drohnenkartierung, AR-Systeme und die Erhaltung des kulturellen Erbes, wo Präzision entscheidend ist.

Wenn es um Augmented Reality (AR) geht, ist es oft eine Herausforderung, virtuelle Objekte mit der realen Welt in Einklang zu bringen. Umgebungen im Freien können sich je nach Umgebungsbedingungen, wie Sonnenlicht und Wetter, ständig verändern. Geringfügige Unterschiede in der realen Welt können dazu führen, dass virtuelle Elemente instabil oder leicht deplatziert erscheinen.

Um dieses Problem zu lösen, nutzen AR-Systeme den Bildabgleich, um ihre Umgebung zu interpretieren. Durch den Vergleich von Live-Kamerabildern mit gespeicherten Referenzbildern können sie verstehen, wo sich der Nutzer befindet und wie sich die Szene verändert hat.

In einer Studie, die ein militärisches AR-Training im Freien mit einer XR-Brille (Extended Reality) beinhaltete, verwendeten die Forscher beispielsweise SIFT und andere merkmalsbasierte Methoden, um visuelle Details zwischen realen und Referenzbildern abzugleichen. Dank präziser Übereinstimmungen blieben die virtuellen Elemente korrekt an der realen Welt ausgerichtet, selbst wenn sich der Benutzer schnell bewegte oder sich die Beleuchtung änderte.

Der Bildabgleich ist eine Kernkomponente der Computer Vision, die es Systemen ermöglicht zu verstehen, wie sich verschiedene Bilder zueinander verhalten oder wie sich eine Szene im Laufe der Zeit verändert. Sie spielt eine entscheidende Rolle in der Robotik, der erweiterten Realität, der 3D-Rekonstruktion, der autonomen Navigation und vielen anderen realen Anwendungen, bei denen es auf Präzision und Stabilität ankommt.

Mit fortschrittlichen KI-Modellen wie SuperPoint und LoFTR werden die heutigen Systeme weitaus robuster als frühere Methoden. Mit der Weiterentwicklung von maschinellen Lerntechniken, spezialisierten Bildverarbeitungsmodulen, neuronalen Netzen und Datensätzen wird der Bildabgleich wahrscheinlich schneller, genauer und anpassungsfähiger werden.

Schließen Sie sich unserer wachsenden Community an und erkunden Sie unser GitHub-Repository für praktische KI-Ressourcen. Wenn Sie noch heute mit Vision AI arbeiten möchten, erkunden Sie unsere Lizenzierungsoptionen. Erfahren Sie auf unseren Lösungsseiten, wie KI in der Landwirtschaft die Landwirtschaft verändert und wie Vision AI im Gesundheitswesen die Zukunft prägt.