Optimierung der Ultralytics YOLO Modelle mit der TensorRT Integration

Erfahren Sie, wie Sie Ultralytics YOLO mit der TensorRT exportieren können, um schnellere und effizientere KI-Leistung auf NVIDIA für Echtzeitanwendungen zu erzielen.

Erfahren Sie, wie Sie Ultralytics YOLO mit der TensorRT exportieren können, um schnellere und effizientere KI-Leistung auf NVIDIA für Echtzeitanwendungen zu erzielen.

Stellen Sie sich vor, ein selbstfahrendes Auto fährt durch eine belebte Straße und hat nur Millisekunden Zeit, um einen Fußgänger detect , der über den Bordstein tritt. Gleichzeitig muss es vielleicht ein Stoppschild erkennen, das teilweise von einem Baum verdeckt wird, oder schnell auf ein Fahrzeug in der Nähe reagieren, das in seine Fahrspur ausweicht. In solchen Situationen sind Geschwindigkeit und Echtzeitreaktionen entscheidend.

Hier spielt die künstliche Intelligenz (KI) eine Schlüsselrolle, insbesondere die Computer Vision, ein Zweig der KI, der Maschinen hilft, visuelle Daten zu interpretieren. Damit Computer-Vision-Lösungen in realen Umgebungen zuverlässig funktionieren, müssen sie oft Informationen schnell verarbeiten, mehrere Aufgaben gleichzeitig bewältigen und Speicher effizient nutzen.

Eine Möglichkeit, dies zu erreichen, ist die Hardwarebeschleunigung, bei der spezialisierte Geräte wie Grafikprozessoren (GPUs) eingesetzt werden, um Modelle schneller auszuführen. NVIDIA sind dank ihrer Fähigkeit, niedrige Latenzzeiten und einen hohen Durchsatz zu liefern, für solche Aufgaben besonders gut geeignet.

Die Ausführung eines Modells auf einer GPU garantiert jedoch nicht immer eine optimale Leistung. KI-Modelle für die Bildverarbeitung müssen in der Regel optimiert werden, um die Fähigkeiten von Hardware-Geräten voll auszuschöpfen. Um die volle Leistung mit einer bestimmten Hardware zu erreichen, müssen wir das Modell so kompilieren, dass es den spezifischen Satz von Anweisungen für die Hardware verwendet.

TensorRT beispielsweise ist ein Exportformat und eine Optimierungsbibliothek, die von NVIDIA entwickelt wurde, um die Leistung von High-End-Rechnern zu verbessern. Sie nutzt fortschrittliche Techniken, um die Inferenzzeit bei gleichbleibender Genauigkeit erheblich zu reduzieren.

In diesem Artikel werden wir die von Ultralytics unterstützte TensorRT erkunden und zeigen, wie Sie Ihr YOLO11 für eine schnellere und effizientere Bereitstellung auf NVIDIA exportieren können. Lassen Sie uns beginnen!

TensorRT ist ein von NVIDIA entwickeltes Toolkit, mit dem KI-Modelle schneller und effizienter auf NVIDIA ausgeführt werden können. Es wurde für reale Anwendungen entwickelt, bei denen es auf Geschwindigkeit und Leistung ankommt, wie z. B. selbstfahrende Autos und Qualitätskontrolle in der Fertigung und Pharmazie.

TensorRT enthält Werkzeuge wie Compiler und Modelloptimierer, die hinter den Kulissen arbeiten können, um sicherzustellen, dass Ihre Modelle mit geringer Latenz laufen und einen höheren Durchsatz bewältigen können.

Die von Ultralytics unterstützte TensorRT funktioniert durch die Optimierung Ihres YOLO für eine effizientere Ausführung auf GPUs unter Verwendung von Methoden wie der Reduzierung der Genauigkeit. Dies bezieht sich auf die Verwendung von Formaten mit niedrigeren Bits, wie z. B. 16-Bit-Gleitkomma (FP16) oder 8-Bit-Integer (INT8), um Modelldaten darzustellen, was die Speichernutzung reduziert und die Berechnung mit minimalen Auswirkungen auf die Genauigkeit beschleunigt.

Außerdem werden kompatible neuronale Netzwerkschichten in optimierten TensorRT verschmolzen, um die Speichernutzung zu reduzieren, was zu einer schnelleren und effizienteren Inferenz führt.

Bevor wir besprechen, wie Sie YOLO11 mit Hilfe der TensorRT exportieren können, lassen Sie uns einen Blick auf einige Schlüsselmerkmale des TensorRT werfen:

Der Export von Ultralytics YOLO Modellen wie Ultralytics YOLO11 in das TensorRT Modellformat ist einfach. Lassen Sie uns die einzelnen Schritte durchgehen.

Um loszulegen, können Sie das Python mit einem Paketmanager wie "pip" installieren. Dazu führen Sie den Befehl "pip install ultralytics" in Ihrer Eingabeaufforderung oder Ihrem Terminal aus.

Nach erfolgreicher Installation des Ultralytics Python können Sie Modelle für verschiedene Computer-Vision-Aufgaben wie Objekterkennung, Klassifizierung und Instanzsegmentierung trainieren, testen, feinabstimmen, exportieren und einsetzen. Sollten Sie bei der Installation des Pakets auf Schwierigkeiten stoßen, finden Sie im Leitfaden für allgemeine Probleme Lösungen und Tipps.

Für den nächsten Schritt benötigen Sie ein NVIDIA . Verwenden Sie den folgenden Codeausschnitt, um YOLOv11 zu laden und in das TensorRT Modellformat zu exportieren. Er lädt eine vortrainierte Nano-Variante des YOLO11 (yolo11n.pt) und exportiert es als TensorRT (yolo11n.engine), wodurch es für den Einsatz auf NVIDIA bereit ist.

from ultralytics import YOLO

model = YOLO("yolo11n.pt")

model.export(format="engine") Nachdem Sie Ihr Modell in das TensorRT konvertiert haben, können Sie es für verschiedene Anwendungen einsetzen.

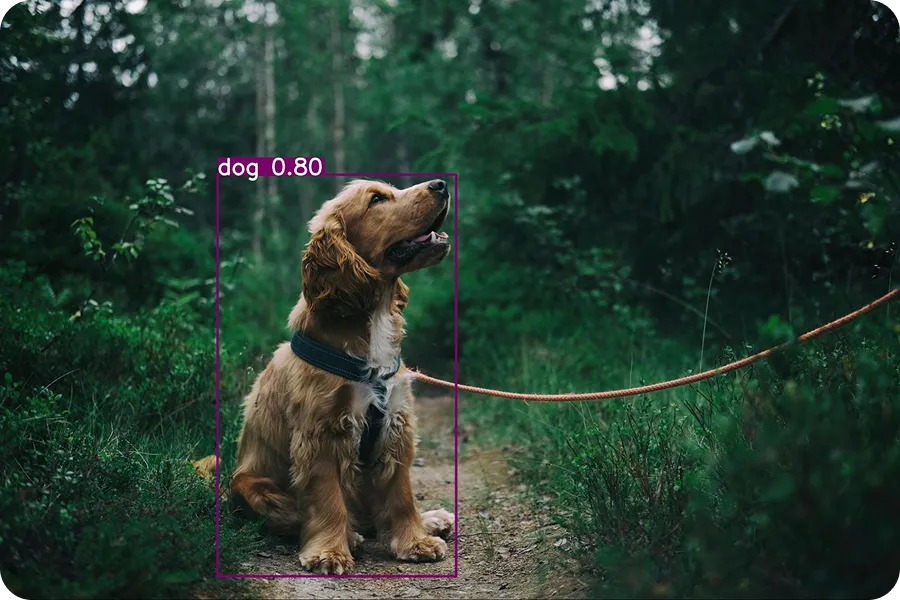

Das folgende Beispiel zeigt, wie man das exportierte YOLO11 (yolo11n.engine) lädt und eine Inferenz damit durchführt. Beim Inferenzieren wird das trainierte Modell verwendet, um Vorhersagen für neue Daten zu treffen. In diesem Fall verwenden wir ein Eingabebild eines Hundes, um das Modell zu testen.

tensorrt_model = YOLO("yolo11n.engine")

results = tensorrt_model("https://images.pexels.com/photos/1254140/pexels-photo-1254140.jpeg?auto=compress&cs=tinysrgb&w=1260&h=750&dpr=2.jpg", save=True)Wenn Sie diesen Code ausführen, wird das folgende Ausgabebild im Ordner detect gespeichert.

Das Ultralytics Python unterstützt verschiedene Integrationen, die den Export von YOLO in verschiedene Formate wie TorchScript, CoreML, ONNX und TensorRT ermöglichen. Wann sollten Sie also die TensorRT verwenden?

Hier sind ein paar Faktoren, die das TensorRT von anderen Export-Integrationsoptionen unterscheiden:

Ultralytics YOLO , die in das TensorRT exportiert werden, können in einer Vielzahl von realen Szenarien eingesetzt werden. Diese optimierten Modelle sind besonders nützlich, wenn schnelle, effiziente KI-Leistung entscheidend ist. Sehen wir uns einige interessante Beispiele an, wie sie verwendet werden können.

Eine Vielzahl von Aufgaben in Einzelhandelsgeschäften, wie das Scannen von Barcodes, das Wiegen von Produkten oder das Verpacken von Artikeln, werden immer noch manuell von Mitarbeitern erledigt. Sich ausschließlich auf Mitarbeiter zu verlassen, kann jedoch den Betrieb verlangsamen und zu Frustration bei den Kunden führen, insbesondere an der Kasse. Lange Schlangen sind sowohl für Käufer als auch für Ladenbesitzer unpraktisch. Intelligente Self-Checkout-Kassen sind eine großartige Lösung für dieses Problem.

Diese Zähler nutzen Computer Vision und GPUs, um den Prozess zu beschleunigen und so die Wartezeiten zu verkürzen. Computer Vision ermöglicht es diesen Systemen, ihre Umgebung durch Aufgaben wie die Objekterkennung zu sehen und zu verstehen. Fortschrittliche Modelle wie YOLO11 können, wenn sie mit Tools wie TensorRT optimiert werden, auf GPU viel schneller laufen.

Diese exportierten Modelle eignen sich gut für intelligente Einzelhandelseinrichtungen, die kompakte, aber leistungsstarke Hardware-Geräte wie den NVIDIA Jetson Nano verwenden, der speziell für Edge-KI-Anwendungen entwickelt wurde.

Ein Computer-Vision-Modell wie YOLO11 kann individuell trainiert werden, um fehlerhafte Produkte in der Fertigungsindustrie detect . Sobald das Modell trainiert ist, kann es in das TensorRT exportiert werden, um in Einrichtungen mit leistungsstarken KI-Systemen eingesetzt zu werden.

Während sich die Produkte über die Förderbänder bewegen, nehmen Kameras Bilder auf, und das YOLO11 , das im TensorRT läuft, analysiert sie in Echtzeit, um Fehler zu erkennen. Auf diese Weise können Unternehmen Probleme schnell und genau erkennen, Fehler reduzieren und die Effizienz steigern.

In ähnlicher Weise verwenden Industrien wie die Pharmaindustrie diese Art von Systemen, um Defekte in medizinischen Verpackungen zu identifizieren. Tatsächlich wird der globale Markt für intelligente Fehlererkennungssysteme bis 2026 voraussichtlich auf 5 Milliarden Dollar anwachsen.

Während die TensorRT viele Vorteile mit sich bringt, wie z.B. schnellere Inferenzgeschwindigkeiten und geringere Latenzzeiten, gibt es einige Einschränkungen, die zu beachten sind:

Durch den Export von Ultralytics YOLO in das TensorRT laufen sie wesentlich schneller und effizienter, was sie ideal für Echtzeitaufgaben wie die Erkennung von Defekten in Fabriken, den Betrieb intelligenter Kassensysteme oder die Überwachung belebter Stadtgebiete macht.

Diese Optimierung hilft den Modellen, auf NVIDIA besser zu funktionieren, indem sie die Vorhersagen beschleunigt und den Speicher- und Stromverbrauch reduziert. Obwohl es einige Einschränkungen gibt, macht die Leistungssteigerung die TensorRT zu einer guten Wahl für jeden, der Hochgeschwindigkeits-Computer-Vision-Systeme auf NVIDIA entwickelt.

Möchten Sie mehr über KI erfahren? Erkunden Sie unser GitHub-Repository, vernetzen Sie sich mit unserer Community und informieren Sie sich über unsere Lizenzoptionen, um Ihr Computer-Vision-Projekt zu starten. Erfahren Sie mehr über Innovationen wie KI in der Fertigung und Computer Vision in der Logistik auf unseren Lösungsseiten.