Tìm hiểu cách xuất khẩu Ultralytics YOLO các mô hình sử dụng TensorRT tích hợp để có hiệu suất AI nhanh hơn, hiệu quả hơn trên NVIDIA GPU cho các ứng dụng thời gian thực.

Tìm hiểu cách xuất khẩu Ultralytics YOLO các mô hình sử dụng TensorRT tích hợp để có hiệu suất AI nhanh hơn, hiệu quả hơn trên NVIDIA GPU cho các ứng dụng thời gian thực.

Hãy xem xét một chiếc xe tự lái di chuyển qua một con phố đông đúc chỉ trong vài mili giây detect Người đi bộ bước ra khỏi lề đường. Đồng thời, người đi bộ có thể cần nhận ra biển báo dừng bị che khuất một phần bởi cây cối hoặc phản ứng nhanh với một phương tiện gần đó đang lấn sang làn đường của mình. Trong những tình huống như vậy, tốc độ và phản ứng tức thời là rất quan trọng.

Đây là nơi trí tuệ nhân tạo (AI), đặc biệt là thị giác máy tính, một nhánh của AI giúp máy móc diễn giải dữ liệu trực quan, đóng một vai trò quan trọng. Để các giải pháp thị giác máy tính hoạt động đáng tin cậy trong môi trường thực tế, chúng thường cần xử lý thông tin nhanh chóng, xử lý nhiều tác vụ cùng một lúc và sử dụng bộ nhớ hiệu quả.

Một cách để đạt được điều này là thông qua tăng tốc phần cứng, sử dụng các thiết bị chuyên dụng như bộ xử lý đồ họa (GPU) để chạy mô hình nhanh hơn. NVIDIA GPU đặc biệt nổi tiếng với những tác vụ như vậy nhờ khả năng cung cấp độ trễ thấp và thông lượng cao.

Tuy nhiên, chạy một mô hình trên một GPU Việc duy trì nguyên trạng không phải lúc nào cũng đảm bảo hiệu suất tối ưu. Các mô hình Vision AI thường yêu cầu tối ưu hóa để tận dụng tối đa khả năng của thiết bị phần cứng. Để đạt được hiệu suất tối đa với phần cứng cụ thể, chúng ta cần biên dịch mô hình để sử dụng bộ hướng dẫn cụ thể cho phần cứng.

Ví dụ, TensorRT là một thư viện định dạng xuất khẩu và tối ưu hóa được phát triển bởi NVIDIA để nâng cao hiệu suất trên các máy móc cao cấp. Nó sử dụng các kỹ thuật tiên tiến để giảm đáng kể thời gian suy luận trong khi vẫn duy trì độ chính xác.

Trong bài viết này, chúng ta sẽ khám phá tích hợp TensorRT được hỗ trợ bởi Ultralytics và hướng dẫn cách bạn có thể xuất khẩu YOLO11 mô hình triển khai nhanh hơn, hiệu quả hơn trên NVIDIA phần cứng. Hãy bắt đầu thôi!

TensorRT là một bộ công cụ được phát triển bởi NVIDIA để giúp các mô hình AI chạy nhanh hơn và hiệu quả hơn trên NVIDIA GPU. Nó được thiết kế cho các ứng dụng thực tế, nơi tốc độ và hiệu suất thực sự quan trọng, như xe tự lái và kiểm soát chất lượng trong sản xuất và dược phẩm.

TensorRT bao gồm các công cụ như trình biên dịch và trình tối ưu hóa mô hình có thể hoạt động ngầm để đảm bảo mô hình của bạn chạy với độ trễ thấp và có thể xử lý thông lượng cao hơn.

Các TensorRT tích hợp được hỗ trợ bởi Ultralytics hoạt động bằng cách tối ưu hóa của bạn YOLO Mô hình chạy hiệu quả hơn trên GPU bằng các phương pháp như giảm độ chính xác . Điều này đề cập đến việc sử dụng các định dạng bit thấp hơn, chẳng hạn như số dấu phẩy động 16 bit (FP16) hoặc số nguyên 8 bit (INT8), để biểu diễn dữ liệu mô hình, giúp giảm mức sử dụng bộ nhớ và tăng tốc tính toán với tác động tối thiểu đến độ chính xác.

Ngoài ra, các lớp mạng nơ-ron tương thích được hợp nhất trong tối ưu hóa TensorRT các mô hình để giảm mức sử dụng bộ nhớ, mang lại suy luận nhanh hơn và hiệu quả hơn.

Trước khi chúng ta thảo luận về cách bạn có thể xuất khẩu YOLO11 sử dụng TensorRT tích hợp, chúng ta hãy xem xét một số tính năng chính của TensorRT định dạng mô hình:

Xuất các mô hình YOLO Ultralytics như Ultralytics YOLO11 đến TensorRT Định dạng mô hình rất dễ. Chúng ta hãy cùng tìm hiểu các bước thực hiện.

Để bắt đầu, bạn có thể cài đặt gói Ultralytics Python bằng trình quản lý gói như 'pip'. Bạn có thể thực hiện việc này bằng cách chạy lệnh "pip install ultralytics " trong dấu nhắc lệnh hoặc terminal.

Sau khi cài đặt thành công Ultralytics Python Với gói này, bạn có thể huấn luyện, kiểm tra, tinh chỉnh, xuất và triển khai các mô hình cho nhiều tác vụ thị giác máy tính khác nhau, chẳng hạn như phát hiện đối tượng, phân loại và phân đoạn phiên bản. Trong quá trình cài đặt gói, nếu gặp bất kỳ khó khăn nào, bạn có thể tham khảo hướng dẫn Các vấn đề thường gặp để biết giải pháp và mẹo.

Đối với bước tiếp theo, bạn sẽ cần một NVIDIA thiết bị. Sử dụng đoạn mã bên dưới để tải và xuất YOLOv11 vào TensorRT định dạng mô hình. Nó tải một biến thể nano được đào tạo trước của YOLO11 mô hình (yolo11n.pt) và xuất nó dưới dạng TensorRT tệp động cơ (yolo11n.engine), giúp nó sẵn sàng để triển khai trên NVIDIA thiết bị.

from ultralytics import YOLO

model = YOLO("yolo11n.pt")

model.export(format="engine") Sau khi chuyển đổi mô hình của bạn thành TensorRT định dạng này, bạn có thể triển khai nó cho nhiều ứng dụng khác nhau.

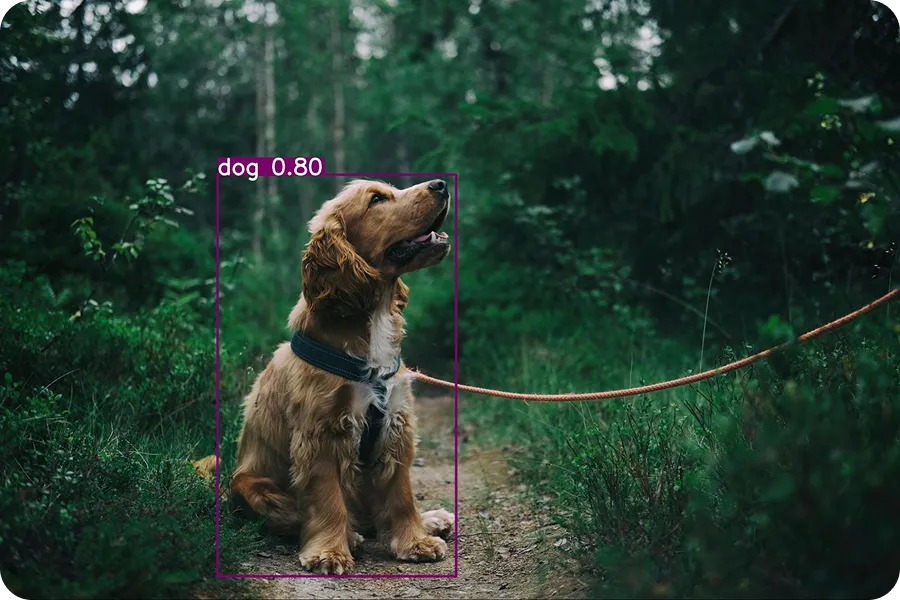

Ví dụ dưới đây cho thấy cách tải dữ liệu đã xuất YOLO11 mô hình (yolo11n.engine) và chạy suy luận bằng mô hình đó. Suy luận bao gồm việc sử dụng mô hình đã được đào tạo để đưa ra dự đoán dựa trên dữ liệu mới. Trong trường hợp này, chúng ta sẽ sử dụng hình ảnh đầu vào của một chú chó để kiểm tra mô hình.

tensorrt_model = YOLO("yolo11n.engine")

results = tensorrt_model("https://images.pexels.com/photos/1254140/pexels-photo-1254140.jpeg?auto=compress&cs=tinysrgb&w=1260&h=750&dpr=2.jpg", save=True)Khi bạn chạy đoạn mã này, hình ảnh đầu ra sau sẽ được lưu trong thư mục runs/ detect /predict .

Các Ultralytics Python gói hỗ trợ nhiều tích hợp khác nhau cho phép xuất YOLO các mô hình thành các định dạng khác nhau như TorchScript , CoreML , ONNX , Và TensorRT . Vì vậy, khi nào bạn nên chọn sử dụng TensorRT tích hợp?

Dưới đây là một số yếu tố thiết lập TensorRT định dạng mô hình ngoài các tùy chọn tích hợp xuất khác:

Ultralytics YOLO các mô hình được xuất khẩu sang TensorRT Định dạng này có thể được triển khai trong nhiều tình huống thực tế. Các mô hình được tối ưu hóa này đặc biệt hữu ích khi hiệu suất AI nhanh chóng và hiệu quả là yếu tố then chốt. Hãy cùng khám phá một số ví dụ thú vị về cách chúng có thể được sử dụng.

Một loạt các công việc trong các cửa hàng bán lẻ, chẳng hạn như quét mã vạch, cân sản phẩm hoặc đóng gói hàng hóa, vẫn được nhân viên thực hiện thủ công. Tuy nhiên, việc chỉ dựa vào nhân viên có thể làm chậm hoạt động và gây khó chịu cho khách hàng, đặc biệt là tại quầy thanh toán. Hàng dài chờ đợi gây bất tiện cho cả người mua sắm và chủ cửa hàng. Quầy tự thanh toán thông minh là một giải pháp tuyệt vời cho vấn đề này.

Các bộ đếm này sử dụng công nghệ thị giác máy tính và GPU để tăng tốc quy trình, giúp giảm thời gian chờ đợi. Thị giác máy tính cho phép các hệ thống này quan sát và hiểu môi trường xung quanh thông qua các tác vụ như phát hiện vật thể. Các mô hình tiên tiến như YOLO11 , khi được tối ưu hóa bằng các công cụ như TensorRT , có thể chạy nhanh hơn nhiều trên GPU thiết bị.

Các mô hình xuất khẩu này rất phù hợp cho các thiết lập bán lẻ thông minh sử dụng các thiết bị phần cứng nhỏ gọn nhưng mạnh mẽ như NVIDIA Jetson Nano , được thiết kế đặc biệt cho các ứng dụng AI biên.

Một mô hình thị giác máy tính như YOLO11 có thể được đào tạo tùy chỉnh để detect sản phẩm lỗi trong ngành sản xuất. Sau khi được đào tạo, mô hình có thể được xuất khẩu sang TensorRT định dạng để triển khai tại các cơ sở được trang bị hệ thống AI hiệu suất cao.

Khi sản phẩm di chuyển dọc theo băng chuyền, máy ảnh sẽ chụp ảnh và YOLO11 mô hình, đang chạy trong TensorRT Định dạng này phân tích chúng theo thời gian thực để phát hiện lỗi. Thiết lập này cho phép các công ty phát hiện sự cố nhanh chóng và chính xác, giảm thiểu lỗi và cải thiện hiệu quả.

Tương tự, các ngành công nghiệp như dược phẩm đang sử dụng các loại hệ thống này để xác định các khuyết tật trong bao bì y tế. Trên thực tế, thị trường toàn cầu cho hệ thống phát hiện khuyết tật thông minh dự kiến sẽ tăng lên 5 tỷ đô la vào năm 2026.

Trong khi TensorRT Việc tích hợp mang lại nhiều lợi thế, chẳng hạn như tốc độ suy luận nhanh hơn và độ trễ giảm, sau đây là một số hạn chế cần lưu ý:

Xuất khẩu Ultralytics YOLO các mô hình cho TensorRT định dạng này giúp chúng chạy nhanh hơn và hiệu quả hơn đáng kể, lý tưởng cho các tác vụ thời gian thực như phát hiện lỗi trong nhà máy, cung cấp năng lượng cho hệ thống thanh toán thông minh hoặc giám sát các khu vực đô thị đông đúc.

Sự tối ưu hóa này giúp các mô hình hoạt động tốt hơn NVIDIA GPU bằng cách tăng tốc độ dự đoán và giảm mức sử dụng bộ nhớ và điện năng. Mặc dù có một vài hạn chế, nhưng việc tăng cường hiệu suất giúp TensorRT tích hợp là một lựa chọn tuyệt vời cho bất kỳ ai xây dựng hệ thống thị giác máy tính tốc độ cao trên NVIDIA phần cứng.

Bạn muốn tìm hiểu thêm về AI? Khám phá kho lưu trữ GitHub của chúng tôi, kết nối với cộng đồng của chúng tôi và xem các tùy chọn cấp phép của chúng tôi để khởi động dự án thị giác máy tính của bạn. Tìm hiểu thêm về những đổi mới như AI trong sản xuất và thị giác máy tính trong ngành logistics trên các trang giải pháp của chúng tôi.