CV-Projekte mit den Open-Source-Tools von Hugging Face vorantreiben

Erleben Sie mit uns eine Keynote von der YOLO Vision 2024, die sich mit der Frage beschäftigt, wie die Open-Source-Tools von Hugging Facedie KI-Entwicklung vorantreiben.

Erleben Sie mit uns eine Keynote von der YOLO Vision 2024, die sich mit der Frage beschäftigt, wie die Open-Source-Tools von Hugging Facedie KI-Entwicklung vorantreiben.

Die Wahl der richtigen Algorithmen ist nur ein Teil der Entwicklung wirkungsvoller Computer-Vision-Lösungen. KI-Ingenieure arbeiten oft mit großen Datensätzen, optimieren Modelle für bestimmte Aufgaben und optimieren KI-Systeme für die Leistung in der realen Welt. Da KI-Anwendungen immer schneller eingesetzt werden, wächst auch der Bedarf an Tools, die diese Prozesse vereinfachen.

Auf der YOLO Vision 2024 (YV24), der jährlichen Hybrid-Veranstaltung von Ultralytics, kamen KI-Experten und Technikbegeisterte zusammen, um die neuesten Innovationen im Bereich Computer Vision zu erkunden. Die Veranstaltung regte Diskussionen zu verschiedenen Themen an, wie z. B. zu Möglichkeiten, die Entwicklung von KI-Anwendungen zu beschleunigen.

Ein wichtiger Höhepunkt der Veranstaltung war eine Keynote über Hugging Face, eine Open-Source-KI-Plattform, die das Training, die Optimierung und den Einsatz von Modellen vereinfacht. Pavel Lakubovskii, ein Ingenieur für maschinelles Lernen bei Hugging Face, erläuterte, wie seine Tools die Arbeitsabläufe für Computer-Vision-Aufgaben wie die Erkennung von Objekten in Bildern, die Kategorisierung von Bildern in verschiedene Gruppen und die Erstellung von Vorhersagen ohne vorheriges Training an spezifischen Beispielen (Zero-Shot-Learning) verbessern.

Hugging Face Hub hostet und bietet Zugang zu verschiedenen KI- und Computer-Vision-Modellen wie Ultralytics YOLO11. In diesem Artikel fassen wir die wichtigsten Erkenntnisse aus Pavels Vortrag zusammen und zeigen, wie Entwickler die Open-Source-Tools von Hugging Facenutzen können, um KI-Modelle schnell zu erstellen und einzusetzen.

Pavel begann seinen Vortrag mit der Vorstellung von Hugging Face , einer Open-Source-KI-Plattform, die bereits trainierte Modelle für eine Vielzahl von Anwendungen bietet. Diese Modelle wurden für verschiedene Bereiche der KI entwickelt, darunter die Verarbeitung natürlicher Sprache (NLP), Computer Vision und multimodale KI, die es Systemen ermöglicht, verschiedene Arten von Daten wie Text, Bilder und Audio zu verarbeiten.

Pavel erwähnte, dass Hugging Face Hub inzwischen mehr als 1 Million Modelle beherbergt und Entwickler leicht Modelle finden können, die für ihre spezifischen Projekte geeignet sind. Hugging Face zielt darauf ab, die KI-Entwicklung zu vereinfachen, indem es Tools für das Training, die Feinabstimmung und den Einsatz von Modellen anbietet. Wenn Entwickler mit verschiedenen Modellen experimentieren können, vereinfacht dies den Prozess der Integration von KI in reale Anwendungen.

Ursprünglich war Hugging Face für NLP bekannt, hat sich aber inzwischen auf Computer Vision und multimodale KI ausgeweitet und ermöglicht es Entwicklern, ein breiteres Spektrum von KI-Aufgaben zu bewältigen. Es gibt auch eine starke Community, in der Entwickler zusammenarbeiten, Erkenntnisse austauschen und über Foren, Discord und GitHub Unterstützung erhalten können.

Pavel erläuterte ausführlich, wie die Tools von Hugging Facedie Entwicklung von Bildverarbeitungsanwendungen erleichtern. Entwickler können sie für Aufgaben wie Bildklassifizierung, Objekterkennung und Bildverarbeitungssprachanwendungen verwenden.

Er wies auch darauf hin, dass viele dieser Computer-Vision-Aufgaben mit vortrainierten Modellen gelöst werden können, die auf dem Hugging Face Hub zur Verfügung stehen, was Zeit spart, da das Training von Grund auf entfällt. Tatsächlich bietet Hugging Face über 13.000 vortrainierte Modelle für Bildklassifizierungsaufgaben, darunter solche für die Klassifizierung von Lebensmitteln, Haustieren und Emotionen.

Er betonte die Zugänglichkeit dieser Modelle und sagte: „Sie müssen wahrscheinlich nicht einmal ein Modell für Ihr Projekt trainieren – Sie finden vielleicht eines im Hub, das bereits von jemandem aus der Community trainiert wurde.“

Als weiteres Beispiel erläuterte Pavel, wie Hugging Face bei der Objekterkennung helfen kann, einer Schlüsselfunktion in der Computer Vision, die zur Identifizierung und Lokalisierung von Objekten in Bildern verwendet wird. Selbst bei begrenzten beschrifteten Daten können die auf dem Hugging Face Hub verfügbaren vortrainierten Modelle die Objekterkennung effizienter machen.

Er gab auch einen kurzen Überblick über verschiedene Modelle, die für diese Aufgabe gebaut wurden und die Sie auf Hugging Face finden können:

Pavel verlagerte dann den Schwerpunkt auf die praktische Arbeit mit den Hugging Face und erläuterte drei Möglichkeiten, wie Entwickler diese nutzen können: Erkunden von Modellen, schnelles Testen und weiteres Anpassen der Modelle.

Er demonstrierte, wie Entwickler Modelle direkt auf dem Hugging Face Hub durchsuchen können, ohne Code zu schreiben, was es einfach macht, Modelle sofort über eine interaktive Schnittstelle zu testen. "Sie können es ausprobieren, ohne auch nur eine Zeile Code zu schreiben oder das Modell auf Ihren Computer herunterzuladen", fügte Pavel hinzu. Da einige Modelle sehr groß sind, können sie auf dem Hub ausgeführt werden, um Speicher- und Verarbeitungsbeschränkungen zu vermeiden.

Außerdem können Entwickler mit der Hugging Face Inference API KI-Modelle mit einfachen API-Aufrufen ausführen. Sie eignet sich hervorragend für schnelle Tests, Proof-of-Concept-Projekte und Rapid Prototyping, ohne dass eine komplexe Einrichtung erforderlich ist.

Für fortgeschrittene Anwendungsfälle können Entwickler das Hugging Face Transformers-Framework nutzen, ein Open-Source-Tool, das bereits trainierte Modelle für Text-, Bild- und Audioaufgaben bereitstellt und sowohl PyTorch als auch TensorFlow unterstützt. Pavel erklärte, dass Entwickler mit nur zwei Zeilen Code ein Modell aus dem Hugging Face Hub abrufen und es mit einem Vorverarbeitungstool, wie einem Bildprozessor, verknüpfen können, um Bilddaten für Vision AI-Anwendungen zu analysieren.

Anschließend erläuterte Pavel, wie Hugging Face KI-Workflows rationalisieren kann. Ein wichtiges Thema war die Optimierung des Aufmerksamkeitsmechanismus in Transformers, einer zentralen Funktion von Deep-Learning-Modellen, die dabei hilft, sich auf die wichtigsten Teile der Eingabedaten zu konzentrieren. Dies verbessert die Genauigkeit von Aufgaben in den Bereichen Sprachverarbeitung und Computer Vision. Allerdings kann dies ressourcenintensiv sein.

Die Optimierung des Aufmerksamkeitsmechanismus kann den Speicherbedarf erheblich reduzieren und gleichzeitig die Geschwindigkeit verbessern. Pavel wies darauf hin: „Beispielsweise könnte ein Wechsel zu einer effizienteren Aufmerksamkeitsimplementierung eine bis zu 1,8-fach schnellere Leistung ermöglichen.“

Hugging Face bietet integrierte Unterstützung für effizientere Aufmerksamkeitsimplementierungen innerhalb des Transformers-Frameworks. Entwickler können diese Optimierungen aktivieren, indem sie beim Laden eines Modells einfach eine alternative Aufmerksamkeitsimplementierung angeben.

Er sprach auch über Quantisierung, eine Technik, die KI-Modelle verkleinert, indem sie die Präzision der von ihnen verwendeten Zahlen reduziert, ohne die Leistung zu stark zu beeinträchtigen. Dies hilft Modellen, weniger Speicher zu verbrauchen und schneller zu laufen, wodurch sie besser für Geräte mit begrenzter Rechenleistung geeignet sind, wie z. B. Smartphones und eingebettete Systeme.

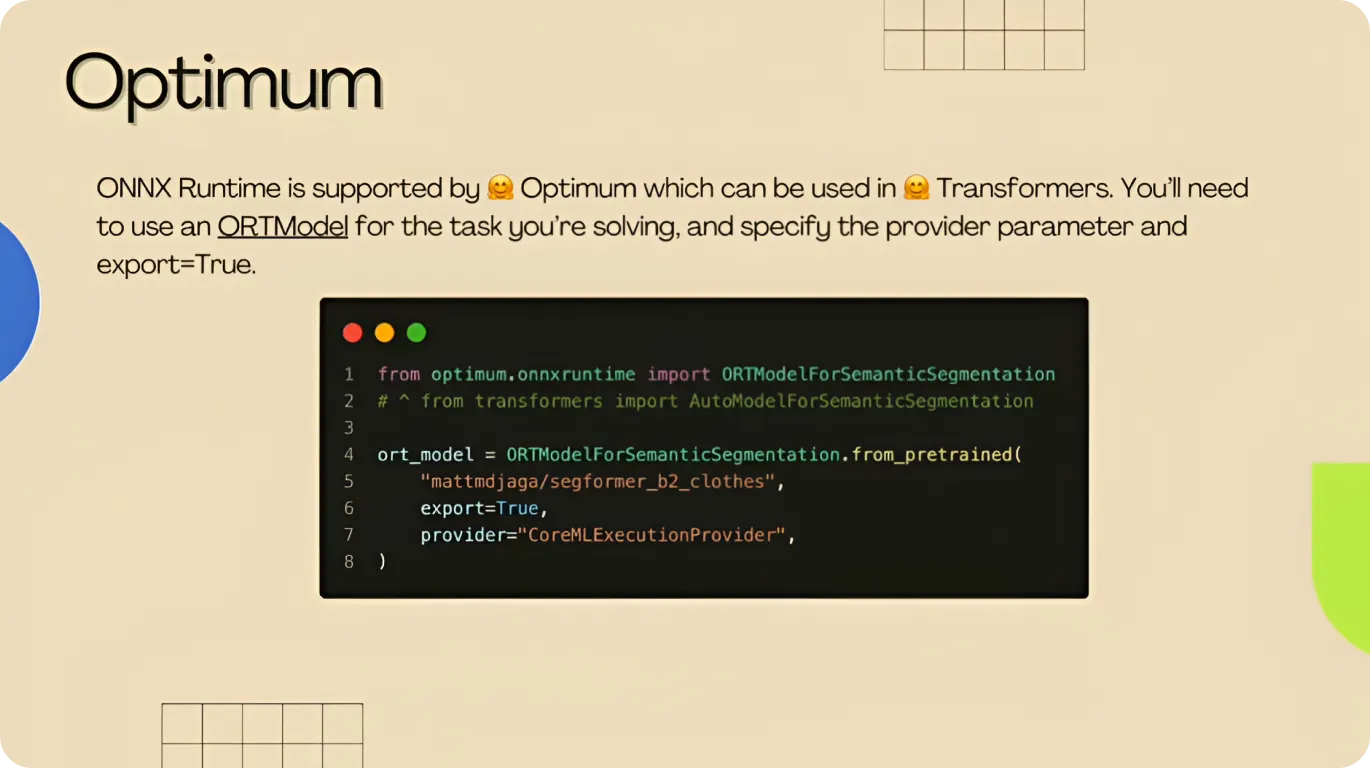

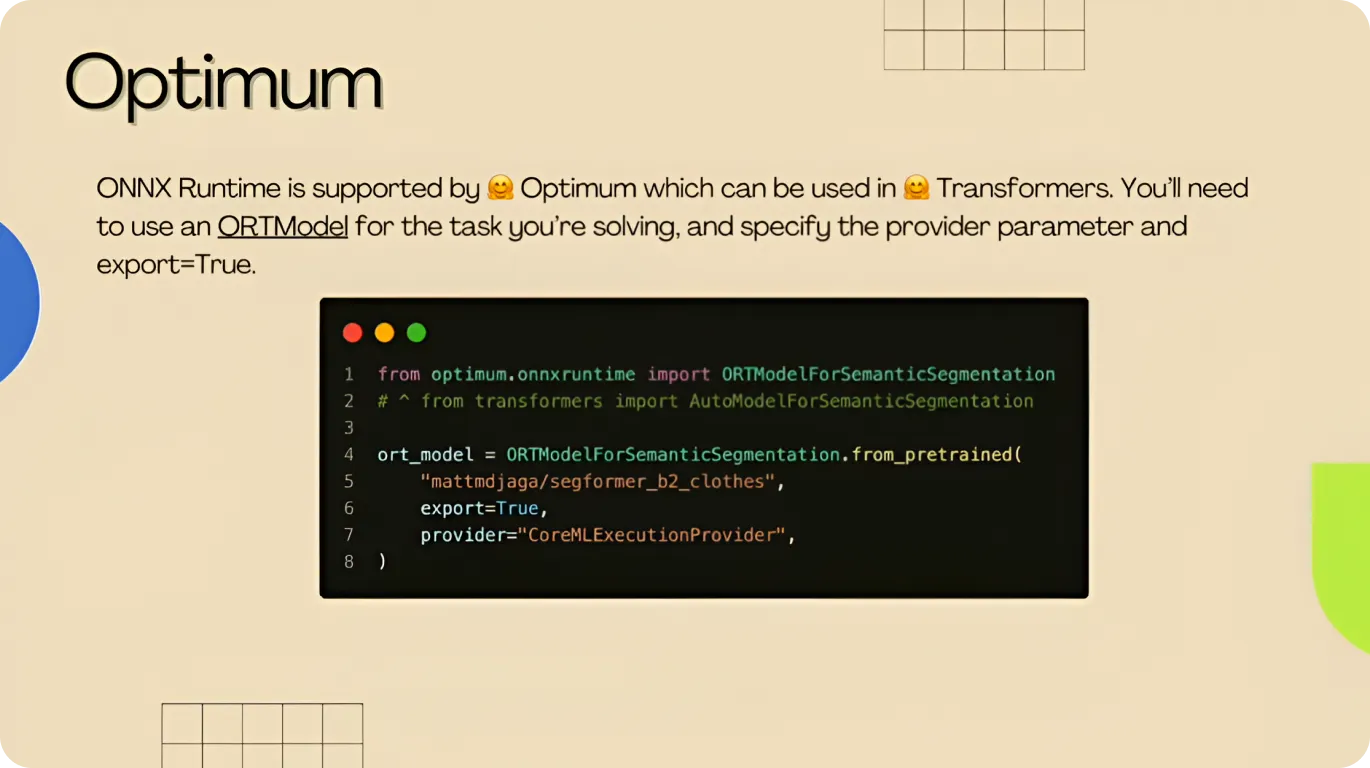

Um die Effizienz weiter zu verbessern, stellte Pavel die Hugging Face Optimum-Bibliothek vor, eine Reihe von Tools zur Optimierung und Bereitstellung von Modellen. Mit nur wenigen Codezeilen können Entwickler Quantisierungstechniken anwenden und Modelle in effiziente Formate wie ONNX (Open Neural Network Exchange) konvertieren, sodass sie problemlos auf verschiedenen Hardwaretypen, einschließlich Cloud-Servern und Edge-Geräten, ausgeführt werden können.

Schließlich erwähnte Pavel die Vorteile von Torch Compile, einer Funktion in PyTorch , die die Verarbeitung von Daten durch KI-Modelle optimiert, so dass diese schneller und effizienter laufen. Hugging Face integriert Torch Compile in seine Transformers- und Optimum-Bibliotheken, so dass Entwickler mit minimalen Code-Änderungen von diesen Leistungsverbesserungen profitieren können.

Durch die Optimierung der Berechnungsstruktur des Modells kann Torch Compile die Inferenzzeiten beschleunigen und die Bildwiederholrate von 29 auf 150 Bilder pro Sekunde erhöhen, ohne die Genauigkeit oder Qualität zu beeinträchtigen.

Anschließend ging Pavel kurz darauf ein, wie Entwickler Vision AI-Modelle mit Hilfe von Hugging Face erweitern und einsetzen können, nachdem sie das richtige Modell ausgewählt und den besten Ansatz für die Entwicklung gewählt haben.

So können Entwickler beispielsweise interaktive KI-Anwendungen mit Gradio und Streamlit bereitstellen. Gradio ermöglicht es Entwicklern, webbasierte Schnittstellen für Machine-Learning-Modelle zu erstellen, während Streamlit dabei hilft, interaktive Datenanwendungen mit einfachen Python zu erstellen.

Pavel wies auch darauf hin, dass "man nicht alles von Grund auf neu schreiben muss", und verwies auf die Leitfäden, Schulungsnotizen und Beispielskripte, die Hugging Face bereitstellt. Diese Ressourcen helfen den Entwicklern, schnell loszulegen, ohne alles von Grund auf neu erstellen zu müssen.

Zum Abschluss seiner Keynote fasste Pavel die Vorteile der Nutzung von Hugging Face Hub zusammen. Er betonte, wie es die Modellverwaltung und Zusammenarbeit vereinfacht. Er wies auch auf die Verfügbarkeit von Leitfäden, Notizbüchern und Tutorials hin, die sowohl Anfängern als auch Experten helfen können, KI-Modelle zu verstehen und zu implementieren.

"Es gibt bereits viele coole Spaces auf dem Hub. Sie können ähnliche finden, den freigegebenen Code klonen, ein paar Zeilen ändern, das Modell durch Ihr eigenes ersetzen und es zurückschieben", erklärte er und ermutigte Entwickler, die Flexibilität der Plattform zu nutzen.

Während seines Vortrags bei YV24 erzählte Pavel, wie Hugging Face Tools anbietet, die das Training, die Optimierung und den Einsatz von KI-Modellen unterstützen. Zum Beispiel können Innovationen wie Transformers, Optimum und Torch Compile Entwicklern helfen, die Modellleistung zu verbessern.

Da KI-Modelle immer effizienter werden, erleichtern Fortschritte bei der Quantisierung und dem Edge Deployment die Ausführung auf Geräten mit begrenzten Ressourcen. Diese Verbesserungen in Kombination mit Tools wie Hugging Face und fortschrittlichen Computer-Vision-Modellen wie Ultralytics YOLO11 sind der Schlüssel zum Aufbau skalierbarer, leistungsstarker Vision-KI-Anwendungen.

Werden Sie Teil unserer wachsenden Gemeinschaft! Erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren, und nutzen Sie unsere yolo , um Ihre Vision-KI-Projekte zu starten. Interessieren Sie sich für Innovationen wie Computer Vision im Gesundheitswesen oder Computer Vision in der Landwirtschaft? Besuchen Sie unsere Lösungsseiten, um mehr zu erfahren!