Esplorazione del rilevamento di piccoli oggetti con Ultralytics YOLO11

Scopri come Ultralytics YOLO11 un rilevamento rapido e accurato di oggetti di piccole dimensioni in applicazioni reali come la sorveglianza e la robotica.

Scopri come Ultralytics YOLO11 un rilevamento rapido e accurato di oggetti di piccole dimensioni in applicazioni reali come la sorveglianza e la robotica.

I droni integrati con Vision AI possono volare a centinaia di metri dal suolo e sono comunque in grado di detect persona che appare come pochi pixel nel loro feed video. In realtà, si tratta di una sfida comune in applicazioni quali la robotica, la sorveglianza e il telerilevamento, dove i sistemi devono identificare oggetti molto piccoli all'interno di un'immagine.

Ma i modelli tradizionali di rilevamento degli oggetti possono avere difficoltà a farlo. Gli oggetti di piccole dimensioni nelle immagini e nei video rappresentano informazioni visive molto limitate. In parole povere, quando un modello li osserva, non ci sono molti dettagli da apprendere o riconoscere.

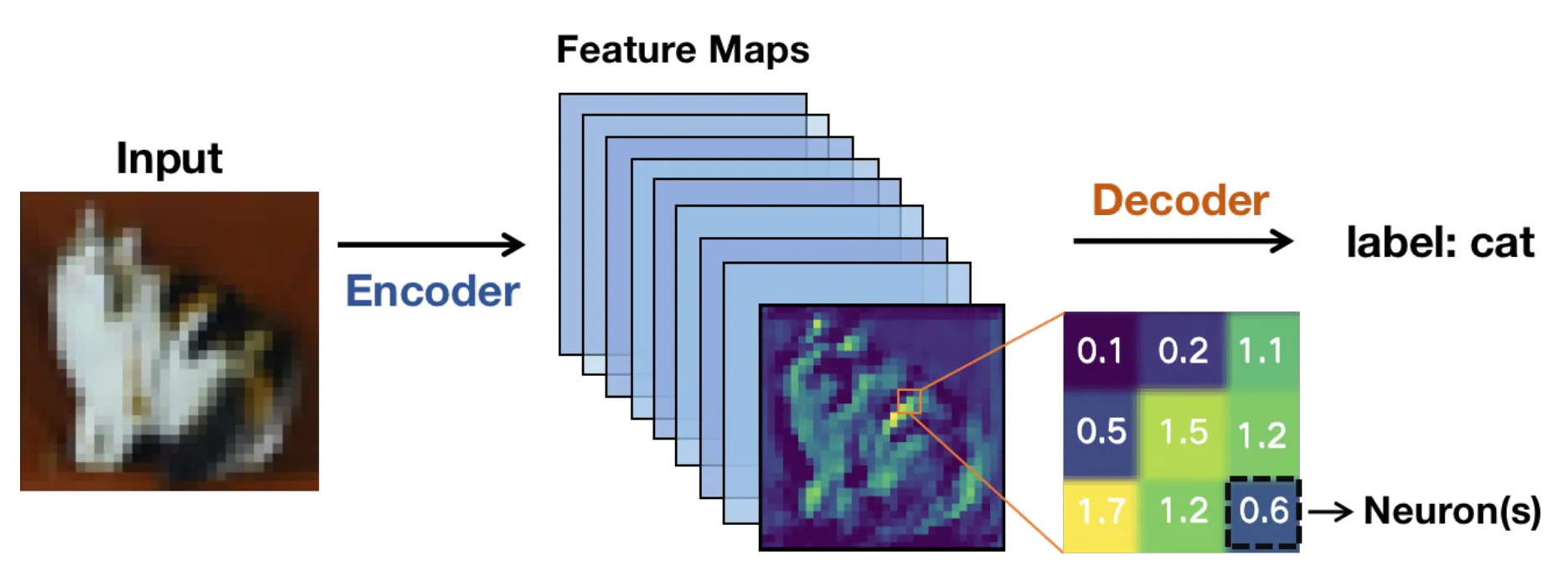

Sotto il cofano, questi modelli si basano tipicamente su un'architettura basata su reti neurali convoluzionali (CNN). Le immagini vengono fatte passare attraverso i livelli della rete e trasformate in mappe di caratteristiche o rappresentazioni semplificate che evidenziano i modelli rilevanti invece dei pixel grezzi.

Man mano che l'immagine si sposta più in profondità nella rete, queste mappe delle caratteristiche diventano più piccole. Ciò rende il calcolo più veloce, ma significa anche che i dettagli più fini possono scomparire.

Per gli oggetti di piccole dimensioni, questi dettagli sono fondamentali. Una volta che tali dettagli scompaiono, un modello di visione artificiale potrebbe avere difficoltà a rilevare l'oggetto, il che può portare a bounding box meno accurate o incoerenti.

I sistemi di visione artificiale end-to-end in tempo reale rendono tutto ancora più complicato. Le immagini ad alta risoluzione aiutano a preservare i dettagli, ma rallentano l'inferenza e richiedono GPU maggiore GPU . Le risoluzioni più basse funzionano più velocemente, ma gli oggetti piccoli diventano ancora più difficili da detect.

Diventa un continuo equilibrio tra velocità, precisione e limiti hardware. Grazie ai recenti progressi tecnologici, modelli di visione artificiale come Ultralytics YOLO11 e il prossimo Ultralytics sono progettati per gestire questo compromesso in modo più efficace.

In questo articolo vedremo perché è difficile rilevare oggetti di piccole dimensioni e come YOLO11 semplificare questa operazione. Cominciamo!

Il rilevamento di piccoli oggetti è un'attività che rientra nell'ambito della visione artificiale, una branca dell'intelligenza artificiale che si occupa di identificare e localizzare oggetti che occupano una porzione molto piccola di un'immagine. Questi oggetti sono spesso rappresentati all'interno dell'immagine da un numero limitato di pixel, che sono le unità più piccole di un'immagine digitale. Ciò li rende più difficili da detect obiettivi più grandi e più chiari (che spesso contengono più pixel).

Ad esempio, i veicoli nelle immagini aeree, gli strumenti in una fabbrica o le persone riprese da telecamere di sorveglianza grandangolari possono apparire come piccoli oggetti all'interno dell'immagine. Rilevarli è importante perché spesso contengono informazioni critiche e molte applicazioni del mondo reale, come la sorveglianza, dipendono da questi rilevamenti per funzionare correttamente.

Quando si perdono di vista oggetti di piccole dimensioni, le prestazioni del sistema e il processo decisionale possono risentirne. Il monitoraggio con veicoli aerei senza pilota (UAV) ne è un buon esempio: perdere di vista un piccolo oggetto in movimento sul terreno può influire sulla navigazione o sulla precisione di tracciamento.

I sistemi precedenti utilizzavano funzionalità artigianali e metodi tradizionali di visione artificiale, che avevano difficoltà in scene affollate o variegate. Ancora oggi, nonostante i modelli di deep learning offrano prestazioni di gran lunga superiori, rilevare piccoli obiettivi è ancora difficile quando questi occupano solo una minima parte dell'immagine.

Passiamo ora ad esaminare alcune delle sfide comuni che si presentano in diversi scenari reali durante il rilevamento di oggetti di piccole dimensioni.

Gli oggetti di piccole dimensioni contengono pochissimi pixel, il che limita la quantità di dettagli visivi che un modello può apprendere durante fasi come l'estrazione delle caratteristiche. Di conseguenza, modelli come bordi, forme e texture sono più difficili da detect, rendendo gli oggetti di piccole dimensioni più inclini a confondersi con lo sfondo.

Man mano che le immagini attraversano i livelli convoluzionali di una rete neurale, le informazioni visive contenute nei pixel vengono gradualmente compresse in mappe di caratteristiche. Ciò contribuisce a mantenere l'efficienza del modello, ma comporta anche la perdita dei dettagli più fini.

Nel caso di obiettivi di piccole dimensioni, gli indizi importanti possono scomparire prima che la rete di rilevamento abbia la possibilità di agire. Quando ciò accade, la localizzazione diventa meno affidabile e i riquadri di delimitazione possono spostarsi, sovrapporsi o mancare completamente gli oggetti target.

Le sfide legate alle dimensioni sono spesso sollevate anche dall'occlusione. L'occlusione si verifica quando gli oggetti, specialmente quelli più piccoli, sono parzialmente nascosti da altri oggetti nella scena.

Ciò riduce l'area visibile di un bersaglio, limitando le informazioni disponibili al rilevatore di oggetti. Anche una piccola occlusione può confondere le reti di rilevamento, specialmente se combinata con un input a bassa risoluzione. Un esempio interessante di ciò è visibile nei set di dati UAV come VisDrone, dove pedoni, biciclette o veicoli possono essere parzialmente oscurati da edifici, alberi o altri oggetti in movimento.

Allo stesso modo, la variazione di scala introduce un ulteriore livello di difficoltà quando lo stesso oggetto appare molto piccolo o relativamente grande a seconda della distanza e della posizione della telecamera. Nonostante questi ostacoli, gli algoritmi di rilevamento devono riconoscere questi piccoli oggetti su scale diverse senza perdere precisione.

Anche il contesto gioca un ruolo importante nel rilevamento. Ad esempio, gli oggetti di grandi dimensioni appaiono solitamente in un ambiente chiaro che fornisce utili indicazioni visive. Al contrario, gli oggetti di piccole dimensioni spesso non dispongono di queste informazioni contestuali, il che rende più difficile il riconoscimento dei modelli.

Le metriche di valutazione comuni, come Intersection over Union (IoU), misurano quanto un riquadro di delimitazione previsto si sovrapponga al riquadro di riferimento. Mentre IoU bene per oggetti più grandi, il suo comportamento è piuttosto diverso per quelli piccoli.

Gli oggetti di piccole dimensioni occupano solo pochi pixel, quindi anche uno spostamento minimo nel riquadro previsto può creare un errore proporzionale significativo e ridurre drasticamente il IoU . Ciò significa che gli oggetti di piccole dimensioni spesso non riescono a soddisfare la IoU standard utilizzata per considerare corretta una previsione, anche quando l'oggetto è visibile nell'immagine.

Di conseguenza, gli errori di localizzazione sono più facilmente classificabili come falsi positivi o falsi negativi. Queste limitazioni hanno spinto i ricercatori a ripensare il modo in cui i sistemi di rilevamento degli oggetti valutano e gestisconodetect piccoli edetect .

Mentre i ricercatori lavoravano per migliorare il rilevamento di oggetti di piccole dimensioni, è diventato chiaro che preservare e rappresentare le informazioni visive su più scale è essenziale. Questa intuizione trova riscontro nella recente ricerca arXiv e in articoli presentati in occasione di eventi quali le conferenze internazionali IEEE e l'European Computer Vision Association (ECCV).

Man mano che le immagini avanzano nella rete neurale, gli oggetti di piccole dimensioni possono perdere dettagli o scomparire del tutto, motivo per cui i moderni modelli di visione artificiale come YOLO11 molto su una migliore estrazione delle caratteristiche. Passiamo ora ad analizzare i concetti fondamentali alla base delle mappe delle caratteristiche e delle reti piramidali delle caratteristiche per comprenderli meglio.

Quando un'immagine in ingresso, come un'immagine di telerilevamento, entra in una rete neurale, viene gradualmente trasformata in mappe di caratteristiche. Si tratta di rappresentazioni semplificate dell'immagine che evidenziano modelli visivi come bordi, forme e texture.

Man mano che la rete diventa più profonda, queste mappe delle caratteristiche diventano più piccole in termini di dimensioni spaziali. Questa riduzione aiuta il modello a funzionare in modo efficiente e a concentrarsi sulle informazioni di alto livello. Tuttavia, le mappe delle caratteristiche ridotte e profonde riducono anche i dettagli spaziali.

Mentre gli oggetti di grandi dimensioni conservano informazioni visive sufficienti per un rilevamento accurato, gli oggetti di piccole dimensioni possono perdere dettagli fondamentali dopo pochi livelli di rete. Quando ciò accade, un modello può avere difficoltà a riconoscere l'esistenza stessa di un oggetto di piccole dimensioni. Questo è uno dei motivi principali per cui gli oggetti di piccole dimensioni vengono ignorati nei modelli di rilevamento profondo degli oggetti.

Le reti piramidali delle caratteristiche, spesso chiamate FPN, sono state introdotte per ovviare alla perdita di dettagli spaziali e funzionano come un modulo di supporto che combina le informazioni provenienti da più livelli, consentendo ai modelli di detect gli oggetti detect in modo più efficace. Questo processo è noto anche come aggregazione delle caratteristiche e fusione delle caratteristiche.

Gli strati superficiali forniscono dettagli spaziali precisi, mentre quelli più profondi aggiungono contesto semantico, consentendo un apprendimento efficace delle caratteristiche su più scale. A differenza del semplice upsampling, che si limita ad ingrandire le mappe delle caratteristiche, FPN preserva le informazioni significative e migliora il rilevamento di oggetti di piccole dimensioni.

Gli approcci moderni si basano su questa idea utilizzando la fusione adattiva delle caratteristiche e progetti sensibili al contesto per migliorare ulteriormente il rilevamento di piccoli obiettivi. In altre parole, FPN aiuta i modelli a vedere contemporaneamente sia il quadro generale che i minimi dettagli. Questa ottimizzazione è essenziale quando gli oggetti sono piccoli.

Ecco una panoramica di come i modelli di rilevamento degli oggetti si sono evoluti e perfezionati nel tempo per detect meglio detect di diverse dimensioni, compresi quelli molto piccoli:

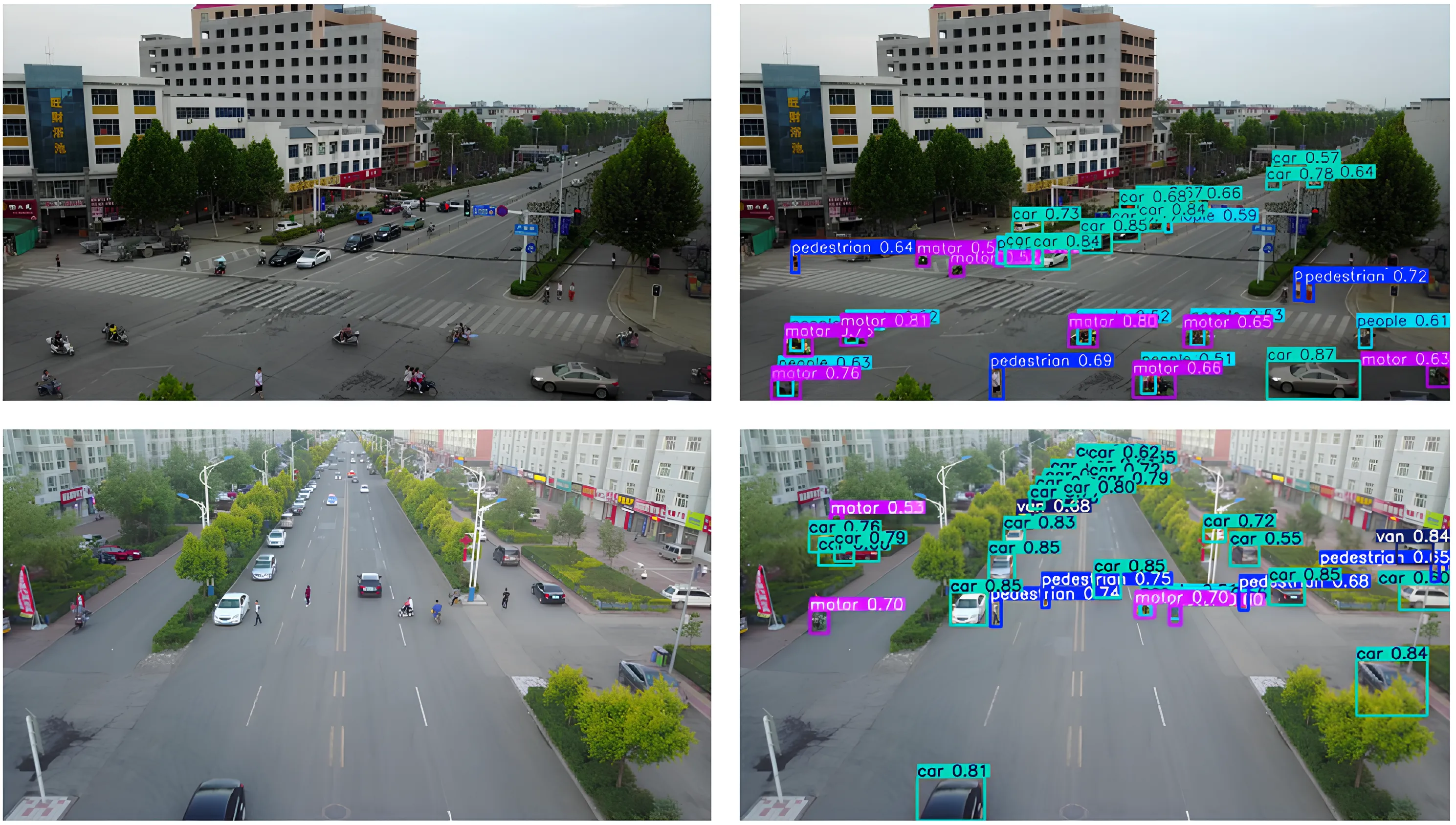

Ora che abbiamo una migliore comprensione di come funziona il rilevamento di oggetti di piccole dimensioni, esaminiamo un paio di applicazioni reali in cui YOLO11 utilizzare YOLO11 .

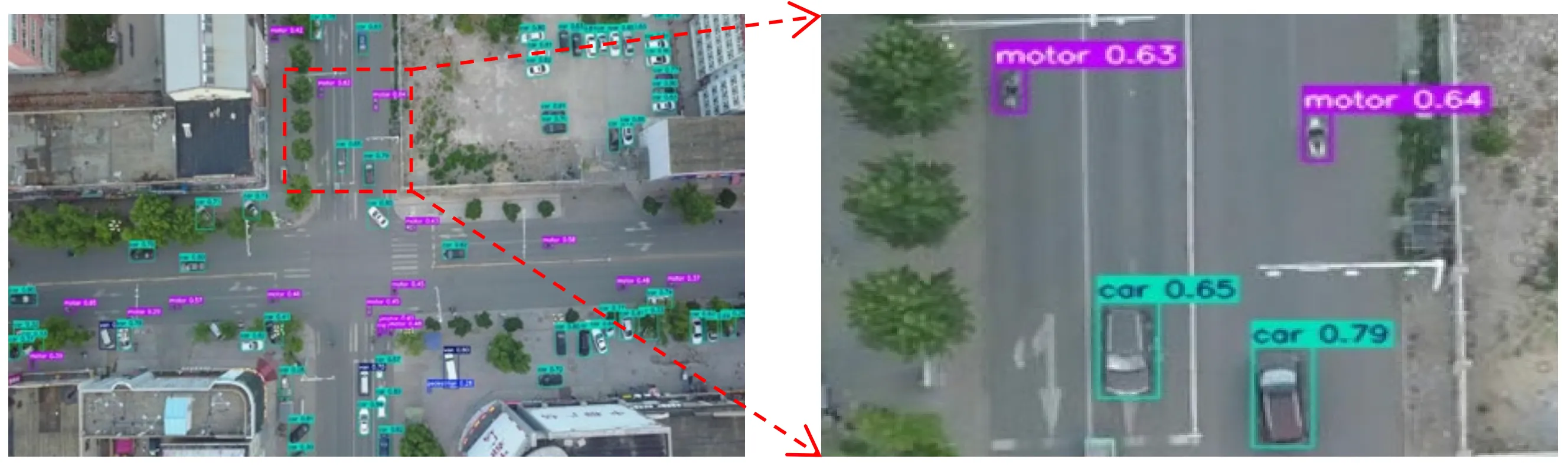

Immaginate un drone che vola alto sopra una strada trafficata della città. Da quell'altezza, automobili, biciclette e persino le persone si riducono a pochi pixel su uno schermo.

I moduli UAV e di imaging aereo spesso catturano scene come questa, in cui gli oggetti di interesse sono minuscoli e circondati da sfondi disordinati, il che rende difficile il loro detect da parte dei modelli di visione artificiale.

In questi tipi di scenari, YOLO11 essere la scelta ideale. Ad esempio, un drone dotato di un modello come YOLO11 monitorare il traffico in tempo reale, rilevando veicoli, ciclisti e pedoni mentre si muovono nella scena, anche quando ogni oggetto occupa solo una piccola porzione dell'immagine. Ciò consente un processo decisionale più rapido e informazioni più accurate in applicazioni quali la gestione del traffico, la sicurezza pubblica o la pianificazione urbana.

I robot vengono spesso utilizzati in ambienti in cui la precisione e la tempistica sono fondamentali. In contesti quali magazzini, fabbriche e aziende agricole, un robot potrebbe dover riconoscere oggetti molto piccoli, come un componente su una catena di montaggio, un'etichetta su un pacco o un piccolo germoglio in un campo, e reagire rapidamente.

Rilevare oggetti di queste dimensioni può essere complicato, soprattutto quando appaiono come pochi pixel nell'immagine ripresa dalla telecamera o sono parzialmente occlusi da altri oggetti. Trascurare questi piccoli dettagli può rallentare l'automazione o compromettere la capacità del robot di portare a termine un compito.

YOLO11 fare la differenza in queste situazioni. La sua estrazione delle caratteristiche migliorata e la sua inferenza veloce permettono ai robot di detect oggetti in tempo reale e di agire immediatamente.

YOLO11 supporta YOLO11 la segmentazione delle istanze, che può aiutare i robot a comprendere i confini degli oggetti e a individuare i punti con maggiore precisione, anziché limitarsi a localizzare i riquadri di delimitazione generali. Ad esempio, un braccio robotico integrato con YOLO11 individuare piccoli componenti su un nastro trasportatore, segment forma esatta e prelevarli prima che si allontanino, contribuendo a mantenere l'efficienza e l'affidabilità del sistema.

Con così tanti modelli di visione artificiale disponibili oggi, ti starai chiedendo cosa distingue Ultralytics YOLO11 .

Ecco alcuni motivi per cui Ultralytics YOLO11 un'ottima scelta per le applicazioni in cui è necessario rilevare oggetti di piccole dimensioni:

Oltre all'utilizzo di un modello come YOLO11, anche il modo in cui si preparano le annotazioni, il set di dati complessivo e la procedura di addestramento del modello possono influire in modo significativo sulle prestazioni di rilevamento.

Ecco una breve panoramica degli aspetti su cui concentrarsi:

Il rilevamento di oggetti di piccole dimensioni è difficile perché i bersagli piccoli perdono dettagli mentre le immagini passano attraverso un modello di visione artificiale. YOLO11 la conservazione di questi dettagli, rendendo il rilevamento di oggetti di piccole dimensioni più affidabile senza sacrificare le prestazioni in tempo reale. Questo equilibrio consente YOLO11 supportare un rilevamento accurato ed efficiente nelle applicazioni del mondo reale.

Unisciti alla nostra community in crescita! Esplora il nostro repository GitHub per saperne di più sull'AI. Scopri innovazioni come la computer vision nel retail e l'AI nel settore automobilistico visitando le nostre pagine delle soluzioni. Per iniziare subito a sviluppare con la computer vision, scopri le nostre opzioni di licenza.