Scoprite come Mask R-CNN può essere utilizzata per segment con precisione gli oggetti nelle immagini e nei video per varie applicazioni in diversi settori.

Scoprite come Mask R-CNN può essere utilizzata per segment con precisione gli oggetti nelle immagini e nei video per varie applicazioni in diversi settori.

Innovazioni come i robot nei magazzini, le auto a guida autonoma che si muovono in sicurezza per le strade trafficate, i droni che controllano i raccolti e i sistemi di intelligenza artificiale che ispezionano i prodotti nelle fabbriche stanno diventando sempre più comuni con l'aumento dell'adozione dell'IA. Una tecnologia chiave alla base di queste innovazioni è la computer vision, una branca dell'IA che consente alle macchine di comprendere e interpretare i dati visivi.

Ad esempio, il rilevamento di oggetti è un'attività di computer vision che aiuta a identificare e localizzare oggetti nelle immagini utilizzando i bounding box. Sebbene i bounding box offrano informazioni utili, forniscono solo una stima approssimativa della posizione di un oggetto e non possono catturare la sua forma o i suoi confini esatti. Questo li rende meno efficaci nelle applicazioni che richiedono un'identificazione precisa.

Per risolvere questo problema, i ricercatori hanno sviluppato modelli di segmentazione che catturano i contorni esatti degli oggetti, fornendo dettagli a livello di pixel per un rilevamento e un'analisi più accurati.

Mask R-CNN è uno di questi modelli. Introdotto nel 2017 da Facebook AI Research (FAIR), si basa su modelli precedenti come R-CNN, Fast R-CNN e Faster R-CNN. Importante pietra miliare nella storia della computer vision, Mask R-CNN ha aperto la strada a modelli più avanzati, come ad esempio Ultralytics YOLO11.

In questo articolo analizzeremo cos'è la Mask R-CNN, come funziona, le sue applicazioni e quali miglioramenti sono stati apportati dopo di essa, fino ad arrivare a YOLO11.

Mask R-CNN, che sta per Mask Region-based Convolutional Neural Network, è un modello di deep learning progettato per attività di computer vision come il rilevamento di oggetti e la segmentazione di istanze.

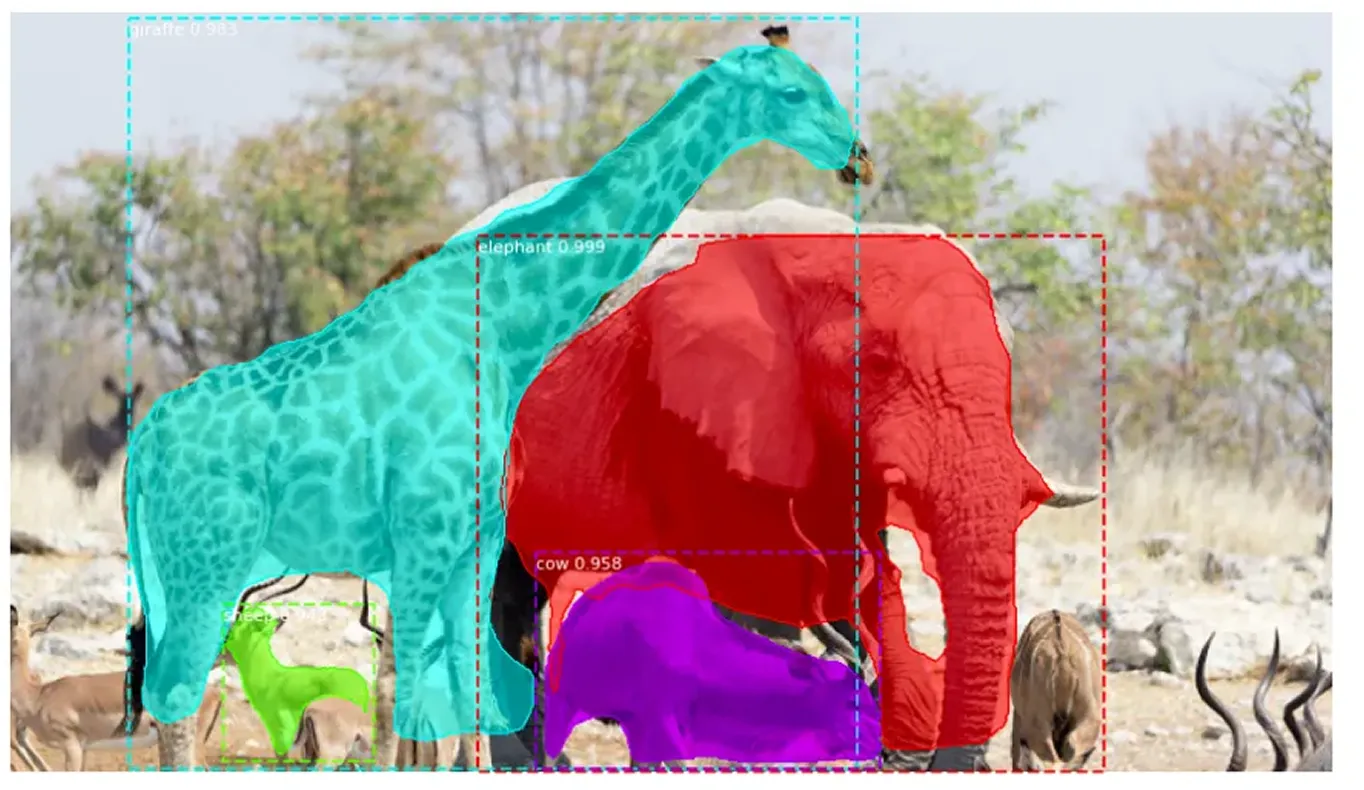

La segmentazione di istanza va oltre il tradizionale object detection non solo identificando gli oggetti in un'immagine, ma anche delineando accuratamente ognuno di essi. Assegna un'etichetta univoca a ogni oggetto rilevato e cattura la sua forma esatta a livello di pixel. Questo approccio dettagliato consente di distinguere chiaramente tra oggetti sovrapposti e di gestire accuratamente forme complesse.

Mask R-CNN si basa su Faster R-CNN, che rileva ed etichetta gli oggetti ma non ne definisce le forme esatte. Mask R-CNN migliora questo aspetto identificando i pixel esatti che compongono ciascun oggetto, consentendo un'analisi delle immagini molto più dettagliata e precisa.

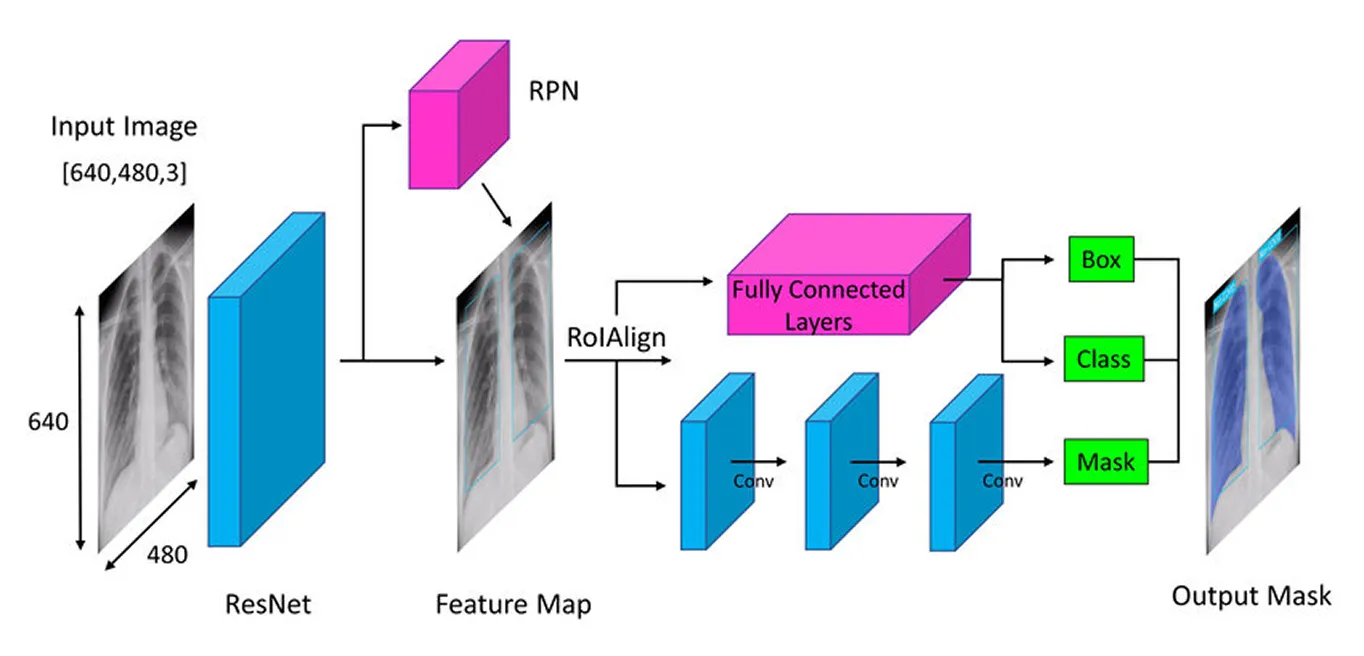

Mask R-CNN adotta un approccio graduale per detect e segment accuratamente gli oggetti. Inizia estraendo le caratteristiche chiave con una rete neurale profonda (un modello multistrato che apprende dai dati), quindi identifica le aree potenziali degli oggetti con una rete di proposta di regioni (un componente che suggerisce le regioni probabili degli oggetti) e infine affina queste aree creando maschere di segmentazione dettagliate (contorni precisi degli oggetti) che catturano la forma esatta di ogni oggetto.

Successivamente, esamineremo ogni passaggio per avere un'idea più chiara di come funziona Mask R-CNN.

Il primo passo nell'architettura di Mask R-CNN è scomporre l'immagine nelle sue parti chiave in modo che il modello possa capire cosa c'è dentro. Pensate a quando guardate una foto e notate naturalmente dettagli come forme, colori e bordi. Il modello fa qualcosa di simile usando una rete neurale profonda chiamata "backbone" (spesso ResNet-50 o ResNet-101), che agisce come i suoi occhi per scansionare l'immagine e cogliere i dettagli chiave.

Poiché gli oggetti nelle immagini possono essere molto piccoli o molto grandi, Mask R-CNN utilizza una Feature Pyramid Network. È come avere diverse lenti d'ingrandimento che consentono al modello di vedere sia i dettagli più fini sia il quadro generale, garantendo che gli oggetti di tutte le dimensioni vengano notati.

Una volta che queste importanti caratteristiche sono state estratte, il modello passa quindi a localizzare i potenziali oggetti nell'immagine, preparando il terreno per ulteriori analisi.

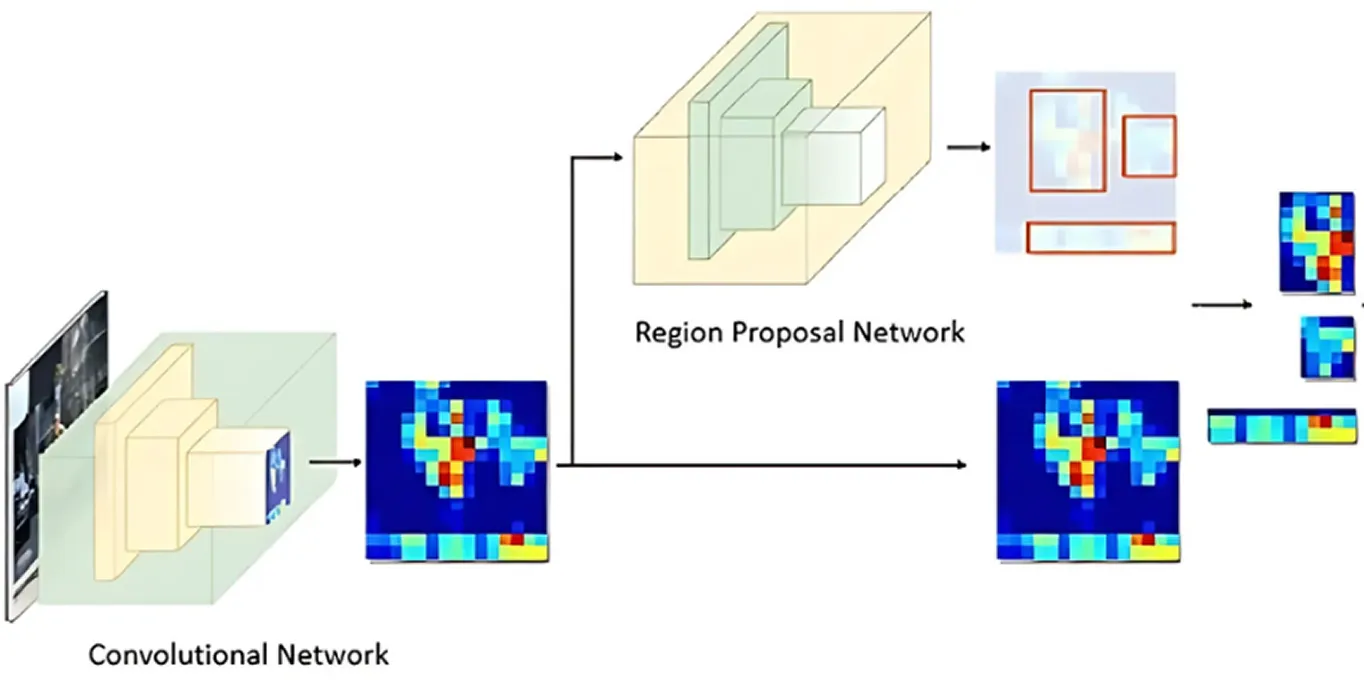

Dopo che l'immagine è stata elaborata per le caratteristiche chiave, subentra la Region Proposal Network. Questa parte del modello esamina l'immagine e suggerisce aree che probabilmente contengono oggetti.

Lo fa generando molteplici posizioni possibili per gli oggetti, chiamate ancore. La rete valuta quindi queste ancore e seleziona quelle più promettenti per ulteriori analisi. In questo modo, il modello si concentra solo sulle aree che hanno maggiori probabilità di essere interessanti, anziché controllare ogni singolo punto nell'immagine.

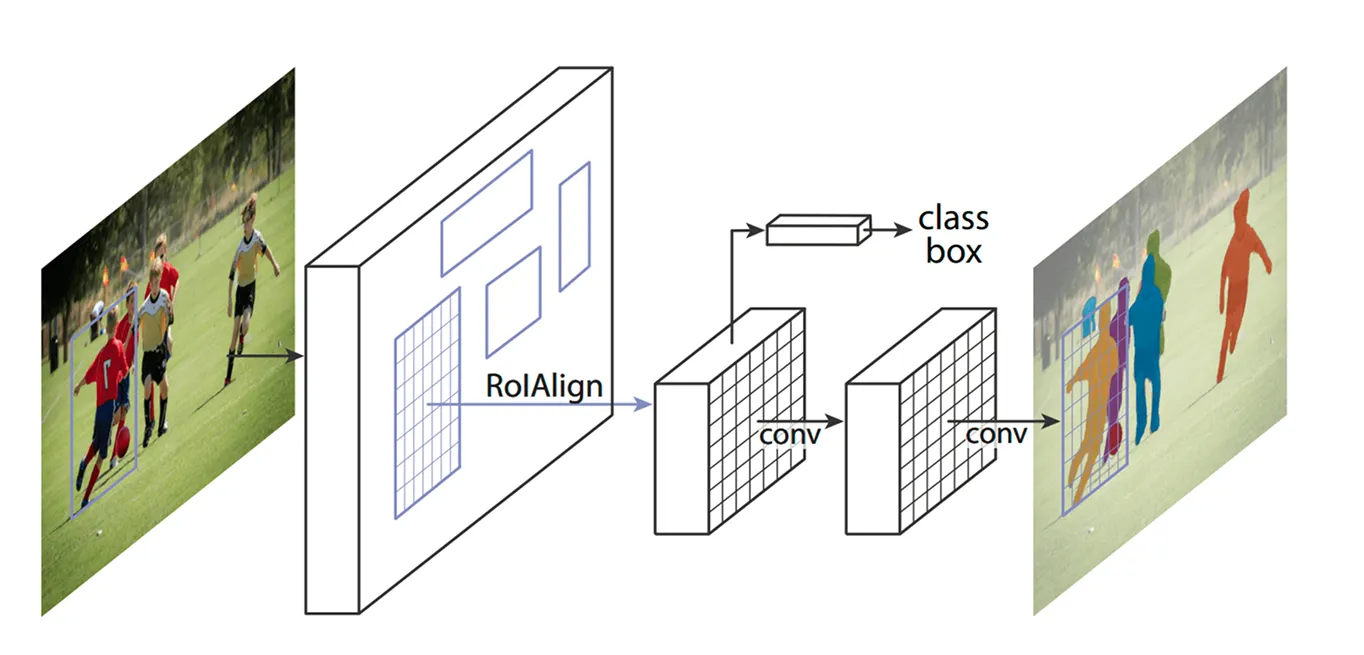

Una volta identificate le aree chiave, il passo successivo è affinare i dettagli estratti da queste regioni. I modelli precedenti utilizzavano un metodo chiamato ROI Pooling (Region of Interest Pooling) per acquisire le caratteristiche da ciascuna area, ma questa tecnica a volte portava a lievi disallineamenti durante il ridimensionamento delle regioni, rendendola meno efficace, soprattutto per oggetti più piccoli o sovrapposti.

Mask R-CNN migliora questo aspetto utilizzando una tecnica denominata ROI Align (Region of Interest Align). Invece di arrotondare le coordinate come fa ROI Pooling, ROI Align utilizza l'interpolazione bilineare per stimare i valori dei pixel in modo più preciso. L'interpolazione bilineare è un metodo che calcola un nuovo valore di pixel facendo la media dei valori dei suoi quattro vicini più prossimi, il che crea transizioni più fluide. Questo mantiene le caratteristiche correttamente allineate con l'immagine originale, con conseguente rilevamento e segmentazione degli oggetti più accurati.

Ad esempio, in una partita di calcio, due giocatori vicini tra loro potrebbero essere scambiati per un unico giocatore a causa della sovrapposizione dei loro bounding box. ROI Align aiuta a distinguerli mantenendo separate le loro forme.

Una volta che ROI Align ha elaborato l'immagine, il passo successivo consiste nel classify gli oggetti e perfezionare la loro posizione. Il modello esamina ogni regione estratta e decide quale oggetto contiene. Assegna un punteggio di probabilità alle diverse categorie e sceglie la migliore corrispondenza.

Allo stesso tempo, regola i riquadri di delimitazione per adattarsi meglio agli oggetti. Le caselle iniziali potrebbero non essere posizionate idealmente, quindi questo aiuta a migliorare l'accuratezza assicurandosi che ogni casella circondi strettamente l'oggetto rilevato.

Infine, Mask R-CNN compie un ulteriore passo avanti: genera una maschera di segmentazione dettagliata per ogni oggetto in parallelo.

Quando questo modello è stato presentato, è stato accolto con grande entusiasmo dalla comunità dell'intelligenza artificiale ed è stato presto utilizzato in diverse applicazioni. La sua capacità di detect e segment gli oggetti in tempo reale lo ha reso un elemento di svolta in diversi settori.

Ad esempio, rintracciare gli animali in via di estinzione in natura è un compito difficile. Molte specie si muovono in foreste fitte, rendendo difficile per i conservazionisti tenerne track . I metodi tradizionali utilizzano trappole con telecamera, droni e immagini satellitari, ma la selezione manuale di tutti questi dati richiede molto tempo. Identificazioni errate e avvistamenti mancati possono rallentare gli sforzi di conservazione.

Riconoscendo caratteristiche uniche come le strisce della tigre, le macchie della giraffa o la forma delle orecchie di un elefante, Mask R-CNN è in grado di detect e segment gli animali nelle immagini e nei video con maggiore precisione. Anche quando gli animali sono parzialmente nascosti dagli alberi o si trovano vicini, il modello è in grado di separarli e di identificarli singolarmente, rendendo il monitoraggio della fauna selvatica più rapido e affidabile.

Nonostante il suo significato storico nel rilevamento e nella segmentazione degli oggetti, Mask R-CNN presenta anche alcuni inconvenienti chiave. Ecco alcune sfide relative a Mask R-CNN:

La maschera R-CNN era ottima per le attività di segmentazione, ma molti settori stavano cercando di adottare la computer vision dando priorità alla velocità e alle prestazioni in tempo reale. Questo requisito ha portato i ricercatori a sviluppare modelli a una fase che detect gli oggetti in un unico passaggio, migliorando notevolmente l'efficienza.

A differenza del processo a più fasi di Mask R-CNN, i modelli di computer vision a una fase, come YOLO (You Only Look Once), si concentrano sulle attività di computer vision in tempo reale. Invece di gestire separatamente il rilevamento e la segmentazione, i modelli YOLO possono analizzare un'immagine in una sola volta. Ciò li rende ideali per applicazioni come la guida autonoma, la sanità, la produzione e la robotica, dove la rapidità delle decisioni è fondamentale.

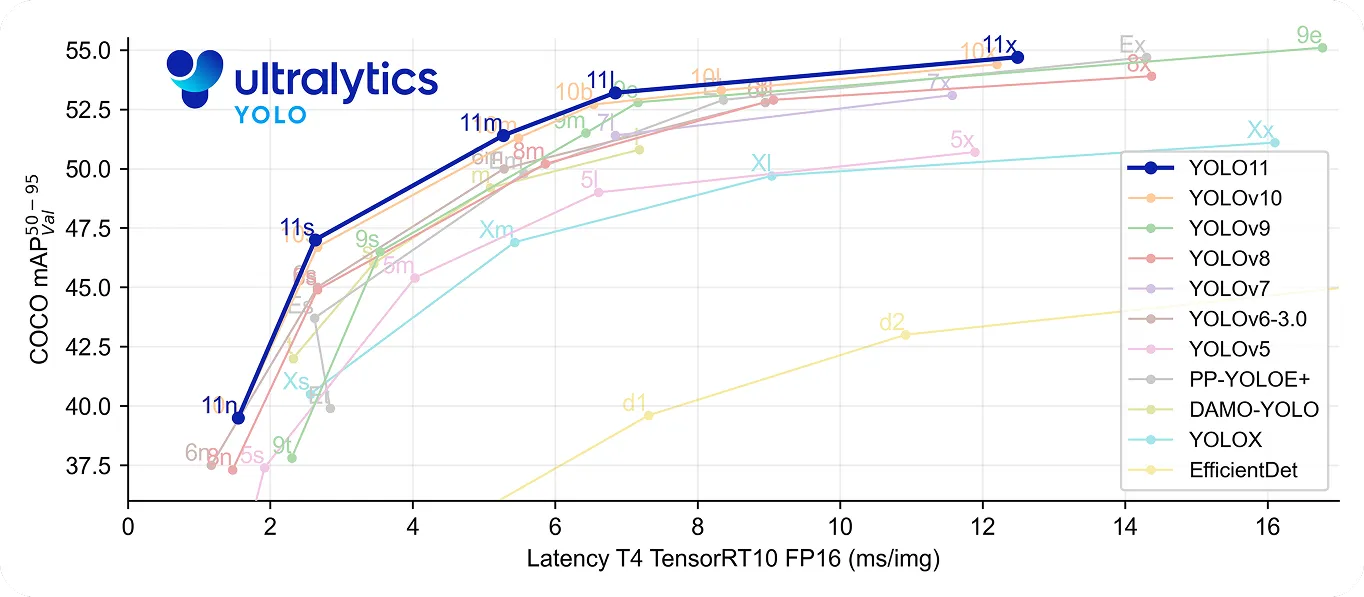

In particolare, YOLO11 compie un ulteriore passo avanti, essendo allo stesso tempo veloce e preciso. Utilizza il 22% di parametri in meno rispetto a YOLOv8m , ma raggiunge comunque una precisione media superioremAP) sul set di dati COCO , il che significa che rileva gli oggetti con maggiore precisione. La sua maggiore velocità di elaborazione lo rende una buona scelta per le applicazioni in tempo reale in cui ogni millisecondo è importante.

Ripensando alla storia della computer vision, Mask R-CNN è riconosciuto come una svolta importante nel rilevamento e nella segmentazione degli oggetti. Fornisce risultati molto precisi anche in contesti complessi, grazie al suo processo dettagliato in più fasi.

Tuttavia, questo stesso processo lo rende più lento rispetto ai modelli in tempo reale come YOLO. Con l'aumentare della necessità di velocità ed efficienza, molte applicazioni utilizzano ora modelli a uno stadio come Ultralytics YOLO11, che offrono un rilevamento rapido e accurato degli oggetti. Sebbene Mask R-CNN sia importante per comprendere l'evoluzione della computer vision, la tendenza verso soluzioni in tempo reale evidenzia la crescente domanda di soluzioni di computer vision più rapide ed efficienti.

Unisciti alla nostra community in crescita! Esplora il nostro repository GitHub per saperne di più sull'IA. Sei pronto per iniziare i tuoi progetti di computer vision? Dai un'occhiata alle nostre opzioni di licenza. Scopri l'IA in agricoltura e la Vision AI nel settore sanitario visitando le nostre pagine delle soluzioni!