여러 분야의 다양한 애플리케이션에서 이미지와 비디오의 오브젝트를 정밀하게 segment 데 Mask R-CNN을 어떻게 사용할 수 있는지 알아보세요.

여러 분야의 다양한 애플리케이션에서 이미지와 비디오의 오브젝트를 정밀하게 segment 데 Mask R-CNN을 어떻게 사용할 수 있는지 알아보세요.

창고의 로봇, 번잡한 거리를 안전하게 이동하는 자율 주행 자동차, 농작물을 점검하는 드론, 공장에서 제품을 검사하는 AI 시스템과 같은 혁신은 AI 도입이 증가함에 따라 더욱 보편화되고 있습니다. 이러한 혁신을 주도하는 핵심 기술은 기계가 시각적 데이터를 이해하고 해석할 수 있도록 하는 AI의 한 분야인 컴퓨터 비전입니다.

예를 들어, 객체 감지는 경계 상자를 사용하여 이미지에서 객체를 식별하고 찾는 데 도움이 되는 컴퓨터 비전 작업입니다. 경계 상자는 유용한 정보를 제공하지만 객체의 위치에 대한 대략적인 추정치만 제공하며 정확한 모양이나 경계를 캡처할 수 없습니다. 따라서 정확한 식별이 필요한 애플리케이션에서는 효과가 떨어집니다.

이러한 문제를 해결하기 위해 연구자들은 객체의 정확한 윤곽을 포착하는 분할 모델을 개발하여 보다 정확한 감지 및 분석을 위해 픽셀 수준의 세부 정보를 제공합니다.

마스크 R-CNN은 이러한 모델 중 하나입니다. Facebook AI Research(FAIR)에서 2017년에 도입한 이 모델은 R-CNN, Fast R-CNN, Faster R-CNN과 같은 이전 모델을 기반으로 합니다. 컴퓨터 비전 역사에서 중요한 이정표가 된 Mask R-CNN은 다음과 같은 고급 모델을 위한 길을 열었습니다. Ultralytics YOLO11.

이 글에서는 마스크 R-CNN이 무엇인지, 어떻게 작동하는지, 어떤 용도로 활용되는지, 그리고 YOLO11 이어 어떤 개선 사항이 있었는지 살펴봅니다.

Mask R-CNN(Mask Region-based Convolutional Neural Network)은 객체 탐지 및 인스턴스 분할과 같은 컴퓨터 비전 작업을 위해 설계된 딥 러닝 모델입니다.

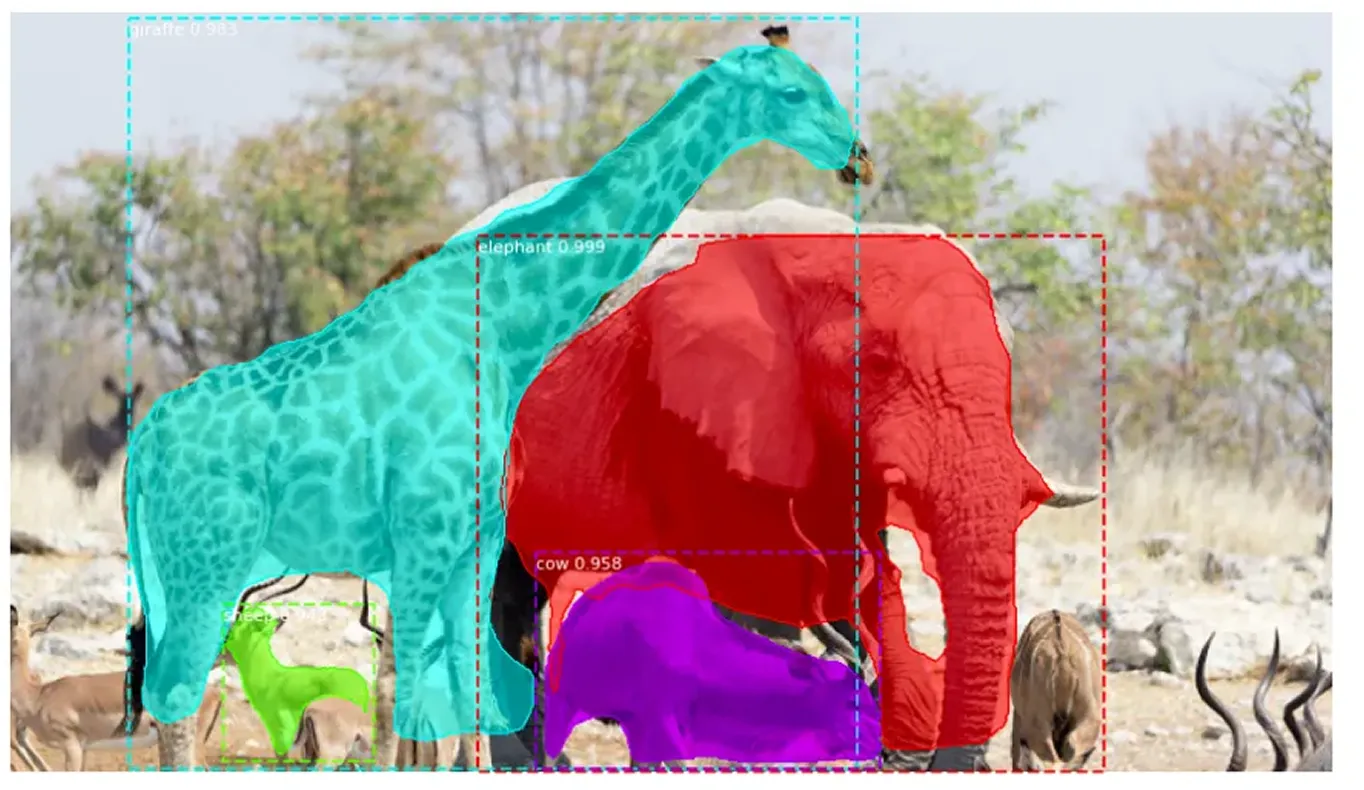

인스턴스 분할은 이미지에서 객체를 식별할 뿐만 아니라 각 객체의 윤곽을 정확하게 표시하여 기존의 객체 감지를 뛰어넘습니다. 감지된 모든 객체에 고유한 레이블을 할당하고 픽셀 수준에서 정확한 모양을 캡처합니다. 이 상세한 접근 방식을 통해 겹치는 객체를 명확하게 구별하고 복잡한 모양을 정확하게 처리할 수 있습니다.

Mask R-CNN은 객체를 탐지하고 레이블을 지정하지만 정확한 모양을 정의하지 않는 Faster R-CNN을 기반으로 합니다. Mask R-CNN은 각 객체를 구성하는 정확한 픽셀을 식별하여 이를 개선하고 훨씬 더 자세하고 정확한 이미지 분석을 가능하게 합니다.

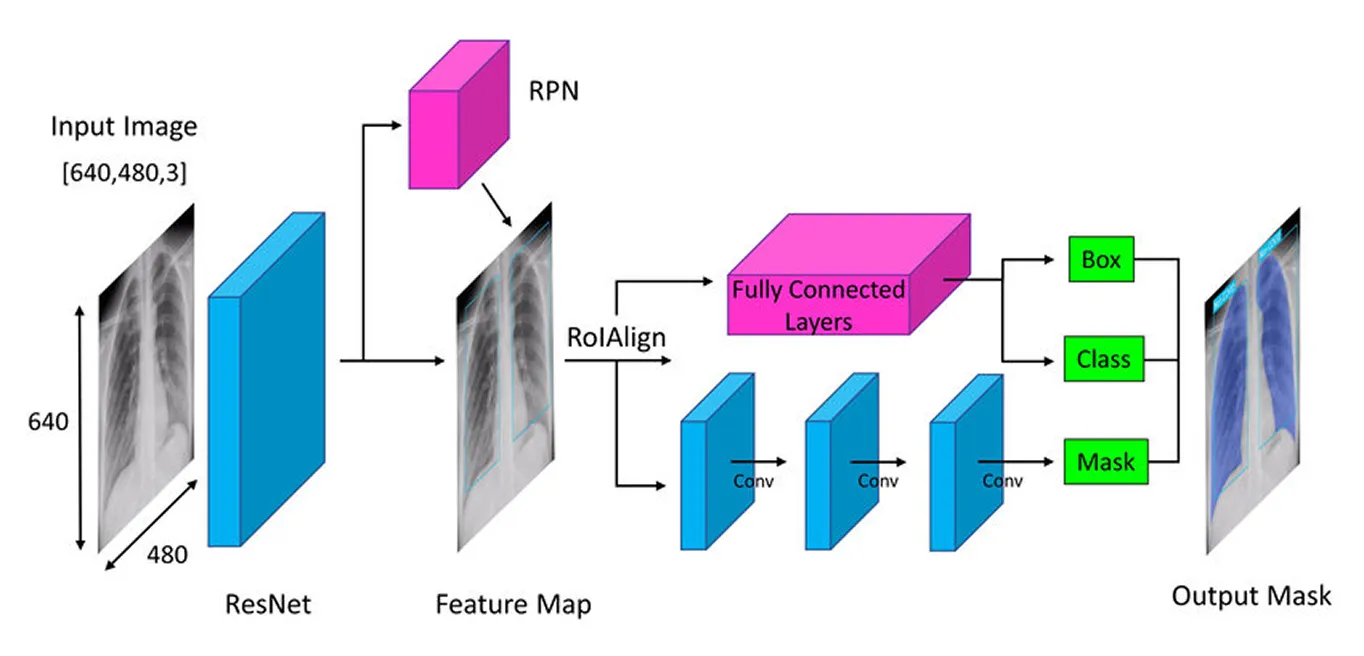

Mask R-CNN은 단계별 접근 방식을 통해 객체를 정확하게 detect segment . 먼저 심층 신경망(데이터로부터 학습하는 다층 모델)을 사용하여 주요 특징을 추출한 다음, 영역 제안 네트워크(물체가 있을 가능성이 있는 영역을 제안하는 구성 요소)로 잠재적인 물체 영역을 식별하고, 마지막으로 각 물체의 정확한 형태를 포착하는 상세한 분할 마스크(물체의 정확한 윤곽)를 생성하여 이러한 영역을 구체화합니다.

다음으로, Mask R-CNN이 어떻게 작동하는지 더 잘 이해하기 위해 각 단계를 살펴보겠습니다.

Mask R-CNN 아키텍처의 첫 번째 단계는 모델이 이미지의 내용을 이해할 수 있도록 이미지를 주요 부분으로 나누는 것입니다. 사진을 볼 때 모양, 색상 및 가장자리와 같은 세부 사항을 자연스럽게 알아차리는 것과 같습니다. 모델은 이미지의 주요 세부 사항을 스캔하고 포착하기 위해 눈 역할을 하는 "백본"(종종 ResNet-50 또는 ResNet-101)이라는 심층 신경망을 사용하여 유사한 작업을 수행합니다.

이미지의 객체는 매우 작거나 매우 클 수 있으므로 Mask R-CNN은 Feature Pyramid Network를 사용합니다. 이는 모델이 미세한 디테일과 더 큰 그림을 모두 볼 수 있도록 하여 모든 크기의 객체를 감지할 수 있도록 하는 다양한 돋보기를 갖는 것과 같습니다.

이러한 중요한 특징이 추출되면 모델은 이미지에서 잠재적인 객체를 찾아 추가 분석을 위한 준비를 합니다.

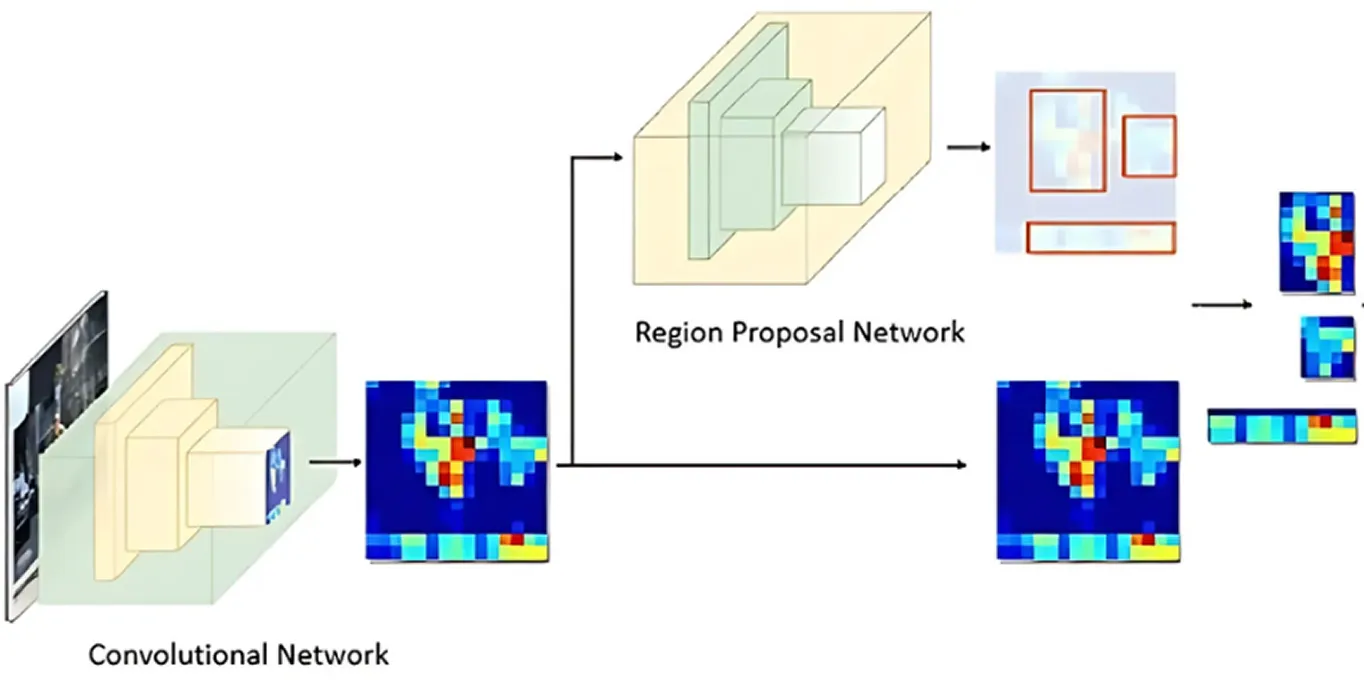

이미지의 주요 특징이 처리된 후 영역 제안 네트워크가 인계받습니다. 이 모델 부분은 이미지를 보고 객체를 포함할 가능성이 있는 영역을 제안합니다.

이것은 가능한 여러 객체 위치인 앵커(anchor)를 생성하여 수행됩니다. 그런 다음 네트워크는 이러한 앵커를 평가하고 추가 분석을 위해 가장 유망한 앵커를 선택합니다. 이러한 방식으로 모델은 이미지의 모든 단일 지점을 확인하는 대신 흥미로울 가능성이 가장 높은 영역에만 집중합니다.

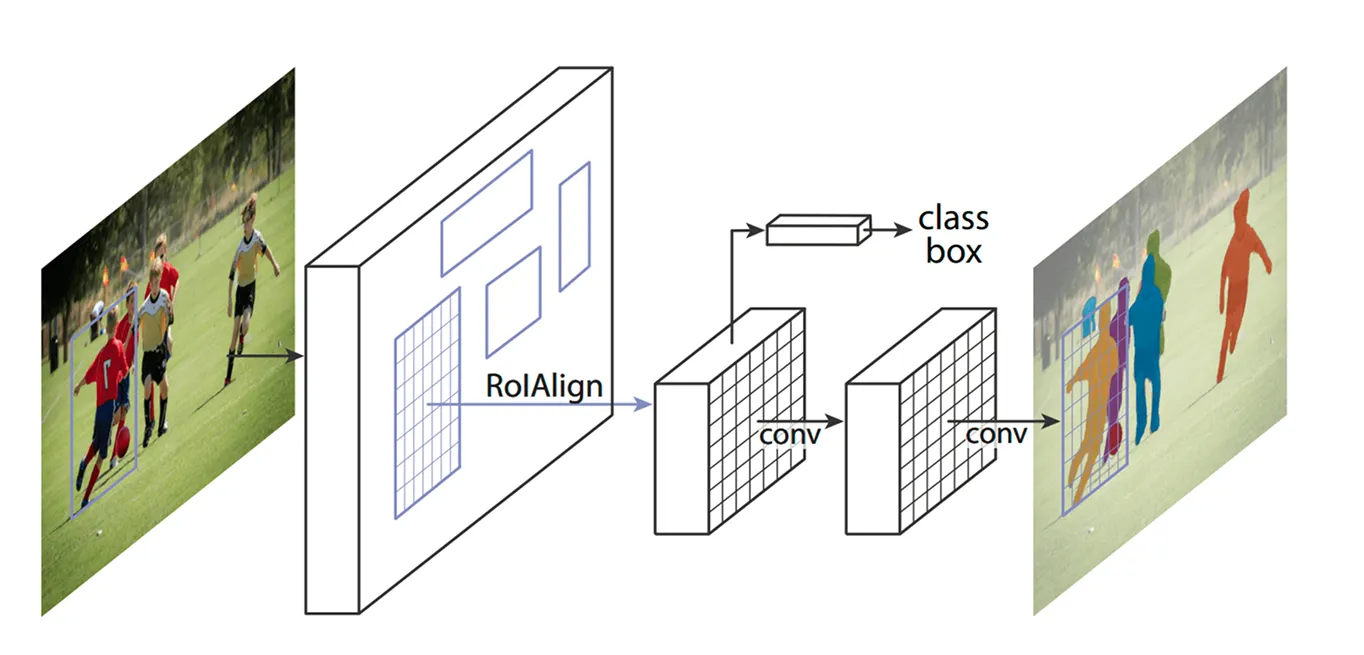

주요 영역이 확인되면 다음 단계는 이러한 영역에서 추출된 세부 정보를 개선하는 것입니다. 초기 모델은 ROI Pooling(Region of Interest Pooling)이라는 방법을 사용하여 각 영역에서 특징을 추출했지만, 이 기술은 영역 크기를 조정할 때 약간의 정렬 불량을 초래하여 특히 작거나 겹치는 객체에 대해서는 효과가 떨어졌습니다.

Mask R-CNN은 ROI Align(관심 영역 정렬)이라는 기술을 사용하여 이를 개선합니다. ROI Pooling처럼 좌표를 반올림하는 대신 ROI Align은 양선형 보간법을 사용하여 픽셀 값을 더 정확하게 추정합니다. 양선형 보간법은 네 개의 가장 가까운 이웃의 값을 평균하여 새로운 픽셀 값을 계산하는 방법으로, 더 부드러운 전환을 만듭니다. 이를 통해 특징이 원본 이미지와 적절하게 정렬되어 보다 정확한 객체 탐지 및 분할이 가능합니다.

예를 들어 축구 경기에서 가까이 서 있는 두 선수는 바운딩 박스가 겹치기 때문에 서로 혼동될 수 있습니다. ROI Align은 모양을 뚜렷하게 유지하여 분리하는 데 도움이 됩니다.

ROI Align이 이미지를 처리하면 다음 단계는 객체를 classify 위치를 미세 조정하는 것입니다. 모델은 추출된 각 영역을 살펴보고 어떤 물체가 포함되어 있는지 결정합니다. 그리고 여러 카테고리에 확률 점수를 할당하고 가장 잘 일치하는 것을 선택합니다.

동시에 경계 상자를 조정하여 객체에 더 잘 맞도록 합니다. 초기 상자가 이상적으로 배치되지 않았을 수 있으므로 각 상자가 감지된 객체를 꽉 둘러싸도록 하여 정확도를 향상시키는 데 도움이 됩니다.

마지막으로 Mask R-CNN은 한 단계 더 나아가 각 객체에 대한 자세한 세분화 마스크를 병렬로 생성합니다.

이 모델이 출시되었을 때 AI 커뮤니티의 많은 관심을 받았으며 곧 다양한 애플리케이션에 사용되었습니다. 실시간으로 물체를 detect segment 기능 덕분에 다양한 산업 분야에서 판도를 바꾸어 놓았습니다.

예를 들어, 야생에서 멸종 위기에 처한 동물을 추적하는 것은 어려운 작업입니다. 많은 동물들이 울창한 숲을 통과하여 이동하기 때문에 환경 보호론자들이 동물들을 track 어렵습니다. 기존의 방법으로는 카메라 트랩, 드론, 위성 이미지 등을 사용하지만 이 모든 데이터를 수작업으로 분류하는 데는 많은 시간이 소요됩니다. 동물의 오인이나 발견을 놓치면 보호 활동의 속도가 느려질 수 있습니다.

호랑이 줄무늬, 기린 반점, 코끼리 귀 모양과 같은 고유한 특징을 인식하여 이미지와 동영상에서 동물을 더욱 정확하게 detect segment 수 있습니다. 동물이 나무에 가려져 있거나 서로 가까이 서 있는 경우에도 모델을 분리하여 개별적으로 식별할 수 있으므로 야생동물을 더욱 빠르고 안정적으로 모니터링할 수 있습니다.

객체 감지 및 분할에서 역사적 중요성에도 불구하고 Mask R-CNN에는 몇 가지 주요 단점도 있습니다. 다음은 Mask R-CNN과 관련된 몇 가지 과제입니다.

마스크 R-CNN은 세분화 작업에 적합했지만, 많은 업계에서 속도와 실시간 성능을 우선시하면서 컴퓨터 비전을 도입하고자 했습니다. 이러한 요구 사항에 따라 연구원들은 한 번에 물체를 detect 1단계 모델을 개발하여 효율성을 크게 향상시켰습니다.

Mask R-CNN의 다단계 프로세스와 달리, YOLO (You Only Look Once)와 같은 1단계 컴퓨터 비전 모델은 실시간 컴퓨터 비전 작업에 중점을 둡니다. YOLO 모델은 감지와 분할을 개별적으로 처리하는 대신 한 번에 이미지를 분석할 수 있습니다. 따라서 빠른 의사 결정이 중요한 자율 주행, 의료, 제조, 로봇 공학 등의 애플리케이션에 이상적입니다.

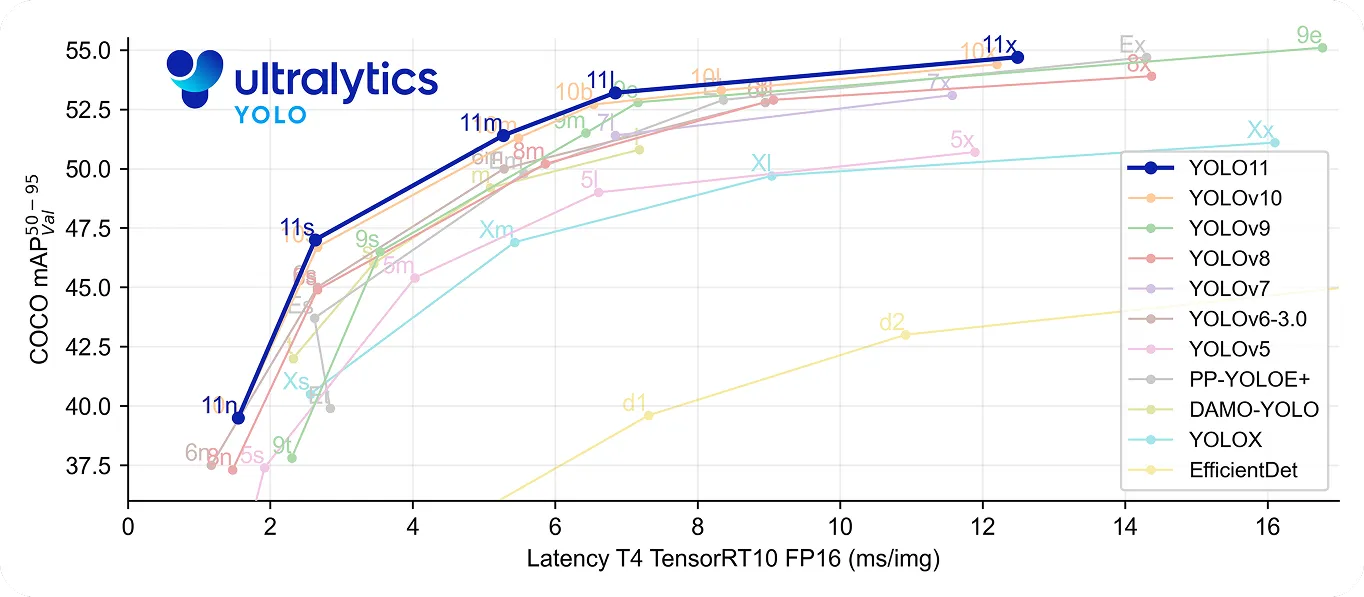

특히, YOLO11 빠르고 정확하다는 점에서 한 단계 더 발전했습니다. YOLOv8m 22% 적은 수의 파라미터를 사용하면서도 COCO 데이터 세트에서 더 높은 평균 정밀도mAP를 달성하여 물체를 더 정확하게 감지합니다. 처리 속도가 향상되어 밀리초 단위가 중요한 실시간 애플리케이션에 적합합니다.

컴퓨터 비전의 역사를 되돌아보면 Mask R-CNN은 객체 감지 및 분할 분야에서 획기적인 발전으로 인정받고 있습니다. 상세한 다단계 프로세스 덕분에 복잡한 환경에서도 매우 정확한 결과를 제공합니다.

그러나 이러한 프로세스는 YOLO 같은 실시간 모델에 비해 속도가 느립니다. 속도와 효율성에 대한 요구가 커지면서 많은 애플리케이션에서 빠르고 정확한 물체 감지를 제공하는 Ultralytics YOLO11 같은 1단계 모델을 사용하고 있습니다. 컴퓨터 비전의 진화를 이해하는 데 있어 마스크 R-CNN도 중요하지만, 실시간 솔루션에 대한 추세는 더 빠르고 효율적인 컴퓨터 비전 솔루션에 대한 수요 증가를 강조합니다.

성장하는 커뮤니티에 참여하세요! GitHub 저장소를 탐색하여 AI에 대해 자세히 알아보세요. 자신만의 컴퓨터 비전 프로젝트를 시작할 준비가 되셨나요? 라이선스 옵션을 확인해 보세요. 솔루션 페이지를 방문하여 농업 분야의 AI와 헬스케어 분야의 Vision AI에 대해 알아보세요!