Saiba como criar aplicações para drones alimentadas por IA com o Ultralytics YOLO11, permitindo a deteção de objectos em tempo real e tarefas de visão computacional baseadas em drones.

Saiba como criar aplicações para drones alimentadas por IA com o Ultralytics YOLO11, permitindo a deteção de objectos em tempo real e tarefas de visão computacional baseadas em drones.

Fazer compras na loja física e online pode parecer semelhante, mas dependem de logísticas diferentes. As lojas precisam de prateleiras reabastecidas, enquanto os pedidos online dependem de entregas na porta de casa. Graças aos avanços tecnológicos, ambas as experiências de compra estão sendo remodeladas em paralelo.

Por exemplo, uma grande mudança está acontecendo nas entregas. Drones alimentados por IA estão mudando a forma como os produtos chegam às nossas casas. Espera-se que esses drones inteligentes realizem cerca de 808 milhões de entregas na próxima década, transformando os céus na mais nova rota de entrega para o comércio diário.

Os drones de entrega utilizam a inteligência artificial (IA) e a visão por computador, um subcampo da IA que é utilizado para analisar dados visuais, para navegar e contornar obstáculos. Modelos de visão por computador como o Ultralytics YOLO11 podem ajudar os drones detect e track objectos em tempo real, permitindo-lhes compreender melhor e interagir com o seu ambiente.

Empresas como Meituan e DJI já estão integrando visão computacional em seus drones. De fato, a rápida adoção de drones em vários setores preparou o mercado de drones com IA para disparar para US$ 206,9 bilhões até 2031.

Neste artigo, analisaremos em pormenor a forma como os modelos de visão por computador, como o Ultralytics YOLO11 , podem ser utilizados em aplicações baseadas em drones, como as entregas por drones. Iremos analisar um exemplo que mostrará como estas tecnologias podem ser desenvolvidas e testadas antes de serem utilizadas em cenários do mundo real.

Uma parte essencial dos drones de entrega é a sua capacidade de detect casas enquanto navegam. Para recriar esta capacidade e compreender o seu funcionamento, vamos treinar um modelo de visão por computador capaz de identificar casas em imagens captadas por um drone aéreo. Para isso, treinaremos YOLO11 de forma personalizada, o que envolve o ajuste fino de um modelo YOLO11 pré-treinado para reconhecer e detect casas usando exemplos rotulados.

Para isso, precisaremos de dados de vídeo de alta qualidade de um drone. Curiosamente, mesmo sem acesso a um drone real, ainda podemos gerar filmagens aéreas realistas. Vamos dar uma olhada em como.

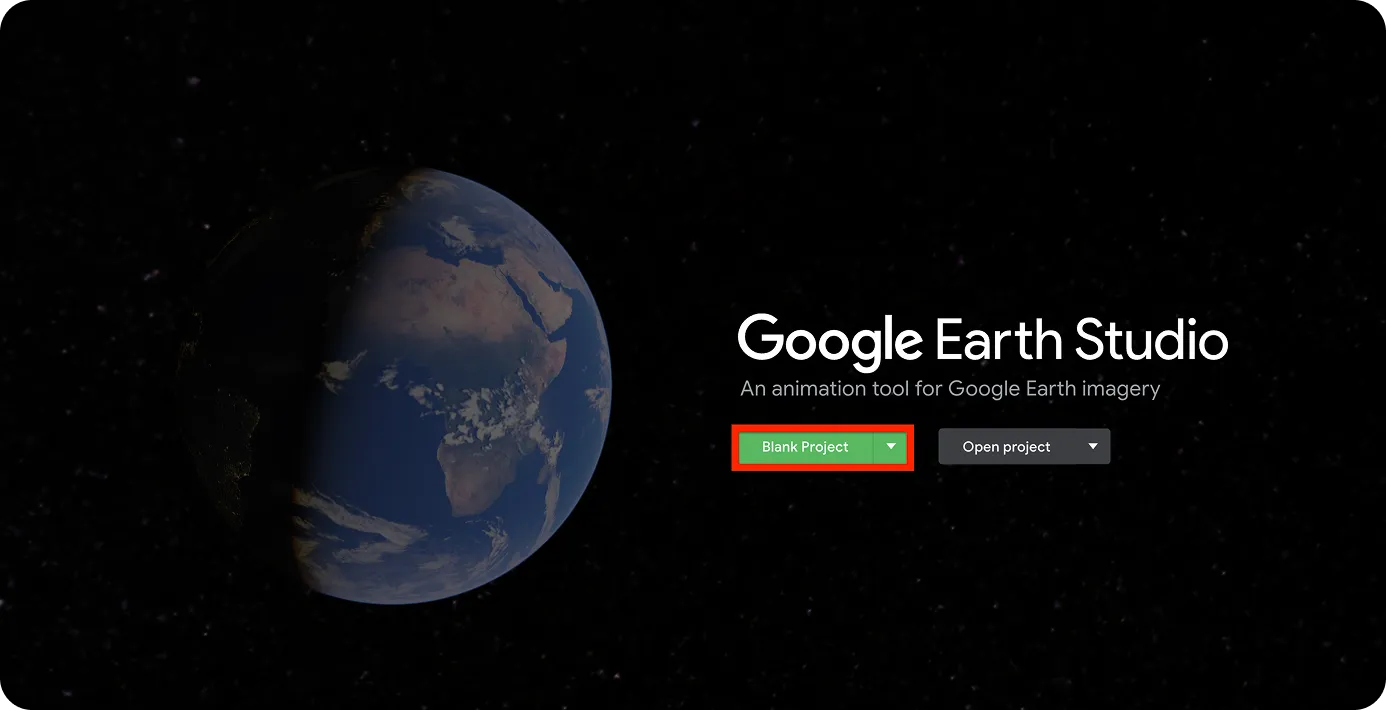

Google Earth Studio é uma ferramenta de animação baseada na Web que pode ser utilizada pelos utilizadores para criar conteúdos estáticos e animados utilizando as imagens de satélite e 3D do Google Earth. Podemos utilizá-lo para criar imagens aéreas realistas.

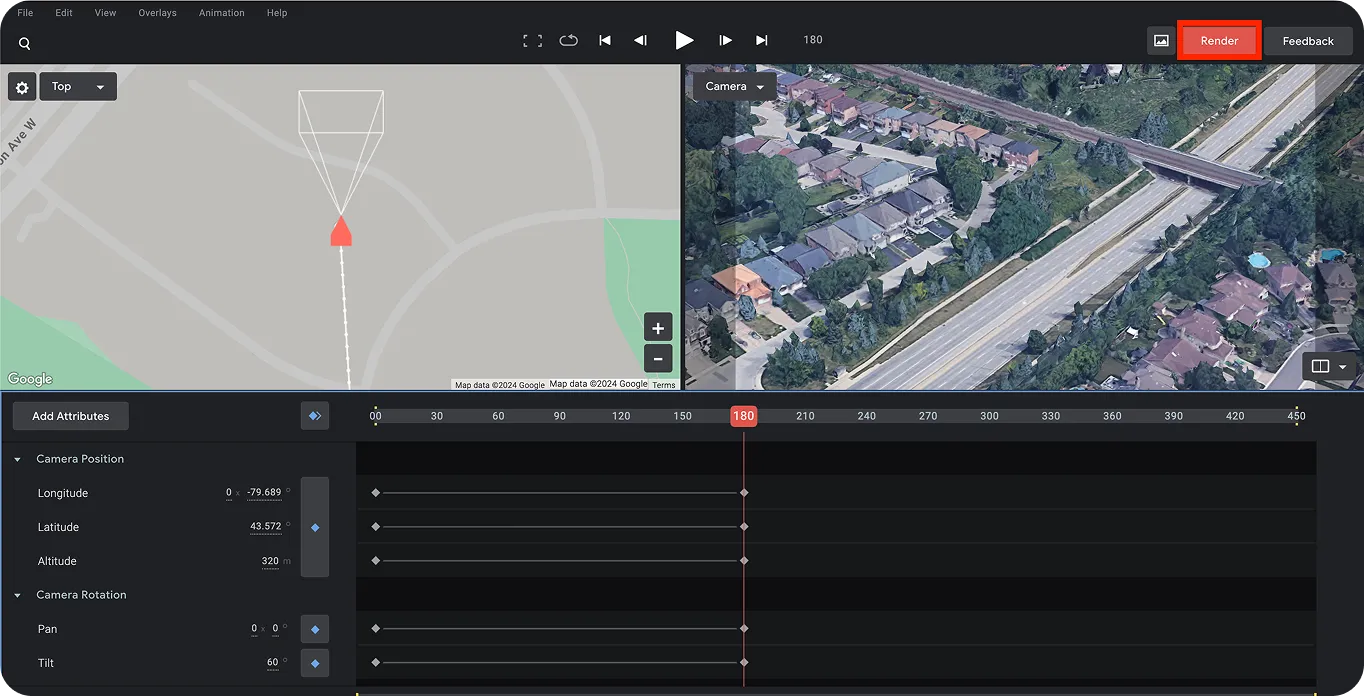

O primeiro passo é abrir o Google Earth Studio e criar um projeto, como se mostra abaixo.

É necessária uma conta Google para iniciar sessão.

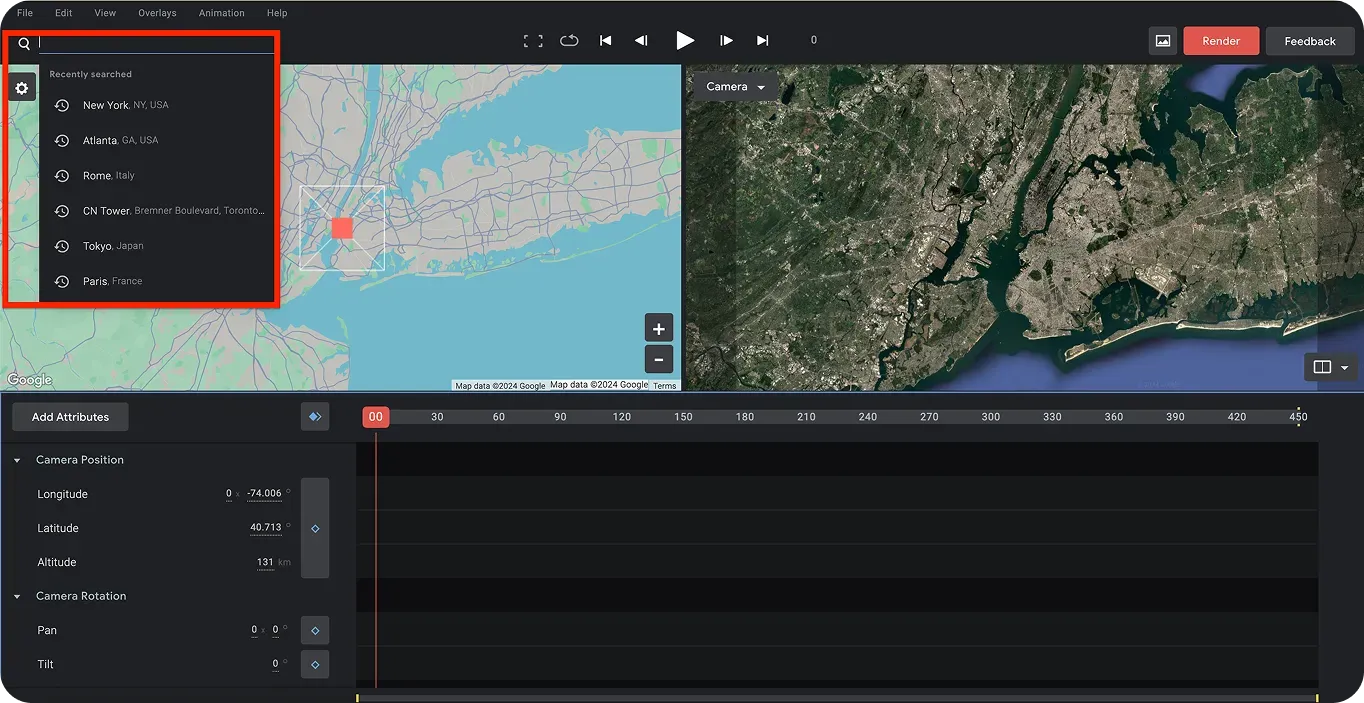

Depois de iniciar sessão, pode escolher um local para o seu vídeo de drone artificial. Utilizando a barra de pesquisa no canto superior esquerdo da página, pode procurar localizações. Para este tutorial, vamos escolher o Canadá. Além disso, como vamos treinar um modelo para detect casas, o nosso vídeo de drone deve ter uma vista aérea de casas.

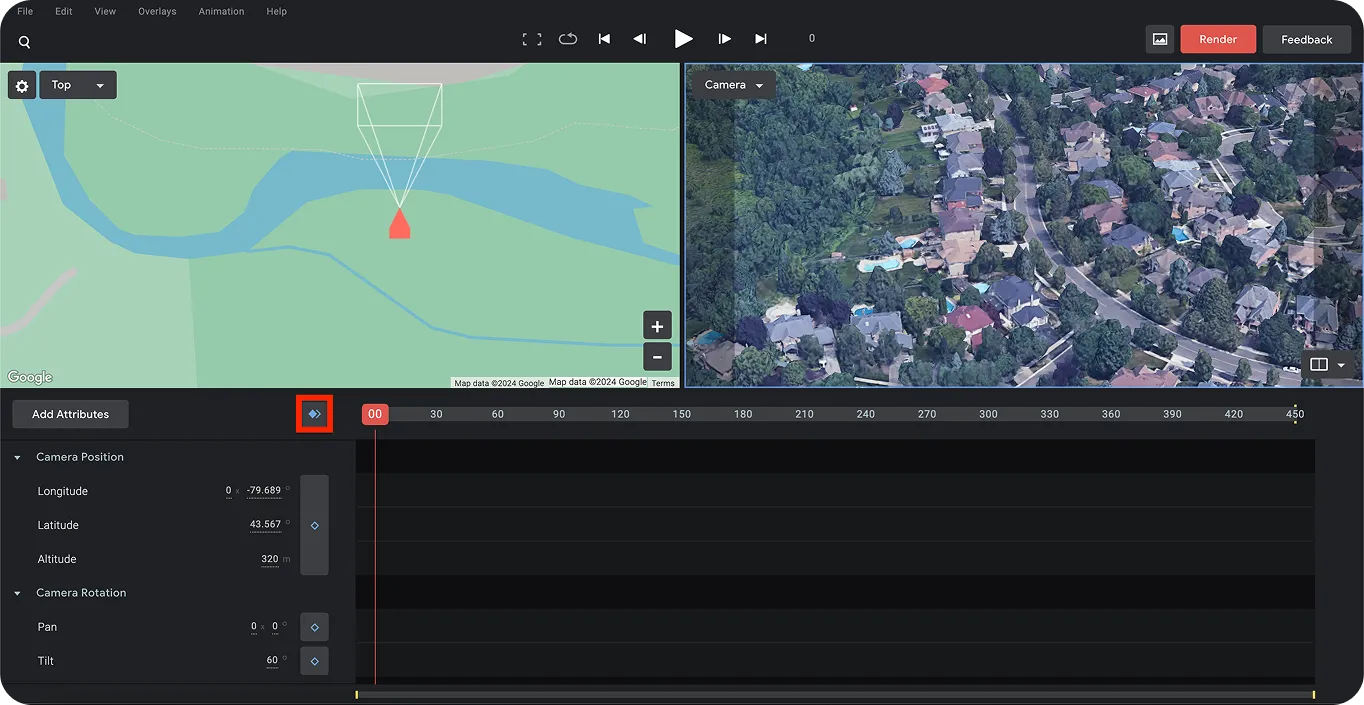

Em seguida, podemos definir os quadros inicial e final para capturar o movimento da filmagem artificial do drone. Depois de escolher o local de partida para a filmagem do drone, defina o primeiro quadro usando os diamantes azuis, como mostrado abaixo.

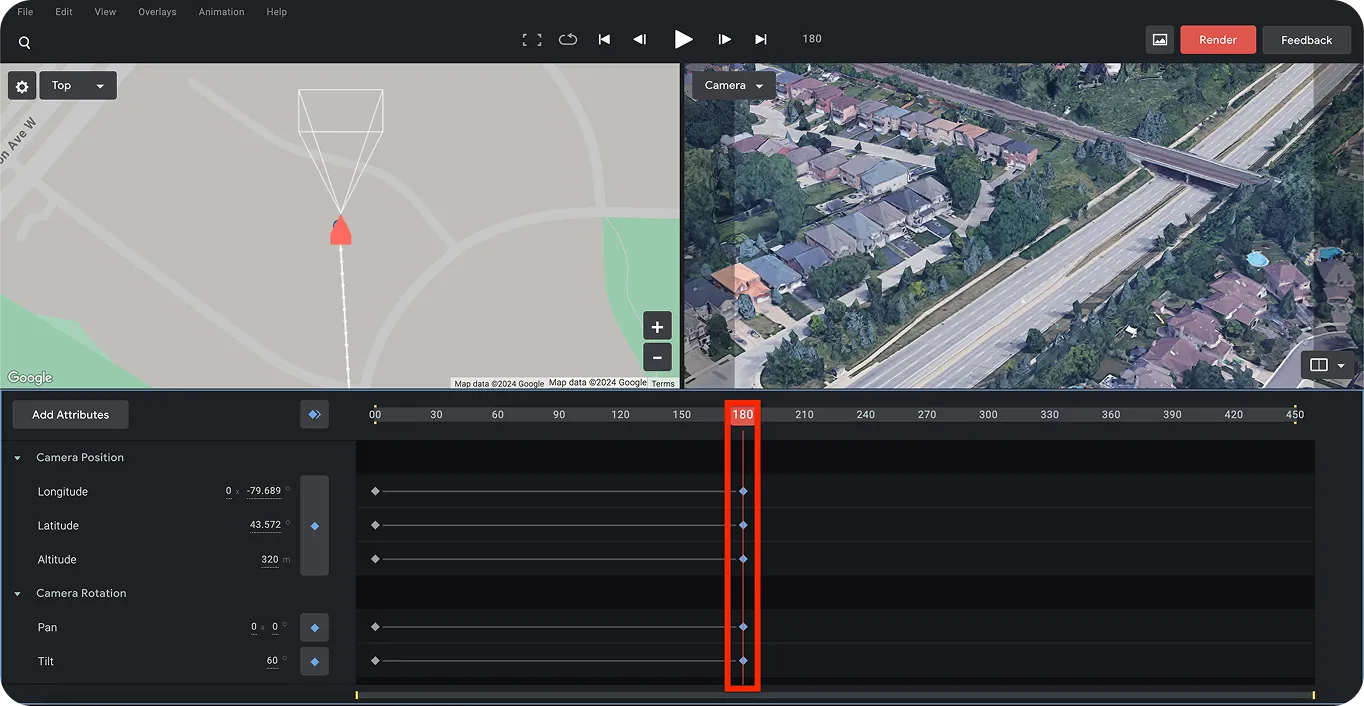

Em seguida, podemos escolher o último quadro para determinar o destino do drone. Isso nos ajudará a criar um efeito de movimento para a filmagem do drone. Para fazer isso, deslize a barra (destacada abaixo) para a direita até um horário específico para criar o efeito de movimento para a filmagem do drone. Mais uma vez, use os diamantes azuis para definir o último ponto.

Finalmente, você pode salvar este projeto e renderizá-lo clicando no botão vermelho "Renderizar" no canto superior direito da página. Isso lhe dará a saída de vídeo final da filmagem do drone, criando com sucesso filmagens de vídeo de drone artificiais.

Agora que criamos filmagens de vídeo de drone artificiais, o próximo passo é rotular ou anotar as casas nele. Também precisaremos separar os frames individuais do vídeo.

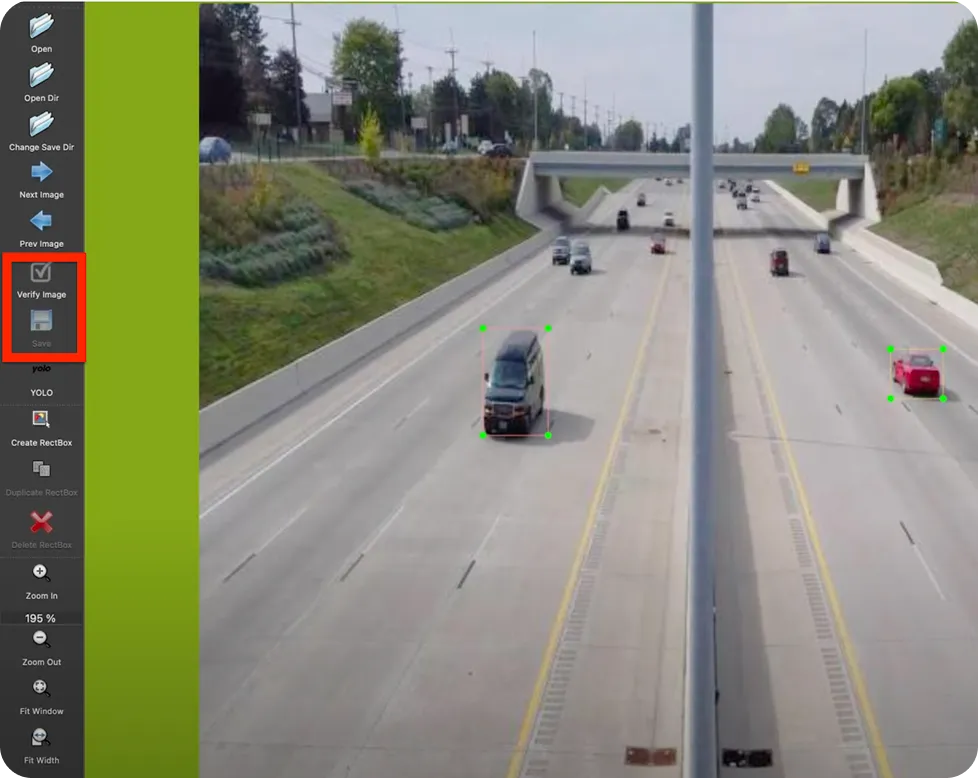

Para começar, instalaremos o LabelImg. LabelImg é uma ferramenta de rotulagem de imagens de código aberto. Você pode instalá-lo diretamente do terminal usando o instalador de pacotes pip executando o seguinte comando: “pip install labelImg”.

Após a instalação, você pode executar a ferramenta usando o comando ‘labelImg’ no seu terminal ou prompt de comando. Isso o levará à página mostrada abaixo.

Enquanto isso, podemos usar um conversor online de vídeo para imagem ou uma ferramenta chamada FFmpeg para dividir o vídeo em frames. FFmpeg é uma coleção de bibliotecas e ferramentas para processar conteúdo multimídia, como áudio, vídeo, legendas e metadados relacionados.

Você pode usar o seguinte comando de terminal para separar cada frame do vídeo da filmagem do drone:

Depois de separar os fotogramas da filmagem do drone, podemos começar a etiquetar os objectos (casas) neles contidos. Navegando para a pasta de imagens através da ferramenta LabelImg, podemos etiquetar os objectos em cada imagem. Certifique-se de que guarda e verifica todas as imagens etiquetadas. Depois de anotar as imagens, podemos agora passar ao treino YOLO11 utilizando estes dados.

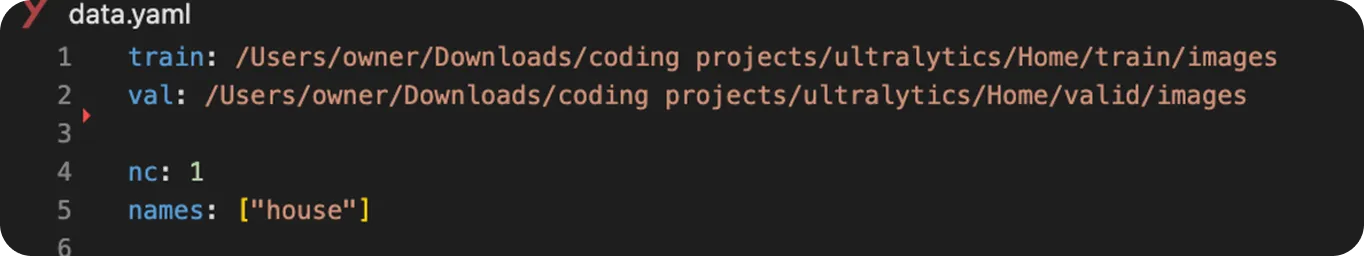

Antes de começarmos a treinar o YOLO11, vamos organizar as nossas imagens e etiquetas. Comece por criar duas pastas: uma com o nome "train" (treino) e a outra com o nome "valid" (válido). Divida as suas imagens entre estas pastas. Dentro de cada uma delas, crie subpastas separadas para as imagens e os ficheiros de etiquetas correspondentes (formato de texto), como se mostra abaixo.

Em seguida, podemos começar a treinar o modelo YOLO11 da seguinte forma:

from ultralytics import YOLO

# Load a YOLO11 model

model = YOLO("yolo11n.pt") # choose your model, e.g., YOLO11 nano

# Train the model with your data and settings

model.train(data="data.yaml", epochs=100, imgsz=640)

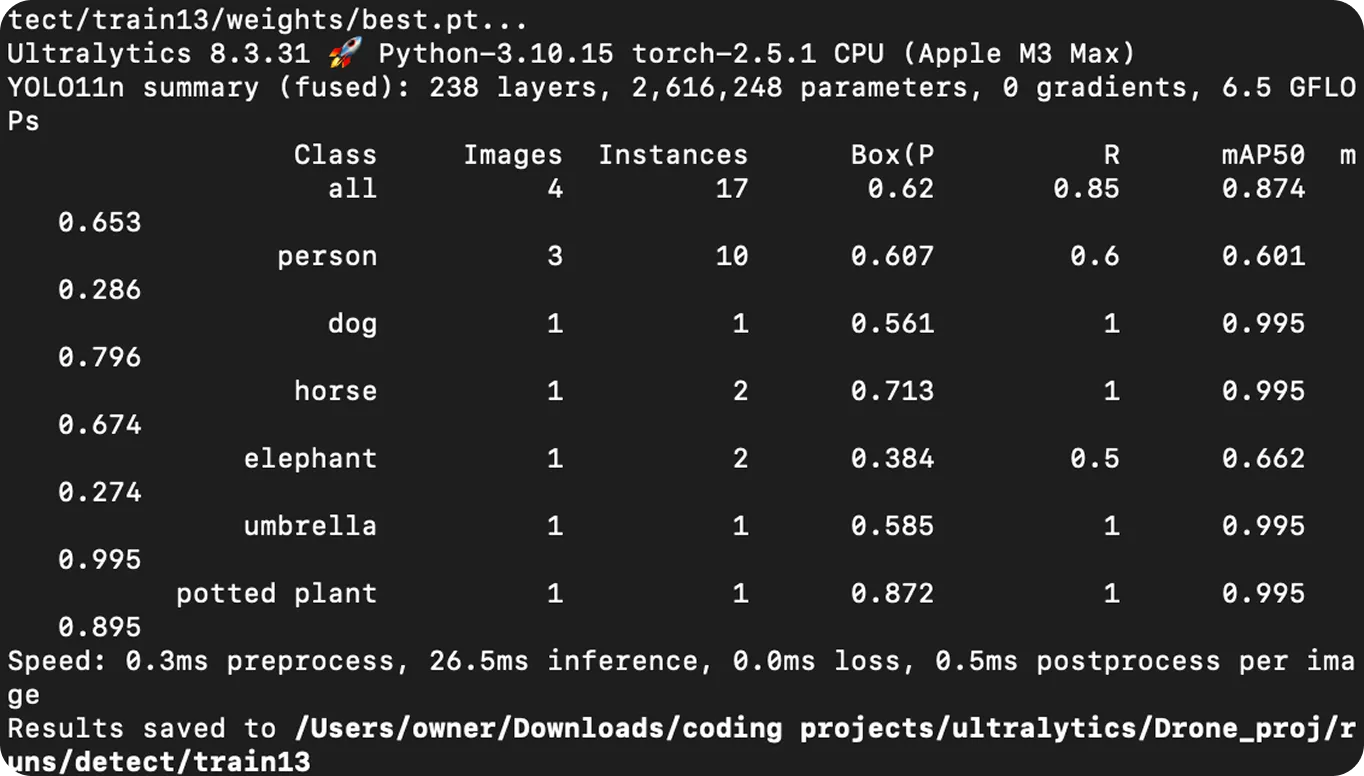

O modelo YOLO11 treinado pode agora ser utilizado para fazer previsões através de um processo designado por inferência. A inferência envolve a utilização de um modelo para analisar dados novos e não vistos com base no que aprendeu durante o treino. Neste caso, o modelo pode ser utilizado para encontrar e rotular objectos específicos, como casas, em imagens ou vídeos, desenhando caixas delimitadoras à sua volta.

Para executar uma previsão, pode utilizar o modelo YOLO11 treinado num vídeo de entrada utilizando o seguinte código Python . Neste exemplo, vamos utilizar o mesmo vídeo de drone artificial que foi utilizado para o treino, mas pode utilizar qualquer outro ficheiro de vídeo, se preferir.

# Import library

from ultralytics import YOLO

# Load the YOLO model

model = YOLO("best.pt") # Choose your custom-trained model

# Predict the results from the model

results = model.predict(source="path/to/original/video.mp4", show=True, save=True)Após executar este código, o arquivo de vídeo de saída com as predições e caixas delimitadoras será salvo.

A deteção de casas para entrega de pacotes por drones é apenas um exemplo de como a visão computacional e YOLO11 podem ser aplicados. Eis algumas outras utilizações reais da visão por computador, YOLO11 e drones aéreos:

Os drones com IA alimentados por visão computacional estão a mudar muitas indústrias, desde a entrega de encomendas à ajuda em emergências e na agricultura. Neste guia, percorremos a criação de um vídeo de drone artificial, rotulando objectos nele, treinando YOLO11 e utilizando-o para detect casas.

A aplicação da deteção de objectos às filmagens dos drones torna estes drones mais inteligentes, permitindo-lhes reconhecer e track objectos automaticamente em tempo real. À medida que a tecnologia melhora, é provável que os drones com IA desempenhem um papel ainda mais importante na realização de entregas mais rápidas, na melhoria da segurança e na ajuda à resposta a catástrofes.

Junte-se à nossa comunidade e explore o nosso repositório GitHub para saber mais sobre a Vision AI, e confira as nossas opções de licenciamento para dar o pontapé inicial nos seus projetos de visão computacional. Interessado em inovações como IA na indústria transformadora ou visão computacional na indústria automotiva? Visite as nossas páginas de soluções para descobrir mais.