Saiba como a Máscara R-CNN pode ser utilizada para segment com precisão objectos em imagens e vídeos para várias aplicações em diferentes sectores.

Saiba como a Máscara R-CNN pode ser utilizada para segment com precisão objectos em imagens e vídeos para várias aplicações em diferentes sectores.

Inovações como robôs em armazéns, carros autônomos movendo-se com segurança por ruas movimentadas, drones verificando plantações e sistemas de IA inspecionando produtos em fábricas estão a tornar-se mais comuns à medida que a adoção da IA aumenta. Uma tecnologia chave que impulsiona estas inovações é a visão computacional, um ramo da IA que permite que as máquinas compreendam e interpretem dados visuais.

Por exemplo, a detecção de objetos é uma tarefa de visão computacional que ajuda a identificar e localizar objetos em imagens usando bounding boxes. Embora as bounding boxes ofereçam informações úteis, elas fornecem apenas uma estimativa aproximada da posição de um objeto e não conseguem capturar sua forma ou limites exatos. Isso os torna menos eficazes em aplicações que exigem identificação precisa.

Para resolver este problema, os investigadores desenvolveram modelos de segmentação que capturam os contornos exatos dos objetos, fornecendo detalhes ao nível do pixel para uma detecção e análise mais precisas.

O Mask R-CNN é um desses modelos. Introduzido em 2017 pela Facebook AI Research (FAIR), baseia-se em modelos anteriores como R-CNN, Fast R-CNN e Faster R-CNN. Como um marco importante na história da visão computacional, o Mask R-CNN abriu caminho para modelos mais avançados, como Ultralytics YOLO11.

Neste artigo, vamos explorar o que é a Máscara R-CNN, como funciona, as suas aplicações e que melhorias surgiram depois dela, levando ao YOLO11.

Mask R-CNN, que significa Mask Region-based Convolutional Neural Network (Rede Neural Convolucional Baseada em Região de Máscara), é um modelo de aprendizado profundo projetado para tarefas de visão computacional como detecção de objetos e segmentação de instâncias.

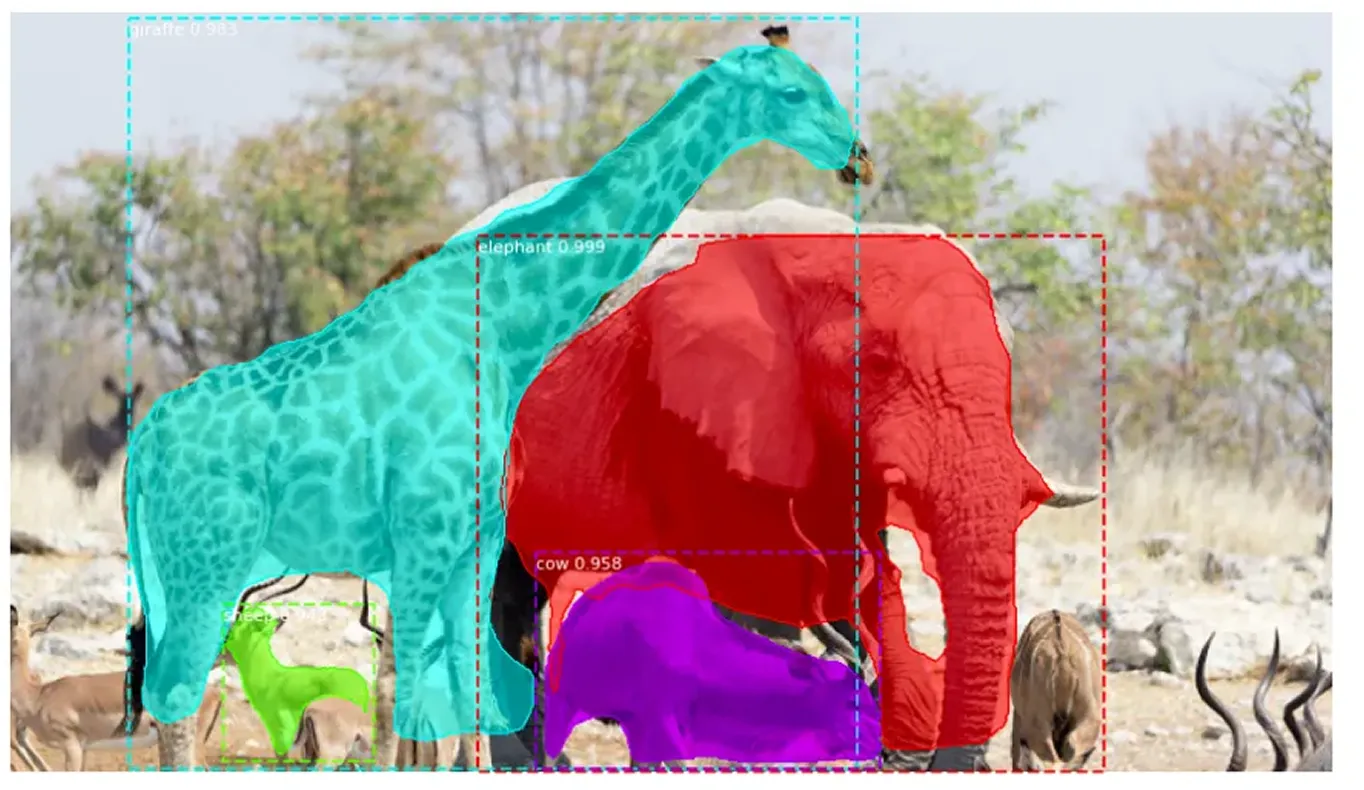

A segmentação de instâncias vai além da detecção de objetos tradicional, não só identificando objetos em uma imagem, mas também delineando com precisão cada um deles. Ela atribui um rótulo exclusivo a cada objeto detectado e captura sua forma exata no nível do pixel. Essa abordagem detalhada possibilita distinguir claramente entre objetos sobrepostos e lidar com precisão com formas complexas.

O Mask R-CNN é construído sobre o Faster R-CNN, que detecta e rotula objetos, mas não define suas formas exatas. O Mask R-CNN aprimora isso identificando os pixels exatos que compõem cada objeto, permitindo uma análise de imagem muito mais detalhada e precisa.

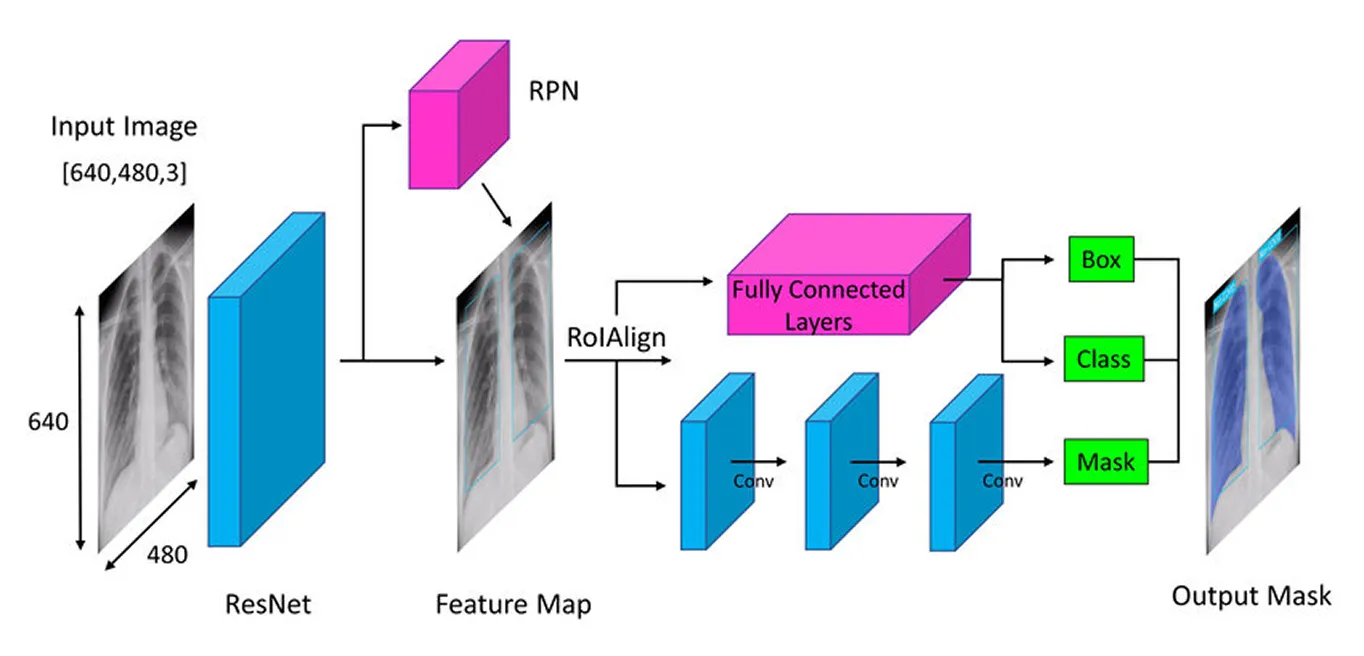

A máscara R-CNN adopta uma abordagem passo-a-passo para detect e segment objectos com precisão. Começa por extrair as principais caraterísticas utilizando uma rede neural profunda (um modelo de várias camadas que aprende com os dados), depois identifica potenciais áreas de objectos com uma rede de proposta de região (um componente que sugere regiões de objectos prováveis) e, por fim, aperfeiçoa estas áreas criando máscaras de segmentação detalhadas (contornos precisos de objectos) que captam a forma exacta de cada objeto.

Em seguida, vamos percorrer cada etapa para ter uma ideia melhor de como o Mask R-CNN funciona.

O primeiro passo na arquitetura do Mask R-CNN é decompor a imagem em suas partes principais para que o modelo possa entender o que há nela. Pense nisso como quando você olha para uma foto e naturalmente percebe detalhes como formas, cores e bordas. O modelo faz algo semelhante usando uma rede neural profunda chamada "backbone" (geralmente ResNet-50 ou ResNet-101), que age como seus olhos para escanear a imagem e captar detalhes importantes.

Como os objetos nas imagens podem ser muito pequenos ou muito grandes, o Mask R-CNN utiliza uma Feature Pyramid Network (Rede de Pirâmide de Características). Isto é como ter diferentes lupas que permitem ao modelo ver tanto os detalhes finos como a imagem maior, garantindo que os objetos de todos os tamanhos são notados.

Uma vez que essas características importantes são extraídas, o modelo passa a localizar os objetos potenciais na imagem, preparando o terreno para análises posteriores.

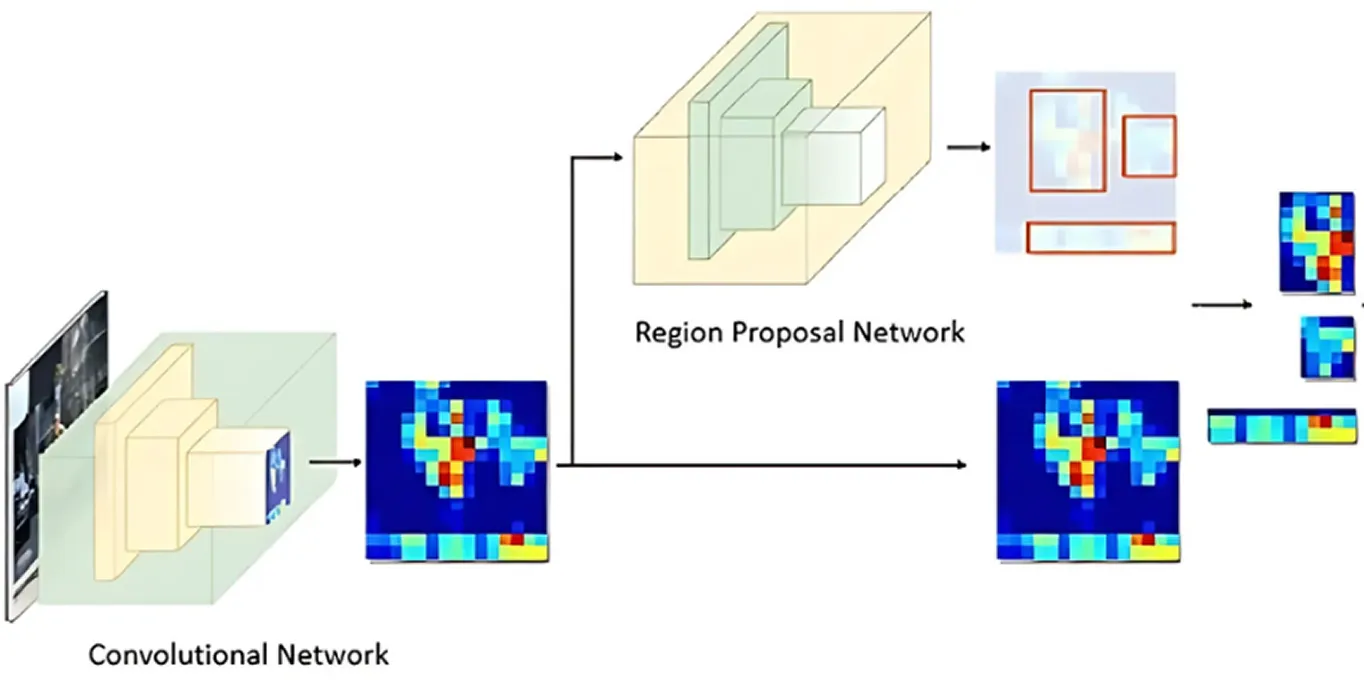

Após a imagem ser processada para obter os principais recursos, a Rede de Proposta de Regiões assume o controle. Esta parte do modelo analisa a imagem e sugere áreas que provavelmente contêm objetos.

Ele faz isso gerando múltiplas localizações de objetos possíveis chamadas de âncoras. A rede então avalia essas âncoras e seleciona as mais promissoras para análise posterior. Desta forma, o modelo foca apenas nas áreas com maior probabilidade de serem interessantes, em vez de verificar cada ponto da imagem.

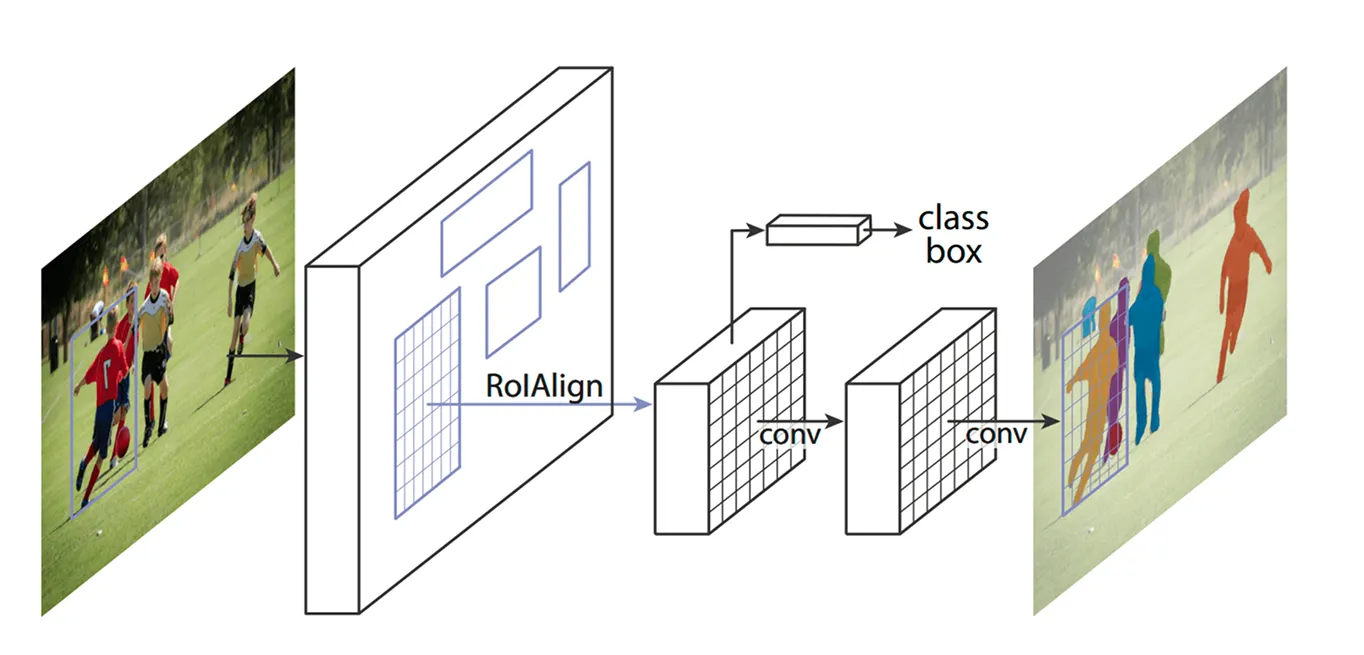

Com as áreas-chave identificadas, a próxima etapa é refinar os detalhes extraídos dessas regiões. Os modelos anteriores usavam um método chamado ROI Pooling (Region of Interest Pooling) para capturar recursos de cada área, mas essa técnica às vezes levava a pequenos desalinhamentos ao redimensionar as regiões, tornando-a menos eficaz - especialmente para objetos menores ou sobrepostos.

O Mask R-CNN melhora isso usando uma técnica conhecida como ROI Align (Alinhamento de Região de Interesse). Em vez de arredondar as coordenadas como o ROI Pooling faz, o ROI Align usa a interpolação bilinear para estimar os valores dos pixels com mais precisão. A interpolação bilinear é um método que calcula um novo valor de pixel, fazendo a média dos valores de seus quatro vizinhos mais próximos, o que cria transições mais suaves. Isso mantém os recursos devidamente alinhados com a imagem original, resultando em detecção e segmentação de objetos mais precisas.

Por exemplo, em uma partida de futebol, dois jogadores próximos um do outro podem ser confundidos, pois suas bounding boxes se sobrepõem. O ROI Align ajuda a separá-los, mantendo suas formas distintas.

Assim que o Alinhamento de ROI processa a imagem, o passo seguinte é classify os objectos e afinar as suas localizações. O modelo analisa cada região extraída e decide que objeto contém. Atribui uma pontuação de probabilidade a diferentes categorias e seleciona a melhor correspondência.

Ao mesmo tempo, ele ajusta as caixas delimitadoras para melhor ajustar os objetos. As caixas iniciais podem não estar idealmente posicionadas, então isso ajuda a melhorar a precisão, garantindo que cada caixa envolva firmemente o objeto detectado.

Finalmente, o Mask R-CNN dá um passo extra: ele gera uma máscara de segmentação detalhada para cada objeto em paralelo.

Quando este modelo foi lançado, foi recebido com grande entusiasmo pela comunidade de IA e foi rapidamente utilizado em várias aplicações. A sua capacidade de detect e segment objectos em tempo real transformou-o num fator de mudança em diferentes indústrias.

Por exemplo, localizar animais em vias de extinção na natureza é uma tarefa difícil. Muitas espécies deslocam-se através de florestas densas, o que torna difícil para os conservacionistas track . Os métodos tradicionais recorrem a armadilhas fotográficas, drones e imagens de satélite, mas a análise manual de todos estes dados é morosa. Os erros de identificação e os avistamentos falhados podem atrasar os esforços de conservação.

Ao reconhecer caraterísticas únicas como riscas de tigre, manchas de girafa ou a forma das orelhas de um elefante, a Mask R-CNN consegue detect e segment animais em imagens e vídeos com maior precisão. Mesmo quando os animais estão parcialmente escondidos por árvores ou próximos uns dos outros, o modelo consegue separá-los e identificar cada um individualmente, tornando a monitorização da vida selvagem mais rápida e fiável.

Apesar de sua importância histórica na detecção e segmentação de objetos, o Mask R-CNN também apresenta algumas desvantagens importantes. Aqui estão alguns desafios relacionados ao Mask R-CNN:

A máscara R-CNN era excelente para tarefas de segmentação, mas muitas indústrias estavam a tentar adotar a visão por computador, dando prioridade à velocidade e ao desempenho em tempo real. Este requisito levou os investigadores a desenvolver modelos de uma fase que detect objectos numa única passagem, melhorando consideravelmente a eficiência.

Ao contrário do processo de várias etapas da Mask R-CNN, os modelos de visão computacional de uma etapa, como o YOLO (You Only Look Once), concentram-se em tarefas de visão computacional em tempo real. Em vez de tratar a deteção e a segmentação separadamente, os modelos YOLO podem analisar uma imagem de uma só vez. Isto torna-os ideais para aplicações como a condução autónoma, cuidados de saúde, fabrico e robótica, onde a tomada rápida de decisões é crucial.

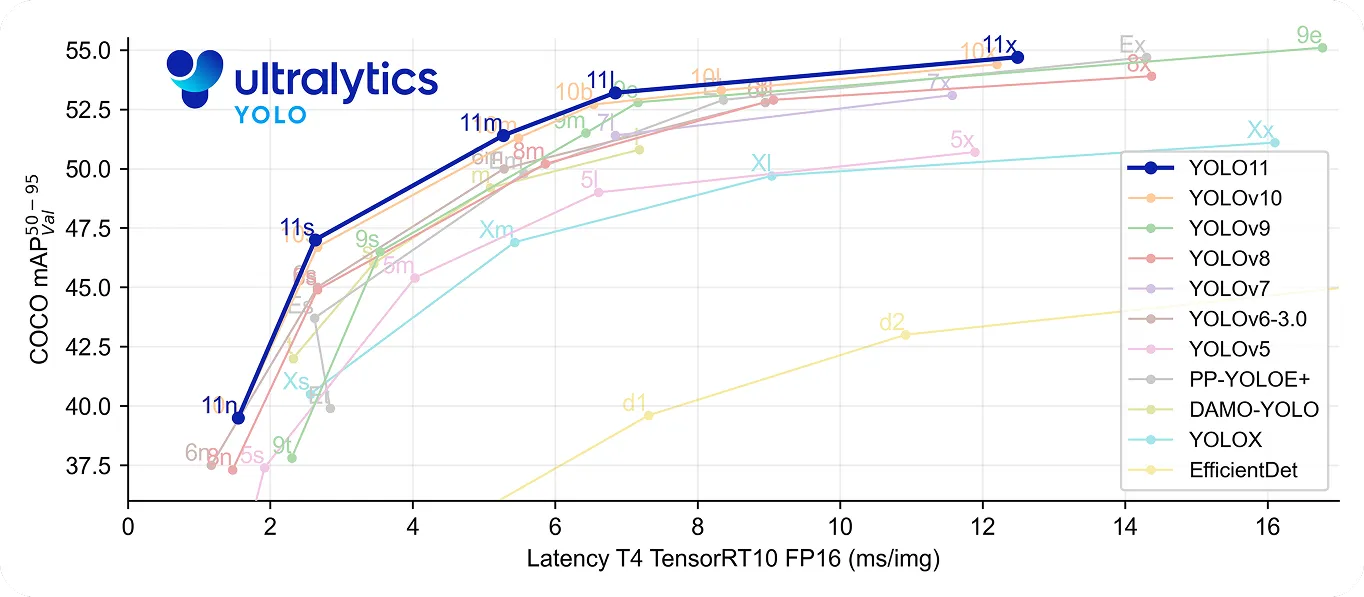

Em particular, YOLO11 dá um passo em frente, sendo simultaneamente rápido e preciso. Utiliza menos 22% de parâmetros do que YOLOv8m , mas ainda assim alcança uma precisão média superiormAP) no conjunto de dados COCO , o que significa que detecta objectos com maior precisão. A sua velocidade de processamento melhorada torna-o uma boa escolha para aplicações em tempo real em que cada milissegundo é importante.

Olhando para trás na história da visão computacional, o Mask R-CNN é reconhecido como um grande avanço na detecção e segmentação de objetos. Ele oferece resultados muito precisos, mesmo em ambientes complexos, graças ao seu processo detalhado de várias etapas.

No entanto, este mesmo processo torna-o mais lento em comparação com modelos em tempo real como o YOLO. À medida que a necessidade de velocidade e eficiência aumenta, muitas aplicações utilizam agora modelos de uma fase, como o Ultralytics YOLO11, que oferecem uma deteção de objectos rápida e precisa. Embora o Mask R-CNN seja importante para compreender a evolução da visão computacional, a tendência para soluções em tempo real destaca a crescente procura de soluções de visão computacional mais rápidas e eficientes.

Junte-se à nossa crescente comunidade! Explore nosso repositório GitHub para saber mais sobre IA. Pronto para iniciar seus próprios projetos de visão computacional? Confira nossas opções de licenciamento. Descubra a IA na agricultura e a Vision AI na área da saúde visitando nossas páginas de soluções!