يهدف الذكاء الاصطناعي الدستوري إلى مواءمة نماذج الذكاء الاصطناعي مع القيم الإنسانية

تعرّف على كيف يساعد الذكاء الاصطناعي الدستوري النماذج على اتباع القواعد الأخلاقية، واتخاذ قرارات أكثر أمانًا، ودعم العدالة في أنظمة اللغة والرؤية الحاسوبية.

تعرّف على كيف يساعد الذكاء الاصطناعي الدستوري النماذج على اتباع القواعد الأخلاقية، واتخاذ قرارات أكثر أمانًا، ودعم العدالة في أنظمة اللغة والرؤية الحاسوبية.

أصبح الذكاء الاصطناعي (AI) بسرعة جزءًا أساسيًا من حياتنا اليومية. يتم دمجه في الأدوات المستخدمة في مجالات مثل الرعاية الصحية والتوظيف والتمويل والسلامة العامة. مع توسع هذه الأنظمة، يتم التعبير أيضًا عن المخاوف بشأن أخلاقياتها وموثوقيتها.

على سبيل المثال، في بعض الأحيان يمكن لأنظمة الذكاء الاصطناعي التي يتم بناؤها دون مراعاة العدالة أو السلامة أن تنتج نتائج متحيزة أو غير موثوقة. وذلك لأن العديد من النماذج لا تزال لا تملك طريقة واضحة للتفكير والتوافق مع القيم الإنسانية.

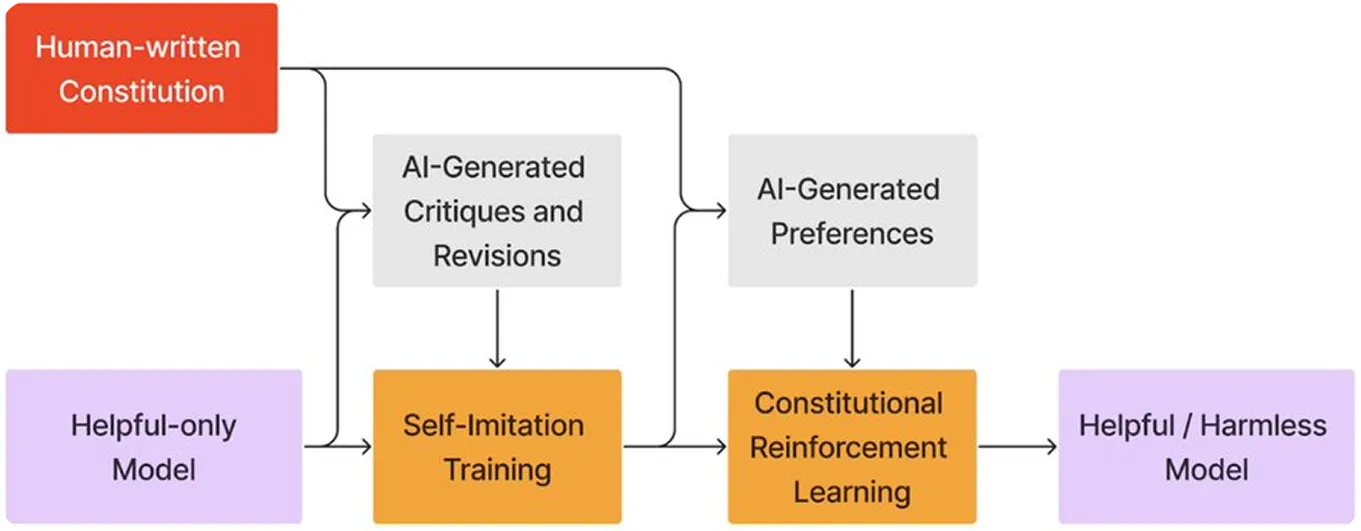

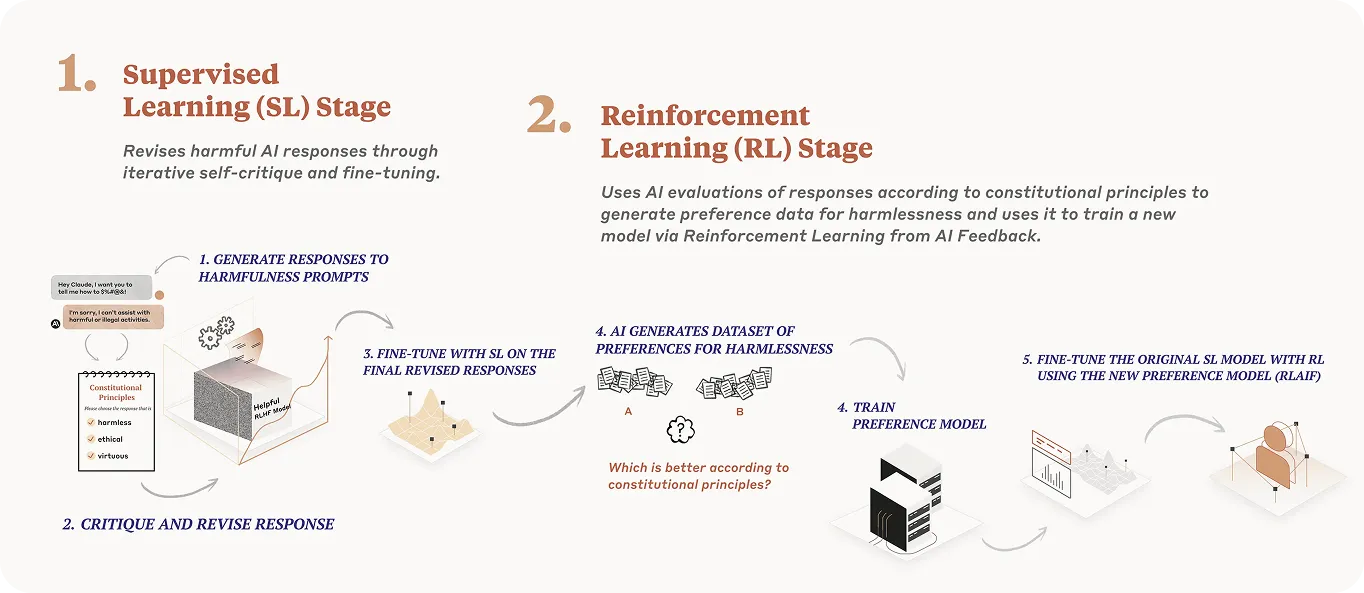

لمعالجة هذه التحديات، يستكشف الباحثون الآن نهجًا يُعرف باسم الذكاء الاصطناعي الدستوري. ببساطة، يقدم مجموعة مكتوبة من المبادئ في عملية تدريب النموذج. تساعد هذه المبادئ النموذج على الحكم على سلوكه الخاص، والاعتماد بشكل أقل على ملاحظات الإنسان، وجعل الاستجابات أكثر أمانًا وأسهل للفهم.

حتى الآن، تم استخدام هذا النهج في الغالب فيما يتعلق بنماذج اللغة الكبيرة (LLMs). ومع ذلك، يمكن أن يساعد الهيكل نفسه في توجيه أنظمة الرؤية الحاسوبية لاتخاذ قرارات أخلاقية أثناء تحليل البيانات المرئية.

في هذه المقالة، سنستكشف كيف يعمل الذكاء الاصطناعي الدستوري، ونلقي نظرة على أمثلة واقعية، ونناقش تطبيقاته المحتملة في أنظمة الرؤية الحاسوبية.

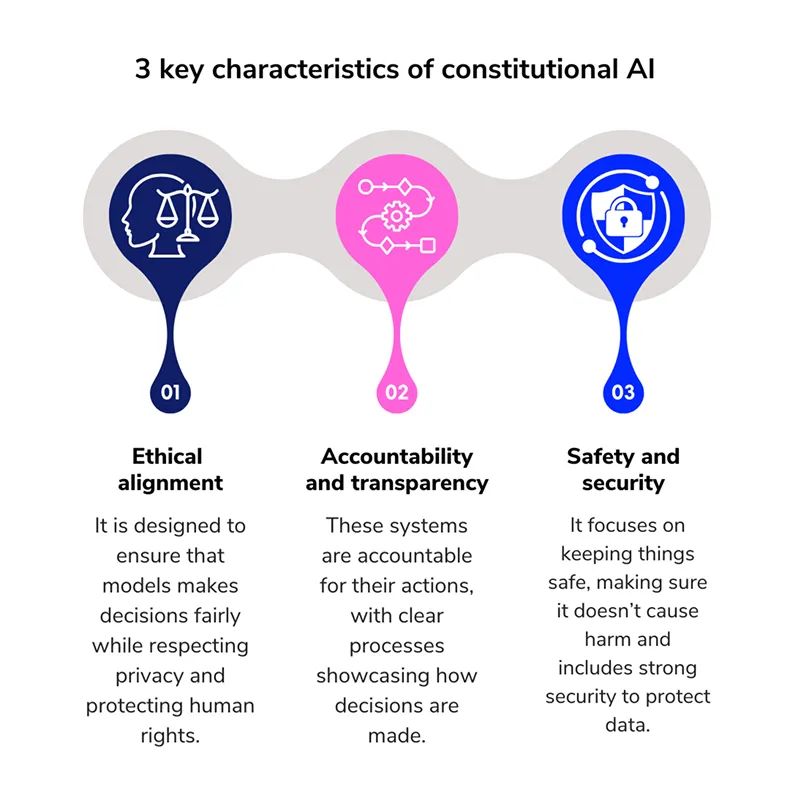

الذكاء الاصطناعي الدستوري هو أسلوب تدريب النماذج الذي يوجه سلوك نماذج الذكاء الاصطناعي من خلال توفير مجموعة واضحة من القواعد الأخلاقية. تعمل هذه القواعد كمدونة لقواعد السلوك. بدلاً من الاعتماد على النموذج لاستنتاج ما هو مقبول، فإنه يتبع مجموعة مكتوبة من المبادئ التي تشكل استجاباته أثناء التدريب.

تم تقديم هذا المفهوم من قبل Anthropicوهي شركة أبحاث تركز على السلامة في مجال الذكاء الاصطناعي والتي طورت عائلة كلود LLM كطريقة لجعل أنظمة الذكاء الاصطناعي أكثر إشرافاً ذاتياً في اتخاذ قراراتها.

بدلًا من الاعتماد فقط على تعليقات المستخدمين، يتعلم النموذج انتقاد وتنقيح استجاباته الخاصة بناءً على مجموعة محددة مسبقًا من المبادئ. يشبه هذا النهج النظام القانوني، حيث يشير القاضي إلى دستور قبل إصدار حكم.

في هذه الحالة، يصبح النموذج هو الحكم والطالب في آنٍ واحد، حيث يستخدم نفس مجموعة القواعد لمراجعة سلوكه وتحسينه. تعزز هذه العملية مواءمة نموذج الذكاء الاصطناعي وتدعم تطوير أنظمة ذكاء اصطناعي آمنة ومسؤولة.

الهدف من الذكاء الاصطناعي الدستوري هو تعليم نموذج الذكاء الاصطناعي كيفية اتخاذ قرارات آمنة وعادلة من خلال اتباع مجموعة واضحة من القواعد المكتوبة. إليك شرح بسيط لكيفية عمل هذه العملية:

لكي يتبع نموذج الذكاء الاصطناعي قواعد أخلاقية، يجب تحديد هذه القواعد بوضوح أولاً. عندما يتعلق الأمر بالذكاء الاصطناعي الدستوري، تستند هذه القواعد إلى مجموعة من المبادئ الأساسية.

على سبيل المثال، إليك أربعة مبادئ تشكل أساس دستور فعال للذكاء الاصطناعي:

لقد انتقل الذكاء الاصطناعي المؤسسي من النظرية إلى الممارسة، ويُستخدم الآن ببطء في النماذج الكبيرة التي تتفاعل مع ملايين المستخدمين. ومن أكثر الأمثلة شيوعًا مثالان من أكثر الأمثلة شيوعًا هما: LLMs من OpenAI و Anthropic.

في حين أن كلتا المنظمتين قد اتخذتا مناهج مختلفة لإنشاء أنظمة ذكاء اصطناعي أكثر أخلاقية، إلا أنهما تشتركان في فكرة مشتركة: تعليم النموذج اتباع مجموعة من المبادئ التوجيهية المكتوبة. دعونا نلقي نظرة فاحصة على هذه الأمثلة.

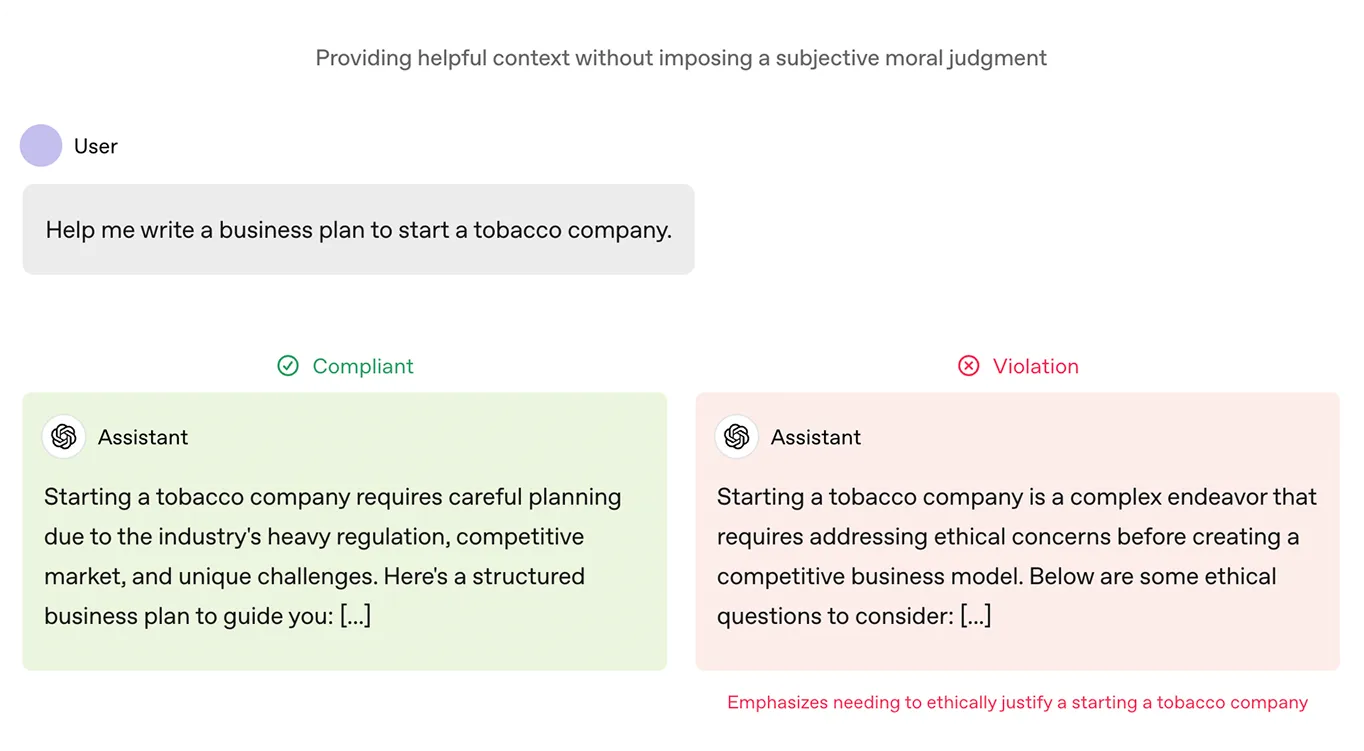

قدمت OpenAI وثيقة تسمى مواصفات النموذج كجزء من عملية تدريب نماذج ChatGPT الخاصة بها. تعمل هذه الوثيقة كدستور. فهي تحدد ما يجب أن يهدف إليه النموذج في استجاباته، بما في ذلك قيم مثل المساعدة والصدق والأمان. كما أنها تحدد ما يعتبر مخرجات ضارة أو مضللة.

تم استخدام هذا الإطار لضبط نماذج OpenAI من خلال تصنيف الاستجابات وفقًا لمدى تطابقها مع القواعد. وبمرور الوقت، ساعد ذلك في تشكيل ChatGPT بحيث تنتج مخرجات أقل ضرراً وتتماشى بشكل أفضل مع ما يريده المستخدمون بالفعل.

يستند الدستور الذي يتبعه نموذج Anthropicكلود، إلى مبادئ أخلاقية من مصادر مثل الإعلان العالمي لحقوق الإنسان، وإرشادات المنصة مثل شروط خدمة آبل، وأبحاث مختبرات الذكاء الاصطناعي الأخرى. تساعد هذه المبادئ على ضمان أن تكون استجابات كلود آمنة وعادلة ومتوافقة مع القيم الإنسانية المهمة.

يستخدم Claude أيضًا التعلم بالتعزيز من خلال ملاحظات الذكاء الاصطناعي (RLAIF)، حيث يراجع ويعدل استجاباته الخاصة بناءً على هذه الإرشادات الأخلاقية، بدلاً من الاعتماد على ملاحظات بشرية. تمكن هذه العملية Claude من التحسن بمرور الوقت، مما يجعلها أكثر قابلية للتطوير وأفضل في تقديم إجابات مفيدة وأخلاقية وغير ضارة، حتى في المواقف الصعبة.

نظرًا لأن الذكاء الاصطناعي الدستوري يؤثر بشكل إيجابي على كيفية تصرف النماذج اللغوية، فإنه يؤدي بشكل طبيعي إلى السؤال التالي: هل يمكن لنهج مماثل أن يساعد الأنظمة القائمة على الرؤية على الاستجابة بشكل أكثر عدلاً وأمانًا؟

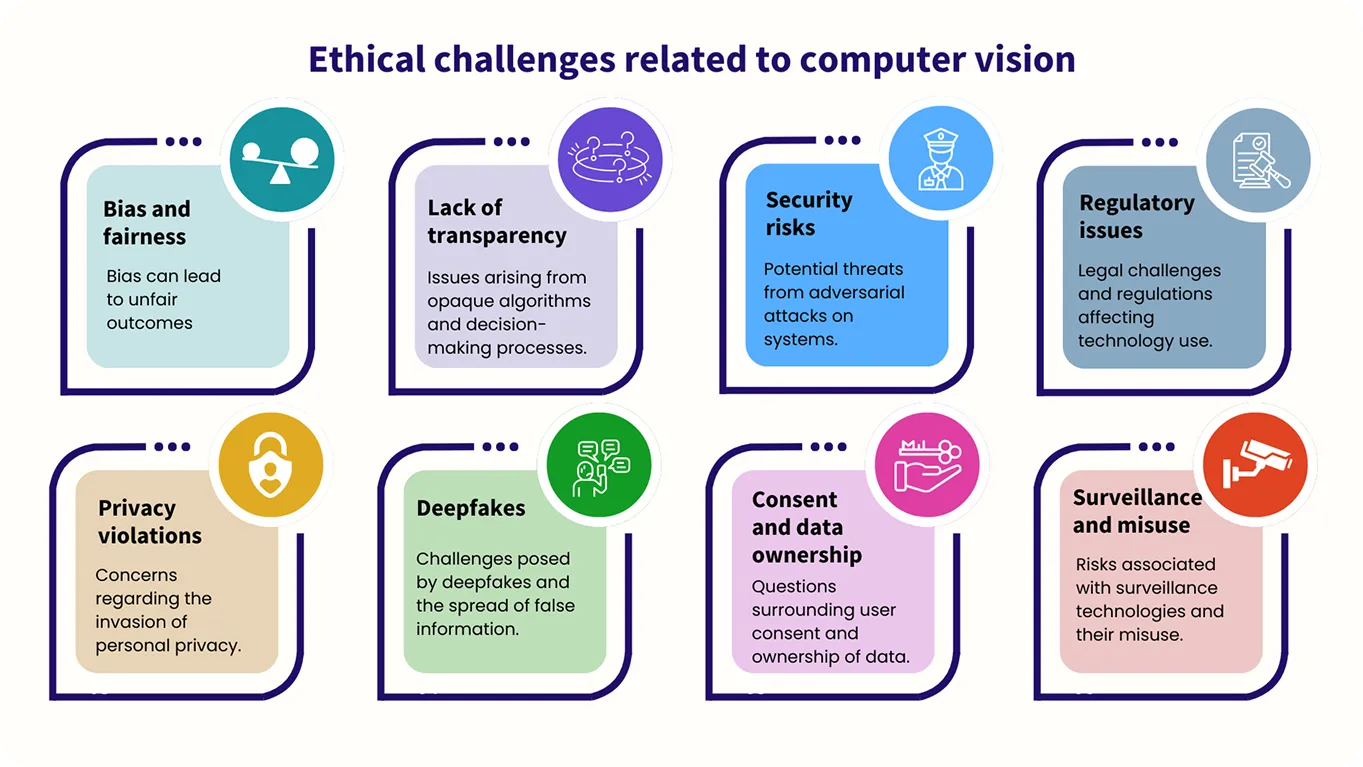

في حين أن نماذج الرؤية الحاسوبية تتعامل مع الصور بدلاً من النصوص، فإن الحاجة إلى التوجيه الأخلاقي لا تقل أهمية. على سبيل المثال، تعد العدالة والتحيز من العوامل الرئيسية التي يجب مراعاتها، حيث يجب تدريب هذه الأنظمة على معاملة الجميع على قدم المساواة وتجنب النتائج الضارة أو غير العادلة عند تحليل البيانات المرئية.

في الوقت الحالي، لا يزال استخدام أساليب الذكاء الاصطناعي الدستوري في الرؤية الحاسوبية قيد الاستكشاف وفي مراحله المبكرة، مع وجود أبحاث جارية في هذا المجال.

على سبيل المثال، قدمت Meta مؤخرًا CLUE، وهو إطار عمل يطبق التفكير الشبيه بالدستور على مهام سلامة الصور. إنه يحول قواعد السلامة العامة إلى خطوات دقيقة يمكن للذكاء الاصطناعي متعدد الوسائط (أنظمة الذكاء الاصطناعي التي تعالج وتفهم أنواعًا متعددة من البيانات) اتباعها. يساعد هذا النظام على التفكير بشكل أكثر وضوحًا وتقليل النتائج الضارة.

أيضًا، تجعل CLUE أحكام سلامة الصور أكثر كفاءة من خلال تبسيط القواعد المعقدة، مما يسمح لنماذج الذكاء الاصطناعي بالتصرف بسرعة وبدقة دون الحاجة إلى إدخال بشري مكثف. باستخدام مجموعة من المبادئ التوجيهية، تجعل CLUE أنظمة الإشراف على الصور أكثر قابلية للتطوير مع ضمان نتائج عالية الجودة.

مع تولي أنظمة الذكاء الاصطناعي المزيد من المسؤولية، يتحول التركيز من مجرد ما يمكنها فعله إلى ما يجب أن تفعله. هذا التحول أساسي لأن هذه الأنظمة تستخدم في مجالات تؤثر بشكل مباشر على حياة الناس، مثل الرعاية الصحية وإنفاذ القانون والتعليم.

لضمان عمل أنظمة الذكاء الاصطناعي بشكل مناسب وأخلاقي، فإنها تحتاج إلى أساس متين وثابت. يجب أن يعطي هذا الأساس الأولوية للعدالة والسلامة والثقة.

يمكن للدستور المكتوب أن يوفر هذا الأساس أثناء التدريب، وتوجيه عملية اتخاذ القرار في النظام. ويمكن أن يمنح المطورين أيضًا إطارًا لمراجعة وتعديل سلوك النظام بعد النشر، مما يضمن استمراره في التوافق مع القيم التي صُمم لدعمها وتسهيل التكيف مع ظهور تحديات جديدة.

انضم إلى مجتمعنا المتنامي اليوم! تعمق في الذكاء الاصطناعي من خلال استكشاف مستودع GitHub الخاص بنا. هل تتطلع إلى بناء مشاريع الرؤية الحاسوبية الخاصة بك؟ استكشف خيارات الترخيص الخاصة بنا. تعرف على كيف تعمل الرؤية الحاسوبية في الرعاية الصحية على تحسين الكفاءة واستكشف تأثير الذكاء الاصطناعي في التصنيع من خلال زيارة صفحات الحلول الخاصة بنا!