اكتشف GPT-4o الجديد من OpenAI، الذي يتميز بالذكاء الاصطناعي المتقدم مع تفاعلات نابضة بالحياة تغير الطريقة التي نتواصل بها مع التكنولوجيا. استكشف ميزاته الرائدة!

اكتشف GPT-4o الجديد من OpenAI، الذي يتميز بالذكاء الاصطناعي المتقدم مع تفاعلات نابضة بالحياة تغير الطريقة التي نتواصل بها مع التكنولوجيا. استكشف ميزاته الرائدة!

في يوم الاثنين الموافق 13 مايو 2024، أعلنت OpenAI عن إطلاق نموذجها الرائد الجديد، GPT-4o، حيث يرمز الحرف 'o' إلى 'omni'. GPT-4o هو نموذج ذكاء اصطناعي متعدد الوسائط متقدم للتفاعلات النصية والصوتية والمرئية في الوقت الفعلي، مما يوفر معالجة أسرع ودعمًا متعدد اللغات وسلامة محسّنة.

إنه يقدم قدرات ذكاء اصطناعي توليدية لم يسبق لها مثيل. بناءً على نقاط قوة المحادثة في ChatGPT تمثل ميزات GPT-4o خطوة كبيرة إلى الأمام في كيفية إدراك الناس للذكاء الاصطناعي. يمكننا الآن التحدث إلى GPT-4o كما لو كان شخصاً حقيقياً. دعنا نتعمق ونرى بالضبط ما يستطيع GPT-4o فعله!

في تحديث الربيع لـ OpenAI، تم الكشف عن أنه في حين أن GPT-4o ذكي تمامًا مثل GPT-4، إلا أنه يمكنه معالجة البيانات بشكل أسرع وهو مجهز بشكل أفضل للتعامل مع النصوص والرؤية والصوت. على عكس الإصدارات السابقة التي ركزت على جعل النماذج أكثر ذكاءً، فقد تم إصدار هذا الإصدار مع الأخذ في الاعتبار الحاجة إلى جعل الذكاء الاصطناعي أسهل في الاستخدام من قبل الجمهور العام.

.png)

تضمّن الوضع الصوتي في ChatGPTالذي تم إصداره أواخر العام الماضي، ثلاثة نماذج مختلفة تتضافر معًا لنسخ المدخلات الصوتية، وفهم الردود المكتوبة وتوليدها، وتحويل النص إلى كلام حتى يتمكن المستخدم من سماع الرد. تعامل هذا الوضع مع مشكلات وقت الاستجابة ولم يكن يبدو طبيعياً جداً. أما GPT-4o فيمكنه معالجة النص والرؤية والصوت دفعة واحدة لإعطاء المستخدم الانطباع بأنه يشارك في محادثة طبيعية.

أيضًا، على عكس الوضع الصوتي، يمكنك الآن مقاطعة GPT-4o أثناء حديثه، وسوف يتفاعل تمامًا كما يفعل الشخص. سيتوقف ويستمع، ثم يقدم استجابته في الوقت الفعلي بناءً على ما قلته. يمكنه أيضًا التعبير عن المشاعر من خلال صوته وفهم نبرتك أيضًا.

يوضح تقييم نموذج GPT-4o مدى تقدمه. كانت إحدى النتائج الأكثر إثارة للاهتمام هي أن GPT-4o يحسن بشكل كبير التعرف على الكلام مقارنة بـ Whisper-v3 في جميع اللغات، وخاصة تلك الأقل استخدامًا.

يقيس أداء التعرف التلقائي على الكلام (ASR) الصوتي مدى دقة تحويل النموذج للغة المنطوقة إلى نص. يتم تتبع أداء GPT-4o بواسطة معدل الخطأ في الكلمات (WER)، والذي يوضح النسبة المئوية للكلمات التي تم نسخها بشكل غير صحيح (معدل WER أقل يعني جودة أفضل). يعرض الرسم البياني أدناه معدل WER الأقل لـ GPT-4o عبر مناطق مختلفة، مما يدل على فعاليته في تحسين التعرف على الكلام للغات الأقل حظًا من حيث الموارد.

.png)

إليك نظرة على بعض الميزات الفريدة الأخرى لـ GPT-4o:

يمكنك الآن سحب GPT-4o على هاتفك وتشغيل الكاميرا ومطالبة GPT-4o، كما تفعل مع صديق، بتخمين حالتك المزاجية بناءً على تعبير وجهك. يمكن لـ GPT-4o رؤيتك من خلال الكاميرا والإجابة.

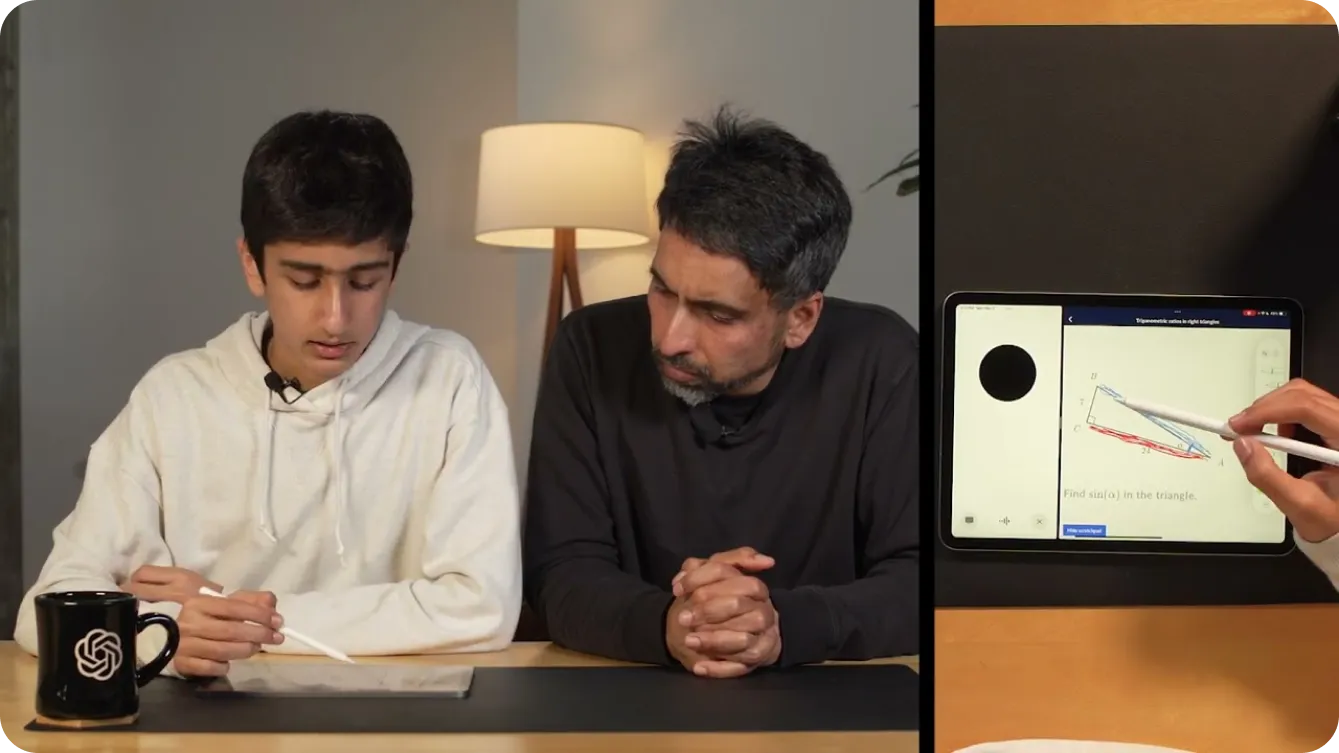

يمكنك حتى استخدامه لمساعدتك في حل مسائل الرياضيات من خلال إظهار GPT-4o ما تكتبه من خلال الفيديو. بدلاً من ذلك، يمكنك مشاركة شاشتك، ويمكن أن يصبح مدرسًا مفيدًا في Khan Academy، ويطلب منك تحديد أجزاء مختلفة من المثلث في الهندسة، كما هو موضح أدناه.

بالإضافة إلى مساعدة الأطفال في الرياضيات، يمكن للمطوّرين إجراء محادثات مع GPT-4o لتصحيح أكوادهم البرمجية. وهذا ممكن بفضل تقديم ChatGPT كتطبيق لسطح المكتب. إذا قمت بتمييز الكود الخاص بك ونسخه باستخدام CTRL "C" أثناء التحدث إلى تطبيق GPT-4o الصوتي لسطح المكتب، فسيكون بإمكانه قراءة الكود الخاص بك. أو يمكنك استخدامه لترجمة المحادثات بين المطورين الذين يتحدثون لغات مختلفة.

تبدو الإمكانيات مع GPt-4o لا حصر لها. أحد العروض التوضيحية الأكثر إثارة للاهتمام من OpenAI استخدمت هاتفين لإظهار GPt-4o يتحدث إلى حالات مختلفة من نفسه ويغني معًا.

كما هو موضح في عرض توضيحي، يمكن لـ GPT-4o أن يجعل العالم أكثر سهولة للأشخاص الذين يعانون من ضعف البصر. يمكن أن يساعدهم على التفاعل والتنقل بأمان واستقلالية أكبر. على سبيل المثال، يمكن للمستخدمين تشغيل الفيديو الخاص بهم وعرض لقطة للشارع على GPT-4o. يمكن لـ GPT-4o بعد ذلك تقديم أوصاف في الوقت الفعلي للبيئة، مثل تحديد العوائق أو قراءة لافتات الشوارع أو توجيههم إلى موقع معين. يمكنه حتى مساعدتهم في استدعاء سيارة أجرة عن طريق تنبيههم عند اقتراب سيارة أجرة.

.png)

وبالمثل، يمكن لـ GPT-4o تحويل مختلف الصناعات بقدراته المتقدمة. في البيع بالتجزئة، يمكنه تحسين خدمة العملاء من خلال توفير المساعدة في الوقت الفعلي والإجابة على الاستفسارات ومساعدة العملاء في العثور على المنتجات عبر الإنترنت وفي المتاجر. لنفترض أنك تنظر إلى رف من المنتجات ولا يمكنك اختيار المنتج الذي تبحث عنه، يمكن لـ GPT-4o مساعدتك.

في الرعاية الصحية، يمكن لـ GPT-4o المساعدة في التشخيص عن طريق تحليل بيانات المريض، واقتراح الحالات المحتملة بناءً على الأعراض، وتقديم إرشادات حول خيارات العلاج. ويمكنه أيضًا دعم المتخصصين الطبيين من خلال تلخيص سجلات المرضى، وتوفير وصول سريع إلى الأدبيات الطبية، وحتى تقديم ترجمة لغوية في الوقت الفعلي للتواصل مع المرضى الذين يتحدثون لغات مختلفة. هذه ليست سوى أمثلة قليلة. تسهل تطبيقات GPT-4o الحياة اليومية من خلال تقديم مساعدة مخصصة ومراعية للسياق وكسر الحواجز أمام المعلومات والاتصالات.

تمامًا مثل الإصدارات السابقة من GPT، التي أثرت على مئات الملايين من الأرواح، من المحتمل أن يتفاعل GPT-4o مع الصوت والفيديو في الوقت الفعلي على مستوى العالم، مما يجعل السلامة عنصرًا حاسمًا في هذه التطبيقات. لقد كانت OpenAI حريصة جدًا على بناء GPT-4o مع التركيز على تخفيف المخاطر المحتملة.

لضمان السلامة والموثوقية، نفذت OpenAI إجراءات سلامة صارمة. وتشمل هذه الإجراءات تصفية بيانات التدريب، وتحسين سلوك النموذج بعد التدريب، ودمج أنظمة سلامة جديدة لإدارة مخرجات الصوت. علاوة على ذلك، تم اختبار GPT-4o على نطاق واسع من قبل أكثر من 70 خبيرًا خارجيًا في مجالات مثل علم النفس الاجتماعي، والتحيز والإنصاف، والمعلومات المضللة. يضمن الاختبار الخارجي تحديد ومعالجة أي مخاطر يتم إدخالها أو تضخيمها بواسطة الميزات الجديدة.

للحفاظ على معايير السلامة العالية، تطلق OpenAI ميزات GPT-4o تدريجيًا على مدار الأسابيع القليلة القادمة. يتيح الطرح المرحلي لـ OpenAI مراقبة الأداء ومعالجة أي مشكلات وجمع ملاحظات المستخدمين. يضمن اتباع نهج حذر أن يقدم GPT-4o قدرات متقدمة مع الحفاظ على أعلى معايير السلامة والاستخدام الأخلاقي.

يتوفر تطبيق GPT-4o مجاناً. لتجربة إمكانيات المحادثة الفورية المذكورة أعلاه، يمكنك تنزيل تطبيقChatGPT من متجر Google Play أو متجر تطبيقات Apple مباشرةً على هاتفك.

بعد تسجيل الدخول، ستتمكن من تحديد GPT-4o من القائمة المعروضة عن طريق النقر على النقاط الثلاث في الزاوية اليمنى العليا من الشاشة. بعد الانتقال إلى محادثة ممكّنة باستخدام GPT-4o، إذا نقرت على علامة الجمع في الزاوية اليسرى السفلية من الشاشة، فسترى خيارات إدخال متعددة. في الزاوية اليمنى السفلية من الشاشة، سترى رمز سماعة الرأس. عند تحديد رمز سماعة الرأس، سيُطلب منك ما إذا كنت ترغب في تجربة نسخة GPT-4o بدون استخدام اليدين. بعد الموافقة، ستتمكن من تجربة GPT-4o، كما هو موضح أدناه.

إذا كنت ترغب في دمج إمكانات GPT-4o المتقدمة في مشاريعك الخاصة، فهو متاح كـ API للمطورين. يتيح لك دمج قدرات GPT-4o القوية في التعرف على الكلام، ودعم اللغات المتعددة، وقدرات المحادثة في الوقت الفعلي في تطبيقاتك. باستخدام API، يمكنك تحسين تجارب المستخدم، وبناء تطبيقات أكثر ذكاءً، وتقديم تكنولوجيا الذكاء الاصطناعي المتطورة إلى قطاعات مختلفة.

في حين أن GPT-4o أكثر تقدماً بكثير من نماذج الذكاء الاصطناعي السابقة، من المهم أن تتذكر أن GPT-4o يأتي مع قيوده الخاصة. فقد ذكر OpenAI أنه يمكنه أحياناً التبديل بين اللغات بشكل عشوائي أثناء التحدث، فينتقل من English إلى الفرنسية. لقد رأوا أيضاً أن GPT-4o يترجم بشكل غير صحيح بين اللغات. مع تجربة المزيد من الأشخاص للنموذج، سنفهم أين يتفوق GPT-4o وما الذي يحتاج إلى مزيد من التحسين.

يفتح GPT-4o من OpenAI أبوابًا جديدة للذكاء الاصطناعي من خلال معالجة النصوص والرؤية والصوت المتقدمة، مما يوفر تفاعلات طبيعية تشبه الإنسان. إنه يتفوق من حيث السرعة والكفاءة من حيث التكلفة ودعم اللغات المتعددة. GPT-4o هو أداة متعددة الاستخدامات للتعليم وإمكانية الوصول والمساعدة في الوقت الفعلي. بينما يستكشف المستخدمون قدرات GPT-4o، ستدفع التعليقات تطوره. يثبت GPT-4o أن الذكاء الاصطناعي يغير عالمنا حقًا ويصبح جزءًا من حياتنا اليومية.

اكتشف مستودع GitHub الخاص بنا وانضم إلى مجتمعنا للتعمق في الذكاء الاصطناعي. قم بزيارة صفحات الحلول الخاصة بنا لترى كيف يُحدث الذكاء الاصطناعي تحولًا في صناعات مثل التصنيع و الزراعة.