Explore el nuevo GPT-4o de OpenAI, que presenta una IA avanzada con interacciones realistas que cambian la forma en que nos comunicamos con la tecnología. ¡Explore sus características innovadoras!

Explore el nuevo GPT-4o de OpenAI, que presenta una IA avanzada con interacciones realistas que cambian la forma en que nos comunicamos con la tecnología. ¡Explore sus características innovadoras!

El lunes 13 de mayo de 2024, OpenAI anunció el lanzamiento de su nuevo modelo insignia, GPT-4o, donde la 'o' significa 'omni'. GPT-4o es un modelo de IA multimodal avanzado para interacciones de texto, audio y visión en tiempo real, que ofrece un procesamiento más rápido, soporte multilingüe y seguridad mejorada.

Pone sobre la mesa capacidades de IA generativa nunca vistas. Las funciones de GPT-4o, que se basan en la capacidad de conversación de ChatGPT, suponen un gran paso adelante en la percepción de la IA. Ahora podemos hablar con GPT-4o como si fuera una persona real. Veamos de qué es capaz GPT-4o.

En la actualización de primavera de OpenAI, se reveló que, si bien GPT-4o es tan inteligente como GPT-4, puede procesar datos más rápido y está mejor equipado para manejar texto, visión y audio. A diferencia de las versiones anteriores que se centraban en hacer que los modelos fueran más inteligentes, esta versión se ha realizado teniendo en cuenta la necesidad de facilitar el uso de la IA por parte del público en general.

.png)

El modo de voz ChatGPT, que se lanzó a finales del año pasado, incluía tres modelos diferentes que se unían para transcribir las entradas vocales, comprender y generar respuestas escritas y convertir el texto en voz para que el usuario pudiera oír una respuesta. Este modo presentaba problemas de latencia y no resultaba muy natural. GPT-4o puede procesar de forma nativa texto, visión y audio de una sola vez para dar al usuario la impresión de estar participando en una conversación natural.

Además, a diferencia del modo de voz, ahora puedes interrumpir a GPT-4o mientras está hablando, y reaccionará como lo haría una persona. Se detendrá y escuchará, y luego dará su respuesta en tiempo real basándose en lo que dijiste. También puede expresar emociones a través de su voz y comprender tu tono.

La evaluación del modelo GPT-4o muestra lo avanzado que es. Uno de los resultados más interesantes encontrados fue que GPT-4o mejora enormemente el reconocimiento de voz en comparación con Whisper-v3 en todos los idiomas, especialmente en aquellos que se usan con menos frecuencia.

El rendimiento de ASR (Reconocimiento Automático del Habla) de audio mide con qué precisión un modelo transcribe el lenguaje hablado en texto. El rendimiento de GPT-4o se rastrea mediante la Tasa de Error de Palabra (WER), que muestra el porcentaje de palabras transcritas incorrectamente (una WER más baja significa una mejor calidad). El siguiente gráfico muestra la WER más baja de GPT-4o en varias regiones, lo que demuestra su eficacia en la mejora del reconocimiento de voz para los idiomas con menos recursos.

.png)

Aquí hay un vistazo a algunas de las características únicas de GPT-4o:

Ahora puedes sacar GPT-4o en tu teléfono, encender tu cámara y pedirle a GPT-4o, como lo harías con un amigo, que adivine tu estado de ánimo basándose en tu expresión facial. GPT-4o puede verte a través de la cámara y responder.

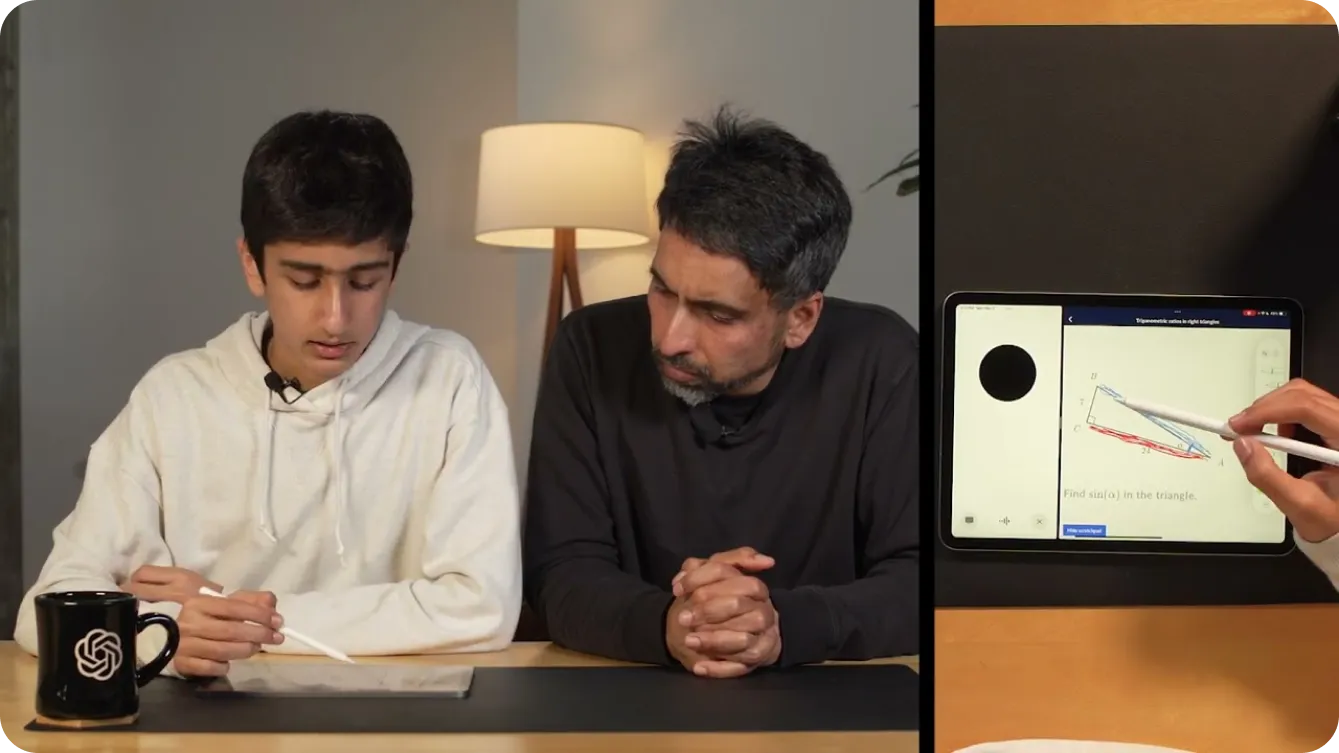

Incluso puedes usarlo para ayudarte a resolver problemas de matemáticas mostrando a GPT-4o lo que estás escribiendo a través de video. Alternativamente, podrías compartir tu pantalla, y puede convertirse en un tutor útil en Khan Academy, pidiéndote que señales diferentes partes de un triángulo en geometría, como se muestra a continuación.

Además de ayudar a los niños con las matemáticas, los desarrolladores pueden mantener conversaciones con GPT-4o para depurar su código. Esto es posible gracias a la introducción de ChatGPT como aplicación de escritorio. Si resaltas y copias tu código utilizando CTRL "C" mientras hablas con la aplicación de voz GPT-4o, ésta podrá leer tu código. También puedes utilizarla para traducir conversaciones entre desarrolladores que hablen distintos idiomas.

Las posibilidades con GPT-4o parecen infinitas. Una de las demostraciones más interesantes de OpenAI utilizó dos teléfonos para mostrar a GPT-4o hablando con diferentes instancias de sí mismo y cantando juntos.

Como se muestra en una demostración, GPT-4o puede hacer que el mundo sea más accesible para las personas con discapacidades visuales. Puede ayudarles a interactuar y moverse de forma más segura e independiente. Por ejemplo, los usuarios pueden encender su video y mostrar a GPT-4o una vista de la calle. GPT-4o puede entonces proporcionar descripciones en tiempo real del entorno, como identificar obstáculos, leer señales de tráfico o guiarlos a una ubicación específica. Incluso puede ayudarles a parar un taxi alertándoles cuando se acerca un taxi.

.png)

De manera similar, GPT-4o puede transformar varias industrias con sus capacidades avanzadas. En el sector minorista, puede mejorar el servicio al cliente proporcionando asistencia en tiempo real, respondiendo preguntas y ayudando a los clientes a encontrar productos tanto en línea como en la tienda. Digamos que estás mirando un estante de productos y no encuentras el producto que buscas, GPT-4o puede ayudarte.

En la atención médica, GPT-4o puede ayudar con los diagnósticos analizando los datos del paciente, sugiriendo posibles afecciones basadas en los síntomas y ofreciendo orientación sobre las opciones de tratamiento. También puede apoyar a los profesionales médicos resumiendo los historiales de los pacientes, proporcionando acceso rápido a la literatura médica e incluso ofreciendo traducción de idiomas en tiempo real para comunicarse con pacientes que hablan diferentes idiomas. Estos son solo un par de ejemplos. Las aplicaciones de GPT-4o facilitan la vida diaria al ofrecer asistencia personalizada y consciente del contexto, y al derribar las barreras a la información y la comunicación.

Al igual que las versiones anteriores de GPT, que han impactado a cientos de millones de vidas, es probable que GPT-4o interactúe con audio y video en tiempo real a nivel mundial, lo que hace que la seguridad sea un elemento crucial en estas aplicaciones. OpenAI ha tenido mucho cuidado en construir GPT-4o con un enfoque en la mitigación de riesgos potenciales.

Para garantizar la seguridad y la fiabilidad, OpenAI ha implementado rigurosas medidas de seguridad. Estas incluyen el filtrado de datos de entrenamiento, el refinamiento del comportamiento del modelo después del entrenamiento y la incorporación de nuevos sistemas de seguridad para la gestión de las salidas de voz. Además, GPT-4o ha sido probado exhaustivamente por más de 70 expertos externos en campos como la psicología social, los sesgos y la equidad, y la desinformación. Las pruebas externas aseguran que cualquier riesgo introducido o amplificado por las nuevas características se identifique y se aborde.

Para mantener altos estándares de seguridad, OpenAI está lanzando las características de GPT-4o gradualmente durante las próximas semanas. Un lanzamiento por fases permite a OpenAI supervisar el rendimiento, abordar cualquier problema y recopilar comentarios de los usuarios. Adoptar un enfoque cuidadoso garantiza que GPT-4o ofrezca capacidades avanzadas manteniendo los más altos estándares de seguridad y uso ético.

GPT-4o es de acceso gratuito. Para probar las capacidades de conversación en tiempo real mencionadas anteriormente, puede descargar la aplicaciónChatGPT desde Google Play Store o Apple App Store directamente en su teléfono.

Después de iniciar sesión, podrás seleccionar GPT-4o de la lista que se muestra tocando los tres puntos en la esquina superior derecha de la pantalla. Después de navegar a un chat habilitado con GPT-4o, si tocas el signo más en la esquina inferior izquierda de la pantalla, verás múltiples opciones de entrada. En la esquina inferior derecha de la pantalla, verás un icono de auriculares. Al seleccionar el icono de los auriculares, se te preguntará si te gustaría experimentar una versión manos libres de GPT-4o. Después de aceptar, podrás probar GPT-4o, como se muestra a continuación.

Si deseas integrar las capacidades avanzadas de GPT-4o en tus propios proyectos, está disponible como una API para desarrolladores. Te permite incorporar el potente reconocimiento de voz, el soporte multilingüe y las capacidades conversacionales en tiempo real de GPT-4o en tus aplicaciones. Mediante el uso de la API, puedes mejorar las experiencias de los usuarios, crear aplicaciones más inteligentes y llevar la tecnología de IA de vanguardia a diferentes sectores.

Aunque GPT-4o es mucho más avanzada que los modelos de IA anteriores, es importante recordar que GPT-4o tiene sus propias limitaciones. OpenAI ha mencionado que a veces puede cambiar aleatoriamente de idioma mientras habla, pasando del English al francés. También han visto cómo GPT-4o traducía incorrectamente entre idiomas. A medida que más gente pruebe el modelo, entenderemos en qué destaca GPT-4o y en qué necesita mejorar.

GPT-4o de OpenAI abre nuevas puertas para la IA con su avanzado procesamiento de texto, visión y audio, ofreciendo interacciones naturales, similares a las humanas. Destaca en términos de velocidad, rentabilidad y soporte multilingüe. GPT-4o es una herramienta versátil para la educación, la accesibilidad y la asistencia en tiempo real. A medida que los usuarios exploren las capacidades de GPT-4o, la retroalimentación impulsará su evolución. GPT-4o demuestra que la IA está cambiando realmente nuestro mundo y se está convirtiendo en parte de nuestra vida diaria.

Explora nuestro repositorio de GitHub y únete a nuestra comunidad para profundizar en la IA. Visita nuestras páginas de soluciones para ver cómo la IA está transformando industrias como la manufactura y la agricultura.