Explore o novo GPT-4o da OpenAI, com IA avançada e interações realistas que mudam a forma como comunicamos com a tecnologia. Explore os seus recursos inovadores!

Explore o novo GPT-4o da OpenAI, com IA avançada e interações realistas que mudam a forma como comunicamos com a tecnologia. Explore os seus recursos inovadores!

Na segunda-feira, 13 de maio de 2024, a OpenAI anunciou o lançamento do seu novo modelo principal, GPT-4o, onde o 'o' significa 'omni'. O GPT-4o é um modelo de IA multimodal avançado para interações de texto, áudio e visão em tempo real, oferecendo processamento mais rápido, suporte multilingue e segurança aprimorada.

Está a trazer para a mesa capacidades de IA generativa nunca antes vistas. Com base nos pontos fortes de conversação do ChatGPT, as funcionalidades do GPT-4o marcam um avanço substancial na forma como as pessoas encaram a IA. Agora podemos falar com o GPT-4o como se fosse uma pessoa real. Vamos mergulhar e ver exatamente do que o GPT-4o é capaz!

Na atualização de primavera da OpenAI, foi revelado que, embora o GPT-4o seja tão inteligente quanto o GPT-4, ele pode processar dados mais rapidamente e está mais bem equipado para lidar com texto, visão e áudio. Ao contrário das versões anteriores que se concentravam em tornar os modelos mais inteligentes, esta versão foi feita tendo em mente a necessidade de tornar a IA mais fácil de usar pelo público em geral.

.png)

O modo de voz do ChatGPT, que foi lançado no final do ano passado, envolvia três modelos diferentes que se juntavam para transcrever entradas vocais, compreender e gerar respostas escritas e converter texto em voz para que o utilizador pudesse ouvir uma resposta. Este modo tinha problemas de latência e não parecia muito natural. O GPT-4o pode processar nativamente texto, visão e áudio de uma só vez para dar ao utilizador a impressão de que está a participar numa conversa natural.

Além disso, ao contrário do modo de voz, agora pode interromper o GPT-4o enquanto ele está a falar, e ele reagirá como uma pessoa reagiria. Ele fará uma pausa e ouvirá, depois dará a sua resposta em tempo real com base no que disse. Ele também pode expressar emoções através da sua voz e entender o seu tom também.

A avaliação do modelo GPT-4o mostra o quão avançado ele é. Um dos resultados mais interessantes encontrados foi que o GPT-4o melhora muito o reconhecimento de fala em comparação com o Whisper-v3 em todos os idiomas, especialmente aqueles que são menos usados.

O desempenho de ASR (Reconhecimento Automático de Fala) de áudio mede a precisão com que um modelo transcreve a linguagem falada em texto. O desempenho do GPT-4o é rastreado pela Taxa de Erro de Palavras (WER), que mostra a percentagem de palavras transcritas incorretamente (WER mais baixo significa melhor qualidade). O gráfico abaixo mostra o WER mais baixo do GPT-4o em várias regiões, demonstrando a sua eficácia na melhoria do reconhecimento de fala para idiomas com menos recursos.

.png)

Aqui está uma visão geral de mais algumas funcionalidades exclusivas do GPT-4o:

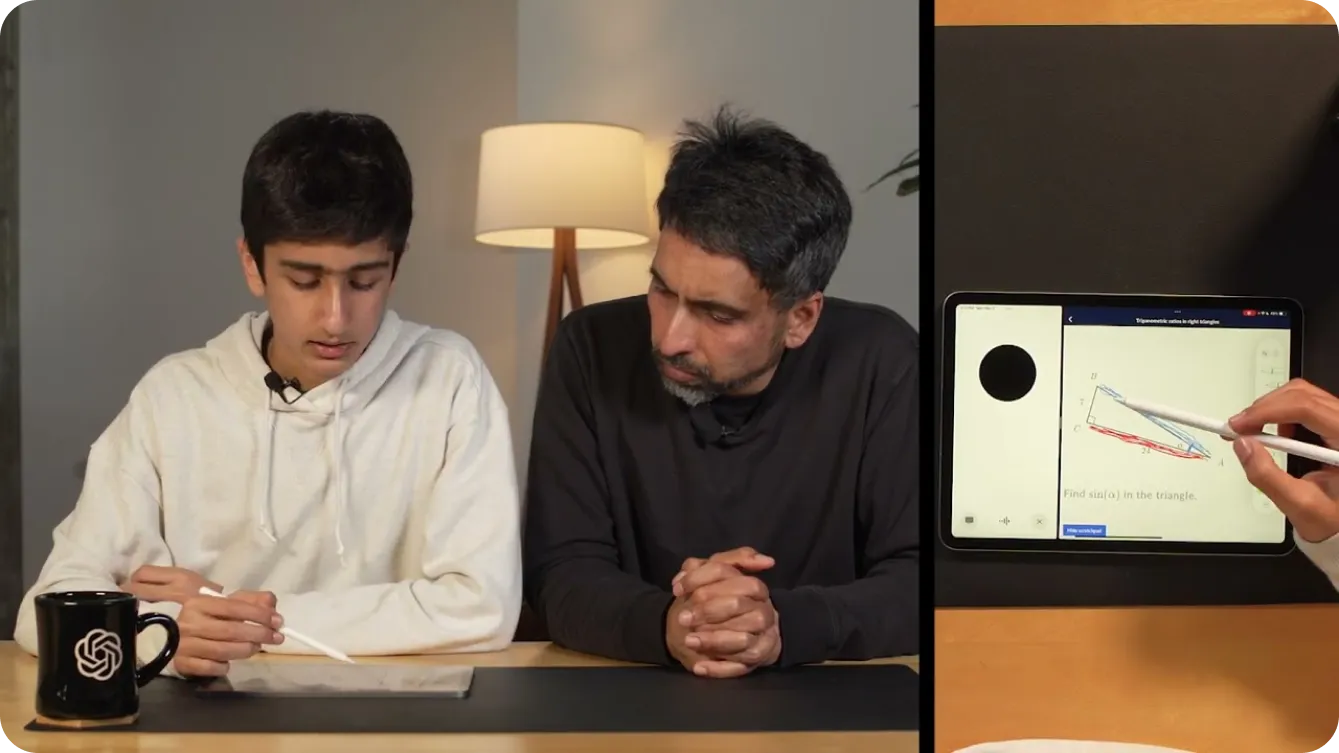

Agora você pode usar o GPT-4o no seu celular, ligar a câmera e pedir ao GPT-4o, como faria com um amigo, para adivinhar seu humor com base na sua expressão facial. O GPT-4o pode ver você através da câmera e responder.

Você pode até usá-lo para ajudar a resolver problemas de matemática, mostrando ao GPT-4o o que você está escrevendo por vídeo. Alternativamente, você pode compartilhar sua tela, e ele pode se tornar um tutor útil na Khan Academy, pedindo que você aponte diferentes partes de um triângulo em geometria, como mostrado abaixo.

Para além de ajudar as crianças com a matemática, os programadores podem ter conversas com o GPT-4o para depurar o seu código. Isto é possível graças à introdução do ChatGPT como uma aplicação de ambiente de trabalho. Se realçar e copiar o seu código utilizando CTRL "C" enquanto fala com a aplicação de voz GPT-4o para ambiente de trabalho, esta será capaz de ler o seu código. Ou pode utilizá-lo para traduzir conversas entre programadores que falam línguas diferentes.

As possibilidades com o GPT-4o parecem infinitas. Uma das demonstrações mais interessantes da OpenAI usou dois telefones para mostrar o GPT-4o conversando com diferentes instâncias de si mesmo e cantando juntos.

Como mostrado em uma demonstração, o GPT-4o pode tornar o mundo mais acessível para pessoas com deficiência visual. Ele pode ajudá-las a interagir e se locomover com mais segurança e independência. Por exemplo, os usuários podem ligar o vídeo e mostrar ao GPT-4o uma visão da rua. O GPT-4o pode então fornecer descrições em tempo real do ambiente, como identificar obstáculos, ler placas de rua ou guiá-los para um local específico. Ele pode até ajudá-los a chamar um táxi, alertando-os quando um táxi estiver se aproximando.

.png)

Da mesma forma, o GPT-4o pode transformar vários setores com suas capacidades avançadas. No varejo, ele pode melhorar o atendimento ao cliente, fornecendo assistência em tempo real, respondendo a perguntas e ajudando os clientes a encontrar produtos tanto online quanto na loja física. Digamos que você esteja olhando para uma prateleira de produtos e não consiga escolher o produto que está procurando, o GPT-4o pode te ajudar.

Na área da saúde, o GPT-4o pode auxiliar no diagnóstico, analisando dados do paciente, sugerindo possíveis condições com base nos sintomas e oferecendo orientação sobre opções de tratamento. Ele também pode apoiar profissionais médicos, resumindo registros de pacientes, fornecendo acesso rápido à literatura médica e até mesmo oferecendo tradução de idiomas em tempo real para se comunicar com pacientes que falam idiomas diferentes. Estes são apenas alguns exemplos. As aplicações do GPT-4o facilitam a vida diária, oferecendo assistência personalizada e contextualizada e quebrando barreiras à informação e à comunicação.

Assim como as versões anteriores do GPT, que impactaram centenas de milhões de vidas, o GPT-4o provavelmente interagirá com áudio e vídeo em tempo real globalmente, tornando a segurança um elemento crucial nessas aplicações. A OpenAI tem sido muito cuidadosa ao construir o GPT-4o com foco na mitigação de riscos potenciais.

Para garantir a segurança e a confiabilidade, a OpenAI implementou medidas de segurança rigorosas. Estas incluem a filtragem de dados de treinamento, o refinamento do comportamento do modelo após o treinamento e a incorporação de novos sistemas de segurança para gerenciar as saídas de voz. Além disso, o GPT-4o foi extensivamente testado por mais de 70 especialistas externos em áreas como psicologia social, viés e justiça e desinformação. Os testes externos garantem que quaisquer riscos introduzidos ou amplificados pelas novas funcionalidades sejam identificados e abordados.

Para manter altos padrões de segurança, a OpenAI está lançando as funcionalidades do GPT-4o gradualmente ao longo das próximas semanas. Uma implementação faseada permite que a OpenAI monitore o desempenho, resolva quaisquer problemas e colete feedback dos usuários. Adotar uma abordagem cuidadosa garante que o GPT-4o ofereça capacidades avançadas, mantendo os mais altos padrões de segurança e uso ético.

O GPT-4o está disponível para acesso gratuito. Para experimentar as capacidades de conversação em tempo real mencionadas acima, pode descarregar a aplicaçãoChatGPT da Google Play Store ou da Apple App Store diretamente para o seu telemóvel.

Após fazer login, você poderá selecionar o GPT-4o na lista exibida tocando nos três pontos no canto superior direito da tela. Depois de navegar para um chat habilitado com o GPT-4o, se você tocar no sinal de mais no canto inferior esquerdo da tela, verá várias opções de entrada. No canto inferior direito da tela, você verá um ícone de fone de ouvido. Ao selecionar o ícone de fone de ouvido, você será perguntado se gostaria de experimentar uma versão mãos-livres do GPT-4o. Depois de concordar, você poderá experimentar o GPT-4o, como mostrado abaixo.

Se você deseja integrar os recursos avançados do GPT-4o em seus próprios projetos, ele está disponível como uma API para desenvolvedores. Isso permite incorporar o poderoso reconhecimento de fala, o suporte multilíngue e os recursos de conversação em tempo real do GPT-4o em seus aplicativos. Ao usar a API, você pode aprimorar as experiências do usuário, criar aplicativos mais inteligentes e levar tecnologia de IA de ponta para diferentes setores.

Embora o GPT-4o seja muito mais avançado do que os modelos anteriores de IA, é importante lembrar que o GPT-4o tem as suas próprias limitações. A OpenAI mencionou que, por vezes, pode mudar aleatoriamente de língua enquanto fala, passando do English para o francês. Também já viram o GPT-4o traduzir incorretamente entre línguas. À medida que mais pessoas experimentarem o modelo, perceberemos em que é que o GPT-4o se destaca e em que é que precisa de ser melhorado.

O GPT-4o da OpenAI abre novas portas para a IA com seu processamento avançado de texto, visão e áudio, oferecendo interações naturais e semelhantes às humanas. Ele se destaca em termos de velocidade, custo-eficiência e suporte multilíngue. O GPT-4o é uma ferramenta versátil para educação, acessibilidade e assistência em tempo real. À medida que os usuários exploram os recursos do GPT-4o, o feedback impulsionará sua evolução. O GPT-4o prova que a IA está realmente mudando nosso mundo e se tornando parte de nossas vidas diárias.

Explore nosso repositório no GitHub e junte-se à nossa comunidade para mergulhar mais fundo na IA. Visite nossas páginas de soluções para ver como a IA está transformando setores como manufatura e agricultura.