Explorar SAM 3: o novo modelo Segment Anything da Meta AI

Descubra como SAM 3, o novo modelo Segment Anything Model da Meta AI, facilita a detect, segment e track objectos em imagens e vídeos do mundo real.

Descubra como SAM 3, o novo modelo Segment Anything Model da Meta AI, facilita a detect, segment e track objectos em imagens e vídeos do mundo real.

Em 19 de novembro de 2025, a Meta AI lançou o Segment Anything Model 3, também conhecido como SAM 3. Esta versão mais recente do Segment Anything Model apresenta novas formas de detect, segment e track objectos em imagens e vídeos do mundo real, utilizando avisos de texto, avisos visuais e exemplos de imagens.

O modelo SAM 3 baseia-se em SAM e SAM 2 e traz novos avanços e funcionalidades como a segmentação de conceitos, a deteção de vocabulário aberto e o seguimento de vídeo em tempo real. Consegue compreender sintagmas nominais curtos, seguir objectos através de fotogramas e identificar conceitos finos ou raros que os modelos anteriores não conseguiam tratar de forma tão consistente.

Como parte da versão SAM 3, a Meta também introduziu SAM 3D. Este conjunto de modelos da próxima geração reconstrói objectos, cenas e corpos humanos completos a partir de uma única imagem e expande o ecossistema Segment Anything para a compreensão 3D. Estas adições abrem novas aplicações em visão computacional, robótica, edição multimédia e fluxos de trabalho criativos.

Neste artigo, vamos explorar o que é o SAM 3, o que o distingue do SAM 2, como funciona o modelo e as suas aplicações no mundo real. Vamos começar!

SAM 3 é um modelo de visão por computador topo de gama que consegue identificar, separar e track objectos em imagens e vídeos com base em instruções simples. Em vez de se basear numa lista fixa de etiquetas, SAM 3 compreende a linguagem natural e as sugestões visuais, tornando mais fácil dizer ao modelo o que pretende encontrar.

Por exemplo, com o SAM 3, pode escrever uma frase curta como "autocarro escolar amarelo" ou "um gato às riscas", clicar num objeto ou realçar um exemplo numa imagem. O modelo irá então detect todos os objectos correspondentes e gerar máscaras de segmentação limpas (um contorno visual que mostra exatamente quais os pixels que pertencem a um objeto). SAM 3 também pode seguir esses objectos através de fotogramas de vídeo, mantendo-os consistentes à medida que se movem.

Outra parte interessante do anúncio da Meta AI é o SAM 3D, que alarga o projeto Segment Anything à compreensão 3D. SAM 3D pode pegar numa única imagem 2D e reconstruir a forma, a pose ou a estrutura de um objeto ou de um corpo humano em três dimensões. Por outras palavras, o modelo pode estimar a forma como algo ocupa o espaço, mesmo quando só está disponível um ponto de vista.

SAM 3D foi lançado como dois modelos diferentes: SAM 3D Objects, que reconstrói objectos do quotidiano com geometria e textura, e SAM 3D Body, que estima a forma e a pose do corpo humano a partir de uma única imagem. Ambos os modelos utilizam o resultado da segmentação do SAM 3 e geram uma representação 3D que se alinha com a aparência e a posição do objeto na fotografia original.

Eis algumas das principais actualizações que SAM 3 introduz para reunir a deteção, a segmentação e o seguimento num modelo unificado:

Digamos que está a ver um vídeo de um safari com muitos animais diferentes e quer detect e segment apenas os elefantes. Como seria esta tarefa nas diferentes versões do SAM?

Com o SAM, teria de clicar manualmente em cada elefante em cada fotograma para gerar uma máscara de segmentação. Não existe rastreio, pelo que cada novo fotograma requer novos cliques.

Com o SAM 2, podia clicar uma vez num elefante, obter a sua máscara e o modelo track esse mesmo elefante ao longo do vídeo. No entanto, continuaria a ser necessário dar cliques separados se quisesse segment vários elefantes (objectos específicos), uma vez que SAM 2 não compreende categorias como "elefante" por si só.

Com o SAM 3, o fluxo de trabalho torna-se muito mais simples. Pode escrever "elefante" ou desenhar uma caixa delimitadora à volta de um único elefante para dar um exemplo, e o modelo irá encontrar automaticamente todos os elefantes no vídeo, segment e track de forma consistente ao longo dos fotogramas. Continua a suportar os avisos de clique e caixa utilizados nas versões anteriores, mas agora também pode responder a avisos de texto e imagens de exemplo, algo que SAM e SAM 2 não conseguiam fazer.

De seguida, vamos analisar mais detalhadamente o funcionamento do modelo SAM 3 e a forma como foi treinado.

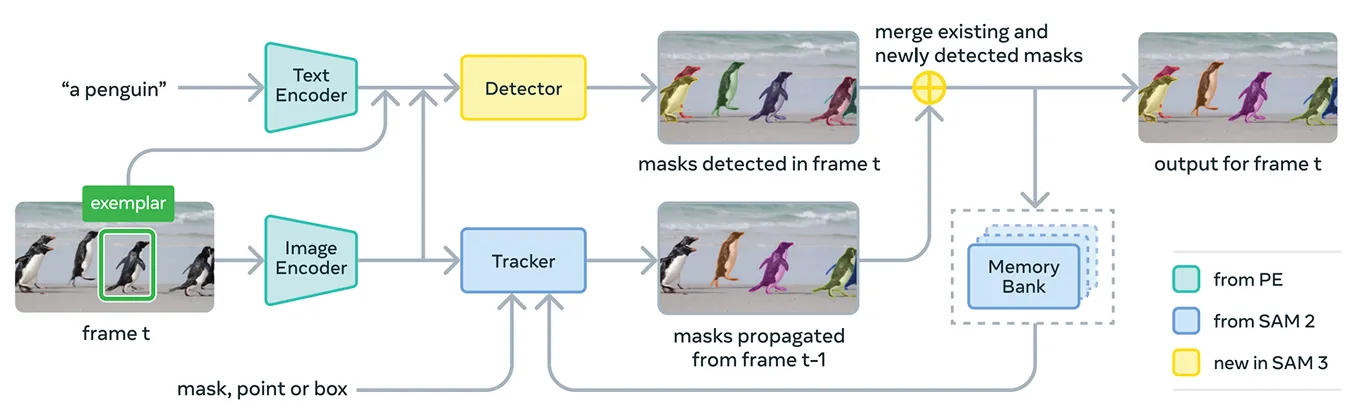

SAM 3 reúne vários componentes para suportar avisos conceptuais e avisos visuais num único sistema. No seu núcleo, o modelo utiliza o codificador de perceção Meta, que é o codificador unificado de texto-imagem de código aberto da Meta.

Este codificador pode processar tanto imagens como frases curtas de substantivos. Em termos simples, isto permite ao SAM 3 associar as caraterísticas linguísticas e visuais de forma mais eficaz do que as versões anteriores do Segment Anything Model.

Para além deste codificador, SAM 3 inclui um detetor que se baseia na família DETR de modelos de transformadores. Este detetor identifica os objectos na imagem e ajuda o sistema a determinar quais os objectos que correspondem ao pedido do utilizador.

Especificamente, para a segmentação de vídeo, SAM 3 utiliza um componente de seguimento que se baseia no banco de memória e no codificador de memória do SAM 2. Isto permite que o modelo retenha informações sobre objectos ao longo dos fotogramas para que possa voltar a identificá-los e track ao longo do tempo.

Para treinar o SAM 3, o Meta precisava de muito mais dados anotados do que os que existem atualmente na Internet. As máscaras de segmentação de alta qualidade e as etiquetas de texto são difíceis de criar em grande escala, e delinear completamente cada instância de um conceito em imagens e vídeos é lento e dispendioso.

Para resolver este problema, a Meta criou um novo motor de dados que combina SAM próprio SAM 3, modelos de IA adicionais e anotadores humanos a trabalhar em conjunto. O fluxo de trabalho começa com um conjunto de sistemas de IA, incluindo SAM 3 e um modelo de legendagem baseado em Llama.

Estes sistemas analisam grandes colecções de imagens e vídeos, geram legendas, convertem essas legendas em etiquetas de texto e produzem candidatos a máscaras de segmentação precoce. Os anotadores humanos e de IA analisam depois estes candidatos.

Os anotadores de IA, treinados para igualar ou mesmo ultrapassar a precisão humana em tarefas como a verificação da qualidade da máscara e a verificação da cobertura de conceitos, filtram os casos simples. Os humanos intervêm apenas nos exemplos mais difíceis, em que o modelo pode ainda ter dificuldades.

Esta abordagem dá ao Meta um grande impulso na velocidade de anotação. Ao permitir que os anotadores de IA tratem de casos fáceis, o pipeline torna-se cerca de cinco vezes mais rápido em pedidos negativos e 36% mais rápido em pedidos positivos em domínios de granularidade fina.

Esta eficiência tornou possível escalar o conjunto de dados para mais de quatro milhões de conceitos únicos. O ciclo constante de propostas de IA, correcções humanas e previsões de modelos actualizados também melhora a qualidade das etiquetas ao longo do tempo e ajuda SAM 3 a aprender um conjunto muito mais vasto de conceitos visuais e baseados em texto.

No que respeita ao desempenho, SAM 3 apresenta uma clara melhoria em relação aos modelos anteriores. No novo benchmark SA-Co da Meta, que avalia a deteção e segmentação de conceitos de vocabulário aberto, SAM 3 atinge aproximadamente o dobro do desempenho dos sistemas anteriores, tanto em imagens como em vídeo.

Também iguala ou excede o SAM 2 em tarefas visuais interactivas, como apontar para a máscara e máscara para máscara. O Meta relata ganhos adicionais em avaliações mais difíceis, como o LVIS de disparo zero (em que os modelos têm de reconhecer categorias raras sem exemplos de treino) e a contagem de objectos (que mede se todas as instâncias de um objeto são detectadas), destacando uma maior generalização entre domínios.

Para além destas melhorias na precisão, SAM 3 é eficiente, processando uma imagem com mais de 100 objectos detectados em cerca de 30 milissegundos numa GPU H200 e mantendo velocidades próximas do tempo real quando rastreia vários objectos em vídeo.

Agora que temos uma melhor compreensão do SAM 3, vamos ver como está a ser utilizado em aplicações reais, desde o raciocínio avançado guiado por texto até à investigação científica e aos próprios produtos da Meta.

SAM 3 também pode ser utilizado como uma ferramenta dentro de um modelo de linguagem multimodal maior, a que o Meta chama Agente SAM 3. Em vez de dar ao SAM 3 uma frase curta como "elefante", o agente pode dividir uma pergunta mais complicada em pedidos mais pequenos que SAM 3 compreenda.

Por exemplo, se o utilizador perguntar: "Que objeto na imagem é utilizado para controlar e guiar um cavalo?", o agente experimenta diferentes frases nominais, envia-as para o SAM 3 e verifica quais as máscaras que fazem sentido. Continua a aperfeiçoar até encontrar o objeto certo.

Mesmo sem ter sido treinado em conjuntos de dados especiais de raciocínio, o agente SAM 3 tem um bom desempenho em testes de referência concebidos para consultas de texto complexas, como o ReasonSeg e o OmniLabel. Isto mostra que SAM 3 pode suportar sistemas que necessitem tanto de compreensão linguística como de segmentação visual fina.

Curiosamente, SAM 3 já está a ser utilizado em ambientes de investigação onde as etiquetas visuais detalhadas são importantes. A Meta trabalhou com a Conservation X Labs e a Osa Conservation para criar o SA-FARI, um conjunto de dados público de monitorização da vida selvagem com mais de 10.000 vídeos de armadilhas fotográficas.

Cada animal em cada fotograma é etiquetado com caixas e máscaras de segmentação, algo que seria extremamente moroso anotar à mão. Do mesmo modo, na investigação oceânica, SAM 3 está a ser utilizado em conjunto com o FathomNet e o MBARI para criar máscaras de segmentação de instâncias para imagens subaquáticas e apoiar novos parâmetros de avaliação.

Estes conjuntos de dados ajudam os cientistas a analisar as imagens de vídeo de forma mais eficiente e a estudar animais e habitats que são normalmente difíceis de track à escala. Os investigadores podem também utilizar estes recursos para criar os seus próprios modelos de identificação de espécies, análise de comportamentos e monitorização ecológica automatizada.

Para além das suas utilizações de investigação, SAM 3 está também a potenciar novas funcionalidades e casos de utilização nos produtos de consumo da Meta. Aqui está um vislumbre de algumas das formas como já está a ser integrado:

SAM 3 é um passo em frente entusiasmante para a segmentação. Introduz a segmentação de conceitos, pedidos de texto de vocabulário aberto e rastreio melhorado. Com um desempenho visivelmente mais forte em imagens e vídeos, e com a adição do SAM 3D, o conjunto de modelos abre novas possibilidades para a IA de visão, ferramentas criativas, investigação científica e produtos do mundo real.

Junte-se à nossa comunidade e explore o nosso repositório GitHub para descobrir mais sobre IA. Se pretende criar o seu próprio projeto de IA de visão, consulte as nossas opções de licenciamento. Explore mais sobre aplicações como a IA nos cuidados de saúde e a IA de visão no retalho visitando as nossas páginas de soluções.