Explorez le nouveau GPT-4o d’OpenAI, doté d’une IA avancée avec des interactions réalistes qui changent notre façon de communiquer avec la technologie. Découvrez ses fonctionnalités révolutionnaires !

Explorez le nouveau GPT-4o d’OpenAI, doté d’une IA avancée avec des interactions réalistes qui changent notre façon de communiquer avec la technologie. Découvrez ses fonctionnalités révolutionnaires !

Le lundi 13 mai 2024, OpenAI a annoncé le lancement de son nouveau modèle phare, GPT-4o, où le « o » signifie « omni ». GPT-4o est un modèle d’IA multimodale avancé pour les interactions en temps réel avec du texte, de l’audio et de la vision, offrant un traitement plus rapide, une prise en charge multilingue et une sécurité améliorée.

Il apporte des capacités d'IA générative jamais vues auparavant. S'appuyant sur les atouts de ChatGPT en matière de conversation, les fonctionnalités de GPT-4o marquent une étape importante dans la manière dont les gens perçoivent l'IA. Nous pouvons désormais parler à GPT-4o comme s'il s'agissait d'une personne réelle. Plongeons dans le vif du sujet et voyons exactement ce dont GPT-4o est capable !

Lors de la mise à jour de printemps d’OpenAI, il a été révélé que bien que GPT-4o soit tout aussi intelligent que GPT-4, il peut traiter les données plus rapidement et est mieux équipé pour gérer le texte, la vision et l’audio. Contrairement aux versions antérieures qui se concentraient sur le fait de rendre les modèles plus intelligents, cette version a été conçue en gardant à l’esprit la nécessité de rendre l’IA plus facile à utiliser par le grand public.

.png)

Le mode vocal de ChatGPT, sorti à la fin de l'année dernière, faisait appel à trois modèles différents pour transcrire les entrées vocales, comprendre et générer des réponses écrites, et convertir le texte en parole afin que l'utilisateur puisse entendre une réponse. Ce mode était confronté à des problèmes de latence et ne donnait pas l'impression d'être très naturel. La GPT-4o peut traiter nativement le texte, la vision et l'audio en une seule fois pour donner à l'utilisateur l'impression qu'il participe à une conversation naturelle.

De plus, contrairement au mode vocal, vous pouvez désormais interrompre GPT-4o pendant qu’il parle, et il réagira comme le ferait une personne. Il fera une pause et écoutera, puis donnera sa réponse en temps réel en fonction de ce que vous avez dit. Il peut également exprimer des émotions par sa voix et comprendre également votre ton.

L’évaluation du modèle de GPT-4o montre à quel point il est avancé. L’un des résultats les plus intéressants a été que GPT-4o améliore considérablement la reconnaissance vocale par rapport à Whisper-v3 dans toutes les langues, en particulier celles qui sont moins couramment utilisées.

Les performances ASR (reconnaissance vocale automatique) audio mesurent la précision avec laquelle un modèle transcrit la langue parlée en texte. Les performances de GPT-4o sont suivies par le taux d’erreur de mots (WER), qui indique le pourcentage de mots incorrectement transcrits (un WER inférieur signifie une meilleure qualité). Le graphique ci-dessous présente le WER inférieur de GPT-4o dans diverses régions, ce qui démontre son efficacité à améliorer la reconnaissance vocale pour les langues moins dotées.

.png)

Voici un aperçu de certaines des fonctionnalités uniques de GPT-4o :

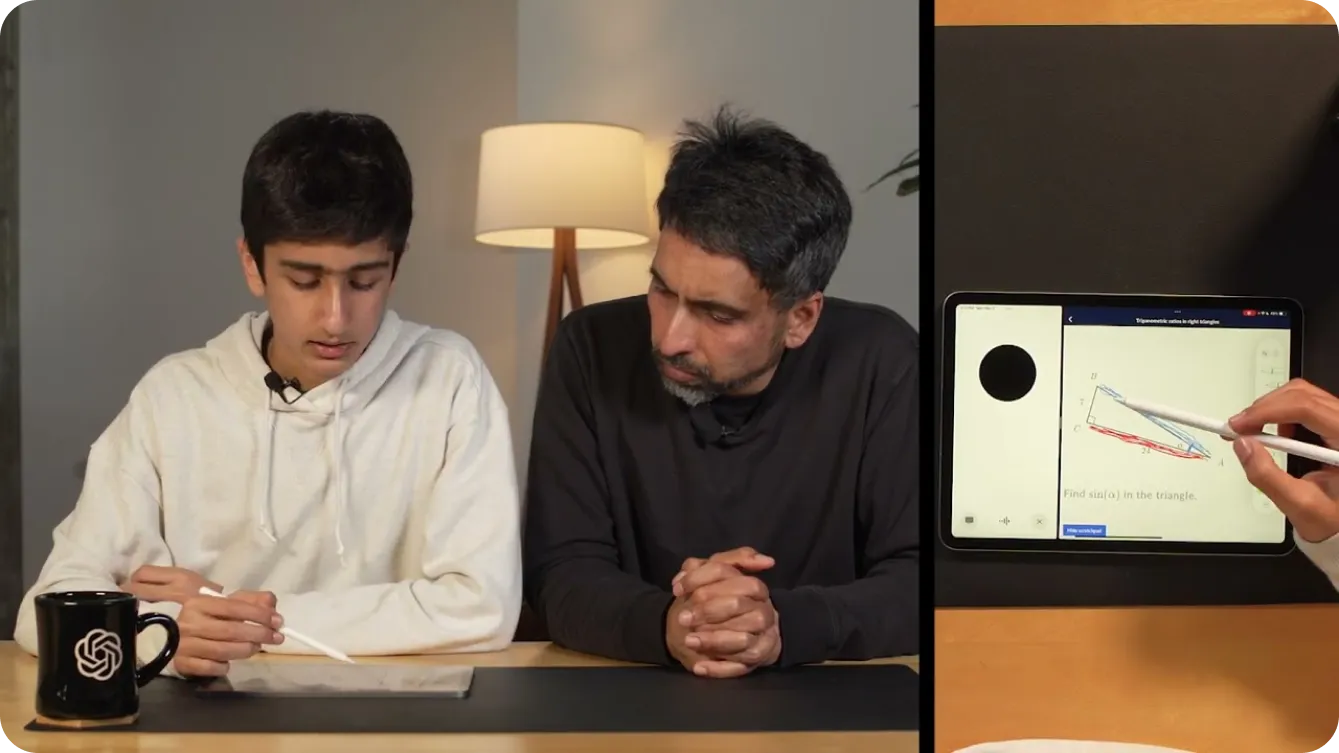

Vous pouvez désormais utiliser GPT-4o sur votre téléphone, activer votre caméra et demander à GPT-4o, comme vous le feriez à un ami, de deviner votre humeur en fonction de votre expression faciale. GPT-4o peut vous voir à travers la caméra et répondre.

Vous pouvez même l'utiliser pour vous aider à résoudre des problèmes de mathématiques en montrant à GPT-4o ce que vous écrivez en vidéo. Vous pouvez également partager votre écran, et il peut devenir un tuteur utile sur Khan Academy, vous demandant de désigner différentes parties d'un triangle en géométrie, comme illustré ci-dessous.

En plus d'aider les enfants en mathématiques, les développeurs peuvent discuter avec GPT-4o pour déboguer leur code. Cela est possible grâce à l'introduction de ChatGPT en tant qu'application de bureau. Si vous mettez votre code en surbrillance et le copiez en utilisant la touche CTRL "C" tout en parlant à l'application vocale GPT-4o, celle-ci sera capable de lire votre code. Vous pouvez également l'utiliser pour traduire des conversations entre développeurs parlant des langues différentes.

Les possibilités avec GPT-4o semblent infinies. L'une des démonstrations les plus intéressantes d'OpenAI a utilisé deux téléphones pour montrer GPT-4o parlant à différentes instances de lui-même et chantant ensemble.

Comme le montre une démonstration, GPT-4o peut rendre le monde plus accessible aux personnes malvoyantes. Il peut les aider à interagir et à se déplacer plus sûrement et de manière plus autonome. Par exemple, les utilisateurs peuvent activer leur vidéo et montrer à GPT-4o une vue de la rue. GPT-4o peut alors fournir des descriptions en temps réel de l'environnement, telles que l'identification des obstacles, la lecture des panneaux de signalisation ou leur guidage vers un emplacement spécifique. Il peut même les aider à héler un taxi en les alertant de l'approche d'un taxi.

.png)

De même, GPT-4o peut transformer divers secteurs grâce à ses capacités avancées. Dans le commerce de détail, il peut améliorer le service client en fournissant une assistance en temps réel, en répondant aux questions et en aidant les clients à trouver des produits en ligne et en magasin. Disons que vous regardez une étagère de produits et que vous ne trouvez pas le produit que vous recherchez, GPT-4o peut vous aider.

Dans le secteur de la santé, GPT-4o peut aider au diagnostic en analysant les données des patients, en suggérant des affections possibles en fonction des symptômes et en offrant des conseils sur les options de traitement. Il peut également aider les professionnels de la santé en résumant les dossiers des patients, en fournissant un accès rapide à la littérature médicale et même en offrant une traduction linguistique en temps réel pour communiquer avec les patients qui parlent différentes langues. Ce ne sont là que quelques exemples. Les applications de GPT-4o facilitent la vie quotidienne en offrant une assistance personnalisée et contextuelle et en supprimant les obstacles à l'information et à la communication.

Tout comme les versions précédentes de GPT, qui ont eu un impact sur des centaines de millions de vies, GPT-4o interagira probablement avec l'audio et la vidéo en temps réel à l'échelle mondiale, ce qui fait de la sécurité un élément crucial dans ces applications. OpenAI a été très attentif à construire GPT-4o en mettant l'accent sur l'atténuation des risques potentiels.

Pour garantir la sécurité et la fiabilité, OpenAI a mis en œuvre des mesures de sécurité rigoureuses. Celles-ci comprennent le filtrage des données d'entraînement, l'affinage du comportement du modèle après l'entraînement et l'intégration de nouveaux systèmes de sécurité pour la gestion des sorties vocales. De plus, GPT-4o a été largement testé par plus de 70 experts externes dans des domaines tels que la psychologie sociale, les biais et l'équité, et la désinformation. Les tests externes permettent de s'assurer que tous les risques introduits ou amplifiés par les nouvelles fonctionnalités sont identifiés et traités.

Afin de maintenir des normes de sécurité élevées, OpenAI déploie les fonctionnalités de GPT-4o progressivement au cours des prochaines semaines. Un déploiement progressif permet à OpenAI de surveiller les performances, de résoudre les problèmes et de recueillir les commentaires des utilisateurs. Cette approche prudente garantit que GPT-4o offre des capacités avancées tout en maintenant les normes les plus élevées en matière de sécurité et d'utilisation éthique.

GPT-4o est disponible en accès gratuit. Pour tester les capacités de conversation en temps réel mentionnées ci-dessus, vous pouvez télécharger l'applicationChatGPT depuis le Google Play Store ou l'Apple App Store directement sur votre téléphone.

Après vous être connecté, vous pourrez sélectionner GPT-4o dans la liste affichée en appuyant sur les trois points dans le coin supérieur droit de l'écran. Après avoir accédé à une conversation activée avec GPT-4o, si vous appuyez sur le signe plus dans le coin inférieur gauche de l'écran, vous verrez plusieurs options de saisie. Dans le coin inférieur droit de l'écran, vous verrez une icône de casque. En sélectionnant l'icône du casque, il vous sera demandé si vous souhaitez essayer une version mains libres de GPT-4o. Après avoir accepté, vous pourrez essayer GPT-4o, comme indiqué ci-dessous.

Si vous souhaitez intégrer les capacités avancées de GPT-4o dans vos propres projets, il est disponible en tant qu'API pour les développeurs. Il vous permet d'intégrer la puissante reconnaissance vocale, la prise en charge multilingue et les capacités conversationnelles en temps réel de GPT-4o dans vos applications. En utilisant l'API, vous pouvez améliorer l'expérience utilisateur, créer des applications plus intelligentes et apporter une technologie d'IA de pointe à différents secteurs.

Bien que GPT-4o soit beaucoup plus avancé que les modèles d'IA précédents, il est important de se rappeler que GPT-4o a ses propres limites. OpenAI a indiqué qu'il pouvait parfois changer de langue de manière aléatoire pendant qu'il parlait, passant de l'English au français. Elle a également constaté que GPT-4o ne traduisait pas correctement d'une langue à l'autre. Au fur et à mesure que d'autres personnes essaieront le modèle, nous comprendrons où GPT-4o excelle et ce qu'il doit encore améliorer.

GPT-4o d'OpenAI ouvre de nouvelles perspectives à l'IA grâce à son traitement avancé du texte, de la vision et de l'audio, offrant des interactions naturelles, semblables à celles des humains. Il excelle en termes de rapidité, de rentabilité et de prise en charge multilingue. GPT-4o est un outil polyvalent pour l'éducation, l'accessibilité et l'assistance en temps réel. Au fur et à mesure que les utilisateurs exploreront les capacités de GPT-4o, leurs commentaires stimuleront son évolution. GPT-4o prouve que l'IA est en train de changer notre monde et de faire partie de notre vie quotidienne.

Explorez notre dépôt GitHub et rejoignez notre communauté pour approfondir vos connaissances sur l'IA. Visitez nos pages de solutions pour découvrir comment l'IA transforme des secteurs tels que la fabrication et l'agriculture.