استرجع اللحظات الرئيسية من YOLO Vision 2025 Shenzhen، حيث جمعت Ultralytics المبتكرين والشركاء ومجتمع الذكاء الاصطناعي ليوم من الإلهام.

استرجع اللحظات الرئيسية من YOLO Vision 2025 Shenzhen، حيث جمعت Ultralytics المبتكرين والشركاء ومجتمع الذكاء الاصطناعي ليوم من الإلهام.

في 26 أكتوبر، عُقد YOLO Vision 2025 (YV25) لأول مرة في الصين في المبنى B10 في حديقة الثقافة الإبداعية OCT في شينزين. جمعت فعالية الرؤية الهجينة للذكاء الاصطناعي التي نظمتها Ultralyticsأكثر من 200 مشارك شخصيًا، وانضم إليهم الكثيرون عبر الإنترنت عبر YouTube وBilibili.

لقد تجاوز البث المباشر لفعالية YV25 Shenzhen 3,500 مشاهدة على YouTube، ولا يزال يحظى بالاهتمام مع مشاركة أبرز أحداث الفعالية عبر المجتمع. لقد كان يوماً مليئاً بالأفكار والمحادثات والاستكشاف العملي للمكان الذي يتجه إليه الذكاء الاصطناعي فيجن.

بدأ اليوم بترحيب حار من مضيفتنا، هوانغ شوي يينغ، التي دعت الجميع للتواصل والتعلم والمشاركة في المناقشات خلال الحدث. وأوضحت أن هذه هي النسخة الثانية من مؤتمر YOLO Vision لهذا العام، بعد نسخة لندن في سبتمبر، وشاركت كم كان من المثير جمع مجتمع Vision AI معًا مرة أخرى هنا في شنتشن.

في هذا المقال، سنستعرض في هذا المقال أبرز ما حدث في هذا اليوم، بما في ذلك تحديثات النماذج، وجلسات المتحدثين، والعروض التوضيحية الحية، واللحظات المجتمعية التي جمعت الجميع. لنبدأ!

كانت الكلمة الرئيسية الأولى لهذا اليوم بقيادة المؤسس والرئيس التنفيذي Ultralytics جلين جوتشر، الذي شارك كيف تطورت نماذجYOLO من نماذجUltralytics YOLO من إنجاز بحثي إلى بعض نماذج الذكاء الاصطناعي البصري الأكثر استخدامًا على نطاق واسع في العالم. أوضح جلين أن عمله المبكر ركز على جعل YOLO أسهل استخداماً.

قام بنقل النماذج إلى PyTorch وحسّن التوثيق، وشارك كل شيء بشكل مفتوح حتى يتمكن المطورون في كل مكان من البناء عليها. وكما يتذكر، "لقد قفزت في عام 2018. وقررت أن هذا هو مستقبلي." ما بدأ كجهد شخصي سرعان ما أصبح حركة عالمية مفتوحة المصدر.

واليوم، تعمل نماذج Ultralytics YOLO على تشغيل مليارات الاستنتاجات كل يوم، وأكد جلين أن هذا الحجم لم يكن ممكنًا إلا بفضل الأشخاص الذين ساعدوا في بنائه. فقد قام باحثون ومهندسون وطلاب وهواة ومساهمون مفتوح المصدر من جميع أنحاء العالم بتشكيل YOLO إلى ما هو عليه اليوم.

وكما قال جلين: "هناك ما يقرب من ألف منهم [المساهمون] في الخارج ونحن ممتنون للغاية لذلك. لم نكن لنصل إلى ما نحن عليه اليوم لولا هؤلاء الأشخاص."

تمت مشاركة النظرة الأولى على Ultralytics YOLO26 في وقت سابق من هذا العام في حدث YOLO Vision 2025 في لندن، حيث تم تقديمه باعتباره الخطوة الرئيسية التالية إلى الأمام في عائلة نموذجYOLO Ultralytics . في YV25 Shenzhen، قدم جلين تحديثًا للتقدم المحرز منذ ذلك الإعلان، وأتاح لمجتمع الذكاء الاصطناعي نظرة فاحصة على كيفية تطور النموذج.

تم تصميم YOLO26 ليكون أصغر حجماً وأسرع وأكثر دقة، مع الحفاظ على كونه عملياً للاستخدام في العالم الحقيقي. أوضح جلين أن الفريق أمضى العام الماضي في تحسين البنية وقياس الأداء عبر الأجهزة ودمج الرؤى المستقاة من الأبحاث وملاحظات المجتمع. والهدف هو تقديم أحدث أداء دون جعل النماذج أكثر صعوبة في النشر.

أحد التحديثات الأساسية التي سلط غلين الضوء عليها هو أن YOLO26 مقترن بحملة مخصصة لضبط المعلمات الفائقة، والانتقال من التدريب بالكامل من الصفر إلى الضبط الدقيق على مجموعات بيانات أكبر. وأوضح أن هذا النهج يتماشى أكثر مع حالات الاستخدام الفعلي في العالم الحقيقي.

فيما يلي بعض التحسينات الرئيسية الأخرى التي تمت مشاركتها في الحدث:

وتنتج عن هذه التحديثات معًا نماذج أسرع بنسبة تصل إلى 43% على CPU بينما تكون أكثر دقة من Ultralytics YOLO11مما يجعل YOLO26 مؤثراً بشكل خاص في الأجهزة المدمجة والروبوتات والأنظمة المتطورة.

ستدعم YOLO26 جميع المهام وأحجام النماذج المتوفرة حاليًا في YOLO11 مما ينتج عنه 25 نموذجًا مختلفًا عبر العائلة. يتضمن ذلك نماذج للكشف، والتجزئة، وتقدير الوضع، والمربعات المحدودة الموجهة، والتصنيف، بدءًا من النانو وحتى الحجم الكبير جدًا.

يعمل الفريق أيضًا على خمسة متغيرات قابلة للتوجيه. هذه هي النماذج التي يمكن أن تأخذ مطالبة نصية وتعيد المربعات المحدودة مباشرة، دون الحاجة إلى تدريب.

إنها خطوة مبكرة نحو تدفقات عمل رؤية أكثر مرونة وقائمة على التعليمات يسهل تكييفها مع حالات الاستخدام المختلفة. لا تزال نماذج YOLO26 قيد التطوير النشط، لكن نتائج الأداء المبكرة قوية، ويعمل الفريق على إطلاقها قريباً.

بعد تحديث YOLO26، رحّب غلين ببراتيك باتناغار، رئيس قسم هندسة المنتجات لدينا، لتقديم عرض توضيحي مباشر لمنصة Ultralytics . تم بناء هذه المنصة لتجميع الأجزاء الرئيسية لسير عمل الرؤية الحاسوبية معاً، بما في ذلك استكشاف مجموعات البيانات، والتعليق على الصور، ونماذج التدريب، ومقارنة النتائج.

أشار براتيك إلى أن المنصة تظل وفية لجذور Ultralyticsمفتوحة المصدر، حيث تقدم مساحتين مجتمعيتين، مجتمع مجموعات البيانات ومجتمع المشاريع، حيث يمكن للمطورين المساهمة وإعادة استخدام وتحسين عمل بعضهم البعض. وخلال العرض التوضيحي، عرض شرحًا توضيحيًا بمساعدة الذكاء الاصطناعي، والتدريب السحابي السهل، والقدرة على ضبط النماذج مباشرةً من المجتمع، دون الحاجة إلى موارد GPU المحلية.

المنصة قيد التطوير حاليًا. شجع براتيك الحضور على ترقب الإعلانات وأشار إلى أن الفريق ينمو في الصين لدعم الإطلاق.

مع تزايد الزخم، تحولت الفعالية إلى حلقة نقاش شارك فيها العديد من الباحثين الذين يقفون وراء نماذج YOLO المختلفة. ضمّت الجلسة جلين جوتشر، إلى جانب جينغ تشيو، كبير مهندسي تعلّم الآلة لدينا؛ وتشين هوي، مهندس تعلّم الآلة في Meta وأحد مؤلفي YOLOv10 وبو تشانغ، خبير استراتيجيات الخوارزميات في Meituan وأحد مؤلفي YOLOv6.

ركزت المناقشة على كيفية استمرار تطور YOLO من خلال الاستخدام الواقعي. وتطرق المتحدثون إلى أن التقدم غالبًا ما يكون مدفوعًا بتحديات النشر العملي، مثل التشغيل بكفاءة على الأجهزة الطرفية، وتحسين اكتشاف الأجسام الصغيرة، وتبسيط تصدير النماذج.

وبدلاً من السعي وراء الدقة فقط، أشار الفريق إلى أهمية الموازنة بين السرعة وسهولة الاستخدام والموثوقية في بيئات الإنتاج. ومن النتائج المشتركة الأخرى التي تم التوصل إليها هي قيمة التكرار وتعليقات المجتمع.

إليك بعض الأفكار الأخرى المثيرة للاهتمام من المحادثة:

بعد ذلك، دعونا نلقي نظرة فاحصة على بعض المحادثات الرئيسية في YV25 Shenzhen، حيث شارك قادة مجتمع الذكاء الاصطناعي في مجتمع الذكاء الاصطناعي كيفية تطور الذكاء الاصطناعي البصري، من البشر الرقميين والروبوتات إلى التفكير متعدد الوسائط ونشر الحافة الفعالة.

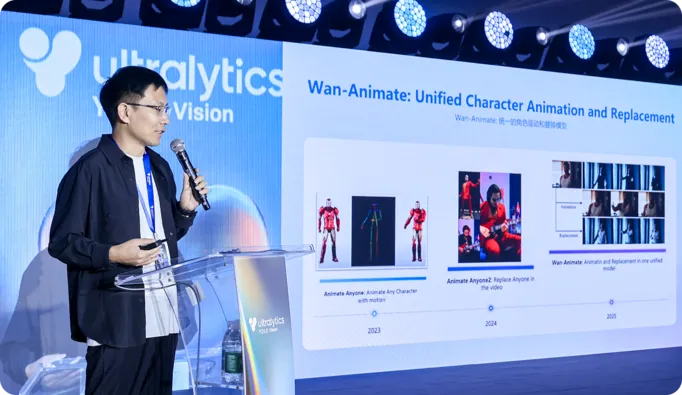

في جلسة ثاقبة، شارك الدكتور بينغ تشانغ من مختبر علي بابا كوين كيف يقوم فريقه بتطوير نماذج فيديو كبيرة يمكنها توليد بشر رقميين معبرين بحركة وتحكم أكثر طبيعية. واستعرض في هذه الجلسة نموذجَي Wan S2V وWan Animate، اللذين يستخدمان مراجع صوتية أو حركية لإنتاج كلام وإيماءات ورسوم متحركة واقعية، ومعالجة القيود التي تواجه التوليد القائم على النصوص البحتة.

كما تحدث الدكتور تشانغ عن التقدم الذي تم إحرازه في مجال الصور الرمزية التفاعلية في الوقت الحقيقي، بما في ذلك استنساخ المظهر والحركة بدون لقطات ونماذج خفيفة الوزن يمكنها تحريك الوجه مباشرة من بث مباشر للكاميرا، مما يجعل البشر الرقميين النابضين بالحياة أقرب إلى العمل بسلاسة على الأجهزة اليومية.

كان أحد المحاور الرئيسية في YV25 Shenzhen هو التحول من نماذج الرؤية التي ترى العالم ببساطة إلى الأنظمة التي يمكنها التصرف فيه. بعبارة أخرى، لم يعد الإدراك هو نهاية المطاف، بل أصبح بداية الفعل.

على سبيل المثال، في كلمته الرئيسية، وصف هو تشونشو من شركة D-Robotics كيف تدمج حلولهم الخاصة بالتطوير وSoC (نظام على شريحة) الاستشعار والتحكم في الحركة في الوقت الحقيقي واتخاذ القرار على مجموعة موحدة من الأجهزة والبرمجيات. من خلال التعامل مع الإدراك والحركة كحلقة تغذية مرتدة مستمرة، بدلاً من مراحل منفصلة، فإن نهجهم يدعم الروبوتات التي يمكنها التحرك والتكيف والتفاعل بشكل أكثر موثوقية في البيئات الحقيقية.

وقد ردد أليكس تشانغ من Baidu Paddle هذه الفكرة في حديثه، موضحًا كيف يعمل YOLO ونظام PaddleOCR معًا detect الأشياء ثم تفسير النص والبنية المحيطة بها. وهذا يمكّن الأنظمة من تحويل الصور والمستندات إلى معلومات منظمة وقابلة للاستخدام في مهام مثل الخدمات اللوجستية وعمليات التفتيش والمعالجة الآلية.

ومن الموضوعات الأخرى المثيرة للاهتمام في YV25 Shenzhen كيف أصبح الذكاء الاصطناعي المرئي أكثر كفاءة وقدرة على الأجهزة المتطورة.

تحدث بول جونغ من DEEPX عن نشر نماذج YOLO مباشرةً على الأجهزة المدمجة، مما يقلل من الاعتماد على السحابة. من خلال التركيز على الاستهلاك المنخفض للطاقة، والاستدلال المحسّن، وضبط النماذج المدرك للأجهزة، تتيح DEEPX إمكانية الإدراك في الوقت الحقيقي للطائرات بدون طيار والروبوتات المتنقلة والأنظمة الصناعية التي تعمل في بيئات ديناميكية.

وبالمثل، شارك ليو لينغفي من شركة Moore Threads كيف تدمج منصة Moore Threads E300 وحدة المعالجة المركزيةCPU ووحدة معالجة الرسوماتGPU وحوسبة وحدة المعالجة العصبية (NPU) لتقديم استنتاجات بصرية عالية السرعة على أجهزة صغيرة الحجم.

يمكن للمنصة تشغيل تدفقات YOLO متعددة بمعدلات إطارات عالية، وتبسط سلسلة أدواتها خطوات مثل التكميم والتجميع الثابت وضبط الأداء. قامت Moore Threads أيضًا بفتح مجموعة واسعة من نماذج الرؤية الحاسوبية وأمثلة النشر لخفض العوائق أمام المطورين.

حتى وقتٍ قريب، كان بناء نموذج واحد يمكنه فهم الصور وتفسير اللغة يتطلب بنية محولات كبيرة مكلفة في التشغيل. في YV25 Shenzhen، قدم يوي زيين من شركة Yuanshi Intelligence لمحة عامة عن RWKV، وهي بنية تمزج بين قدرات التفكير طويل السياق للمحوّلات مع كفاءة النماذج المتكررة.

وشرح كيف تطبق Vision-RWKV هذا التصميم على الرؤية الحاسوبية من خلال معالجة الصور بطريقة تتدرج خطياً مع الدقة. وهذا يجعلها مناسبة للمدخلات عالية الدقة وللأجهزة الطرفية حيث تكون الحوسبة محدودة.

أظهر يوي أيضًا كيف يتم استخدام RWKV في أنظمة الرؤية اللغوية، حيث يتم إقران ميزات الصورة مع فهم النص لتجاوز اكتشاف الأشياء إلى تفسير المشاهد والوثائق والسياق الواقعي.

بينما كانت المحادثات على المنصة تتطلع إلى ما سيصل إليه الذكاء الاصطناعي البصري، أظهرت الأكشاك الموجودة على الأرض كيف يتم استخدامه بالفعل اليوم. تمكن الحاضرون من رؤية نماذج تعمل بشكل مباشر، ومقارنة خيارات الأجهزة، والتحدث مباشرة مع الفرق التي تبني هذه الأنظمة.

إليك لمحة عن التكنولوجيا التي تم عرضها:

بالإضافة إلى جميع التقنيات المثيرة، كان أحد أفضل أجزاء مؤتمر YV25 Shenzhen هو جمع مجتمع الرؤية الحاسوبية وفريق Ultralytics معًا شخصيًا مرة أخرى. وطوال اليوم، تجمع الناس حول العروض التوضيحية، وتبادلوا الأفكار أثناء استراحات القهوة، واستمروا في المحادثات لفترة طويلة بعد انتهاء المحادثات.

قام الباحثون والمهندسون والطلاب والبناة بمقارنة الملاحظات وطرح الأسئلة وتبادل الخبرات الواقعية من النشر إلى التدريب على النماذج. وبفضل Cinco Jotas من Grupo Osborne، أضفنا لمسة من الثقافة الإسبانية إلى الحدث مع الجامون المنحوت الطازج، مما خلق لحظة دافئة من التواصل. مكان جميل وحشد متحمس وشعور مشترك بالزخم جعل اليوم مميزًا حقًا.

من الكلمات الرئيسية الملهمة إلى العروض التوضيحية العملية، استحوذت YOLO Vision 2025 Shenzhen على روح الابتكار التي تميز مجتمع Ultralytics . وطوال اليوم، تبادل المتحدثون والحضور الأفكار واستكشفوا تقنيات جديدة وتواصلوا فيما بينهم حول رؤية مشتركة لمستقبل الذكاء الاصطناعي. غادروا معًا وهم مفعمون بالطاقة ومستعدون لما هو قادم مع Ultralytics YOLO.

أعد تخيل ما هو ممكن باستخدام الذكاء الاصطناعي والرؤية الحاسوبية. انضم إلى مجتمعنا ومستودع GitHub لاكتشاف المزيد. تعرّف على المزيد حول تطبيقات مثل رؤية الكمبيوتر في الزراعة والذكاء الاصطناعي في مجال البيع بالتجزئة. استكشف خيارات الترخيص لدينا وابدأ في استخدام الرؤية الحاسوبية اليوم!