تعرف على كيفية تسريع عملية تقطير مجموعات البيانات لتدريب النماذج وخفض تكاليف الحوسبة من خلال استبدال مجموعات البيانات الكبيرة بمجموعة صغيرة ومحسّنة من العينات الاصطناعية.

تعرف على كيفية تسريع عملية تقطير مجموعات البيانات لتدريب النماذج وخفض تكاليف الحوسبة من خلال استبدال مجموعات البيانات الكبيرة بمجموعة صغيرة ومحسّنة من العينات الاصطناعية.

قد تبدو نماذج التدريب الجزء الأكثر استهلاكا للوقت في عمل عالم البيانات. لكن معظم وقتهم، غالبا ما يتراوح بين 60٪ و 80٪، يذهب في الواقع إلى إعداد البيانات: جمعها وتنظيفها وتنظيمها للنمذجة. مع نمو مجموعات البيانات، يزداد وقت الإعداد أيضا، مما يبطئ التجارب ويجعل التكرار أكثر صعوبة.

لمعالجة هذه المشكلة، أمضى الباحثون سنوات في البحث عن طرق لتبسيط التدريب. تهدف الأساليب مثل البيانات الاصطناعية وضغط مجموعات البيانات وطرق التحسين الأفضل إلى تقليل تكلفة العمل مع مجموعات البيانات الضخمة وتسريع سير عمل التعلم الآلي.

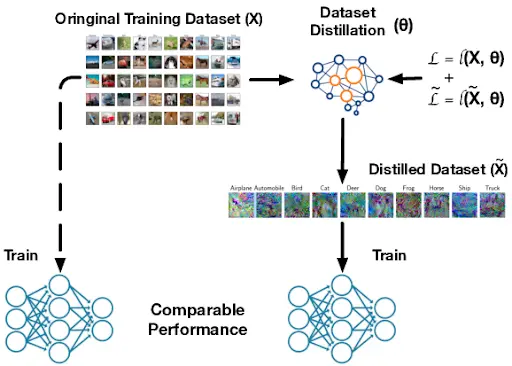

والسؤال الرئيسي الذي يطرح نفسه هنا هو: هل يمكننا تقليص حجم مجموعة البيانات بشكل كبير مع الحفاظ على نفس الأداء الذي نحصل عليه عند تدريب النموذج على البيانات الكاملة؟ وتعد عملية تقطير مجموعة البيانات إجابة واعدة على هذا السؤال.

إنه ينشئ نسخة مدمجة من مجموعة بيانات تدريب كبيرة مع الحفاظ على الأنماط الأساسية التي يحتاجها النموذج للتعلم بفعالية. ويوفر مسارًا لتدريب أسرع، واحتياجات حوسبة أقل، وتجارب أكثر كفاءة. يمكنك التفكير فيه على أنه ورقة غش دراسية للنموذج، وهي مجموعة صغيرة من أمثلة البيانات الاصطناعية المصممة لتعليم نفس الأنماط الأساسية مثل مجموعة البيانات الكاملة.

في هذه المقالة، سوف نستكشف كيفية عمل تقطير مجموعات البيانات وكيف يدعم التعلم الآلي القابل للتطوير والتعلم العميق عبر التطبيقات الواقعية. لنبدأ!

تقطير مجموعة البيانات هو عملية يتم فيها تكثيف مجموعة بيانات تدريب كبيرة إلى مجموعة بيانات أصغر بكثير لا تزال تعلم النموذج نفس المعلومات تقريبًا التي تحتوي عليها مجموعة البيانات الأصلية. يشير العديد من الباحثين إلى هذه العملية أيضًا باسم تكثيف مجموعة البيانات لأن الهدف منها هو التقاط الأنماط الأساسية التي تظهر عبر مجموعة البيانات الكاملة.

تختلف مجموعة البيانات المقطرة عن البيانات الاصطناعية التي يتم إنشاؤها عشوائياً أو مجرد اختيار مجموعة فرعية أصغر من الصور الحقيقية. فهي ليست مجموعة بيانات مزيفة عشوائية أو نسخة مقتطعة من الأصل.

بدلاً من ذلك، يتم تحسينها بشكل متعمد لالتقاط الأنماط الأكثر أهمية. خلال هذه العملية، يتم تعديل كل بكسل وميزة وتحسينها بحيث تتعلم الشبكة العصبية المدربة على البيانات المكررة كما لو كانت مدربة على مجموعة البيانات بأكملها.

ظهرت هذه الفكرة لأول مرة في ورقة بحثية نشرت في arXiv عام 2018 من قبل Tongzhou Wang و Jun-Yan Zhu و Antonio Torralba و Alexei A. Efros. استخدمت الاختبارات المبكرة مجموعات بيانات بسيطة مثل MNIST و CIFAR-10، مما سهّل إثبات أن بضع عينات مختارة يمكن أن تحل محل آلاف الصور الحقيقية.

.webp)

منذ ذلك الحين، دفعت أعمال المتابعة عملية تقطير مجموعات البيانات إلى الأمام، بما في ذلك الأساليب المنشورة في ICML و ICLR التي تجعل عملية التكثيف أكثر كفاءة وقابلية للتطوير.

تحسين كفاءة التدريب وتسريع دورات التطوير. من خلال تقليل كمية البيانات التي يحتاج النموذج إلى التعلم منها، فإنه يقلل من متطلبات الحوسبة.

وهذا مفيد بشكل خاص للتعلم المستمر، حيث يتم تحديث النماذج بمرور الوقت، والبحث في البنية العصبية، حيث يتم اختبار العديد من تصميمات النماذج، والتدريب المتطور، حيث تعمل النماذج على أجهزة صغيرة ذات ذاكرة وطاقة محدودة. بشكل عام، تجعل هذه المزايا تقطير مجموعة البيانات خيارًا رائعًا للتهيئة السريعة، والضبط السريع، وبناء النماذج الأولية المبكرة عبر العديد من سير عمل التعلم الآلي.

يؤدي تقطير مجموعة البيانات إلى إنشاء عينات تدريب اصطناعية أو مولدة صناعياً. تساعد هذه العينات النموذج على التعلم بطريقة تشبه إلى حد كبير التدريب على البيانات الحقيقية. ويعمل ذلك عن طريق تتبع ثلاثة عوامل رئيسية أثناء التدريب العادي.

الأول هو دالة الخسارة، وهي درجة خطأ النموذج التي توضح مدى خطأ تنبؤاته. والثاني هو معلمات النموذج، وهي الأوزان الداخلية للشبكة التي يتم تحديثها أثناء التعلم.

ثالثًا، مسار التدريب، الذي يصف كيفية تغير الخطأ والأوزان خطوة بخطوة بمرور الوقت. ثم يتم تحسين العينات الاصطناعية بحيث، عندما يتم تدريب النموذج عليها، ينخفض خطأه ويتم تحديث أوزانه بنفس الطريقة التي يتم بها مع مجموعة البيانات الكاملة.

فيما يلي نظرة فاحصة على كيفية عمل عملية تقطير مجموعة البيانات:

تستند جميع طرق تقطير مجموعات البيانات إلى نفس الفكرة الأساسية، حتى لو كانت تستخدم خوارزميات مختلفة للوصول إلى ذلك. تنقسم معظم الطرق إلى ثلاث فئات: مطابقة الأداء، ومطابقة التوزيع، ومطابقة المعلمات.

بعد ذلك، دعونا نلقي نظرة على كل واحد منها ونرى كيف يعمل.

يركز مطابقة الأداء في تقطير مجموعة البيانات على إنشاء مجموعة تدريب صغيرة ومحسّنة تتيح للنموذج الوصول إلى نفس الدقة تقريبًا كما لو كان قد تم تدريبه على مجموعة البيانات الأصلية الكاملة. بدلاً من اختيار مجموعة فرعية عشوائية، يتم تحسين العينات المقطرة بحيث ينتهي النموذج الذي تم تدريبه عليها بتنبؤات مماثلة، أو سلوك خسارة مماثل أثناء التدريب، أو دقة نهائية مماثلة لنموذج تم تدريبه على مجموعة البيانات الأصلية.

التعلم التلوي هو طريقة شائعة تستخدم لتحسين هذه العملية. يتم تحديث مجموعة البيانات المكررة من خلال حلقات تدريب متكررة، بحيث تصبح فعالة في العديد من المواقف المحتملة.

خلال هذه الحلقات، تحاكي الطريقة كيفية تعلم نموذج الطالب من العينات المقطرة الحالية، وتتحقق من أداء ذلك الطالب على البيانات الحقيقية، ثم تعدل العينات المقطرة لتكون معلمين أفضل. بمرور الوقت، تتعلم المجموعة المقطرة دعم التعلم السريع والتعميم القوي، حتى عندما يبدأ نموذج الطالب من أوزان أولية مختلفة أو يستخدم بنية مختلفة. وهذا يجعل مجموعة البيانات المقطرة أكثر موثوقية وغير مرتبطة بتدريب واحد.

.webp)

في الوقت نفسه، يولد مطابقة التوزيع بيانات اصطناعية تتطابق مع الأنماط الإحصائية لمجموعة البيانات الحقيقية. بدلاً من التركيز فقط على الدقة النهائية للنموذج، يركز هذا النهج على الميزات الداخلية التي تولدها الشبكة العصبية أثناء التعلم.

بعد ذلك، دعونا نلقي نظرة على التقنيتين اللتين تحركان مطابقة التوزيع.

تركز مطابقة التوزيع أحادي الطبقة على طبقة واحدة من الشبكة العصبية وتقارن الميزات التي تنتجها للبيانات الحقيقية مقابل البيانات الاصطناعية. تلتقط هذه الميزات، التي تسمى أيضًا التنشيطات، ما تعلمه النموذج في تلك المرحلة من الشبكة.

من خلال جعل البيانات الاصطناعية تنتج تنشيطات مماثلة، تشجع هذه الطريقة مجموعة البيانات المكررة على عكس نفس الأنماط المهمة الموجودة في مجموعة البيانات الأصلية. في الممارسة العملية، يتم تحديث العينات الاصطناعية بشكل متكرر حتى تتطابق التنشيطات في الطبقة المختارة بشكل وثيق مع تلك الموجودة في الصور الحقيقية.

هذا النهج بسيط نسبيًا لأنه يحاذي مستوى واحد فقط من التمثيل في كل مرة. ويمكن أن يعمل بشكل جيد بشكل خاص على مجموعات البيانات الصغيرة أو المهام التي لا تتطلب مطابقة هرميات الميزات العميقة متعددة المراحل. من خلال محاذاة مساحة ميزة واحدة بوضوح، توفر المطابقة أحادية الطبقة إشارة مستقرة وذات مغزى للتعلم باستخدام مجموعة البيانات المكررة.

يعتمد التوافق التوزيعي متعدد الطبقات على فكرة مقارنة البيانات الحقيقية والاصطناعية من خلال القيام بذلك على عدة طبقات من الشبكة العصبية بدلاً من طبقة واحدة فقط. تلتقط الطبقات المختلفة أنواعًا مختلفة من المعلومات، من الحواف والأنسجة البسيطة في الطبقات المبكرة إلى الأشكال والأنماط الأكثر تعقيدًا في الطبقات الأعمق.

من خلال مطابقة الميزات عبر هذه الطبقات، يتم دفع مجموعة البيانات المكررة لتعكس ما يتعلمه النموذج على مستويات متعددة. نظرًا لأنها تعمل على مواءمة الميزات عبر الشبكة، تساعد هذه الطريقة البيانات الاصطناعية على الحفاظ على إشارات أكثر ثراءً يعتمد عليها النموذج لتمييز الفئات عن بعضها البعض.

وهذا مفيد بشكل خاص في الرؤية الحاسوبية، أي المهام التي تتعلم فيها النماذج فهم الصور ومقاطع الفيديو، لأن الأنماط المفيدة منتشرة عبر العديد من الطبقات. عندما تتطابق توزيعات الميزات جيدًا على عدة مستويات، تعمل مجموعة البيانات المقطرة كبديل أقوى وأكثر موثوقية لبيانات التدريب الأصلية.

تعد مطابقة المعلمات فئة أخرى مهمة في تقطير مجموعات البيانات. فبدلاً من مطابقة الدقة أو توزيعات الميزات، فإنها تطابق كيفية تغير أوزان النموذج أثناء التدريب. من خلال جعل التدريب على مجموعة البيانات المقطرة ينتج تحديثات معلمات مشابهة لتدريب البيانات الحقيقية، يتبع النموذج مسار تعلم متطابق تقريبًا.

سنستعرض بعد ذلك طريقتين رئيسيتين لمطابقة المعلمات.

تقارن المطابقة أحادية الخطوة ما يحدث لأوزان النموذج بعد خطوة تدريب واحدة فقط على البيانات الحقيقية. ثم يتم ضبط مجموعة البيانات المكررة بحيث ينتج عن النموذج الذي تم تدريبه عليها لخطوة واحدة تحديث أوزان مشابه جدًا. نظرًا لأنها تركز فقط على هذا التحديث الفردي، فإن هذه الطريقة بسيطة وسريعة التنفيذ.

الجانب السلبي هو أن خطوة واحدة لا تعكس عملية التعلم الكاملة، خاصة بالنسبة للمهام الأصعب التي تحتاج فيها النموذج إلى العديد من التحديثات لبناء ميزات أكثر ثراءً. ولهذا السبب، فإن المطابقة أحادية الخطوة تعمل بشكل أفضل في المشكلات الأبسط أو مجموعات البيانات الأصغر حيث يمكن التقاط الأنماط المفيدة بسرعة.

في المقابل، تنظر مطابقة المعلمات متعددة الخطوات في كيفية تغير أوزان النموذج عبر عدة خطوات تدريب، وليس خطوة واحدة فقط. هذه السلسلة من التحديثات هي مسار تدريب النموذج.

يتم إنشاء مجموعة البيانات المقطرة بحيث عندما يتم تدريب النموذج على العينات الاصطناعية، فإن مساره يتبع عن كثب المسار الذي سيتخذه على البيانات الحقيقية. من خلال مطابقة فترة تعلم أطول، تلتقط المجموعة المقطرة المزيد من الهيكل في عملية التدريب الأصلية.

نظرًا لأنها تعكس كيفية تطور التعلم بمرور الوقت، فإن المطابقة متعددة الخطوات عادةً ما تكون أكثر فعالية في مجموعات البيانات الأكبر حجمًا أو الأكثر تعقيدًا، حيث تحتاج النماذج إلى العديد من التحديثات لاكتشاف الأنماط المفيدة. وهي تتطلب المزيد من الحسابات نظرًا لأنها track خطوات، ولكنها غالبًا ما تنتج مجموعات بيانات مركزة يمكن تعميمها بشكل أفضل وتقدم أداءً أفضل من المطابقة أحادية الخطوة.

بعد أن أصبح لدينا فهم أفضل لأساليب التقطير الرئيسية، يمكننا الآن أن ننظر في كيفية إنشاء البيانات الاصطناعية. في تقطير مجموعة البيانات، يتم تحسين العينات الاصطناعية لالتقاط أهم إشارة تعلم، بحيث يمكن لمجموعة صغيرة أن تحل محل مجموعة بيانات أكبر بكثير.

بعد ذلك، سنرى كيف يتم إنشاء هذه البيانات المكررة وتقييمها.

أثناء تقطير مجموعة البيانات، يتم تحديث البكسلات الاصطناعية عبر العديد من خطوات التدريب. تتعلم الشبكة العصبية من الصور الاصطناعية الحالية وترسل ملاحظات قائمة على التدرج، والتي توضح كيف يجب أن يتغير كل بكسل ليتناسب بشكل أفضل مع الأنماط الموجودة في مجموعة البيانات الحقيقية.

يعمل هذا لأن العملية قابلة للتفاضل (بمعنى أن كل خطوة سلسة ولها تدرجات محددة جيدًا، لذا تؤدي التغييرات الصغيرة في البكسل إلى تغييرات يمكن التنبؤ بها في الخسارة)، مما يسمح للنموذج بتعديل البيانات الاصطناعية بسلاسة أثناء الهبوط التدرجي.

مع استمرار عملية التحسين، تبدأ الصور الاصطناعية في تشكيل بنية ذات معنى، بما في ذلك الأشكال والأنسجة التي يتعرف عليها النموذج. غالبًا ما تُستخدم هذه الصور الاصطناعية المحسّنة في مهام تصنيف الصور لأنها تلتقط الإشارات البصرية الرئيسية التي يحتاج المصنف إلى تعلمها.

يتم تقييم مجموعات البيانات المقطرة من خلال تدريب النماذج عليها ومقارنة النتائج بالنماذج المدربة على البيانات الحقيقية. يقيس الباحثون دقة التحقق ويحققون فيما إذا كانت المجموعة الاصطناعية تحافظ على السمات التمييزية (الأنماط أو الإشارات التي يعتمد عليها النموذج لتمييز فئة عن أخرى) اللازمة لفصل الفئات. كما يختبرون الاستقرار والتعميم عبر عمليات تشغيل أو إعدادات نماذج مختلفة للتأكد من أن البيانات المقطرة لا تؤدي إلى الإفراط في الملاءمة.

بعد ذلك، سنلقي نظرة فاحصة على أمثلة توضح كيف تعمل مجموعات البيانات المكررة على تسريع التدريب وتقليل تكاليف الحوسبة مع الحفاظ على الأداء القوي، حتى عندما تكون البيانات محدودة أو متخصصة للغاية.

عندما يتعلق الأمر بالرؤية الحاسوبية، فإن الهدف هو تدريب النماذج على فهم البيانات المرئية مثل الصور ومقاطع الفيديو. تتعلم هذه النماذج أنماطًا مثل الحواف والأنسجة والأشكال والأجسام، ثم تستخدم تلك الأنماط في مهام مثل تصنيف الصور أو اكتشاف الأجسام أو التجزئة. نظرًا لأن مشاكل الرؤية غالبًا ما تتنوع بشكل كبير في الإضاءة والخلفيات ووجهات النظر، فإن أنظمة الرؤية الحاسوبية عادةً ما تحتاج إلى مجموعات بيانات كبيرة لتعميمها بشكل جيد، مما يجعل التدريب مكلفًا وبطيئًا.

عندما يتعلق الأمر بحالات استخدام تصنيف الصور مثل الفحوصات الطبية أو مراقبة الحياة البرية أو الكشف عن العيوب في المصانع، غالبًا ما تواجه النماذج صعوبة في الموازنة بين الدقة وتكلفة التدريب. عادةً ما تتضمن هذه المهام مجموعات بيانات ضخمة.

يمكن لتقطير مجموعة البيانات ضغط مجموعة التدريب الأصلية إلى عدد صغير من الصور الاصطناعية التي لا تزال تحتوي على أهم الإشارات البصرية للمصنف. في المعايير الكبيرة مثل ImageNet ثبت أن المجموعات المقطرة التي تستخدم حوالي 4.2٪ فقط من الصور الأصلية تحافظ على دقة تصنيف قوية. وهذا يعني أن وكيلًا اصطناعيًا صغيرًا يمكن أن يحل محل ملايين العينات الحقيقية بحساب أقل بكثير.

البحث في البنية العصبية، أو NAS، هو تقنية تستكشف تلقائيًا العديد من تصميمات الشبكات العصبية الممكنة للعثور على التصميم الأنسب لمهمة ما. نظرًا لأن NAS يتعين عليه تدريب وتقييم عدد كبير من النماذج المرشحة، فإن تشغيله على مجموعات بيانات كاملة قد يكون بطيئًا ومكثفًا للغاية من الناحية الحسابية.

يساعد تقطير مجموعة البيانات في إنشاء مجموعة تدريب اصطناعية صغيرة لا تزال تحتوي على إشارة التعلم الرئيسية للبيانات الأصلية، بحيث يمكن اختبار كل بنية مرشحة بشكل أسرع. وهذا يتيح لـ NAS مقارنة التصميمات بكفاءة مع الحفاظ على تصنيفات البنى الجيدة مقابل السيئة موثوقة بشكل معقول، مما يقلل من تكلفة البحث دون التضحية بجودة النموذج النهائي.

تحتاج أنظمة التعلم المستمر، أي النماذج التي تستمر في التحديث مع وصول بيانات جديدة بدلاً من أن يتم تدريبها مرة واحدة، إلى تحديثات سريعة وفعالة من حيث الذاكرة. تواجه الأجهزة الطرفية مثل الكاميرات والهواتف وأجهزة الاستشعار قيودًا مماثلة لأنها تتمتع بميزانيات محدودة للحوسبة والتخزين.

يساعد تقطير مجموعة البيانات في كلتا الحالتين عن طريق ضغط مجموعة تدريب كبيرة إلى مجموعة اصطناعية صغيرة، بحيث يمكن للنماذج التكيف أو إعادة التدريب باستخدام مجموعة إعادة تشغيل صغيرة بدلاً من مجموعة البيانات الكاملة. على سبيل المثال، أظهرت أعمال التعلم التلوي القائمة على النواة أن 10 عينات مقطرة فقط يمكن أن تحقق دقة تزيد عن 64٪ على CIFAR-10، وهو معيار قياسي لتصنيف الصور. نظرًا لأن مجموعة إعادة التشغيل صغيرة جدًا، تصبح التحديثات أسرع وأكثر عملية، خاصةً عندما تحتاج النماذج إلى التحديث بشكل متكرر.

يمكن أن يعمل تقطير مجموعة البيانات جنبًا إلى جنب مع تقطير المعرفة في النماذج اللغوية الكبيرة. يمكن لمجموعة البيانات المقطرة الصغيرة أن تحتفظ بأهم إشارات المهام من نموذج المعلم، بحيث يمكن تدريب نموذج الطالب المضغوط أو تحديثه بشكل أكثر كفاءة دون فقدان الكثير من الأداء. نظرًا لأن مجموعات البيانات هذه صغيرة الحجم، فهي مفيدة بشكل خاص للاستخدام على الأجهزة أو على الحافة، حيث تكون سعة التخزين والقدرة الحاسوبية محدودة، ولكنك لا تزال تريد أن يظل النموذج دقيقًا بعد التحديثات.

فيما يلي بعض مزايا استخدام تقطير مجموعة البيانات:

على الرغم من أن تقطير مجموعات البيانات يوفر العديد من المزايا، إلا أن هناك بعض القيود التي يجب أخذها في الاعتبار:

يتيح تقطير مجموعة البيانات إمكانية استخدام مجموعة صغيرة من العينات الاصطناعية لتدريب النموذج بنفس فعالية مجموعة البيانات الكاملة تقريبًا. وهذا يجعل التعلم الآلي أسرع وأكثر كفاءة وأسهل في التوسع. مع نمو النماذج وزيادة احتياجها للبيانات، توفر مجموعات البيانات المقطرة طريقة عملية لتقليل تكاليف الحوسبة دون التضحية بالدقة.

انضم إلى مجتمعنا وتصفح مستودع GitHub الخاص بنا لتكتشف المزيد عن الذكاء الاصطناعي. إذا كنت ترغب في إنشاء مشروع Vision AI خاص بك، فراجع خيارات الترخيص المتاحة لدينا. اكتشف المزيد عن تطبيقات مثل الذكاء الاصطناعي في الرعاية الصحية وVision AI في تجارة التجزئة من خلال زيارة صفحات الحلول الخاصة بنا.