Erfahren Sie, wie Computer Vision in Navigationslösungen die Echtzeitkartierung, die Objekterkennung und die Augmented Reality für intelligentere und sicherere Reiseerlebnisse verbessert.

Erfahren Sie, wie Computer Vision in Navigationslösungen die Echtzeitkartierung, die Objekterkennung und die Augmented Reality für intelligentere und sicherere Reiseerlebnisse verbessert.

Heutzutage fühlt es sich mühelos an, sein Telefon herauszuholen, ein Ziel einzutippen und Schritt-für-Schritt-Anweisungen zu befolgen, um dorthin zu gelangen. Es ist etwas, das nur wenige Sekunden dauert. Aber diese alltägliche Bequemlichkeit ist das Ergebnis jahrelanger technologischer Fortschritte. Die Navigation hat einen langen Weg zurückgelegt, von Papierkarten und Kompassen bis hin zu intelligenten Systemen, die die Welt in Echtzeit verstehen und auf sie reagieren können.

Eine der Technologien hinter diesem Wandel ist Computer Vision, ein Zweig der künstlichen Intelligenz (KI), der es Maschinen ermöglicht, visuelle Informationen wie Menschen zu interpretieren. Moderne Navigationstools nutzen jetzt Echtzeitbilder von Satelliten, Dashcams und Sensoren auf Straßenebene, um die Kartengenauigkeit zu verbessern, Straßenverhältnisse zu überwachen und Benutzer durch komplexe Umgebungen zu führen.

In diesem Artikel werden wir untersuchen, wie Computer Vision die Navigation verbessert, indem sie GPS-Karten verbessert, Echtzeit-Verkehrsinformationen bereitstellt und Technologien wie Augmented-Reality-Navigation und autonome Fahrzeuge unterstützt.

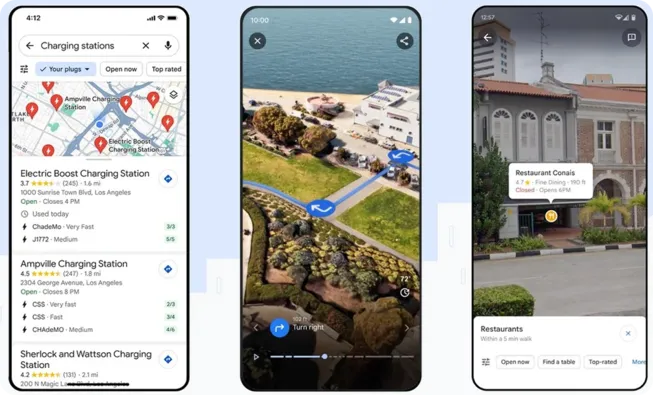

Die Verwendung von Tools wie Google Maps für die Navigation im Alltag ist mittlerweile weit verbreitet, sei es auf dem Weg durch die Stadt oder auf der Suche nach einem Café in der Nähe. Mit der zunehmenden Verbreitung von KI-Technologien sehen wir immer fortschrittlichere Funktionen wie die Immersive View, die 2023 von Google Maps eingeführt wird und mit der Nutzer Teile ihrer Reise in einer 3D-Umgebung sehen können. Ermöglicht wird dies durch eine Kombination aus KI, Photogrammetrie und Computer Vision.

Alles beginnt mit Milliarden von hochauflösenden Bildern, die von einer Reihe von Spezialgeräten aufgenommen werden. Dazu gehören Street View-Autos, Fahrzeuge, die mit 360-Grad-Kameras ausgestattet sind und durch Städte fahren, und Trekker-Geräte, tragbare Rucksäcke mit montierten Kameras, die verwendet werden, um Bilder an Orten aufzunehmen, die Fahrzeuge nicht erreichen können, wie Wanderwege oder enge Gassen.

Diese Bilder werden mit Kartendaten mithilfe von Photogrammetrie abgeglichen, einer Technik, die 2D-Fotos, die aus verschiedenen Winkeln aufgenommen wurden, zusammenfügt, um genaue 3D-Modelle von Straßen, Gebäuden und Gelände zu erstellen.

Computer Vision wird dann verwendet, um diese Modelle mithilfe von Objekterkennung und Bildsegmentierung zu analysieren, um wichtige Merkmale wie Straßenschilder, Gehwege, Fußgängerüberwege und Gebäudeeingänge zu identifizieren und zu kennzeichnen.

Die beschrifteten Daten werden verwendet, um KI-Systeme zu trainieren, die erkennen, wie sich visuelle Hinweise in verschiedenen Regionen unterscheiden. Zum Beispiel kann das System leicht zwischen einem “SLOW”-Schild in den Vereinigten Staaten, das typischerweise ein gelbes oder oranges Quadrat ist, und einem ähnlichen Schild in Japan unterscheiden, das normalerweise ein rotes und weißes Dreieck ist. Dieses Verständnis macht die Navigationserfahrung genauer und kulturell bewusster.

Schließlich überlagert Immersive View Live-Navigationspfade auf der 3D-Umgebung und bietet so ein reibungsloses, intuitives Erlebnis, das genau zeigt, wohin Sie unterwegs sind.

Wir haben wahrscheinlich alle schon einmal erlebt, dass wir uns im Kreis gedreht und versucht haben, herauszufinden, in welche Richtung uns Google Maps führt. Genau diese Verwirrung soll die Augmented-Reality-Navigation (AR) lösen, eine Technologie, bei der digitale Informationen über die reale Kameraansicht gelegt werden. Sie verändert die Art und Weise, wie Menschen ihren Weg an belebten Orten wie Straßen oder großen Innenräumen finden.

Normale Karten können schwer zu befolgen sein, besonders wenn GPS-Signale schwach sind oder nicht gut funktionieren. AR-Navigation behebt dies, indem digitale Wegbeschreibungen, Pfeile und Beschriftungen direkt in der Live-Kameraansicht der realen Welt angezeigt werden. Das bedeutet, dass Benutzer eine Führung sehen, die zu den Straßen und Gebäuden um sie herum passt, was es viel einfacher macht zu wissen, wohin man gehen muss.

Die AR-Navigation stützt sich auf Computer Vision Modelle, um die Umgebung über die Kamera eines Geräts zu erfassen. Dies beinhaltet verschiedene Aufgaben wie die Bildlokalisierung, die Merkmale wie Gebäudekanten oder Straßenschilder erkennt und sie mit einer gespeicherten Karte abgleicht. Simultaneous Localization and Mapping (SLAM) erstellt eine Karte der Umgebung und verfolgt gleichzeitig die Position des Geräts in Echtzeit.

Der Flughafen Zürich war beispielsweise der erste, der die Live View-Funktion von Google Maps für die Navigation in Innenräumen einsetzte. Die Passagiere können ihre Telefonkameras verwenden, um Pfeile und Richtungen in der realen Umgebung zu sehen, die sie durch die Terminals zu den Gates, Geschäften und Dienstleistungen führen. Dies verbessert das Erlebnis der Passagiere, indem es die Navigation in komplizierten Innenräumen erleichtert.

Die Straßen der Stadt werden jeden Tag voller. Mit mehr Autos auf der Straße, überfüllten Gehwegen und ständiger Aktivität wird es immer schwieriger, den Verkehr reibungslos und sicher zu gestalten. Um das Chaos zu bewältigen, setzen viele Städte auf KI und Computer Vision.

Intelligente Kameras und Sensoren, die an Kreuzungen und entlang von Straßen installiert sind, erfassen einen ständigen Strom visueller Daten. Dieses Bildmaterial wird in Echtzeit verarbeitet, um Unfälle detect , den Verkehrsfluss zu überwachen, Schlaglöcher zu entdecken und Dinge wie illegales Parken oder riskantes Verhalten von Fußgängern zu erfassen.

Ein interessantes Beispiel hierfür ist der Smart Airport Expressway in Hangzhou, China. Diese 20 Kilometer lange Autobahn, die die Innenstadt von Hangzhou mit dem internationalen Flughafen Xiaoshan verbindet, wurde mit hochauflösenden Kameras und Millimeterwellenradaren aufgerüstet. Diese Geräte erfassen kontinuierlich Video- und Sensordaten, die dann mit Computer Vision analysiert werden.

Das System zeichnet nicht nur Bilder auf, sondern interpretiert das Geschehen auf der Straße. Computer-Vision-Algorithmen detect Fahrzeugkollisionen, erkennen Verkehrsverstöße und identifizieren sogar Fußgänger oder ungewöhnliche Bewegungen in der Nähe von Autobahnausfahrten. Auf diese Weise können Verkehrsbeamte innerhalb von Sekunden auf Vorfälle reagieren, ohne selbst vor Ort sein zu müssen.

Die Daten fließen auch in einen digitalen Zwilling ein: ein virtuelles 3D-Live-Modell der Schnellstraße, das Echtzeit-Verkehrsbedingungen, Fahrzeugdetails und aufkommende Staus anzeigt. Verkehrspolizisten überwachen diese visuelle Schnittstelle, um den Verkehrsfluss zu steuern, intelligente Warnmeldungen auszugeben und schnell und genau auf Vorfälle zu reagieren.

Navigation geht heute weit über die bloße Wegfindung von Punkt A nach Punkt B hinaus. Sie ist heute ein wichtiger Bestandteil intelligenter Systeme, die Menschen bewegen, Waren verwalten und Echtzeitentscheidungen treffen - ob auf der Straße oder in Lagerhallen.

Das Herzstück vieler dieser Systeme ist die Computer Vision, die es Maschinen ermöglicht, visuelle Daten zu interpretieren und sofort auf ihre Umgebung zu reagieren. Gehen wir einige Beispiele durch, um zu sehen, wie diese Technologie die Navigation in verschiedenen Umgebungen verändert.

Roboter werden für die Zukunft der Logistik immer wichtiger, insbesondere in groß angelegten Lagerbetrieben. Da die Nachfrage im E-Commerce wächst, verlassen sich Unternehmen zunehmend auf computergestützte Maschinen, um sich in komplexen Umgebungen zurechtzufinden, Artikel zu sortieren und den Lagerbestand schnell und präzise zu verwalten.

Nehmen wir zum Beispiel die Amazon-Versandzentren, wo über 750.000 Roboter mit Menschen zusammenarbeiten, um den Betrieb effizient aufrechtzuerhalten. Diese Roboter sind in hohem Maße auf Computer Vision angewiesen, um sich in den belebten Lagerhallen zurechtzufinden, Artikel zu identifizieren und schnelle, genaue Entscheidungen zu treffen.

Ein solches System ist Sequoia, eine Roboterplattform, die entwickelt wurde, um die Lagerhaltung zu beschleunigen. Es verwendet fortschrittliche Computer Vision, um eingehende Produkte zu scannen, zu zählen und zu organisieren, was zur Rationalisierung von Lager- und Abrufprozessen beiträgt.

Auch Vulcan, ein Roboterarm, verwendet Kameras und Bildanalyse, um Gegenstände sicher aus Regalen zu entnehmen, wobei er seinen Griff an die Form und Position jedes Objekts anpasst und sogar erkennt, wann menschliche Hilfe benötigt wird. Cardinal, ein weiterer robotergestützter Roboter mit Bildverarbeitung, ist auf das Sortieren spezialisiert: Er scannt gemischte Paketstapel und platziert sie präzise in die richtigen Ausgangswagen.

Bisher haben wir gesehen, wie Computer Vision Menschen und Robotern hilft, sich in ihrer Umgebung zurechtzufinden. Aber sie ist ebenso entscheidend für autonome Systeme, wie z. B. selbstfahrende Autos, bei denen die Navigation vollständig davon abhängt, was das Fahrzeug in Echtzeit sehen und verstehen kann.

Ein gutes Beispiel ist das Tesla Vision System. Tesla hat einen reinen Kameraansatz für das autonome Fahren gewählt und Radar und andere Sensoren zugunsten eines Netzwerks von Kameras entfernt, die eine vollständige 360-Grad-Ansicht der Umgebung des Autos ermöglichen. Diese Kameras speisen visuelle Daten in den Full Self-Driving (FSD)-Computer ein, der tiefe neuronale Netze verwendet, um die Umgebung zu interpretieren und in Sekundenschnelle Fahrentscheidungen zu treffen.

Basierend auf dem, was es sieht, entscheidet das System, wann es lenken, beschleunigen, bremsen oder die Spur wechseln muss – genau wie ein menschlicher Fahrer, aber ausschliesslich durch visuelle Eingabe. Tesla verbessert dieses System kontinuierlich, indem es riesige Mengen an realen Fahrdaten aus seiner Flotte sammelt und daraus lernt.

Hier sind einige der wichtigsten Vorteile des Einsatzes von Computer Vision in der Navigation, insbesondere in Systemen, in denen Genauigkeit, Sicherheit und Echtzeit-Entscheidungsfindung von entscheidender Bedeutung sind:

Obwohl Computer Vision viele Vorteile für die Navigation mit sich bringt, gibt es auch einige wichtige Einschränkungen, die bei der Implementierung solcher Lösungen berücksichtigt werden müssen. Hier sind einige wichtige Herausforderungen, die Sie beachten sollten:

Computer Vision erfindet die Navigation neu, indem es Karten dynamischer, Verkehrssysteme intelligenter und Mobilität zugänglicher macht. Was einst statische Routen waren, sind jetzt interaktive Echtzeit-Erlebnisse - unterstützt durch immersive 3D-Vorschauen, AR-gestützte Wegbeschreibungen und autonome Transporttechnologien.

Mit dem Fortschritt der Technologie wird sich der Fokus wahrscheinlich darauf verlagern, diese Systeme inklusiver, anpassungsfähiger und verantwortungsvoller zu gestalten. Der weitere Fortschritt wird von der Verbesserung der Genauigkeit in verschiedenen Umgebungen, der Aufrechterhaltung einer zuverlässigen Leistung und dem Schutz der Privatsphäre der Benutzer abhängen. Die Zukunft der Computer Vision in der Navigation liegt im Aufbau von Lösungen, die nicht nur intelligent, sondern auch in ihrem Design und ihrer Wirkung durchdacht sind.

Treten Sie unserer wachsenden Community bei! Erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren, und informieren Sie sich über unsere Lizenzoptionen, um Ihre Vision-KI-Projekte zu starten. Interessieren Sie sich für Innovationen wie KI im Einzelhandel und Computer Vision in der Landwirtschaft? Besuchen Sie unsere Lösungsseiten, um mehr zu erfahren!