Erforschung des Ensemble-Lernens und seiner Rolle in KI und ML

Erfahren Sie, wie Ensemble-Learning die Leistung von KI-Modellen durch Techniken wie Bagging, Boosting und Stacking steigert, um genauere und stabilere Vorhersagen zu ermöglichen.

Erfahren Sie, wie Ensemble-Learning die Leistung von KI-Modellen durch Techniken wie Bagging, Boosting und Stacking steigert, um genauere und stabilere Vorhersagen zu ermöglichen.

Eine visuelle Darstellung der in diesem Artikel behandelten Konzepte finden Sie im folgenden Video.

KI-Innovationen wie Empfehlungsmaschinen und Betrugserkennungssysteme stützen sich auf Algorithmen und Modelle des maschinellen Lernens, um Vorhersagen und Entscheidungen auf der Grundlage von Daten zu treffen. Diese Modelle können Muster erkennen, Trends vorhersagen und dabei helfen, komplexe Aufgaben zu automatisieren.

Ein einzelnes Modell kann jedoch nicht alle Details in realen Daten erfassen. Es kann in einigen Fällen gute Leistungen erbringen, in anderen jedoch versagen, z. B. wenn ein Betrugserkennungsmodell neue Arten von Transaktionen übersieht.

Mit dieser Einschränkung sind KI-Ingenieure häufig konfrontiert, wenn sie Modelle für maschinelles Lernen erstellen und einsetzen. Einige Modelle sind zu gut angepasst, weil sie die Trainingsdaten zu genau lernen, während andere zu schlecht angepasst sind, weil sie wichtige Muster übersehen. Ensemble-Lernen ist eine KI-Technik, die dabei hilft, diese Herausforderungen zu bewältigen, indem sie mehrere Modelle, die als Basis-Lerner bekannt sind, zu einem einzigen, leistungsfähigeren System kombiniert.

Man kann es sich wie ein Team von Experten vorstellen, die gemeinsam an der Lösung eines Problems arbeiten. In diesem Artikel werden wir untersuchen, was Ensemble-Learning ist, wie es funktioniert und wo es eingesetzt werden kann. Fangen wir an!

Ensemble-Lernen bezieht sich auf eine Reihe von Techniken, die mehrere Modelle kombinieren, um das gleiche Problem zu lösen und ein einziges, verbessertes Ergebnis zu erzielen. Es kann sowohl beim überwachten Lernen (bei dem Modelle aus gekennzeichneten Daten lernen) als auch beim unüberwachten Lernen (bei dem Modelle Muster in nicht gekennzeichneten Daten finden) angewendet werden.

Anstatt sich auf ein einziges Modell zu verlassen, um Vorhersagen zu treffen, verwendet ein Ensemble mehrere Modelle, die die Daten jeweils auf ihre eigene Weise betrachten. Wenn ihre Ergebnisse kombiniert werden, ist das Ergebnis oft genauer, stabiler und verallgemeinerungsfähiger als das, was ein einzelnes Modell für sich allein erreichen könnte.

Sie können es mit einem Panel von Analysten vergleichen, die sich mit demselben Problem befassen. Jeder Analyst oder jedes einzelne Modell interpretiert die Daten anders.

Der eine konzentriert sich vielleicht auf Muster, der andere auf Anomalien und wieder ein anderer auf den Kontext. Durch die Zusammenführung ihrer Perspektiven kann die Gruppe eine Entscheidung treffen, die ausgewogener und zuverlässiger ist als jedes Einzelurteil.

Dieser Ansatz hilft auch, zwei der größten Herausforderungen beim maschinellen Lernen zu bewältigen: Verzerrung und Varianz. Ein Modell mit hoher Verzerrung ist zu einfach und übersieht wichtige Muster, während ein Modell mit hoher Varianz zu empfindlich ist und die Trainingsdaten zu genau abbildet. Durch die Kombination von Modellen findet das Ensemble-Lernen ein Gleichgewicht zwischen diesen beiden Faktoren und verbessert die Leistung des Systems bei neuen, noch nicht gesichteten Daten.

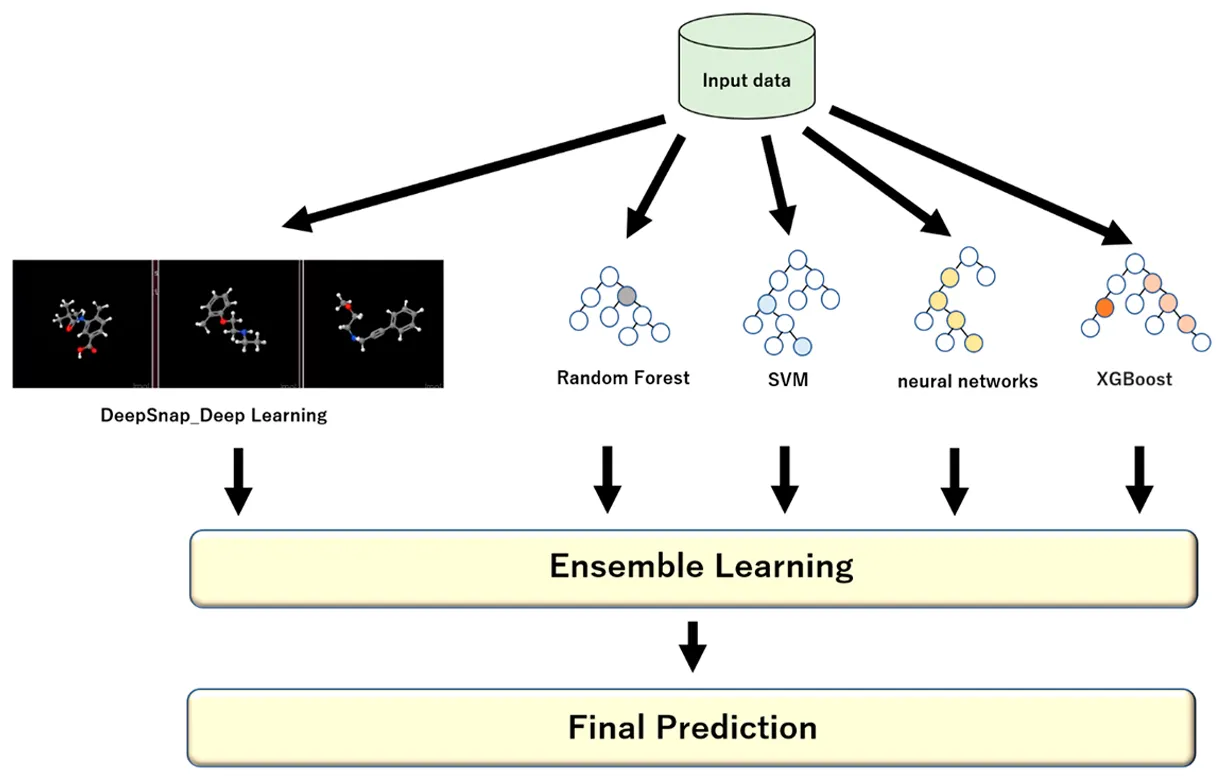

Jedes Modell in einem Ensemble wird als Basis-Learner oder Basis-Modell bezeichnet. Dabei kann es sich entweder um dieselbe Art von Algorithmus oder um eine Mischung verschiedener Algorithmen handeln, je nachdem, welche Ensemble-Technik verwendet wird.

Hier sind einige gängige Beispiele für die verschiedenen Modelle, die beim Ensemble-Lernen verwendet werden:

Ein kombiniertes Modell-Ensemble wird im Allgemeinen als starker Lerner bezeichnet, weil es die Stärken der Basis-Lerner (auch als schwache Modelle bezeichnet) integriert und gleichzeitig deren Schwächen minimiert. Zu diesem Zweck werden die Vorhersagen der einzelnen Modelle auf strukturierte Weise kombiniert, wobei bei Klassifizierungsaufgaben eine Mehrheitsabstimmung und bei Regressionsaufgaben eine gewichtete Mittelwertbildung verwendet wird, um ein genaueres Endergebnis zu erzielen.

Bevor wir uns mit den verschiedenen Ensemble-Learning-Techniken beschäftigen, sollten wir einen Schritt zurücktreten und verstehen, wann diese Art von Ansatz in einem maschinellen Lern- oder KI-Projekt verwendet werden sollte.

Das Ensemble-Lernen ist am wirkungsvollsten, wenn ein einzelnes Modell Schwierigkeiten hat, genaue oder konsistente Vorhersagen zu machen. Es kann auch in Situationen verwendet werden, in denen die Daten komplex, verrauscht oder unvorhersehbar sind.

Hier sind einige häufige Fälle, in denen Ensemble-Methoden besonders wirksam sind:

Es ist auch einfacher zu trainieren, leichter zu interpretieren und schneller zu pflegen. Vor dem Einsatz eines Ensembles ist es wichtig, den Vorteil der höheren Genauigkeit gegen den zusätzlichen Zeitaufwand, die Rechenleistung und die Komplexität abzuwägen, die es erfordert.

Als Nächstes wollen wir uns die wichtigsten Möglichkeiten ansehen, wie das Ensemble-Lernen in Projekten des maschinellen Lernens eingesetzt werden kann. Es gibt mehrere Kerntechniken zur Kombination von Modellen, die jeweils auf ihre eigene Weise die Leistung verbessern. Die gängigsten Ensemble-Methoden sind Bagging, Boosting, Stacking und Blending.

Bagging, kurz für Bootstrap-Aggregation, ist eine Ensemble-Lernmethode, die zur Verbesserung der Modellstabilität und -genauigkeit beiträgt, indem mehrere Versionen desselben Modells auf verschiedenen Teilen der Daten trainiert werden.

Jede Teilmenge wird mit einem Verfahren namens Bootstrap Sampling erstellt, bei dem die Datenpunkte nach dem Zufallsprinzip mit Ersetzung ausgewählt werden. Das bedeutet, dass nach der Auswahl eines Datenpunkts dieser wieder in den Pool aufgenommen wird, bevor der nächste ausgewählt wird, so dass derselbe Punkt mehr als einmal vorkommen kann, während andere möglicherweise ausgelassen werden. Durch diese Zufälligkeit wird sichergestellt, dass jedes Modell auf einer etwas anderen Version des Datensatzes trainiert.

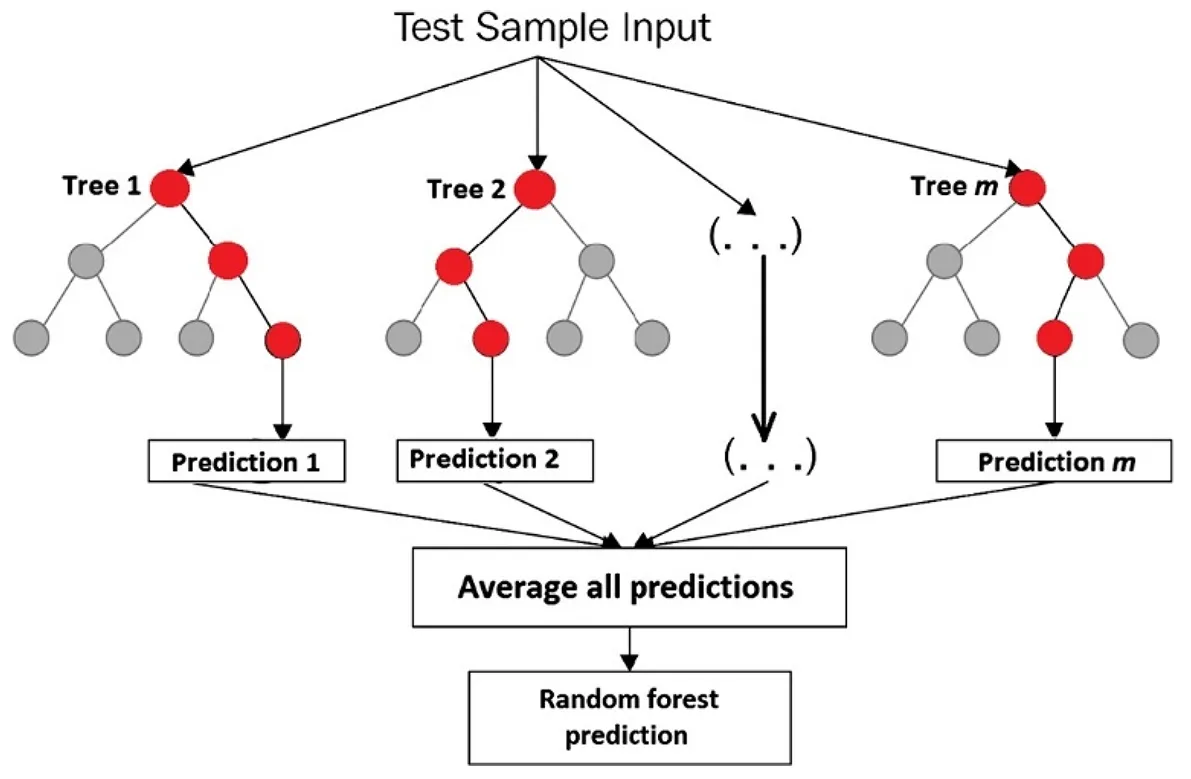

Während der Inferenz laufen alle trainierten Modelle parallel, um Vorhersagen für neue, ungesehene Daten zu treffen. Jedes Modell erzeugt seine eigene Ausgabe auf der Grundlage dessen, was es gelernt hat, und diese einzelnen Vorhersagen werden dann zu einem Endergebnis kombiniert.

Bei Regressionsaufgaben, wie der Vorhersage von Hauspreisen oder Umsatzprognosen, bedeutet dies in der Regel, dass die Ergebnisse aller Modelle gemittelt werden, um eine glattere Schätzung zu erhalten. Bei Klassifizierungsaufgaben, z. B. bei der Feststellung, ob eine Transaktion betrügerisch ist oder nicht, entscheidet das Ensemble oft durch eine Mehrheitsentscheidung über die endgültige Klasse.

Ein gutes Beispiel dafür, dass Bagging gut funktioniert, sind Entscheidungsbäume, die sich leicht zu stark anpassen können, wenn sie auf einen einzigen Datensatz trainiert werden. Durch das Trainieren vieler Bäume auf leicht unterschiedlichen Stichproben und das Kombinieren ihrer Ergebnisse verringert das Bagging die Überanpassung und verbessert die Zuverlässigkeit.

Nehmen wir den Random-Forest-Algorithmus. Es handelt sich um ein Ensemble von Entscheidungsbäumen, wobei jeder Baum auf einer zufälligen Teilmenge des Trainingsdatensatzes sowie einer zufälligen Teilmenge von Merkmalen trainiert wird.

Diese Zufälligkeit der Merkmale trägt dazu bei, dass die Bäume weniger korreliert sind und dass das Gesamtmodell stabiler und genauer ist. Ein Random-Forest-Algorithmus kann zur classify Bildern, zur detect , zur Vorhersage der Kundenabwanderung, zur Umsatzprognose oder zur Schätzung von Immobilienpreisen verwendet werden.

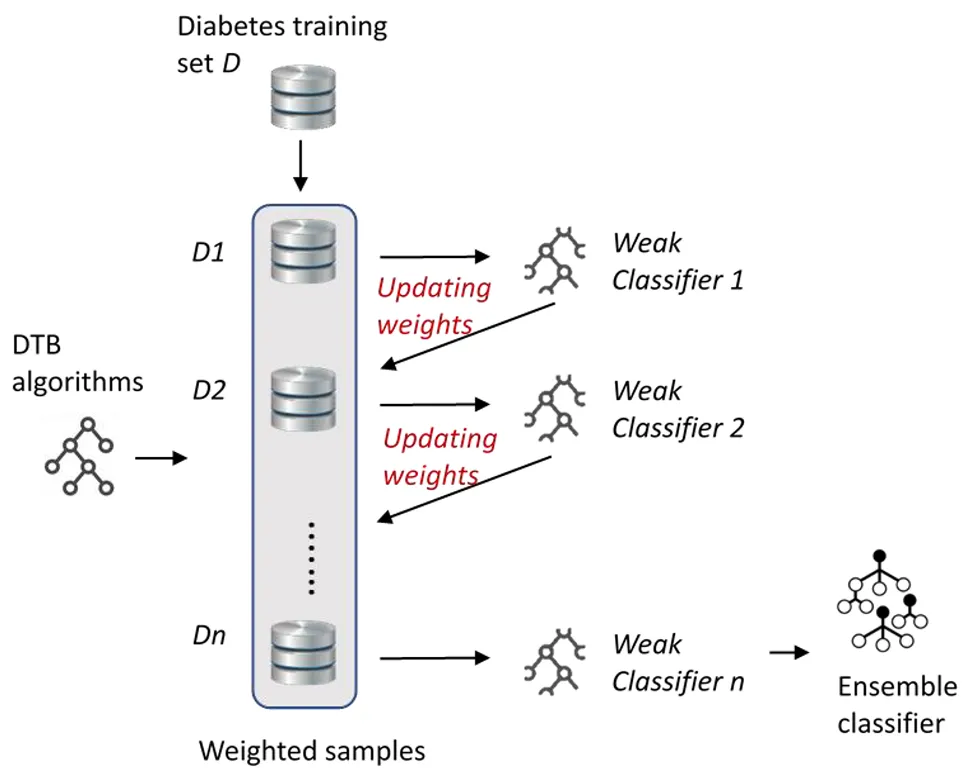

Boosting ist eine weitere Technik des Ensemble-Lernens, bei der es darum geht, schwache Lerner (Modelle) zu verbessern, indem sie nacheinander und nicht parallel trainiert werden. Das Kernkonzept des Boosting besteht darin, dass jedes neue Modell aus den Fehlern der vorherigen Modelle lernt und so die Gesamtleistung des Modells schrittweise verbessert.

Im Gegensatz zum Bagging, bei dem die Varianz durch die Durchschnittsbildung unabhängiger Modelle reduziert wird, verringert das Boosting die Verzerrung, indem jedes neue Modell schwierige Fälle, mit denen die früheren Modelle nicht zurechtkamen, stärker berücksichtigt.

Da Boosting-Modelle nacheinander trainiert werden, unterscheidet sich die Art und Weise, wie ihre Vorhersagen am Ende kombiniert werden, leicht von anderen Ensemble-Methoden. Jedes Modell trägt im Verhältnis zu seiner Leistung während des Trainings zur endgültigen Vorhersage bei, wobei genauere Modelle ein größeres Gewicht erhalten.

Bei Regressionsaufgaben ist das Endergebnis in der Regel eine gewichtete Summe aller Modellvorhersagen. Bei Klassifizierungsaufgaben kombiniert der Algorithmus die gewichteten Stimmen der Modelle, um die endgültige Klasse zu bestimmen. Dieser Ansatz hilft beim Boosten, ein starkes Gesamtmodell zu erstellen, indem er den Modellen, die genauer sind, mehr Gewicht gibt, während er gleichzeitig von den anderen Modellen lernt.

Hier sind einige gängige Arten von Boosting-Algorithmen:

Stacking, auch gestapelte Generalisierung genannt, geht noch einen Schritt weiter, indem es die Vorhersagen mehrerer Modelle als Input für ein endgültiges Modell verwendet, das als Meta-Learner bekannt ist. Man kann sich das so vorstellen, als hätte man eine Gruppe von Experten, die alle ihre Meinung kundtun, und dann lernt ein endgültiger Entscheidungsträger, wie er diese Meinungen abwägen muss, um die bestmögliche Entscheidung zu treffen.

So kann ein Modell beispielsweise sehr gut Betrug erkennen, während ein anderes besser in der Lage ist, die Kundenabwanderung vorherzusagen. Der Meta-Lerner untersucht, wie die einzelnen Modelle abschneiden, und nutzt ihre Stärken zusammen, um eine genauere Vorhersage zu treffen.

Blending funktioniert ähnlich wie Stacking, da es ebenfalls die Vorhersagen mehrerer Modelle kombiniert, um eine endgültige Entscheidung zu treffen, aber es verfolgt einen einfacheren und schnelleren Ansatz. Anstatt wie beim Stacking eine Kreuzvalidierung durchzuführen (eine Methode, bei der die Daten in mehrere Teile aufgeteilt und zwischen Training und Test gewechselt werden, um das Modell zuverlässiger zu machen), wird beim Blending ein kleiner Teil der Daten beiseite gelegt, der sogenannte Holdout-Satz.

Die Basismodelle werden auf den verbleibenden Daten trainiert und machen dann Vorhersagen für den Holdout-Satz, den sie noch nicht gesehen haben. Auf diese Weise erhält man zwei wichtige Informationen: die tatsächlichen Antworten bzw. wahren Bezeichnungen und die Vorhersagen der einzelnen Basismodelle.

Diese Vorhersagen werden dann an ein weiteres Modell weitergegeben, das so genannte Blending-Modell oder Meta-Modell. Dieses endgültige Modell untersucht, wie genau die Vorhersagen der einzelnen Basismodelle sind, und lernt, wie sie am besten kombiniert werden können.

Da beim Blending nur ein einziges Mal trainiert und getestet wird, anstatt den Prozess mehrmals zu wiederholen, läuft es schneller und ist einfacher einzurichten. Der Nachteil ist, dass etwas weniger Informationen zum Lernen zur Verfügung stehen, wodurch es etwas ungenauer werden kann.

Ein wichtiger Teil des Ensemble-Lernens ist die Bewertung der Leistung eines Modells bei Daten, die es noch nicht gesehen hat. Unabhängig davon, wie fortschrittlich eine Technik ist, muss sie getestet werden, um sicherzustellen, dass sie verallgemeinert werden kann, d. h., dass sie genaue Vorhersagen für neue, reale Beispiele macht, anstatt sich nur die Trainingsdaten zu merken.

Im Folgenden finden Sie einige gängige Leistungskennzahlen zur Bewertung von KI-Modellen:

Bisher haben wir uns mit der Funktionsweise und den Techniken des Ensemble-Lernens beschäftigt. Jetzt wollen wir uns ansehen, wo dieser Ansatz Wirkung zeigt.

Im Folgenden werden einige Schlüsselbereiche genannt, in denen Ensemble-Learning häufig eingesetzt wird:

Das Ensemble-Lernen wird zwar am häufigsten bei strukturierten oder tabellarischen Daten wie Tabellenkalkulationen mit numerischen oder kategorialen Informationen eingesetzt, kann aber auch auf unstrukturierte Daten wie Text, Bilder, Audio und Video angewendet werden.

Diese Datentypen sind komplexer und für Modelle schwieriger zu interpretieren, aber Ensemble-Methoden helfen, die Genauigkeit und Zuverlässigkeit zu verbessern. In der Computer Vision zum Beispiel können Ensembles Aufgaben wie die Bildklassifizierung und Objekterkennung verbessern.

Durch die Kombination der Vorhersagen mehrerer Bildgebungsmodelle, wie z. B. Faltungsneuronaler Netze (CNNs), kann das System Objekte genauer erkennen und mit Variationen in der Beleuchtung, dem Winkel oder dem Hintergrund umgehen, die ein einzelnes Modell verwirren könnten.

Ein interessantes Beispiel für den Einsatz von Ensemble-Lernen in der Computer Vision ist die Kombination mehrerer Modelle zur Objekterkennung, um die Genauigkeit zu verbessern. Stellen Sie sich einen Ingenieur vor, der an einem Sicherheitsüberwachungssystem für eine Baustelle arbeitet, auf der sich Beleuchtung, Winkel und Objektgrößen ständig ändern.

Ein einzelnes Modell könnte einen Arbeiter im Schatten übersehen oder Maschinen in Bewegung verwechseln. Durch die Verwendung eines Ensembles von Modellen, die jeweils unterschiedliche Stärken haben, wird das System zuverlässiger und die Wahrscheinlichkeit, dass solche Fehler auftreten, geringer.

Insbesondere Modelle wie Ultralytics YOLOv5 gehen Hand in Hand mit Modell-Ensembling. Ingenieure können verschiedene YOLOv5 , wie YOLOv5x und YOLOv5l6, kombinieren, um gemeinsam Vorhersagen zu treffen. Jedes Modell analysiert dasselbe Bild und erzeugt seine eigenen Erkennungen, die dann gemittelt werden, um ein stärkeres und genaueres Endergebnis zu erzielen.

Hier sind einige der wichtigsten Vorteile des Ensemble-Lernens:

Das gemeinsame Lernen bringt zwar zahlreiche Vorteile mit sich, aber es gibt auch einige Herausforderungen zu beachten. Hier sind einige Faktoren, die Sie im Auge behalten sollten:

Ensemble-Lernen zeigt, wie die Kombination mehrerer Modelle KI-Systeme genauer und zuverlässiger machen kann. Es hilft, Fehler zu reduzieren und die Leistung bei verschiedenen Aufgaben zu verbessern. Da maschinelles Lernen und KI weiter zunehmen, führen Techniken wie diese zu einer breiteren Akzeptanz und zu mehr praktischen, leistungsstarken KI-Lösungen.

Werden Sie Teil unserer wachsenden Community und unseres GitHub-Repository und erfahren Sie mehr über Vision AI. Informieren Sie sich auf unseren Lösungsseiten über Anwendungen von Computer Vision in der Landwirtschaft und KI in der Logistik. Informieren Sie sich über unsere Lizenzierungsoptionen, um noch heute mit Ihrem eigenen Computer-Vision-Modell zu beginnen!