Pruning und Quantisierung in der Computer Vision: Eine Kurzanleitung

Entdecken Sie, warum Pruning und Quantisierung unerlässlich sind, um Computer Vision Modelle zu optimieren und eine schnellere Leistung auf Edge-Geräten zu ermöglichen.

Entdecken Sie, warum Pruning und Quantisierung unerlässlich sind, um Computer Vision Modelle zu optimieren und eine schnellere Leistung auf Edge-Geräten zu ermöglichen.

Mit der fortschreitenden Technologie werden Edge-Geräte immer häufiger eingesetzt. Von Smartwatches, die track Herzfrequenz track , bis hin zu Flugdrohnen, die Straßen überwachen, können Edge-Systeme Daten in Echtzeit lokal im Gerät selbst verarbeiten.

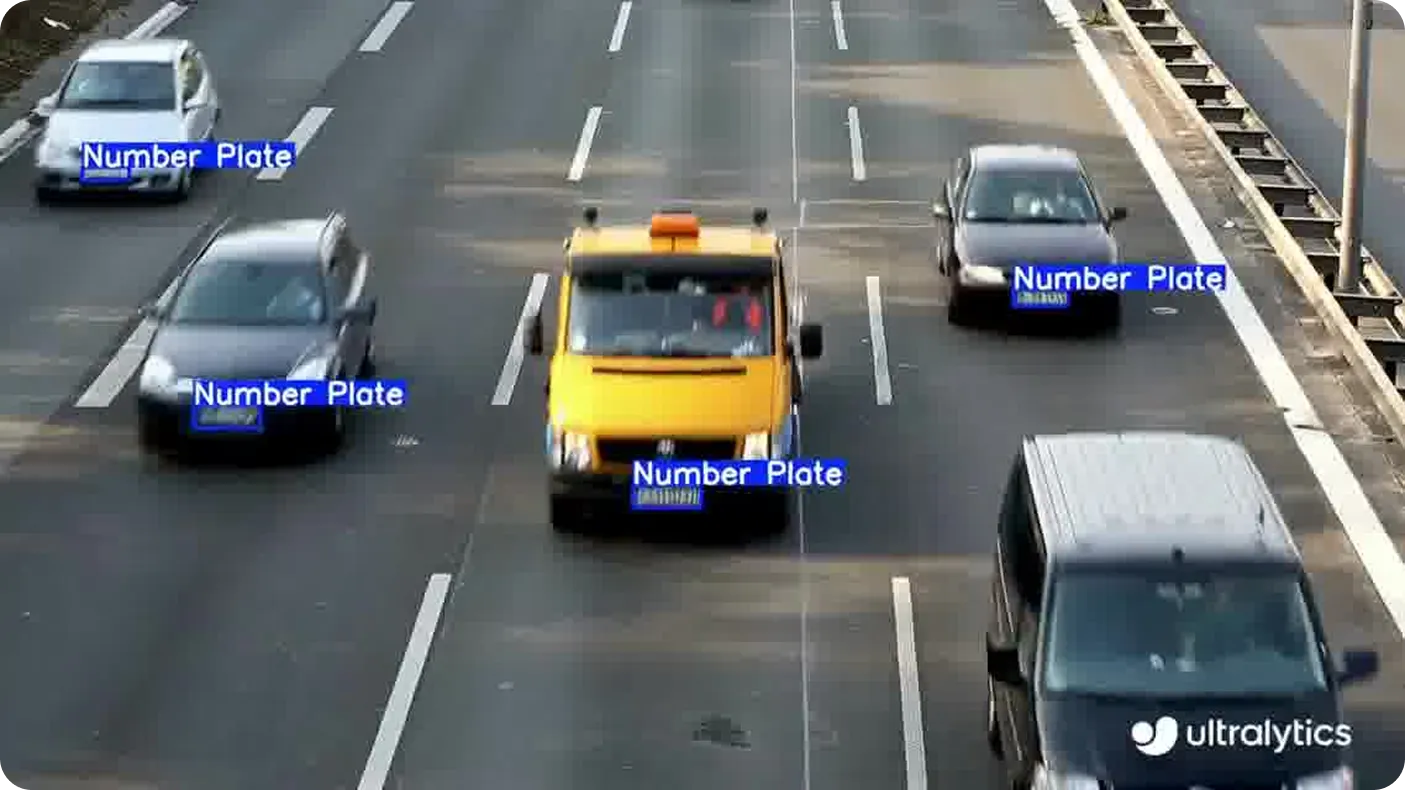

Diese Methode ist oft schneller und sicherer als das Senden von Daten in die Cloud, insbesondere bei Anwendungen, die persönliche Daten beinhalten, wie z. B. die Erkennung von Nummernschildern oder die Verfolgung von Gesten. Dies sind Beispiele für Computer Vision, einem Zweig der künstlichen Intelligenz (KI), der es Maschinen ermöglicht, visuelle Informationen zu interpretieren und zu verstehen.

Eine wichtige Überlegung ist jedoch, dass solche Anwendungen Vision-AI-Modelle erfordern, die in der Lage sind, rechenintensive Aufgaben mit minimalen Ressourcen zu bewältigen und unabhängig zu arbeiten. Die meisten Computer Vision Modelle werden für Hochleistungssysteme entwickelt, wodurch sie weniger für den direkten Einsatz auf Edge-Geräten geeignet sind.

Um diese Lücke zu schließen, wenden Entwickler häufig gezielte Optimierungen an, die das Modell so anpassen, dass es effizient auf kleinerer Hardware läuft. Diese Anpassungen sind entscheidend für reale Edge-Bereitstellungen, bei denen Speicher und Rechenleistung begrenzt sind.

Interessant ist, dass Computer-Vision-Modelle wie Ultralytics YOLO11 bereits mit Blick auf die Kanteneffizienz entwickelt und eignen sich daher hervorragend für Echtzeitaufgaben. Ihre Leistung kann jedoch durch Modelloptimierungstechniken wie Pruning und Quantisierung weiter verbessert werden, was noch schnellere Schlussfolgerungen und eine geringere Ressourcennutzung auf eingeschränkten Geräten ermöglicht.

In diesem Artikel werden wir einen genaueren Blick darauf werfen, was Pruning und Quantisierung sind, wie sie funktionieren und wie sie die Leistung von YOLO in realen Edge-Einsätzen unterstützen können. Legen wir los!

Bei der Vorbereitung von Vision-KI-Modellen für den Einsatz auf Edge-Geräten ist eines der Hauptziele, das Modell leichtgewichtig und zuverlässig zu machen, ohne die Leistung zu beeinträchtigen. Dies beinhaltet oft die Reduzierung der Größe und des Rechenaufwands des Modells, damit es effizient auf Hardware mit begrenztem Speicher, Strom oder Verarbeitungskapazität arbeiten kann. Zwei gängige Methoden hierfür sind Pruning und Quantisierung.

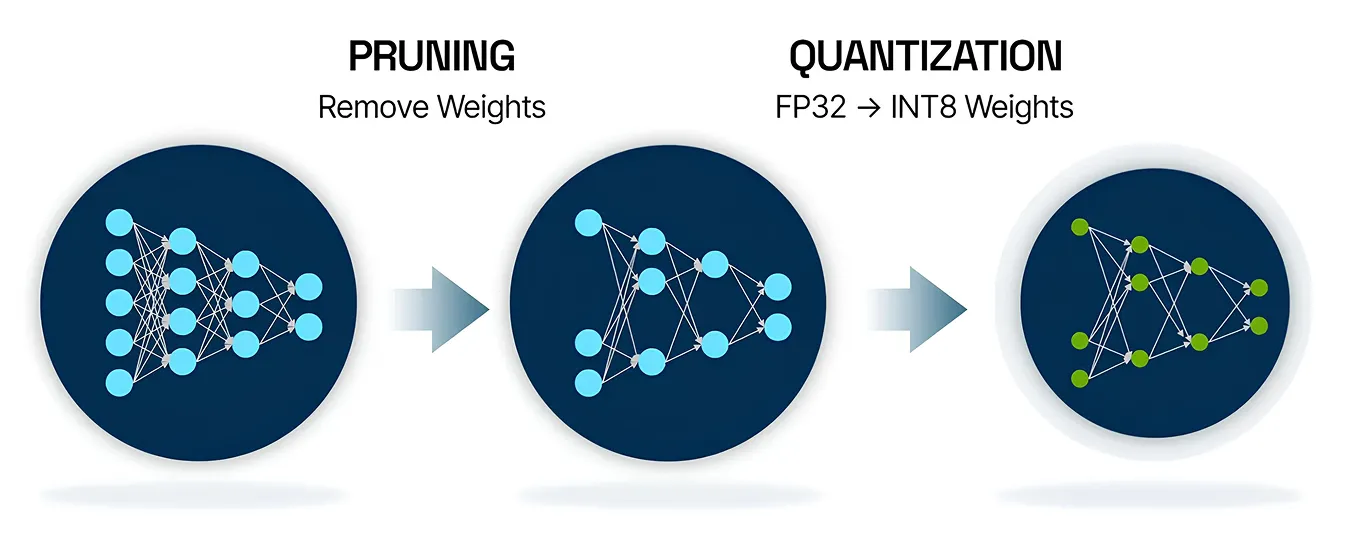

Pruning ist eine KI-Modelloptimierungstechnik, die dazu beiträgt, neuronale Netze kleiner und effizienter zu machen. In vielen Fällen tragen Teile eines Modells, wie z. B. bestimmte Verbindungen oder Knoten, nicht wesentlich zu seinen endgültigen Vorhersagen bei. Pruning funktioniert, indem es diese weniger wichtigen Teile identifiziert und entfernt, was die Größe des Modells reduziert und seine Leistung beschleunigt.

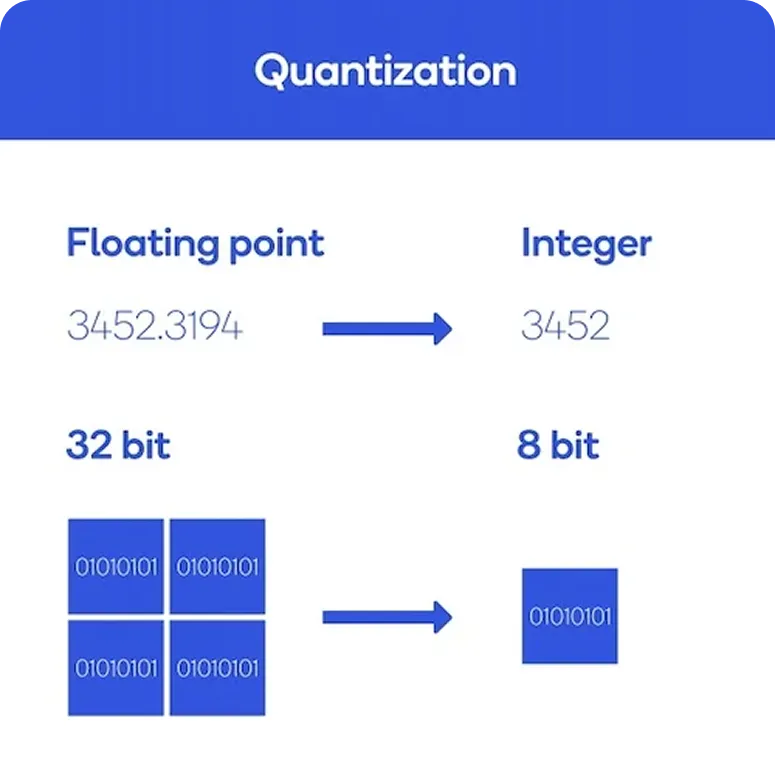

Andererseits ist die Quantisierung eine Optimierungstechnik, die die Präzision der von einem Modell verwendeten Zahlen reduziert. Anstatt sich auf hochpräzise 32-Bit-Gleitkommazahlen zu verlassen, wechselt das Modell zu kleineren, effizienteren Formaten wie 8-Bit-Integer. Diese Änderung trägt dazu bei, den Speicherverbrauch zu senken und die Inferenz, den Prozess, bei dem das Modell Vorhersagen trifft, zu beschleunigen.

Nachdem wir nun ein besseres Verständnis davon haben, was Pruning und Quantisierung sind, wollen wir uns ansehen, wie beides funktioniert.

Das Pruning erfolgt mithilfe eines Prozesses, der als Sensitivitätsanalyse bekannt ist. Dabei wird ermittelt, welche Teile der neuronalen Netzwerkmodelle, wie z. B. bestimmte Gewichte, Neuronen oder Kanäle, am wenigsten zur endgültigen Ausgabevorhersage beitragen. Diese Teile können mit minimalen Auswirkungen auf die Genauigkeit entfernt werden. Nach dem Pruning wird das Modell in der Regel erneut trainiert, um seine Leistung feinabzustimmen. Dieser Zyklus kann wiederholt werden, um das richtige Gleichgewicht zwischen seiner Größe und Genauigkeit zu finden.

Unterdessen konzentriert sich die Modellquantisierung darauf, wie das Modell Daten verarbeitet. Sie beginnt mit der Kalibrierung, bei der das Modell mit Beispieldaten ausgeführt wird, um den Wertebereich zu erlernen, den es verarbeiten muss. Diese Werte werden dann von 32-Bit-Gleitkommazahlen in Formate mit niedrigerer Präzision wie 8-Bit-Ganzzahlen konvertiert.

Es gibt mehrere Tools, die die Verwendung von Pruning und Quantisierung in realen KI-Projekten erleichtern. Die meisten KI-Frameworks, wie PyTorch und TensorFlow, bieten integrierte Unterstützung für diese Optimierungstechniken, sodass Entwickler sie direkt in den Modellbereitstellungsprozess integrieren können.

Sobald ein Modell optimiert ist, können Tools wie ONNX Runtime dabei helfen, es effizient auf verschiedenen Hardwareplattformen wie Servern, Desktops und Edge-Geräten auszuführen. Außerdem bietet Ultralytics Integrationen, mit denen YOLO in Formate exportiert werden können, die für die Quantisierung geeignet sind, was die Reduzierung der Modellgröße und die Steigerung der Leistung erleichtert.

YOLO Ultralytics wie YOLO11 sind weithin für ihre schnelle, einstufige Objekterkennung bekannt und damit ideal für Echtzeit-Vision-KI-Aufgaben. Sie sind bereits so konzipiert, dass sie leichtgewichtig und effizient genug für den Edge-Einsatz sind. Die Schichten, die für die Verarbeitung visueller Merkmale zuständig sind, die so genannten Faltungsschichten, können jedoch während der Inferenz eine erhebliche Rechenleistung erfordern.

Sie werden sich vielleicht fragen: Wenn YOLO11 bereits für den Einsatz auf Edge-Geräten optimiert ist, warum muss es dann noch weiter optimiert werden? Einfach gesagt, sind nicht alle Edge-Geräte gleich. Einige laufen mit sehr minimaler Hardware, wie winzige eingebettete Prozessoren, die weniger Strom verbrauchen als eine Standard-LED-Glühbirne.

In diesen Fällen muss selbst ein schlankes Modell wie YOLO11 zusätzlich optimiert werden, um eine reibungslose und zuverlässige Leistung zu gewährleisten. Techniken wie Pruning und Quantisierung helfen dabei, die Größe des Modells zu reduzieren und die Inferenz zu beschleunigen, ohne die Genauigkeit wesentlich zu beeinträchtigen.

Um die Anwendung dieser Optimierungstechniken zu erleichtern, unterstützt Ultralytics verschiedene Integrationen, mit denen YOLO in verschiedene Formate wie ONNX, TensorRT, OpenVINO, CoreML und PaddlePaddle exportiert werden können. Jedes Format ist so konzipiert, dass es mit bestimmten Arten von Hardware und Einsatzumgebungen gut funktioniert.

Beispielsweise wird ONNX aufgrund seiner Kompatibilität mit einer Vielzahl von Tools und Plattformen häufig in Quantisierungs-Workflows eingesetzt. TensorRT hingegen ist hochgradig für NVIDIA optimiert und unterstützt Inferenz mit niedriger Genauigkeit unter Verwendung von INT8, was es ideal für den Hochgeschwindigkeitseinsatz auf Edge-GPUs macht.

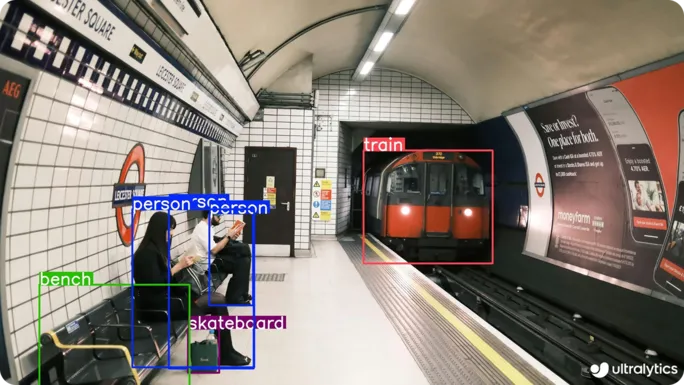

Da sich die Computer Vision immer mehr auf verschiedene reale Anwendungen ausweitet, ermöglichen optimierte YOLO die Ausführung von Aufgaben wie Objekterkennung, Instanzsegmentierung und Objektverfolgung auf kleinerer, schnellerer Hardware. Als Nächstes werden wir einige Anwendungsfälle erörtern, in denen Pruning und Quantisierung diese Computer-Vision-Aufgaben effizienter und praktischer machen.

Viele Industrieanlagen und öffentliche Bereiche sind auf Echtzeitüberwachung angewiesen, um sicher zu sein. An Orten wie Bahnhöfen, Produktionsstätten und großen Außenanlagen werden Vision AI-Systeme benötigt, die Personen oder Fahrzeuge schnell und präzise detect können. Oft arbeiten diese Orte mit eingeschränkter Konnektivität und Hardwarebeschränkungen, was den Einsatz großer Modelle erschwert.

In solchen Fällen ist ein optimiertes Vision AI-Modell wie YOLO11 eine hervorragende Lösung. Dank seiner kompakten Größe und schnellen Leistung eignet es sich perfekt für den Einsatz auf stromsparenden Edge-Geräten, wie eingebetteten Kameras oder intelligenten Sensoren. Diese Modelle können visuelle Daten direkt auf dem Gerät verarbeiten und ermöglichen die Erkennung von Sicherheitsverletzungen, unbefugtem Zugriff oder abnormalen Aktivitäten in Echtzeit, ohne auf einen ständigen Cloud-Zugriff angewiesen zu sein.

Baustellen sind schnelllebig und unvorhersehbar, voller schwerer Maschinen, sich bewegender Arbeiter und ständiger Aktivität. Die Bedingungen können sich aufgrund von sich ändernden Zeitplänen, Gerätebewegungen oder sogar plötzlichen Wetteränderungen schnell ändern. In einem so dynamischen Umfeld kann sich die Arbeitssicherheit wie eine ständige Herausforderung anfühlen.

Die Echtzeitüberwachung spielt eine entscheidende Rolle, aber herkömmliche Systeme sind oft auf einen Cloud-Zugang oder teure Hardware angewiesen, die vor Ort nicht praktikabel ist. Hier können Modelle wie YOLO11 eine wichtige Rolle spielen. YOLO11 kann für den Betrieb auf kleinen, effizienten Edge-Geräten optimiert werden, die direkt vor Ort arbeiten, ohne dass eine Internetverbindung erforderlich ist.

Denken Sie zum Beispiel an eine große Baustelle, wie eine Autobahnerweiterung, die sich über mehrere Hektar erstreckt. In einem solchen Umfeld kann die manuelle Verfolgung jedes Fahrzeugs oder Geräts schwierig und zeitaufwändig sein. Eine Drohne, die mit einer Kamera und einem optimierten YOLO11 ausgestattet ist, kann helfen, indem sie automatisch Fahrzeuge erkennt und verfolgt, den Verkehrsfluss überwacht und Sicherheitsprobleme wie unbefugte Zugriffe oder unsicheres Fahrverhalten identifiziert.

Hier sind einige der wichtigsten Vorteile, die Optimierungsmethoden für Computer-Vision-Modelle wie Pruning und Quantisierung bieten:

Obwohl Pruning und Quantisierung viele Vorteile bieten, bringen sie auch bestimmte Kompromisse mit sich, die Entwickler bei der Optimierung von Modellen berücksichtigen sollten. Hier sind einige Einschränkungen, die Sie beachten sollten:

Pruning und Quantisierung sind nützliche Techniken, mit denen YOLO auf Edge-Geräten besser funktionieren. Sie reduzieren die Größe des Modells, verringern seinen Rechenbedarf und beschleunigen die Vorhersagen, ohne dass die Genauigkeit merklich abnimmt.

Diese Optimierungsmethoden geben Entwicklern auch die Flexibilität, Modelle für verschiedene Hardwaretypen anzupassen, ohne sie vollständig neu erstellen zu müssen. Mit etwas Feinabstimmung und Tests wird es einfacher, Vision AI in realen Situationen anzuwenden.

Treten Sie unserer wachsenden Community bei! Erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren. Sind Sie bereit, Ihre Computer-Vision-Projekte zu starten? Sehen Sie sich unsere Lizenzoptionen an. Entdecken Sie KI in der Landwirtschaft und Vision AI im Gesundheitswesen auf unseren Lösungsseiten!